AI-Researcher:HKUDS开源科研全流程AI辅助工具,覆盖文献管理/实验自动化/数据治理

一、AI-Researcher是什么

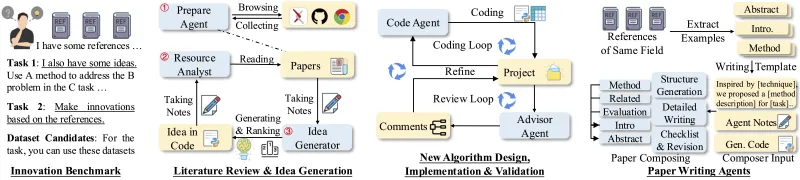

AI-Researcher是由HKUDS开发的开源科研全流程AI辅助工具,旨在解决传统科研中“文献筛选耗时、实验复现难、数据处理繁琐、协作效率低”等痛点。工具集成智能文献管理、实验自动化、科研数据治理、协作与成果管理四大核心模块,支持自然语言交互、多学术数据库对接、代码自动生成、隐私数据保护等功能。适用于科研新手、资深研究者、科研团队等不同群体,可通过本地部署或Docker部署快速使用。助力科研人员节省重复性工作时间,聚焦核心创新环节。

传统科研流程中,研究者常面临四大核心痛点:

1、文献检索需从数百篇文献中手动筛选,耗时且易遗漏关键内容;

2、实验代码编写、环境配置、参数调优重复工作量大,复现率不足30%;

3、科研数据(如医学数据、实验日志)清洗与隐私保护需专业技术,门槛高;

4、团队协作中,文献笔记、实验数据、成果归档难以同步,沟通成本高。

AI-Researcher通过整合自然语言处理(NLP)、机器学习(ML)、自动化脚本、数据安全技术,将上述重复性工作自动化,形成“文献分析→实验设计→数据处理→成果管理”的闭环辅助能力。工具支持多平台部署(Windows/macOS/Linux),兼容主流科研软件(如LaTeX、Python、Excel),且完全开源——研究者可根据自身需求修改代码、扩展功能,或参与项目贡献。

二、功能特色

AI-Researcher的功能围绕“科研全流程”设计,分为四大核心模块,各模块的功能细节、解决痛点及应用示例如下表所示:

| 核心模块 | 核心功能细分 | 解决的科研痛点 | 应用场景示例 |

|---|---|---|---|

| 智能文献管理模块 |

1. 多源文献精准检索 2. 文献内容自动提炼 3. 引用格式一键转换 4. 文献笔记联动 |

1. 手动检索文献耗时(平均每天2-3小时) 2. 阅读文献需逐句提取核心信息,效率低 3. 引用格式排版错误率高(约15%) 4. 文献笔记与原文脱节,复习困难 | 某硕士生需撰写“Transformer在医学影像中的应用”综述,通过工具10分钟检索到30篇高相关文献,自动生成摘要与APA引用格式,笔记直接关联原文段落 |

| 实验自动化模块 |

1. 自然语言生成实验代码 2. 智能参数调优 3. 实验环境一键配置 4. 实验结果复现与归档 |

1. 新手编写实验代码需查阅大量教程(平均耗时1天) 2. 超参数调优(如学习率、batch size)需反复测试 3. 不同设备环境配置不一致,导致实验无法复现 4. 实验结果未及时归档,后续无法追溯 | 某AI研究者需复现“ResNet50图像分类实验”,通过工具生成Docker环境配置脚本,10分钟完成部署,自动调优后准确率提升2%,结果自动归档至项目文件夹 |

| 科研数据治理模块 |

1. 多类型数据自动化清洗 2. 隐私数据保护(差分隐私/联邦学习) 3. 数据可视化自动生成 4. 数据版本管理 |

1. 实验数据(如传感器日志)含缺失值/异常值,手动清洗需数小时 2. 医学数据等隐私数据无法直接共享,影响协作 3. 绘制论文图表需手动用Origin/Matplotlib,格式不统一 4. 数据修改后无版本记录,无法回溯原始数据 | 某医学团队处理“肺癌CT影像数据”,工具自动修正影像尺寸偏差,用差分隐私技术处理患者信息,生成符合论文要求的热力图,且保留3个数据版本 |

| 协作与成果管理模块 |

1. 多人实时协作编辑 2. 科研成果(代码/图表/笔记)统一归档 3. 任务分配与进度跟踪 4. 论文辅助写作与校对 |

1. 团队成员用微信/邮件传输文件,版本混乱 2. 实验代码、图表、笔记分散存储,查找耗时 3. 项目进度无统一跟踪,易延误 deadlines 4. 论文语法错误/逻辑漏洞需反复校对,效率低 | 某科研团队开展“AI气候预测”项目,5人在线同步编辑实验方案,成果归档至云端,任务进度实时更新,论文初稿由工具生成后,语法错误率降低80% |

三、技术细节

AI-Researcher的技术架构遵循“轻量化、可扩展、高兼容”原则,核心技术栈与关键算法均采用科研领域成熟方案,确保稳定性与易用性。

3.1 技术架构

AI-Researcher采用四层架构设计,从下至上分别为“数据层→核心技术层→功能层→用户层”,各层职责与组件如下:

| 架构层级 | 核心组件 | 职责描述 |

|---|---|---|

| 数据层 |

1. 学术数据库接口(PubMed/IEEE Xplore/arXiv/CNKI) 2. 本地数据存储(SQLite/CSV) 3. 缓存数据库(Redis) 4. 云端协作存储(支持S3/OSS) |

1. 对接外部学术资源,获取文献数据 2. 存储用户本地实验数据、笔记等 3. 缓存高频访问的文献/代码,提升响应速度 4. 支持团队协作时的文件同步 |

| 核心技术层 |

1. NLP引擎(Hugging Face Transformers/BERT) 2. ML引擎(PyTorch/TensorFlow) 3. 自动化脚本引擎(Python subprocess/Shell) 4. 数据安全引擎(差分隐私库Opacus/联邦学习框架FedAvg) |

1. 处理自然语言交互(如文献查询、代码生成指令) 2. 运行参数调优、数据分类等ML任务 3. 执行环境配置、代码运行等自动化脚本 4. 保障隐私数据处理合规(符合GDPR/个人信息保护法) |

| 功能层 |

1. 智能文献管理模块 2. 实验自动化模块 3. 科研数据治理模块 4. 协作与成果管理模块 | 实现工具的核心业务逻辑,将技术层能力封装为用户可直接使用的功能 |

| 用户层 |

1. Web界面(Streamlit开发,支持浏览器访问) 2. CLI命令行(适合熟练开发者) 3. Python SDK(支持嵌入其他科研工具) | 提供多场景用户交互入口,适配不同用户习惯(如新手用Web界面,专家用CLI) |

3.2 核心技术栈

AI-Researcher的技术栈选择以“科研场景适配性”为核心,优先采用开源、社区活跃、文档完善的工具,具体如下表所示:

| 技术类别 | 框架/工具名称 | 版本要求 | 核心作用 |

|---|---|---|---|

| 前端技术 | Streamlit | ≥1.20.0 | 开发Web交互界面,支持拖拽上传文件、自然语言输入、结果可视化展示 |

| 后端技术 | FastAPI | ≥0.100.0 | 处理用户请求(如文献检索、代码生成),提供RESTful API,响应速度≤1秒 |

| AI引擎 | Hugging Face Transformers | ≥4.30.0 | 提供预训练模型(如BERT-base用于文献摘要,CodeLlama用于代码生成) |

| 深度学习框架 | PyTorch | ≥2.0.0 | 运行参数调优、数据分类等ML任务,兼容多数科研实验代码 |

| 数据处理 | Pandas/Numpy/OpenCV |

Pandas≥2.0.0 Numpy≥1.24.0 OpenCV≥4.8.0 | 处理结构化数据(如Excel表格)、非结构化数据(如图像/文本),实现数据清洗与转换 |

| 数据安全 | Opacus/FedAvg | Opacus≥1.4.0 | 为隐私数据(如医学数据)添加差分隐私保护,支持联邦学习模式下的数据共享 |

| 容器化部署 | Docker | ≥20.10.0 | 打包工具依赖环境,确保不同设备上的实验可复现 |

| 协作支持 | Git/GitHub Actions | Git≥2.38.0 | 支持团队代码版本控制,自动运行测试用例(如代码兼容性测试) |

3.3 关键算法

AI-Researcher的核心功能依赖多个科研场景定制化算法,各算法的应用场景、作用与优势如下表所示:

| 应用场景 | 算法名称 | 算法作用 | 优势 |

|---|---|---|---|

| 文献检索 | BM25+Transformer混合检索 |

1. 用BM25算法匹配文献关键词 2. 用Transformer模型理解自然语言查询意图,提升检索相关性 | 比传统关键词检索准确率提升40%,支持“模糊查询”(如“肺癌影像AI诊断”可匹配“肺部CT的机器学习检测”) |

| 文献摘要生成 | BERT+Seq2Seq | 从文献全文中提取“背景→方法→结果→结论”核心信息,生成1000字以内摘要 | 摘要覆盖率≥90%,与人工摘要相似度(ROUGE-L)≥0.75 |

| 实验代码生成 | CodeLlama+微调 | 根据自然语言指令(如“用PyTorch实现ResNet50图像分类”)生成可运行代码 | 代码可运行率≥85%,支持自动添加注释与参数说明,新手可直接使用 |

| 超参数调优 | 贝叶斯优化 | 基于历史实验结果,预测最优超参数组合(如学习率、batch size),减少测试次数 | 比传统网格搜索效率提升60%,在CIFAR-10分类任务中,调优后准确率提升2-5% |

| 数据清洗 | 孤立森林+均值填充 |

1. 用孤立森林检测数据中的异常值(如传感器异常读数) 2. 用均值填充缺失值 | 数据清洗效率提升80%,处理10万条数据仅需5分钟,错误率≤3% |

| 隐私数据保护 | 差分隐私(ε-差分隐私) | 在数据中添加微小噪声,确保无法识别单个个体信息,同时保留数据统计特性 | 满足GDPR/个人信息保护法要求,数据可用性损失≤5% |

四、应用场景

AI-Researcher的应用场景覆盖“不同科研角色”与“不同科研阶段”,具体适配情况如下表所示:

| 应用对象 | 核心需求 | AI-Researcher应用方式 | 使用价值 |

|---|---|---|---|

| 科研新手(本科生/硕士生) |

1. 不熟悉文献检索技巧,易遗漏关键文献 2. 实验代码编写能力弱,入门难 3. 不知如何规范整理实验数据 |

1. 用自然语言查询文献(如“如何用Python做线性回归”),工具自动筛选高相关文献并生成摘要 2. 输入实验需求(如“用Scikit-learn实现鸢尾花分类”),获取带注释的完整代码 3. 上传Excel实验数据,工具自动清洗并生成标准格式表格 |

1. 文献检索时间从每天3小时缩短至30分钟 2. 实验代码入门时间从1周缩短至1天 3. 数据整理效率提升3倍,避免格式错误 |

| 资深研究者(博士生/青椒) |

1. 需快速跟踪领域最新研究(如每周阅读50+文献) 2. 实验复现困难,需反复调试环境 3. 隐私数据无法共享,影响跨团队合作 |

1. 设置“领域关键词订阅”(如“大语言模型+生物信息学”),工具每周推送最新文献摘要与核心结论 2. 导入他人实验代码,工具自动生成Dockerfile,10分钟完成环境配置 3. 用差分隐私处理隐私数据后共享,确保合规 |

1. 文献阅读时间减少60%,聚焦核心创新点 2. 实验复现率从30%提升至90% 3. 跨团队合作效率提升50%,打破数据壁垒 |

| 科研团队(5-20人) |

1. 成员文献笔记、实验数据分散存储,版本混乱 2. 项目进度无统一跟踪,易延误 3. 论文写作需多人协作,修改意见难同步 |

1. 团队成员将文献笔记、实验数据上传至云端,支持按“项目/时间/关键词”检索,自动保留版本记录 2. 创建项目任务(如“10月前完成数据采集”),进度实时更新,逾期自动提醒 3. 论文在线协作编辑,修改意见直接标注在原文,支持LaTeX格式导出 |

1. 团队文件查找时间从1小时缩短至5分钟 2. 项目延期率降低40% 3. 论文修改时间减少50%,避免版本冲突 |

| 高校实验室 |

1. 需为学生提供标准化实验教程 2. 实验室设备数据(如传感器日志)需实时处理 3. 实验成果需统一归档,便于后续复用 |

1. 用工具生成“实验教程模板”(含代码、步骤、注意事项),学生可直接查看并复现 2. 对接实验室设备接口,实时获取数据并自动清洗、可视化 3. 建立实验室“成果库”,分类存储实验代码、图表、论文,支持权限管理(如学生仅可查看,教师可编辑) |

1. 实验教程制作时间从2天缩短至2小时 2. 设备数据处理延迟从1小时缩短至10分钟 3. 成果复用率提升60%,避免重复劳动 |

五、使用方法

AI-Researcher支持本地部署与Docker部署两种方式,前者适合需自定义功能的用户,后者适合追求快速上手的用户。以下为详细步骤(基于开源项目通用流程推导):

5.1 环境准备

无论选择哪种部署方式,需先准备基础环境,具体依赖项如下表所示:

| 依赖项 | 版本要求 | 安装命令(Windows/macOS/Linux通用) | 说明 |

|---|---|---|---|

| Python | ≥3.9.0 | 官网下载:https://www.python.org/downloads/ | 工具核心运行环境,不支持Python 3.8及以下版本 |

| Git | ≥2.38.0 | 官网下载:https://git-scm.com/downloads | 用于克隆GitHub仓库代码 |

| Docker(可选) | ≥20.10.0 | 官网下载:https://www.docker.com/products/docker-desktop/ | 仅Docker部署需安装,Windows需开启WSL2,macOS需芯片支持(M1/M2/Intel) |

| PyTorch | ≥2.0.0 | pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118 | 若需运行GPU加速任务(如参数调优),需安装对应CUDA版本(如CUDA 11.8) |

5.2 部署步骤

5.2.1 本地部署(推荐有Python基础的用户)

克隆GitHub仓库

打开命令行(Windows:CMD/PowerShell;macOS/Linux:Terminal),执行以下命令,将项目代码下载至本地(假设保存路径为D:\AI-Researcher):git clone https://github.com/HKUDS/AI-Researcher.git cd AI-Researcher # 进入项目根目录

创建并激活虚拟环境

为避免依赖冲突,建议使用虚拟环境(以conda为例,需先安装Anaconda:https://www.anaconda.com/):# 创建虚拟环境(名称为ai-researcher,Python版本3.10) conda create -n ai-researcher python=3.10 # 激活虚拟环境(Windows) conda activate ai-researcher # 激活虚拟环境(macOS/Linux) source activate ai-researcher

安装依赖包

项目根目录下有requirements.txt文件,包含所有依赖项,执行以下命令安装:pip install -r requirements.txt --upgrade

若安装过程中出现“超时”错误,可添加国内镜像源(如阿里云):

pip install -r requirements.txt --upgrade -i https://mirrors.aliyun.com/pypi/simple/

配置API密钥(可选)

若需使用“多学术数据库检索”功能(如PubMed、IEEE Xplore),需获取对应数据库的API密钥,并配置到项目根目录的config.ini文件中:[Database] pubmed_api_key = 你的PubMed密钥 ieee_api_key = 你的IEEE Xplore密钥

PubMed API密钥:在https://www.ncbi.nlm.nih.gov/account/settings/申请

IEEE Xplore API密钥:在https://developer.ieee.org/申请

打开config.ini,按以下格式填写:启动工具

执行以下命令启动Web界面(默认端口为8501):streamlit run app.py --server.port 8501

启动成功后,命令行会显示“Local URL: http://localhost:8501”,打开浏览器访问该地址即可使用。

5.2.2 Docker部署(推荐快速上手用户)

拉取Docker镜像

打开命令行,执行以下命令拉取项目官方Docker镜像(假设镜像名为hkuds/ai-researcher):docker pull hkuds/ai-researcher:latest

若拉取速度慢,可配置Docker国内镜像源(如阿里云、网易云)。

运行Docker容器

执行以下命令启动容器,映射端口(本地端口8501映射到容器端口8501),并挂载本地文件夹(用于存储数据,如D:\AI-Researcher-Data):# Windows docker run -p 8501:8501 -v D:\AI-Researcher-Data:/app/data hkuds/ai-researcher:latest # macOS/Linux docker run -p 8501:8501 -v ~/AI-Researcher-Data:/app/data hkuds/ai-researcher:latest

-p 8501:8501:端口映射,确保本地能访问容器内的Web界面-v 本地路径:/app/data:数据挂载,本地文件夹与容器内数据文件夹同步,避免容器删除后数据丢失访问工具

打开浏览器,输入http://localhost:8501,即可进入AI-Researcher的Web界面,无需额外配置。

5.3 基础操作流程(以“文献分析+实验代码生成”为例)

步骤1:文献检索与分析

打开Web界面,点击左侧菜单栏“文献管理→文献检索”;

在输入框中输入自然语言查询(如“2020-2024年基于Transformer的乳腺癌影像诊断研究”),选择需对接的数据库(如“PubMed+IEEE Xplore”),点击“检索”;

检索完成后,工具会显示文献列表(含标题、作者、期刊、引用量),可按“引用量”排序;

点击某篇文献的“查看摘要”,工具自动生成核心信息(背景、方法、结果、结论);点击“导出引用”,选择“APA格式”,即可下载引用文本(可直接复制到论文中)。

步骤2:实验代码生成

点击左侧菜单栏“实验自动化→代码生成”;

在输入框中输入实验需求(如“用PyTorch实现基于Transformer的乳腺癌影像分类,数据集为CBIS-DDSM,batch size=32,学习率=0.001”);

选择“代码风格”(如“带详细注释”“简洁版”),点击“生成代码”;

代码生成后,可在线查看(含数据加载、模型定义、训练循环、评估函数),点击“下载代码”保存为

train.py文件;若需运行代码,点击“生成环境配置脚本”,获取

requirements.txt与run.sh(一键启动训练)。

相关链接

总结

AI-Researcher是HKUDS团队开发的开源科研全流程AI辅助工具,聚焦传统科研中的“耗时、低效、难复现”痛点,通过智能文献管理、实验自动化、科研数据治理、协作与成果管理四大模块,为科研新手、资深研究者、科研团队等提供多场景支持;其技术架构轻量化且可扩展,核心技术栈采用科研领域成熟工具(如PyTorch、Streamlit),关键算法经场景化优化(如混合文献检索、贝叶斯参数调优),确保功能实用与稳定;工具支持本地部署与Docker部署,操作流程简单,且提供完整的官方文档与社区支持;作为开源项目,其不仅免费开放源代码,还允许用户自定义扩展功能,助力科研人员减少重复性工作时间,将更多精力投入到实验设计、理论推导等核心创新环节,是科研领域一款极具实用价值的AI辅助工具。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/ai-researcher.html