Audio2Face-3D:NVIDIA 开源的音频驱动 3D 面部动画生成框架

Audio2Face-3D 是什么

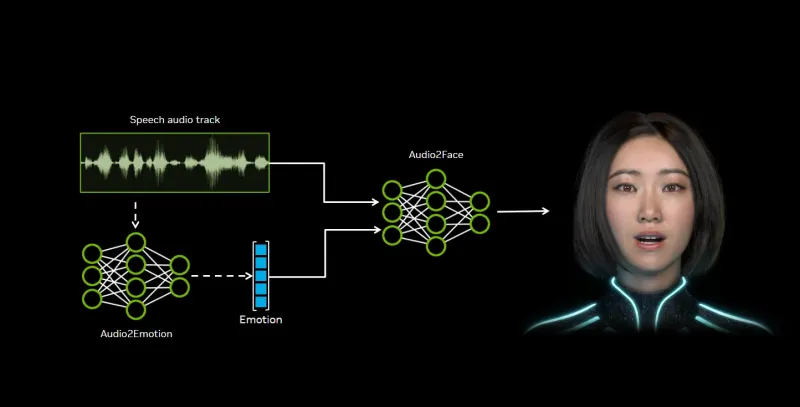

Audio2Face-3D 是 NVIDIA 开源的音频驱动 3D 面部动画生成框架,能够从语音音频实时生成高精度的 3D 面部动画,包括精确的唇形同步、表情变化和情感驱动。该项目提供了从训练、推理到集成的完整工具链,支持离线批处理和实时流处理,可广泛应用于游戏开发、虚拟主播、影视动画、教育培训等领域。

与传统的面部动画制作方法相比,Audio2Face-3D 具有以下优势:

自动化:无需手动制作口型同步,大大减少了动画师的工作量

实时性:支持实时音频流处理,延迟低至几十毫秒

高精度:能够生成精细的面部细节,包括微表情和皮肤变形

多平台:支持多种 3D 软件和游戏引擎集成

Audio2Face-3D 不仅是一个工具,更是一个完整的技术框架,包含了从模型训练、推理到应用集成的各个环节。

功能特色

1. 核心功能

| 功能 | 描述 | 应用场景 |

|---|---|---|

| 音频驱动面部动画 | 将输入的音频信号转换为对应的面部动作,实现精确的唇形同步 | 游戏角色、虚拟主播、影视配音 |

| 情感推断与表达 | 从语音中分析情绪状态(如高兴、悲伤、惊讶等),并在面部动画中体现 | 虚拟人交互、情感计算研究 |

| 多语言支持 | 支持多种语言的唇形同步,包括英语、中文、日语等 | 国际化内容制作、多语言虚拟助手 |

| 实时处理 | 支持低延迟的实时音频流处理,可用于实时互动场景 | 实时直播、视频会议、虚拟演出 |

| 离线批处理 | 支持对预录制音频进行批处理,生成高质量面部动画 | 影视后期、动画制作、内容生成 |

2.2. 技术特色

| 技术特色 | 描述 | 优势 |

|---|---|---|

| 双模型架构 | 采用回归模型(v2.3)和扩散模型(v3.0)两种架构,满足不同需求 | 回归模型速度快,扩散模型质量高 |

| 高精度面部细节 | 能够生成包括舌头、眼睛在内的完整面部动作,以及皮肤的细微变形 | 动画更加逼真自然 |

| 标准化输出 | 输出标准化的面部动作数据,便于与各种 3D 角色模型集成 | 提高了兼容性和可扩展性 |

| 跨平台支持 | 支持 Windows、Linux 等操作系统,可在本地或云端部署 | 适应不同的工作环境和需求 |

| 多引擎集成 | 提供 Unreal Engine、Maya 等主流 3D 软件的插件 | 无缝融入现有工作流 |

3. 技术细节

1. 系统架构

Audio2Face-3D 的系统架构主要包括以下几个部分:

音频分析模块:负责提取音频中的关键特征,包括:

频谱特征(梅尔频谱图)

韵律特征(音高、能量等)

语音内容特征

面部动画生成模块:基于深度学习模型,将音频特征转换为面部动作参数:

回归模型(v2.3):采用 Transformer 架构,直接预测面部动作参数

扩散模型(v3.0):采用基于扩散过程的生成模型,生成更高质量的面部动画

面部动作驱动模块:将生成的面部动作参数应用到 3D 角色模型上:

直接网格变形

关节变换

混合形状(Blendshape)权重控制

2. 模型架构

2.1 回归模型(v2.3)

回归模型采用了改进的 Transformer 架构,主要包括:

编码器:处理音频特征序列,提取高级语义表示

解码器:生成对应的面部动作序列

注意力机制:捕捉音频和面部动作之间的长程依赖关系

该模型优势在于速度快,适合实时应用场景,但在细节表现上稍逊于扩散模型。

2.2 扩散模型(v3.0)

扩散模型采用了基于去噪扩散概率模型(DDPM)的架构,主要特点包括:

多步迭代:通过多步去噪过程逐步生成高质量的面部动画

噪声预测:模型学习预测添加到真实数据中的噪声

条件生成:以音频特征为条件,生成符合语音内容的面部动作

扩散模型生成的动画质量更高,细节更丰富,但计算成本也更高,适合离线高质量内容制作。

3. 数据处理流程

Audio2Face-3D 的数据处理流程包括:

数据准备:收集音频-面部动作配对数据

特征提取:从音频中提取梅尔频谱图等特征

数据预处理:标准化音频和面部动作数据

模型训练:使用准备好的数据集训练模型

推理生成:将新的音频输入到训练好的模型中,生成面部动作数据

动画驱动:将生成的面部动作数据应用到 3D 角色模型上

4. 性能优化

为了提高性能,Audio2Face-3D 采用了多种优化技术:

模型量化:使用 INT8 量化减少模型大小和计算量

TensorRT 加速:利用 NVIDIA TensorRT 进行推理加速

多线程处理:并行处理音频和动画生成任务

流式处理:采用滑动窗口技术处理长音频流

应用场景

Audio2Face-3D 适用于多种应用场景,包括但不限于:

1. 游戏开发

| 应用点 | 描述 | 优势 |

|---|---|---|

| 角色语音动画 | 自动为游戏角色生成与语音匹配的面部动画 | 减少动画制作成本,提高开发效率 |

| 实时对话系统 | 在游戏对话中实时生成角色面部动画 | 增强游戏沉浸感和真实感 |

| 动态剧情生成 | 根据动态生成的对话内容实时生成面部动画 | 支持更加丰富多变的游戏剧情 |

2. 虚拟主播与直播

| 应用点 | 描述 | 优势 |

|---|---|---|

| 实时面部捕捉 | 无需专业的面部捕捉设备,仅通过麦克风输入即可生成面部动画 | 降低入门门槛,扩大虚拟主播群体 |

| 个性化虚拟形象 | 为不同主播创建独特的虚拟形象和表情风格 | 增强品牌识别度和观众粘性 |

| 多平台直播 | 支持同时在多个平台进行虚拟形象直播 | 扩大影响力和覆盖面 |

3. 影视动画制作

| 应用点 | 描述 | 优势 |

|---|---|---|

| 配音自动化 | 自动为配音生成对应的口型动画 | 大大减少后期制作时间和成本 |

| 角色表情设计 | 辅助动画师设计角色表情和情绪变化 | 提高动画质量和一致性 |

| 虚拟角色制作 | 创建完全由 AI 驱动的虚拟角色 | 拓展影视创作的可能性 |

4. 教育培训

| 应用点 | 描述 | 优势 |

|---|---|---|

| 虚拟教师 | 创建能够进行自然交流的虚拟教师形象 | 提供更加生动的学习体验 |

| 多语言教学 | 支持多种语言的虚拟教师,实现国际化教育 | 打破语言障碍,促进教育公平 |

| 情感化学习 | 通过虚拟教师的情感表达增强学习效果 | 提高学生的学习兴趣和参与度 |

安装使用方法

1. 环境准备

使用 Audio2Face-3D 需要以下环境:

硬件要求:

NVIDIA GPU(推荐 RTX 3060 或更高)

至少 8GB RAM

10GB 以上可用硬盘空间

软件要求:

Windows 10/11 或 Linux(Ubuntu 20.04/22.04)

Python 3.8-3.10

CUDA 11.7 或更高版本

PyTorch 1.13 或更高版本

2. 安装步骤

克隆仓库

git clone https://github.com/NVIDIA/Audio2Face-3D.git cd Audio2Face-3D

创建虚拟环境

python -m venv venv source venv/bin/activate # Linux/Mac venv\Scripts\activate # Windows

安装依赖

pip install -r requirements.txt

下载预训练模型

python scripts/download_models.py

3. 基本使用示例

3.1 离线处理

from audio2face3d import Audio2Face3D

# 初始化模型

a2f = Audio2Face3D(model_version="v3.0")

# 处理音频文件

animation_data = a2f.process_audio("input.wav")

# 保存结果

a2f.save_animation(animation_data, "output.fbx")3.2 实时处理

import pyaudio from audio2face3d import Audio2Face3D # 初始化模型 a2f = Audio2Face3D(model_version="v2.3", realtime=True) # 配置音频输入 p = pyaudio.PyAudio() stream = p.open(format=pyaudio.paFloat32, channels=1, rate=16000, input=True, frames_per_buffer=1024) # 实时处理音频流 while True: data = stream.read(1024) animation_frame = a2f.process_frame(data) # 将 animation_frame 应用到你的 3D 角色上

4. 集成到 3D 软件

4.1 Unreal Engine 集成

在 Unreal Engine 中创建新项目或打开现有项目

下载并安装 Audio2Face-3D UE 插件

在插件设置中配置 Audio2Face-3D 服务器地址

将 Audio2Face3D 组件添加到你的角色上

配置音频输入源(麦克风或音频文件)

运行项目,角色将根据音频自动生成面部动画

4.2 Maya 集成

安装 Maya ACE (MACE) 插件

在 Maya 中加载插件

连接到 Audio2Face-3D 服务

选择要驱动的角色模型

开始音频输入,模型将实时生成面部动画

常见问题解答

Q1: Audio2Face-3D 支持哪些 3D 模型格式?

A1: Audio2Face-3D 支持多种常见的 3D 模型格式,包括 FBX、OBJ、GLB/GLTF 等。对于特定格式的模型,可能需要进行一些预处理才能获得最佳效果。

Q2: 模型的延迟是多少?适合实时应用吗?

A2: 使用回归模型(v2.3)时,在 RTX 3060 上的延迟通常在 50-100 毫秒范围内,完全适合实时应用。扩散模型(v3.0)由于计算复杂度较高,延迟会更高,更适合离线处理。

Q3: 可以自定义角色的表情风格吗?

A3: 是的,Audio2Face-3D 支持通过微调模型来适应特定角色的表情风格。你需要准备该角色的音频-表情配对数据,然后使用训练框架进行微调。

Q4: 支持中文等非英语语言吗?

A4: 是的,Audio2Face-3D 支持多种语言,包括中文、日语、韩语等。预训练模型已经包含了多语言支持,对于特定语言,你也可以使用该语言的数据进行微调以获得更好的效果。

Q5: 如何提高生成动画的质量?

A5: 提高动画质量的方法包括:

使用更高质量的音频输入

调整模型参数,如采样率和窗口大小

对特定角色进行微调

结合其他面部捕捉技术进行混合驱动

Q6: 可以在云端部署 Audio2Face-3D 吗?

A6: 是的,Audio2Face-3D 提供了 Docker 容器化部署方案,可以轻松部署到云端服务器。NVIDIA 还提供了 Audio2Face-3D NIM,专门用于大规模和多用户部署。

Q7: 项目的许可证是什么?可以用于商业项目吗?

A7: Audio2Face-3D 的不同组件有不同的许可证:

SDK 和插件:MIT 许可证,允许商业使用

训练框架:Apache 许可证,允许商业使用

预训练模型:NVIDIA Open Model 许可证,允许商业使用

NIM:NVIDIA 软件许可协议,需要遵守特定条款

Q8: 对硬件有什么特殊要求?

A8: Audio2Face-3D 需要 NVIDIA GPU 才能运行,推荐使用 RTX 3060 或更高性能的显卡。CPU 和内存要求相对较低,但为了获得最佳性能,建议使用多核 CPU 和至少 16GB RAM。

相关链接

GitHub 仓库: https://github.com/NVIDIA/Audio2Face-3D

Hugging Face 模型库:

数据集: https://huggingface.co/datasets/nvidia/Audio2Face-3D-Dataset-v1.0.0-claire

总结

Audio2Face-3D 是一个功能强大、灵活且易于集成的音频驱动 3D 面部动画生成工具。它通过先进的深度学习技术,能够从音频信号中实时生成高精度的面部动画,包括精确的唇形同步和情感表达。项目提供了完整的工具链,从模型训练、推理到应用集成,满足了不同场景下的需求。无论是游戏开发、虚拟主播、影视动画还是教育培训,Audio2Face-3D 都能提供高质量、高效率的面部动画解决方案。其开源特性也为开发者和研究人员提供了良好的学习和扩展平台,有望在未来推动面部动画技术的进一步发展。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/audio2face-3d.html