Baichuan-M3-235B:百川智能推出的 2350 亿参数级专业医疗大模型

一、Baichuan-M3-235B是什么

Baichuan-M3-235B是百川智能于2026年1月正式发布并开源的新一代医疗增强大语言模型,属于百川医疗大模型系列的升级版本,前序产品为Baichuan-M2-32B。该模型拥有2350亿参数规模,是当前全球范围内针对严肃医疗场景设计的参数规模大、性能表现领先的开源医疗大模型。

与传统医疗问答模型仅聚焦于“知识输出”不同,Baichuan-M3-235B的核心定位是构建可信赖的临床决策辅助系统,从“被动回答用户问题”转向“主动模拟医生进行严肃问诊”,通过多轮结构化交互收集关键诊疗信息,再基于完整信息开展深度医学推理,最终输出符合循证医学原则的结论与建议。

该模型并非通用大模型的简单医疗微调版本,而是从训练目标、评测体系、交互逻辑三个维度围绕医疗场景进行系统性重构,其设计初衷是解决传统医疗AI存在的回答模糊、幻觉率高、部署成本高、无法适配真实临床流程等核心痛点,推动医疗AI从“知识工具”向“专业服务能力”演进。目前,Baichuan-M3-235B已集成至百川智能旗下医疗应用“百小应”,并面向医生与患者开放试用,同时遵循Apache 2.0开源协议,支持科研、教学与商业场景的二次开发。

二、功能特色

Baichuan-M3-235B围绕医疗场景的核心需求,打造了四大核心功能特色,覆盖“性能表现、交互能力、可靠性、部署效率”四大维度,且各项能力均通过权威评测与真实临床场景验证,具体如下:

(一)全球领先的医疗评测性能

Baichuan-M3-235B在当前全球最权威的医疗大模型评测集HealthBench及其高难度子集HealthBench Hard中均取得全球第一的成绩,首次在医疗领域实现对OpenAI GPT-5.2的全面超越,成为当前全球医疗沟通与推理能力最强的开源医疗大模型。

HealthBench综合得分65.1分:该评测集由262名来自60个国家的医生共同构建,包含5000组高保真真实医疗对话,覆盖问诊、风险评估、医学解释、临床推理等全流程任务,是衡量医疗大模型性能的“黄金标准”。

HealthBench Hard得分44.4分:该子集聚焦复杂临床决策问题,此前行业平均水平仅处于及格线附近,Baichuan-M3-235B的成绩实现了“断崖式领先”。

SCAN-bench全维度登顶:在百川智能自研的端到端医疗评测集SCAN-bench中,该模型是唯一在病史采集、实验室检查、疾病诊断三大核心维度均排名第一的模型,且各项能力显著高于人类医生基线水平。

(二)原生端到端的严肃问诊能力

这是Baichuan-M3-235B最核心的突破点,区别于传统模型的“角色扮演式问诊”,该模型具备内生的临床问诊思维,能像真实医生一样完成从接诊到信息收集的全流程交互,核心遵循SCAN原则(Safety Stratification安全分层、Clarity Matters信息澄清、Association & Inquiry关联追问、Normative Protocol规范化输出),将临床问诊的经验性思维“白盒化”。

主动风险分层:面对用户模糊的症状描述,模型会优先排查危急重症相关信号,而非直接输出常规诊断建议,符合医疗“安全第一”的核心原则。

结构化信息澄清:通过多轮针对性追问,将用户的主观描述(如“我肚子痛”)转化为结构化临床信息(如“腹痛位置在左上腹、持续时间2小时、伴随恶心呕吐”)。

有限轮次高效问诊:基于SPAR算法优化,模型能在有限对话轮次内问全、问准关键信息,避免冗余提问,问诊准确度每提升2%,后续诊疗结果准确度可提升1%。

(三)全球最低的医疗幻觉率(3.5%)

幻觉是医疗AI落地的核心障碍,可能导致错误的诊断建议与安全风险。Baichuan-M3-235B通过内化式事实约束,在不依赖外部检索工具的前提下,将医疗幻觉率降至3.5%,成为当前公开评测中幻觉率最低的医疗大模型,且显著优于GPT-5.2。

事实感知训练:将医学事实一致性纳入强化学习的核心训练目标,让模型在生成回答时持续受到权威医学证据的约束,而非仅通过后处理纠错。

知边界、敢说“不知道”:面对知识边界外的复杂病例,模型不会生成不确定性结论,而是主动给出风险提示与就医建议,符合“知之为知之,不知为不知”的医疗原则。

细粒度事实校验:模型输出会被拆解为可验证的原子医学声明,逐条对照权威医学指南与证据,从根源上减少“一本正经的胡说八道”。

(四)高效部署与推理优化

尽管拥有2350亿超大参数规模,但Baichuan-M3-235B通过量化与推理加速技术,大幅降低了部署门槛与显存占用,兼顾性能与实用性:

W4量化方案:采用4比特量化技术,相比全精度模型,显存占用降低74%,仅需原显存的26%即可实现推理。

Gated Eagle3投机解码:搭配该解码技术后,推理速度提升96%,大幅缩短大参数模型的响应时间。

多版本适配:官方提供全精度版本与GPTQ-INT4量化版本,量化版本可在消费级显卡(如RTX 4090)上实现本地部署,无需依赖大型分布式集群。

三、技术细节

Baichuan-M3-235B的技术体系围绕医疗场景的痛点设计,核心包含模型训练范式、核心算法、幻觉抑制机制、推理优化技术四大模块,是一套从“训练”到“落地”的全链路解决方案,具体细节如下:

(一)三阶段多专家融合训练范式

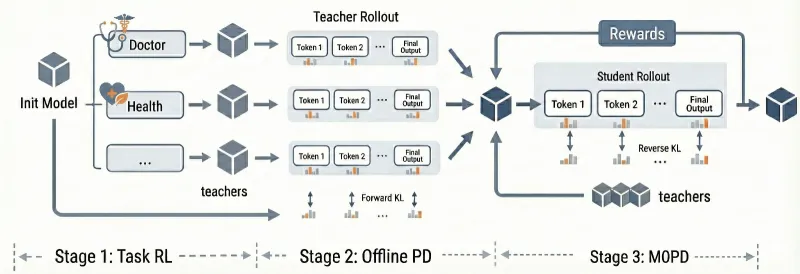

为兼顾模型效果与训练效率,Baichuan-M3-235B采用“分阶段、多专家”的训练策略,区别于传统大模型的单一训练流程,该范式更贴合医疗知识的专业性与复杂性特征:

第一阶段:领域专项强化学习(RL)

基于海量权威医学数据(包括医学指南、临床病例、诊疗规范等)进行专项预训练,同时引入150多位一线医生的人工标注数据,让模型掌握基础的医学知识与临床逻辑。此阶段核心解决“模型懂医学”的问题。第二阶段:离线蒸馏

将大参数模型的医疗能力蒸馏至中小参数分支,同时保留核心推理能力,为后续轻量化部署打下基础。此阶段核心解决“模型效率”的问题。第三阶段:MOPD在线优化

引入动态Verifier System(动态验证系统),替代传统的静态评分规则,根据模型能力的提升持续调整监督信号,让模型在训练过程中不断适应更复杂的临床场景,避免“刷评测”式的能力提升。此阶段核心解决“模型泛化能力”的问题。

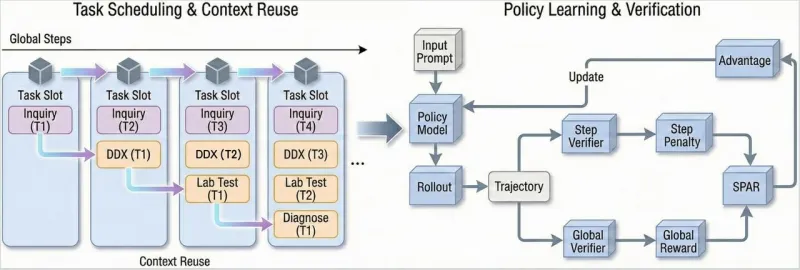

(二)核心算法:SPAR与SCAN原则

两大核心算法是Baichuan-M3-235B实现“严肃问诊”的关键,分别解决“长对话训练稳定性”与“问诊逻辑标准化”的问题:

SPAR算法(Step-Penalized Advantage with Relative baseline)

中文名为分段流水线强化学习算法,针对传统GRPO算法无法稳定进行长对话训练的痛点设计。该算法将临床诊疗流程解耦为病史采集、鉴别诊断、检验检查、精确诊断四个阶段,通过“过程级奖励”实现精准的信用分配,解决医疗长交互链路中的“奖励稀疏”问题,让模型在每一个诊疗阶段都能得到针对性的优化反馈。SCAN原则

并非传统意义上的算法,而是一套临床问诊行为准则,是Baichuan-M3-235B的“问诊思维框架”。通过将安全分层、信息澄清、关联追问、规范化输出四个维度的要求融入模型训练,让模型摆脱“角色扮演”的表层交互,形成内生的临床问诊逻辑。例如,在安全分层维度,模型会优先提问“是否有胸痛、呼吸困难等症状”,排除心脑血管急症后,再进行常规症状排查。

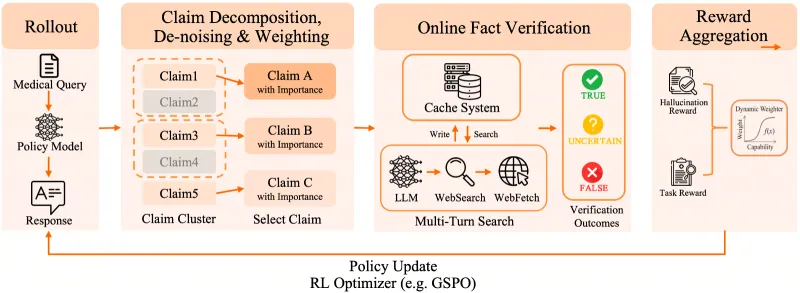

(三)幻觉抑制机制:Fact-Aware RL框架

Baichuan-M3-235B采用Fact-Aware RL(事实感知强化学习) 框架,从模型训练阶段就实现幻觉抑制,而非依赖外部工具补充,这是其幻觉率全球最低的核心技术支撑:

事实校验模块内置:在强化学习循环中,嵌入基于权威医学证据的在线幻觉检测模块,模型生成的每一条医学结论都会实时与权威数据库进行比对。

动态奖励聚合:将“事实一致性”作为核心奖励指标,若模型生成幻觉内容,会受到负向奖励惩罚;若能准确引用医学证据或主动声明知识边界,会得到正向奖励。

医学证据库迭代:关联最新的医学指南与临床研究成果,让事实校验模块的内容持续更新,保证模型输出与当前医疗共识一致。

(四)推理与部署优化技术

针对2350亿参数的大模型部署难题,Baichuan-M3-235B采用多项优化技术,大幅降低使用门槛,具体技术细节如下表所示:

| 优化技术 | 核心作用 | 效果提升 | 适用场景 |

|---|---|---|---|

| W4量化方案 | 降低显存占用 | 显存占用减少74%,仅需原显存的26% | 私有化部署、本地推理 |

| Gated Eagle3投机解码 | 提升推理速度 | 推理加速96%,缩短响应时间 | 在线交互场景、实时问诊 |

| GPTQ-INT4量化版本 | 轻量化部署 | 支持消费级显卡(如RTX 4090)本地运行 | 个人科研、小型医疗机构 |

| 分布式集群适配 | 全精度模型部署 | 支持8×A100 80GB/H100集群,TB级内存适配 | 大型医疗平台、企业级应用 |

四、应用场景

Baichuan-M3-235B遵循“辅助而非替代”的医疗AI原则,其能力边界聚焦于“医疗信息处理、临床流程辅助、医学知识传播”,不涉及直接的疾病诊断与治疗决策,核心应用场景可分为面向患者、面向医疗从业者、面向科研与教育三大类,具体如下:

(一)面向患者:健康咨询与就医辅助

这是Baichuan-M3-235B最贴近大众的应用场景,核心解决患者“就医前信息梳理”与“日常健康咨询”的需求,避免因信息不对称导致的就医效率低下问题:

症状初步梳理:患者可通过自然语言向模型描述身体不适,模型通过多轮追问将模糊的症状转化为结构化信息,并生成“病情摘要”,患者可将该摘要带给线下医生,帮助医生快速掌握病情,减少问诊时间。

日常健康指导:针对饮食、运动、慢病管理等日常健康问题,模型可输出符合循证医学的建议,例如“高血压患者的低盐饮食方案”“糖尿病患者的运动注意事项”等。

就医路径指引:根据患者的症状与病史,模型可给出合理的就医科室建议,避免患者“挂错号、跑错科”。

医疗知识科普:用通俗易懂的语言解释医学术语、疾病原理、检查项目意义等,例如“什么是血常规?各项指标代表什么?”,提升患者的医疗认知水平。

(二)面向医疗从业者:临床决策与工作效率辅助

针对医生、护士等医疗从业者,Baichuan-M3-235B可作为临床辅助工具,帮助从业者提升工作效率,聚焦核心的诊疗决策工作:

诊疗思路推演:医生可将疑难病例的信息输入模型,模型可输出可能的鉴别诊断方向、需要完善的检查项目等,为医生的诊疗决策提供参考(非替代决策)。

医疗文书辅助:基于临床数据自动生成病历、病程记录等医疗文书的初稿,医生可在此基础上进行修改完善,减少文书撰写的时间成本。

医学指南查询与解读:模型可快速检索并解读最新的医学指南,例如“2025版高血压诊疗指南的更新要点”,帮助医生及时掌握行业最新进展。

临床风险提醒:在诊疗过程中,模型可针对特定病例给出潜在的风险提示,例如“老年糖尿病患者使用某药物的低血糖风险”,辅助医生做好风险防控。

(三)面向科研与教育:医学研究与人才培养

Baichuan-M3-235B的开源特性使其成为医学科研与教育的重要工具,推动医疗AI技术的创新与医学人才的培养:

医疗AI算法研究:科研人员可基于该模型的开源代码与权重,开展医疗大模型的微调、优化、创新算法研究,例如针对特定专科(如心血管、肿瘤)的模型定制化开发。

临床病例分析:模型可对海量临床病例进行结构化分析与挖掘,帮助科研人员发现疾病的发病规律、治疗效果关联因素等,为医学研究提供数据支撑。

医学教育实训:针对医学生与年轻医生,模型可模拟标准化病人进行问诊实训,帮助学习者提升问诊能力与临床思维;同时,模型可作为“医学知识问答助手”,解答学习者的专业问题。

医疗知识图谱构建:基于模型的医学知识储备,可辅助构建或更新医疗知识图谱,为医疗大数据分析与智能决策提供基础。

五、使用方法

Baichuan-M3-235B的使用方式分为快速体验与本地部署/二次开发两种,前者适合普通用户与开发者快速验证模型能力,后者适合有定制化需求的企业与科研机构。官方提供了基于Hugging Face的标准化调用方式,同时支持量化版本的轻量化部署,具体操作步骤如下:

(一)快速体验:在线试用

普通用户无需部署模型,可通过百川智能官方推出的医疗应用百小应(ying.ai)快速体验Baichuan-M3-235B的核心能力,操作步骤如下:

打开浏览器,访问网址:https://ying.ai/;

无需注册,直接在对话框中输入健康问题或症状描述(例如“我最近总是失眠,该怎么办?”);

模型会通过多轮追问与用户交互,最终输出对应的健康建议或信息梳理结果;

医生用户可通过实名认证后,解锁更多临床辅助功能(如诊疗思路推演、医学指南查询)。

(二)本地部署/二次开发:基于Hugging Face调用

该方式适合开发者与科研人员,需具备一定的Python编程基础与硬件资源,核心分为环境准备、模型加载、推理调用三个步骤,同时需注意硬件配置要求(参考表1)。

1. 环境准备

首先搭建模型运行的基础环境,推荐使用Python 3.8及以上版本,核心依赖库包括PyTorch、Transformers、Accelerate等,具体命令如下:

# 安装Python依赖库 pip install torch==2.1.0 transformers==4.36.0 accelerate==0.25.0 sentencepiece==0.1.99 # 若使用量化版本,需额外安装GPTQ相关库 pip install auto-gptq==0.7.1

硬件配置需根据使用的模型版本调整,具体要求如下:

全精度版本(235B):需分布式集群(8×A100 80GB或H100),TB级内存,InfiniBand网络支持;

GPTQ-INT4量化版本:消费级显卡(如RTX 4090 24GB)或专业级显卡(如A10G 24GB),32GB及以上内存;

操作系统:支持Windows 10及以上、Mac OS 12及以上、Linux(Ubuntu 18.04及以上)。

2. 模型加载

通过Hugging Face的AutoModelForCausalLM与AutoTokenizer加载模型与分词器,官方提供了模型权重的开源地址,需设置trust_remote_code=True以支持自定义代码,具体代码如下:

# 加载全精度版本

from transformers import AutoTokenizer, AutoModelForCausalLM

# 初始化分词器

tokenizer = AutoTokenizer.from_pretrained("baichuan-inc/Baichuan-M3-235B", trust_remote_code=True)

# 初始化模型,开启分布式训练加速

model = AutoModelForCausalLM.from_pretrained(

"baichuan-inc/Baichuan-M3-235B",

trust_remote_code=True,

device_map="auto", # 自动分配设备

torch_dtype=torch.bfloat16 # 使用bf16精度,降低显存占用

)

# 加载GPTQ-INT4量化版本(推荐轻量化部署使用)

# model = AutoModelForCausalLM.from_pretrained(

# "baichuan-inc/Baichuan-M3-235B-GPTQ-INT4",

# trust_remote_code=True,

# device_map="auto"

# )3. 推理调用

模型加载完成后,可通过自然语言输入进行推理调用,核心是将输入文本编码为张量,经过模型生成后再解码为自然语言输出,同时可设置生成参数(如最大长度、温度、top_p等)调整输出效果,具体代码如下:

# 定义输入问题(医疗相关) prompt = "患者,男,30岁,突发头痛2小时,伴随恶心、呕吐,无肢体麻木,请问需要优先排查哪些疾病?" # 编码输入文本 inputs = tokenizer(prompt, return_tensors="pt").to(model.device) # 模型生成输出 outputs = model.generate( **inputs, max_new_tokens=512, # 最大生成长度 temperature=0.7, # 生成多样性,数值越低越严谨 top_p=0.95, # 核采样 do_sample=True, num_return_sequences=1 ) # 解码并打印结果 response = tokenizer.decode(outputs[0], skip_special_tokens=True) print(response)

运行上述代码后,模型会输出对应的医学推理结果,例如优先排查颅内出血、偏头痛、高血压急症等疾病,并给出进一步的检查建议。

4. 多轮对话调用

针对“严肃问诊”的多轮交互场景,可通过循环输入实现多轮对话,核心是保留历史对话上下文,具体代码示例如下:

# 初始化历史对话

history = []

while True:

# 用户输入

user_input = input("请输入你的问题(输入q退出):")

if user_input.lower() == "q":

break

# 构建对话上下文

prompt = "\n".join([f"用户:{h[0]}\n模型:{h[1]}" for h in history]) + f"\n用户:{user_input}\n模型:"

# 编码与生成

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=256, temperature=0.6, top_p=0.9)

response = tokenizer.decode(outputs[0], skip_special_tokens=True).split("模型:")[-1]

# 打印并保存历史对话

print(f"模型:{response}")

history.append((user_input, response))

六、常见问题解答

Q:Baichuan-M3-235B与传统医疗问答机器人有什么区别?

A:传统医疗问答机器人是“知识库检索工具”,只能根据用户问题匹配预设的答案,无法主动追问与推理;而Baichuan-M3-235B是生成式大模型,具备内生的临床思维,能通过多轮对话收集信息,再基于完整信息进行医学推理,交互方式更接近真实医生,且回答的灵活性与准确性更高。

Q:Baichuan-M3-235B可以替代医生进行疾病诊断吗?

A:不可以。官方明确说明,该模型的定位是“医疗辅助工具”,而非替代医生的诊疗决策。其输出结果仅可作为参考,不能作为疾病诊断、治疗方案制定的依据。在任何情况下,用户都应优先咨询专业医生的意见。

Q:Baichuan-M3-235B的训练数据来源是什么?是否符合医疗数据隐私要求?

A:模型的训练数据主要包括公开的权威医学指南、临床诊疗规范、医学期刊论文、匿名化的临床病例等,所有数据均经过脱敏处理,符合《个人信息保护法》与医疗数据隐私相关规定,未使用任何未授权的个人医疗信息。

Q:普通电脑能否运行Baichuan-M3-235B?

A:全精度235B版本无法在普通电脑上运行,需要大型分布式集群;但GPTQ-INT4量化版本可在配备高端消费级显卡(如RTX 4090 24GB)的电脑上运行,具体要求为显卡显存≥24GB、内存≥32GB、固态硬盘(SSD)≥100GB(用于存储模型权重)。

Q:部署过程中出现“显存不足”的错误,该如何解决?

A:可通过以下方式解决:① 切换至GPTQ-INT4量化版本,这是最有效的方式;② 开启模型的低精度推理(如使用torch.bfloat16或torch.float16);③ 减少生成的最大长度(max_new_tokens);④ 若使用多卡环境,开启分布式训练(device_map="auto")。

Q:模型生成的回答存在延迟,如何提升推理速度?

A:① 采用Gated Eagle3投机解码技术,官方代码已集成该功能,可在生成时开启;② 使用量化版本,量化后的模型推理速度远快于全精度版本;③ 优化硬件配置,使用更高性能的显卡(如A100、H100);④ 减少生成参数的多样性(如降低temperature值)。

Q:Baichuan-M3-235B支持哪些专科的医疗咨询?

A:模型覆盖全科医疗的核心能力,包括内科、外科、妇产科、儿科、皮肤科等常见专科的基础问诊与推理能力,同时对心血管、神经、消化等重点专科的支持更为深入。但对于罕见病、疑难重症,模型的能力有限,会主动提示用户咨询专科医生。

Q:模型的幻觉率为3.5%,是否意味着其回答100%可靠?

A:3.5%的幻觉率是基于权威评测集的统计结果,并不代表在所有场景下的回答均100%可靠。医疗场景复杂多变,个体病例存在差异,因此模型的输出结果仍需医疗专业人员的审核与验证,不可直接作为诊疗依据。

Q:Baichuan-M3-235B是否支持多语言?

A:目前模型的核心能力聚焦于中文医疗场景,对英文医疗内容的支持有限。官方表示后续会逐步升级多语言能力,但当前优先优化中文临床场景的性能。

七、相关链接

Hugging Face全精度模型权重:https://huggingface.co/baichuan-inc/Baichuan-M3-235B

Hugging Face量化模型权重:https://huggingface.co/baichuan-inc/Baichuan-M3-235B-GPTQ-INT4

在线体验入口(百小应):https://ying.ai/

八、总结

Baichuan-M3-235B是百川智能开源的2350亿参数级医疗增强大语言模型,也是当前全球性能领先的开源医疗大模型,其在HealthBench、HealthBench Hard、SCAN-bench等权威评测中均取得全球第一的成绩,医疗幻觉率低至3.5%,并首次实现了原生端到端的严肃问诊能力,核心遵循SCAN原则与SPAR算法,能模拟真实医生的临床思维进行多轮结构化交互。该模型并非通用大模型的简单医疗微调,而是从训练范式、评测体系、交互逻辑三个维度围绕医疗场景进行系统性重构,通过Fact-Aware RL框架实现内化式幻觉抑制,搭配W4量化与Gated Eagle3投机解码技术大幅降低部署门槛,量化版本可在消费级显卡上运行。Baichuan-M3-235B遵循Apache 2.0开源协议,支持商业与二次开发,应用场景覆盖患者健康咨询、医疗从业者临床辅助、医学科研与教育三大领域,其核心定位是“医疗辅助工具”,不可替代专业医生的诊疗决策,官方也通过在线应用“百小应”向大众开放了试用渠道。作为医疗大模型从“知识问答”走向“临床流程建模”的重要技术节点,Baichuan-M3-235B为医疗AI的落地提供了高性能、低幻觉、易部署的开源解决方案,推动了医疗AI向专业化、可信赖化的方向发展。

版权及免责申明:本文由@97ai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/baichuan-m3-235b.html