MiniCPM:面壁智能联合清华大学等开源的轻量级大语言模型,兼顾端云部署与高效推理

一、MiniCPM 是什么?

MiniCPM 是面壁智能(Modelbest Inc.)联合清华大学自然语言处理实验室(THUNLP)、中国人民大学高瓴人工智能学院共同研发的 轻量级大语言模型系列,对应的开源项目聚焦于该系列模型的全生命周期支持,包括模型开源发布、技术文档沉淀、推理部署工具集、量化优化方案及应用拓展组件等核心内容。

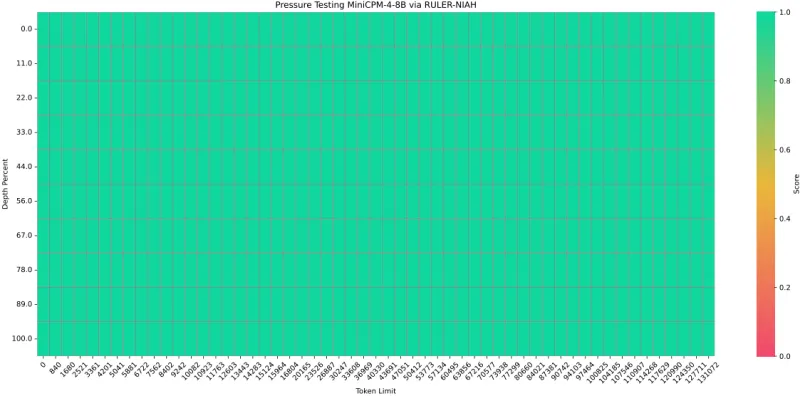

作为面向「轻量化、高效能、广适配」需求的大语言模型方案,MiniCPM 核心定位是解决传统大模型部署成本高、资源占用大、推理速度慢的痛点,同时保证模型性能不打折——在 4B(40 亿参数)及以下规模,实现对同级别主流模型的性能超越,甚至媲美 7B-9B 级模型,让大语言模型能力能够低成本落地到端侧设备(如 PC、边缘计算设备)和中小规模服务器。

二、功能特色

MiniCPM 开源项目的核心优势在于「轻量不轻质、高效且易用」,围绕模型性能、部署适配、应用拓展三大核心维度,形成了以下关键功能特色:

2.1 多版本迭代,性能与效率双优

项目涵盖 MiniCPM 1/2/3/4 及 4.1 等多个核心版本,同时衍生出轻量化、量化版等细分型号,满足不同资源场景需求,各版本核心优势如下表所示:

| 模型版本 | 参数规模 | 核心优势 | 适用场景 |

|---|---|---|---|

| MiniCPM 3 | 4B | 性能超越 Phi-3.5-mini-instruct、GPT-3.5-Turbo-0125,媲美 Llama3.1-8B-Instruct | 云端轻量化部署、中等复杂度任务 |

| MiniCPM 4 | 4B | 端侧推理加速 5 倍以上,支持混合推理模式(深度推理/非推理切换) | 端侧设备(PC、边缘设备)部署 |

| MiniCPM 4.1 | 4B | 推理效率进一步提升,工具调用能力增强,支持更多量化方案 | 端云通用、高并发推理场景 |

| MiniCPM 4-0.5B | 0.5B | 极致轻量化,资源占用极低 | 超低成本边缘设备、嵌入式场景 |

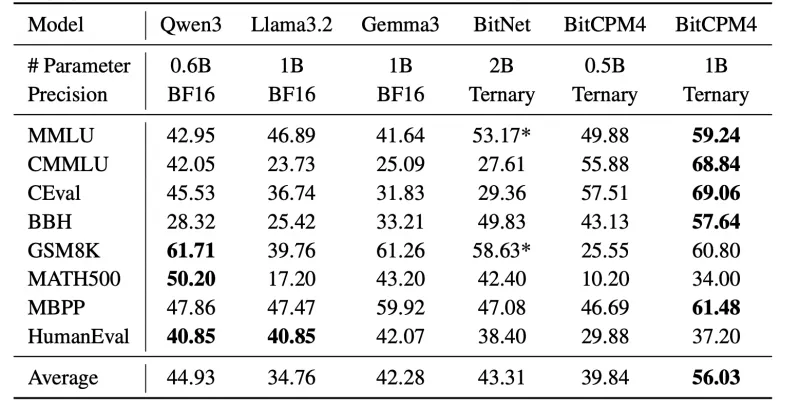

| BitCPM4-1B/0.5B | 1B/0.5B | 专属量化优化,兼顾性能与显存占用 | 低显存设备、轻量化推理任务 |

2.2 全场景部署适配,降低落地门槛

项目提供覆盖「云端-端侧」全场景的部署方案,支持多种主流推理框架,无需复杂定制即可快速上手,具体支持范围如下:

基础推理框架:兼容 HuggingFace Transformers、vLLM(支持投机采样加速,推理速度提升 2-3 倍)、SGLang、CPM.cu(面壁智能自研高效推理框架);

端侧部署方案:支持 llama.cpp、Ollama 部署,适配 Intel AIPC 客户端,可直接在 Windows、macOS 桌面设备运行;

跨硬件适配:兼容 x86、ARM 架构,支持 NVIDIA GPU、Intel CPU、AMD GPU 等多种硬件形态,无需针对性改码。

2.3 丰富量化优化方案,兼顾性能与资源

为进一步降低部署成本,项目提供多种成熟的量化优化方案,覆盖不同精度需求,具体如下表所示:

| 量化方案 | 核心优势 | 适用场景 |

|---|---|---|

| AWQ | 权重量化,显存占用降低 70% 以上,推理性能损失小于 5% | 中低显存 GPU 部署 |

| GPTQ | 支持 4bit/8bit 量化,适配主流 GPU,量化速度快 | 快速部署、中等资源场景 |

| Marlin | 极致量化优化,支持 2bit 低精度量化,资源占用最小 | 端侧低资源设备 |

| GGUF | 适配 llama.cpp 框架,专为端侧 CPU 推理优化 | 端侧 CPU 部署场景 |

| BitCPM4 专属量化 | 针对 BitCPM4 系列模型定制,量化后性能损失低于 3%,显存占用降低 80% 以上 | BitCPM4 模型专属部署 |

2.4 实用应用拓展,赋能落地场景

项目基于 MiniCPM 核心模型,延伸出多个高价值应用组件,降低开发者二次开发成本,核心拓展能力包括:

MiniCPM4-Survey:可信综述生成工具,支持学术论文、行业报告等长文本综述的自动生成,内置事实核查机制,提升内容可信度;

MiniCPM4-MCP:基于 Model Context Protocol 增强的工具调用能力,支持 Airbnb 预订、高德地图查询、计算器、GitHub 代码查询等数十种工具调用,公开详细评测数据与调用示例;

稀疏模型探索:提供 MiniCPM-S-1B 稀疏模型,实现 FFN 层 87.89% 平均稀疏度,降低 84% FFN 计算量的同时,保持下游任务性能不下降,适配高并发低延迟场景。

2.5 易用性优化,降低使用门槛

项目提供完善的技术文档与示例代码,核心优势包括:

多语言文档:提供中英文 README(README.md / README-cn.md),覆盖模型介绍、部署步骤、参数说明等全流程;

丰富 Demo:内置工具调用、综述生成、对话交互等多个场景的示例代码,可直接运行调试;

简化依赖:提供 requirements.txt 明确依赖清单,支持 pip 一键安装,兼容 Python 3.8+ 版本。

三、技术细节

MiniCPM 开源项目的技术核心围绕「模型架构优化、推理加速、量化方案」三大维度展开,以下是关键技术细节的通俗解读:

3.1 模型架构基础

MiniCPM 系列模型基于 Transformer 架构优化,核心改进方向是「轻量化架构设计」,通过以下技术实现性能与效率的平衡:

精简参数结构:在保持 Transformer 核心模块(自注意力机制、FFN 层)的基础上,优化层归一化方式、注意力头数量,减少冗余参数;

混合精度训练:采用 FP16 混合精度训练,在保证训练稳定性的同时,降低训练过程中的资源占用;

预训练数据优化:基于海量中英文语料训练,覆盖通用知识、行业场景数据,提升模型通用能力与场景适配性。

3.2 推理加速核心技术

项目的推理加速能力是核心技术亮点,尤其在 MiniCPM 4 及以上版本中,通过以下技术实现端侧 5 倍以上的生成加速:

混合推理模式:支持「深度推理模式」与「非推理模式」动态切换——深度推理模式用于复杂任务(如逻辑推理、工具调用),保证精度;非推理模式用于简单任务(如文本续写、常规问答),提升速度;

投机采样(Speculative Decoding):适配 vLLM 框架的投机采样机制,通过小模型快速生成候选文本,大模型验证修正,减少大模型推理步数,提升整体速度;

算子优化:针对端侧设备(如 Intel CPU、NVIDIA 移动端 GPU)定制算子,优化内存访问效率,减少数据传输延迟。

3.3 量化优化技术原理

量化优化的核心是「在降低显存占用的同时,尽可能保留模型性能」,项目采用的主流量化技术原理如下:

权重量化:将模型权重从 FP32(32 位浮点数)转换为 4bit/8bit 整数,显存占用直接降低 4-8 倍,核心挑战是通过量化校准(如 AWQ 的权重均等化)减少精度损失;

激活量化:部分方案(如 GPTQ)支持激活值量化,进一步降低推理过程中的内存占用,适配低显存设备;

动态量化:在推理过程中根据输入数据的分布动态调整量化精度,平衡性能与资源占用,适合输入差异较大的场景(如对话交互)。

3.4 工具调用技术架构

MiniCPM4-MCP 的工具调用能力基于「Model Context Protocol(MCP)」实现,核心架构分为三层,通俗理解如下:

输入层:接收用户指令,解析任务需求(如「查询北京天气」「生成学术综述」);

调度层:基于 MCP 协议匹配对应的工具(如高德地图 API、学术数据库接口),生成工具调用参数;

执行层:调用工具获取结果,将结果整理为自然语言反馈给用户,同时支持多轮工具调用(如「查询北京天气后,规划前往故宫的路线」)。

四、应用场景

基于「轻量、高效、易用」的核心优势,MiniCPM 开源项目可广泛应用于「端侧设备、云端轻量化部署、行业场景定制」三大类场景,具体落地场景如下:

4.1 端侧设备场景

桌面端智能助手:在 Windows、macOS 设备上部署,实现本地对话交互、文档总结、代码辅助等功能,无需联网即可使用,保护数据隐私;

边缘计算设备:在工业边缘设备、智能终端(如智能音箱、车载设备)部署,实现本地语音交互、实时数据处理(如设备故障诊断、语音指令识别);

嵌入式设备:基于 MiniCPM 4-0.5B 等轻量化版本,部署在嵌入式芯片(如 Raspberry Pi、ESP32)上,实现简单问答、文本生成等轻量任务。

4.2 云端轻量化部署场景

中小微企业智能服务:部署在中小规模服务器上,实现客服对话机器人、订单查询助手、办公自动化工具(如会议纪要生成、邮件撰写);

高并发轻量化任务:如短视频字幕生成、评论审核、简单文本分类等,通过量化优化与投机采样,支持高并发请求处理,降低服务器部署成本;

科研实验平台:为科研人员提供轻量化大模型基线,用于大模型压缩、推理加速、场景适配等方向的实验验证。

4.3 行业定制场景

学术科研:基于 MiniCPM4-Survey 实现学术综述生成,辅助科研人员快速梳理领域研究现状;

企业办公:定制化开发内部知识库问答、合同审核助手、报告生成工具,提升办公效率;

教育场景:部署轻量化模型实现错题讲解、知识点问答、作业辅助批改等功能,适配教育终端设备。

五、使用方法

MiniCPM 开源项目的使用流程可分为「环境准备、模型下载、部署运行、场景调试」四个核心步骤,以下是详细的操作指南(以最常用的「云端 vLLM 部署」和「端侧 llama.cpp 部署」为例):

5.1 通用环境准备

无论哪种部署方式,首先需要完成基础环境配置,步骤如下:

安装 Python 环境:推荐 Python 3.8+,可通过 Anaconda 或官方安装包配置;

克隆项目仓库:

git clone https://github.com/OpenBMB/MiniCPM.git cd MiniCPM

安装依赖包:

pip install -r requirements.txt

(注:若使用特定框架如 vLLM、llama.cpp,需额外安装对应依赖,具体参考项目文档)

5.2 云端 vLLM 部署(推荐高并发场景)

5.2.1 步骤说明

安装 vLLM 依赖:

pip install vllm

下载模型权重:支持从 HuggingFace 或 ModelScope 下载,以 HuggingFace 为例:

# 安装 HuggingFace Hub

pip install huggingface-hub

# 登录 HuggingFace(需注册账号并获取访问令牌)

huggingface-cli login

# 下载 MiniCPM-4B 模型

from huggingface_hub import snapshot_download

snapshot_download("openbmb/MiniCPM-4B", local_dir="./MiniCPM-4B")启动 vLLM 推理服务:

python -m vllm.entrypoints.openai.api_server \ --model ./MiniCPM-4B \ --tensor-parallel-size 1 \ --port 8000

调用服务:通过 OpenAI API 兼容接口调用,示例代码:

from openai import OpenAI

client = OpenAI(api_key="dummy", base_url="http://localhost:8000/v1")

response = client.chat.completions.create(

model="MiniCPM-4B",

messages=[{"role": "user", "content": "介绍一下 MiniCPM 项目"}]

)

print(response.choices[0].message.content)5.2.2 关键参数说明

--model:模型权重本地路径;--tensor-parallel-size:张量并行数量(多 GPU 部署时使用,如 2 表示使用 2 张 GPU);--port:服务端口号,默认 8000;--quantization:量化方案,如awq表示使用 AWQ 量化,需提前下载量化版模型。

5.3 端侧 llama.cpp 部署(本地桌面设备)

5.3.1 步骤说明

安装 llama.cpp 依赖:

# 克隆 llama.cpp 仓库 git clone https://github.com/ggerganov/llama.cpp.git cd llama.cpp # 编译(需安装 CMake、GCC 等编译工具) mkdir build && cd build cmake .. && make

下载 MiniCPM 模型的 GGUF 量化版本(适配 llama.cpp):

从 HuggingFace 下载预量化的 GGUF 版本(如MiniCPM-4B-Q4_K_M.gguf),保存至 llama.cpp/models 目录;启动本地推理:

./main -m models/MiniCPM-4B-Q4_K_M.gguf -p "介绍一下 MiniCPM 项目"

5.3.2 关键参数说明

-m:GGUF 模型文件路径;-p:输入的提示词;-n:生成文本的最大长度,默认 256;--temp:温度参数,控制生成文本的随机性(0-1 之间,值越小越确定)。

5.4 工具调用场景使用(MiniCPM4-MCP)

下载 MCP 工具调用相关依赖:

pip install -r demo/minicpm4/MCP/requirements.txt

运行工具调用示例:

python demo/minicpm4/MCP/mcp_demo.py

自定义工具调用:

参考 demo 中的工具配置文件,添加自定义工具(如企业内部系统接口),修改工具名称、调用参数、返回格式即可快速集成。

六、常见问题解答(FAQ)

Q1:部署时提示「显存不足」怎么办?

A1:优先使用量化版模型(如 AWQ、GPTQ 量化版),可降低 70% 以上显存占用;若使用 GPU 部署,可通过 --quantization 参数指定量化方案;若为端侧设备,推荐使用 GGUF 量化版 + llama.cpp 部署。

Q2:端侧部署时推理速度慢,如何优化?

A2:可通过以下方式优化:1)使用 MiniCPM 4 及以上版本,自带端侧加速优化;2)选择更高精度的量化版本(如 Q4_K_M 比 Q2_K 速度更快);3)减少生成文本长度(通过 -n 参数限制);4)确保设备驱动已更新(如 NVIDIA GPU 安装最新 CUDA 驱动,Intel CPU 安装最新 OpenVINO 工具包)。

Q3:是否支持 Windows 系统部署?

A3:支持。云端部署可直接使用 Windows 服务器,通过 Python 环境运行;端侧部署推荐使用 llama.cpp 的 Windows 编译版本(可通过 CMake 编译生成 exe 文件),或使用 Ollama 客户端(Windows 版),直接拉取 MiniCPM 模型运行。

Q4:MiniCPM 各版本之间如何选择?

A4:根据场景需求选择:1)追求性能优先:选择 MiniCPM 3 或 4.1 版本;2)端侧部署:选择 MiniCPM 4 或 4.1 版本;3)超低成本场景:选择 MiniCPM 4-0.5B 或 BitCPM4 系列;4)工具调用场景:优先选择 MiniCPM 4.1 + MCP 组件。

Q5:模型支持多轮对话吗?如何实现?

A5:支持。实现方式:在调用模型时,将历史对话记录传入 messages 参数(如 OpenAI API 兼容接口),示例如下:

messages = [

{"role": "user", "content": "什么是 MiniCPM?"},

{"role": "assistant", "content": "MiniCPM 是轻量级大语言模型..."},

{"role": "user", "content": "它支持哪些部署方式?"}

]

response = client.chat.completions.create(model="MiniCPM-4B", messages=messages)Q6:模型是否支持中文?

A6:支持。MiniCPM 系列模型经过海量中英文语料训练,中文处理能力优异,可直接处理中文对话、文本生成、工具调用等任务,无需额外配置。

Q7:如何基于 MiniCPM 进行微调,适配自定义场景?

A7:项目提供微调相关代码框架(finetune 目录),核心步骤:1)准备自定义数据集(需符合对话格式或文本格式);2)修改微调配置文件(如学习率、训练轮数、批量大小);3)运行微调脚本:python finetune/finetune.py --config finetune/config.yaml;4)微调完成后,可直接使用微调后的模型权重进行部署。

Q8:如何集成自定义工具到 MiniCPM4-MCP?

A8:参考以下步骤:1)在 MCP 工具配置目录添加工具配置文件(JSON 格式),包含工具名称、描述、输入参数、调用接口;2)实现工具调用函数(参考 demo 中的现有工具);3)在 demo 代码中导入自定义工具,即可通过用户指令触发调用。

七、相关链接

| 资源名称 | 链接地址 |

|---|---|

| 官方 GitHub 仓库 | https://github.com/OpenBMB/MiniCPM |

| HuggingFace 模型仓库 | https://huggingface.co/openbmb |

| ModelScope 模型仓库 | https://www.modelscope.cn/organization/openbmb |

| 面壁智能官方网站 | https://www.openbmb.org/ |

八、总结

MiniCPM 开源项目是轻量级大语言模型领域的优秀解决方案,由面壁智能联合高校团队研发,核心价值在于通过模型架构优化、推理加速、量化方案等技术创新,实现了「轻量不轻质、高效且易用」的核心目标。项目涵盖多版本模型矩阵,支持云端、端侧全场景部署,提供丰富的应用拓展组件与完善的技术文档,既降低了大语言模型的部署成本,又拓宽了其落地场景,适用于科研实验、中小微企业智能服务、端侧智能设备等多个领域。作为开源项目,MiniCPM 凭借友好的开源协议、活跃的社区支持,为开发者提供了低成本接入大语言模型能力的路径,是轻量级大模型落地应用的优质选择。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/minicpm.html