Pixelle-Video:开源全流程自动化AI短视频创作工具,一句话主题生成完整成片

一、Pixelle-Video是什么

Pixelle-Video是一款基于Python开发的开源AI全自动短视频生成引擎,核心优势在于支持用户仅输入一个主题,即可零门槛完成从文案撰写、AI配图/视频生成、语音合成、背景音乐添加到成品视频合成的全流程自动化创作。项目采用模块化设计与ComfyUI架构,兼容GPT、通义千问、FLUX、WAN 2.1等主流AI模型,支持本地部署、云端调用等多种部署方式,适配Windows、macOS、Linux多系统,覆盖自媒体创作、教育科普、营销宣传等多场景,让无剪辑经验的用户也能快速产出高质量短视频。

与市面上仅专注于单一环节(如文生图、视频剪辑)的工具不同,Pixelle-Video的核心竞争力在于全流程覆盖与高度可扩展性:它不仅能自动完成视频创作的所有关键步骤,还支持用户根据需求替换AI模型、自定义工作流、调整视频参数,既满足了新手用户的“开箱即用”需求,也适配了专业用户的个性化定制需求。目前项目已支持快速创作、数字人口播、图生视频、自定义素材生成等多种流水线模式,兼容竖屏、横屏、方形等多尺寸输出,成为兼顾易用性与灵活性的开源短视频创作解决方案。

二、功能特色

Pixelle-Video的功能设计围绕“全自动化、高灵活性、多场景适配”三大核心展开,覆盖视频创作从前期准备到后期合成的全环节,具体特色如下:

1. 全流程自动化,零门槛创作

这是Pixelle-Video最核心的功能亮点,用户无需参与任何中间环节,仅需输入一个主题(如“如何养成早起习惯”“冬季养生小常识”),系统即可在3-10分钟内自动完成从文案到成品视频的全流程输出。整个过程无需手动撰写脚本、寻找素材、剪辑拼接,真正实现“输入一句话,坐等成片”,即使是完全没有剪辑经验的新手,也能快速产出高质量内容。

2. 多模型兼容的AI文案生成

文案是短视频的灵魂,Pixelle-Video整合了多款主流大语言模型,确保生成的文案贴合主题、逻辑清晰、符合短视频传播特性:

支持模型包括GPT系列、通义千问、DeepSeek、Ollama等,用户可根据自身需求选择熟悉的模型或已有API Key的平台;

文案生成支持自定义调整长度、语气风格(如科普风、口语化、幽默风),系统会自动将文案分段为适合视频呈现的分镜脚本,为后续画面生成提供精准依据;

支持文案二次编辑,用户可在AI生成的基础上修改内容,兼顾自动化与个性化需求。

3. 高质量AI视觉内容生成

视觉画面是短视频的核心吸引力,Pixelle-Video基于ComfyUI生态构建视觉生成系统,支持图片与视频两种视觉内容形式:

配图生成:为每一句文案自动匹配高精度AI插图,支持FLUX、Stable Diffusion等主流生图模型,用户可自定义画面风格(如卡通、写实、科技感)、分辨率等参数;

视频生成:支持WAN 2.1等文生视频模型,可直接生成动态视频片段,也支持“图生视频”模式——上传首帧图片后,AI自动生成后续连贯画面;

分镜智能规划:系统会根据文案逻辑自动规划分镜切换节奏,确保画面与语音解说同步,提升视频观看体验。

4. 多样化语音合成与音频配置

语音解说与背景音乐能显著提升视频感染力,Pixelle-Video提供了丰富的音频解决方案:

多引擎语音合成:兼容Edge-TTS、Index-TTS、ChatTTS等主流TTS方案,支持多语言、多音色选择,部分引擎支持声音克隆功能——用户上传参考音频后,即可生成与目标音色一致的解说词,让视频更具个人特色;

智能背景音乐添加:内置背景音乐库,支持自定义上传BGM,系统会自动根据视频节奏、风格匹配合适的音乐,也可手动调整音乐音量、循环模式;

音频同步优化:自动实现语音解说与画面、字幕的精准对齐,避免出现音画不同步问题。

5. 灵活的视觉定制与多尺寸输出

为适配不同平台的传播需求,Pixelle-Video提供了丰富的视觉定制选项:

多尺寸支持:兼容竖屏(9:16,适合抖音、快手)、横屏(16:9,适合B站、YouTube)、方形(1:1,适合小红书、朋友圈)等多种比例,用户可按需选择;

多模板库:内置多种视频模板,涵盖科普、Vlog、营销、教育等不同场景,模板包含预设的转场效果、字幕样式、画面布局,一键应用即可快速统一视频风格;

自定义设置:支持调整字幕字体、颜色、大小,画面转场效果、时长,以及视频分辨率、帧率等参数,满足个性化创作需求。

6. 多流水线模式,适配复杂场景

除基础的“主题生成视频”外,Pixelle-Video还提供了多种专项创作流水线,覆盖更丰富的使用场景:

数字人口播:支持上传数字人形象,选择生成模式后,AI自动生成数字人出镜口播的视频,适合知识分享、产品介绍等场景;

自定义素材生成:用户可上传自有图片、视频素材,AI会自动分析素材内容,生成匹配的脚本并合成完整视频,适合二次创作、素材整合等需求;

批量任务创建:支持同时创建多个视频任务,批量生成不同主题或不同风格的视频,大幅提升内容产出效率,适合自媒体矩阵运营、企业批量宣传等场景。

7. 高度可扩展的模块化架构

项目采用模块化设计,将视频生成流程拆分为“文案生成→配图规划→逐帧处理→视频合成”四大核心模块,每个模块均支持灵活替换与扩展:

模型替换:可自由更换生图模型、TTS引擎、LLM模型,例如将生图模型替换为自定义微调的Checkpoint,或使用本地化部署的Ollama模型替代云端API;

工作流自定义:基于ComfyUI架构,用户可自定义视觉生成工作流,调整画面生成的参数逻辑、处理顺序;

API接口支持:提供API接口,可对接自有系统或第三方平台,实现更灵活的集成与二次开发。

8. 完善的任务管理功能

为方便用户跟踪与复用创作成果,Pixelle-Video提供了全面的任务管理功能:

历史任务查询:支持分页查看所有生成任务,可按时间、状态、主题关键词筛选;

任务详情查看:展示每个任务的完整配置参数(如模型选择、视频尺寸、生成时长)、成品视频及中间产物(文案、配图);

任务复用与删除:支持复制历史任务的参数快速创建新任务,也可删除无用任务释放空间;

数据统计:自动统计任务总数、完成率、总生成时长等数据,方便用户掌握创作情况。

三、技术细节

Pixelle-Video的强大功能背后,是基于Python生态构建的稳健技术架构与多模型协作机制,以下从核心技术栈、架构设计、工作流程、部署方案四个维度展开说明:

1. 核心技术栈

项目的技术选型围绕“高效、兼容、易用”三大原则,采用成熟的开源技术与工具,确保系统稳定性与扩展性:

| 技术类别 | 核心组件 | 功能说明 |

|---|---|---|

| 开发语言 | Python 3.10+ | 核心开发语言,采用AsyncIO异步架构,提升并发处理能力 |

| Web框架 | Streamlit | 构建直观易用的Web操作界面,无需前端开发经验即可快速部署 |

| 视觉架构 | ComfyUI | 支撑AI视觉生成工作流,兼容主流生图/生视频模型,支持自定义工作流 |

| 包管理 | uv | 替代传统pip,提供更快的依赖安装速度与更可靠的虚拟环境管理 |

| 视频处理 | FFmpeg | 核心视频合成工具,负责画面、音频、字幕的整合与格式转换 |

| 配置管理 | YAML | 统一管理模型配置、API密钥、系统参数,方便用户修改与维护 |

| 模型支持 | LLM(GPT/通义千问等)、生图模型(FLUX等)、TTS引擎(Edge-TTS等) | 多模型兼容,满足不同场景下的技术需求 |

2. 架构设计

Pixelle-Video采用模块化分层架构,整体分为前端层、核心服务层、模型适配层、数据存储层四个层级,各层级职责清晰、松耦合,便于扩展与维护:

前端层:基于Streamlit开发的Web界面,提供用户交互入口,包括主题输入、参数配置、任务管理、视频预览等功能,界面设计简洁直观,无需专业操作知识;

核心服务层:系统的核心逻辑层,包含四大模块:

文案生成模块:接收用户主题,调用指定LLM模型生成文案并分段;

视觉生成模块:根据分镜文案,调用ComfyUI生态的生图/生视频模型生成视觉内容;

音频处理模块:将文案转换为语音解说,匹配背景音乐并优化音频质量;

视频合成模块:整合视觉内容、语音、背景音乐、字幕,生成最终成品视频;

模型适配层:提供统一的模型调用接口,适配不同类型、不同厂商的AI模型,屏蔽模型间的差异,让用户可无缝切换模型;

数据存储层:存储用户配置、任务记录、生成的文案/素材/视频等数据,支持本地文件存储与云端存储两种方式。

这种架构设计的优势在于:各模块独立运行,可单独升级或替换;新增功能时无需修改核心逻辑,仅需开发新的模块并接入核心服务层;模型适配层降低了新增模型的开发成本,让项目能快速兼容最新的AI模型。

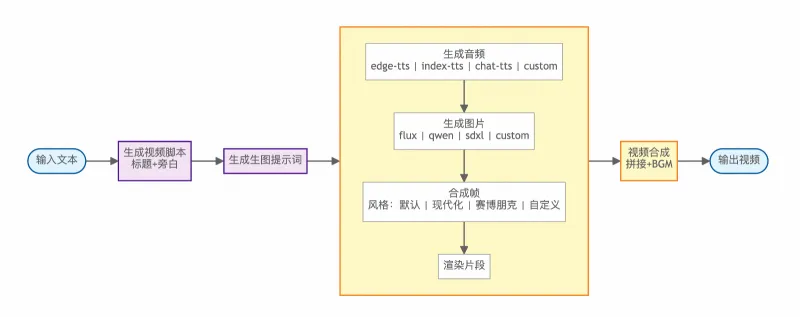

3. 核心工作流程

Pixelle-Video的视频生成流程可拆解为五个关键步骤,全程自动化执行,无需人工干预:

主题解析与文案生成:用户输入主题后,系统先通过LLM模型分析主题核心需求,确定文案的结构、风格与长度;随后生成完整的视频文案,并自动拆分为若干分镜片段,每个片段对应一段独立的画面与语音;

分镜视觉规划:针对每个分镜文案,系统生成详细的视觉描述(如“一位年轻人在书桌前阅读,背景是简约的书房,暖色调灯光”),并根据用户选择的风格、模型参数,确定视觉生成方案;

视觉内容生成:将视觉描述传入指定的生图或生视频模型,生成与文案匹配的图片或动态视频片段;若用户选择自定义素材,系统会跳过此步骤,直接使用上传的素材;

音频生成与适配:调用TTS引擎将分镜文案转换为语音解说,自动调整语速与停顿,确保与分镜时长匹配;同时根据视频风格选择合适的背景音乐,调整音量比例,避免语音与音乐冲突;

视频合成与优化:将各分镜的视觉内容、语音解说、背景音乐按时间线整合,添加字幕、转场效果,优化视频分辨率与帧率,最终生成完整的成品视频并存储供用户下载。

4. 部署方案技术细节

Pixelle-Video提供多种部署方式,适配不同用户的硬件条件与使用需求,技术细节如下:

本地部署(Selfhost):

硬件要求:推荐配置4GB以上内存,若需本地运行生图/生视频模型,建议配备8GB以上显存的显卡(如NVIDIA RTX 3090、4090);

核心依赖:需安装Python 3.10+、FFmpeg、uv(或pip),若使用ComfyUI本地服务,还需安装ComfyUI及对应模型权重;

技术优势:数据本地存储,隐私安全有保障;可完全免费运行(使用Ollama本地LLM + 本地生图模型),无API调用成本;

Windows一键整合包:

技术特点:整合所有依赖(Python、FFmpeg、ComfyUI、模型权重),无需用户手动安装任何环境,解压后即可运行;

启动方式:双击start_web.bat文件,系统自动配置环境并启动Web界面,浏览器自动打开http://localhost:8501;

适用场景:Windows系统用户,无技术背景,希望快速上手使用;

云端调用部署:

技术逻辑:LLM、生图/生视频模型通过云端API调用(如OpenAI API、RunningHub云服务),本地仅运行Web界面与合成服务,无需高性能硬件;

优势:降低本地硬件要求,即使无独立显卡也可使用;生成速度快,无需等待模型本地推理;

注意事项:需配置对应的API Key,可能产生一定的云端服务费用;

Docker部署:

技术支持:提供Dockerfile与docker-compose.yml配置文件,支持快速构建Docker镜像并部署;

部署命令:通过docker-compose up -d即可启动服务,支持跨平台运行,适合服务器部署与多用户共享;

系统兼容性:适配Windows 10/11、macOS 12+、Linux(Ubuntu 20.04+、Debian 11+)等主流操作系统,解决了不同系统下的依赖兼容问题。

四、应用场景

Pixelle-Video的全自动化特性与高灵活性,使其能够覆盖多个行业、多种类型的短视频创作需求,以下是主要应用场景及具体使用案例:

1. 自媒体与内容创作者

对于抖音、快手、B站、小红书等平台的自媒体博主而言,内容产出效率是核心竞争力。Pixelle-Video能帮助他们快速批量生成内容,降低创作成本:

适用内容类型:知识科普(如“10个生活小妙招”)、个人成长(如“如何提升专注力”)、情感语录(如“治愈系文案合集”)、小说解说(如“热门小说剧情速看”);

使用案例:一位小红书博主专注于“职场干货”分享,通过Pixelle-Video输入“职场沟通技巧”主题,选择“口语化”文案风格、“简约商务”视觉风格,10分钟内生成3条竖屏短视频,稍作修改后即可发布,大幅提升了更新频率;

核心价值:减少文案撰写与剪辑时间,让博主聚焦于创意与主题策划;支持批量生成,适配自媒体矩阵运营需求。

2. 教育与知识分享

教育工作者、培训机构、知识博主可利用Pixelle-Video快速生成教学视频、科普内容,让知识传播更生动直观:

适用内容类型:学科知识点讲解(如“小学数学应用题解题技巧”)、科普视频(如“宇宙行星小知识”)、培训教程(如“办公软件操作指南”)、育儿知识(如“幼儿安全教育”);

使用案例:一位初中物理老师需要制作“浮力原理”教学视频,通过Pixelle-Video输入主题后,选择“严谨科普”文案风格、“实验演示”视觉风格,系统自动生成包含实验步骤、原理讲解的文案,并匹配对应的动画画面与清晰语音,生成的视频可直接用于课堂教学或线上分享;

核心价值:降低教学视频制作门槛,无需专业剪辑团队;视觉化呈现复杂知识,提升学习兴趣与理解效率。

3. 企业营销与品牌宣传

企业市场部、运营团队可利用Pixelle-Video快速生成产品介绍、活动宣传、品牌推广等短视频,降低营销成本:

适用内容类型:产品功能演示(如“新款手机拍照功能介绍”)、活动推广(如“双11促销活动预告”)、品牌故事(如“企业发展历程”)、客户见证(如“产品使用反馈合集”);

使用案例:一家初创科技公司推出新款智能手环,市场团队通过Pixelle-Video输入“智能手环健康监测功能”主题,选择“专业严谨”文案风格、“科技感”视觉风格,同时上传产品实拍图片作为自定义素材,快速生成3条不同侧重点的宣传视频,分别发布于抖音、视频号、小红书,覆盖不同用户群体;

核心价值:快速响应营销节点,无需等待外包剪辑;支持批量生成多平台适配的视频,提升营销覆盖面;降低营销内容制作成本,适合中小企业。

4. 数字人口播与虚拟主播

随着数字人技术的普及,Pixelle-Video的“数字人口播”功能可满足虚拟主播、数字人带货等场景的需求:

适用内容类型:数字人新闻播报、虚拟主播带货讲解、数字人知识分享、品牌虚拟代言人宣传;

使用案例:一家电商平台推出虚拟带货主播,运营团队通过Pixelle-Video上传虚拟主播形象,输入“爆款零食推荐”主题,选择“活泼亲切”文案风格与“直播场景”视觉风格,系统自动生成带货脚本、匹配直播间背景画面,生成的数字人口播视频可直接用于电商平台直播回放或短视频推广;

核心价值:无需真人出镜,降低主播成本;支持24小时批量生成内容,提升带货效率;数字人形象可定制,强化品牌辨识度。

5. 个人日常与兴趣分享

普通用户可利用Pixelle-Video记录生活、分享兴趣,无需专业技巧即可制作高质量Vlog或兴趣内容:

适用内容类型:旅行Vlog(如“周末周边游攻略”)、美食分享(如“家常菜谱教程”)、兴趣展示(如“手工制作过程”)、生活记录(如“宝宝成长瞬间”);

使用案例:一位宝妈想分享“宝宝辅食制作”教程,通过Pixelle-Video输入主题后,选择“温馨日常”文案风格、“写实”视觉风格,上传自己制作辅食的实拍图片,系统自动生成包含步骤讲解的文案与语音,合成后的视频可分享给亲友或社交平台;

核心价值:零门槛制作个人视频,无需学习剪辑软件;快速整合素材,留住生活美好瞬间;支持自定义风格,让个人内容更具特色。

6. 二次创作与素材整合

用户可通过“自定义素材”功能,上传已有图片、视频素材,利用Pixelle-Video的AI能力进行二次创作与整合:

适用内容类型:旧视频翻新(如“老照片做成纪念视频”)、素材合集(如“宠物搞笑瞬间合集”)、会议记录整理(如“会议要点视频总结”);

使用案例:一位职场人士参加行业会议后,收集了会议PPT、现场照片,通过Pixelle-Video上传这些素材,输入“行业会议核心要点”主题,系统自动分析素材内容,生成总结性文案与语音,合成后的视频可用于团队内部分享或个人学习回顾;

核心价值:快速整合零散素材,提升内容可读性;AI辅助提炼核心信息,节省整理时间。

五、使用方法

Pixelle-Video提供多种使用方式,无论是零基础用户还是专业开发者,都能快速上手。以下按“部署方式→配置流程→创作步骤→视频导出”的逻辑,详细介绍使用方法:

1. 部署方式选择与安装

根据自身设备条件与技术水平,选择合适的部署方式,具体安装步骤如下:

(1)Windows一键整合包(推荐零基础用户)

步骤1:下载最新版Windows一键整合包(可从项目GitHub Releases页面获取);

步骤2:将整合包解压到任意文件夹(建议路径不含中文、空格,如“D:\Pixelle-Video”);

步骤3:双击文件夹中的“start_web.bat”文件,系统会自动配置环境、启动服务;

步骤4:等待启动完成后,浏览器会自动打开Web界面(地址:http://localhost:8501),若未自动打开,可手动在浏览器输入地址访问。

(2)源码安装(适合macOS/Linux用户或开发者)

步骤1:安装前置依赖

macOS:打开终端,执行命令“brew install ffmpeg”;

Ubuntu/Debian:执行命令“sudo apt update && sudo apt install ffmpeg”;

Windows:从FFmpeg官网(https://ffmpeg.org/download.html)下载解压,将“bin”目录添加到系统环境变量(以管理员身份打开PowerShell,执行命令:(Environment)::SetEnvironmentVariable("Path", $Env:Path + ";C:\ffmpeg\bin", "Machine"),替换路径为实际解压目录);

安装FFmpeg:

安装uv(推荐):执行命令“curl -LsSf https://astral.sh/uv/install.sh | sh”,安装完成后执行“uv --version”验证;若使用pip,需先创建虚拟环境:“python -m venv venv”,再激活环境(Windows:venv\Scripts\activate;macOS/Linux:source venv/bin/activate)。

步骤2:下载项目源码

终端执行命令:“git clone https://github.com/AIDC-AI/Pixelle-Video.git”;

进入项目目录:“cd Pixelle-Video”。

步骤3:安装项目依赖

使用uv:执行“uv sync”,自动安装所有依赖;

使用pip:执行“pip install -e .”。

步骤4:启动Web界面

使用uv:“uv run streamlit run web/app.py”;

使用pip:“streamlit run web/app.py”;

步骤5:浏览器访问http://localhost:8501,进入操作界面。

(3)Docker部署(适合服务器或多用户共享)

步骤1:安装Docker与docker-compose(需提前完成环境配置);

步骤2:克隆项目源码:“git clone https://github.com/AIDC-AI/Pixelle-Video.git && cd Pixelle-Video”;

步骤3:执行命令“docker-compose up -d”,构建镜像并启动服务;

步骤4:访问“http://服务器IP:8501”,即可使用(需确保服务器8501端口开放)。

2. 首次使用配置

进入Web界面后,首次使用需完成基础配置,否则无法正常生成视频:

步骤1:在Web界面左侧找到“⚙️ 系统配置”面板,展开配置项;

步骤2:LLM配置(必填):

选择需要使用的LLM模型(如“通义千问”“GPT-3.5”“Ollama”);

若选择云端模型(如GPT、通义千问),需输入对应的API Key;若选择Ollama,需确保本地已启动Ollama服务,并输入本地服务地址;

步骤3:图像配置(必填):

选择图像生成方式:“本地ComfyUI”或“云端服务(RunningHub)”;

本地ComfyUI:输入ComfyUI服务地址(默认http://127.0.0.1:8188),需提前启动ComfyUI;

云端服务:输入RunningHub API Key(可注册获取,新用户赠送1000 RH币);

步骤4:音频配置(可选):

选择TTS引擎(如“Edge-TTS”),可预览音色并选择偏好的声音;

若需使用声音克隆,上传参考音频文件;

步骤5:点击“保存配置”,完成基础设置。

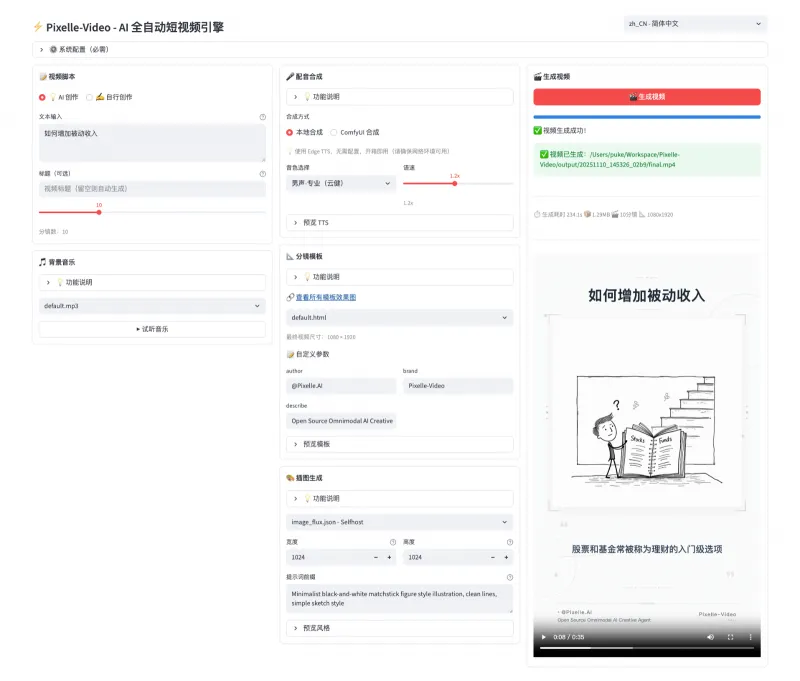

3. 视频创作步骤

配置完成后,即可开始创作视频,以最常用的“快速创作”模式为例:

(1)快速创作模式(主题生成视频)

步骤1:在Web界面首页选择“快速创作”选项;

步骤2:输入视频主题(如“夏季防暑小知识”),可补充说明(如“面向中老年群体,口语化风格”);

步骤3:配置视频参数:

文案设置:选择LLM模型、文案长度(短/中/长)、语气风格;

视觉设置:选择视觉风格(如“写实”“卡通”)、生图模型、视频尺寸(9:16/16:9/1:1);

音频设置:选择TTS引擎、音色、背景音乐风格(如“轻快”“舒缓”);

模板设置:从模板库选择合适的视频模板(包含转场、字幕样式);

步骤4:点击“生成视频”按钮,系统开始执行全流程自动化创作,页面会显示进度(文案生成中→视觉生成中→音频合成中→视频合成中);

步骤5:生成完成后,页面会显示视频预览,可播放查看效果。

(2)数字人口播模式

步骤1:选择“数字人口播”选项;

步骤2:上传数字人形象图片(建议正面清晰、背景简单);

步骤3:输入视频主题与补充说明,配置文案、音频参数;

步骤4:选择生成模式(如“全身出镜”“半身出镜”),设置背景场景(如“直播间”“书房”);

步骤5:点击“生成视频”,等待数字人口播视频生成。

(3)自定义素材模式

步骤1:选择“自定义素材”选项;

步骤2:点击“上传素材”,选择本地图片或视频文件(支持批量上传);

步骤3:输入主题,系统会根据素材内容生成匹配的文案;也可手动上传已有的文案脚本;

步骤4:配置音频、模板、视频尺寸等参数;

步骤5:点击“生成视频”,系统会将上传的素材与生成的音频、字幕整合为成品视频。

(4)图生视频模式

步骤1:选择“图生视频”选项;

步骤2:上传首帧图片(如“一片花海”);

步骤3:输入视频提示词(如“花海中蝴蝶飞舞,镜头缓慢移动,阳光明媚”);

步骤4:配置视频时长、帧率、视觉风格等参数;

步骤5:点击“生成视频”,系统基于首帧图片与提示词生成动态视频。

4. 视频导出与任务管理

导出视频:视频预览满意后,点击预览下方的“下载视频”按钮,即可将成品视频保存到本地(格式为MP4);

任务管理:

在“历史任务”页面,可查看所有生成任务,按时间、状态筛选;

点击任务卡片,可查看详细配置参数、重新生成(复制参数创建新任务)、删除任务;

支持批量导出或删除任务视频。

六、常见问题解答(FAQ)

1. 启动服务时提示“FFmpeg not found”,如何解决?

这是最常见的问题,原因是系统未安装FFmpeg或未配置环境变量:

解决方案:

macOS:打开终端,执行“brew install ffmpeg”,等待安装完成后重启服务;

Ubuntu/Debian:执行“sudo apt update && sudo apt install ffmpeg”,安装后验证“ffmpeg -version”是否能正常输出版本;

Windows:从FFmpeg官网下载解压包,将“bin”目录(如“C:\ffmpeg\bin”)添加到系统环境变量,具体步骤:

以管理员身份打开PowerShell;

执行命令:(Environment)::SetEnvironmentVariable("Path", $Env:Path + ";C:\ffmpeg\bin", "Machine");

关闭当前PowerShell,重新打开后执行“ffmpeg -version”验证;

若仍提示未找到,重启电脑后再尝试启动服务。

2. 生成视频时提示“API Key无效”或“模型调用失败”,怎么办?

可能原因:API Key输入错误、API密钥过期、网络无法访问模型服务、模型未开通对应权限;

解决方案:

检查API Key是否正确,有无多余空格或拼写错误,重新输入后保存配置;

确认API密钥是否过期(如OpenAI API需检查账户余额与有效期),过期则重新申请;

若使用境外模型(如GPT),需确保网络能正常访问,必要时配置代理(注意合规性);

确认已开通对应模型的调用权限(如通义千问需在阿里云控制台开通服务);

若仍无法解决,可切换其他模型(如改用Ollama本地模型,无需API Key)。

3. 本地部署后生成视觉内容速度极慢,如何优化?

可能原因:硬件配置不足(尤其是显卡显存)、模型参数设置过高、同时运行其他占用资源的程序;

解决方案:

降低模型参数:在视觉设置中选择“轻量化模型”或降低分辨率(如从1080P改为720P)、减少生成图片数量;

关闭其他程序:生成视频时关闭占用CPU、内存、显存的程序(如游戏、其他AI工具);

升级硬件:若长期使用,建议配备8GB以上显存的NVIDIA显卡,提升推理速度;

改用云端视觉服务:将图像配置改为“RunningHub云端服务”,无需本地硬件资源,生成速度更快。

4. 生成的视频出现音画不同步,如何处理?

可能原因:TTS语音时长与视觉内容时长不匹配、转场效果设置过长、视频帧率配置异常;

解决方案:

重新生成:音画不同步多为偶发的时长计算误差,重新点击“生成视频”即可修复;

调整TTS参数:在音频设置中选择“语速稍快”或“语速稍慢”,匹配视觉内容时长;

简化转场效果:选择“无转场”或“短转场”,避免转场占用过多时间;

统一帧率设置:将视频帧率设置为24fps或30fps(默认值),避免自定义过高帧率。

5. Windows系统启动“start_web.bat”后,浏览器未自动打开,怎么办?

可能原因:端口被占用、服务启动失败、浏览器设置阻止自动跳转;

解决方案:

手动打开浏览器,输入地址“http://localhost:8501”,尝试访问;

若提示“无法访问”,可能是8501端口被占用,需修改端口:打开“web/app.py”文件,找到“streamlit run”命令,添加“--server.port 8502”(改为其他未占用端口),保存后重新启动;

查看启动窗口的报错信息,若有“Permission denied”,以管理员身份运行“start_web.bat”;

若启动窗口一闪而过,可右键编辑“start_web.bat”,在最后一行添加“pause”,保存后重新运行,查看具体报错信息(如依赖缺失),针对性解决。

6. 生成的文案不符合预期(如逻辑混乱、风格不符),如何调整?

解决方案:

补充详细提示:在输入主题时,添加更具体的说明(如“面向大学生,科普人工智能基础,幽默风趣,避免专业术语”);

更换LLM模型:不同模型的文案生成风格不同,可尝试切换为通义千问、DeepSeek等模型;

手动编辑文案:AI生成文案后,点击“编辑文案”按钮,手动修改逻辑混乱或风格不符的部分,再生成视频;

调整文案长度:若文案过长导致逻辑混乱,选择“短”或“中”长度,精简内容。

7. 如何自定义视频的字幕样式(字体、颜色、大小)?

操作步骤:

在Web界面“系统配置”中,找到“字幕设置”选项;

选择字体(如“微软雅黑”“黑体”)、调整字体大小(默认24号,可按需增减);

选择字幕颜色(支持纯色或渐变色)、背景色(可选透明、半透明);

保存配置后,新生成的视频会应用自定义的字幕样式;

若需单独调整某个视频的字幕,可在“快速创作”的“模板设置”中选择带自定义字幕的模板。

8. 能否批量生成多个视频?如何操作?

可以批量生成,操作步骤:

在Web界面选择“批量创作”选项(部分版本需在“历史任务”页面点击“批量创建”);

批量输入主题(每行一个主题,如“春季穿搭技巧”“夏季护肤指南”);

统一配置文案、视觉、音频、模板等参数(也可单独为每个主题设置参数);

点击“批量生成”,系统会依次处理每个主题,生成对应的视频;

批量生成完成后,可在“历史任务”中批量下载或管理视频。

9. 项目是否支持二次开发?如何贡献代码?

支持二次开发与开源贡献,具体方式:

Fork项目仓库到个人GitHub账户;

创建功能分支(如“feature/add-new-tts-engine”);

开发完成后提交代码,确保通过单元测试;

提交Pull Request到原仓库,等待维护者审核合并;

二次开发:项目采用模块化设计,可基于现有代码扩展功能(如新增TTS引擎、自定义工作流),参考项目“开发指南”文档;

贡献代码:

贡献资源:也可分享视频案例、模板、提示词到项目社区,或帮助完善中英双语文档。

10. 生成的视频有版权问题吗?可以商用吗?

版权说明:

部分模型生成的内容可商用(如通义千问、FLUX的商用授权);

部分模型可能限制商用(如部分开源模型需遵守Creative Commons协议);

Pixelle-Video项目本身开源(遵循对应开源协议),用户可自由使用,但需遵守开源协议要求(如保留版权声明);

AI生成的文案、视觉内容、语音的版权,取决于所使用的AI模型的版权政策:

建议:商用前确认所使用模型的版权政策,避免侵权;若使用自定义素材,需确保素材本身拥有合法版权;

项目不承担因用户使用AI生成内容导致的版权纠纷责任,用户需自行负责。

七、相关链接

项目GitHub仓库:https://github.com/AIDC-AI/Pixelle-Video

八、总结

Pixelle-Video作为一款开源AI全自动短视频引擎,通过整合多领域AI技术与模块化架构设计,成功实现了“一句话主题生成完整短视频”的核心目标,彻底打破了短视频创作的技术门槛与效率瓶颈。它兼容多款主流LLM、生图/生视频模型及TTS引擎,提供Windows一键整合包、源码安装、Docker部署、云端调用等多种使用方式,适配不同用户的技术水平与硬件条件;功能上覆盖文案生成、视觉创作、音频合成、视频合成等全环节,支持快速创作、数字人口播、自定义素材、图生视频等多场景流水线,满足自媒体、教育、营销、个人分享等多样化创作需求。无论是无剪辑经验的普通用户,还是需要批量产出内容的专业团队,都能通过Pixelle-Video快速降低创作成本、提升产出效率,同时其开源特性与高度可扩展性,也为开发者提供了二次开发与功能定制的空间。总体而言,Pixelle-Video以“简单、高效、灵活、开源”为核心优势,成为连接创意与短视频成品的桥梁,让内容创作真正走向民主化、全民化。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/pixelle-video.html