Step-Audio-EditX:阶跃星辰推出的开源AI音频编辑工具,支持零样本TTS与多维度语音特征定制

一、Step-Audio-EditX 是什么?

Step-Audio-EditX是阶跃星辰推出的一款开源音频编辑工具,基于 30 亿参数的大语言模型(LLM)构建,专注于提供富有表现力(expressive)和迭代式的音频编辑体验。该工具不仅支持普通话、英语、四川话、粤语等多语言/方言的零样本语音克隆与文本转语音(TTS),还能精准控制数十种情感(如愤怒、快乐、悲伤)、说话风格(如娇羞、老年、耳语)及 10 种副语言特征(如呼吸、笑声、惊讶语气词),让合成音频更自然、拟人化。项目已开源推理代码、Gradio 在线演示及核心模型(Step-Audio-Tokenizer、Step-Audio-EditX),支持 Linux 系统与 NVIDIA GPU 运行,适用于内容创作、游戏配音、方言内容生产等多种场景,为开发者与创作者提供灵活、高效的音频定制解决方案。

在音频编辑领域,传统工具往往依赖专业技能(如 Audition、Logic Pro),且难以精准捕捉人类语音中的情感、风格与副语言细节(如呼吸、笑声);而现有 AI 音频工具多聚焦于基础 TTS 或简单语音转换,缺乏对“表现力”和“迭代式编辑”的深度支持。为解决这一痛点,StepFun AI 开源了 Step-Audio-EditX——一款以 LLM 为核心驱动的音频编辑工具,旨在让普通用户与开发者通过简单文本指令,即可完成高自然度、个性化的音频创作与编辑。

Step-Audio-EditX 的核心定位是“expressive(富有表现力)+ 迭代式”:

表现力:突破传统 TTS“无情感、无风格”的局限,支持情感、说话风格、副语言特征的精细化控制,让语音更贴近人类真实交流场景;

迭代式:基于 LLM 的强大理解能力,用户可通过自然语言指令逐步调整音频参数(如“把这句话改成开心的语气,加上一点笑声”),无需复杂操作;

开源属性:完全开放推理代码、模型权重及演示工具,降低开发者二次开发门槛,推动音频 AI 技术的普及与创新。

项目的核心优势在于“零样本能力”——无需为特定语言、方言或情感训练额外模型,仅通过文本指令即可实现多场景语音生成与编辑,这得益于其 30 亿参数 LLM 对语言和语音特征的泛化学习能力。

二、功能特色

Step-Audio-EditX 的功能围绕“多维度语音定制”展开,涵盖零样本 TTS、情感/风格编辑、副语言特征控制三大核心模块,且支持灵活的指令交互方式,具体如下:

1. 零样本 TTS(文本转语音):多语言/方言一键生成

传统 TTS 工具往往需要针对特定语言或方言训练专用模型,而 Step-Audio-EditX 凭借 LLM 的跨语言泛化能力,实现了零样本语音克隆与多语言生成,无需额外训练数据即可支持多种语言与方言。

核心特性:

支持语言/方言:普通话、英语、四川话、粤语(更多语言持续扩展中);

使用方式:通过文本前添加标签指定语言/方言,例如:

四川话:

[Sichuanese] 今天天气好得很,适合去公园耍粤语:

[Cantonese] 听日想唔想去饮茶?零样本语音克隆:用户可提供少量参考语音(如 10 秒音频),模型即可克隆其音色,结合文本指令生成个性化语音(该功能需配合参考音频输入)。

优势:

降低多语言内容生产门槛,尤其适用于方言内容(如地方媒体、方言短视频);

无需专业录音设备,仅通过文本即可快速生成自然语音。

2. 情感与说话风格编辑:数十种风格精准切换

语音的情感与风格是传递信息的重要载体(如“愤怒的警告”与“温柔的提醒”传递的效果完全不同)。Step-Audio-EditX 内置了数十种情感与说话风格模板,用户可通过简单标签或文本指令控制语音的情绪倾向与表达风格。

支持类型(表格1):

| 功能分类 | 支持选项 | 示例指令 |

|---|---|---|

| 情感编辑 | 愤怒(Angry)、快乐(Happy)、悲伤(Sad)、兴奋(Excited)、平静(Calm)、惊讶(Surprised)、失望(Disappointed)、恐惧(Fearful)等数十种 | [Angry] 你怎么又迟到了!这次必须扣绩效! |

| 说话风格编辑 | 娇羞(Act_coy)、老年(Older)、儿童(Child)、耳语(Whisper)、严肃(Serious)、正式(Formal)、随意(Casual)、幽默(Humorous)等 | [Child] 妈妈,我想要那个会发光的玩具![Laughter] |

特色:

情感与风格可组合使用(如“愤怒+严肃”“快乐+儿童”),满足复杂场景需求;

风格标签持续扩展中,用户可通过项目 GitHub 提交新风格需求。

3. 副语言特征编辑:让语音更贴近人类真实交流

副语言特征(Paralinguistic Features)是指除词汇和语法外,伴随语音的非语言元素(如呼吸声、笑声、语气词),这些特征是人类语音自然度的关键。Step-Audio-EditX 支持10 种常见副语言特征的精确控制,让合成语音更具“人情味”。

支持的副语言特征(表格2):

| 特征标签 | 描述 | 示例指令 |

|---|---|---|

| [Breathing] | 呼吸声(如说话间隙的自然呼吸) | [Breathing] 我……我有点紧张,第一次上台演讲。 |

| [Laughter] | 笑声(如开心时的大笑、娇羞时的浅笑) | [Laughter] 你这个笑话太逗了!我肚子都笑疼了。 |

| [Suprise-oh] | 惊讶语气词“哦”(如突然得知消息时的反应) | [Suprise-oh] 哦?你居然还记得我的生日! |

| [Suprise-ah] | 惊讶语气词“啊”(如意外事件时的反应) | [Suprise-ah] 啊!下雨了,我没带伞! |

| [Suprise-wa] | 惊讶语气词“哇”(如赞叹时的反应) | [Suprise-wa] 哇!这朵花好漂亮啊! |

| [Confirmation-en] | 确认语气词“嗯”(如回应他人时的肯定) | [Confirmation-en] 嗯,我知道了,明天一定准时到。 |

| [Uhm] | 犹豫语气词“呃”(如思考时的停顿) | [Uhm] 这个问题……我需要再想想。 |

| [Sigh] | 叹息声(如无奈、疲惫时的叹气) | [Sigh] 唉,今天的工作怎么这么多啊。 |

优势:

副语言特征与文本内容无缝融合,避免“机械感”;

支持自定义特征出现的位置与强度(通过指令微调,如“[Laughter:0.8] 表示中等强度笑声”)。

4. 其他特色功能

迭代式编辑:基于 LLM 的上下文理解能力,用户可通过多轮指令调整音频(如“先把这句话改成悲伤的语气,再加上一点叹息声”);

Gradio 在线演示:提供直观的 Web 界面,无需编写代码即可体验所有功能(支持文本输入、语音输出、参数调整);

灵活的部署方式:支持本地部署(NVIDIA GPU)、Docker 容器部署,满足不同场景的使用需求。

三、技术细节

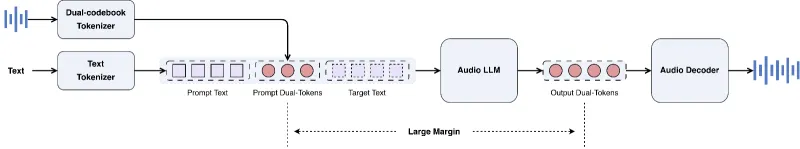

Step-Audio-EditX 的技术架构围绕“LLM 驱动 + 音频 tokenization + 语音合成”三大核心模块展开,整体流程如下:文本指令 → 前端处理 → LLM 推理 → 音频 token 生成 → 语音合成 → 输出音频。以下是关键技术细节的拆解:

1. 核心模型架构

LLM 核心:采用 30 亿参数的大语言模型作为“指令理解与决策引擎”,负责解析用户的文本指令(如情感、风格、副语言特征需求),并生成对应的语音特征描述;

Step-Audio-Tokenizer:音频 tokenizer 用于将语音信号转换为离散的 token(类似 NLP 中的分词),便于 LLM 进行处理。该 tokenizer 基于自监督学习训练,能捕捉语音的韵律、音色、情感等关键特征;

StepVocoder:语音合成器(声码器),基于 HIFI-GAN 架构(来自 CosyVoice2 项目),负责将 LLM 生成的音频 token 转换为高质量的语音波形。HIFI-GAN 以“高保真、低延迟”著称,能还原自然的语音细节。

2. 关键技术流程

(1)前端处理(funasr_detach 模块)

负责文本的分词、标签解析(如提取

[Angry]、[Sichuanese]等标签);对参考语音(若有)进行预处理(如降噪、采样率转换),提取音色特征供语音克隆使用。

(2)LLM 推理(tts_infer.py 模块)

接收前端处理后的文本指令与语音特征,生成包含情感、风格、副语言信息的音频 token 序列;

支持零样本推理的关键:LLM 通过大规模多语言、多情感语音数据预训练,学习到不同语言/方言的语音模式,以及情感/风格与语音特征的映射关系,无需针对特定场景微调。

(3)语音合成(stepvocoder 模块)

将 LLM 生成的音频 token 输入 HIFI-GAN 生成器,转换为连续的语音波形;

优化策略:通过调整声码器的超参数(如合成速率、带宽),平衡合成质量与推理速度。

3. 模型训练计划(待完成)

项目目前已开源推理代码与模型检查点,训练相关功能仍在开发中,计划包含:

SFT 训练(监督微调):基于高质量情感/风格语音数据集,进一步提升模型对指令的遵循度与生成质量;

PPO 训练(强化学习):通过用户反馈优化模型输出,让语音更符合人类偏好;

Int8 量化模型:降低模型显存占用(预计支持 8GB 显存 GPU 运行),提升推理速度。

4. 硬件与软件依赖

硬件要求:NVIDIA GPU(支持 CUDA),推荐显存 ≥12GB(如 L40S、A10、3090 等);

系统支持:Linux(已测试 Ubuntu 20.04/22.04);

软件依赖:

Python ≥ 3.10.0(推荐 Anaconda/Miniconda);

PyTorch ≥ 2.4.1-cu121(需匹配 CUDA 版本);

CUDA Toolkit(12.1 及以上);

其他依赖:

transformers、gradio、soundfile、librosa等(详见requirements.txt)。

四、应用场景

Step-Audio-EditX 的功能特性使其适用于多种音频创作与编辑场景,无论是个人创作者还是企业级应用,都能找到对应的使用场景:

1. 内容创作(短视频、播客、自媒体)

短视频配音:为搞笑视频、情感短剧、知识科普视频生成符合场景的语音(如搞笑视频用“快乐+笑声”,情感短剧用“悲伤+叹息”);

播客制作:生成多角色语音(不同风格/情感),降低多人配音的成本;

自媒体运营:快速生成方言内容(如四川话美食测评、粤语生活分享),吸引地域化粉丝。

2. 游戏与动画配音

角色语音定制:为游戏角色生成个性化语音(如反派角色用“愤怒+严肃”,儿童角色用“Child+Laughter”);

动态语音反馈:根据游戏剧情变化,实时调整角色语音的情感(如战斗时“兴奋”,失败时“悲伤”)。

3. 本地化与方言内容生产

地方媒体:生成方言新闻、方言公益广告(如粤语新闻播报、四川话乡村宣传);

文化保护:记录与传承濒危方言(通过零样本方言 TTS,生成方言语音素材)。

4. 辅助工具与无障碍应用

语音助手优化:为智能音箱、车载语音助手添加情感交互能力(如“开心”地回应用户需求);

视障辅助:为视障人士生成个性化语音(如“温柔+清晰”的读书声),提升使用体验;

语言学习:生成多语言/方言的标准发音,辅助用户学习外语或方言。

5. 企业级音频应用

客服语音机器人:生成“耐心+专业”的客服语音,提升客户咨询体验;

教育培训:生成不同风格的教学语音(如“严肃”的学术讲解、“活泼”的儿童教学);

广告制作:快速生成广告语音(如“兴奋”的促销播报、“温馨”的品牌宣传)。

五、使用方法

Step-Audio-EditX 支持本地部署与 Docker 部署两种方式,以下是详细的使用步骤(基于 Linux 系统):

1. 本地部署步骤

(1)环境准备

安装 Anaconda/Miniconda(推荐,便于环境隔离);

确保已安装 NVIDIA 驱动、CUDA Toolkit(12.1+)。

(2)克隆仓库与创建环境

# 克隆仓库 git clone https://github.com/stepfun-ai/Step-Audio-EditX.git cd Step-Audio-EditX # 创建并激活 conda 环境 conda create -n stepaudioedit python=3.10 conda activate stepaudioedit

(3)安装依赖

# 安装 PyTorch(需匹配 CUDA 版本,此处以 CUDA 12.1 为例) pip install torch==2.4.1 torchvision==0.19.1 torchaudio==2.4.1 --index-url https://download.pytorch.org/whl/cu121 # 安装其他依赖 pip install -r requirements.txt

(4)下载模型

项目依赖两个核心模型:Step-Audio-Tokenizer 与 Step-Audio-EditX,支持从 Hugging Face 或 ModelScope 下载(推荐使用 Git LFS 避免大文件下载失败):

# 安装 Git LFS git lfs install # 从 Hugging Face 下载模型(推荐海外用户) git clone https://huggingface.co/stepfun-ai/Step-Audio-Tokenizer git clone https://huggingface.co/stepfun-ai/Step-Audio-EditX # 从 ModelScope 下载模型(推荐国内用户,速度更快) # git clone https://modelscope.cn/models/stepfun-ai/Step-Audio-Tokenizer.git # git clone https://modelscope.cn/models/stepfun-ai/Step-Audio-EditX.git

(5)启动 Gradio 在线演示

python app.py

启动后,访问终端输出的 URL(如 http://localhost:7860),即可在浏览器中使用可视化界面:

文本输入:输入需要转换的文本(支持添加情感/风格/副语言标签);

参数调整:选择语言/方言、情感、风格(可选);

生成音频:点击“Generate”按钮,等待生成完成后播放或下载音频。

(6)命令行调用(进阶用法)

若需集成到代码中,可使用 tts.py 进行命令行调用:

# 示例:生成四川话+快乐+笑声的语音 python tts.py \ --text "[Sichuanese] [Happy] [Laughter] 今天中了500万,太开心了!" \ --output_dir ./output \ --model_path ./Step-Audio-EditX \ --tokenizer_path ./Step-Audio-Tokenizer

输出音频将保存到 ./output 目录下(默认格式为 wav)。

2. Docker 部署步骤

若本地环境配置复杂,可使用项目提供的 Dockerfile 快速搭建环境:

# 构建 Docker 镜像 docker build -t stepaudioedit . # 运行容器(映射端口 7860,挂载模型目录) docker run -d -p 7860:7860 \ -v $(pwd)/Step-Audio-Tokenizer:/app/Step-Audio-Tokenizer \ -v $(pwd)/Step-Audio-EditX:/app/Step-Audio-EditX \ stepaudioedit

启动后同样访问 http://localhost:7860 使用界面。

六、常见问题解答(FAQ)

1. 模型下载慢或失败怎么办?

国内用户:优先使用 ModelScope 下载(

https://modelscope.cn/models/stepfun-ai/...),速度更快;Git LFS 失败:手动下载模型文件(Hugging Face/ModelScope 模型页面提供“Files and versions”下载入口),解压后放到项目根目录;

网络代理:配置 Git 代理(

git config --global http.proxy http://代理地址:端口)后重试。

2. 运行时提示“CUDA out of memory”(显存不足)怎么办?

硬件升级:更换显存 ≥12GB 的 GPU(如 L40S、3090);

等待量化模型:项目计划推出 Int8 量化模型,预计支持 8GB 显存运行;

优化参数:在

app.py或tts.py中降低batch_size(如设置为 1),减少显存占用(可能影响推理速度)。

3. 生成的音频情感/风格效果不佳怎么办?

优化指令:明确指定情感/风格标签(如

[Angry:0.9]增强愤怒强度),避免模糊描述;添加参考语音:若使用语音克隆功能,提供清晰、情感明确的参考语音(10-30 秒);

检查文本:确保文本内容与情感/风格匹配(如“开心”的文本搭配

[Happy]标签)。

4. 支持长音频生成吗?

目前版本更适合短音频(≤30 秒),长音频可能导致生成质量下降或显存不足;

长音频建议分段生成后,使用音频编辑工具(如 Audacity)拼接。

5. 可以添加自定义情感/风格吗?

目前项目暂不支持自定义情感/风格,但可通过 GitHub Issues 提交需求(

https://github.com/stepfun-ai/Step-Audio-EditX/issues);未来训练代码开源后,用户可基于 SFT 训练添加自定义情感/风格。

6. 输出音频格式可以调整吗?

默认输出为 wav 格式(无损音质);

若需 MP3 等格式,可使用

ffmpeg转换(如ffmpeg -i input.wav output.mp3)。

七、相关链接

Hugging Face 模型库:

Step-Audio-EditX:https://huggingface.co/stepfun-ai/Step-Audio-EditX

Step-Audio-Tokenizer:https://huggingface.co/stepfun-ai/Step-Audio-Tokenizer

ModelScope 模型库:

Step-Audio-EditX:https://modelscope.cn/models/stepfun-ai/Step-Audio-EditX

Step-Audio-Tokenizer:https://modelscope.cn/models/stepfun-ai/Step-Audio-Tokenizer

八、总结

Step-Audio-EditX 是一款基于 LLM 的开源音频编辑工具,核心优势在于“零样本多语言支持”“情感与风格精细化控制”“副语言特征自然融合”,通过简单的文本指令即可实现富有表现力的音频生成与编辑。项目已开源推理代码、Gradio 演示及核心模型,支持 Linux 系统与 NVIDIA GPU 部署,适用于内容创作、游戏配音、方言内容生产、无障碍应用等多种场景。尽管目前训练代码与量化模型仍在开发中,但已提供足够灵活的工具链供开发者与创作者使用。作为开源项目,Step-Audio-EditX 不仅降低了音频 AI 技术的使用门槛,也为开发者提供了二次开发的基础,有望推动音频编辑领域的智能化创新。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/step-audio-editx.html