Zen MCP Server:开源多模型协作工作流服务器,连接各类 AI 工具与模型

1. Zen MCP Server是什么

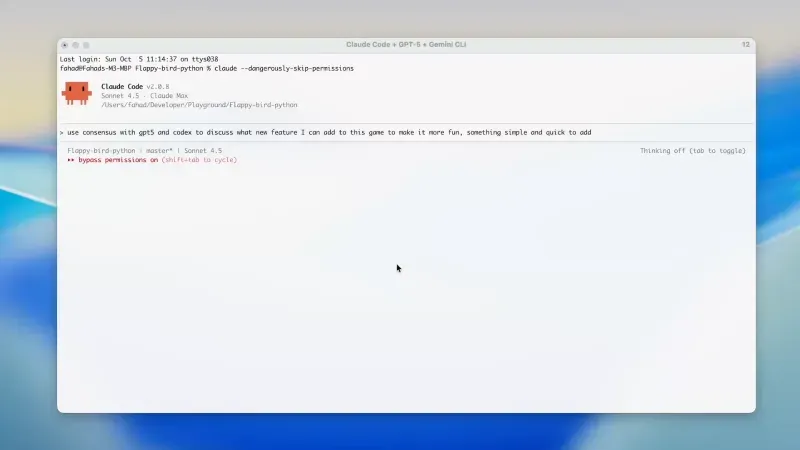

Zen MCP Server是一个开源的多模型协作工作流服务器,旨在连接各类AI工具与模型,实现跨工具、跨模型的协同工作流,从而提升开发效率与分析能力。它支持主流AI工具和多种AI模型,通过CLI桥接与子代理机制实现上下文隔离和角色专业化,为复杂任务提供协作式解决方案。

该项目的核心思想是创建一个"AI协作平台",让不同的AI模型能够像团队成员一样协同工作,各自发挥专长,共同解决复杂问题。通过Zen MCP Server,用户可以在单一工作流中调用不同的AI工具和模型,实现专业化分工和高效协作。

Zen MCP Server特别适合需要多步骤推理、多模型验证或复杂分析的任务,如代码审查、系统调试、项目规划等。它提供了标准化的接口和工具集,使AI模型能够无缝协作,同时保持上下文的连续性和一致性。

2. 功能特色

2.1 多工具与多模型集成

Zen MCP Server支持主流AI工具和多种AI模型,包括但不限于:

| 支持的AI工具 | 支持的AI模型 |

|---|---|

| Claude Code | Gemini系列 |

| Gemini CLI | OpenAI系列 |

| Codex CLI | Anthropic系列 |

| 自定义工具 | Ollama本地模型 |

| Hugging Face模型 |

这种广泛的兼容性使得用户可以根据任务需求选择最适合的工具和模型组合,而不受限于单一平台或供应商。

2.2 CLI桥接与子代理机制

Zen MCP Server通过clink工具连接外部AI CLI,支持在当前CLI中启动隔离的子代理。这种机制带来了以下优势:

上下文隔离:不同任务可以在独立的上下文中运行,避免相互干扰

角色专业化:可以为不同任务创建专门的AI角色,如

planner(规划师)、codereviewer(代码审查员)等模型协作:允许一个AI模型调用另一个AI模型来处理特定子任务

避免主会话污染:子代理的操作不会影响主会话的上下文和状态

2.3 协作式工作流

Zen MCP Server支持对话线程和上下文连续性,使不同模型能协同讨论、交换推理结果,实现复杂工作流。这种协作模式特别适合以下场景:

多模型代码审查 → 自动化规划 → 实现 → 提交前验证

数据分析 → 可视化 → 报告生成

研究探索 → 假设验证 → 结论总结

2.4 专业化工具集

仓库提供多种专业化工具,核心包括:

| 工具名称 | 主要功能 | 默认状态 |

|---|---|---|

codereview | 系统化代码审查,支持多步骤分析、问题严重性分类 | 启用 |

consensus | 获取多模型专家意见,支持立场引导和决策辩论 | 启用 |

debug | 系统化故障排查和根因分析 | 启用 |

precommit | 提交前验证,防止代码回归 | 启用 |

analyze | 代码分析工具,支持架构、性能、安全等专项分析 | 禁用 |

refactor | 智能代码重构,支持代码异味检测、大型组件分解 | 禁用 |

这些工具可以单独使用,也可以组合成复杂的工作流,满足不同场景的需求。

2.5 灵活的配置与扩展性

Zen MCP Server提供了灵活的配置系统,允许用户:

自定义模型参数和优先级

配置工具的启用/禁用状态

设置工作流的默认行为

集成自定义工具和模型

项目的模块化设计也使其易于扩展,开发者可以轻松添加新的工具、模型支持或工作流模板。

3. 技术细节

3.1 架构设计

Zen MCP Server采用模块化架构,主要包含以下组件:

核心服务器(server.py):暴露MCP入口点,协调多模型工作流

工具模块(tools/):存放各类功能工具,如代码审查、调试等

模型集成(providers/):实现各AI模型提供商的集成

共享工具(utils/):包含通用辅助函数

配置系统(conf/):管理项目配置模板和用户设置

通信系统:处理模型间和工具间的通信

上下文管理器:维护会话状态和上下文信息

3.2 通信协议

Zen MCP Server实现了自定义的模型上下文协议(Model Context Protocol,MCP),该协议定义了:

模型与工具之间的通信格式

上下文信息的传递方式

工作流指令的执行规范

错误处理和日志记录标准

这种标准化的协议使得不同的AI模型和工具能够无缝协作,而不必关心对方的具体实现细节。

3.3 上下文管理

上下文管理是Zen MCP Server的核心功能之一,它负责:

维护会话状态

管理对话历史

传递上下文信息给不同的模型和工具

实现上下文隔离和恢复

上下文系统支持多种存储后端,包括内存存储、文件存储和数据库存储,以适应不同的使用场景。

3.4 安全与权限控制

Zen MCP Server包含基本的安全机制:

API密钥管理

权限控制(基于角色的访问控制)

日志记录和审计

输入验证和过滤

这些机制确保了系统的安全性,特别是在处理敏感代码或数据时。

3.5 性能优化

为了提高性能,Zen MCP Server采用了多种优化策略:

模型调用缓存

异步任务处理

批量请求处理

资源池化

这些优化措施使得系统能够高效处理多个并发请求,即使在调用多个外部AI模型时也能保持良好的响应速度。

4. 应用场景

Zen MCP Server的灵活性和强大功能使其适用于多种场景:

4.1 软件开发

| 场景 | 应用方式 | 优势 |

|---|---|---|

| 代码审查 |

使用codereview工具结合多个代码专家模型 | 多模型视角,发现更多潜在问题 |

| 调试 | debug工具引导多模型协作定位问题 | 结合不同模型的专长,提高调试效率 |

| 重构 | refactor工具分析代码结构并提出改进建议 | 系统化重构,减少技术债务 |

| 提交前验证 | precommit工具自动检查代码质量 | 防止低质量代码进入代码库 |

4.2 数据分析与科学研究

多模型数据分析:结合统计分析模型和领域专家模型,获得更全面的分析结果

研究假设验证:使用

consensus工具获取多个AI专家的意见,验证研究假设文献综述:自动化处理大量文献,提取关键信息并生成综合报告

4.3 内容创作

多风格写作:不同模型负责不同风格的内容创作,然后整合成统一风格

内容审核:多个模型协作检查内容的准确性、合规性和质量

创意生成:结合不同AI模型的创意优势,产生更丰富的创意

4.4 教育与培训

个性化学习计划:根据学生特点制定定制化学习计划

多视角教学:不同AI教师从不同角度解释同一概念

自动化评估:AI模型协作评估学生作业,提供全面反馈

4.5 商业决策支持

市场分析:结合数据分析模型和行业专家模型,提供更全面的市场洞察

风险评估:多模型协作评估商业决策的潜在风险

战略规划:AI团队协作制定长期战略计划

5. 使用方法

5.1 环境搭建

克隆仓库

git clone https://github.com/BeehiveInnovations/zen-mcp-server.git cd zen-mcp-server

安装依赖

./run-server.sh

该脚本会安装必要的依赖、刷新环境变量并启动服务器。

配置环境变量 创建

.env文件,添加必要的API密钥和配置信息:

OPENAI_API_KEY=your_api_key ANTHROPIC_API_KEY=your_api_key GEMINI_API_KEY=your_api_key

5.2 基本使用

启动服务器

python server.py

使用CLI工具

# 启动代码审查 ./clink codereview --file path/to/your/code.py # 启动调试会话 ./clink debug --issue "描述你的问题" # 获取多模型共识 ./clink consensus --question "你的问题"

使用子代理

# 在当前会话中启动代码审查子代理 ./clink subagent codereviewer # 在子代理中执行任务 analyze code path/to/code

5.3 高级用法

创建自定义工作流 在

workflows/目录下创建YAML格式的工作流文件:

name: code_quality_check

steps:

- name: analyze_code

tool: analyze

params:

path: "{{ code_path }}"

- name: review_code

tool: codereview

params:

file: "{{ code_path }}"

- name: generate_report

tool: report

params:

title: "代码质量报告"调用自定义工作流

./clink workflow run code_quality_check --var code_path=path/to/code.py

集成自定义工具

在

tools/目录下创建新的Python模块实现工具接口

在配置文件中启用新工具

6. 常见问题解答

Q: 安装过程中遇到依赖错误怎么办?

A: 确保你的Python版本符合要求(建议3.9+),然后尝试手动安装依赖:pip install -r requirements.txt。如果问题仍然存在,请查看错误日志并在项目的Issue跟踪器中报告。

Q: 如何配置多个AI模型?

A: 在.env文件中添加相应的API密钥即可。Zen MCP Server会自动检测并使用可用的模型。你也可以在配置文件中设置模型优先级。

Q: 如何确保不同模型之间的上下文一致性?

A: Zen MCP Server的上下文管理器会自动处理这个问题。当一个模型调用另一个模型时,系统会传递相关的上下文信息。你也可以使用--context参数手动指定需要传递的上下文。

Q: 子代理和主代理有什么区别?

A: 子代理是在主代理会话中创建的独立会话,拥有自己的上下文和配置。子代理可以调用其他模型或工具,但不会影响主代理的状态。这对于需要隔离上下文的复杂任务特别有用。

Q: 系统在处理大量并发请求时性能如何?

A: Zen MCP Server采用了异步处理和资源池化等技术来优化性能。对于极高并发的场景,建议使用负载均衡器将请求分发到多个Zen MCP Server实例。

Q: 如何确保敏感数据的安全?

A: Zen MCP Server提供了多种安全机制,包括API密钥管理、权限控制和输入验证。对于特别敏感的数据,建议使用本地模型或在私有网络中部署系统。

Q: 如何添加自定义工具?

A: 创建一个新的Python模块,实现工具接口,然后在配置文件中注册该工具。详细步骤可以参考项目文档中的"扩展指南"。

Q: 是否支持自定义AI模型?

A: 是的,Zen MCP Server的设计具有良好的扩展性。你可以通过实现相应的提供商接口来添加对新AI模型的支持。

7. 相关链接

8. 总结

Zen MCP Server是一个功能强大的开源多模型协作工作流服务器,它通过连接各类AI工具与模型,实现了跨平台、跨模型的协同工作流。无论是在软件开发、数据分析、内容创作还是教育培训等领域,Zen MCP Server都能发挥重要作用,帮助用户提高工作效率和分析能力。其灵活的架构设计和丰富的工具集使其易于扩展和定制,能够满足不同场景的需求。通过CLI桥接与子代理机制,Zen MCP Server实现了上下文隔离和角色专业化,为复杂任务提供了理想的协作环境。无论是个人开发者还是大型团队,都能从Zen MCP Server中获益,实现AI模型的高效协作和最大化利用。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/zen-mcp-server.html