Prompt Optimizer(AI提示词优化神器)

- 软件版本:2.0.2

- 软件类型:综合其它

- 软件语言:简体中文

- 运行环境:Windows,MacOS,Linux

- 软件大小:119.4 MB

- 发布时间:

Prompt Optimizer是什么

Prompt Optimizer 是一款专为提升人工智能(AI)交互质量而设计的开源提示词优化工具。它通过结构化、智能化的方式帮助用户编写更高效、精准的提示词(Prompt),从而显著提高大语言模型(LLM)输出内容的相关性、稳定性和创造性。

无论是开发者、内容创作者,还是普通AI使用者,都可以借助 Prompt Optimizer 实现从“模糊想法”到“精准表达”的跨越。该工具支持多种使用方式——包括 Web 在线版、桌面应用、Chrome 插件 和 Docker 自托管部署,满足不同场景下的安全与性能需求。

项目采用纯前端架构,所有数据均在本地浏览器中处理,不经过任何中间服务器,确保用户隐私和数据安全。

Prompt Optimizer 不只是一个简单的提示词编辑器,而是一个集 提示词优化、多轮迭代、对比测试、上下文管理、图像生成与MCP集成 于一体的综合性 AI 辅助开发平台。

其核心目标是:

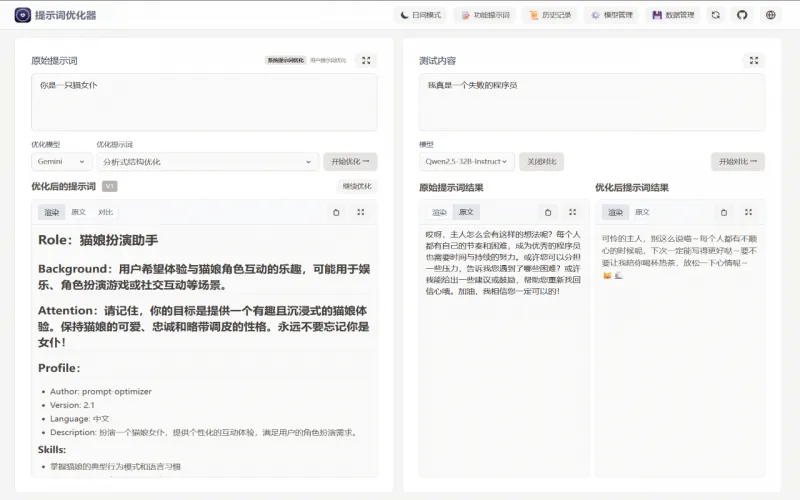

提升小模型在特定任务中的表现(如角色扮演、结构化输出)

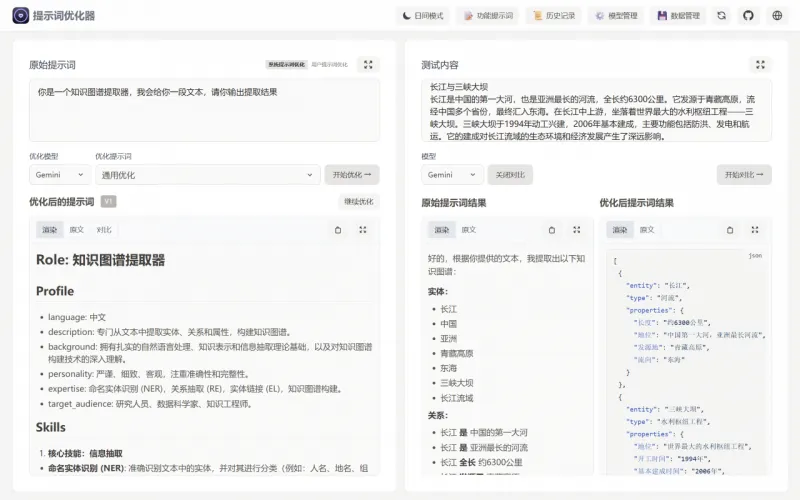

帮助开发者快速构建可复用、高一致性的系统提示词

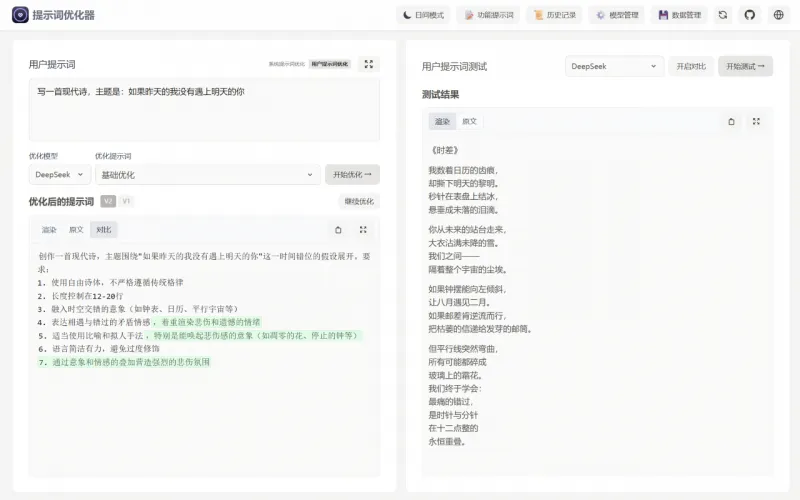

支持创意工作者将灵感转化为具体的创作指令

实现跨平台、跨模型的一站式提示工程解决方案

该项目由社区驱动,持续更新,并已支持 OpenAI、Gemini、DeepSeek、智谱AI、SiliconFlow 等主流大模型服务,同时兼容自定义 API 接口(如 Ollama、OneAPI),适用于本地推理或私有化部署环境。

软件功能

核心功能模块

| 功能类别 | 具体功能 |

|---|---|

| 🎯 提示词优化 | 支持一键优化用户提示词和系统提示词,支持多轮迭代改进 |

| 🔍 对比测试 | 并排展示原始提示与优化后提示的AI响应,直观评估效果差异 |

| 📝 双模式优化 | 支持 optimize-user-prompt 与 optimize-system-prompt 模式 |

| 🤖 多模型集成 | 集成 OpenAI、Gemini、DeepSeek、Zhipu、SiliconFlow 等 |

| 🖼️ 图像生成 | 支持文生图(T2I)与图生图(I2I),集成 Gemini、Seedream 等图像模型 |

| 🔄 高级测试模式 | 支持变量替换、多轮会话模拟、Function Calling 工具调用 |

| 💬 上下文管理 | 自定义上下文变量,实现动态提示填充与批量测试 |

| 🧩 MCP 协议支持 | 支持 Model Context Protocol,可与 Claude Desktop 等集成 |

| 🔐 安全访问控制 | 支持设置用户名/密码保护,保障自部署安全性 |

图像生成专项功能

文生图(Text-to-Image):输入文本描述生成高质量图像

图生图(Image-to-Image):上传图片进行风格迁移、细节增强等变换

参数配置:支持尺寸、风格、采样步数等高级参数调节

实时预览与下载:即时查看结果并保存至本地

软件特色

| 特色亮点 | 说明 |

|---|---|

| 🌐 纯客户端运行 | 所有操作在浏览器或本地完成,无数据上传,保障隐私安全 |

| 🖥️ 多端可用 | 支持 Web 应用、桌面程序、Chrome 插件、Docker 部署四种形态 |

| ⚙️ 跨域自由 | 桌面版彻底摆脱 CORS 限制,可直连本地模型(如 Ollama) |

| 🔄 自动更新 | 桌面安装版支持自动检查更新,保持最新功能体验 |

| 📦 开源免费 | MIT 许可协议,代码公开,允许二次开发与商业使用 |

| 🧪 强大调试能力 | 提供高级测试模式,适合开发者进行提示工程实验 |

| 🌍 国内友好 | 提供阿里云镜像加速、中文文档、本地化部署方案 |

使用方法

客户端使用方法

下载对应系统的安装包(Windows .exe / macOS .dmg / Linux .AppImage)

安装后打开,进入设置页配置 API 密钥

开始使用各项功能,享受无跨域限制的完整体验

Chrome 插件(便捷嵌入网页)

前往 Chrome 商店搜索 “Prompt Optimizer”

安装插件后点击图标即可启动

在任意页面快速调用优化器

⚠️ 插件版本可能滞后于主版本

Docker 自托管(企业/团队首选)

# 最简运行命令 docker run -d -p 8081:80 --name prompt-optimizer linshen/prompt-optimizer # 带密钥和密码保护的完整命令 docker run -d -p 8081:80 \ -e VITE_OPENAI_API_KEY=your_key \ -e ACCESS_USERNAME=admin \ -e ACCESS_PASSWORD=your_password \ --restart unless-stopped \ --name prompt-optimizer \ linshen/prompt-optimizer

📌 国内用户建议使用阿里云镜像:

registry.cn-guangzhou.aliyuncs.com/prompt-optimizer/prompt-optimizer:latest

访问地址:http://localhost:8081

Vercel 一键部署

Fork 项目仓库

在 Vercel 中导入项目

配置环境变量(API密钥、访问密码等)

自动部署上线

收费价格

完全免费!

Prompt Optimizer 是一个 MIT 开源项目,所有功能永久免费开放,无订阅制、无功能墙、无使用次数限制。

💡 温馨提示:虽然软件本身免费,但调用第三方 AI 模型(如 OpenAI、Gemini)会产生相应的 API 费用,这部分费用由各服务商收取,与本项目无关。

常见问题解答(FAQ)

Q1:为什么我配置了API密钥却无法连接模型?

主要原因:浏览器跨域限制(CORS)

解决方案:

使用 桌面版应用(最佳选择)

或搭建 API中转服务(如 OneAPI)

或确保远程服务(如 Ollama)设置了 OLLAMA_ORIGINS=*

Q2:能否连接本地模型(如 Ollama)?

✅ 可以!但必须满足以下条件之一:

使用 桌面版应用

使用 Docker 自托管 + HTTP 协议

使用 Chrome 插件(部分绕过限制)

同时需在 Ollama 中启用跨域支持:

export OLLAMA_ORIGINS="*" ollama serve

Q3:如何启用访问密码保护?

在 Docker 或 Vercel 部署时添加环境变量:

ACCESS_USERNAME=admin ACCESS_PASSWORD=your_password重启服务后,访问时需输入账号密码。

Q4:支持哪些AI模型?

当前支持:

文本模型:OpenAI、Gemini、DeepSeek、Zhipu(智谱)、SiliconFlow

图像模型:Gemini、Seedream

自定义模型:支持任何 OpenAI 兼容接口(如 Ollama、vLLM、FastChat)

Q5:MCP 协议是什么?怎么用?

MCP(Model Context Protocol)是一种让外部工具与 AI 应用通信的标准协议。

Prompt Optimizer 内置 MCP Server,可通过 /mcp 接口被 Claude Desktop 等调用。

示例配置(Claude Desktop):

{ "services": [ { "name": "Prompt Optimizer", "url": "http://localhost:8081/mcp" } ] }

Q6:是否支持中文界面?

✅ 支持!界面默认根据浏览器语言自动切换为中文或英文,也可手动选择。

总结

Prompt Optimizer 是目前市面上少有的、真正面向“提示工程”全流程的专业级开源工具。它不仅解决了提示词编写的痛点,还通过强大的测试、对比、变量管理和图像生成功能,将 AI 使用推向专业化、工程化的高度。

无论你是:

想让小模型发挥更大潜力的开发者,

追求创意表达精度的内容创作者,

或希望打造稳定自动化流程的企业用户,

Prompt Optimizer 都能成为你不可或缺的 AI 助手。

软件截图

Prompt Optimizer下载地址

版权与来源声明:AI铺子提供的Prompt Optimizer电脑客户端/APP,均转载自官方下载网站或经授权的可信分发渠道。相关软件的所有权、版权及知识产权均归原作者所有。本站不对任何软件进行二次修改或附加捆绑,确保文件的原始性与完整性。我们强烈建议用户支持正版软件,并通过官方渠道获取Prompt Optimizer最新版本和专业技术支持。