TalkCody(开源AI编程代理工具)

- 软件版本:0.1.13

- 软件类型:编程开发

- 软件语言:英文

- 运行环境:Windows,MacOS,Linux

- 软件大小:17.3 MB

- 发布时间:

TalkCody是什么

TalkCody 是一款免费、开源的AI编程代理(AI Coding Agent),专为开发者设计,旨在提升软件开发效率。它通过集成多种主流AI大语言模型,提供智能代码生成、项目规划、终端执行、多模态输入等强大功能,帮助程序员在本地环境中高效完成编码任务。

TalkCody采用 Rust + Tauri 构建,具备原生性能、快速响应和低资源占用的特点,支持跨平台运行(macOS、Windows、Linux)。其核心理念是“用户掌控一切”——从API密钥到数据存储,完全由用户自主控制,无中间商加价,无数据泄露风险。

TalkCody 不只是一个简单的AI代码补全插件,而是一个完整的AI驱动开发环境代理系统。它融合了现代前端技术与系统级后端能力,构建了一个可扩展、高度定制化的AI辅助开发平台。

前端架构:基于 React 19 + TypeScript 开发,界面现代化,交互流畅。

后端架构:使用 Tauri 2 + Rust 实现高性能本地服务,确保安全性和速度。

通信协议:支持 Model Context Protocol (MCP),可通过 MCP Server 扩展AI能力。

模型接入:支持超过50种主流AI模型,包括 OpenAI、Claude、Gemini、DeepSeek 等,并可无缝接入 Ollama 运行本地模型。

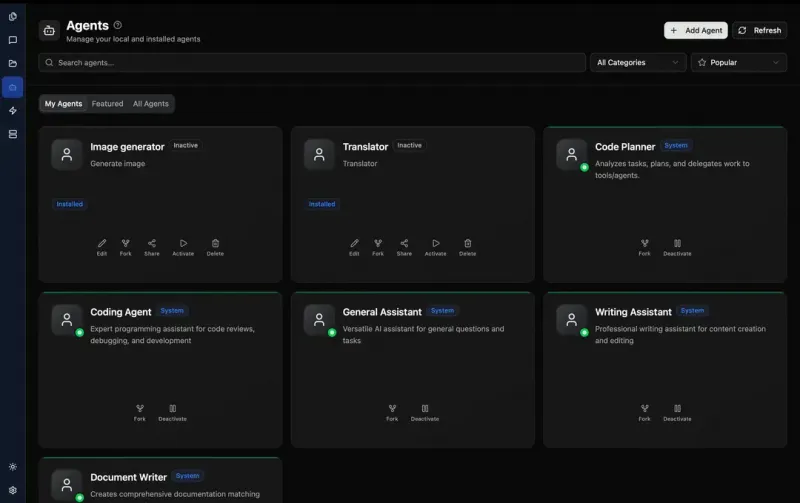

社区生态:设有 Agents & Skills Marketplace,开发者可共享自动化工作流和专用智能体。

TalkCody 完全遵循 MIT 许可证,代码公开透明,适合个人开发者、团队以及对数据隐私有高要求的企业使用。

软件功能

| 功能类别 | 具体功能 |

|---|---|

| AI 编程辅助 | 智能代码生成、函数注释、错误修复、代码重构建议 |

| 多模型支持 | 支持 OpenAI、Anthropic Claude、Google Gemini、DeepSeek、Mistral、Llama 等 50+ 模型 |

| BYOK 模式 | 用户自带API密钥(Bring Your Own Key),直接对接服务商,无中间商 markup |

| 本地化部署 | 支持 Ollama 部署本地模型,实现全离线运行,保障数据隐私 |

| 多模态输入 | 支持文本、语音、图像、文件等多种输入方式,提升交互灵活性 |

| 内置终端 | 可在应用内执行命令行操作,无需切换窗口 |

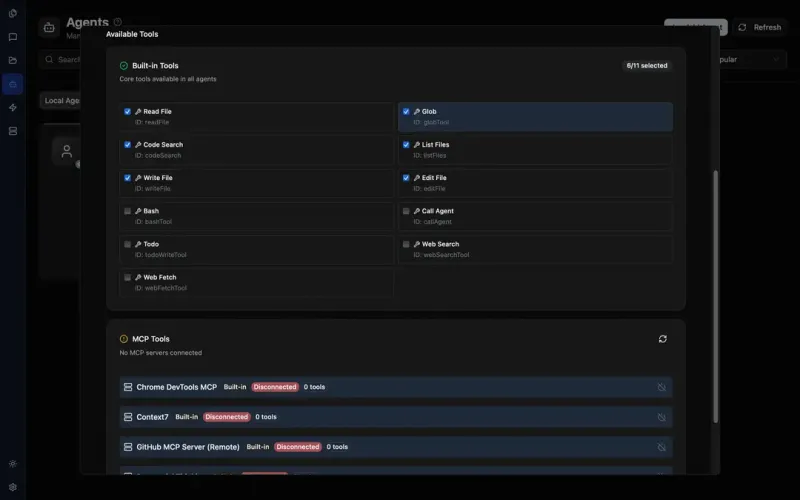

| 自定义能力 | 支持自定义系统提示词(System Prompts)、工具链、技能(Skills)、代理(Agents) |

| 规划模式(Plan Mode) | 对复杂项目进行分步拆解,制定开发计划 |

| MCP 服务器 | 通过 Model Context Protocol 接入外部知识源或工具接口 |

| 开发者友好 | 提供完整的开发文档,支持源码编译与二次开发 |

软件特色

开源透明

全部代码托管于 GitHub,社区驱动开发,任何人都可以审查、贡献或审计安全性。

模型自由选择

不受限于单一供应商,用户可根据需求自由切换不同AI提供商和模型版本,第一时间体验最新发布的大模型。

隐私优先设计

所有项目数据、对话记录均保存在本地设备上,不上传任何服务器;支持完全离线运行,适用于敏感项目开发。

零锁定策略(Zero Lock-in)

无需注册账号,无需绑定支付,用户自行管理API密钥,避免厂商锁定和费用不透明问题。

高性能原生体验

基于 Rust 和 Tauri 构建,启动快、响应迅速、内存占用低,远优于 Electron 类应用。

高度可定制化

从提示词模板到AI行为逻辑,均可深度配置,满足专业开发者个性化需求。

活跃社区生态

拥有 Agents & Skills Marketplace,用户可下载他人分享的工作流,也可发布自己的智能体解决方案。

使用方法

步骤 1:下载安装

前往官网或 GitHub 发布页下载对应平台版本:

macOS(Apple Silicon / Intel)

Windows(x64)

Linux(x86_64 AppImage)

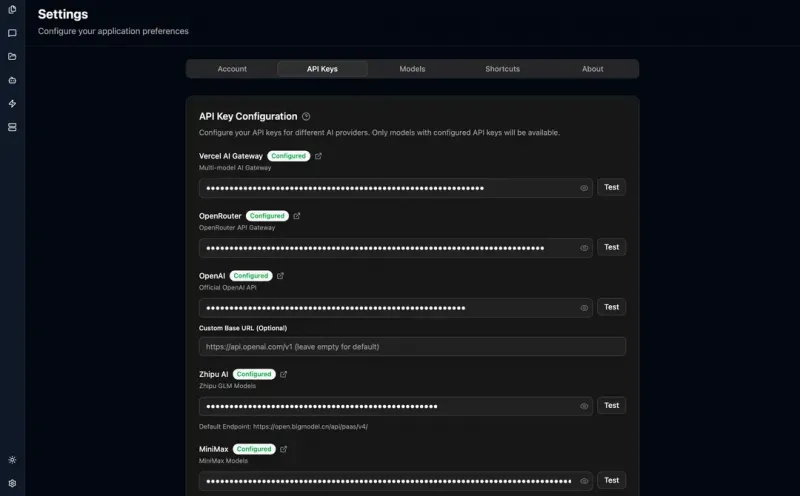

步骤 2:配置 API 密钥

打开应用后,在设置中添加你已有的 AI 服务密钥,例如:

OpenAI API Key

Anthropic API Key(Claude)

Google API Key(Gemini)

或配置 Ollama 本地模型地址

✅ 推荐使用 .env 文件管理密钥,增强安全性

步骤 3:选择 AI 模型

在模型选择器中挑选你要使用的模型,如 gpt-4o、claude-3-opus、gemini-pro 或本地运行的 llama3:70b。

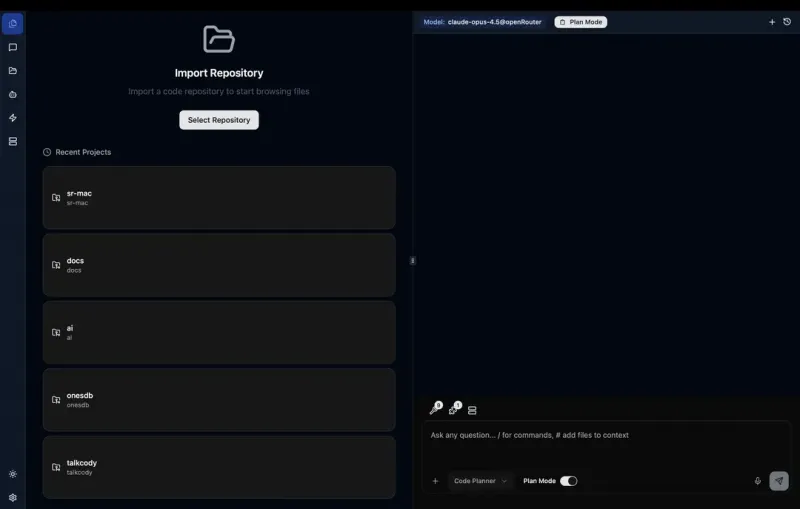

步骤 4:导入项目

将你的代码项目文件夹拖入 TalkCody,AI 将自动分析上下文结构。

步骤 5:开始编码协作

输入自然语言指令(如“帮我写一个登录接口”)

使用语音或图片描述需求

查看AI生成的代码并一键插入

在内置终端中运行测试命令

收费价格

TalkCody 本身完全免费!

软件免费:TalkCody 是 MIT 开源项目,永久免费,无订阅费、无功能限制。

AI服务费用自理:你需要自行承担所选AI模型的调用成本(如 OpenAI 的 token 费用),但因采用 BYOK(自带密钥) 模式,费用直接支付给 AI 提供商,无额外加价。

本地模型免费运行:若使用 Ollama 运行本地模型(如 Llama、Mistral),则几乎零成本运行。

总结:“软件免费 + 算力按需付费” 的灵活模式,让用户掌握预算主动权。

常见问题解答(FAQ)

Q1:TalkCody 是否需要联网?

A:部分功能需要联网(如调用云端AI模型),但支持通过 Ollama 运行本地模型,实现完全离线使用。

Q2:我的代码会被上传吗?

A:不会。TalkCody 默认只将必要的上下文发送给AI模型(取决于模型类型),且所有数据默认保留在本地。你可以通过设置进一步限制上下文范围或启用脱敏模式。

Q3:是否支持中文?

A:支持。底层AI模型大多支持中文理解和生成,TalkCody 界面也正在逐步增加中文本地化支持。

Q4:能否与 VS Code 插件比较?

A:TalkCody 是独立桌面应用,功能更全面,尤其强调本地化、隐私保护、多模型自由切换,适合追求掌控感和技术深度的开发者。

Q5:支持哪些操作系统?

A:目前支持:

macOS(Apple Silicon 和 Intel)

Windows 10/11(64位)

Linux(x86_64 AppImage 格式,兼容大多数发行版)

总结

TalkCody是一款面向未来的开发者利器,它不仅提供了强大的AI辅助编程能力,更重要的是坚持“开源、透明、可控、隐私优先”的核心价值观。对于希望摆脱闭源AI工具束缚、掌控自己开发流程的程序员来说,TalkCody 提供了一个理想的替代方案——既能享受最先进的AI能力,又能确保数据安全与成本透明。

无论你是独立开发者、开源贡献者,还是企业技术团队,都可以借助 TalkCody 实现更高效、更智能、更自主的编码体验。

TalkCody下载地址

版权与来源声明:AI铺子提供的TalkCody电脑客户端/APP,均转载自官方下载网站或经授权的可信分发渠道。相关软件的所有权、版权及知识产权均归原作者所有。本站不对任何软件进行二次修改或附加捆绑,确保文件的原始性与完整性。我们强烈建议用户支持正版软件,并通过官方渠道获取TalkCody最新版本和专业技术支持。