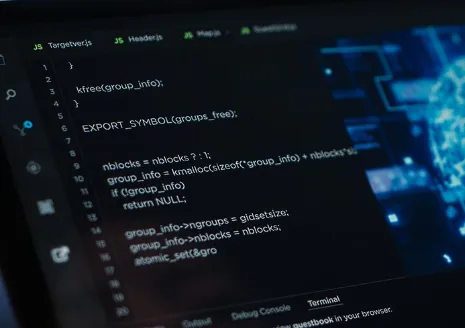

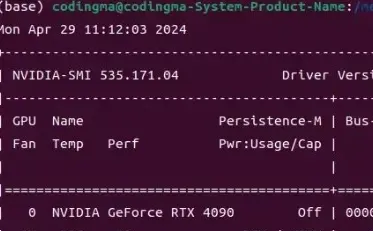

不靠 GPU,也能跑大模型?深入 llama.cpp 的硬核实践

详解 llama.cpp 架构原理、GGUF 模型格式、Q4_K_M 量化策略、CPU/GPU 部署实战、API 服务配置及 2025 新增路由模式。涵盖树莓派/Mac/Windows/Linux 全平台,附故障排查与性...

详解 llama.cpp 架构原理、GGUF 模型格式、Q4_K_M 量化策略、CPU/GPU 部署实战、API 服务配置及 2025 新增路由模式。涵盖树莓派/Mac/Windows/Linux 全平台,附故障排查与性...

深度解析8款GitHub热门开源AI抠图工具(IOPaint, RMBG 2.0, MODNet, BiRefNet, RobustVideoMatting等),涵盖静态图像与视频流处理。提供详细的技术原理、Star数对比、选型...

2026年最新AI绘画工具深度测评,对比Midjourney、Stable Diffusion、DALL-E 3及国内热门工具。从出图质量、生成速度、使用门槛到价格政策,为你揭示哪款AI绘图软件才是真正...

本文深度对比2026年主流AI编程工具Cursor、Copilot、Claude Code、Qoder、Trae与通义灵码,从代码生成速度、准确率、调试能力、多文件联动、自然语言理解及企业级应用等维度...

本文对 NullClaw、ZeroClaw、PicoClaw、NanoBot、OpenClaw 五款主流开源 AI 智能体框架进行真实、无虚构的全面对比测评,围绕二进制大小、峰值内存、0.8GHz 启动速度、测试...

本文深度解析OpenClaw原生痛点与社区优化方向,详细对比Claw家族6大轻量化AI Agent项目:Nanobot、PicoClaw、ZeroClaw、NanoClaw、IronClaw、TinyClaw,从定位、性能、适用...

零代码微调大模型实战指南!详解 LLaMA-Factory 框架下 LoRA+SFT 全流程:数据集构建、YAML 配置、WebUI 训练、动态推理、BLEU/ROUGE 评估、模型合并导出、OpenAI 兼容 API...

深度解析LLaMA-2(7B/13B/70B)与Mixtral(MoE架构)的提示词适配逻辑:5大LLaMA-2调优技巧(含Few-Shot、温度协同、否定约束)+3大Mixtral专属技巧(专家引导、分段标注、...

Mac mini 零基础部署 Clawdbot 私人AI助手教程:一行命令安装、Claude Opus 模型接入、神马中转API配置、Telegram/WhatsApp多平台接入,全程本地运行,保障数据隐私与执行自...

深度实测Seedance 2.0全能参考模式!详解9图+3视频+3音频+文字混合输入规范、@引用正确写法、12文件分配策略、首尾帧vs全能入口选择逻辑,附避坑清单与4–15秒生成时长实操...