从零部署 EchoMimicV3:蚂蚁集团开源多模态数字人生成框架实战指南

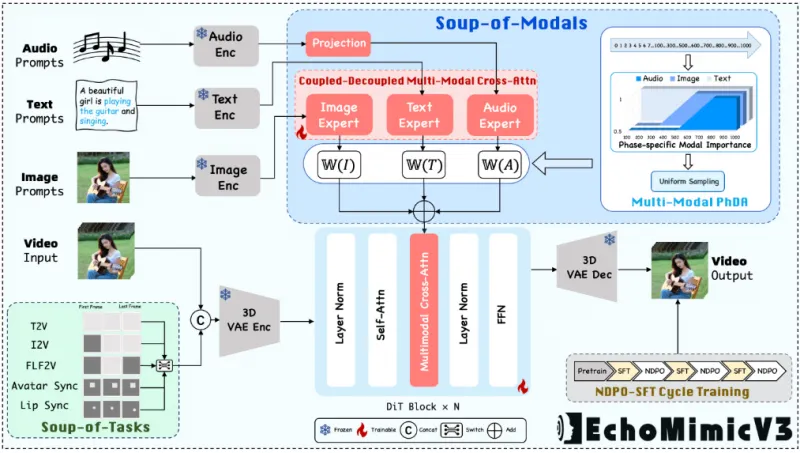

随着AIGC技术的迅猛发展,数字人已从概念走向实际应用,在虚拟主播、智能客服、教育娱乐等领域展现出巨大潜力。2023年8月底,蚂蚁集团开源了一款高效、多模态、多任务的数字人视频生成框架——EchoMimicV3,凭借仅13亿参数的紧凑型视频扩散模型(CVDM),实现了高质量、低延迟的数字人动画生成,引发了开发者社区的广泛关注。本文将带你从零开始,完整复现EchoMimicV3的本地化部署全过程,涵盖环境搭建、依赖安装、模型配置到Web服务启动等关键步骤,帮助你快速上手这一前沿开源项目,亲手打造属于自己的可对话数字人。

一、介绍

EchoMimicV3 是蚂蚁集团在8月底开源的一款高效、多模态、多任务的数字人视频生成框架,凭借13亿参数的紧凑型视频扩散模型(CVDM),实现了在多种输入条件下快速生成高质量、强泛化能力的数字人动画,为数字人动画技术带来了重要突破。

二、部署过程

快速部署及使用方法,请通过文末卡片进入算家云,参考“镜像社区”。

基础环境最低要求说明:

| 环境名称 | 版本信息 |

|---|---|

| Ubuntu | 22.04 |

| Cuda | 12.1.1 |

| Python | 3.10 |

| NVIDIA Corporation | RTX 4090 D |

1、在算家云构建基础镜像 Miniconda-Ubuntu-22.04-cuda12.1.1

2、更新系统

sudo apt update && sudo apt upgrade -y

更新过程中遇到下图的情况时,在命令行中输入“2”即可

3、创建虚拟环境

# 创建一个名为 echomimic_v3 的新虚拟环境,并指定 Python 版本为 3.10 conda create -n echomimic_v3 python=3.10 -y

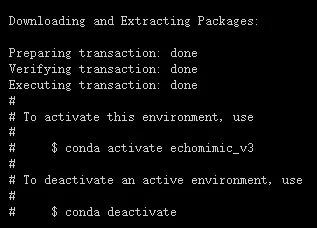

等待安装完成

# 进入虚拟环境 conda activate echomimic_v3

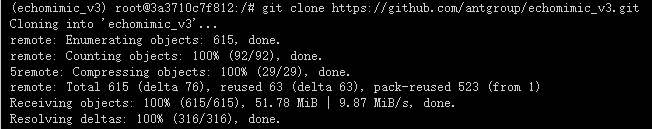

4、从 github 仓库 克隆项目

# (如果下载速度过慢可以开启学术代理加速) git clone https://github.com/antgroup/echomimic_v3.git

5、安装依赖

cd echomimic_v3 pip install -r requirements.txt

安装成功

6、模型准备

| 模型名称 | 备注 |

|---|---|

| Wan2.1-Fun-1.3B-InP | 基础模型 |

| wav2vec2-base | 音频编码器 |

| EchoMimicV3-preview | 权重 |

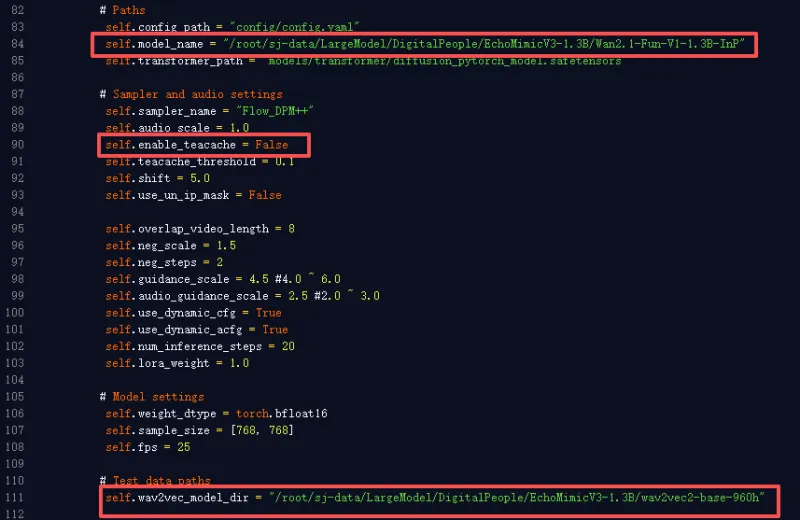

注意:由于Wan2.1-Fun-1.3B-InP和wav2vec2-base模型已经下载到堡垒机里面,所以这里不需要下载。之后在 app_mm.py文件中修改地址即可

6.1 下载权重

创建目录

cd echomimic_v3 mkdir -p models

下载元数据(不拉大文件)

cd models GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/BadToBest/EchoMimicV3

拉取大文件

cd EchoMimicV3/transformer git lfs pull

移动transformer文件夹

mv /echomimic_v3/models/EchoMimicV3/transformer /echomimic_v3/models

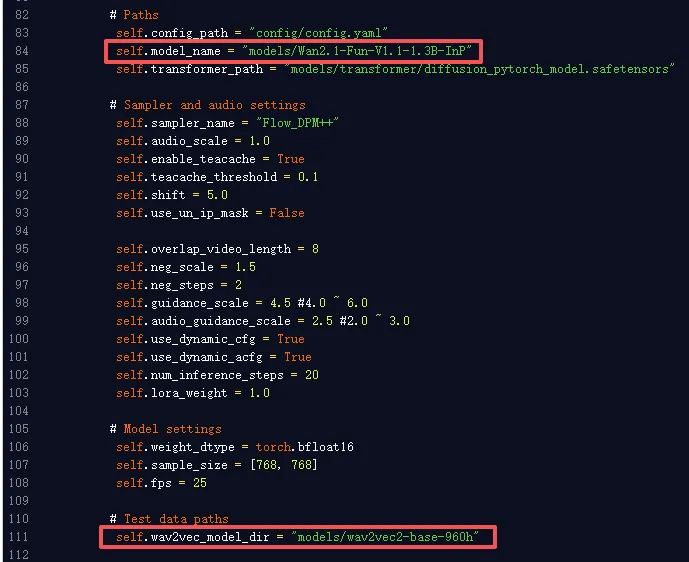

7、编辑 app_mm.py文件

7.1 打开 app_mm.py文件,找到第82行左右

修改红框部分:

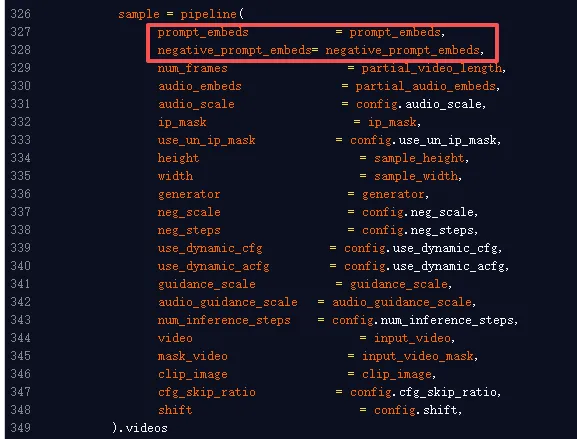

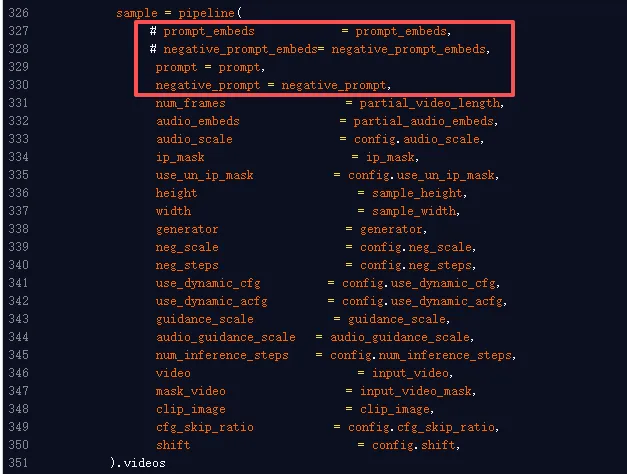

7.2 打开 app_mm.py文件,找到第326行左右

修改红框部分:

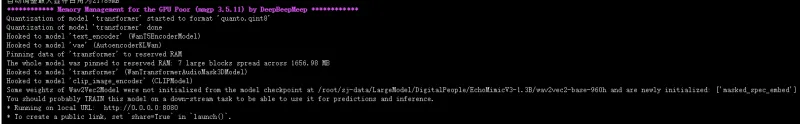

8、运行 app_mm.py文件

cd echomimic_v3 python app_mm.py --server_name 0.0.0.0 --server_port 8080

运行成功

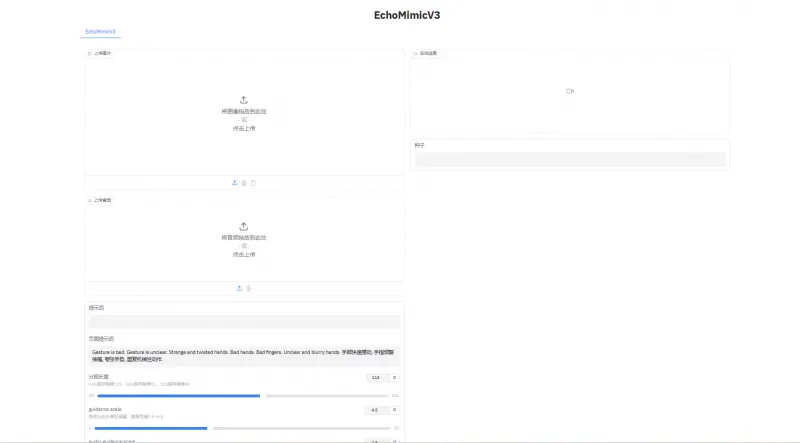

三、网页演示

出现以下 Gradio 页面,即是模型已搭建完成。

总结

本文详细记录了从基础环境准备到成功运行EchoMimicV3的完整部署流程,验证了其在算家云平台上的可行性与稳定性。通过使用Miniconda管理环境、Git LFS拉取模型权重、修改核心脚本路径并启动Gradio服务,我们最终实现了本地化的多模态数字人视频生成能力。EchoMimicV3不仅展示了蚂蚁集团在轻量化生成模型上的技术积累,也为广大研究者和开发者提供了低成本、高可用的数字人开发范例。未来,可进一步探索其在语音驱动口型同步、表情控制、个性化形象定制等方面的应用拓展,推动数字人技术真正“飞入寻常百姓家”。

版权及免责申明:本文来源于#算家计算,由@dotaai整理发布。如若内容造成侵权/违法违规/事实不符,请联系本站客服处理!该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/684.html