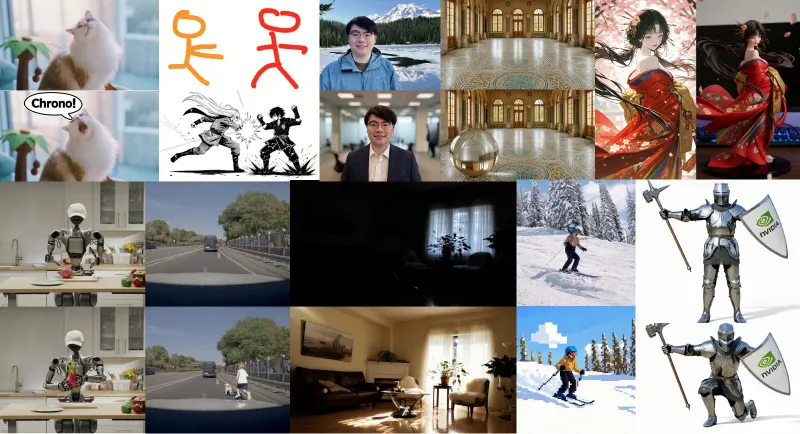

ChronoEdit:英伟达开源的时间一致型AI图像编辑与视频生成工具

一、ChronoEdit是什么?

ChronoEdit是英伟达NVIDIA多伦多AI实验室(nv-tlabs)开发的开源图像编辑与世界模拟工具,核心创新在于将传统图像编辑重构为视频生成任务——以输入图像和目标编辑图像作为起止帧,借力预训练视频模型的时间一致性优势,搭配专属时间推理阶段确保编辑效果的物理合理性,并可视化完整编辑轨迹。

其核心设计理念打破了传统图像编辑“单帧修改”的局限:将图像编辑任务重新定义为“从原始图像到目标图像的视频生成过程”——原始图像作为视频的起始帧,编辑后的目标图像作为结束帧,中间通过预训练视频扩散模型补全过渡帧,既保证了编辑前后的内容连贯性,又通过时间推理机制解决了物理合理性问题(如物体位置、光影变化符合现实逻辑)。

简单来说,传统工具编辑图像时,可能出现“添加的物体与场景光影不匹配”“修改后内容与原图风格割裂”等问题,而ChronoEdit通过“视频化轨迹”思维,让编辑过程像“动态演进”而非“静态粘贴”,最终既输出目标编辑结果,还能生成完整的编辑轨迹视频,直观呈现变化过程。

该项目采用Apache-2.0开源协议,代码仓库包含核心模型实现、推理脚本、训练工具、数据集生成脚本等完整组件,支持Linux系统下的本地部署与二次开发,目前已整合至diffusers官方管道,降低了开发者的使用门槛。

二、功能特色

ChronoEdit的功能围绕“时间一致性”“高灵活性”“强实用性”三大核心展开,兼具工具属性与研究价值,主要特色如下:

1. 时间推理机制:物理合理的编辑效果

这是ChronoEdit的核心优势。传统图像编辑仅关注“起始帧”(原图)和“结束帧”(编辑后图)的匹配,忽略了中间过程的逻辑连贯性,容易导致编辑结果不符合物理规律(如物体悬浮、光影突变)。ChronoEdit在模型中引入“推理令牌(reasoning tokens)”,通过时间推理阶段分析图像元素的时空关系(如物体运动轨迹、光影变化规律、场景透视逻辑),确保编辑后的内容不仅与目标描述一致,还能符合现实世界的物理规则。同时,工具会自动生成编辑轨迹视频,直观展示从原图到目标图的演进过程,让编辑效果更具说服力。

2. 多场景LoRA扩展:按需适配不同编辑需求

项目提供多款功能专用LoRA(低秩适配)模型,无需修改核心模型即可扩展编辑能力,且支持多LoRA组合使用,灵活性极高:

ChronoEdit-14B-Diffusers-Upscaler-Lora:图像超分增强专用,可在保持内容不变的前提下,提升图像清晰度与分辨率(测试支持最高2K分辨率),触发提示词包含“super-resolution、4K clarity、natural texture”等关键词;

ChronoEdit-14B-Diffusers-Paint-Brush-Lora:草图转实体工具,能将图像中的铅笔草图(优先支持黑色线条)转化为与原图风格一致的实体物体(如将草图皇冠转为真实皇冠),需搭配简单描述性提示词使用;

8-Steps Distilled LoRA:加速推理专用,将推理步数从默认值降至8步,在保证效果的前提下提升运行速度,建议与其他功能LoRA搭配使用。

3. 深度集成diffusers生态:低门槛推理与二次开发

ChronoEdit已正式合并至diffusers Pipeline(2025年11月10日更新),开发者可直接通过diffusers库调用模型,无需额外适配复杂依赖。同时,项目提供完整的diffusers推理脚本,支持单GPU、多GPU(torchrun分布式)推理,还可通过“--offload_model”参数卸载模型以节省显存,降低硬件门槛。

4. 智能提示词增强:提升编辑效果精准度

针对普通用户提示词描述模糊、不精准的问题,ChronoEdit内置“提示词增强器(Prompt Enhancer)”,支持自动优化提示词表达。默认推荐使用Qwen/Qwen3-VL-30B-A3B-Instruct模型(效果最佳),也支持切换为更小的视觉语言模型(适配低显存环境);若无需本地部署,还可通过在线LLM聊天工具结合官方提供的系统提示词实现同等效果,大幅提升编辑指令的执行精准度。

5. 全流程工具链:从推理到训练无缝衔接

项目提供从“模型推理”“LoRA微调”“全模型训练”到“数据集生成”的完整工具链:

推理阶段:支持单图编辑、多LoRA组合推理、Gradio交互式画笔Demo;

训练阶段:提供LoRA训练脚本(基于Diffsynth-Studio)、全模型分布式训练基础设施;

数据阶段:内置自动化编辑标注脚本,可通过成对图像(编辑前后)生成高质量编辑指令,支持Chain-of-Thought(CoT)推理优化提示词,降低数据集制备成本。

6. 灵活的硬件适配:兼顾效果与效率

项目支持根据硬件条件调整配置:无需flash attention也可运行(基础模式),安装后可提升推理速度;通过“--offload_model”参数可降低显存占用;提供14B(高精度)和计划中的2B(轻量化)两种模型规格,适配不同算力环境。

三、技术细节

ChronoEdit的技术核心是“图像编辑→视频生成”的范式转换,结合时间推理机制与扩散模型技术,以下从核心架构、关键技术、硬件依赖三方面展开:

1. 核心架构逻辑

ChronoEdit的架构可拆解为三个关键阶段,形成“输入→推理→输出”的完整流程:

输入阶段:接收“原始图像”“编辑提示词”(可选:LoRA配置、推理参数),若启用提示词增强,先通过视觉语言模型优化提示词表达;

时间推理与视频生成阶段:将原始图像作为起始帧(t=0)、目标编辑状态作为结束帧(t=T),模型通过推理令牌分析两帧间的时空演进逻辑(如物体添加的位置变化、光影适配、风格统一),再利用预训练视频扩散模型(基于Wan2.1-I2V-14B等基础模型)生成中间过渡帧,形成完整的编辑轨迹视频;

输出阶段:同时输出目标编辑图像(结束帧)和编辑轨迹视频,支持自定义输出格式(如MP4、PNG)。

2. 关键技术亮点

时间推理令牌(Reasoning Tokens):模型在编码阶段引入专属令牌,专门用于学习图像元素的时空关系(如物体运动、光影变化、场景交互规则),避免编辑过程中出现物理逻辑矛盾(如在室内场景添加阳光却无投影);

基于LoRA的功能扩展:核心模型采用14B参数的视频扩散模型,通过LoRA技术在特定任务(超分、草图转实体)上微调,既保证了核心模型的通用性,又让功能扩展轻量化(LoRA文件体积小、训练成本低);

蒸馏加速技术:8-Steps Distilled LoRA通过模型蒸馏将推理步数从默认值压缩至8步,同时保持效果接近原始模型,核心是通过知识蒸馏保留关键特征映射,平衡速度与精度;

diffusers深度集成:通过适配diffusers的Pipeline接口,复用其分布式推理、模型加载、参数优化等成熟功能,降低开发与使用门槛,同时支持与diffusers生态的其他工具兼容;

自动化数据集生成:基于CoT推理的标注脚本,通过视觉语言模型分析编辑前后图像的差异,生成精准的编辑指令(如“将图像中左侧的灰色杯子改为红色陶瓷杯,保持杯子位置和场景光影一致”),解决编辑任务数据集稀缺的问题。

3. 模型基础与训练配置

基础模型依赖:核心基于Wan-AI/Wan2.1-I2V-14B-720P预训练视频模型,依赖T5/UMT5编码器、Wan2.1 VAE、CLIP-XLM-Roberta-Large-Vit-Huge-14视觉模型;

LoRA训练参数:目标模块包括q、k、v、o、ffn.0、ffn.2,秩(rank)设为32,学习率1e-4,支持梯度检查点卸载(gradient checkpointing offload)以节省显存;

推理参数:默认推理步数为基础值,8-Steps LoRA推荐设置--num-inference-steps 8、--guidance-scale 1.0、--flow-shift 2.0,平衡速度与效果。

4. 硬件与环境依赖

ChronoEdit对运行环境有明确要求,以下是关键配置信息(整理自项目文档):

| 配置类型 | 要求详情 |

|---|---|

| 操作系统 | 仅支持Linux系统(无Windows/Mac适配) |

| Python版本 | 必须为3.10(其他版本可能出现依赖冲突) |

| 核心依赖库 | torch==2.7.1、torchvision==0.22.1,diffusers(需兼容项目版本) |

| 可选依赖 | flash-attn==2.6.3(提升推理速度,需CUDA支持) |

| GPU内存要求 | 普通推理(--offload_model):34G;时间推理模式:38G;提示词增强(Qwen3-VL-30B):最高60G |

| 多GPU支持 | 支持torchrun分布式推理/训练,推荐≥8卡(全模型训练) |

注:显存不足时可关闭时间推理、使用更小的提示词增强模型或等待2B轻量化版本。

四、应用场景

ChronoEdit的功能特性使其覆盖“实用生产”与“学术研究”两大场景,具体落地场景如下:

1. 创意设计与内容创作

图像内容编辑:设计师可通过提示词快速添加/修改图像元素(如给产品图添加装饰、给人物调整服饰),时间推理机制确保元素与场景风格、光影一致,无需手动微调;

草图转实体:插画师、UI设计师可将线稿(铅笔草图)快速转化为实体效果(如将APP界面线稿转为带质感的界面图、将角色草图转为上色后的形象),Paint-Brush-Lora支持风格适配;

图像质量增强:自媒体、摄影师可使用Upscaler-Lora提升图像分辨率(如将低清老照片、手机拍摄图转为4K高清图),保持内容与构图不变,自然纹理不丢失。

2. 视频与动态内容制作

编辑轨迹可视化:营销人员可生成“产品修改轨迹视频”(如包装设计迭代、广告图元素调整),用于内部评审或客户展示;

短视频素材生成:创作者可通过“单图编辑+轨迹视频”生成短视频片段(如“宠物从无配饰到戴墨镜的动态过程”),无需复杂剪辑。

3. 学术研究与技术开发

时间推理研究:研究者可基于项目的时间推理机制,探索图像/视频中的物理逻辑建模、时空一致性优化等方向;

扩散模型应用扩展:开发者可基于项目的diffusers集成方案,二次开发专属LoRA模型(如特定风格编辑、行业专用编辑功能);

数据集生成:需要图像编辑数据集的团队,可通过自动化标注脚本快速生成高质量标注数据(含编辑前后图像+精准指令),降低数据制备成本。

4. 电商与营销素材优化

产品图优化:电商运营可批量提升产品图分辨率(Upscaler-Lora)、添加促销元素(如“限时折扣”标签),确保标签与产品图风格统一,提升转化;

营销素材迭代:快速测试不同营销素材版本(如不同颜色的产品展示、不同文案位置),生成轨迹视频对比效果,提升决策效率。

5. 教育与演示场景

教学演示:教师可通过编辑轨迹视频展示图像修改逻辑(如“如何给风景图添加晚霞”),直观呈现步骤与效果关联;

方案演示:设计团队向客户展示方案迭代过程(如LOGO修改、海报调整),轨迹视频让修改逻辑更清晰,提升沟通效率。

五、使用方法

1. 环境准备

(1)克隆仓库与创建conda环境

# 克隆仓库 git clone https://github.com/nv-tlabs/ChronoEdit cd ChronoEdit # 创建并激活conda环境(需Python 3.10) conda env create -f environment.yml -n chronoedit_mini conda activate chronoedit_mini

(2)安装核心依赖

# 安装PyTorch及torchvision(指定版本) pip install torch==2.7.1 torchvision==0.22.1 # 安装基础依赖 pip install -r requirements_minimal.txt

(3)可选:安装flash attention(提升推理速度)

# 限制编译线程数,避免内存溢出(可选) export MAX_JOBS=16 # 安装flash attention(需CUDA支持) pip install flash-attn==2.6.3

2. 模型下载

所有预训练模型均从HuggingFace下载,核心模型及LoRA下载命令如下:

(1)核心模型:ChronoEdit-14B-Diffusers

hf download nvidia/ChronoEdit-14B-Diffusers --local-dir checkpoints/ChronoEdit-14B-Diffusers

(2)超分LoRA:ChronoEdit-14B-Diffusers-Upscaler-Lora

hf download nvidia/ChronoEdit-14B-Diffusers-Upscaler-Lora --local-dir checkpoints/ChronoEdit-14B-Diffusers-Upscaler-Lora

(3)画笔LoRA:ChronoEdit-14B-Diffusers-Paint-Brush-Lora

hf download nvidia/ChronoEdit-14B-Diffusers-Paint-Brush-Lora --local-dir checkpoints/ChronoEdit-14B-Diffusers-Paint-Brush-Lora

(4)蒸馏LoRA:内置在核心模型目录中(路径:checkpoints/ChronoEdit-14B-Diffusers/lora/chronoedit_distill_lora.safetensors)

3. 核心推理场景示例

(1)基础单GPU推理(添加物体)

功能:给输入图像中的猫添加墨镜,输出编辑轨迹视频

PYTHONPATH=$(pwd) python scripts/run_inference_diffusers.py \ --input assets/images/input_2.png \ # 输入图像路径 --offload_model \ # 启用模型卸载,节省显存 --use-prompt-enhancer \ # 启用提示词增强 --prompt "Add a sunglasses to the cat's face" \ # 编辑提示词 --output output.mp4 \ # 输出视频路径 --model-path ./checkpoints/ChronoEdit-14B-Diffusers # 核心模型路径

(2)启用时间推理(提升物理一致性)

在基础推理命令后添加--enable-temporal-reasoning标签,需≥38G显存:

PYTHONPATH=$(pwd) python scripts/run_inference_diffusers.py \ --input assets/images/input_2.png \ --offload_model \ --use-prompt-enhancer \ --prompt "Add a sunglasses to the cat's face" \ --output output_temporal.mp4 \ --model-path ./checkpoints/ChronoEdit-14B-Diffusers \ --enable-temporal-reasoning # 启用时间推理

(3)使用超分LoRA提升图像分辨率

功能:将低清图像转为高分辨率(保持内容不变)

PYTHONPATH=$(pwd) python scripts/run_inference_diffusers.py \ --input assets/images/lr.png \ # 低清输入图像 --width 1584 --height 1056 \ # 输出分辨率(测试支持最高2K) --prompt "The user want to enhance image clarity and resolution while keeping the content identical. super-resolution, high detail, 4K clarity, same composition, natural texture." \ # 超分触发提示词 --output output_sr.mp4 \ --lora-scale 1.0 \ # LoRA权重 --seed 42 \ # 随机种子(保证结果可复现) --lora-path ./checkpoints/ChronoEdit-14B-Diffusers-Upscaler-Lora/upsample_lora_diffusers.safetensors \ # 超分LoRA路径 --model-path ./checkpoints/ChronoEdit-14B-Diffusers

(4)使用画笔LoRA将草图转实体

功能:将黑色铅笔草图转为与原图风格一致的皇冠和帽子

PYTHONPATH=$(pwd) python scripts/run_inference_diffusers.py \ --input assets/images/input_paintbrush.png \ # 含草图的输入图像 --prompt "Turn the pencil sketch in the image into an actual object that is consistent with the image’s content. The user wants to change the sketch to a crown and a hat." \ # 画笔LoRA触发提示词 --output output_paintbrush.png \ # 输出实体化图像 --num-inference-steps 8 \ # 启用蒸馏LoRA,设置8步推理 --guidance-scale 1.0 \ # 引导尺度(蒸馏LoRA推荐1.0) --flow-shift 2.0 \ # 流偏移参数(蒸馏LoRA推荐2.0) --lora-scale 1.0 \ --seed 42 \ # 组合蒸馏LoRA和画笔LoRA(空格分隔多个LoRA路径) --lora-path ./checkpoints/ChronoEdit-14B-Diffusers/lora/chronoedit_distill_lora.safetensors ./checkpoints/ChronoEdit-14B-Diffusers-Paint-Brush-Lora/paintbrush_lora_diffusers.safetensors \ --model-path ./checkpoints/ChronoEdit-14B-Diffusers

(5)Gradio交互式画笔Demo(可视化操作)

PYTHONPATH=$(pwd) python scripts/gradio_paintbrush.py

运行后可通过浏览器访问本地端口,手动绘制草图并实时生成实体效果,适合快速测试。

4. LoRA微调(基于Diffsynth-Studio)

(1)安装Diffsynth-Studio

pip install git+https://github.com/modelscope/DiffSynth-Studio.git

(2)准备数据集

参考项目“Dataset Doc”,需准备图像对(编辑前后)及metadata.csv文件,放置在data/example_dataset目录。

(3)启动LoRA训练

PYTHONPATH=$(pwd) accelerate launch scripts/train_diffsynth.py \ --dataset_base_path data/example_dataset \ # 数据集根路径 --dataset_metadata_path data/example_dataset/metadata.csv \ # 数据集元信息路径 --height 1024 --width 1024 \ # 训练图像分辨率 --num_frames 5 \ # 视频帧数 --dataset_repeat 1 \ # 数据集重复次数 --model_paths '[["checkpoints/ChronoEdit-14B-Diffusers/transformer/diffusion_pytorch_model-00001-of-00014.safetensors",...]]' \ # 核心模型权重路径(需列出所有14个文件) --model_id_with_origin_paths "Wan-AI/Wan2.1-I2V-14B-720P:models_t5_umt5-xxl-enc-bf16.pth,Wan-AI/Wan2.1-I2V-14B-720P:Wan2.1_VAE.pth,Wan-AI/Wan2.1-I2V-14B-720P:models_clip_open-clip-xlm-roberta-large-vit-huge-14.pth" \ # 基础模型依赖 --learning_rate 1e-4 \ # 学习率 --num_epochs 5 \ # 训练轮数 --remove_prefix_in_ckpt "pipe.dit." \ # 移除权重前缀 --output_path "./models/train/ChronoEdit-14B_lora" \ # 输出路径 --lora_base_model "dit" \ # LoRA基础模型类型 --lora_target_modules "q,k,v,o,ffn.0,ffn.2" \ # LoRA目标模块 --lora_rank 32 \ # LoRA秩 --extra_inputs "input_image" \ # 额外输入(原始图像) --use_gradient_checkpointing_offload # 梯度检查点卸载

(4)微调后推理

PYTHONPATH=$(pwd) python scripts/run_inference_diffsynth.py

多GPU推理可使用:

PYTHONPATH=$(pwd) torchrun --standalone --nproc_per_node=8 scripts/run_inference_diffsynth.py

5. 自动化数据集生成

运行项目提供的标注脚本(参考“dataset guidance doc”),输入编辑前后的图像对,脚本会通过视觉语言模型生成CoT推理优化后的编辑提示词,自动生成metadata.csv文件,无需手动标注。

六、常见问题解答(FAQ)

1. 系统不支持Linux,能在Windows/Mac上运行吗?

不能。项目明确说明仅支持Linux系统,Windows/Mac暂无适配计划,建议通过虚拟机或云服务器(Linux系统)部署。

2. GPU显存不足怎么办?

关闭时间推理模式(移除

--enable-temporal-reasoning标签),显存需求从38G降至34G;不使用Qwen3-VL-30B提示词增强模型,切换为更小的视觉语言模型;

启用

--offload_model参数,通过模型卸载节省显存;等待项目计划发布的2B轻量化模型(显存需求更低);

避免同时使用多个LoRA(如不同时启用蒸馏LoRA和画笔LoRA)。

3. 提示词怎么写才能获得最佳效果?

启用

--use-prompt-enhancer参数,让工具自动优化提示词;手动编写时需明确“编辑对象+动作+效果”(如“给左侧的棕色小狗添加黑色墨镜,墨镜风格与小狗形象可爱风一致”);

参考项目“Prompt Guidance”文档(需访问官方链接),遵循示例格式;

功能型LoRA需包含触发关键词(如超分LoRA需含“super-resolution、4K clarity”)。

4. 不同LoRA可以同时使用吗?

可以。支持通过--lora-path参数指定多个LoRA文件路径(空格分隔),建议搭配蒸馏LoRA使用(如画笔LoRA+蒸馏LoRA),可提升效果与速度。

5. 模型支持的最大图像分辨率是多少?

普通编辑:无明确上限,需匹配GPU显存(分辨率越高,显存占用越大);

超分LoRA:官方测试支持最高2K分辨率,更高分辨率可能导致效果下降或显存溢出。

6. 推理速度很慢,如何优化?

安装flash attention(

pip install flash-attn==2.6.3);使用8-Steps Distilled LoRA,设置

--num-inference-steps 8;关闭提示词增强(移除

--use-prompt-enhancer标签);降低图像分辨率(如从1024×1024降至512×512)。

7. 可以商用吗?

项目采用Apache-2.0开源协议,允许商用,但需遵守协议要求:保留版权声明、开源修改后的代码(若二次开发),同时需注意基础模型(如Wan2.1-I2V-14B)的商用授权限制。

七、相关链接

Arxiv论文:https://arxiv.org/abs/2510.04290

HuggingFace模型库:https://huggingface.co/nvidia/ChronoEdit-14B

八、总结

ChronoEdit作为NVIDIA实验室推出的开源图像编辑与世界模拟工具,以“图像编辑→视频生成”的创新范式打破了传统工具的局限,通过时间推理机制确保编辑效果的物理合理性与时空一致性,同时深度集成diffusers生态并提供多款功能型LoRA,形成了“推理-训练-数据集生成”的完整工具链。其既满足了设计师、创作者的实用生产需求(如内容编辑、超分增强、草图转实体),又为学术研究者提供了时间推理、扩散模型应用的研究载体,兼顾实用性与技术深度。尽管工具仅支持Linux系统且对GPU显存有一定要求,但通过灵活的参数配置与LoRA扩展,可适配不同算力环境,是AIGC领域图像编辑与视频生成融合方向的重要开源成果。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/chronoedit.html