Fabric:开源AI增强框架,实现LLM能力与本地工作流的无缝集成

一、Fabric是什么

Fabric是由知名技术专家Daniel Miessler开发的开源AI增强人类能力的框架,核心定位是解决当下AI能力强大但难以无缝融入人类日常工作、生活工具链的集成问题,让大型语言模型(LLM)的能力能像原生命令行工具一样被灵活调用、组合和复用。它并非简单的AI模型API包装器,也不是传统的AI聊天工具,而是以“使用AI增强人类天赋”为设计核心理念,通过Pattern(模式) 机制将高质量的AI提示词模板与本地工作流深度结合,让用户能在终端、Web界面等多端完成从内容生成、代码审查到学术分析的一系列复杂任务。

Fabric最初以Python开发,后全面迁移至Go语言实现,大幅提升了命令行工具的执行效率、跨平台兼容性和启动速度,支持Linux ARM、Windows ARM、Apple Silicon等多种架构,能运行在树莓派、Windows Surface、普通服务器、个人电脑等各类设备上。其核心价值在于将AI的基本单元——提示词(Prompt)——组织成可复用、可管理、可扩展的Pattern,让用户无需反复编写复杂提示词,也无需在多个AI平台间切换窗口,就能把LLM能力变成日常工作流中的标准化流程节点,实现从“和AI聊天”到“指挥AI工作”的转变。

简单来说,Fabric是AI提示词的工程化管理平台,也是LLM能力的本地集成枢纽:对于熟悉命令行的用户,它是终端里的AI工具箱;对于普通用户,它的Web界面能实现可视化的Pattern管理与调用;对于开发者,它是一个可扩展的框架,能自定义Pattern、插件和工作流,适配不同的业务场景需求。

二、功能特色

Fabric的功能围绕“AI能力的高效集成与复用”展开,兼具命令行原生体验、提示词工程化、多模型适配、高扩展性等核心特色,同时遵循Unix哲学,支持标准输入/输出流的管道集成,让AI工具能与传统命令行工具无缝配合,以下是其核心功能特色的详细介绍:

2.1 Pattern模式:AI提示词的工程化管理

Pattern是Fabric的灵魂核心,也是其区别于其他AI工具的关键特性。Pattern本质是精心设计的AI提示词模板(以Markdown格式编写),每个Pattern对应一个特定的任务场景,内置了AI的角色定义、任务目标、输出格式、思考逻辑等内容,用户只需调用Pattern名称,即可让AI按预设规则完成任务。

丰富的内置Pattern:Fabric内置了数百个覆盖全场景的Pattern,涵盖内容创作(write_video_script、write_blog)、文本处理(summarize、tldr、translate)、代码开发(code_review、code_explain、debug_code)、学术研究(paper_summarize、extract_citation)、SEO优化(seo_analysis、keyword_extract)、日常办公(email_write、meeting_notes)等多个领域,能直接满足大部分通用需求。

自定义与复用Pattern:用户可根据自身业务需求,编写个性化的Pattern,支持设置元数据(描述、标签、适用模型),并可将Pattern按目录分类管理。同时Fabric支持设置自定义Pattern目录,确保个人私有Pattern在框架升级时不会被覆盖,实现个人/团队级别的提示词沉淀与复用。

Pattern高级能力:支持Pattern链式调用(Stitch),可将多个简单Pattern组合成复杂的工作流,完成多步骤的复杂任务;还提供suggest功能,让AI自动优化Pattern本身,实现“AI改进AI提示词”的元编程体验,例如通过

fabric -p summarize --suggest "Make the summary more concise and use bullet points"可让AI优化总结类Pattern的输出效果。Markdown原生编写:Pattern采用Markdown格式编写,兼具可读性和可编辑性,不仅方便人类理解和修改提示词逻辑,也能让LLM更准确地遵循指令,降低提示词编写的门槛。

2.2 多LLM服务商与多模型深度适配

Fabric提供统一的接口层,屏蔽了不同AI服务商的API差异,用户无需学习不同平台的调用方式,只需在配置中填入API密钥,即可一键切换使用主流的LLM模型,同时支持按Pattern指定专属模型,实现“任务与模型的精准匹配”。

全面的服务商支持:适配OpenAI、Azure OpenAI、Anthropic(Claude Opus 4.5/Sonnet 4.5)、Google Gemini、Amazon Bedrock、GitHub Models、Digital Ocean GenAI、Microsoft 365 Copilot、xAI(Grok-3)、DeepSeek、Perplexity等数十家AI服务商/模型。

灵活的模型指定方式:支持全局默认模型设置,也可通过环境变量

FABRIC_MODEL_PATTERN_NAME=vendor|model为单个Pattern指定专属模型,例如让代码审查任务使用GPT-4o,文本总结任务使用Claude Sonnet 4.5,最大化利用不同模型的优势。多模态能力支持:不仅支持纯文本交互,还集成了多模态功能,包括OpenAI的语音转文字(STT)、Whisper的音频处理、文本转语音(TTS)、图像生成与分析,以及Gemini的推理增强能力,能处理文本、音频、图像等多种输入类型。

实时Web搜索能力:通过

--search参数可启用模型的实时Web搜索功能(支持Anthropic、OpenAI、Gemini),让AI能获取最新的网络信息,解决传统LLM“知识截止期”的问题。

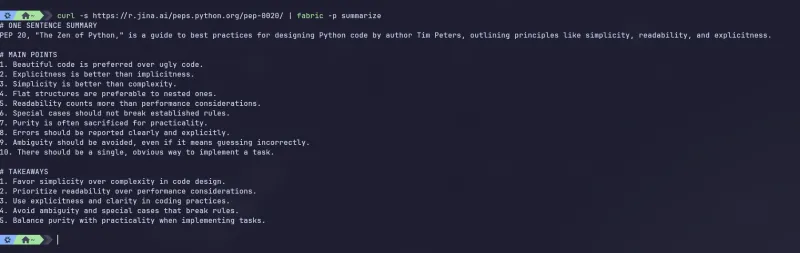

2.3 命令行原生体验,兼容传统工具链

Fabric以命令行(CLI) 为核心交互方式,遵循Unix的“小工具、组合用”哲学,支持标准输入/输出流(STDIN/STDOUT),能与grep、sed、awk、cat等传统命令行工具无缝集成,通过管道(|)组合实现复杂的AI工作流,这也是Fabric最受开发者青睐的特性之一。

管道集成:可将其他命令的输出作为Fabric的输入,也可将Fabric的AI处理结果作为其他命令的输入,例如

cat article.md | fabric -p summarize | grep "key point",实现“读取文件→AI总结→关键词提取”的一键操作。丰富的CLI参数:提供了简洁的命令格式和丰富的参数,支持指定输入文件、输出文件、复制结果到剪贴板、流式输出AI结果、调试日志级别等,满足不同的使用需求。

Shell生态适配:支持Shell别名(Alias)、命令自动补全(bash/zsh/fish)、桌面通知等功能,配置完成后,用户可像使用

ls、cd一样使用Fabric,大幅提升操作效率。高性能执行:基于Go语言开发,CLI工具启动速度极快,执行效率远高于传统Python实现的AI工具,即使在低配设备(如树莓派)上也能流畅运行。

2.4 多端交互与便捷的内容集成

Fabric并非仅支持命令行,还提供了多端交互方式,同时内置了内容抓取与处理能力,能一键获取网络内容并直接交给AI处理,解决了“内容获取→AI处理”的割裂问题。

Web可视化界面:基于Svelte开发了Web前端,提供可视化的Pattern管理、收藏、调用功能,支持Obsidian笔记软件集成,普通用户无需熟悉命令行也能轻松使用。

REST API服务:提供完整的OpenAPI/Swagger文档,内置REST API服务,支持Pattern的增删改查、AI调用、结果存储等接口,方便开发者将Fabric集成到自己的Web应用、客户端程序中。

一键内容抓取:支持一键抓取YouTube视频字幕、任意网页内容(自动转为Markdown格式),并直接作为输入传递给AI模型,无需手动复制粘贴,例如可直接抓取技术博客并让Fabric生成代码实现思路。

辅助工具集:内置多个实用的辅助工具,包括

code_helper(生成代码目录的JSON表示,配合AI进行代码编辑)、to_pdf(将AI生成的LaTeX内容快速编译为PDF),进一步拓展了使用场景。

2.5 高度可扩展,支持插件与国际化

Fabric采用模块化架构,提供了灵活的扩展体系,同时支持多语言国际化,满足不同地区、不同业务场景的定制化需求。

插件扩展体系:支持自定义扩展插件,插件配置存放于

~/.config/fabric/extensions/,可通过插件实现新的AI服务商适配、新的功能模块(如本地数据处理、第三方工具集成)、新的输入输出方式等。自定义配置:所有配置文件采用易读的格式,支持自定义Pattern目录、API密钥管理、日志级别、默认输出格式等,用户可根据自身习惯调整框架行为。

完善的国际化支持:覆盖英语、西班牙语、德语、法语、日语、中文、葡萄牙语(巴西/欧洲)等多种语言,遵循BCP 47地区化规范,方便全球用户使用。

高级调试能力:通过

--debug 1|2|3参数可控制运行时的日志级别,能查看AI模型的请求参数、响应内容、Pattern加载过程等细节,方便调试复杂的Pattern链和模型交互问题。

2.6 内置高级提示词策略,优化AI输出

Fabric内置了多种高级提示词策略,如“思维链(Chain of Thought)”,能引导AI按预设的逻辑进行思考和推理,大幅提升AI输出的准确性和逻辑性,无需用户手动编写复杂的提示词逻辑。同时,Fabric的Pattern库由社区众包维护,不断更新和优化各类场景的提示词,让普通用户也能使用专业级的提示词工程能力。

三、技术细节

Fabric基于Go语言开发,遵循Go语言的标准项目架构规范,代码结构清晰、模块化程度高,同时采用跨平台的开发思路,支持多种操作系统和硬件架构。其核心技术架构围绕Pattern、Provider、Model、CLI、Server五大核心组件构建,同时提供了完善的扩展接口和配置体系,以下是详细的技术细节解析:

3.1 核心技术架构

Fabric的核心架构采用分层设计,从底层的AI服务商对接,到中层的Pattern管理与任务调度,再到上层的交互接口(CLI/Web/API),各层之间解耦,便于维护和扩展,核心组件及功能如下:

| 核心组件 | 英文名称 | 核心功能 |

|---|---|---|

| 模式层 | Pattern | 管理AI提示词模板,负责加载、解析、执行Pattern,支持链式调用和优化 |

| 服务商层 | Provider | 对接各AI服务商的API,屏蔽平台差异,提供统一的模型调用接口 |

| 模型层 | Model | 管理具体的LLM模型,支持按任务指定模型,处理模型的请求与响应 |

| 交互层 | CLI | 命令行核心交互接口,处理用户输入、参数解析、管道集成、结果输出 |

| 服务层 | Server | 提供REST API和Web前端服务,实现可视化交互和第三方集成 |

| 扩展层 | Extension | 插件扩展体系,支持自定义功能、新服务商适配、第三方工具集成 |

Pattern层:Fabric的核心层,负责所有Pattern的加载、解析、管理和执行。Pattern以Markdown文件存储,默认存放在

data/patterns/目录,支持按目录分类,框架启动时会自动扫描Pattern目录并加载元数据,方便用户快速调用。该层还实现了Pattern的链式调用、suggest优化等高级功能,能将多个Pattern组合成复杂的工作流。Provider层:作为Fabric与外部AI服务商的中间层,提供了统一的模型调用接口,每个AI服务商对应一个Provider插件,例如OpenAI Provider、Anthropic Provider、Gemini Provider等。用户只需配置对应的API密钥,Provider层会自动处理请求参数的封装、响应结果的解析,屏蔽不同服务商的API格式差异。

Model层:基于Provider层实现,管理具体的LLM模型实例,支持全局默认模型和Pattern专属模型的设置,能根据用户的参数指定,自动选择对应的Provider和模型进行调用,同时处理模型的流式输出、批量请求等逻辑。

CLI层:Fabric的核心交互入口,基于Go语言的Cobra库开发,实现了命令行参数解析、标准输入/输出流处理、管道集成、Shell自动补全等功能。CLI层接收用户的命令后,会将任务分发给Pattern层和Model层,最终将AI处理结果输出到终端、文件或剪贴板。

Server层:基于Go语言的Gin框架开发,提供REST API服务和Web前端的后端支持。API层实现了Pattern的增删改查、AI模型调用、配置管理等接口,遵循OpenAPI规范;Web前端基于Svelte开发,提供可视化的Pattern管理和调用界面,支持收藏、搜索、分类等功能。

Extension层:Fabric的扩展核心,采用插件化设计,支持用户开发自定义插件,实现新的功能或集成第三方工具。扩展插件可对接新的AI服务商、实现新的内容处理能力、添加新的输入输出方式等,插件配置存放于用户目录的

~/.config/fabric/extensions/,框架启动时会自动加载。

3.2 项目目录结构

Fabric的项目目录严格遵循Go语言标准项目规范,将源码、数据、文档、前端、脚本等按功能清晰划分,便于开发者理解和贡献代码,核心目录结构如下(省略部分次要目录):

. ├── cmd/ # Go语言可执行程序入口(标准目录) │ ├── fabric/ # Fabric主命令行工具入口 │ ├── code_helper/ # 代码分析辅助工具入口 │ └── to_pdf/ # LaTeX转PDF工具入口 ├── internal/ # 私有业务逻辑(Go语言标准,不对外暴露) │ ├── cli/ # 命令行交互核心逻辑 │ ├── core/ # 框架核心业务逻辑(Pattern、Provider、Model管理) │ ├── domain/ # 领域模型(数据结构定义,从原common包拆分) │ ├── patterns/ # Pattern加载、解析、执行逻辑 │ ├── plugins/ # 插件核心逻辑(AI服务商、扩展插件等) │ ├── server/ # REST API服务逻辑(原restapi重命名) │ └── tools/ # 非二进制工具逻辑(如Git仓库文件拉取) ├── data/ # 非源码数据资产 │ ├── patterns/ # 内置Pattern库(Markdown格式,按场景分类) │ └── strategies/ # 高级提示词策略配置文件 ├── web/ # Svelte开发的Web前端代码 ├── docs/ # 项目完整文档(架构、配置、贡献指南等) ├── completions/ # Shell自动补全脚本(bash/zsh/fish) ├── scripts/ # 辅助脚本 │ ├── docker/ # Docker部署文件和启动脚本 │ ├── python_ui/ # Streamlit前端脚本(备用) │ └── pattern_generation/ # Pattern生成与提取脚本 ├── flake.nix/ # Nix环境配置文件,支持一键环境搭建 └── go.mod/go.sum # Go语言依赖管理文件

3.3 核心技术栈

Fabric采用前后端分离的技术架构,后端以Go语言为核心,前端采用轻量级的Svelte框架,同时集成了多种开源库和工具,核心技术栈如下:

后端技术栈(Go语言)

命令行开发:Cobra(命令行参数解析)、Viper(配置管理)

Web开发:Gin(HTTP框架)、Swagger/OpenAPI(API文档)

网络请求:net/http(原生网络库)、resty(HTTP客户端)

数据处理:gorm(可选数据库操作)、jsoniter(JSON解析)

跨平台:go-cross(跨平台编译)、CGO_ENABLED=0(静态编译)

前端技术栈

Web前端:Svelte(轻量级前端框架)、Tailwind CSS(样式框架)

备用前端:Streamlit(Python,快速可视化)

其他核心工具

容器化:Docker、Docker Compose(部署)

包管理:Homebrew、AUR(Linux)、Go Module(Go语言)

文档:Markdown、MkDocs(文档生成)

自动化:GitHub Actions(CI/CD)、Shell脚本(安装/配置)

3.4 关键技术特性

静态编译:Fabric的Go语言代码支持静态编译(CGO_ENABLED=0),编译后的二进制文件不依赖任何系统库,可直接在目标系统上运行,无需安装额外依赖,大幅提升了跨平台部署的便捷性。

无状态设计:Fabric的核心功能采用无状态设计,除了配置文件和Pattern库外,不依赖本地数据库或持久化存储,运行时无需启动后台服务(API服务除外),符合命令行工具的使用习惯。

懒加载机制:Pattern和Provider采用懒加载机制,框架启动时仅加载元数据,当用户调用具体的Pattern或模型时,才会加载对应的文件和插件,大幅提升了启动速度和内存占用效率。

标准化的配置体系:Fabric的配置文件统一存放在用户的

~/.config/fabric/目录(Windows为%APPDATA%/fabric/),采用YAML/JSON格式,支持全局配置和局部配置,同时可通过环境变量覆盖配置,方便在不同环境(开发/生产/服务器)中使用。

四、应用场景

Fabric的应用场景极为广泛,只要是需要使用AI处理信息、完成任务的场景,都能通过Fabric实现效率提升,其核心优势是无缝集成到现有工作流,无需改变用户的使用习惯。无论是个人用户的日常办公、内容创作,还是团队用户的开发协作、学术研究,Fabric都能提供对应的解决方案。以下是Fabric的典型应用场景,按用户群体和使用场景分类介绍:

4.1 开发者/程序员

开发者是Fabric的核心用户群体,Fabric能将AI能力集成到开发工作流中,实现代码开发、调试、优化的自动化,大幅提升开发效率:

代码审查与优化:通过

code_reviewPattern一键审查代码,获取语法错误、性能优化、代码规范的建议;通过refactor_codePattern自动重构代码,提升代码可读性和可维护性。代码解释与调试:对于复杂的开源代码或陌生框架,使用

code_explainPattern让AI逐行解释代码功能;通过debug_codePattern输入报错信息,让AI分析错误原因并提供解决方案。代码生成与补全:结合

create_coding_featurePattern和code_helper工具,输入功能需求,让AI生成代码目录和核心代码;通过管道将需求文档传递给Fabric,生成对应的测试代码。技术文档编写:通过

write_docsPattern根据代码自动生成技术文档、接口文档;通过translate_docsPattern将英文技术文档翻译成中文,方便团队阅读。开发流程自动化:将Fabric与Git、Make等工具集成,实现“提交代码→AI审查→生成变更日志”的自动化流程,例如

git diff | fabric -p code_review,一键审查本次提交的代码差异。

4.2 内容创作者/自媒体人

Fabric内置了大量内容创作类Pattern,能帮助内容创作者快速生成内容、优化内容,解决“选题难、写作慢、优化繁”的问题:

内容生成:通过

write_blog、write_video_script、write_wechatPattern,输入选题和核心观点,一键生成博客、视频脚本、公众号文章的草稿;通过write_socialPattern生成适合微博、小红书、抖音的社交媒体文案。文本优化:通过

rewritePattern优化文章的语句通顺度和可读性;通过seo_analysisPattern对文章进行SEO优化,提取关键词、优化标题和摘要,提升搜索引擎排名。内容总结与提取:通过

summarize、tldrPattern快速总结长文、书籍、报告的核心观点;通过extract_wisdomPattern从文章中提取金句、核心观点,用于内容二次创作。多语言翻译:通过

translatePattern将内容翻译成不同语言,实现内容的全球化发布;通过localizePattern对翻译内容进行本地化优化,适配不同地区的文化习惯。内容素材处理:一键抓取YouTube、B站的视频字幕,通过Fabric生成视频文案;抓取行业博客、新闻,通过AI提取核心信息,作为内容创作的素材。

4.3 学术研究者/学生

Fabric能帮助学术研究者快速处理学术文献、分析研究数据,节省大量的文献阅读和整理时间:

文献总结与分析:通过

paper_summarizePattern快速总结英文论文、学术报告的核心研究内容、实验方法和结论;通过extract_citationPattern从论文中提取参考文献,自动生成引用格式。研究思路梳理:通过

brainstormPattern输入研究课题,让AI提供研究思路、实验方案和研究方向;通过literature_reviewPattern生成文献综述的草稿,梳理领域内的研究现状。数据与图表分析:将实验数据通过管道传递给Fabric,通过

data_analysisPattern让AI分析数据、生成结论;通过plot_chartPattern让AI生成图表的代码(Python/Matplotlib),快速可视化数据。论文写作与修改:通过

write_paperPattern生成论文的框架和草稿;通过edit_paperPattern优化论文的语法、逻辑和学术表达,提升论文的投稿质量。

4.4 职场办公人士/管理者

Fabric能帮助职场人士高效完成日常办公任务,实现办公流程的自动化,提升工作效率:

会议与笔记处理:通过

meeting_notesPattern将会议录音(转文字后)生成会议纪要;通过todo_extractPattern从会议纪要中提取待办事项和责任人。邮件与公文写作:通过

write_email、write_officialPattern,输入核心信息,一键生成正式的邮件、公文、通知等文档;通过reply_emailPattern根据收到的邮件,生成回复草稿。报告与方案制作:通过

write_reportPattern生成工作周报、月报、年度报告;通过make_planPattern输入目标,让AI生成详细的工作计划、项目方案。信息筛选与分析:通过

filter_infoPattern从大量的新闻、资讯、邮件中筛选出关键信息;通过trend_analysisPattern分析行业趋势、市场数据,为决策提供参考。团队协作与管理:通过

team_analysisPattern分析团队的工作数据,生成团队绩效分析报告;通过assign_taskPattern根据团队成员的能力,合理分配工作任务。

4.5 团队/企业级使用

Fabric支持团队级的Pattern共享与管理,可作为企业内部的AI提示词库和LLM集成平台,提升团队的整体工作效率:

团队提示词沉淀:将团队的优质提示词编写为Pattern,存放在团队共享目录,让所有成员都能复用,避免重复编写,保证AI输出的一致性。

定制化业务流程:根据企业的业务场景,开发自定义的Pattern和插件,实现业务流程的AI自动化,例如电商企业的商品文案生成、客服对话分析,金融企业的财报分析、风险评估。

统一AI资源管理:通过Fabric统一管理企业的AI API密钥和模型资源,控制不同团队、不同员工的AI使用权限,实现AI资源的精细化管理和成本控制。

内部系统集成:通过Fabric的REST API,将AI能力集成到企业的OA、CRM、ERP等内部系统,让员工在熟悉的系统中就能使用AI功能,无需切换平台。

五、使用方法

Fabric的使用门槛低,提供了多种安装方式和简洁的命令格式,无论是新手还是资深开发者,都能快速上手。使用Fabric的核心流程为:安装框架→初始化配置→调用Pattern/使用功能,同时Fabric提供了完善的帮助文档和自动补全功能,方便用户查询和使用。以下是Fabric的详细使用方法,包括安装、配置、基础使用、高级使用等部分:

5.1 安装方式

Fabric支持一键安装、包管理器安装、源码安装、Docker部署等多种方式,适配Windows、macOS、Linux(包括ARM架构)等所有主流操作系统,用户可根据自身情况选择合适的安装方式,一键安装适合新手,包管理器安装适合熟悉系统工具的用户,源码安装适合开发者,Docker部署适合服务器环境。

方式一:一键安装(推荐新手)

Fabric官方提供了一键安装脚本,会自动检测系统环境(操作系统、硬件架构),下载对应的二进制文件并完成安装,无需手动处理依赖,打开终端输入以下命令即可:

curl -L https://github.com/danielmiessler/fabric/releases/latest/download/install.sh | bash

注意:安装需要网络访问权限和适当的管理员权限,若遇到权限问题,可在命令前添加sudo;Windows用户需使用WSL2或Git Bash执行该命令。

方式二:包管理器安装

适合使用系统包管理器的用户,目前支持macOS的Homebrew、Arch Linux的AUR仓库:

macOS(Homebrew)

brew install fabric

Arch Linux(AUR)

# 使用paru paru -S fabric # 或使用yay yay -S fabric

方式三:从源码安装(开发者推荐)

适合需要修改源码、参与项目贡献的开发者,需提前安装Go 1.21+ 环境,安装完成后执行以下命令:

go install github.com/danielmiessler/fabric/cmd/fabric@latest

编译后的二进制文件会存放在$GOPATH/bin目录,需确保该目录已加入系统的PATH环境变量。

方式四:Docker部署(服务器/容器化环境)

适合服务器环境、需要隔离部署的用户,无需在主机安装Go环境和依赖,通过Docker容器运行,首先创建配置目录,再启动容器进行初始化:

# 创建配置目录 mkdir -p $HOME/.fabric-config # 启动容器并完成初始化配置 docker run --rm -it -v $HOME/.fabric-config:/root/.config/fabric kayvan/fabric:latest --setup

日常使用时,通过以下命令调用Fabric:

docker run --rm -it -v $HOME/.fabric-config:/root/.config/fabric kayvan/fabric:latest -p summarize

Docker镜像地址:hub.docker.com/repository/docker/kayvan/fabric/general

5.2 环境配置与初始化

Fabric安装完成后,必须执行初始化命令,完成目录结构创建和AI服务商API密钥配置,同时可根据需要配置环境变量和Shell自动补全,提升使用体验。

5.2.1 核心初始化

执行以下命令,Fabric会引导用户完成配置,包括选择默认AI服务商、输入API密钥、设置默认模型等,至少需要配置一个AI服务商的API密钥才能正常使用:

fabric --setup

配置完成后,所有的配置文件会存放在~/.config/fabric/目录,包括API密钥、默认模型、Pattern目录等。

5.2.2 环境变量配置(可选)

部分系统(如Linux、Apple Silicon Mac)可能需要配置Go相关的环境变量,确保Fabric能正常运行:

Linux/Intel Mac用户:在

~/.bashrc文件中添加以下内容,然后执行source ~/.bashrc生效:

export GOROOT=/usr/local/go export GOPATH=$HOME/go export PATH=$GOPATH/bin:$GOROOT/bin:$HOME/.local/bin:$PATH

Apple Silicon Mac用户:在

~/.zshrc文件中添加以下内容,然后执行source ~/.zshrc生效:

export GOROOT=$(brew --prefix go)/libexec export GOPATH=$HOME/go export PATH=$GOPATH/bin:$GOROOT/bin:$HOME/.local/bin:$PATH

5.2.3 Shell自动补全(强烈推荐)

Fabric支持bash、zsh、fish等主流Shell的自动补全功能,配置后输入fabric -p按Tab键即可自动提示可用的Pattern名称,大幅提升操作效率,提供一键配置和手动配置两种方式。

一键配置(推荐)

curl -fsSL https://raw.githubusercontent.com/danielmiessler/Fabric/refs/heads/main/completions/setup-completions.sh | sh

手动配置

Zsh用户

mkdir -p ~/.zsh/completions cp completions/_fabric ~/.zsh/completions/ echo 'fpath=(~/.zsh/completions $fpath)' >> ~/.zshrc echo 'autoload -Uz compinit && compinit' >> ~/.zshrc source ~/.zshrc

Bash用户

echo 'source /path/to/fabric/completions/fabric.bash' >> ~/.bashrc # 或复制到系统补全目录 sudo cp completions/fabric.bash /etc/bash_completion.d/ source ~/.bashrc

Fish用户

mkdir -p ~/.config/fish/completions cp completions/fabric.fish ~/.config/fish/completions/

5.3 基础使用

Fabric的核心命令格式简洁,支持管道输入、文件输入、直接文本输入三种输入方式,同时提供了丰富的参数控制输出效果,核心命令格式为:

fabric [参数]

首先可通过fabric -h查看所有可用参数和帮助信息,快速了解核心用法。

5.3.1 核心参数说明

Fabric的常用参数不多,核心参数主要用于指定Pattern、模型、输入输出方式,以下是高频使用的核心参数:

| 参数 | 简写 | 功能说明 |

|---|---|---|

| --pattern | -p | 指定要使用的Pattern名称(核心参数) |

| --model | -m | 指定本次使用的AI模型,覆盖全局默认模型 |

| --file | -f | 从指定文件读取输入内容 |

| --text | -t | 直接输入文本内容作为AI的输入 |

| --output | -o | 将AI输出结果保存到指定文件 |

| --copy | -c | 将AI输出结果复制到系统剪贴板 |

| --stream | -s | 流式输出AI结果,类似ChatGPT的实时输出 |

| --search | -se | 启用AI模型的实时Web搜索能力 |

| --list patterns | -l | 列出所有可用的Pattern名称和描述 |

| --debug | -d | 启用调试模式,指定日志级别(1/2/3) |

| --setup | -su | 重新执行初始化配置 |

| --help | -h | 查看帮助信息 |

5.3.2 三种核心输入方式

Fabric支持管道输入、文件输入、直接文本输入,适配不同的使用场景,用户可根据需求选择:

管道输入(最常用,适合与其他命令配合):将其他命令的输出通过

|传递给Fabric,例如总结一个Markdown文件的内容:

cat article.md | fabric -p summarize

文件输入(适合处理本地大文件):通过

--file参数指定输入文件,例如分析一个Python代码文件:

fabric -p code_review -f main.py

直接文本输入(适合简单的短文本处理):通过

--text参数直接输入文本,或直接执行fabric -p 模式名后手动输入文本,例如解释一个技术概念:

# 方式1:通过--text参数直接输入 fabric -p explain_concept -t "Go语言的协程是什么" # 方式2:手动输入 fabric -p explain_concept # 执行后终端会提示输入内容,输入后按回车即可

5.3.3 输出结果控制

Fabric提供了灵活的输出结果控制方式,可将结果保存到文件、复制到剪贴板,或流式输出:

保存到文件:通过

--output参数指定输出文件,例如将总结结果保存到summary.md:

cat article.md | fabric -p summarize -o summary.md

复制到剪贴板:通过

--copy参数将结果复制到剪贴板,方便直接粘贴使用:

fabric -p write_email -t "给客户写一封感谢邮件" -c

流式输出:通过

--stream参数实现实时流式输出,适合处理长文本、生成大篇幅内容:

fabric -p write_blog -t "AI工具提升工作效率" -s

5.3.4 常用基础操作示例

结合以上参数和输入方式,以下是Fabric日常使用的高频示例,覆盖大部分通用场景,可直接复制使用:

查看所有可用Pattern

fabric -l

总结网页内容(结合curl)

curl -s https://example.com/tech-blog | fabric -p summarize

代码审查并将结果保存到文件

fabric -p code_review -f app.go -o code_review_result.md

生成视频脚本并复制到剪贴板

fabric -p write_video_script -t "AI工具Fabric的使用教程" -c

启用Web搜索并分析行业趋势

fabric -p trend_analysis -t "2026年AI开发工具的发展趋势" -se

指定模型进行文本翻译

fabric -p translate -m gpt-4o -t "Fabric is an open source AI enhancement framework"

5.4 高级使用

Fabric的高级使用主要包括自定义Pattern、Pattern链式调用、按Pattern指定模型、使用扩展插件等,能满足个性化和复杂场景的需求,以下是核心的高级使用方法:

5.4.1 自定义Pattern

自定义Pattern是Fabric的核心高级功能,用户可将自己的优质提示词编写为Pattern,实现复用。Pattern为Markdown格式,存放在自定义目录或默认的data/patterns/目录,编写步骤如下:

创建Markdown文件:文件名即为Pattern名称(例如

my_blog.md),文件内容为提示词模板,核心是编写System Prompt,明确AI的角色、任务、输出格式。编写Pattern内容:一个标准的Pattern示例(生成个人博客):

# Role 你是一名资深的技术博客作者,擅长用通俗易懂的语言讲解复杂的技术概念,文章结构清晰,有案例有分析。 # Goal 根据用户提供的技术主题,生成一篇1000字左右的个人技术博客,包含标题、引言、核心内容、总结四个部分。 # Output Format - 标题:吸引眼球的技术博客标题 - 引言:简要介绍主题的价值和意义 - 核心内容:分3-4个小节,讲解技术概念和使用方法,搭配简单案例 - 总结:总结核心观点,给出使用建议

加载自定义Pattern:将编写好的Markdown文件放到

~/.config/fabric/patterns/目录(若无则创建),Fabric会自动加载该目录下的Pattern,即可通过fabric -p my_blog调用。

5.4.2 Pattern链式调用

Pattern链式调用(Stitch)是将多个Pattern组合使用,完成复杂的多步骤任务,例如“先提取文章核心观点→再将观点生成社交媒体文案→最后翻译为英文”,通过管道实现链式调用:

cat article.md | fabric -p extract_wisdom | fabric -p write_social | fabric -p translate

5.4.3 按Pattern指定专属模型

通过环境变量可为单个Pattern指定专属模型,实现“不同Pattern使用不同模型”,例如让code_review Pattern使用GPT-4o,summarize Pattern使用Claude Sonnet 4.5:

# 临时设置(当前终端有效) export FABRIC_MODEL_CODE_REVIEW=openai|gpt-4o export FABRIC_MODEL_SUMMARIZE=anthropic|claude-3-sonnet-20240229 # 永久设置:将上述命令添加到~/.bashrc或~/.zshrc,执行source生效

5.4.4 启用调试模式

通过--debug参数启用调试模式,查看Fabric的运行细节,包括Pattern加载过程、AI模型的请求参数、响应内容等,方便调试问题,日志级别分为1(基础日志)、2(详细日志)、3(完整请求/响应):

cat article.md | fabric -p summarize -d 3

六、常见问题解答

Q1:执行fabric命令时,提示“command not found”?

问题原因:Fabric的二进制文件所在目录未加入系统的PATH环境变量,或安装过程中出现权限问题。

解决方案:

查找Fabric二进制文件的位置:

find / -name fabric 2>/dev/null(Linux/macOS),Windows在%APPDATA%/fabric/或GOPATH/bin目录。将该目录添加到系统PATH环境变量,例如Linux/macOS:

export PATH=$PATH:/找到的目录,并将该命令添加到~/.bashrc/~/.zshrc永久生效。若为一键安装的权限问题,重新执行安装命令并添加

sudo:sudo curl -L https://github.com/danielmiessler/fabric/releases/latest/download/install.sh | bash。

Q2:初始化配置时,输入API密钥后提示“API key invalid”?

问题原因:API密钥输入错误、密钥无对应模型的使用权限、AI服务商的地区限制。

解决方案:

检查API密钥是否正确,注意区分大小写,不要包含空格或特殊字符。

确认API密钥具有对应模型的使用权限,例如OpenAI的API密钥需要开通GPT-4o权限,Anthropic的密钥需要开通Claude 3权限。

若为地区限制,可通过代理服务器访问,Fabric支持配置HTTP代理:

export HTTP_PROXY=http://127.0.0.1:7890; export HTTPS_PROXY=http://127.0.0.1:7890。测试API密钥的有效性:直接调用AI服务商的官方API,确认密钥可正常使用。

Q3:使用Docker部署时,提示“no such file or directory”?

问题原因:未创建配置目录,或目录挂载路径错误。

解决方案:

首先执行

mkdir -p $HOME/.fabric-config创建配置目录,确保目录存在。检查Docker运行命令中的挂载路径,主机目录为

$HOME/.fabric-config,容器内目录为/root/.config/fabric,路径不可修改。若为Windows Docker用户,需将

$HOME替换为实际的用户目录,例如C:/Users/你的用户名/.fabric-config。

Q4:调用Pattern时,AI输出结果不符合预期?

问题原因:Pattern的提示词编写不规范、模型选择不合适、未启用高级提示词策略。

解决方案:

优化Pattern的提示词,明确AI的角色、任务、输出格式,尽量使用“Role-Goal-Output Format”的结构。

更换更适合的模型,例如代码处理选择GPT-4o、Claude 3 Opus,文本总结选择Claude 3 Sonnet、Gemini 2.5 Pro。

启用Fabric的内置高级提示词策略,在Pattern中添加思维链(Chain of Thought)逻辑,引导AI推理。

使用

suggest功能让AI优化Pattern:fabric -p 你的Pattern名 --suggest "让输出更符合xxx要求"。

Q5:Windows系统中无法使用管道输入?

问题原因:Windows的原生CMD不支持Unix风格的管道,或未使用正确的终端工具。

解决方案:

使用WSL2(推荐):在Windows中安装WSL2(Ubuntu/CentOS),在WSL2中安装和使用Fabric,完全支持管道和所有命令行功能。

使用Git Bash:安装Git for Windows,使用Git Bash终端执行Fabric命令,支持管道输入。

避免使用Windows原生CMD,改用PowerShell:PowerShell支持部分管道功能,命令格式为

Get-Content article.md | fabric -p summarize。

Q6:Fabric启动速度慢,或调用模型时响应时间长?

问题原因:网络速度慢、模型选择不当、Fabric未启用懒加载,或设备性能过低。

解决方案:

优化网络环境,使用就近的AI服务商节点,或配置高速代理。

选择轻量级模型处理简单任务,例如使用GPT-3.5 Turbo、Claude 3 Haiku进行文本总结,避免使用大模型处理简单任务。

确认Fabric为Go语言版本(最新版本),Python版本的启动速度和执行效率较低,建议升级到Go版本。

低配设备(如树莓派)避免同时运行多个Fabric任务,关闭不必要的后台程序。

Q7:自定义Pattern后,无法通过fabric -l查看到?

问题原因:Pattern文件存放目录错误、文件格式不是Markdown、文件名包含特殊字符。

解决方案:

将自定义Pattern文件放到

~/.config/fabric/patterns/目录,该目录是Fabric的自定义Pattern默认扫描目录。确认Pattern文件的后缀为

.md(Markdown格式),纯文本文件无法被加载。确保Pattern文件名仅包含字母、数字、下划线,不包含空格、中文、特殊字符(例如

my_pattern.md合法,我的模式.md不推荐)。重启终端或执行

fabric --setup重新加载配置,让Fabric扫描新的Pattern文件。

Q8:支持的AI服务商中,没有我需要的模型?

问题原因:Fabric的默认Provider中未集成该模型,或该模型的API未对外开放。

解决方案:

查看Fabric的官方GitHub Issues,确认是否有计划集成该模型,或提交Issue请求官方添加。

开发自定义Provider插件:Fabric支持插件化的Provider扩展,可根据模型的官方API,开发对应的Provider插件,放到

~/.config/fabric/extensions/目录即可加载。使用通用的API适配:若模型支持OpenAI兼容的API,可通过Fabric的OpenAI Provider进行适配,只需修改API基础地址即可。

七、相关链接

Docker官方镜像:https://hub.docker.com/repository/docker/kayvan/fabric/general(Docker部署专用)

官方Release页面:https://github.com/danielmiessler/Fabric/releases(下载最新的二进制文件、查看版本更新日志)

八、总结

Fabric是一款以Go语言为核心开发的开源AI增强框架,由Daniel Miessler打造,核心解决了AI能力与人类日常工作流的集成痛点,通过Pattern模式实现了AI提示词的工程化管理与复用,让大型语言模型的能力能像原生命令行工具一样被灵活调用和组合,其不仅支持多主流AI服务商与模型的深度适配,还遵循Unix哲学实现了与传统命令行工具的管道集成,同时提供Web界面、REST API等多端交互方式和完善的插件扩展体系,适配不同用户的使用习惯和业务需求。Fabric的内置Pattern库覆盖了内容创作、代码开发、学术研究、职场办公等数百种场景,同时支持用户自定义Pattern和工作流,能实现个人/团队级别的提示词沉淀,而其跨平台的特性让它能运行在个人电脑、服务器、树莓派等各类设备上,安装和使用门槛低。无论是开发者、内容创作者、学术研究者,还是职场办公人士和企业团队,都能通过Fabric将AI能力无缝融入现有工作流,实现从“和AI聊天”到“指挥AI工作”的转变,大幅提升信息处理和任务完成的效率,Fabric也凭借其简洁的设计、强大的功能和活跃的社区,成为了当下最受欢迎的开源AI工具框架之一,是提升AI使用效率的核心利器。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/fabric.html