MTranServer:开源离线翻译服务器,低耗高速私有化部署解决方案

一、MTranServer 是什么?

在数字化时代,翻译服务已成为跨语言沟通的核心工具,但主流在线翻译服务普遍存在网络依赖、数据隐私泄露风险、响应速度受网络波动影响等问题。而传统开源翻译方案又往往面临资源消耗过高、部署复杂、响应迟缓等痛点,难以满足普通用户和中小企业的实际需求。MTranServer 的出现,正是为了解决这些矛盾,为用户提供一款"轻量、快速、安全、易用"的翻译服务替代方案。

MTranServer 是一个专注于低资源消耗、超快速响应、完全离线运行、支持私有化部署的开源翻译服务器项目,其核心定位是"可私有部署的自由版 Google 翻译"。该项目基于 Mozilla 的 Bergamot 翻译模型和 Marian-NMT 推理框架构建,无需依赖独立显卡,仅通过 CPU 即可实现高效的神经网络翻译计算,单个翻译请求平均响应时间仅需 50 毫秒,远优于同类开源产品。

与传统在线翻译服务不同,MTranServer 采用"本地模型+离线运行"的架构,首次使用时下载对应语言模型后,后续所有翻译任务均在本地设备或私有服务器上完成,无需将文本数据传输至第三方服务器,从根源上保障了数据隐私安全。同时,其极致优化的资源占用设计,使得该项目不仅能在普通电脑、云服务器上稳定运行,还可部署在 Raspberry Pi(树莓派)等边缘设备上,满足多样化的使用场景需求。

截至目前,MTranServer 已迭代至 v4 版本,在内存占用控制、响应速度优化、稳定性提升及多语言支持方面持续完善,支持英语、中文、法语、西班牙语、波斯语、波兰语等全球主要语言的互译,翻译质量接近商业级翻译服务水平,用户满意度达到商业服务的 90%,而资源消耗仅为后者的十分之一。其开源特性允许开发者根据需求扩展语言支持或进行二次开发,进一步提升了项目的灵活性和适用范围。

二、功能特色

MTranServer 之所以能在众多翻译工具中脱颖而出,核心在于其围绕"实用场景"构建的四大核心功能特色,既解决了用户的核心痛点,又提供了超出预期的使用体验。

1. 超低资源消耗,无显卡也能流畅运行

这是 MTranServer 最突出的优势之一。项目通过先进的模型量化技术和架构优化,将资源占用控制在极低水平,完全摆脱了对独立显卡的依赖,仅需普通 CPU 即可驱动。实际测试数据显示,运行单个语言模型(如英译中)时,其内存占用仅为 700-860MB,远低于 Facebook NLLB、LibreTranslate 等同类开源项目的高内存占用表现。

这种低资源消耗特性带来了极强的设备兼容性:无论是配置普通的办公电脑、性能有限的边缘计算设备(如树莓派 4B),还是资源受限的云服务器,都能流畅运行 MTranServer,无需为翻译服务额外升级硬件配置。对于中小企业或个人用户而言,这意味着无需投入高额硬件成本,即可拥有专属的翻译服务器。

2. 极速响应性能,支持高并发处理

MTranServer 针对实时翻译场景进行了深度优化,单个翻译请求的平均响应时间仅为 50 毫秒,批量翻译场景下支持高吞吐量处理,可满足实时应用的性能需求。在树莓派 4B(4GB 版)上测试时,经过优化配置后平均响应时间可控制在 52 毫秒,接近桌面端设备的表现;而在 4 核 CPU 的云服务器上,通过 Nginx 反代分发请求,并发处理能力可达 1000 req/s(每秒 1000 个请求),足以支撑中小型团队的日常翻译需求。

这种极速响应能力主要得益于两大技术优化:一是模型加载机制的优化,首次加载模型后会常驻内存,后续翻译请求无需重复加载,大幅缩短响应时间;二是异步处理架构与多线程并行计算的结合,能够高效利用 CPU 资源,提升并发处理效率。对于需要实时翻译的场景(如网页划词翻译、聊天机器人多语言交互),这种性能表现能够带来"无感延迟"的使用体验。

3. 完全离线运行,数据隐私绝对安全

MTranServer 采用"离线优先"的设计理念,所有翻译逻辑均在本地完成,彻底摆脱了对互联网连接的依赖。用户首次使用时,仅需下载对应语言对的模型文件(每个模型约 100-500MB,根据语言对不同有所差异),后续即使断开网络,也能正常使用翻译功能。

更重要的是,离线运行模式从根本上解决了数据隐私泄露的风险。在翻译过程中,待翻译文本无需传输至任何第三方服务器,所有数据处理均在本地设备或私有服务器内部完成,避免了数据在传输过程中被拦截、泄露的可能。这一特性对于处理敏感信息的场景(如企业机密文档翻译、政府保密通讯、个人隐私内容翻译)尤为重要,已在医疗、军工等关键行业的实际应用中得到验证。

4. 灵活部署方式,多场景无缝适配

MTranServer 提供了多样化的部署方案,无论是技术小白还是专业开发者,都能找到适合自己的部署方式,同时支持多种设备和系统环境,适配性极强。

跨平台支持:兼容 Windows、Mac、Linux 三大桌面操作系统,同时支持 x86_64 和 ARM64 处理器架构,无论是普通 PC、Apple Silicon 架构的 Mac,还是树莓派等 ARM 设备,都能稳定运行。

部署方式多样:提供桌面端一键启动包、Docker 容器化部署、服务端手动部署三种核心方式。桌面端用户可通过一键安装包快速启动服务,无需复杂配置;开发者或企业用户可通过 Docker 实现快速部署和环境隔离,支持容器后台运行和自动重启;专业用户则可选择手动部署,进行更精细的参数配置。

丰富的接口兼容:内置普通翻译、批量翻译等基础 API,同时兼容 Google Translate 接口、OpenAI 接口,支持沉浸式翻译、简约翻译、划词翻译等主流浏览器插件集成,可无缝对接现有应用或工具链。

安全防护能力:支持设置 API_TOKEN 进行访问认证,防止服务被未授权调用;可结合防火墙限制访问来源,进一步提升私有部署的安全性。

5. 多语言支持,翻译质量接近商业级

MTranServer 基于多语言神经机器翻译架构,采用共享编码器设计,能够有效捕捉不同语言之间的隐含关联,翻译质量接近 Google Translate 等商业级服务。目前已支持全球主要语言的互译,包括但不限于:

常用语言:英语、中文(简体/繁体)、日语、韩语、法语、西班牙语、德语、俄语、葡萄牙语等;

扩展语言:波斯语、波兰语等,且语言支持列表仍在持续更新中。

对于日常沟通、文档阅读、网页浏览等普通场景,其翻译结果的准确性和流畅度完全能够满足需求;即使是专业文档翻译,虽然在专业术语处理上略逊于商业大模型,但通过后续的模型优化和自定义词典扩展,可进一步提升翻译质量。此外,项目的开源特性允许开发者根据需求添加小众语言模型,进一步扩展其多语言覆盖能力。

三、技术细节

MTranServer 的出色表现,离不开其底层扎实的技术架构和针对性的优化设计。以下从核心技术选型、架构设计、关键优化策略三个维度,详细解析其技术细节。

1. 核心技术选型

MTranServer 在技术选型上遵循"实用优先、高效轻量"的原则,选择了经过实践验证的成熟技术栈,同时针对翻译场景进行了定制化优化:

翻译模型:基于 Mozilla Bergamot 项目构建核心翻译模型,该模型以轻量高效著称,专为客户端和低资源环境设计,在保证翻译质量的同时,大幅降低了资源消耗。

推理框架:采用 Marian-NMT 推理框架,这是一款高效的神经机器翻译框架,支持多线程并行计算和模型量化,能够充分发挥 CPU 的计算能力,提升翻译速度。

后端开发:早期版本采用 Fastify 框架和 Node.js 开发,v3 版本后重构为 Go 语言开发,进一步提升了性能和资源利用效率,降低了内存占用。

部署工具:基于 Docker 实现容器化部署,简化了环境配置和部署流程,确保在不同设备和系统上的运行一致性;同时支持 Docker Compose 进行服务编排,方便进行多容器协同部署。

前端交互:内置简易 UI 界面和 Swagger 接口调试文档,方便用户直接通过浏览器使用翻译功能或调试 API;桌面端提供托盘菜单管理服务,支持启动、停止、配置等快速操作。

2. 架构设计

MTranServer 采用"分层架构+模块化设计",整体架构清晰,各模块职责明确,便于维护和扩展:

表现层:包括桌面端托盘程序、内置 Web UI、Swagger 接口文档、插件集成接口等,负责与用户或外部应用进行交互,提供多样化的使用入口。

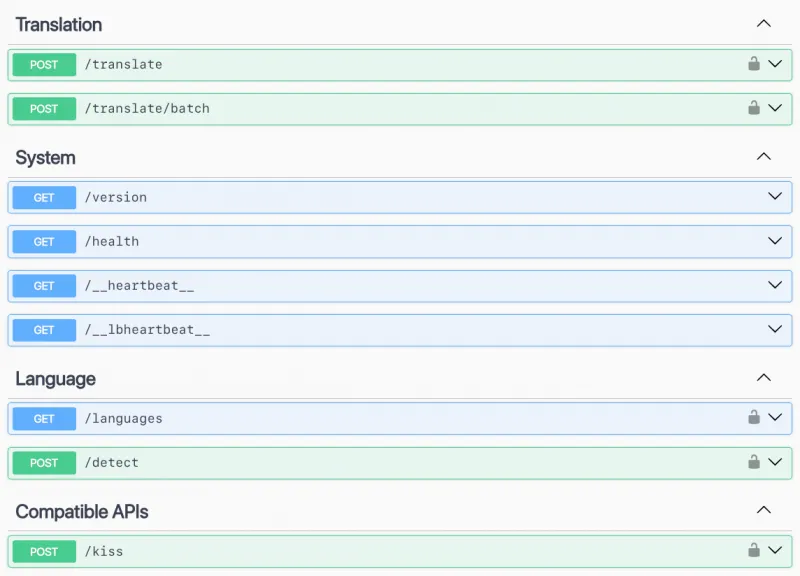

接口层:封装了各类翻译 API(普通翻译、批量翻译、兼容接口等)和系统管理 API(版本查询、健康检查、模型列表查询等),统一接口规范,方便外部应用调用。

核心服务层:包含翻译任务调度、模型管理、并发控制、权限验证等核心逻辑,是系统的核心处理单元。其中,翻译任务调度模块负责接收和分发翻译请求,通过多线程并行处理提升效率;模型管理模块负责模型的加载、缓存、卸载等生命周期管理,确保模型资源的高效利用。

数据层:主要包括语言模型文件、配置文件、缓存数据等,采用本地文件存储方式,无需依赖数据库,简化了部署和维护成本。

这种架构设计的优势在于:各层之间松耦合,便于单独升级或修改某一层的功能;模块化设计使得新增语言支持、扩展接口类型等操作更加便捷;本地文件存储减少了外部依赖,提升了系统的稳定性和离线可用性。

3. 关键优化策略

MTranServer 的低资源消耗和高响应速度,离不开以下三大关键优化策略:

模型量化优化:采用 INT8 量化技术对原始模型进行压缩,在几乎不损失翻译质量的前提下,将模型体积缩小 75% 以上,同时降低内存占用和计算量,提升运行速度。

矩阵运算优化:通过 ALPHAS 参数优化矩阵运算逻辑,减少不必要的计算步骤,充分利用 CPU 的 SIMD 指令集,提升计算效率,缩短翻译耗时。

资源管理优化:实现智能的模型缓存机制,支持配置模型缓存大小,避免频繁加载和卸载模型;同时通过多线程并行处理架构,根据 CPU 核心数动态调整工作线程数量,平衡资源占用和处理速度。

此外,针对 ARM 架构设备(如树莓派),MTranServer 还提供了专门的优化配置,包括限制 CPU 核心使用以避免资源竞争、控制并行线程数、限制磁盘 I/O 速度等,确保在低性能设备上也能稳定运行。

四、应用场景

MTranServer 凭借其低资源消耗、离线运行、私有化部署、高速响应等核心特性,已在多个场景中得到广泛应用,覆盖个人用户、中小企业、专业开发者、科研机构等不同用户群体。

1. 企业内部翻译场景

对于需要处理敏感文档的企业而言,数据安全是首要考虑因素。MTranServer 的私有化部署和离线运行特性,使其成为企业内部翻译服务的理想选择:

机密文档翻译:企业的商业合同、技术文档、财务报告等敏感内容,可通过内部部署的 MTranServer 进行翻译,无需上传至外部服务器,避免数据泄露风险。

多语言办公协作:跨国企业或拥有多语言团队的企业,可在内部服务器部署 MTranServer,为员工提供实时翻译服务,支持邮件、会议纪要、项目文档等内容的快速翻译,提升协作效率。

产品本地化:软件企业在进行产品国际化时,可使用 MTranServer 翻译产品界面、用户手册、帮助文档等内容,本地化过程在企业内部完成,保障产品信息的保密性,同时降低翻译成本。

某制造企业的实际应用案例显示,通过部署 MTranServer 替代原有的在线翻译服务,不仅杜绝了技术文档外泄的风险,还将多语言文档生成时间从 10 秒缩短至 1 秒,显著提升了工作效率。

2. 个人与办公场景

对于普通个人用户或办公人群,MTranServer 可满足日常翻译需求,同时提供更安全、更快速的使用体验:

网页翻译:通过集成沉浸式翻译、划词翻译等浏览器插件,实现网页内容的实时翻译,响应速度比在线翻译插件快 3 倍以上,且无需担心浏览内容被第三方获取。

文档翻译:处理 PDF、Word 等格式的文档翻译时,无需上传文件至在线翻译平台,直接在本地完成翻译,既保护隐私,又不受文件大小限制。

学习与研究:学生、科研人员可使用 MTranServer 翻译外文文献、论文、专业资料等,离线模式支持在无网络环境下(如图书馆、实验室)使用,高速响应提升学习和研究效率。

3. 开发者与技术集成场景

MTranServer 提供了丰富的 API 接口和插件兼容能力,深受开发者青睐,可作为翻译服务组件集成到各类应用中:

应用程序集成:开发者可将 MTranServer 的翻译 API 集成到自己开发的 Web 应用、移动应用、桌面软件中,为应用添加内置翻译功能,无需依赖第三方翻译 API,降低开发成本和使用成本。

聊天机器人开发:为多语言聊天机器人提供实时翻译支持,实现不同语言用户之间的无障碍沟通,50 毫秒级的响应速度确保对话的流畅性。

测试环境替代:在软件开发测试过程中,可使用 MTranServer 替代在线翻译 API,避免网络波动影响测试流程,同时降低 API 调用费用。

4. 低资源与边缘设备场景

MTranServer 的低资源消耗特性,使其能够部署在树莓派等边缘计算设备上,拓展了翻译服务的应用边界:

边缘计算节点:在工业物联网、智慧园区等场景中,部署在边缘设备上的 MTranServer 可为本地设备提供实时翻译服务,支持设备间的多语言数据交互。

偏远地区使用:在网络信号差或无网络覆盖的偏远地区(如野外作业、乡村教育场景),可通过本地部署 MTranServer 的设备,为用户提供翻译服务,解决语言沟通障碍。

嵌入式系统集成:可作为嵌入式翻译模块,集成到智能终端、车载系统、智能家居设备等产品中,为用户提供本地化的翻译功能。

五、使用方法

MTranServer 提供了多种部署和使用方式,满足不同用户的需求。以下详细介绍最常用的三种使用方式,包括桌面端一键部署、Docker 容器化部署、服务端手动部署,以及 API 接口调用和插件集成方法。

1. 前置准备

无论选择哪种部署方式,都需要完成以下基础准备工作:

硬件要求:

CPU:支持 AVX2 指令集的 x86_64 架构处理器,或兼容的 ARM64 架构处理器(如树莓派 4B);

内存:建议至少 2GB(运行单个语言模型),若需同时运行多个语言模型,建议 4GB 及以上;

存储:每个语言模型约需 200MB 存储空间,建议预留至少 1GB 空间用于存储模型文件和配置文件。

软件要求:

桌面端部署:需安装 Docker Desktop(Windows/Mac)或 Docker Engine(Linux);

服务端部署:需安装 Docker-CE 及 Docker Compose(推荐),或 Node.js/bun/pnpm 等包管理器;

网络要求:首次使用需联网下载语言模型文件,后续可离线使用。

2. 桌面端一键部署(推荐新手)

桌面端一键部署是最简单的使用方式,适用于普通用户,无需复杂配置,步骤如下:

步骤 1:下载安装包

前往 MTranServer 项目的 GitHub Releases 页面,下载对应操作系统的桌面一键包(Onekey Package),或直接下载 Docker 一键部署压缩包(包含 compose.yml 配置文件和默认模型目录)。

步骤 2:解压与配置

将下载的压缩包解压到纯英文路径的文件夹中(如 D:\MTranServer),解压后会得到 compose.yml 配置文件和 models 模型目录(默认可能仅包含英译中模型)。

用文本编辑器打开 compose.yml 文件,进行基础配置修改:

services: mtranserver: image: xxnuo/mtranserver:latest container_name: mtranserver restart: unless-stopped ports: - "8989:8989" # 端口映射,左侧为本地访问端口,可修改(如9000:8989) volumes: - ./models:/app/models # 模型文件目录映射 environment: - CORE_API_TOKEN=your_secure_token # 访问认证Token,本机使用可留空

端口映射:默认使用 8989 端口,若该端口被占用,可修改左侧端口号(如

9000:8989);API Token:用于防止服务被未授权访问,公网部署时建议设置复杂密码,本地使用可留空;

模型目录:

models文件夹用于存放语言模型,默认可能仅包含英译中模型,如需其他语言模型,需单独下载并解压至该目录。

步骤 3:启动服务

Windows 系统:进入解压后的文件夹,右键选择"在终端中打开",输入命令

docker compose up启动服务进行测试,若终端显示"Container mtranserver Created"且无报错,说明启动成功;测试无误后,输入docker compose up -d使服务在后台运行(后台运行后可关闭终端)。Mac/Linux 系统:打开终端,切换到解压目录(如

cd ~/Downloads/MTranServer),执行docker compose up测试启动,再执行docker compose up -d后台运行。

步骤 4:验证服务

打开浏览器,输入 http://localhost:8989/imme(端口号需与配置文件一致),若页面返回"405 Method Not Allowed",说明服务运行正常;若需查看 Swagger 接口文档,可访问 http://localhost:8989/docs。

3. Docker Compose 部署(推荐企业/服务器使用)

Docker Compose 部署适用于云服务器、NAS 等设备,支持更灵活的配置和管理,步骤如下:

步骤 1:安装 Docker 环境

云服务器(Ubuntu/Debian):执行以下命令安装 Docker-CE 和 Docker Compose:

# 更新软件源 sudo apt update # 安装依赖包 sudo apt install -y apt-transport-https ca-certificates curl software-properties-common # 添加 Docker 官方 GPG 密钥 curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo gpg --dearmor -o /etc/apt/trusted.gpg.d/docker.gpg # 添加 Docker 软件源 sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable" # 安装 Docker-CE sudo apt install -y docker-ce docker-compose-plugin # 启动 Docker 服务 sudo systemctl start docker # 设置 Docker 开机自启 sudo systemctl enable docker

其他系统:参考 Docker 官方文档安装对应版本的 Docker 环境。

步骤 2:创建部署目录

# 创建项目目录 mkdir -p /opt/mtranserver # 进入目录 cd /opt/mtranserver # 创建模型目录 mkdir models # 创建 compose.yml 文件 touch compose.yml

步骤 3:编写配置文件

用文本编辑器打开 compose.yml 文件,添加以下配置(可根据需求调整):

services: mtranserver: image: xxnuo/mtranserver:latest container_name: mtranserver restart: unless-stopped ports: - "8989:8989" volumes: - ./models:/app/models - ./logs:/app/logs # 日志目录映射(可选) environment: - CORE_API_TOKEN=your_secure_token # 必选,公网部署建议设置复杂密码 - MODEL_CACHE_SIZE=2 # 模型缓存数量(可选,默认2) - WORKER_THREADS=4 # 工作线程数(可选,默认等于CPU核心数) networks: - mtranserver-network networks: mtranserver-network: driver: bridge

步骤 4:下载语言模型

前往项目 GitHub Releases 的 Models 标签页,下载所需的语言模型包(如 enzh、zhfr 等),将每个模型包解压至 ./models 目录下,解压后目录结构如下:

models/ ├── enzh │ ├── lex.50.50.enzh.s2t.bin │ ├── model.enzh.intgemm.alphas.bin │ └── vocab.enzh.spm └── zhfr ├── lex.50.50.zhfr.s2t.bin ├── model.zhfr.intgemm.alphas.bin └── vocab.zhfr.spm

步骤 5:启动与管理服务

启动服务:

docker compose up -d查看服务状态:

docker compose ps查看日志:

docker compose logs -f停止服务:

docker compose down更新服务:

docker compose pull && docker compose up -d(更新镜像并重启)

4. 服务端手动部署(开发者/专业用户)

对于需要自定义配置或二次开发的用户,可选择手动部署方式:

步骤 1:安装依赖

# 安装 Node.js(推荐v16+)或 bun(推荐) # 以 bun 为例(性能更优) curl -fsSL https://bun.sh/install | bash

步骤 2:安装 MTranServer

# 全局安装 bun install -g mtranserver@latest # 或使用 npm/pnpm npm install -g mtranserver@latest pnpm add -g mtranserver@latest

步骤 3:启动服务

# 直接启动(默认端口8989) mtranserver # 自定义端口启动 mtranserver --port 9000 # 设置 API Token 启动 mtranserver --token your_secure_token # 指定模型目录启动 mtranserver --model-dir /path/to/models

5. 核心使用方式

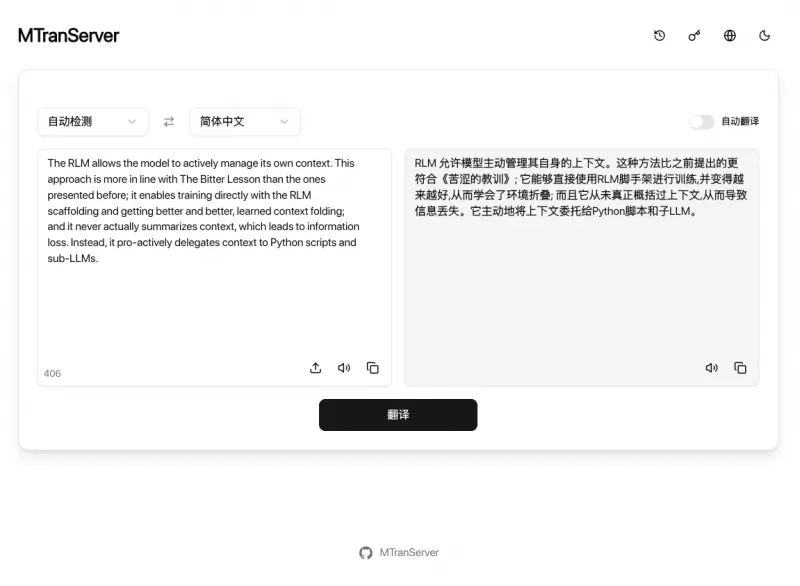

(1)Web UI 直接使用

服务启动后,打开浏览器访问 http://localhost:8989(端口号与配置一致),即可进入内置 Web UI,输入待翻译文本,选择源语言和目标语言,点击翻译即可获得结果,操作简单直观,适合临时翻译需求。

(2)API 接口调用

开发者可通过 API 接口调用翻译服务,支持普通翻译、批量翻译等功能,以下是常用接口的使用示例:

基础翻译接口

请求地址:

http://host:port/translate请求方法:POST

请求头:

Content-Type: application/json请求体(JSON):

{

"from": "en", # 源语言代码(ISO 639-1标准,如en=英语,zh=中文)

"to": "zh", # 目标语言代码

"text": "Hello, world!" # 待翻译文本

}响应体(JSON):

{

"result": "你好,世界!"

}批量翻译接口

请求地址:

http://host:port/translate/batch请求方法:POST

请求体(JSON):

{

"from": "en",

"to": "zh",

"texts": ["Text 1", "Text 2", "This is a test."] # 批量待翻译文本数组

}响应体(JSON):

{

"results": ["文本1", "文本2", "这是一个测试。"]

}带认证的接口调用

若设置了 API Token,需在请求中添加 Token 认证:

方式一:URL 参数携带:

http://host:port/translate?token=your_secure_token方式二:请求头携带:

Authorization: Bearer your_secure_token

(3)浏览器插件集成

MTranServer 兼容多种主流翻译插件,可直接在插件中配置使用,以下是常用插件的配置方法:

| 插件类型 | 无认证URL | 认证URL格式 | 配置说明 |

|---|---|---|---|

| 沉浸式翻译 | http://host:8989/imme | http://host:8989/imme?token=YOUR_TOKEN | 在插件设置中选择"自定义API",填入URL即可 |

| 简约翻译 | http://host:8989/kiss | - | 在插件设置中添加KEY参数,值为你的TOKEN |

| 划词翻译 | http://host:8989/hcfy | http://host:8989/hcfy?token=YOUR_TOKEN | 直接填入URL,划词时自动调用翻译服务 |

配置完成后,即可像使用在线翻译插件一样,实现网页划词翻译、全页翻译等功能,响应速度更快,且数据本地处理更安全。

6. 性能优化建议

为了获得更好的使用体验,可根据实际场景进行以下优化:

模型管理:仅加载实际需要的语言模型,避免同时加载过多模型导致内存占用过高;

并发设置:根据 CPU 核心数调整工作线程数(WORKER_THREADS),4 核 CPU 建议设置为 4-8,避免线程过多导致资源竞争;

缓存策略:对频繁翻译的内容(如固定术语、常用短语)实现应用层缓存,减少重复翻译计算;

长文本处理:单次请求文本长度建议不超过 5000 字符,过长文本应分段发送,提升翻译速度和成功率;

Windows 环境优化:Docker Desktop 可切换至 WSL2 后端,大幅降低内存占用和提升运行效率;

ARM 设备优化:限制 CPU 核心使用(如

--cpuset-cpus 0-3)、设置 OMP_NUM_THREADS=2 环境变量,避免设备过热和资源耗尽。

六、常见问题解答(FAQ)

1. 翻译质量如何?与商业翻译服务有差距吗?

MTranServer 的翻译质量接近 Google Translate 等商业级服务,用户满意度达到商业服务的 90%,能够满足日常沟通、文档阅读、网页浏览等普通场景的需求。但在长文本翻译、专业术语处理、语境理解等方面,仍略逊于商业大模型(如 GPT-4 系列、DeepL)。如果需要极高精度的专业翻译,建议结合人工校对或使用商业翻译服务;若注重隐私和效率,MTranServer 是更优选择。

2. 支持哪些语言?如何添加新的语言对?

目前支持英语、中文、法语、西班牙语、波斯语、波兰语等全球主要语言的互译,语言列表持续更新中。添加新语言对的步骤如下:

前往项目 GitHub Releases 的 Models 标签页,下载所需语言对的模型包;

将模型包解压至部署目录下的

models文件夹中;重启 MTranServer 服务,即可自动识别并加载新语言模型。

3. 必须使用 Docker 部署吗?没有 Docker 可以使用吗?

不是必须使用 Docker 部署。MTranServer 提供多种部署方式,除了 Docker 部署,还支持桌面端一键启动(内置 Docker 环境)、服务端手动部署(通过 npm/bun/pnpm 安装),无需 Docker 也能正常使用。对于技术小白,推荐使用桌面端一键包;对于开发者,可选择手动部署方式。

4. 支持 ARM 架构设备(如树莓派)吗?如何优化运行效果?

目前 MTranServer 主要支持 x86_64 架构,ARM64 架构(如树莓派 4B、Apple Silicon Mac)已适配,可正常运行但性能可能略低于 x86_64 设备。ARM 设备优化建议:

限制 CPU 核心使用,避免资源竞争(如

--cpuset-cpus 0-3);控制并行线程数,设置

OMP_NUM_THREADS=2环境变量;为设备安装散热片,避免长时间运行导致过热降频;

仅加载必要的语言模型,减少内存占用。

5. 如何保障服务安全?防止未授权访问?

保障服务安全的核心措施有两点:

设置强 API Token:部署时通过

CORE_API_TOKEN环境变量或--token参数设置复杂的访问密码,避免弱密码被破解;限制访问来源:通过防火墙或安全组规则,仅允许信任的 IP 地址访问服务端口(如企业内网 IP),禁止公网直接访问;

定期更新:及时拉取最新镜像或更新软件版本,修复可能存在的安全漏洞。

6. 服务启动后无法访问,可能是什么原因?如何排查?

服务启动后无法访问,常见原因及排查方法如下:

端口被占用:检查配置的端口(默认 8989)是否被其他应用占用,可更换端口后重启服务;

防火墙拦截:检查本地防火墙或服务器安全组是否开放了对应的服务端口,需确保端口允许访问;

容器启动失败:Docker 部署时,查看容器日志(

docker compose logs -f),排查是否存在模型文件缺失、权限不足等问题;地址配置错误:确保访问地址中的 IP 和端口与配置一致,本地部署使用

localhost或127.0.0.1,服务器部署使用服务器公网/内网 IP。

7. 单次翻译支持的最大文本长度是多少?

建议单次请求的文本长度不超过 5000 字符,过长的文本会导致翻译耗时增加,甚至可能出现内存溢出或请求超时。对于长文本(如长篇文档、论文),建议分段拆分后通过批量翻译接口发送,每段字符数控制在 2000-3000 为宜。

8. 如何更新语言模型或服务器版本?

更新服务器版本:

Docker 部署:执行

docker compose pull && docker compose up -d,自动拉取最新镜像并重启服务;手动部署:执行

bun update -g mtranserver或npm update -g mtranserver。更新语言模型:

前往项目 GitHub 下载最新的语言模型包;

替换

models目录下对应的旧模型文件;重启 MTranServer 服务即可生效。

七、相关链接

项目 GitHub 仓库:https://github.com/xxnuo/MTranServer

官方 Releases 页面(下载安装包/模型):https://github.com/xxnuo/MTranServer/releases

模型下载地址:https://github.com/xxnuo/MTranServer/releases/tag/models

镜像仓库(Docker):https://hub.docker.com/r/xxnuo/mtranserver

八、总结

MTranServer 作为一款开源离线翻译服务器,以"低资源消耗、高速响应、私有化部署、数据安全"为核心优势,通过优化的模型架构和部署方案,成功解决了传统在线翻译服务的数据隐私风险、网络依赖问题,以及同类开源项目资源占用过高、部署复杂的痛点。该项目支持跨平台运行和多语言互译,翻译质量接近商业级服务,同时提供桌面端一键部署、Docker 容器化部署、服务端手动部署等多种灵活的使用方式,兼容浏览器插件和开发者 API 接口,适配企业内部翻译、个人办公学习、开发者应用集成、边缘设备部署等多样化场景。无论是注重数据安全的企业用户、追求高效便捷的个人用户,还是需要定制化集成的开发者,都能从 MTranServer 中获得符合需求的翻译解决方案。其开源特性不仅降低了使用成本,更允许开发者参与到项目迭代和功能扩展中,持续丰富项目的语言支持和功能特性,使其成为离线翻译领域极具实用价值的开源项目。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/mtranserver.html