Pixel Reasoner:开源7B级像素空间视觉推理模型,解锁多模态精细感知与主动视觉操作

一、Pixel Reasoner是什么

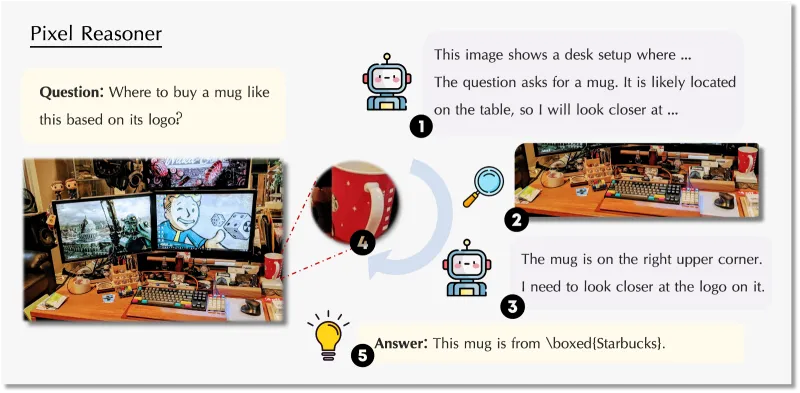

Pixel Reasoner是由滑铁卢大学、香港科技大学、中国科学技术大学及Vector Institute联合TIGER-AI-Lab研发的开源视觉语言模型(VLM)项目,基于Qwen2.5-VL架构搭建,首创像素空间推理全新范式,打破传统VLM仅依赖文本思维链的推理局限。项目采用指令微调与好奇心驱动强化学习两阶段训练方案,为模型配备主动放大、关键帧选取等原生视觉操作能力,让模型可直接在像素维度检视、质询视觉证据,提升复杂视觉任务的推理保真度。7B参数版本的Pixel Reasoner在V* bench、TallyQA-Complex、InfographicsVQA、MVBench-test等主流视觉推理基准斩获开源模型SOTA成绩。

从技术本质来看,Pixel Reasoner不是全新的模型架构,而是一套完整的VLM能力增强框架,包含数据合成、两阶段训练、推理优化、评估基准适配全流程工具链,同时提供训练完成的成品模型,开发者可直接用于推理,也可基于框架微调适配自定义视觉任务。其核心创新是提出“像素空间推理(Pixel-space Reasoning)”概念,并设计好奇心驱动奖励机制解决模型“学习陷阱”问题,让模型愿意主动使用视觉操作,而非依赖成熟的文本推理能力规避探索。

二、功能特色

Pixel Reasoner围绕像素空间推理构建全栈功能,兼顾学术研究的可复现性与工程落地的实用性,核心功能可分为六大类,覆盖训练、推理、评估、兼容适配全场景:

(一)原生视觉操作集成

为模型内置标准化视觉操作接口,核心支持两类基础操作,可覆盖绝大多数精细视觉推理需求,操作逻辑嵌入推理轨迹,由模型自主决策触发时机与执行参数:

zoom-in(区域放大):对图像指定边界框(bbox)区域进行像素级放大,聚焦微小文字、细节图案、局部特征,解决高分辨率图像细节丢失问题;

select-frame(帧选取):从视频序列中筛选关键帧,定位动作发生、状态变化的核心画面,适配视频理解、时序推理任务。

(二)多形态训练支持

支持多轮轨迹指令微调:基于合成的视觉-文本混合推理轨迹进行监督微调,让模型学习视觉操作的触发条件、执行流程与结果结合逻辑;

支持多轮轨迹强化学习:基于好奇心驱动奖励机制,优化模型视觉操作的使用频率与合理性,平衡探索与利用;

支持图像+视频混合数据训练:同时兼容静态图像数据集与动态视频数据集,统一训练流程与数据格式,降低多模态数据适配成本。

(三)高效推理与评估优化

集成vLLM推理引擎,实现高并发、低延迟的批量推理,大幅提升评估与部署效率;

适配V* bench、TallyQA-Complex、InfographicsVQA、MVBench-test四大主流视觉推理基准,提供一键数据准备、推理执行、指标计算脚本,可快速复现官方SOTA结果;

支持单节点与多节点分布式训练/评估,适配4×8、8×8等多GPU集群配置,满足大规模训练需求。

(四)完整工程化工具链

提供从环境安装、数据下载、训练启动、推理运行到结果保存的全流程Shell脚本,无需复杂代码修改,仅需配置路径与超参数即可执行;同时包含数据预处理、图像路径重命名、评估结果解析等辅助工具,降低开发者上手门槛。

(五)跨环境兼容适配

针对中国大陆用户提供Hugging Face镜像源配置方案,解决模型与数据集下载卡顿问题;修复Qwen2.5-VL与flash-attn、vLLM的版本兼容bug,提供明确的环境依赖与修复指令,保障不同硬件、系统环境下的稳定运行。

(六)轻量化高性能平衡

采用7B参数基础模型,相较于13B、27B等大参数量VLM,显存占用更低、推理速度更快,同时在多个基准上超越同规模甚至更大参数的开源模型,实现“小模型、高性能”的效果,适合边缘部署与低成本落地。

核心视觉操作与适用场景对照表

| 视觉操作名称 | 执行逻辑 | 适用任务类型 | 典型使用案例 |

|---|---|---|---|

| zoom-in | 接收图像边界框坐标,对目标区域进行像素放大,保留细节纹理 | 高分辨率图像解析、微小物体识别、图表文字读取、医疗影像局部分析 | 读取产品包装微小印刷文字、放大医学影像病灶区域、解析信息图细小标注 |

| select-frame | 接收视频帧序号,提取单帧或多帧关键画面,转化为静态图像推理 | 视频动作定位、时序事件分析、短视频内容理解、监控画面检索 | 定位视频中物品掉落的关键帧、提取教学视频操作步骤核心画面 |

三、技术细节

Pixel Reasoner的技术体系围绕“像素空间推理落地”展开,核心解决两大问题:一是让模型学会使用视觉操作,二是让模型主动使用视觉操作,整体技术框架分为问题定义、训练范式、奖励机制、性能优化四大模块,所有设计均严格遵循项目论文与官方文档。

(一)核心问题:传统VLM的学习陷阱

研发团队发现,直接为VLM添加视觉操作会陷入“学习陷阱”:模型原生文本推理能力成熟,而像素空间推理能力为零,初始使用视觉操作易产生错误结果,获得负反馈后,模型会彻底放弃视觉操作,完全依赖文本推理,无法形成能力迭代。同时,模型缺乏主动探索视觉操作的内在动机,仅追求答案正确的外在奖励,进一步加剧对文本推理的依赖。这一问题是像素空间推理难以落地的核心障碍,也是Pixel Reasoner的技术攻关重点。

(二)两阶段训练范式

项目采用固定的两阶段训练流程,分步解决“学会操作”与“主动用操作”的问题,流程可复现、参数可配置,是项目的核心技术框架:

第一阶段:合成轨迹指令微调(Instruction Tuning)

数据准备:以高分辨率图像、视频为种子数据,通过源数据标注或GPT-4o生成边界框/帧序号,定位视觉关键线索;

轨迹合成:采用模板化方式生成推理轨迹,结构为“全局视觉分析→触发视觉操作→局部细节分析→输出答案”,同时加入错误操作自校正轨迹,提升模型鲁棒性;

微调目标:让模型熟悉视觉操作的语法、触发场景、执行逻辑,建立文本推理与视觉操作的关联,完成基础能力初始化。

第二阶段:好奇心驱动强化学习(Curiosity-Driven RL)

基于OpenRLHF框架与PPO算法优化,解决学习陷阱问题;

核心目标:平衡像素空间推理与文本推理的探索,让模型在保证答案正确的前提下,主动使用视觉操作。

(三)创新奖励机制设计

为驱动模型主动探索视觉操作,项目设计带约束的拉格朗日奖励函数,融合基础奖励、好奇心奖励、惩罚项三部分,公式如下:

r'(x, y) = r(x, y) + α·r_curiosity(x, y) + β·r_penalty(y)

各组件作用:

**基础奖励r(x, y)**:传统答案正确性奖励,保证模型输出结果准确;

好奇心奖励r_curiosity:鼓励模型探索视觉操作,提升像素空间推理率(RaPR),克服初始操作失败的负反馈;

惩罚项r_penalty:限制单轮推理中视觉操作的使用次数,避免无意义重复操作,提升推理效率。

同时设置两大硬约束:像素空间推理率(RaPR)不低于阈值H、单轮视觉操作次数不超过上限N,通过拉格朗日松弛法融入奖励函数,实现约束与奖励的动态平衡。

(四)基准性能表现

项目7B参数模型在四大核心基准的测试结果,均为当前开源模型最优水平,性能数据如下:

| 基准数据集 | 任务类型 | 模型指标 | 得分 | 行业定位 |

|---|---|---|---|---|

| V* bench | 综合视觉推理 | 准确率(Acc) | 84% | 开源模型SOTA |

| TallyQA-Complex | 复杂计数推理 | 准确率(Acc) | 74% | 开源模型SOTA |

| InfographicsVQA | 信息图视觉问答 | 准确率(Acc) | 84% | 开源模型SOTA |

| MVBench-test | 视频视觉推理 | 准确率(Acc) | 对应峰值 | 开源模型第一梯队 |

(五)推理与工程优化

显存优化:固定图像像素范围(MIN_PIXELS=401408、MAX_PIXELS=4014080),控制图像token数量,避免超出模型上下文长度;

推理加速:集成vLLM引擎,支持批量推理与张量并行,单GPU可承载高并发查询;

兼容性修复:针对Qwen2.5-VL的flash-attn兼容问题,提供nvjitlink库路径配置方案;解决transformers与vLLM版本不匹配的数据类型错误,提供指定版本安装指令。

四、典型应用场景

Pixel Reasoner的像素空间推理能力,精准匹配需要细粒度视觉分析、局部特征提取的场景,覆盖学术研究、工业落地、内容生产、专业分析等多个领域,核心应用场景如下:

(一)专业影像分析

医疗影像解读:对CT、MRI、病理切片进行区域放大,聚焦病灶、微小结节等细微特征,辅助医生完成初步筛查与报告生成;

工业质检:识别产品表面微小划痕、瑕疵、印刷错误,放大缺陷区域完成精准定位与分类,适配电子元件、包装、精密部件质检。

(二)文档与信息图解析

复杂文档处理:解析包含小字体注释、密集表格、嵌套图表的技术文档、财报、学术图表,放大文字与数据区域完成信息提取;

海报与宣传物料分析:提取海报角落微小版权信息、参数说明,识别商品包装的细小成分表、使用说明。

(三)视频内容理解

短视频与监控分析:从长视频、监控画面中选取关键帧,定位动作发生、异常事件的核心画面,简化视频检索与内容审核流程;

教育视频解析:提取实验操作、技能教学视频的关键步骤帧,生成图文版操作指南,适配在线教育内容生产。

(四)多模态产品开发

智能识图工具:为识图App、浏览器插件添加细节放大查询功能,用户可针对图像局部提问,模型自主放大区域后给出答案;

视觉问答机器人:适配客服机器人的图像咨询场景,用户发送商品细节、故障图片,模型放大问题区域后精准回复。

(五)学术研究与二次开发

VLM能力研究:作为像素空间推理的基准框架,供研究者探索新视觉操作、优化奖励机制、拓展多模态推理范式;

自定义任务微调:基于项目框架与预训练模型,微调适配遥感图像、天文图像、司法物证图像等垂直领域视觉任务。

五、使用方法

(一)基础环境准备

硬件要求:推荐NVIDIA GPU,显存≥24GB(7B模型单卡可运行,多卡可加速训练/评估);支持单节点与多节点分布式集群;

系统要求:Linux系统(Ubuntu 20.04及以上),支持CUDA 11.7及以上版本;

核心依赖:Python 3.8+、PyTorch、transformers、vLLM、OpenRLHF、ray等;

镜像配置(中国大陆用户):执行export HF_ENDPOINT=https://hf-mirror.com,解决Hugging Face下载问题。

(二)指令微调阶段执行

代码拉取:git clone https://github.com/TIGER-AI-Lab/Pixel-Reasoner.git,进入项目目录;

进入指令微调模块:cd instruction_tuning;

安装依赖:执行install目录下的安装指令,pip install -r requirements.txt,并从源码安装指定版本transformers;

配置参数:修改sft.sh脚本,填入预训练模型路径、SFT数据集路径、训练超参数(批次、学习率、训练轮数);

启动训练:bash sft.sh,等待训练完成,得到warm start模型(官方提供预训练好的PixelReasoner-WarmStart模型,可直接跳过此阶段)。

(三)好奇心驱动RL训练执行

数据准备:export dataname=PixelReasoner-RL-Data,进入onestep_evaluation目录,执行bash prepare.sh ${dataname},自动下载并处理RL训练数据;

模型下载:获取官方PixelReasoner-WarmStart模型,放置于指定路径;

环境安装:进入curiosity_driven_rl目录,按照installation.md安装OpenRLHF等RL依赖;

脚本配置:修改scripts/train_vlm_multi.sh(多节点)或train_vlm_single.sh(单节点),配置数据路径、模型路径、wandb密钥、GPU数量等参数;

启动训练:多节点执行bash ./scripts/train_vlm_multi.sh,单节点执行bash ./scripts/train_vlm_single.sh,训练完成得到PixelReasoner-RL-v1成品模型。

(四)模型推理与基准评估

图像基准评估(以V* bench为例)

数据准备:export dataname=VStar-EvalData-PixelReasoner,进入onestep_evaluation,执行bash prepare.sh ${dataname};

参数配置:设置benchmark=vstar,配置工作路径、模型路径、保存路径、nvjitlink库路径;

启动评估:执行scripts/eval_vlm_new.sh,自动完成推理与指标计算,输出准确率结果。

视频基准评估(以MVBench为例)

数据准备:export dataname=MVBench-EvalData-PixelReasoner,执行prepare.sh处理数据;

参数配置:设置benchmark=mvbench,其余参数同图像基准;

启动评估:执行相同评估脚本,得到视频推理准确率。

常规推理:基于transformers加载成品模型,输入图像/视频帧与文本指令,模型自主生成包含视觉操作的推理轨迹与最终答案。

六、常见问题解答

1. 运行时出现“上下文长度超出”错误如何解决?

该问题由图像像素过高导致图像token过多,或文本生成长度设置过大引发。首先调整环境变量MIN_PIXELS与MAX_PIXELS为官方默认值(401408、4014080),控制图像分辨率;其次减小训练/推理中的generate_max_len参数,降低文本生成长度;训练阶段可修改experience_maker.py中的max_imgnum参数,限制单轮输入的图像数量,减少总token数。

2. 出现transformers与vLLM数据类型不匹配错误怎么办?

这是依赖版本不兼容导致的,需强制重新安装官方指定的transformers源码版本,执行pip install --force-reinstall git+https://github.com/huggingface/transformers.git@9985d06add07a4cc691dc54a7e34f54205c04d4,同时更新vLLM至最新版本,重启环境后重新运行。

3. 计算logprobs时出现dump-info相关异常如何处理?

官方明确要求计算logprobs时必须设置单批次,即配置logp_bsz=1或--micro_rollout_batch_size=1,因为model.generate()接口在批次大于1时会出现特征不匹配问题,修改脚本参数后即可解决。

4. 无法复现官方SOTA成绩的原因有哪些?

核心原因是环境变量与参数配置错误,首先检查MIN_PIXELS、MAX_PIXELS是否与官方完全一致;其次确认多节点环境下,ray集群已同步所有环境变量,避免单节点配置生效、其他节点未同步;同时使用官方提供的模型checkpoint-246版本,勿使用其他训练中间节点。

5. 中国大陆用户无法下载模型与数据集的解决方案?

除配置HF_ENDPOINT镜像源外,可手动从Hugging Face镜像站下载模型与数据集,放置于本地路径,修改脚本中的路径配置为本地绝对路径,跳过在线下载环节;评估数据可通过官方HF集合页手动下载后预处理。

6. flash-attn相关报错的修复方法?

该问题是系统无法找到NVIDIA nvjitlink库导致,需在脚本中配置nvj_path变量,指向系统中nvjitlink的lib目录,例如export nvj_path=/usr/local/cuda/lib64,加载库文件后即可正常运行。

7. 模型是否支持13B及以上参数的Qwen-VL模型扩展?

项目官方代码基于7B参数模型开发,未直接提供13B/72B版本的配置文件,但框架架构支持扩展,开发者可修改模型加载配置、调整批次大小与显存分配参数,适配更大参数的Qwen-VL系列模型,需自行优化超参数与训练流程。

七、相关链接

研究论文arXiv链接:https://arxiv.org/pdf/2505.15966

成品模型(RL版):https://huggingface.co/TIGER-Lab/PixelReasoner-RL-v1

热启动模型(指令微调版):https://huggingface.co/TIGER-Lab/PixelReasoner-WarmStart

指令微调数据集:https://huggingface.co/datasets/TIGER-Lab/PixelReasoner-SFT-Data

强化学习数据集:https://huggingface.co/datasets/TIGER-Lab/PixelReasoner-RL-Data

评估数据集集合:https://huggingface.co/collections/JasperHaozhe/evaldata-pixelreasoner-6846868533a23e71a3055fe9

在线交互Demo:https://huggingface.co/spaces/TIGER-Lab/Pixel-Reasoner

八、总结

Pixel Reasoner是首个实现像素空间推理工程化落地的开源视觉语言模型框架,以解决传统VLM文本推理局限为核心目标,通过合成轨迹指令微调完成视觉操作基础学习,借助好奇心驱动强化学习克服模型学习陷阱,让7B参数模型在多个视觉推理基准达到开源SOTA水平,同时提供覆盖训练、推理、评估的全流程工具链,兼容图像与视频任务、支持高效vLLM推理与分布式部署,搭配完整的预训练模型、数据集与在线Demo,降低了像素空间推理技术的研究与落地门槛,其MIT开源协议、明确的问题修复方案与镜像适配支持,让不同地区、不同技术背景的开发者均可快速上手,既为多模态视觉推理研究提供了可复现的基准框架,也为医疗影像、文档解析、视频理解等实际场景提供了高性能、低成本的模型方案,完整实现了从学术创新到工程落地的全链路闭环。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/pixel-reasoner.html