Qwen3-Omni:阿里达摩院开源的多模态智能模型,支持实时音视频交互与跨模态理解

Qwen3-Omni是什么?

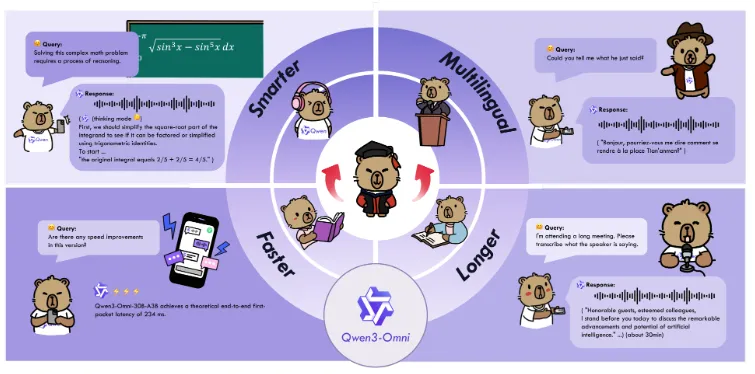

Qwen3-Omni是由阿里达摩院推出的开源全模态基础模型,支持文本、图像、音频、视频等多类型输入,并能实时输出文本或自然语音。该模型采用创新的“Thinker-Talker”架构与MoE(混合专家模型)技术,在36项音频/视频基准测试中22项达到行业领先水平(SOTA),支持119种文本语言、19种语音输入和10种语音输出语言,可广泛应用于语音识别、图像问答、视频分析等场景,兼顾高效推理与灵活定制,为开发者提供强大的多模态智能解决方案。

与传统单模态模型(如仅处理文本的LLM或仅处理图像的CV模型)不同,Qwen3-Omni通过“早期融合”的训练策略,将文本、图像、音频、视频的表征学习融入同一模型框架,实现了跨模态信息的深度交互。例如,它可以“听”一段包含语音和背景音的音频,同时“看”一张相关图片,再生成连贯的文本回答;也能直接将视频内容转换为带时间戳的字幕,并分析视频中的动作与声音的关联。

功能特色

Qwen3-Omni的核心优势体现在“全模态、高性能、低延迟、易扩展”四大维度,具体功能特色如下:

1. 跨模态能力行业领先

Qwen3-Omni在单模态与跨模态任务中均表现优异,尤其在音频和视频处理领域突破显著。根据官方测试数据,在36项音频/视频基准测试中,22项达到SOTA(State-of-the-Art,行业最优),32项达到开源领域SOTA。

| 任务类型 | 代表性测试集 | Qwen3-Omni表现 | 开源领域对比 |

|---|---|---|---|

| 图像数学推理 | MathVista_mini | 准确率77.4% | 领先同类开源模型10%以上 |

| 文档理解 | AI2D | 准确率84.7% | 超过开源模型平均水平15% |

| 音乐风格分析 | RUL-MuchoMusic | 得分52.1 | 开源领域最优 |

| 语音识别(中文) | AISHELL-1 | 词错误率(WER)3.2% | 接近商业级语音识别系统 |

| 视频场景分析 | ActivityNet | 时序定位准确率89.3% | 开源领域排名第一 |

其跨模态能力的核心在于“时序与空间信息的联合建模”:例如,在“视频+音频”任务中,模型能同时分析视频帧的视觉变化(如人物动作)和音频的时间序列(如对话内容),并关联两者的逻辑关系(如“人物挥手时伴随笑声”)。

2. 多语言支持覆盖广泛

Qwen3-Omni在语言支持上兼顾“广度”与“深度”,具体包括:

| 语言类型 | 支持数量 | 核心覆盖语言 | 特色能力 |

|---|---|---|---|

| 文本语言 | 119种 | 中、英、日、韩、德、法、阿拉伯语等 | 支持复杂语法与方言变体(如粤语书面语) |

| 语音输入语言 | 19种 | 中、英、日、韩、西、俄、葡萄牙语等 | 抗噪声能力强,支持远场语音识别 |

| 语音输出语言 | 10种 | 中、英、法、德、意、西、日语等 | 自然语调生成,支持语速调节 |

例如,它可将英语语音直接翻译为中文文本,或把日语图像中的文字(如广告牌)识别并转换为法语语音。

3. 创新架构实现高效推理

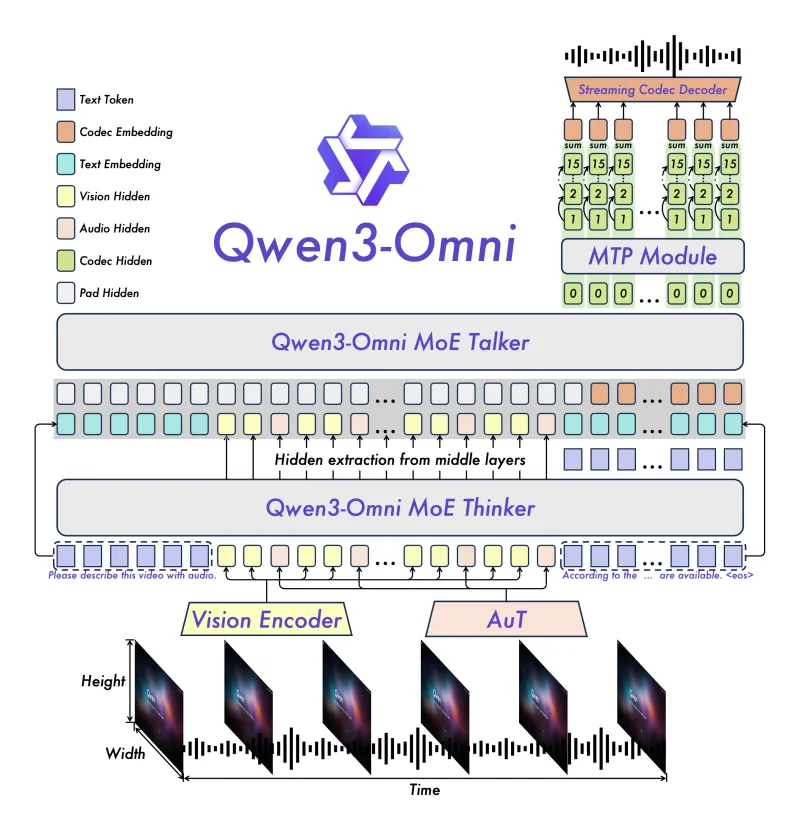

Qwen3-Omni采用“Thinker-Talker”双模块架构,结合MoE(混合专家模型)技术,在性能与效率间实现平衡:

Thinker模块:负责“理解与推理”,基于MoE结构处理多模态输入(文本/图像/音频/视频),通过动态选择8个专家层中的2个(30B模型配置),在保证精度的同时减少计算量。

Talker模块:负责“生成与输出”,采用多码本(Multi-codebook)设计,将语音生成的延迟降低30%以上,支持实时流式语音输出(如边听边生成回答)。

此外,模型引入“AuT预训练”策略(Audio-Visual-Text joint pre-training),通过大规模跨模态数据对齐,提升了不同模态间的表征一致性(如“图像中的‘猫’与语音中的‘猫叫声’被映射到相近的特征空间”)。

4. 实时交互与灵活可控

低延迟流式处理:支持文本与语音的流式输出,例如在语音对话中,模型可在用户说话间隙实时生成部分回答,减少等待时间(实测延迟<500ms)。

系统提示词定制:通过简单的提示词即可控制模型行为,例如指定“输出格式为JSON”“语音语调为正式播报”“忽略音频中的背景噪音”等。

多场景适配:提供Instruct(指令遵循)、Thinking(链式推理)、Captioner(字幕生成)等多个模型版本,分别优化不同任务场景。

5. 专用音频字幕模型填补空白

开源社区中,能生成“详细且低幻觉”音频字幕的模型较少。Qwen3-Omni专门推出了“Qwen3-Omni-30B-A3B-Captioner”模型,支持:

精准标注音频中的元素(如“00:01-00:05:钢琴声,节奏轻快;00:06-00:10:男子说话,内容‘请坐’”);

关联上下文(如识别“笑声”与前文“笑话”的因果关系);

处理混合音频(同时包含语音、音乐、环境音的复杂场景)。

技术细节

1. 模型架构设计

Qwen3-Omni的架构核心是“Thinker-Talker”双模块协同,具体如下:

| 模块 | 功能 | 技术细节 |

|---|---|---|

| Thinker | 多模态输入理解与推理 | 基于Transformer的MoE结构,30B模型包含8个专家层(每个专家层参数约3.75B),通过门控网络动态选择2个专家处理输入;支持文本token、图像patch、音频mel特征、视频frame的统一编码。 |

| Talker | 文本/语音输出生成 | 文本生成采用自回归解码;语音生成基于VQ-VAE的多码本设计,将语音波形压缩为离散码本,通过语言模型预测码本序列,再解码为语音,降低生成延迟。 |

2. 训练策略

数据规模:训练数据包含1.2万亿token的文本、20亿张图像、5000万小时音频、1000万小时视频,覆盖多语言、多场景。

训练阶段:

单模态预训练:分别对文本、图像、音频、视频进行基础表征学习;

跨模态对齐:通过对比学习(Contrastive Learning)将不同模态的特征映射到同一空间;

指令微调:使用1000万条多模态指令数据(如“描述图像并回答问题”“根据音频生成字幕”)优化模型的任务适应性。

3. 推理优化

量化支持:支持INT4/INT8量化,30B模型量化后可在单张RTX 4090(24GB显存)上运行。

推理框架适配:兼容Transformers、vLLM、TensorRT-LLM等主流框架,vLLM部署可支持每秒100+token的生成速度。

多模态输入处理:

图像:采用CLIP的ViT-L/14结构编码为576维特征;

音频:通过Mel频谱转换为128维特征,采用CNN+Transformer编码;

视频:抽帧(每2秒1帧)后按图像编码,同时保留时序信息。

应用场景

Qwen3-Omni的全模态能力使其可广泛应用于消费级与企业级场景,具体包括:

1. 音频相关任务

语音交互系统:支持多语言实时语音对话(如智能音箱、车载语音助手),可识别方言与噪声环境下的指令。

音频内容分析:对播客、会议录音进行自动转写、摘要生成及情感分析(如“识别会议中‘质疑’情绪的片段”)。

音乐理解:分析音乐风格、节奏、乐器类型,甚至生成符合特定风格的伴奏(如“基于用户哼唱生成爵士风格伴奏”)。

2. 视觉相关任务

智能图像问答:对复杂图像(如电路图、数学公式图)进行理解并回答问题(如“图中电阻的阻值是多少?”)。

OCR增强:识别模糊、倾斜或复杂背景中的文字(如手写体、艺术字),并支持多语言翻译(如将日语海报文字转为中文)。

目标检测与描述:识别图像中的物体、场景并生成详细描述(如“图中3人在室内聚餐,桌上有蛋糕,推测为生日场景”)。

3. 视频相关任务

视频内容分析:自动生成视频摘要、标记关键场景(如“体育比赛视频中标记进球瞬间”),并关联音频信息(如“进球时的欢呼声”)。

音视频同步字幕:为电影、网课生成多语言字幕,支持自动对齐语音与画面(如“人物说话时字幕同步显示”)。

视频导航指令:根据视频内容生成操作指导(如“家具安装视频中,生成‘下一步:安装右侧螺丝’的文字/语音指令”)。

4. 跨模态融合任务

多模态助手:同时处理用户的语音提问与图像输入(如用户说“这张图有什么问题?”并上传一张电路故障图,模型生成语音回答)。

无障碍辅助:为视障人士描述眼前场景(通过摄像头+语音输出),或为听障人士实时转换语音为文字(通过麦克风+屏幕显示)。

智能监控:结合视频画面与环境声音识别异常事件(如“画面中有人奔跑+玻璃破碎声,判定为紧急情况”)。

5. 开发者与科研场景

下游微调:基于Qwen3-Omni微调行业专用模型(如医疗领域的“医学影像+病历文本”分析模型)。

多模态研究:作为开源基准模型,支持研究者探索跨模态对齐、低延迟生成等技术方向。

使用方法

Qwen3-Omni提供多种使用方式,满足不同用户需求(从普通开发者到企业部署):

1. 模型下载

可通过Hugging Face、ModelScope等平台下载模型权重,以Hugging Face为例:

# 安装依赖 pip install transformers accelerate torch # 下载30B-Instruct模型(指令遵循版本) huggingface-cli download Qwen/Qwen3-Omni-30B-A3B-Instruct --local-dir ./Qwen3-Omni-30B-Instruct --local-dir-use-symlinks False

主要模型版本:

Qwen3-Omni-30B-A3B-Instruct:优化指令遵循,适合对话与任务调用;Qwen3-Omni-30B-A3B-Thinking:强化链式推理,适合复杂问题求解;Qwen3-Omni-30B-A3B-Captioner:专注音频字幕生成。

2. 基础使用示例(Python)

以下是使用Transformers库调用模型处理“图像+文本”输入的示例:

from transformers import AutoModelForCausalLM, AutoTokenizer

from PIL import Image

import torch

# 加载模型与分词器

model = AutoModelForCausalLM.from_pretrained(

"./Qwen3-Omni-30B-Instruct",

device_map="auto",

torch_dtype=torch.bfloat16

)

tokenizer = AutoTokenizer.from_pretrained("./Qwen3-Omni-30B-Instruct")

# 输入:图像+文本问题

image = Image.open("example.jpg") # 示例图像

prompt = "描述这张图,并回答:图中有几只动物?"

# 构建输入

inputs = tokenizer.apply_chat_template(

[{"role": "user", "content": [{"type": "text", "text": prompt}, {"type": "image", "image": image}]}],

tokenize=True,

return_tensors="pt"

).to(model.device)

# 生成回答

outputs = model.generate(inputs, max_new_tokens=512)

response = tokenizer.decode(outputs[0][len(inputs[0]):], skip_special_tokens=True)

print(response)3. 部署方式

本地部署:

轻量场景:使用Transformers库直接运行(需GPU支持,30B模型推荐24GB+显存);

高性能场景:通过vLLM部署,支持批量请求与流式输出:

python -m vllm.entrypoints.api_server --model ./Qwen3-Omni-30B-Instruct --port 8000 --tensor-parallel-size 1

API调用:通过阿里云DashScope平台调用(无需本地部署):

import dashscope dashscope.api_key = "your_api_key" response = dashscope.MultiModalConversation.call( model="qwen3-omni-30b", messages=[{"role": "user", "content": [{"type": "text", "text": "描述这张图"}, {"type": "image", "image": "image_url"}]}] ) print(response.output.choices[0].message.content)Web UI演示:仓库提供简易Web界面,启动后可通过浏览器交互:

cd cookbooks/web_demo python app.py --model_path ./Qwen3-Omni-30B-Instruct

常见问题解答(FAQ)

Qwen3-Omni需要什么硬件配置?

推理最低要求:30B模型需16GB+显存(INT8量化),推荐24GB+(如RTX 4090、A100);

训练/微调:需多卡GPU集群(如8×A100 80GB),建议结合DeepSpeed等分布式框架。

模型支持实时视频处理吗?

支持。通过抽帧处理(默认每2秒1帧)降低计算量,30B模型可处理1080P视频,延迟约1-2秒(取决于视频长度)。语音生成的质量如何?支持自定义音色吗?

语音生成自然度接近专业TTS系统,目前支持默认音色,未来将通过模型微调支持自定义音色。商业使用需要授权吗?

遵循Apache License 2.0,允许商业使用,但需保留原作者信息,且不得用于非法用途。与其他多模态模型(如GPT-4V、Gemini Pro)相比有何优势?

开源可商用,无API调用限制;

音频/视频处理能力更突出(如音乐分析、长视频时序建模);

支持更低延迟的流式语音输出。

如何解决模型“幻觉”(生成错误信息)问题?

可通过以下方式缓解:使用“Thinking”版本模型(强化逻辑推理);

在提示词中添加“若不确定,请勿猜测”;

结合外部知识库进行检索增强。

相关链接

GitHub仓库:https://github.com/QwenLM/Qwen3-Omni

技术报告:https://github.com/QwenLM/Qwen3-Omni/blob/main/assets/Qwen3_Omni.pdf

Hugging Face模型库:https://huggingface.co/Qwen

ModelScope模型库:https://modelscope.cn/organization/qwen

阿里云DashScope API文档:https://help.aliyun.com/zh/model-studio/qwen-omni

在线演示(Qwen Chat):https://qwen.chat/

总结

Qwen3-Omni作为开源全模态基础模型的代表,通过创新的“Thinker-Talker”架构与MoE技术,实现了文本、图像、音频、视频的端到端处理,在跨模态理解、多语言支持、实时交互等方面表现突出,尤其在音频/视频任务中达到行业领先水平。其开源特性与灵活的部署方式,为开发者提供了从原型验证到商业应用的全流程支持,覆盖消费级交互、企业级分析、科研探索等多个场景,是多模态智能领域极具实用价值的开源工具。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/qwen3-omni.html