Spark-TTS:开源的文本到语音合成(TTS)系统,支持高质量语音克隆与多语言合成

Spark-TTS 是什么

Spark-TTS 是一个基于大语言模型(LLM)架构的高效文本到语音(TTS)系统,由 SparkAudio 团队开发并开源。该项目最大的特点是不依赖额外的声码器,直接通过 LLM 预测语音的离散化表示(Speech Tokens),然后通过解码器生成音频波形。这种设计简化了 TTS 流程,同时实现了高质量、高自然度的语音合成效果。Spark-TTS 支持零样本语音克隆、跨语言合成、多风格语音生成等功能,适合在语音助手、有声读物、播客、教育、无障碍工具等多种场景中应用。

与传统 TTS 系统不同,Spark-TTS 无需复杂的声码器(Vocoder)和多阶段训练流程,大幅降低了工程复杂度。项目由 SparkAudio 团队在 2024 年发起,并于 2025 年开源。代码和预训练模型托管在 GitHub 和 Hugging Face,支持中英文双语,并且能够通过零样本方式克隆新的声音。

功能特色

| 功能 | 描述 | 优势 |

|---|---|---|

| 基于 LLM 的端到端架构 | 直接用大语言模型预测语音离散单元,无需声码器 | 结构简单、训练和推理速度快 |

| 零样本语音克隆 | 只需少量参考音频(甚至几秒)即可克隆说话人声音 | 无需大规模说话人数据,应用灵活 |

| 跨语言合成 | 支持中英双语及混合语码转换 | 适合多语言环境下的语音生成 |

| 多风格语音生成 | 可控制语速、音调、情感等参数 | 生成多样化、富有表现力的语音 |

| 离线与流式推理 | 支持本地部署及实时流式输出 | 满足实时交互和隐私保护需求 |

| 易于集成 | 提供 CLI、Python API 和 Web UI | 方便快速接入各类应用 |

技术细节

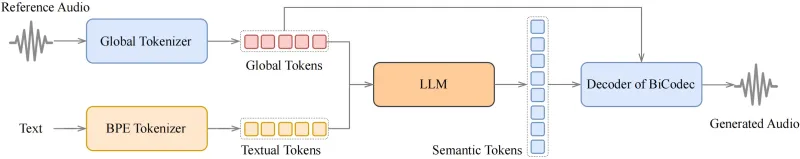

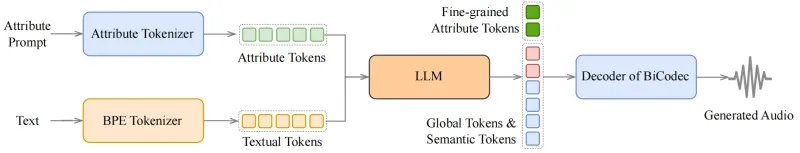

1. 模型架构

Spark-TTS 的架构主要包含以下几个部分:

文本编码器(Text Encoder)

将输入文本转换为语义向量表示

支持多语言分词(中英混合)

LLM 解码器(LLM Decoder)

核心组件,基于 Qwen2.5 架构

预测语音的离散化单元(Speech Tokens)

支持自回归生成,实现流畅的语音合成

声学生成器(Audio Generator)

将 Speech Tokens 转换为最终的音频波形

采用轻量级解码器,计算效率高

2. 语音离散化

Spark-TTS 使用**自编码器(Autoencoder)**将原始音频压缩为离散化的 Speech Tokens:

编码器将音频转换为潜伏表示

量化器将连续值转换为离散索引

解码器将离散索引重构为音频波形

这种方法的好处是:

降低数据维度,提高训练效率

使 LLM 可以直接预测语音单元

便于实现跨语言和零样本语音克隆

3. 训练流程

Spark-TTS 的训练分为两个主要阶段:

自编码器预训练

在大规模无标注音频数据集上训练

学习音频的高效表示方式

LLM 训练

在文本-语音配对数据集上训练 Qwen2.5 模型

学习从文本到 Speech Tokens 的映射关系

4. 推理流程

将输入文本编码为语义向量

LLM 基于语义向量预测 Speech Tokens

声学生成器将 Tokens 转换为音频波形

输出最终的音频文件

5. 技术原理图解说明

以下是 Spark-TTS 的工作流程(文字版流程图):

[输入文本] ↓ [文本编码器 (Text Encoder)] ↓ [语义向量 (Semantic Embedding)] ↓ [LLM 解码器 (Qwen2.5-based Decoder)] ↓ [语音离散单元 (Speech Tokens)] ↓ [声学生成器 (Audio Generator)] ↓ [最终音频波形 (Audio Waveform)]

步骤详解:

输入文本

用户提供的自然语言文本,例如:"欢迎使用 Spark-TTS 语音合成系统"

文本编码器

将文本转换为语义向量表示

支持多语言分词,处理中英文混合输入

LLM 解码器

核心创新点:使用 Qwen2.5 架构的大语言模型

预测音频的离散化单元(Speech Tokens)

支持自回归生成,确保语音流畅自然

语音离散单元

这些单元是通过自编码器从原始音频中学习的

每个单元代表音频的一个基本构建块

相比直接预测原始波形,预测这些单元大幅降低了计算复杂度

声学生成器

将离散单元转换为连续的音频波形

轻量级设计,计算效率高

支持流式输出,可用于实时应用

语音克隆工作流程

[参考音频] ↓ [特征提取 (Speaker Feature Extractor)] ↓ [说话人嵌入 (Speaker Embedding)] ↓ [与文本语义向量融合] ↓ [LLM 解码器 (带说话人信息)] ↓ [语音离散单元 (带说话人特征)] ↓ [声学生成器] ↓ [克隆后的音频]

应用场景

| 场景 | 应用示例 | Spark-TTS 优势 |

|---|---|---|

| 语音助手 | 智能音箱、手机语音助手 | 支持多风格语音,交互更自然 |

| 有声读物 | 电子书、小说的自动朗读 | 可模仿不同角色声音,提升体验 |

| 播客制作 | 自动生成播客内容 | 快速批量生产,支持多语言 |

| 教育领域 | 语言学习、课文朗读 | 可定制发音和语速,适合教学 |

| 无障碍工具 | 视觉障碍辅助系统 | 高质量语音,提升信息获取体验 |

| 内容创作 | 视频配音、广告制作 | 快速生成多风格配音,降低成本 |

使用方法

1. 环境准备

# 克隆仓库 git clone https://github.com/SparkAudio/Spark-TTS.git cd Spark-TTS # 创建并激活虚拟环境 conda create -n sparktts -y python=3.12 conda activate sparktts # 安装依赖 pip install -r requirements.txt

2. 模型下载

from huggingface_hub import snapshot_download

# 下载 0.5B 参数模型

snapshot_download("SparkAudio/Spark-TTS-0.5B", local_dir="pretrained_models/Spark-TTS-0.5B")3. 基本使用(CLI)

python -m cli.inference \ --text "你好,欢迎使用 Spark-TTS!" \ --device 0 \ --save_dir "./output" \ --model_dir "pretrained_models/Spark-TTS-0.5B"

4. 语音克隆

python -m cli.inference \ --text "这是克隆后的声音" \ --device 0 \ --save_dir "./output" \ --model_dir "pretrained_models/Spark-TTS-0.5B" \ --prompt_speech_path "./reference.wav"

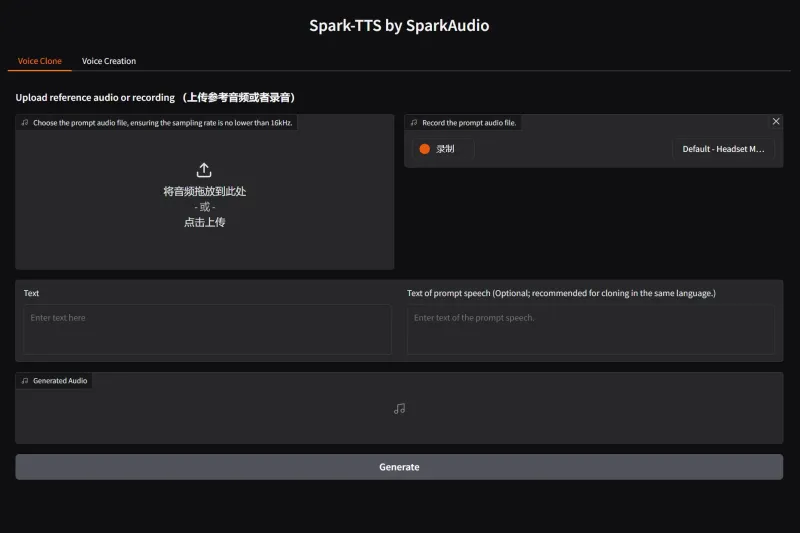

5. Web UI 使用

python webui.py --device 0

启动后,在浏览器访问 http://localhost:7860 即可使用图形界面进行语音合成和克隆。

实际效果对比

| 特性 | Spark-TTS | Tacotron 2 + WaveNet | Coqui TTS | Microsoft Azure TTS |

|---|---|---|---|---|

| 架构 | 基于 LLM,端到端 | 两阶段(Tacotron 2 + 声码器) | 多架构支持 | 混合架构 |

| 声码器需求 | 无 | 需要(WaveNet/Griffin-Lim) | 需要 | 需要 |

| 语音克隆 | 支持零样本 | 有限支持,需微调 | 支持,需训练 | 支持,需特定API |

| 多语言支持 | 中英双语 | 有限 | 多语言 | 多语言 |

| 实时推理 | 支持 | 较慢 | 部分模型支持 | 支持 |

| 开源程度 | 完全开源 | 部分开源 | 完全开源 | 闭源 |

| 模型大小 | 0.5B-7B参数 | 较小(约200M参数) | 多样 | 未知 |

| 音质 | 高 | 高 | 中-高 | 高 |

| 延迟 | 低 | 高 | 中 | 低 |

| 硬件需求 | GPU推荐(≥6GB) | GPU推荐 | GPU可选 | 云端服务 |

对比分析:

架构优势:Spark-TTS 采用单阶段 LLM 架构,简化了系统复杂度,而其他方案通常需要声码器

语音克隆:Spark-TTS 的零样本克隆能力是其最大优势之一,无需大量训练数据

实时性:相比 Tacotron 2 等传统方案,Spark-TTS 在延迟方面表现更优

开源自由度:与 Azure TTS 等商业服务相比,Spark-TTS 提供完全的开源代码和模型

实际应用示例

1. 语音助手应用

# 伪代码示例

from spark_tts import SparkTTS

# 初始化模型

tts = SparkTTS(model_dir="pretrained_models/Spark-TTS-0.5B", device="cuda")

# 设置说话人声音

tts.set_speaker(prompt_speech_path="assistant_voice.wav")

# 生成回复语音

audio = tts.generate("您好,我是您的智能助手,有什么可以帮助您的吗?")

# 播放或保存音频

audio.save("response.wav")2. 有声读物生成

# 伪代码示例

from spark_tts import SparkTTS

import textwrap

tts = SparkTTS(model_dir="pretrained_models/Spark-TTS-0.5B", device="cuda")

# 加载电子书文本

with open("book.txt", "r", encoding="utf-8") as f:

text = f.read()

# 分章节生成音频

chapters = textwrap.split(text, 500) # 每500字一章

for i, chapter in enumerate(chapters):

audio = tts.generate(chapter)

audio.save(f"chapter_{i+1}.wav")

性能优化建议

模型量化:使用 INT8 或 FP16 量化可显著减少显存占用

批处理:批量处理多个文本可提高吞吐量

模型蒸馏:可以将大模型蒸馏为更小的模型,适合移动端部署

推理优化:使用 TensorRT 或 ONNX Runtime 加速推理

缓存机制:缓存重复文本的合成结果,避免重复计算

常见问题解答(FAQ)

Q1: Spark-TTS 与其他 TTS 系统有什么区别?

A1: Spark-TTS 最大的区别是使用 LLM 直接预测语音单元,无需传统声码器,简化了系统结构并提高了效率。

Q2: 需要什么硬件配置才能运行?

A2: 推荐使用 NVIDIA GPU(至少 6GB VRAM),CPU 也可运行但速度较慢。

Q3: 支持哪些语言?

A3: 官方模型主要支持中文和英文,但架构支持多语言扩展。

Q4: 语音克隆需要多少参考音频?

A4: 通常 3-10 秒的清晰音频即可获得不错的克隆效果。

Q5: 是否支持实时流式输出?

A5: 是的,Spark-TTS 支持流式推理,可用于实时对话系统。

Q6: 模型可以微调吗?

A6: 可以,项目提供了微调脚本,可在特定数据集上进一步优化模型。

Q7: 为什么生成的音频有杂音?

A7: 可能原因包括:输入文本过长、采样率设置不正确、GPU内存不足。尝试缩短文本长度、调整采样率或使用更小的模型。

Q8: 语音克隆效果不佳怎么办?

A8: 确保参考音频质量高、无背景噪音,且包含足够的语音变化(不同音高、语速)。

Q9: 如何提高生成速度?

A9: 可以尝试使用更小的模型、启用FP16量化、使用更强大的GPU,或优化批量大小。

相关链接

GitHub 仓库: https://github.com/SparkAudio/Spark-TTS

Hugging Face 模型页面: https://huggingface.co/SparkAudio/Spark-TTS-0.5B

总结

Spark-TTS 是一个基于大语言模型的创新型文本到语音合成系统,通过直接预测语音离散单元的方式,实现了高效、高质量的语音合成。其独特的架构设计不仅简化了传统 TTS 系统的复杂性,还带来了零样本语音克隆、跨语言合成等强大功能。无论是在语音助手、教育、内容创作还是无障碍领域,Spark-TTS 都展现出巨大的应用潜力。作为开源项目,它为研究人员和开发者提供了一个优秀的平台,有助于推动语音合成技术的进一步发展和应用。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/spark-tts.html