StableAvatar:音频驱动的无限长度虚拟人视频生成框架

什么是StableAvatar

StableAvatar是由来自华东师范大学、腾讯AI Lab等机构的研究人员开发的一个基于扩散模型的音频驱动无限长度虚拟人视频生成框架,能够基于参考图像和音频,合成具有身份一致性、自然音频同步的长视频,无需依赖人脸交换或修复等后处理工具,该项目旨在解决现有音频驱动视频生成技术中存在的几个关键挑战:

长视频生成中的身份漂移问题

音频与视频的精确同步

生成高质量视频时的计算效率

StableAvatar通过创新的时间步感知音频适配器和音频原生引导机制,实现了从参考图像和音频输入中生成无限长度、身份一致且音频同步的虚拟人视频。

功能特色

StableAvatar具有以下核心功能和特色:

1. 无限长度视频生成

突破传统扩散模型的视频长度限制

支持生成任意时长的虚拟人视频

通过滑动窗口策略保持视频的时序一致性

2. 身份一致性

精确保持参考图像中的人物特征

避免长视频生成中的身份漂移问题

支持多种人物风格和表情变化

3. 音频同步

精准的口型同步与表情变化

支持多种音频类型(演讲、歌唱、对话等)

音频特征直接影响视频生成过程

4. 高保真质量

生成视频质量高,细节丰富

无需额外的人脸修复或增强工具

支持多种分辨率输出(480x832、832x480、512x512等)

5. 灵活性与扩展性

支持LoRA微调,适应特定人物或风格

模块化设计,易于扩展新功能

提供完整的训练和推理代码

技术细节

StableAvatar的技术核心主要包括以下几个创新点:

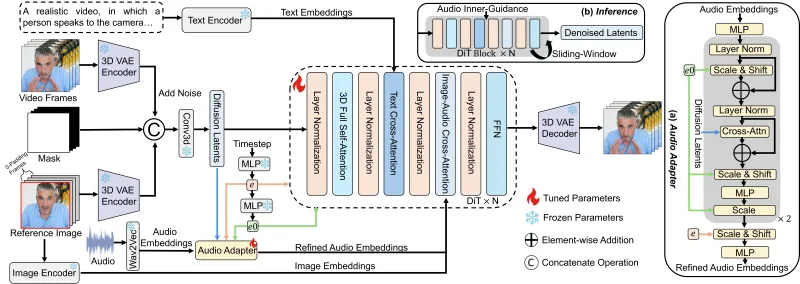

1. 时间步感知音频适配器(Time-step-aware Audio Adapter)

这是StableAvatar的核心创新之一,通过时间步感知调制防止音频潜在分布误差累积。传统方法通常将音频特征一次性注入到视频生成过程中,而StableAvatar的适配器能够根据扩散过程的不同时间步动态调整音频特征的影响。

2. 音频原生引导机制(Audio Native Guidance Mechanism)

该机制利用扩散过程中的联合音频-潜在预测增强音频同步性。它不仅在生成过程中考虑视觉信息,还直接将音频信息作为引导信号,确保生成的视频与音频内容高度匹配。

3. 动态加权滑动窗口策略(Dynamic Weighted Sliding-window Strategy)

这一策略用于融合时序潜在特征,提升长视频流畅度。通过动态调整窗口权重,StableAvatar能够在保持身份一致性的同时,处理长时间序列的视频生成。

4. 技术架构

StableAvatar的整体架构包括:

音频特征提取模块:使用Wav2Vec2等模型提取音频特征

时间步感知适配器:将音频特征与扩散模型的时间步信息结合

扩散模型主体:基于Stable Diffusion架构,进行视频帧生成

时序一致性模块:确保生成视频的流畅过渡

身份保持机制:维护参考图像中的人物特征

5. 训练策略

StableAvatar采用分阶段训练策略:

预训练阶段:在大规模视频-音频数据集上训练基础模型

微调阶段:使用特定领域数据进行微调,提升特定场景表现

LoRA适配:支持低资源场景下的快速适配

应用场景

StableAvatar的应用范围广泛,包括但不限于:

1. 虚拟主播与数字人

自动生成虚拟主播的播报视频

为数字人角色创建实时互动内容

支持多语言虚拟主播

2. 教育与培训

生成教学视频中的虚拟讲师

创建交互式学习助手

为在线课程生成多语言版本

3. 娱乐与内容创作

为游戏角色创建语音驱动的动画

生成虚拟偶像的表演视频

支持个性化虚拟形象定制

4. 企业应用

自动生成企业宣传视频中的虚拟代言人

创建客户服务虚拟助手

为产品演示生成虚拟讲解员

5. 无障碍服务

为视障人士提供视频描述服务

为听障人士生成唇读视频

支持多语言字幕与虚拟人同步

使用方法

1. 环境配置

StableAvatar需要以下环境依赖:

Python 3.8+

PyTorch 2.6.0+

CUDA 11.7+(推荐)

其他依赖:diffusers、transformers、accelerate等

可以通过以下命令安装依赖:

pip install -r requirements.txt

2. 模型下载

预训练模型可以从Hugging Face下载:

git lfs install git clone https://huggingface.co/FrancisRing/StableAvatar

3. 推理示例

使用以下命令生成视频:

python inference.py \ --checkpoint_path checkpoints/stableavatar_1.3b_basic \ --reference_image examples/reference.jpg \ --audio_path examples/input.wav \ --output_path outputs/result.mp4 \ --resolution 512x512 \ --duration 10

4. 训练示例

使用以下命令进行模型训练:

bash train_1B_rec_vec.sh

训练配置可以在configs/目录下修改。

5. LoRA微调

对于特定人物或风格的适配,可以使用LoRA微调:

bash train_lora.sh

常见问题解答

1. 对硬件有什么要求?

训练阶段需要约50GB显存,推荐使用多节点GPU配置(如8节点×8×NVIDIA A100 80GB)。推理阶段显存需求较低,可以在单张RTX 3090或A100上运行。

2. 支持哪些输入格式?

参考图像:JPEG、PNG等常见图片格式

音频:WAV、MP3等常见音频格式

3. 生成视频的分辨率和帧率有什么限制?

目前支持480x832、832x480、512x512等分辨率,帧率默认为24fps。可以通过修改配置文件调整。

4. 如何提高生成视频的质量?

使用更高质量的参考图像

提供清晰的音频输入

调整生成参数(如guidance scale)

考虑使用LoRA微调适配特定人物

5. 是否支持多语言?

是的,StableAvatar支持多种语言的音频输入,但效果可能因语言特性而有所不同。

6. 如何处理长音频?

StableAvatar通过滑动窗口策略自然支持长音频输入,无需手动分割。

相关链接

Hugging Face模型库:https://huggingface.co/FrancisRing/StableAvatar

Hugging Face演示空间:https://huggingface.co/spaces/YinmingHuang/StableAvatar

总结

StableAvatar是一个创新的音频驱动虚拟人视频生成框架,通过时间步感知音频适配器、音频原生引导机制和动态加权滑动窗口策略,有效解决了长视频生成中的身份漂移和音频同步问题。该项目不仅提供了高质量的视频生成能力,还具有良好的扩展性和灵活性,支持LoRA微调和多种应用场景。无论是用于虚拟主播、教育培训、娱乐内容创作还是企业应用,StableAvatar都展现出了强大的潜力。随着技术的不断发展,我们期待看到更多基于StableAvatar的创新应用和改进。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/stableavatar.html