UltraEval-Audio:全球首个开源音频大模型全维度评测框架

一、UltraEval-Audio是什么

UltraEval-Audio是面向音频大模型的全维度开源评测框架,也是全球首个专为音频大模型设计的标准化评测解决方案。区别于通用型AI评测工具,该框架深度聚焦音频领域的特殊性,同时覆盖语音理解(如ASR语音识别、AST音频语义理解、EMO情感分析)和语音生成(如TTS语音合成、Audio Codec音频编解码)两大类核心任务,为音频基础模型的研发、优化、对比提供全面、可落地、高易用性的评估体系。

该框架的核心目标是解决音频大模型评测领域的三大痛点:一是评测标准不统一,不同数据集、指标、模型的评测流程难以对齐;二是易用性低,数据集下载预处理、模型依赖配置、指标计算需手动完成,效率低下;三是覆盖范围有限,多数工具仅支持单一音频任务(如仅TTS或仅ASR),无法满足全维度评估需求。基于此,UltraEval-Audio聚合34个权威基准数据集,适配10种语言、12类音频任务,绑定官方标准评测指标,形成“数据-模型-指标-流程”全闭环的评测体系,让开发者无需从零搭建评测链路,即可完成音频大模型的标准化评估。

二、功能特色

UltraEval-Audio的核心优势体现在“全维度覆盖、高易用性、强灵活性、可复现性”四大维度,具体功能特色如下:

1. 全维度的评测覆盖能力

(1)数据集与任务覆盖

框架聚合34个权威音频基准数据集,覆盖语音、声音、医疗、音乐四大领域,支持12类核心音频任务,适配10种语言,基本覆盖音频大模型的主流应用场景。核心任务与对应典型数据集、评测指标如下表所示:

| 任务类型 | 英文缩写 | 典型数据集 | 核心评测指标 | 适用场景 |

|---|---|---|---|---|

| 自动语音识别 | ASR | Librispeech、TED-LIUM | WER、CER(越低越好) | 语音转文字、实时字幕 |

| 语音合成 | TTS | Seed-TTS-Eval、Long-TTS-Eval | UTMOS、DNSMOS(越高越好) | 智能语音助手、有声书生成 |

| 音频语义理解 | AST | AudioSet、Clotho | ACC、BLEU(越高越好) | 音频内容分类、语义检索 |

| 音频情感分析 | EMO | IEMOCAP、RAVDESS | F1、ACC(越高越好) | 语音情绪识别、客服语音分析 |

| 音频编解码 | Audio Codec | VCTK、LibriTTS | PESQ、STOI(越高越好) | 音频压缩、音质优化 |

(2)指标体系完善

框架内置音频领域全品类标准化评测指标,无需开发者手动集成:

语音理解类指标:WER(词错误率)、CER(字符错误率)、BLEU(机器翻译评估指标,适配音频语义生成)、ACC(准确率)、F1(调和平均率);

语音生成类指标:UTMOS(语音合成质量评分)、DNSMOS P.835/P.808(声学质量评分,0-5分)、PESQ(语音质量感知评估)、STOI(短时客观可懂度);

多语言适配:针对中文ASR任务优化了tractor结果提取、中英文文本归一化器,确保不同语言的指标计算准确性。

2. 开箱即用的高易用性

(1)一键式数据与模型管理

数据集:自动完成Librispeech、TED-LIUM等主流数据集的下载、解压、预处理,无需手动处理数据格式、标签对齐等问题;

模型:提供CosyVoice2/3、GLM-TTS、IndexTTS2、VoxCPM、Qwen3-Omni、Kimi-Audio等主流音频模型的一键复现命令,内置模型推理逻辑,无需编写基础推理代码。

(2)标准化流程与低门槛操作

框架将“数据加载→模型推理→结果后处理→指标计算→报告生成”全流程标准化,开发者仅需通过简单的命令行参数即可启动评测,无需关注底层细节。例如,针对TTS模型的评测,仅需指定模型名称、数据集名称,即可自动完成全流程并输出UTMOS/DNSMOS评分。

3. 灵活高效的评测能力

(1)容错与高效运行机制

断点续跑:支持

--resume参数,评测过程中断后可从断点继续,避免重复计算;错误重试:自动捕获推理过程中的异常,对失败样本进行重试,降低评测失败率;

并行评测:通过

--workers参数配置并行进程数,利用多核资源加速评测;依赖加速:集成

uv工具加速模型依赖安装,解决传统pip安装慢的问题。

(2)隔离运行时环境

针对不同音频模型依赖冲突的行业痛点,框架引入隔离式推理机制:自动为每个模型创建独立的运行环境,安装专属依赖,通过IPC(进程间通信)与主评测进程交互,彻底解决多模型评测时的依赖冲突问题。

(3)定制化扩展能力

自定义数据集:支持快速接入私有数据集,仅需按照框架的配置规范编写数据集配置文件,即可适配自有数据的评测;

自定义指标:预留指标扩展接口,开发者可添加自研评测指标,适配特定场景的评估需求;

结果灵活输出:支持从推理文件直接启动评测(

--infer-file参数),也可输出标准化评测报告(含指标明细、模型对比),适配不同的分析需求。

4. 可复现的科研级评测能力

框架在replication/目录提供主流音频模型的详细复现文档,包括:

精准的评测命令:确保开发者可一键复现官方公布的评测结果;

结果对齐细节:标注模型推理的参数设置、数据采样规则、后处理逻辑,解释结果差异原因;

双维度排行榜:内置“音频理解排行榜”和“音频生成排行榜”,基于标准化评测结果展示不同模型的性能对比,为科研对比提供基准。

三、技术细节

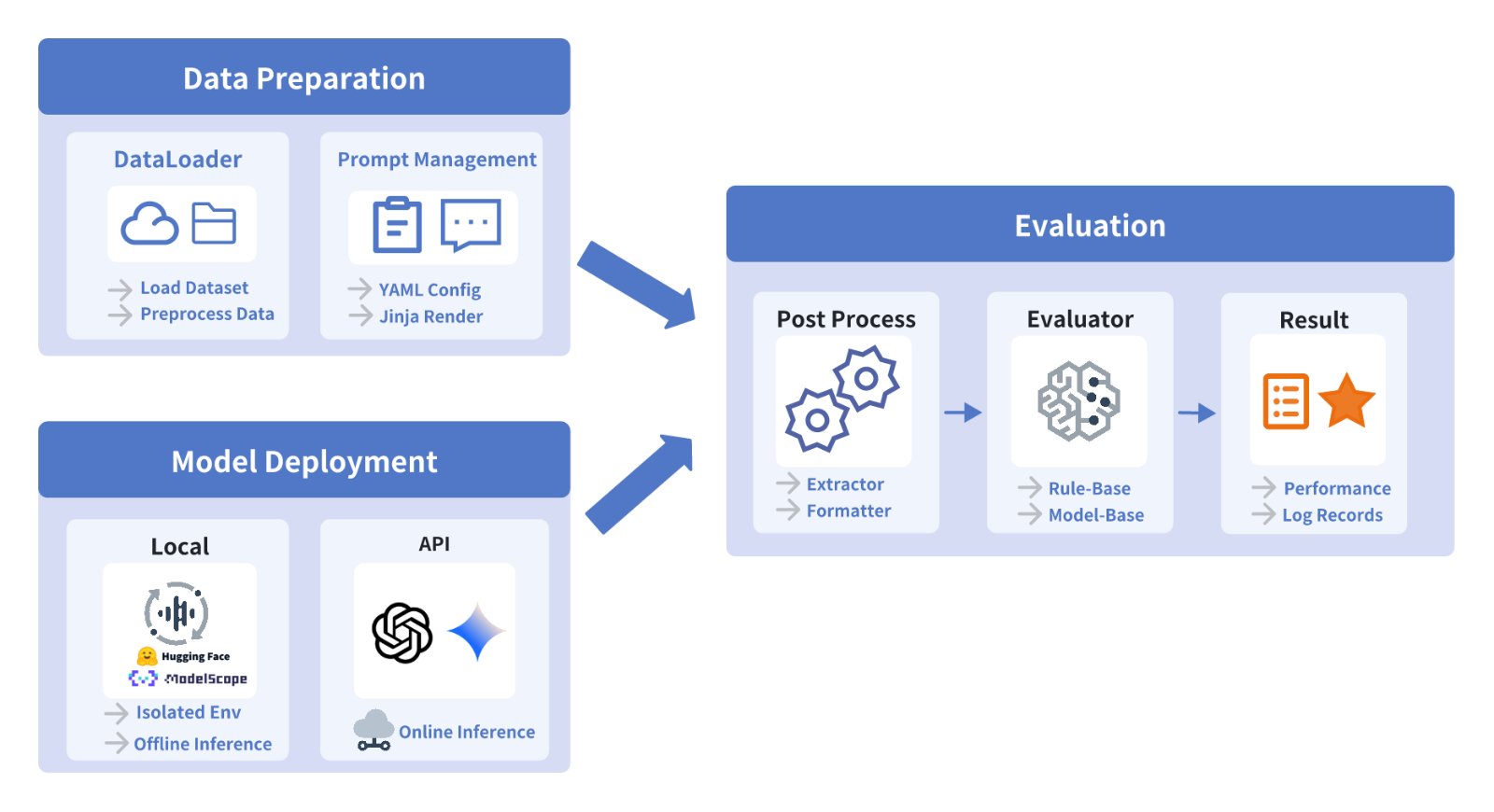

1. 核心架构

UltraEval-Audio采用“配置中心+核心逻辑+命令行工具”的三层架构,各层职责清晰,便于扩展与维护:

(1)配置中心(registry/目录)

作为框架的“大脑”,包含四类核心配置:

数据集配置(dataset):定义数据集的下载地址、数据格式、标签解析规则、采样方式;

模型配置(model):定义模型的加载路径、推理参数、依赖列表、隔离环境配置;

评测任务配置(eval_task):绑定数据集与评测指标,定义任务执行流程;

后处理配置(process):定义结果的归一化、错误过滤、指标计算规则(如中文ASR的文本归一化)。

(2)核心逻辑层(audio_evals/目录)

实现评测的核心功能:

模型推理模块:适配不同音频模型的推理接口,支持离线推理、API调用等多种方式;

数据处理模块:完成音频数据的加载、预处理(如采样率转换、时长裁剪)、标签对齐;

指标计算模块:实现WER、UTMOS、DNSMOS等指标的原生计算,或集成第三方指标工具包(如Kimi-Audio-Evalkit);

隔离运行时模块:管理独立的模型运行环境,处理进程间通信。

(3)命令行工具层(cli/目录)

提供简洁的命令行接口,将核心逻辑封装为易用的命令,例如:

数据集下载命令:

ultraeval-audio dataset download --name Librispeech;模型评测命令:

ultraeval-audio eval --model CosyVoice3 --dataset Seed-TTS-Eval --task TTS;断点续跑命令:

ultraeval-audio eval --resume --infer-file ./infer_result.json。

2. 关键技术点

(1)隔离运行时实现

框架通过Python的subprocess模块创建独立子进程,为每个模型安装专属依赖(基于uv工具),子进程负责模型推理,主进程负责任务调度和结果汇总,通过JSON格式的IPC消息完成通信,既解决了依赖冲突,又保证了进程间的数据安全。

(2)多语言文本归一化

针对不同语言的特性,框架内置文本归一化器:

中文:去除标点、统一数字格式(如“123”转为“一百二十三”)、纠正多音字标注;

英文:统一大小写、去除缩写标点(如“don't”转为“do not”);

其他语言:适配字符编码、去除特殊符号,确保ASR结果与参考文本的对齐准确性。

(3)音质指标计算优化

UTMOS和DNSMOS是TTS模型评测的核心指标,框架对其计算流程进行了优化:

批量处理音频文件,减少重复的特征提取操作;

缓存预计算的特征值,避免重复计算;

支持多线程计算,提升指标生成效率。

四、应用场景

UltraEval-Audio的设计兼顾科研场景和工程场景,核心应用场景包括:

1. 科研场景:音频大模型性能对比与优化

学术研究:研究人员可基于框架的标准化评测体系,对比不同音频模型在同一基准数据集上的性能,验证自研模型的改进效果,为论文发表提供可复现的评测结果;

基准对齐:通过框架的

replication/目录复现主流模型的评测结果,确保自研模型与行业基准的对比公平性;任务拓展:基于框架的扩展能力,新增自研数据集或评测指标,探索音频大模型在医疗、音乐等垂直领域的性能边界。

2. 工程场景:企业级音频模型研发与验收

模型迭代:企业研发团队可将框架集成到CI/CD流程中,在模型迭代过程中自动完成核心指标评测,快速定位模型性能下降的版本;

定制化评测:接入企业私有数据集(如客服语音、医疗音频),完成定制化场景的模型评估,满足业务专属需求;

供应商对比:对不同厂商的音频模型(如Qwen-Audio、Kimi-Audio)进行标准化评测,为采购选型提供数据支撑;

规模化评测:利用框架的并行评测、断点续跑能力,完成大规模数据集的评测,适配生产环境的模型验收需求。

3. 教育场景:音频AI教学与实践

高校教学:作为音频AI课程的实践工具,帮助学生理解音频大模型的评测流程、核心指标含义,通过实操掌握音频模型的评估方法;

竞赛支持:为音频AI相关竞赛提供标准化评测平台,确保竞赛评分的公平性和可复现性。

五、使用方法

1. 环境准备

(1)系统要求

操作系统:Linux(推荐Ubuntu 20.04+/CentOS 7+)、macOS 12+;

Python版本:3.8-3.11(兼容主流音频模型的依赖);

硬件要求:建议GPU显存≥16GB(TTS/ASR模型推理),CPU≥8核(并行评测)。

(2)安装框架

# 克隆仓库 git clone https://github.com/UltraEval/UltraEval-Audio.git cd UltraEval-Audio # 安装核心依赖(使用uv加速) pip install uv uv pip install -e .

2. 基础使用流程

以TTS模型CosyVoice3的评测为例,展示完整的使用流程:

(1)下载评测数据集

# 下载Seed-TTS-Eval数据集(TTS评测常用) ultraeval-audio dataset download --name Seed-TTS-Eval

框架会自动完成数据集的下载、解压、预处理,并存储到默认数据目录(可通过--data-dir指定自定义目录)。

(2)启动模型评测

# 评测CosyVoice3在Seed-TTS-Eval上的性能,输出UTMOS/DNSMOS指标 ultraeval-audio eval \ --model CosyVoice3 \ --dataset Seed-TTS-Eval \ --task TTS \ --workers 4 # 4进程并行评测

(3)查看评测结果

评测完成后,框架会在当前目录生成eval_report.json文件,包含:

模型基本信息(版本、推理参数);

数据集统计信息(样本数、语言、时长);

指标明细(UTMOS平均分、DNSMOS P.835/P.808分数);

错误样本列表(便于定位模型问题)。

3. 进阶使用

(1)断点续跑评测

若评测过程中断(如服务器重启),可通过以下命令续跑:

ultraeval-audio eval \ --model CosyVoice3 \ --dataset Seed-TTS-Eval \ --task TTS \ --resume \ --infer-file ./infer_result_half.json # 中断时生成的推理文件

(2)接入自定义数据集

在

registry/dataset/目录下创建自定义数据集配置文件(如my_tts_dataset.yaml),定义数据集路径、音频格式、参考文本字段等;执行评测命令,指定自定义数据集名称:

ultraeval-audio eval --model CosyVoice3 --dataset my_tts_dataset --task TTS

(3)仅计算指标(基于已有推理结果)

若已生成模型推理结果文件,可直接计算指标,无需重新推理:

ultraeval-audio eval \ --dataset Seed-TTS-Eval \ --task TTS \ --infer-file ./my_infer_result.json \ --only-calculate-metric # 仅计算指标

六、常见问题解答(FAQ)

Q1:评测过程中出现“依赖冲突”错误怎么办?

A:框架默认启用隔离运行时机制,可通过--isolated-runtime参数强制开启:

ultraeval-audio eval --model CosyVoice3 --dataset Seed-TTS-Eval --task TTS --isolated-runtime

该参数会为模型创建独立的虚拟环境,安装专属依赖,彻底解决依赖冲突问题。

Q2:中文ASR评测的WER分数偏高,可能是什么原因?

A:主要原因包括:

文本归一化未开启:框架默认开启中文文本归一化,若手动关闭,可通过

--enable-text-normalization参数重新开启;数据集标签格式不统一:检查参考文本是否包含特殊符号、多音字标注错误;

模型推理参数不当:调整ASR模型的推理参数(如beam size、解码策略),重新评测。

Q3:TTS评测的UTMOS指标计算缓慢,如何优化?

A:可通过以下方式加速:

增加并行进程数:

--workers 8(根据CPU核心数调整);启用特征缓存:

--cache-features(缓存音频特征,避免重复提取);采样评测:

--sample-ratio 0.5(仅评测50%的样本,快速获取近似分数)。

Q4:如何接入自研的音频模型?

A:步骤如下:

在

registry/model/目录下创建模型配置文件,定义模型加载函数、推理接口、依赖列表;在

audio_evals/models/目录下编写模型推理代码,实现infer方法;执行评测命令,指定自研模型名称即可。

Q5:评测结果与官方公布的分数不一致,怎么办?

A:首先检查以下几点:

数据集版本是否一致:确认使用的数据集与官方一致(如Librispeech的dev-clean版本);

评测参数是否对齐:参考

replication/目录下对应模型的复现文档,核对推理参数、采样规则;指标计算规则是否一致:框架默认使用官方标准计算规则,可通过

--metric-config参数指定自定义规则。

七、相关链接

八、总结

UltraEval-Audio作为全球首个开源的音频大模型专属评测框架,通过聚合34个权威基准数据集、适配12类音频任务和10种语言,构建了覆盖语音理解与生成的全维度评测体系,其开箱即用的一键式操作、隔离运行时的依赖冲突解决方案、断点续跑的高效评测机制,既满足了科研场景下音频模型性能对比的可复现性需求,也适配了工程场景下定制化、规模化的评测需求。该框架不仅内置WER、UTMOS等主流评测指标,还提供了CosyVoice、Qwen3-Omni等主流音频模型的一键复现能力,通过标准化的配置中心和灵活的扩展接口,降低了音频大模型评测的门槛,成为音频AI研发、优化、对比的核心工具。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/ultraeval-audio.html