VideoPipe:轻量级开源视频分析框架,一键搭建视频结构化与行为分析应用

一、VideoPipe是什么

VideoPipe是一款基于C++17开发的开源视频分析与结构化框架,核心定位是“轻量化、易集成、可移植”的视频分析流程整合工具,而非深度学习训练框架(如TensorFlow)或重型工业级视频分析平台(如NVIDIA DeepStream)。其核心目标是降低计算机视觉算法落地的门槛:开发者无需从零编写视频流读写、算法推理、数据输出的全流程代码,只需通过框架提供的“节点”组件自由组合,即可快速搭建从视频源输入到结构化数据输出的完整视频分析应用,覆盖目标检测、跟踪、行为分析等核心场景。该框架完全开源免费,学习曲线低,即使仅具备基础C++知识的开发者也能快速上手。

二、功能特色

为清晰体现VideoPipe的核心优势,我们将其与主流同类视频分析框架进行对比,具体如下:

表1:VideoPipe与主流视频分析框架核心特性对比

| 特性 | VideoPipe | NVIDIA DeepStream | 华为mxVision |

|---|---|---|---|

| 开源属性 | 完全开源免费 | 商业授权(部分开源) | 商业授权 |

| 学习曲线 | 低(C++基础即可上手) | 高(需掌握CUDA/TensorRT深度知识) | 高(绑定昇腾生态,适配成本高) |

| 硬件支持 | NVIDIA GPU、华为昇腾、瑞芯微RK3588、CPU | 仅NVIDIA GPU | 仅华为昇腾 |

| 依赖要求 | 仅C++17、OpenCV、GStreamer(基础) | CUDA、TensorRT、DeepStream SDK等 | 昇腾驱动、mxVision SDK等 |

| 架构设计 | 插件化节点,灵活组合 | 流水线式,耦合度较高 | 绑定昇腾架构,灵活性低 |

基于上述对比,VideoPipe的核心功能特色可总结为以下5点:

2.1 跨平台与多硬件兼容

框架原生支持x86_64(英特尔/AMD)、aarch64(ARM)架构的Ubuntu操作系统,可适配NVIDIA GPU(如RTX 3090/4090)、华为昇腾(Ascend 310/910)、瑞芯微RK3588等硬件,同时支持纯CPU推理(无GPU场景下的轻量化部署)。无需针对不同硬件重构代码,仅需在编译时开启对应硬件的编译选项即可完成适配。

2.2 低依赖与轻量化部署

基础运行仅需三个核心依赖:C++17编译环境、OpenCV(≥4.6)、GStreamer(1.14.5);可选依赖为CUDA、TensorRT、PaddleInference等加速库,开发者可根据部署环境选择是否集成。编译后的可执行文件体积小,无冗余组件,可在嵌入式设备(如RK3588开发板)上流畅运行,满足边缘端部署需求。

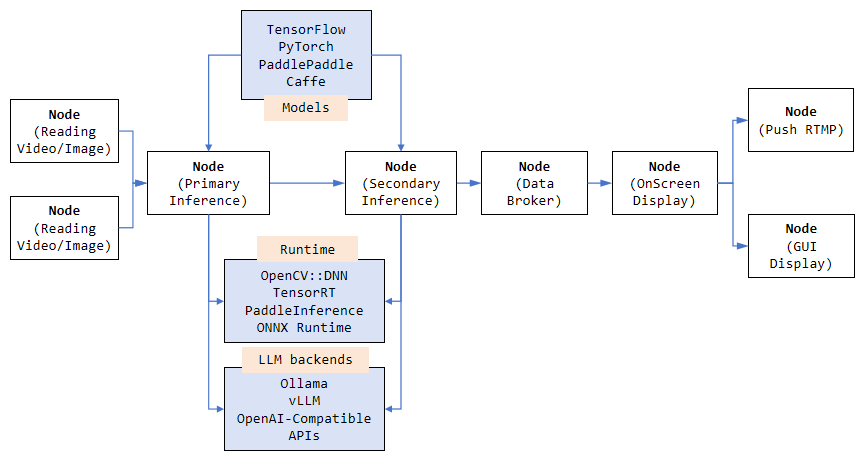

2.3 插件化节点设计,灵活组合

框架以“节点(Node)”为最小功能单元,所有功能均封装为独立节点,支持自由组合成任意长度的流水线。例如,仅需组合“RTSP源节点→YOLO检测节点→SORT跟踪节点→屏幕显示节点”,即可快速实现视频流的目标检测与跟踪可视化,无需关注底层编解码、推理接口等细节。

2.4 丰富的算法与功能集成

视频流处理:支持UDP、RTSP、RTMP等主流协议的视频流读写,本地视频/图片文件编解码(基于GStreamer硬件加速);

深度学习推理:兼容OpenCV::DNN、TensorRT、PaddleInference等推理后端,内置YOLO(目标检测)、Mask RCNN(实例分割)、SFace(人脸特征提取)等算法节点;

目标跟踪:集成IOU、SORT、DeepSORT等经典跟踪算法,支持多目标跨帧跟踪并生成唯一目标ID;

行为分析:基于跟踪结果实现跨线检测、停车检测、违规行为识别等;

数据输出:支持JSON/XML格式的结构化数据通过Kafka、Socket推送至云端,支持关键帧截图、违规片段录制;

可视化:实时叠加OSD(结构化数据标注),可自定义目标框、ID、行为状态等信息,支持屏幕显示、RTMP推流输出。

2.5 多模态大模型集成

新增mLLM(多模态大语言模型)集成能力,可将视频帧/关键帧输入大模型,实现自然语言化的视频内容分析。例如,通过mLLM节点可直接输出“画面中3名人员在工地未佩戴安全帽,1辆白色货车停在禁停区域”的自然语言描述,无需手动解析结构化数据。

三、技术细节

VideoPipe的核心技术架构围绕“节点流水线”展开,所有功能均通过节点的组合与调度实现,以下是核心技术细节:

3.1 节点体系(核心架构)

节点是VideoPipe的核心组成部分,不同类型的节点负责不同环节的处理,开发者可根据业务需求灵活组合。核心节点类型及说明如下:

表2:VideoPipe核心节点类型及功能说明

| 节点类型 | 代表节点名称 | 核心功能 |

|---|---|---|

| 源节点(Src) | vp_file_src_node、vp_rtsp_src_node | 读取本地视频/图片文件、RTSP/UDP/RTMP视频流,输出原始帧数据 |

| 推理节点(Infer) | vp_yolo_detector_node、vp_sface_feature_encoder_node | 执行目标检测、实例分割、人脸特征提取等算法推理,输出结构化的检测结果 |

| 跟踪节点(Track) | vp_sort_track_node、vp_dsort_track_node | 基于推理结果实现多目标跨帧跟踪,生成唯一目标ID,输出带ID的跟踪结果 |

| 目标节点(Des) | vp_screen_des_node、vp_file_des_node | 将处理后的帧数据显示到屏幕、保存为视频文件,或推送结构化数据至第三方平台 |

| 辅助节点 | vp_split_node、vp_sync_node | 拆分视频流(一分多)、同步多流数据(多合一),适配复杂业务流程 |

3.2 核心技术模块

视频编解码模块:基于OpenCV+GStreamer实现,支持NVIDIA NVDEC/NVENC、RK3588 Mpp等硬件加速编码/解码,可高效处理1080P/4K分辨率的视频流;

推理引擎适配模块:封装多类推理后端的统一接口,开发者无需修改业务代码,仅通过配置即可切换OpenCV::DNN(轻量化)、TensorRT(高性能)等推理引擎;

跟踪算法模块:抽象跟踪算法通用接口,内置IOU、SORT、DeepSORT等算法,同时支持开发者自定义跟踪算法集成;

数据序列化模块:支持JSON/XML等主流格式的结构化数据序列化,适配Kafka、Socket等数据推送方式,可直接对接第三方平台;

可视化模块:提供简洁的OSD叠加接口,支持自定义标注目标框、ID、行为状态等信息,兼顾实时显示与推流输出需求。

3.3 技术栈说明

开发语言:C++17(核心代码),少量Python(示例脚本/辅助工具);

核心依赖:OpenCV ≥4.6(图像处理)、GStreamer 1.14.5(视频流处理);

可选依赖:CUDA ≥11.0、TensorRT ≥8.0(NVIDIA GPU加速)、PaddleInference(飞桨推理)、华为昇腾驱动(昇腾适配)、RK3588 Mpp库(瑞芯微适配);

编译工具:CMake ≥3.16、GCC ≥9.0。

四、应用场景

VideoPipe的轻量化、易集成特性使其适配多类视频分析场景,核心应用场景如下:

4.1 安防监控领域

异常行为检测:组合“RTSP源节点+YOLO检测节点+SORT跟踪节点+行为分析节点”,可实现园区/小区/工地内人员翻越围墙、区域逗留、物品遗留、未佩戴安全帽等异常行为检测,检测到异常后自动录制视频片段,并通过Kafka推送告警信息至安保平台;

人脸识别布控:集成SFace人脸特征提取节点,将抓拍的人脸特征与黑名单库实时比对,实现重点人员布控,触发匹配后立即输出告警信息,适用于园区、车站等场景。

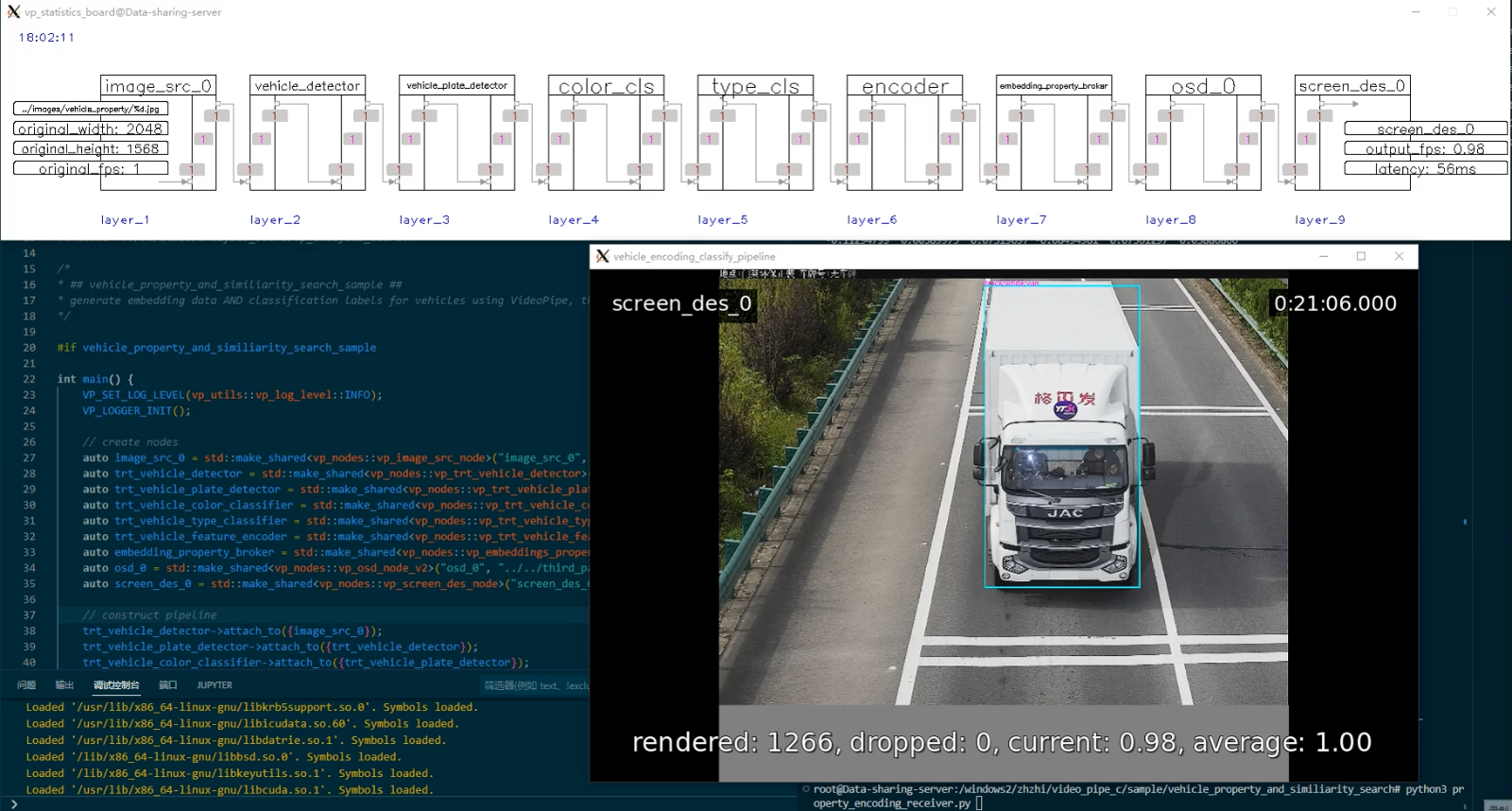

4.2 交通管理领域

交通违章检测:通过“RTSP源节点+车辆检测节点+DeepSORT跟踪节点+跨线分析节点”,实现路口闯红灯、逆行、违停、压线等违章行为检测,输出包含车牌、违章时间、地点、行为类型的结构化数据,可直接对接交通管理平台;

车流统计:基于跟踪节点的唯一目标ID,统计指定路段的车流量、车型分布(轿车/货车/客车)、平均车速等数据,为交通调度、道路规划提供数据支撑。

4.3 视频结构化与内容分析

视频内容标签化:结合mLLM节点,将视频帧转换为自然语言描述,生成“时间+画面内容+目标行为”的结构化标签(如“2025-08-12 14:00 园区入口 白色轿车驶入 驾驶员未系安全带”),大幅提升视频检索效率;

关键帧提取:针对海量监控视频,自动提取包含目标行为的关键帧(如人员翻越围墙、车辆违章的瞬间),减少人工回看视频的时间成本。

4.4 人脸识别与图像检索

人脸检索:将人脸特征提取节点输出的特征向量存入数据库,支持实时人脸抓拍与库内检索,适用于园区门禁、商场客流分析、考勤管理等场景;

图像相似检索:基于目标检测节点提取的物体特征(如车辆、物品),实现相似图像检索,可用于查找同款车辆、丢失物品溯源等场景。

五、使用方法

VideoPipe的使用流程分为“环境准备→代码编译→运行示例”三步,全程无需复杂配置,零基础也可快速上手(以Ubuntu 20.04系统为例):

5.1 环境准备

5.1.1 基础依赖安装

# 更新软件源 sudo apt update && sudo apt upgrade -y # 安装C++编译环境 sudo apt install -y gcc-9 g++-9 cmake make # 安装OpenCV(≥4.6) sudo apt install -y libopencv-dev libopencv-contrib-dev # 安装GStreamer sudo apt install -y libgstreamer1.0-dev libgstreamer-plugins-base1.0-dev gstreamer1.0-plugins-good gstreamer1.0-plugins-bad gstreamer1.0-plugins-ugly

5.1.2 可选依赖安装(以NVIDIA GPU为例)

若需启用GPU加速,需安装CUDA和TensorRT:

# 安装CUDA 11.8(需适配显卡驱动) wget https://developer.download.nvidia.com/compute/cuda/11.8.0/local_installers/cuda_11.8.0_520.61.05_linux.run sudo sh cuda_11.8.0_520.61.05_linux.run --silent --toolkit # 安装TensorRT 8.6 sudo apt install -y libnvinfer8 libnvinfer-dev libnvonnxparsers8 libnvonnxparsers-dev

5.2 代码编译

# 克隆仓库 git clone https://github.com/sherlockchou86/VideoPipe.git cd VideoPipe # 创建编译目录 mkdir build && cd build # 配置CMake(启用CUDA加速) cmake .. -DVP_WITH_CUDA=ON -DVP_WITH_TENSORRT=ON # 编译(-j后接CPU核心数,如8核则-j8) make -j8

编译完成后,可执行文件生成在build/bin目录,节点库文件生成在build/lib目录。

5.3 运行示例

VideoPipe提供40+现成示例,覆盖人脸跟踪、车辆违章检测、mLLM分析等场景,以“车辆跟踪示例”为例:

# 进入编译后的bin目录 cd build/bin # 运行车辆跟踪示例(替换为实际RTSP流/本地视频路径) ./vehicle_tracking_sample --video_path rtsp://admin:123456@192.168.1.100:554/stream1

示例运行后,会实时显示视频画面(叠加车辆检测框、目标ID、行驶状态),同时在终端输出JSON格式的结构化跟踪数据。

六、常见问题解答

Q1:编译时提示“OpenCV版本过低”怎么办?

A1:VideoPipe要求OpenCV≥4.6,若系统自带版本过低,可手动编译安装高版本:

# 下载OpenCV 4.8.0源码 git clone https://github.com/opencv/opencv.git -b 4.8.0 cd opencv && mkdir build && cd build cmake .. -DCMAKE_INSTALL_PREFIX=/usr/local make -j8 && sudo make install

安装完成后重新执行CMake配置即可。

Q2:运行RTSP流示例时卡顿严重怎么办?

A2:卡顿主要原因有二:① 网络带宽不足(建议使用有线网络);② 未启用硬件加速。可在编译时开启GStreamer硬件解码,或切换至TensorRT推理后端(GPU加速);同时建议根据硬件性能适配视频流分辨率(如RK3588建议处理1080P/30帧以内的流)。

Q3:如何自定义新增节点?

A3:VideoPipe节点采用插件化设计,新增节点仅需两步:① 继承框架的vp_node基类,实现process核心方法;② 在CMakeLists.txt中添加节点编译配置,编译后将生成的so库放入build/lib目录,即可在流水线中调用。具体可参考仓库nodes目录下的vp_yolo_detector_node代码。

Q4:支持Windows系统吗?

A4:目前核心代码仅适配Ubuntu系统(x86_64/aarch64),暂不支持原生Windows。可通过WSL2(Ubuntu子系统)部署,步骤与原生Ubuntu完全一致。

Q5:mLLM集成需要哪些依赖?

A5:mLLM示例需安装PaddlePaddle或LLaMA.cpp等大模型推理库,同时需准备LLaVA等多模态模型权重,具体依赖及配置可参考samples/mllm_analyse_sample目录下的README。

七、相关链接

八、总结

VideoPipe作为一款基于C++开发的轻量级开源视频分析与结构化框架,以插件化节点为核心架构,兼具跨平台、多硬件兼容、低依赖、易集成的特性,既适配NVIDIA GPU、华为昇腾等高性能硬件,也支持瑞芯微RK3588等嵌入式设备,内置目标检测、跟踪、行为分析、mLLM集成等丰富功能,开发者无需深入掌握底层编解码或推理引擎知识,即可快速搭建安防监控、交通管理、人脸识别等各类视频分析应用,其完全开源免费的属性与低学习曲线,为中小开发者及企业降低了计算机视觉算法落地的门槛,是视频分析领域兼具实用性与灵活性的优秀开源工具。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/videopipe.html