GPT4All(本地AI大模型部署及运行工具)

- 软件版本:3.10.0

- 软件类型:智能助手

- 软件语言:简体中文

- 运行环境:Windows,MacOS,Linux

- 软件大小:710 MB

- 发布时间:

GPT4All是什么

GPT4All是一款专为个人用户设计的开源本地AI大语言模型部署及运行工具,允许用户在普通台式机或笔记本电脑上私密、安全地运行先进的AI语言模型。它无需依赖云服务、API调用或昂贵的GPU硬件,真正实现“AI平民化”——让每个人都能在自己的设备上免费使用强大的AI对话能力。

该软件由 Nomic 团队开发,并依托于 llama.cpp 等高效推理引擎,支持多种主流模型架构和量化格式(如 GGUF),同时提供图形界面与 Python 编程接口,适用于从普通用户到开发者在内的广泛人群。

1. 核心技术基础

基于 llama.cpp 实现 CPU 高效推理

支持 GGUF 格式的量化模型(Q4_0、Q4_1等)

使用 Nomic 自研蒸馏技术 训练出高质量的小型化模型

可通过 Vulkan 加速在 NVIDIA/AMD GPU 上运行(Nomic Vulkan)

2. 平台兼容性

| 操作系统 | 安装方式 | 处理器要求 |

|---|---|---|

| Windows x86_64 | 官方安装包 | Intel Core i3 第二代 / AMD Bulldozer 或更高 |

| Windows ARM | ARM 安装包 | 高通 Snapdragon / Microsoft SQ1/SQ2 |

| macOS | dmg 安装包 | macOS Monterey 12.6+,推荐 Apple Silicon M系列芯片 |

| Linux (Ubuntu) | deb 安装包 | x86_64 架构,不支持 ARM |

| Linux 其他发行版 | Flathub(社区维护) | x86_64 |

⚠️ 注意:Linux 版本目前仅支持 x86_64,暂无原生 ARM 支持。

软件功能

| 功能模块 | 描述 |

|---|---|

| 🧠 本地大模型运行 | 在本地加载并运行完整的 LLM(如 Meta-Llama-3-8B-Instruct),无需联网 |

| 💬 智能对话交互 | 提供类 ChatGPT 的聊天体验,支持多轮对话上下文管理 |

| 📂 LocalDocs 本地文档问答 | 用户可上传 PDF、TXT、DOCX 等文件,在本地进行知识库检索与问答 |

| 🔌 API 服务支持 | 支持 Docker 部署 OpenAI 兼容 HTTP 接口,便于集成第三方应用 |

| 🐍 Python SDK 调用 | 提供 gpt4all Python 包,可在代码中直接调用模型 |

| 🤖 多模型支持 | 内置模型画廊,支持 Mistral、Llama3、CodeLlama、Rift Coder 等多种架构 |

| 🎮 GPU 加速推理 | 通过 Nomic Vulkan 实现对 NVIDIA 和 AMD 显卡的本地加速支持 |

软件特色

完全离线运行

所有计算均在本地完成,不上传任何数据,保障用户隐私与信息安全。

零成本使用

无需订阅费用、无需 API 密钥、无需高性能显卡,普通电脑即可流畅运行。

开箱即用

提供一键安装程序,下载后即可启动使用,新手友好。

开放生态支持

支持 LangChain、Weaviate 向量数据库集成

兼容 OpenLIT 进行可观测性监控

社区活跃,支持贡献代码与文档

持续更新迭代

项目保持高频更新,已发布多个重要版本:

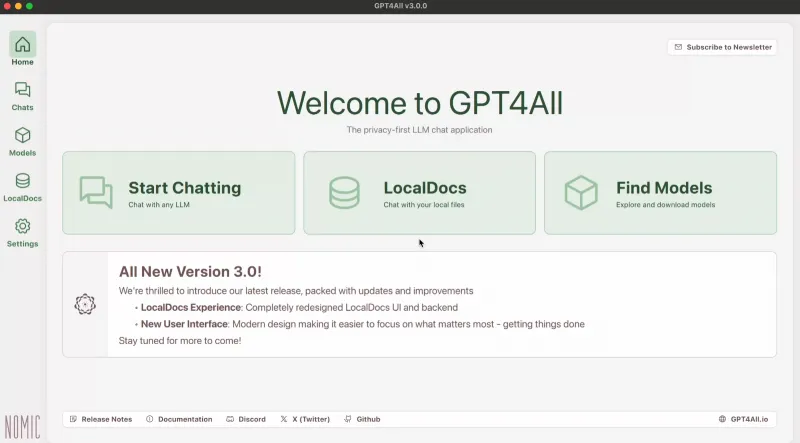

2024年7月 V3.0.0:全新UI设计、优化LocalDocs流程、扩展模型架构支持

2023年10月:全面支持 GGUF 模型格式,新增 Rift Coder 编程模型

2023年9月:推出 Nomic Vulkan,支持 GPU 加速推理

2023年6月:上线 Docker API 服务器,兼容 OpenAI 接口

使用方法

方法一:图形界面使用(适合普通用户)

下载安装

访问AI铺子

根据操作系统选择对应安装包(Windows/macOS/Ubuntu)

安装完成后启动应用程序

首次运行配置

软件将自动提示下载默认模型(如 Meta-Llama-3-8B-Instruct.Q4_0.gguf,约 4.66GB)

下载完成后进入主界面开始对话

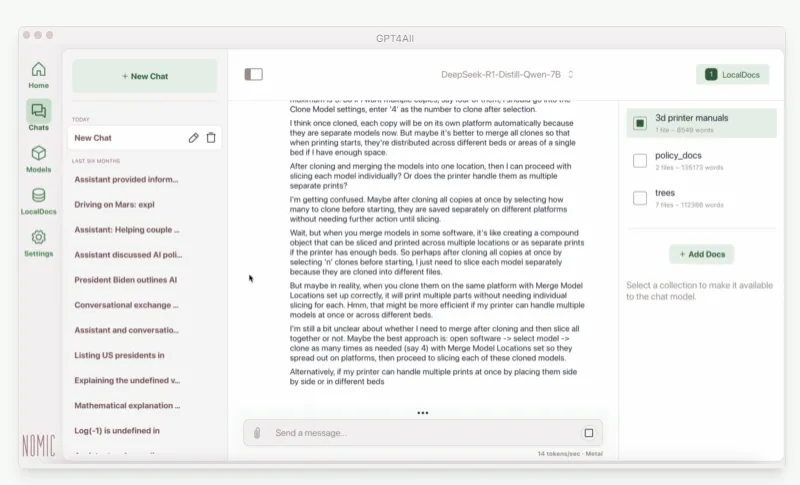

使用 LocalDocs 功能

点击左侧菜单 “LocalDocs”

添加本地文档(PDF/TXT/DOCX 等)

开启“启用文档搜索”后,提问将结合文档内容回答

方法二:Python 编程调用(适合开发者)

from gpt4all import GPT4All

# 自动下载并加载模型

model = GPT4All("Meta-Llama-3-8B-Instruct.Q4_0.gguf")

# 开启聊天会话

with model.chat_session():

response = model.generate("如何在我的笔记本上高效运行大模型?", max_tokens=1024)

print(response)📌 安装 Python 包:

pip install gpt4all

方法三:部署为本地 API 服务(高级用途)

使用 Docker 启动 OpenAI 兼容接口:

docker run -d -p 4891:4891 nomic/gpt4all

然后可通过 http://localhost:4891/v1/chat/completions 发送请求,与 OpenAI SDK 完全兼容。

收费价格

💰 GPT4All 完全免费!

所有软件、模型、工具链均为 开源免费

不收取任何订阅费、使用费或授权费

所有模型均可自由下载和再分发(遵循相应许可证)

✅ 零成本 + 零依赖 + 零追踪 = 真正属于用户的 AI 工具

常见问题解答(FAQ)

Q1:需要独立显卡才能运行吗?

❌ 不需要。GPT4All 主要基于 CPU 推理,即使没有 GPU 也能正常运行。但若拥有 NVIDIA 或 AMD 显卡,可通过 Nomic Vulkan 启用 GPU 加速提升性能。

Q2:模型文件有多大?需要多少内存?

典型模型大小约为 4~8GB(如 Llama-3 8B 量化版)。建议设备至少具备 16GB RAM,以确保流畅运行。

Q3:能否连接互联网获取实时信息?

🚫 默认情况下完全离线,无法访问网络。如需实时信息,需手动导入相关资料至 LocalDocs。

Q4:支持中文吗?

✅ 支持一定程度的中文理解和生成,但由于主要训练语料为英文,中文表达能力有限。建议搭配专门优化的中文模型使用效果更佳。

Q5:是否可以更换其他模型?

✅ 可以!GPT4All 支持自定义模型加载,用户可以从官方模型库或第三方渠道下载 .gguf 格式模型放入 models/ 目录后切换使用。

总结

GPT4All 是当前最成熟、最易用的本地大语言模型解决方案之一。它打破了传统 AI 对云端服务和高端硬件的依赖,赋予每个普通用户掌控 AI 的能力。无论是希望保护隐私的企业用户、追求低成本实验的研究者,还是想学习 AI 开发的学生,GPT4All 都是一个理想的选择。

软件截图

GPT4All下载地址

版权与来源声明:AI铺子提供的GPT4All电脑客户端/APP,均转载自官方下载网站或经授权的可信分发渠道。相关软件的所有权、版权及知识产权均归原作者所有。本站不对任何软件进行二次修改或附加捆绑,确保文件的原始性与完整性。我们强烈建议用户支持正版软件,并通过官方渠道获取GPT4All最新版本和专业技术支持。