LocalAI(AI本地化推理与多模态生成工具)

- 软件版本:3.6.0

- 软件类型:综合其它

- 软件语言:简体中文

- 运行环境:Windows,MacOS,Linux

- 软件大小:63 MB

- 发布时间:

LocalAI是什么

LocalAI 是一款开源免费的本地AI推理工具,旨在为用户提供与OpenAI(及ElevenLabs、Anthropic等)API规范兼容的本地REST API服务。它允许用户在个人设备或企业私有环境中运行大语言模型(LLMs)、生成图像、处理音频等,无需依赖云端服务,甚至可在消费级硬件(包括无GPU的设备)上部署,核心目标是平衡AI能力与数据隐私,让本地AI应用更易用、更灵活。

LocalAI 由开发者 Ettore Di Giacinto 主导开发,属于“Local Stack Family”生态的核心工具,其设计理念是打破对云端AI服务的依赖,让用户通过本地硬件即可享受与主流AI服务相当的功能。

从技术层面看,LocalAI 并非单一模型,而是一个“AI推理中间层”:它通过集成多种后端(如llama-cpp、diffusers、exllama2等),适配不同类型的模型文件,并将模型能力封装为与OpenAI API一致的接口。这意味着依赖OpenAI API的应用(如聊天工具、AI助手、自动化脚本等)可无缝切换到LocalAI,无需修改代码。

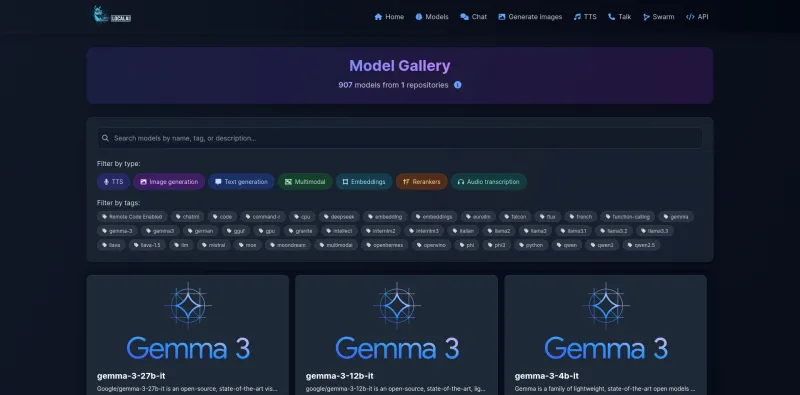

此外,LocalAI 支持从HuggingFace、GitHub等平台获取模型,并提供“模型画廊”功能简化模型安装流程,同时兼容多种硬件加速(NVIDIA CUDA、AMD ROCm、Intel GPU、Apple Metal等),兼顾性能与硬件门槛。

软件功能

OpenAI API兼容:提供与OpenAI API一致的接口(如

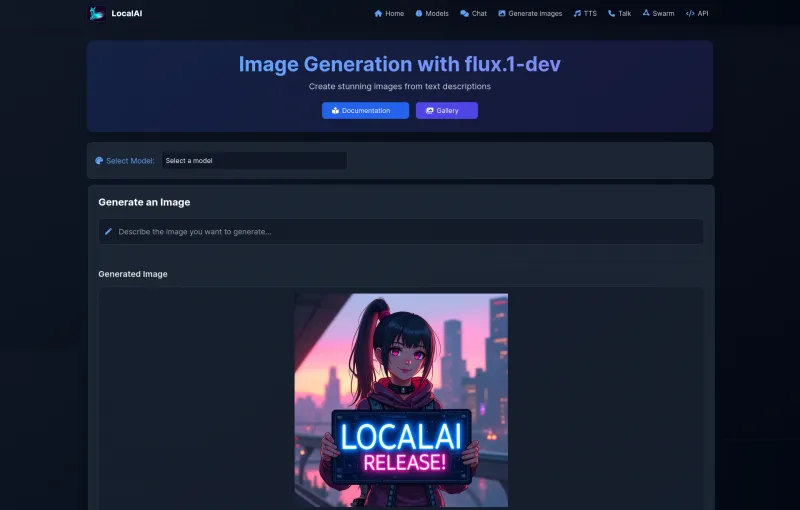

/v1/chat/completions、/v1/completions),支持文本生成、聊天交互等,可直接替代OpenAI服务。多模型支持:兼容文本模型(如Llama 2、Mistral、GPT-2)、图像生成模型(如Stable Diffusion)、音频模型(如Whisper)等,覆盖多模态场景。

本地部署与隐私保护:模型运行在本地设备或私有服务器,数据无需上传云端,避免隐私泄露风险。

硬件适配灵活:支持CPU运行(适合低配置设备),也可利用GPU加速(NVIDIA/AMD/Intel/Apple芯片均兼容),平衡性能与硬件成本。

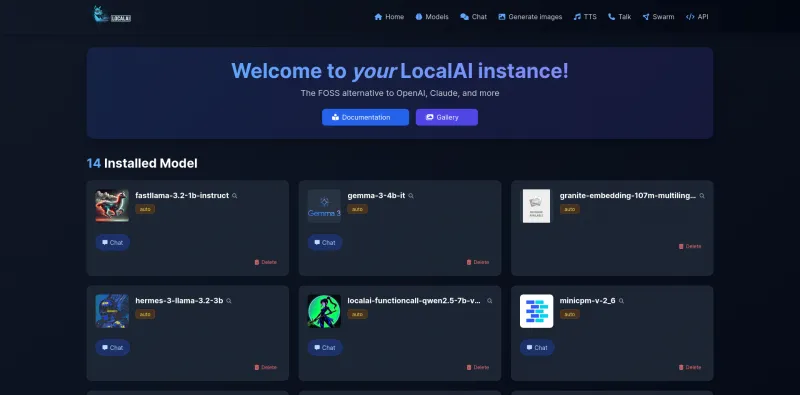

模型管理:支持从画廊一键安装模型、预加载常用模型、自定义模型配置(如参数调优),简化模型维护流程。

向量存储功能:内置向量数据管理接口,可用于语义检索、知识库对接,增强AI的上下文理解能力。

软件特色

完全本地化:从模型运行到数据处理全程本地完成,无需依赖网络或第三方服务,适合对数据隐私敏感的场景(如企业内部、医疗、金融)。

零成本替代:作为开源工具免费使用,无需支付云端API费用,仅需承担本地硬件成本,降低AI应用门槛。

高度兼容性:不仅兼容OpenAI API,还支持ElevenLabs(音频)、Anthropic( Claude )等接口规范,适配多数主流AI应用。

生态丰富:属于“Local Stack Family”生态,可与LocalAGI(AI代理管理)、LocalRecall(知识库存储)等工具联动,构建完整本地AI系统。

社区驱动:活跃的开源社区持续更新功能,支持用户贡献代码、模型配置或使用经验,迭代速度快。

安装使用方法

本软件Windows版非直装版,需在docker中运行。

安装部署:

推荐通过Docker快速启动:执行

docker run -p 8080:8080 localai/localai:latest即可启动服务。也可从源码编译:克隆仓库后,通过

make build生成二进制文件,再执行./localai启动。

配置模型:

从“模型画廊”安装:通过API调用

/models/install,指定模型名称(如llama-2-7b-chat)即可自动下载配置。手动添加模型:将模型文件放入指定目录(如

models/),并创建配置文件(定义模型类型、后端等)。

调用API:

以聊天为例,使用curl发送请求:

curl http://localhost:8080/v1/chat/completions \ -H "Content-Type: application/json" \ -d '{"model": "llama-2-7b-chat", "messages": [{"role": "user", "content": "Hello!"}]}'

进阶使用:通过修改配置文件调整模型参数(如温度、最大token数),或对接向量存储实现知识库问答。

收费价格

LocalAI 是完全开源免费的软件,用户可自由下载、使用、修改和分发,无需支付任何许可费用。

成本主要来自本地硬件(如CPU/GPU、存储)和模型文件(多数开源模型可免费获取,部分需遵循特定许可协议)。

常见问题解答

LocalAI 需要GPU才能运行吗?

不需要。LocalAI 支持纯CPU运行(适合轻量模型),但配备GPU(如NVIDIA显卡)可显著提升大模型的推理速度。

支持哪些模型?

兼容多数开源模型,包括Llama 2、Mistral、Stable Diffusion、Whisper等,具体可参考官方“模型画廊”列表。

如何更新LocalAI?

Docker部署:执行

docker pull localai/localai:latest更新镜像后重启。源码部署:通过

git pull获取最新代码,重新编译即可。

与OpenAI API的区别是什么?

核心区别在于“本地运行” vs “云端服务”:LocalAI 数据不离开设备,延迟更低(取决于硬件),但性能受本地硬件限制;OpenAI API依赖云端,需联网且有数据上传风险,但模型能力更强(如GPT-4)。

总结

LocalAI 作为一款开源的本地AI推理工具,通过兼容主流API、支持多模型与硬件、强调隐私保护,为用户提供了“云端AI替代方案”的新选择。无论是开发者想降低AI应用成本,企业需保障数据安全,还是个人用户希望在本地体验AI功能,LocalAI 都能通过灵活的部署方式和丰富的生态,满足多样化需求。随着开源模型的快速发展,LocalAI 有望成为本地AI应用的核心基础设施之一。

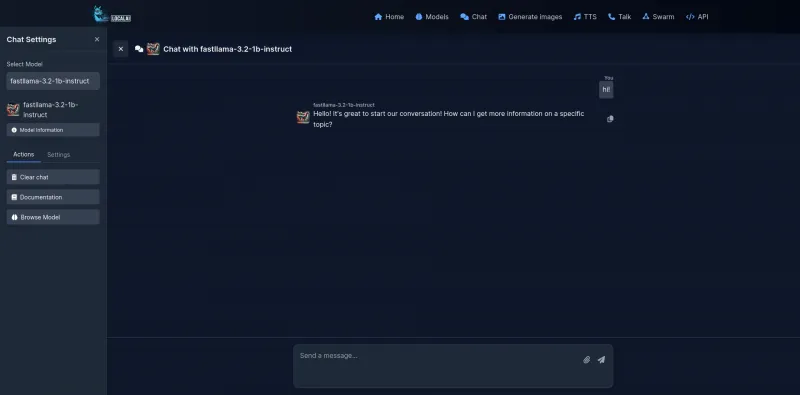

软件截图

LocalAI下载地址

版权与来源声明:AI铺子提供的LocalAI电脑客户端/APP,均转载自官方下载网站或经授权的可信分发渠道。相关软件的所有权、版权及知识产权均归原作者所有。本站不对任何软件进行二次修改或附加捆绑,确保文件的原始性与完整性。我们强烈建议用户支持正版软件,并通过官方渠道获取LocalAI最新版本和专业技术支持。