ZenMux是什么?

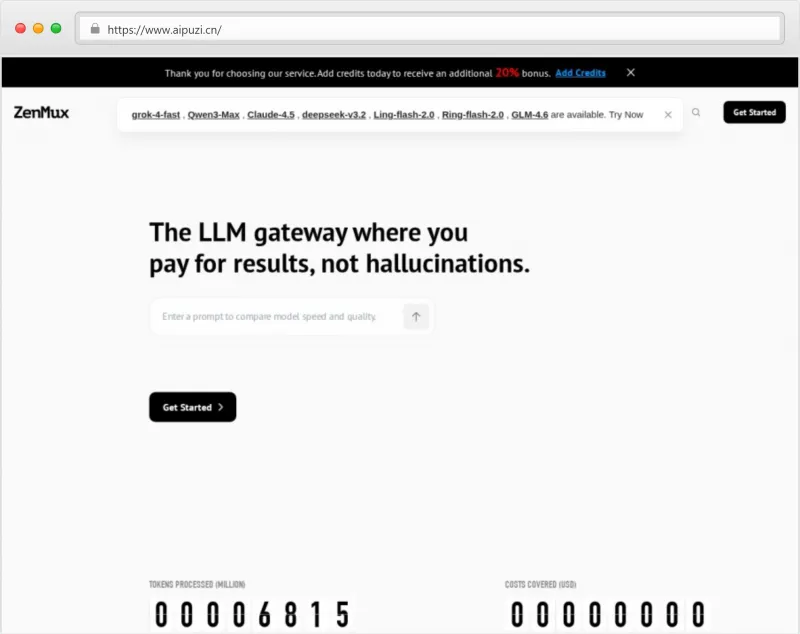

ZenMux 是一个面向开发者与企业的生成式人工智能(GenAI)API 网关平台,致力于解决当前大语言模型(LLM)应用中的核心痛点——幻觉(Hallucinations)、服务不稳定、延迟高、成本不可控等问题。它并非单一模型提供商,而是聚合了全球顶级大模型(如 Qwen3-Max、MetaGPT 等)的“超级接入层”,通过统一接口、智能路由与内置保险机制,为用户提供稳定、高效、可信赖的 AI 服务能力。

其核心理念是:“Pay for Results, Not Hallucinations”(为结果付费,而非为幻觉买单)。这意味着当请求因模型错误、响应失败或输出不合规而产生无效结果时,用户无需为此类“坏结果”支付费用——这正是 ZenMux 的革命性所在。

ZenMux 采用与 OpenAI 完全兼容的 API 接口设计,开发者可以无缝迁移现有项目,无需重写代码即可接入多个高性能 LLM,并享受更低延迟、更高稳定性及成本优化带来的红利。

产品功能

1. 多模型统一接入

ZenMux 支持接入全球领先的大语言模型,包括但不限于:

阿里通义千问系列(Qwen)

MetaGPT

CamelAI(Eigent)

以及其他主流闭源/开源模型

用户只需一个 API Key,即可调用多种模型,实现灵活切换和负载均衡。

2. OpenAI 兼容 API

完全兼容 OpenAI 的接口格式(如 /v1/chat/completions),支持现有框架(LangChain、LlamaIndex、AutoGPT 等)直接对接,极大降低集成门槛。

3. LLM 保险机制(LLM Insurance)

这是 ZenMux 最具创新性的功能之一:

自动检测无效请求结果,包括:

幻觉内容(虚构事实)

工具调用失败

缓存命中缺失

提供商超时或错误

检测到问题后,系统自动补偿信用额度,确保用户只为有效输出付费。

保险机制默认开启,无需额外配置。

4. 智能路由与故障转移

基于实时性能数据动态选择最优模型供应商。

当某节点出现延迟或中断时,自动切换至备用节点,保障服务连续性。

全球分布式部署,覆盖主要区域(北美、欧洲、亚太),提升访问速度。

5. 低延迟高性能网络

平均响应延迟低于 40 毫秒,满足生产级高并发需求。

网络经过全球优化,确保开发者在全球任意位置都能获得一致体验。

6. 开发者友好工具链

实时监控仪表盘:查看请求量、成功率、延迟、成本等关键指标。

账户信用管理:支持预充值、自动续费、发票导出。

清晰的计费日志:每笔请求对应具体消耗与状态,便于审计。

产品特色亮点

| 特色 | 描述 |

|---|---|

| 真正按结果付费 | 创行业先河,引入“LLM保险”,无效结果不扣费,降低试错成本。 |

| 超高稳定性 | 多节点冗余 + 自动 fallback,适合企业级生产环境使用。 |

| 极致低延迟 | 尤其值得一提的是,ZenMux 提供 20% 充值奖励(Bonus Credits),即每次充值都将额外赠送 20% 的可用额度,进一步降低使用成本。 |

使用方法

ZenMux 提供极简的接入流程,帮助开发者“Build with Confidence”:

STEP 1:注册账号

访问官网,点击【Sign Up】创建账户。注册即激活 LLM 保险功能,无需申请。

STEP 2:获取 API 密钥

登录后台,进入 “API Keys” 页面,生成您的通用 API Key。该密钥支持所有模型调用。

# 示例:在代码中设置环境变量 export OPENAI_API_KEY="zmux_abc123xyz" export OPENAI_BASE_URL="https://api.zenmux.com/v1"

STEP 3:充值信用额度

进入【Billing】页面,添加信用(Add Credits)。支持主流支付方式(信用卡、PayPal 等)。

STEP 4:在代码中调用

使用标准 OpenAI SDK 发起请求:

from openai import OpenAI

client = OpenAI(

api_key="zmux_abc123xyz",

base_url="https://api.zenmux.com/v1"

)

response = client.chat.completions.create(

model="qwen3-max",

messages=[{"role": "user", "content": "请写一首关于春天的诗"}]

)

print(response.choices[0].message.content)✅ 四步完成,即可享受世界级 LLM 服务!

适合人群

ZenMux 凭借其稳定性、性价比与工程友好性,适用于以下几类用户群体:

| 用户类型 | 使用场景 | 核心收益 |

|---|---|---|

| 独立开发者 / Maker | 构建个人 AI 应用、自动化脚本、聊天机器人 | 成本低、易上手、免费保险降低风险 |

| 初创公司(AI Native) | 开发 AI Agent、情感陪伴、编程助手等产品 | 快速迭代、高可用架构支撑业务增长 |

| 中小企业技术团队 | 集成 AI 到 CRM、客服、内容生成系统 | 统一接口管理多模型,节省运维成本 |

| 科研机构与教育单位 | 进行长文本理解、多轮对话实验 | 支持长上下文处理,响应稳定可靠 |

| SaaS 平台运营商 | 为客户提供 AI 功能模块(如摘要、翻译) | 可靠 SLA 保障用户体验,避免因 AI 故障影响品牌声誉 |

常见问题解答(FAQ)

Q1:什么是“LLM保险”?如何运作?

A:LLM保险是ZenMux内置的一项保障机制,能够智能识别无效AI输出(如幻觉、空回复、工具调用失败等),并对用户进行信用补偿。整个过程全自动,无需申请。

Q2:是否需要更改现有代码才能接入?

A:不需要。ZenMux API 完全兼容 OpenAI 格式,只需修改 base_url 和 api_key 即可无缝迁移。

Q3:支持哪些模型?

A:目前已支持 Qwen-Max、Llama 系列等主流模型,未来将持续接入更多顶级模型。具体列表可在官网模型市场查看。

Q4:是否有免费试用额度?

A:注册即送小额试用额度,可用于测试基本功能。详细政策请见官网「Free Tier」说明。

Q5:数据隐私与安全如何保障?

A:ZenMux 承诺不会存储或滥用用户数据。所有传输均加密处理,符合GDPR等国际隐私标准。

Q6:能否用于商业项目?

A:完全可以。ZenMux 支持企业级SLA服务,适用于生产环境部署。

Q7:如何查看调用记录与保险补偿明细?

A:后台提供完整的「Usage Logs」与「Insurance Claims」面板,可实时追踪每次请求状态与赔付情况。

总结

在当前AI基础设施竞争日益激烈的环境下,ZenMux 凭借其独特的价值主张脱颖而出:

理念创新:首家提出“Stop paying for hallucinations”,重新定义AI付费逻辑;

技术领先:全球低延迟网络 + 自动fallback机制,保障极致稳定性;

成本最优:零手续费 + 20%充值奖励 + 保险补偿,全方位节省开支;

开发友好:OpenAI兼容接口,五分钟完成集成;

生态开放:聚合全球顶级模型,助力AI创新落地。

无论是个人开发者尝试AI项目,还是企业构建高并发AI系统,ZenMux 都是一个值得信赖的底层支撑平台。