四步完成 Qwen-Image-Edit 本地部署:附完整依赖与 GPU 优化策略

详解 Qwen-Image-Edit 本地部署全流程:从环境配置、依赖安装到模型加载与Web界面启动,附多GPU显存优化技巧与常见问题解决方案,助你快速搭建高性能AI图像编辑系统。

详解 Qwen-Image-Edit 本地部署全流程:从环境配置、依赖安装到模型加载与Web界面启动,附多GPU显存优化技巧与常见问题解决方案,助你快速搭建高性能AI图像编辑系统。

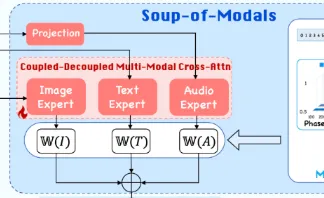

本文提供EchoMimicV3完整部署教程,涵盖Ubuntu + CUDA环境配置、Python虚拟环境搭建、模型权重下载与路径修改、app_mm.py运行等全流程步骤,助你快速实现蚂蚁集团开源的高效...

本文提供B站开源工业级零样本文本转语音模型IndexTTS2的完整本地部署教程,涵盖Ubuntu系统环境搭建、依赖安装、模型下载、国内镜像加速技巧及WebUI可视化界面启动步骤。支持...

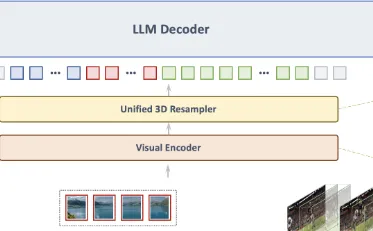

深度解析 MiniCPM-V 4.5 多模态大模型,手把手教你完成本地部署。支持高精度 OCR 与长视频理解,基于 Ubuntu 环境,适配 GGUF 量化,轻松在消费级硬件运行视觉语言模型。

本文专为零基础用户精心打造,无需编程经验。结合 ComfyUI 可视化界面与 Wan2.2-Animate-14B 模型,轻松实现图片角色替换与动作模仿。从部署到生成,图文详解全流程,助你快...

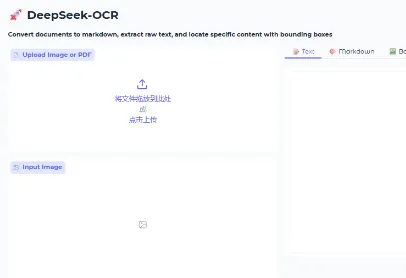

DeepSeek-OCR本地部署指南:仅需16G显存,手把手教你搭建支持高分辨率文档识别的OCR系统,含Conda环境、模型下载、Gradio可视化全流程。

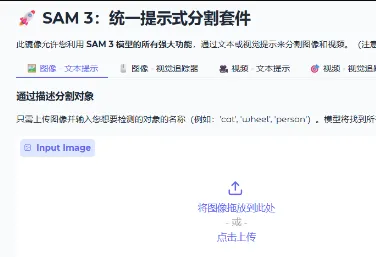

手把手教你部署 SAM 3 模型!从环境搭建、模型下载到 Web 界面运行,完整教程覆盖 Ubuntu + Conda + Gradio 部署全流程,支持文本/点/框多模态分割提示,低显存友好,即刻体...

阿里巴巴Wan团队开源Wan2.2-Animate-14B模型,支持静态图生成高保真角色动画。本文详解Ubuntu系统下基于ComfyUI的本地部署全流程,涵盖环境配置、依赖安装、模型下载与运行...

AI Agent(智能体) 作为基于LLM的下一代智能交互形态,正逐渐成为行业关注的焦点。它不再是简单的“输入输出”工具,而是能够自主感知环境、规划任务、执行操作并持续学习...

长短期记忆网络(Long Short-Term Memory, LSTM)是循环神经网络(RNN)的核心改进架构,核心解决传统 RNN 处理长序列时的梯度消失问题。本文将从数学原理、结构创新、工程...