手把手教你部署 MultiTalk:在 ComfyUI 中实现音频驱动的多人对话视频生成

随着多模态人工智能技术的快速发展,音频驱动的虚拟人物视频生成正逐步从单人对话迈向复杂的多人交互场景。由中山大学、美团与香港科技大学联合研发的MultiTalk,正是这一领域的前沿突破——它能够基于多路音频输入、参考图像和文本提示,生成唇形与语音高度同步、角色间具备互动性的多人对话视频。更令人兴奋的是,该框架已可通过ComfyUI实现本地化部署与可视化操作。本文将带你从零开始,手把手完成 MultiTalk 在 ComfyUI 中的完整部署流程,涵盖环境配置、依赖安装、模型下载到最终启动的每一个关键步骤,助你快速搭建属于自己的多人对话视频生成系统。

一、介绍

MultiTalk 是由中山大学、美团和香港科技大学联合研发的一款音频驱动的多人对话视频生成框架。它能够根据多路音频输入、参考图像和文本提示,生成包含多个角色互动且唇形与语音高度同步的视频内容。简单来说,它能让静态图片中的人物“开口说话”,并且还能进行“对话”。其特点为:

💬 逼真的对话 - 支持单人和多人生成

👥 交互式角色控制 - 通过提示指导虚拟人

🎤 泛化表演 - 支持卡通人物和歌唱的生成

📺 分辨率灵活性:任意纵横比下的 480p 和 720p 输出

⏱️ 长视频生成:支持长达 15 秒的视频生成

二、本地部署

注意:本文主要介绍部署到 ComfyUI 中使用

| 环境 | 版本号 |

|---|---|

| Python | =3.12 |

| PyTorch | =2.8.0 |

| cuda | =12.6 |

| Ubtuntu | 22.0.4 |

1.安装 Miniconda

步骤 1:更新系统

首先,更新您的系统软件包:

sudo apt update sudo apt upgrade -y

步骤 2:下载 Miniconda 安装脚本

访问 Miniconda 的官方网站或使用以下命令直接下载最新版本的安装脚本(以 Python 3 为例):

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

步骤 3:验证安装脚本的完整性(可选)

下载 SHA256 校验和文件并验证安装包的完整性:

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh.sha256 sha256sum Miniconda3-latest-Linux-x86_64.sh

比较输出的校验和与.sha256 文件中的值是否一致,确保文件未被篡改。

步骤 4:运行安装脚本

为安装脚本添加执行权限:

chmod +x Miniconda3-latest-Linux-x86_64.sh

运行安装脚本:

./Miniconda3-latest-Linux-x86_64.sh

步骤 5:按照提示完成安装

安装过程中,您需要:

阅读许可协议 :按 Enter 键逐页阅读,或者按 Q 退出阅读。

接受许可协议 :输入 yes 并按 Enter。

选择安装路径 :默认路径为/home/您的用户名/miniconda3,直接按 Enter 即可,或输入自定义路径。

是否初始化 Miniconda :输入 yes 将 Miniconda 添加到您的 PATH 环境变量中。

步骤 6:激活 Miniconda 环境

安装完成后,使环境变量生效:

source ~/.bashrc

步骤 7:验证安装是否成功

检查 conda 版本:

conda --version

步骤 8:更新 conda(推荐)

为了获得最新功能和修复,更新 conda:

conda update conda

2.部署 ComfyUI

2.1 克隆代码仓库

git clone https://github.com/comfyanonymous/ComfyUI.git

2.2 安装依赖

创建 conda 虚拟环境

conda create -n comfyenv python==3.12 conda activate comfyenv

安装依赖

cd ComfyUI pip install -r requirements.txt

安装 ComfyUI Manager

#进入插件的文件 cd /ComfyUI/custom_nodes/ #下载ComfyUI Manager git clone https://github.com/Comfy-Org/ComfyUI-Manager.git

3.下载模型

在huggingface中下载模型

#进入项目文件 cd ComfyUI #下载模型文件到指定文件夹 #下载huggingface_hub pip install huggingface_hub huggingface-cli download --resume-download Comfy-Org/Wan_2.2_ComfyUI_Repackaged --local-dir /ComfyUI/models/diffusion_models --include "split_files/diffusion_models/wan2.2_i2v_low_noise_14B_fp8_scaled.safetensors" huggingface-cli download --resume-download Comfy-Org/Wan_2.2_ComfyUI_Repackaged --local-dir /ComfyUI/models/diffusion_models --include "split_files/diffusion_models/wan2.2_t2v_low_noise_14B_fp8_scaled.safetensors" #下载text_encoders模型 huggingface-cli download AUTOMATIC/stable-diffusion-3-medium-text-encoders --local_dir /models/text_encoders/

4.启动 ComfyUI

python main.py

输入网址进入 ComfyUI:

http://127.0.0.1:8188

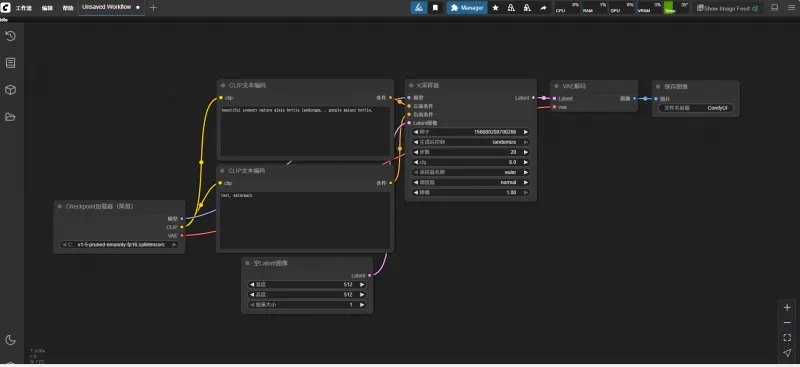

5.工作流

本镜像工作流已改动过,原工作流可以在kijai的仓库中找到

总结:

本文详细介绍了如何在本地环境中部署并运行 MultiTalk 视频生成框架,并集成至 ComfyUI 实现图形化操作。通过 Miniconda 创建隔离环境、安装 PyTorch 与 CUDA 支持、克隆 ComfyUI 项目、配置自定义节点,再到从 Hugging Face 下载核心模型文件,我们一步步完成了从环境准备到服务启动的全过程。最终,用户可在浏览器中通过http://127.0.0.1:8188访问 ComfyUI 界面,加载适配的工作流,实现音频驱动的高质量多人对话视频生成。无论是用于虚拟人交互、内容创作还是科研实验,这套部署方案都为深入探索 MultiTalk 提供了坚实基础。

版权及免责申明:本文来源于#算家计算,由@AI工具箱整理发布。如若内容造成侵权/违法违规/事实不符,请联系本站客服处理!该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/686.html