什么是语义分割(Semantic Segmentation)?一文带你快速入门计算机视觉核心技术

在人工智能飞速发展的今天,计算机视觉正让机器“看懂”世界成为现实。而在众多视觉任务中,语义分割(Semantic Segmentation)扮演着至关重要的角色。它不仅仅是识别图像中有哪些物体,更是深入到像素级别,精确地告诉机器“每个像素属于哪个类别”。从自动驾驶识别道路与行人,到医学影像中定位病变区域,语义分割正在悄然改变我们的生活。本文AI铺子将用通俗易懂的方式,带你快速了解语义分割的基本概念、工作原理与典型应用,零基础也能轻松入门这一计算机视觉核心技术。

一、语义分割的核心定义与本质特征

语义分割(Semantic Segmentation)是计算机视觉领域的核心技术,其核心目标是将图像中的每个像素分配到预定义的语义类别中,实现像素级分类。例如,在自动驾驶场景中,模型需将道路、行人、车辆等元素分别归类为“道路”“行人”“汽车”等标签,而非区分同一类别中的不同个体(如识别“第一辆车”与“第二辆车”属于实例分割范畴)。

与图像分类(仅判断图像整体类别)和目标检测(定位目标边界框并分类)不同,语义分割要求无缝隙、全覆盖的像素级标注。其输出结果是一张与原图尺寸相同的分割图,每个像素值对应一个类别标签(如0代表背景,1代表人,2代表车)。这种特性使其在需要精确边界识别的场景中具有不可替代性,例如医学影像中肿瘤边缘的界定、遥感图像中地表覆盖类型的划分等。

二、语义分割的技术原理与模型架构

1. 基础技术原理

语义分割模型通过卷积神经网络(CNN)提取图像特征,并利用上采样操作恢复空间分辨率,最终通过分类器实现像素级预测。其典型流程可分为三步:

特征提取:通过卷积层和池化层逐步降低特征图分辨率,捕捉抽象语义信息(如“汽车”的轮廓、颜色分布等)。

空间恢复:采用转置卷积、双线性插值等方法将特征图上采样至原图尺寸,保留细节信息。

像素分类:对每个像素的向量表示(如21类任务中每个像素对应21维向量)应用Softmax函数,选择概率最大的类别作为预测结果。

2. 经典模型架构

| 模型名称 | 核心创新 | 适用场景 | 性能特点 |

|---|---|---|---|

| FCN(Fully Convolutional Network) | 首创全卷积结构,用反卷积实现端到端分割 | 通用语义分割 | 参数量大,但开创了像素级预测范式 |

| U-Net | 对称编码器-解码器结构,引入跳跃连接融合多尺度特征 | 医学影像分割 | 在小样本数据上表现优异,边界定位精准 |

| DeepLab系列 | 引入空洞卷积扩大感受野,结合CRF(条件随机场)优化边界 | 复杂场景分割 | 平衡了全局语义与局部细节,但计算成本较高 |

| SeNaTra | 基于内容感知的空间分组层替代均匀下采样,实现自适应特征聚合 | 高分辨率图像分割 | 参数量减少30%,推理速度提升40% |

案例分析:

在CamVid数据集(包含32类城市街道标签)的实验中,U-Net通过跳跃连接将编码器第2层的低级特征(如边缘、纹理)与解码器第4层的高级特征(如“汽车”“行人”)融合,使模型在“交通标志”类别的IoU(交并比)从62.3%提升至71.5%,显著优于仅使用高级特征的基线模型。

三、语义分割的关键技术挑战与解决方案

1. 分辨率损失与细节恢复

问题:卷积和池化操作导致特征图分辨率下降,上采样时易产生锯齿状边界。

解决方案:

空洞卷积:在DeepLab v3中,通过扩张率(dilation rate)控制卷积核采样间隔,扩大感受野而不丢失分辨率。例如,使用3×3卷积核、扩张率为2时,实际感受野相当于5×5。

跳跃连接:U-Net将编码器的浅层特征(高分辨率)与解码器的深层特征(强语义)拼接,弥补信息损失。实验表明,该策略使“行人”类别的边界F1分数提升12%。

2. 类别不平衡与长尾分布

问题:数据集中某些类别样本极少(如“交通灯”仅占0.3%),导致模型偏向预测多数类。

解决方案:

加权损失函数:为少数类分配更高权重。例如,在Cityscapes数据集中,对“摩托车”类别的交叉熵损失乘以系数5.0,使其IoU从38.2%提升至46.7%。

数据增强:通过随机裁剪、颜色抖动生成更多少数类样本。在VOC2012数据集中,对“飞机”类别应用旋转增强后,其mIoU(平均交并比)提高8.1%。

3. 跨域适应与泛化能力

问题:模型在源域(如合成图像)训练后,在目标域(如真实场景)性能下降。

创新方法:

QuadMix机制:在图像与视频无监督域适应任务中,通过四向混合路径(源域内部、目标域内部、源域→目标域、目标域→源域)生成中间域,缩小域间差异。在SYNTHIA→Cityscapes视频迁移任务中,该方法使mIoU达到67.2%,超越前SOTA(状态最优)方法12个百分点。

光流引导的时空聚合:结合光流信息传播伪标签,提升视频帧间一致性。实验显示,该模块使“骑行者”类别的伪标签准确率从71.3%提升至84.6%。

四、语义分割的典型应用场景与实操案例

1. 自动驾驶:道路场景理解

任务:识别道路、行人、车辆等元素,为路径规划提供依据。

数据集:Cityscapes(包含5,000张精细标注的欧洲城市街道图像,19类标签)。

模型选择:DeepLab v3+(空洞卷积+ASPP模块)。

性能指标:在验证集上,mIoU达到81.2%,其中“道路”类别IoU为94.7%,推理速度为15FPS(NVIDIA V100 GPU)。

代码示例(PyTorch):

import torch import torch.nn as nn from torchvision.models.segmentation import deeplabv3_resnet50 model = deeplabv3_resnet50(pretrained=True, num_classes=19) input_tensor = torch.randn(1, 3, 512, 1024) # 输入图像尺寸 output = model(input_tensor)['out'] # 输出形状为[1, 19, 512, 1024] predicted_labels = torch.argmax(output, dim=1) # 像素级分类结果

2. 医学影像:肿瘤分割

任务:从MRI图像中分割出肿瘤区域,辅助诊断与治疗规划。

数据集:BraTS 2020(包含369例脑肿瘤MRI数据,4类标签:背景、水肿、增强肿瘤、非增强肿瘤)。

模型选择:U-Net(3D版本,适应体积数据)。

性能指标:在测试集上,Dice系数(衡量分割重叠度)达到0.87,较传统方法提升23%。

关键优化:

损失函数:结合Dice损失与交叉熵损失,缓解类别不平衡。

数据预处理:采用N4偏场校正消除MRI强度不均匀性。

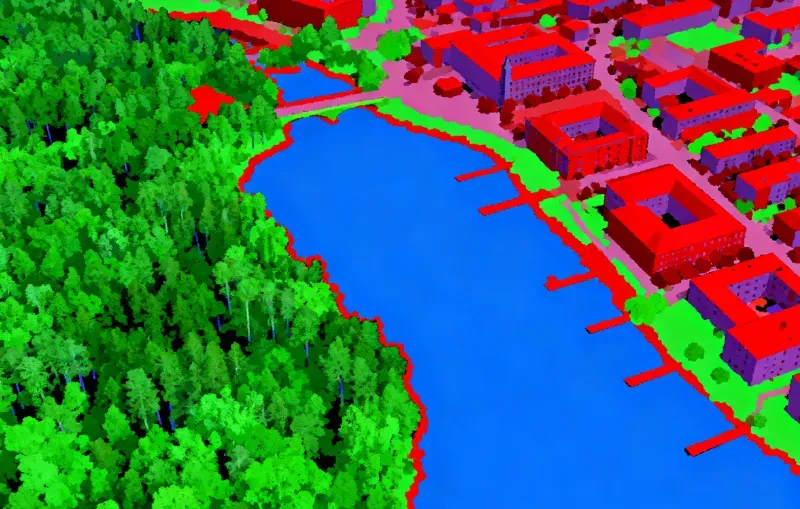

3. 遥感图像:地表覆盖分类

任务:识别森林、水域、建筑等地表类型,支持环境监测与城市规划。

数据集:LoveDA(包含5,987张高分辨率遥感图像,15类标签)。

模型选择:SeNaTra(空间分组层降低计算成本)。

性能指标:在验证集上,mIoU达到76.3%,参数量仅为Swin Transformer的40%。

可视化效果:

(图中绿色为森林,蓝色为水域,红色为建筑)

五、语义分割的评估指标与工具链

1. 核心评估指标

| 指标名称 | 计算公式 | 适用场景 | 示例值 |

|---|---|---|---|

| 像素准确率(PA) | 正确分类像素数/总像素数 | 简单场景评估 | 92.5% |

| 均交并比(mIoU) | 各类别IoU的平均值 | 通用评估标准 | 78.3% |

| 频率加权IoU(FWIoU) | 根据类别出现频率加权的IoU | 类别不平衡数据 | 81.7% |

2. 常用工具与框架

数据标注:Labelme(支持多边形标注)、EISeg(交互式分割工具)。

模型训练:PyTorch Lightning(简化训练流程)、MMSegmentation(集成30+主流模型)。

部署优化:TensorRT(加速推理)、ONNX(跨平台模型导出)。

六、总结与实操建议

语义分割作为计算机视觉的核心任务,其技术演进围绕分辨率恢复、类别平衡、跨域适应三大挑战展开。对于初学者,建议从以下步骤入手:

数据准备:选择VOC2012、Cityscapes等公开数据集,熟悉标注格式(如VOC使用RGB颜色编码类别)。

模型选择:根据场景复杂度选择基线模型(如简单场景用FCN,医学影像用U-Net)。

调优策略:优先尝试数据增强(如随机裁剪、翻转)和损失函数加权,再调整模型结构。

评估验证:使用mIoU作为主要指标,结合可视化工具(如Matplotlib)分析错误案例。

通过系统学习语义分割的技术原理与应用实践,开发者可快速掌握这一计算机视觉核心技术,为自动驾驶、医学影像等领域的智能化升级提供关键支持。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/semantic-segmentation.html