Agent Lightning:微软开源的 AI 代理全流程训练与优化工具

一、Agent Lightning是什么?

Agent Lightning是微软开发的开源AI代理训练工具,旨在简化AI代理的优化流程。它支持零代码改动适配各类代理框架(如LangChain、AutoGen)及无框架场景,集成强化学习、自动提示优化等多种算法,可高效提升AI代理在复杂任务中的表现,适用于企业级助手、多代理协作、特定任务处理等场景,为开发者提供从部署到持续优化的全流程支持。

在AI代理技术快速发展的背景下,开发者常面临一个核心难题:如何高效优化AI代理的性能?传统方式往往需要深度修改代理代码、受限于特定框架,且优化算法单一,导致迭代周期长、适配成本高。

Agent Lightning(简称“AL”)正是为解决这些痛点而生——它定位为“AI代理的全流程优化引擎”。其核心目标是让开发者无需重构现有代理系统,即可通过多种算法(如强化学习、自动提示优化等)快速提升代理的任务处理能力。

从技术本质来看,AL是一个“低侵入性优化层”:它不替代现有代理框架,而是通过灵活的接口对接各类系统,收集代理运行轨迹(如交互日志、任务结果),再利用内置算法生成优化策略(如更优的提示词、微调模型权重),最终反哺原始代理系统。无论是基于LangChain的单代理、AutoGen的多代理协作系统,还是纯Python编写的原生API调用逻辑,AL都能无缝适配,实现“即插即用”的优化效果。

二、功能特色

AL的功能设计围绕“降低优化门槛”和“提升优化效率”两大核心,具体可总结为以下六大特色:

1. 零代码改动,快速适配现有系统

这是AL最核心的优势之一。传统AI代理优化往往需要修改代理的核心逻辑(如添加轨迹收集代码、适配算法接口),而AL通过“钩子机制”和“抽象层封装”实现了对原始代码的“零侵入”。

例如,若开发者已基于OpenAI SDK编写了一个客服代理,只需通过AL的wrap_agent接口对代理进行简单封装,即可自动收集对话轨迹、触发优化流程,无需修改原始的API调用、逻辑判断等代码。这种设计大幅降低了迁移成本,让存量系统也能快速享受优化能力。

2. 跨框架兼容,打破生态壁垒

AI代理领域存在众多框架(如LangChain、AutoGen、CrewAI、LangGraph等),且很多团队会选择无框架的原生开发模式。AL通过“框架抽象层”实现了对多生态的兼容,具体支持范围如下:

| 兼容类型 | 支持的框架/场景 | 适配方式 |

|---|---|---|

| 主流框架 | LangChain、AutoGen、CrewAI、LangGraph | 内置专属适配器,直接对接框架接口 |

| 大模型SDK | OpenAI SDK、Anthropic SDK、Azure OpenAI | 封装API调用,自动收集交互轨迹 |

| 无框架原生代码 | 纯Python编写的代理逻辑 | 基于函数装饰器捕获输入输出 |

这种兼容性意味着开发者无需为适配AL而重构系统,可在现有技术栈上直接启用优化。

3. 多算法集成,满足多样化优化需求

AL内置了多种优化算法,覆盖从“轻量级提示优化”到“深度模型微调”的全场景,开发者可根据任务类型和资源条件灵活选择:

自动提示优化(APO):无需模型微调,通过分析代理失败案例,自动生成更优的提示词(如补充任务约束、优化指令逻辑),适用于快速提升零样本/少样本任务表现。

强化学习(RL):基于人类反馈(RLHF)或环境反馈(如任务成功率)训练代理策略,支持多代理协作场景(如通过代理间的交互奖励优化分工逻辑),适用于复杂决策任务(如流程自动化、多步推理)。

监督微调(SFT):利用高质量示范数据微调代理模型(支持LoRA、4位量化等轻量化技术),适用于需要深度适配特定领域(如医疗、法律)的场景。

混合优化:支持多种算法组合(如“APO+RL”先通过提示词快速迭代,再用强化学习深度优化),平衡效率与效果。

4. 灵活控制优化范围,聚焦核心问题

在多代理系统中(如一个包含“检索代理”“推理代理”“总结代理”的RAG系统),往往无需优化所有代理,只需针对性提升性能短板。AL支持“精准优化”:通过配置文件指定需要优化的代理实例,其他代理保持原有逻辑,避免无效计算资源消耗。

5. 全流程可视化与调试

为降低优化过程的复杂度,AL提供了完整的可视化工具:

轨迹看板:展示代理运行的详细轨迹(输入、输出、工具调用、中间结果),帮助定位失败原因(如工具调用错误、推理逻辑断层)。

优化日志:记录算法迭代过程(如APO生成的提示词版本、RL的奖励变化曲线),支持对比不同优化策略的效果。

调试模式:可暂停优化流程,手动修改中间参数(如临时调整提示词、干预奖励函数),便于开发者介入优化过程。

6. 轻量化设计,适配多环境

AL的核心代码仅需数百MB存储空间,支持在CPU、单GPU、多GPU集群等多种环境运行:

轻量任务(如APO优化)可在普通笔记本CPU上完成;

重度任务(如大模型SFT)可通过分布式训练配置对接GPU集群,支持Horovod、DeepSpeed等分布式框架。

三、技术细节

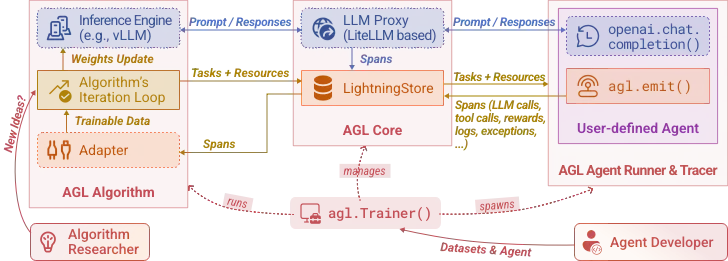

AL的架构设计以“简洁、可扩展”为原则,核心由5个模块组成,各模块通过标准化接口通信,确保灵活性和可维护性。

1. 核心架构

![架构示意图(文字描述)]

AL的架构可分为“数据层”“算法层”“控制层”“接口层”和“存储层”五大模块,具体职责如下:

接口层(Agent Adapter):负责对接外部代理系统(框架或原生代码),通过钩子函数、装饰器等方式收集代理的输入、输出、中间状态(即“轨迹数据”),同时将优化后的资源(如提示词、模型权重)推送回原始代理。

数据层(Trajectory Processor):对接口层收集的轨迹数据进行清洗、标准化(如统一格式为JSONL),并提取关键特征(如任务类型、成功率、错误标签),为算法层提供高质量输入。

算法层(Optimization Algorithms):包含APO、RL、SFT等算法的实现,核心逻辑是“从轨迹中学习优化策略”。例如,APO模块会通过对比成功/失败轨迹,生成提示词改进建议;RL模块会将轨迹转化为“状态-动作-奖励”样本,训练策略模型。

控制层(Trainer):协调各模块工作的“中枢”,负责:

接收用户配置(如选择算法、设置优化轮次);

调度数据层处理轨迹;

触发算法层执行优化;

将优化结果(如优化后的提示词)通过接口层更新到代理系统。

存储层(LightningStore):存储所有中间数据,包括原始轨迹、处理后的数据、算法模型参数、优化历史等,支持本地文件系统、AWS S3、Azure Blob等多种存储后端。

2. 关键技术亮点

低侵入性适配:通过“动态代理”和“函数劫持”技术,在不修改原始代码的前提下捕获代理行为。例如,对OpenAI SDK的

ChatCompletion.create方法进行封装,自动记录输入消息、输出结果和调用参数,实现轨迹收集。多算法协同:算法层的模块设计遵循“插件化”原则,每个算法独立封装,可通过配置文件动态加载。例如,用户可在配置中指定

algorithm: ["apo", "rl"],Trainer会自动按顺序执行APO和RL,并传递中间结果(如APO生成的提示词可作为RL的初始策略)。轨迹数据标准化:为支持跨框架算法调用,AL定义了统一的轨迹数据格式(包含

agent_id、task、input、output、reward、timestamp等字段),无论原始代理输出何种格式,数据层都会将其转化为标准格式,确保算法层无需适配不同框架。

3. 性能优化

为提升大规模训练的效率,AL做了多项性能优化:

轨迹数据增量处理:仅处理新生成的轨迹,避免重复计算;

算法并行化:支持多算法同时运行(如对不同代理分别执行APO和SFT);

模型轻量化:SFT模块集成Unsloth等工具,支持4位量化、LoRA低秩适配,将大模型微调的显存需求降低70%以上。

四、应用场景

AL的灵活性使其适用于各类AI代理优化场景,以下是典型案例:

1. 企业级AI助手优化

场景描述:某企业基于LangChain开发了内部办公助手,负责日程管理、文档检索、流程审批等任务,但存在“指令理解偏差”(如误判用户的会议时间需求)和“工具调用错误”(如错误触发审批流程)等问题。

AL的解决方案:

通过接口层对接LangChain代理,收集1周内的交互轨迹;

用APO算法分析失败案例(如“用户说‘明天3点开会’被理解为‘今天3点’”),自动生成更精准的提示词(补充“需明确区分‘明天’与‘今天’,优先提取日期关键词”);

启用RL算法,以“用户确认率”为奖励,优化工具调用逻辑(如调用日程工具前先二次确认时间)。

效果:2周内任务成功率从68%提升至91%,无需修改原始助手代码。

2. 多代理协作系统优化

场景描述:某团队用AutoGen搭建了“数据分析代理群”,包含“数据爬取代理”“清洗代理”“建模代理”,但存在分工混乱(如爬取代理重复获取数据)、结果不一致(如清洗规则冲突)等问题。

AL的解决方案:

配置AL仅优化“爬取代理”和“清洗代理”;

收集代理间的交互轨迹(如爬取结果、清洗规则、建模反馈);

用多代理RL算法,设计“协作奖励”(如数据重复率低、清洗后建模效果好则奖励高),优化代理的任务分配逻辑和规则生成策略。

效果:数据重复率降低62%,建模准确率提升18%。

3. 特定任务代理训练(如文本到SQL)

场景描述:开发者基于LangGraph开发了一个“文本到SQL”代理,用于将自然语言问题转化为数据库查询语句,但在复杂查询(如多表关联、条件嵌套)上准确率低。

AL的解决方案:

在Spider数据集(文本到SQL基准数据集)上运行代理,收集失败案例(如错误关联表、遗漏条件);

用SFT算法,以高质量SQL示例为训练数据,通过LoRA微调代理的生成模型;

结合APO优化提示词(如补充“需先分析表结构,再确定关联字段”)。

效果:复杂查询准确率从45%提升至73%。

4. RAG系统优化

场景描述:某知识库系统的RAG代理(基于CrewAI)存在“检索偏差”(如返回无关文档)和“生成冗余”(如回答包含重复信息)的问题。

AL的解决方案:

收集检索结果、用户反馈(如“不相关”标签);

用APO优化检索提示(如“优先匹配标题和关键词,排除发布时间超过3年的文档”);

用RL算法,以“用户满意度”和“信息密度”为奖励,优化生成逻辑(如精简重复内容)。

效果:相关文档召回率提升40%,回答冗余度降低35%。

五、使用方法

AL的使用流程简单直观,分为“安装→配置→运行→查看结果”四步,以下是详细说明:

1. 安装

支持两种安装方式,满足不同需求:

快速安装(推荐普通用户):通过pip安装稳定版

pip install agentlightning

源码安装(推荐开发者):获取最新功能

git clone https://github.com/microsoft/agent-lightning.git cd agent-lightning pip install -e .[dev] # 包含开发依赖(如测试工具、文档生成)

2. 快速上手(以APO优化为例)

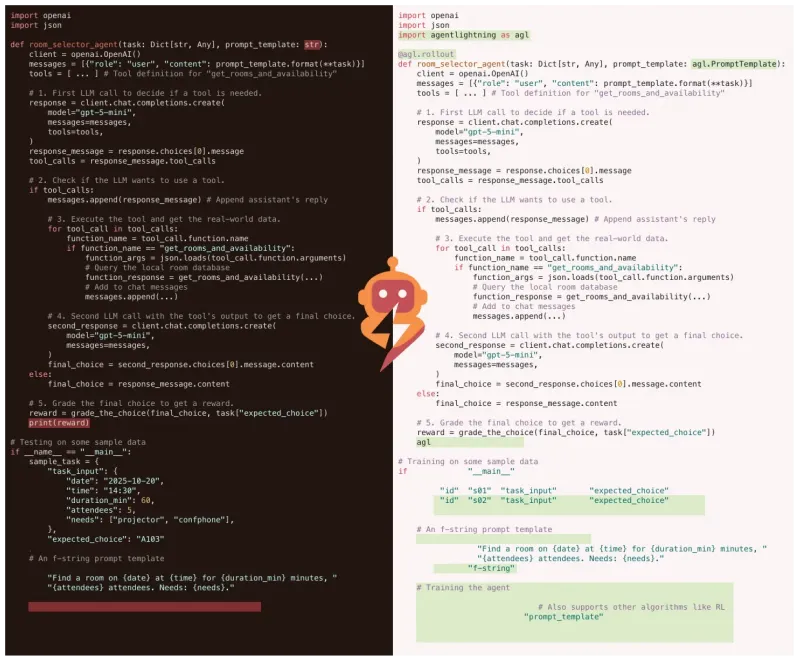

以下是一个基于OpenAI SDK的简单代理,通过AL的APO算法优化提示词的完整流程:

步骤1:定义原始代理

import openai

from agentlightning import wrap_agent, Trainer

# 原始代理:根据问题生成回答(提示词简单,可能效果差)

def simple_agent(question: str) -> str:

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": question}]

)

return response.choices[0].message["content"]步骤2:用AL封装代理并配置优化策略

# 封装代理,指定优化算法为APO wrapped_agent = wrap_agent( agent=simple_agent, agent_type="openai_sdk", # 声明代理类型,AL自动适配 algorithm="apo" # 选择自动提示优化算法 ) # 配置训练器:设置优化轮次、数据存储路径等 trainer = Trainer( agent=wrapped_agent, max_epochs=3, # 优化3轮 data_dir="./trajectory_data", # 轨迹数据存储路径 output_dir="./optimized_results" # 优化结果存储路径 )

步骤3:准备训练数据并运行优化

# 准备任务数据(如用户问题列表) tasks = [ "什么是强化学习?用一句话解释", "如何用Python实现简单的加法函数?", "介绍下微软的Agent Lightning项目" ] # 运行优化:AL会自动让代理执行任务、收集轨迹、生成优化提示 trainer.train(tasks=tasks)

步骤4:使用优化后的代理

# 加载优化后的提示词

optimized_agent = trainer.load_optimized_agent()

# 测试效果:优化后的代理会使用APO生成的更优提示词

print(optimized_agent("什么是强化学习?用一句话解释"))

# 输出(示例):强化学习是一种AI算法,通过与环境交互获得奖励来学习最优行为策略。3. 高级配置

对于复杂场景(如多算法组合、分布式训练),可通过配置文件(YAML格式)精细控制优化过程。示例配置如下:

# al_config.yaml agent: type: "autogen" # 代理基于AutoGen框架 path: "./my_autogen_agent.py" # 代理代码路径 target_agents: ["coder_agent", "reviewer_agent"] # 仅优化这两个代理 algorithm: - name: "apo" params: max_prompt_length: 500 # 提示词最大长度 - name: "rl" params: reward_function: "task_success_rate" # 以任务成功率为奖励 policy_lr: 0.001 # 学习率 trainer: max_epochs: 5 distributed: True # 启用分布式训练 gpus: 2 # 使用2个GPU

运行时指定配置文件:

agentlightning train --config al_config.yaml

六、常见问题解答(FAQ)

AL支持哪些大模型?

支持主流大模型,包括OpenAI(GPT-3.5/4)、Anthropic(Claude)、Azure OpenAI、本地部署模型(如Llama 3、Mistral)等,只需在代理代码中正确配置模型API即可。

优化过程需要大量标注数据吗?

不一定。APO算法可通过无标注的失败轨迹自动优化提示词;RL支持基于环境反馈(如任务是否完成)的无标注训练;SFT需要少量高质量示范数据(可结合AL的轨迹筛选功能自动生成)。

与LangChain的RLHF模块有什么区别?

LangChain的RLHF模块仅支持自身框架,且算法单一;AL支持跨框架,集成APO、RL、SFT等多算法,且无需修改原始代码。

是否需要GPU?

轻量任务(如APO、小模型RL)可在CPU运行;SFT或大模型RL建议使用GPU(单GPU即可支持7B模型的LoRA微调)。

如何自定义优化算法?

AL支持算法插件化:只需继承BaseAlgorithm类并实现train和predict方法,再在配置文件中指定自定义算法路径即可。

多代理系统中,如何避免优化后的代理冲突?

AL的多代理优化会同时考虑代理间的交互轨迹,通过“协作奖励”机制确保优化后的代理保持协同性,而非各自最优。

七、相关链接

八、总结

Agent Lightning是微软为解决AI代理优化痛点推出的开源工具,它以零代码改动、跨框架兼容为核心优势,集成APO、RL、SFT等多种算法,支持从单代理到多代理系统的全场景优化。通过简洁的架构设计和灵活的配置,开发者可快速将其接入现有系统,显著提升AI代理在任务处理、协作效率等方面的表现,是企业级AI应用、研究项目中优化代理性能的实用工具。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/agent-lightning.html