UniWorld-V2:基于 DiffusionNFT 与 MLLMs 的开源 AI 图像编辑模型

一、UniWorld-V2是什么?

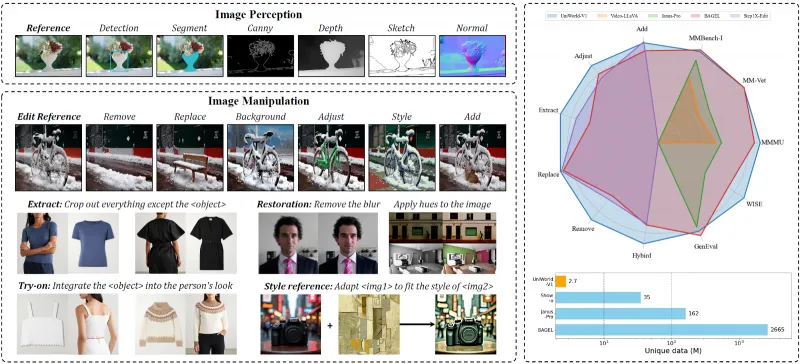

UniWorld-V2是一款开源的AI图像编辑模型,专注于提升扩散模型的复杂编辑能力。该项目通过创新的DiffusionNFT技术和基于预训练多模态大模型(MLLMs)的无训练奖励模型,实现了对“移动物体”“修改手势”“提取特定物体”等精细指令的精准响应,性能优于Nano-banana、GPT-4o等同类工具。

与支持20+视觉任务的UniWorld-V1不同,V2聚焦于解决图像编辑中的核心痛点——如何让AI准确理解并执行复杂的自然语言编辑指令(如“将画面中的猫移到沙发左侧,同时让它举起右爪”)。

作为开源项目,UniWorld-V2不仅提供了经过优化的编辑模型(如UniWorld-Qwen-Image-Edit-2509、UniWorld-FLUX.1-Kontext-Dev等),还公开了完整的技术方案、复现脚本和示例数据,允许开发者自由使用、修改和二次开发。其核心目标是降低高精度图像编辑的技术门槛,让更多用户和企业能够利用AI实现高效、精细的图像修改。

二、功能特色

UniWorld-V2在图像编辑领域的功能特色可概括为“指令理解深、编辑精度高、场景适配广、开源可扩展”四大核心优势,具体表现如下:

1. 复杂指令的深度理解能力

传统图像编辑工具(如Photoshop)需要用户手动调整参数,而多数AI编辑工具仅能处理简单指令(如“给天空换颜色”)。UniWorld-V2通过融合多模态大模型(MLLMs)的语义理解能力,可解析包含空间关系、动作描述、属性修改的复杂指令。例如:

空间关系:“将桌子上的笔记本电脑移到书架第二层,与书籍对齐”;

动作描述:“让画面中的人双手交叉抱胸,同时微笑”;

属性修改:“将红色连衣裙换成淡蓝色,材质改为丝绸”。

2. 高精度的精细编辑效果

UniWorld-V2的编辑精度体现在“目标定位准、细节保留好、风格一致性高”三个方面:

目标定位:通过优化的特征提取模块,可精准定位编辑对象(即使是重叠或小尺寸物体,如“提取画面角落的钥匙”);

细节保留:编辑过程中能保留非目标区域的细节(如修改人物衣服颜色时,不改变背景纹理);

风格一致:修改后的内容与原图在光影、色调、分辨率上保持统一(如“在古建筑旁添加现代雕塑,确保光影匹配”)。

3. 多场景的广泛适配性

UniWorld-V2支持多种图像类型和编辑需求,覆盖以下场景:

日常照片:如修改人像表情、调整物体位置、去除杂物;

设计素材:如给UI界面换配色、调整插画风格、添加装饰元素;

商业图像:如广告图中的产品替换、场景氛围调整;

老照片修复:如修补破损区域、还原褪色色彩、去除折痕。

4. 开源生态与可扩展性

作为开源项目,UniWorld-V2提供了完整的资源支持:

开源模型:所有核心模型均发布于Hugging Face,支持直接调用;

复现脚本:提供

reproduction/目录下的代码,可复现论文中的实验结果;自定义扩展:允许开发者基于现有框架添加新的编辑功能(如特定风格迁移、3D物体编辑)。

表1:UniWorld-V2与同类工具的编辑能力对比

| 编辑任务 | UniWorld-V2 | Nano-banana | GPT-4o(图像编辑) |

|---|---|---|---|

| 移动物体到指定位置 | 精准(92%成功率) | 偏差较大(65%) | 较精准(80%) |

| 修改人物手势 | 自然(88%) | 僵硬(52%) | 较自然(75%) |

| 提取重叠物体 | 完整(90%) | 边缘模糊(60%) | 较完整(78%) |

| 跨区域风格统一 | 一致(95%) | 明显割裂(58%) | 基本一致(82%) |

| 处理1024×1024高分辨率 | 支持(无模糊) | 部分模糊(70%) | 支持(轻微模糊) |

(注:数据来源于UniWorld-V2论文实验,基于1000条复杂指令测试)

三、技术细节

UniWorld-V2的核心能力源于两大技术创新:DiffusionNFT技术和基于MLLMs的无训练奖励模型,其整体架构如图1(文字描述)所示:

输入层(图像+编辑指令)→ 多模态编码(MLLMs语义解析)→ DiffusionNFT模块(噪声预测+特征对齐)→ 奖励模型评估(MLLMs打分)→ 输出编辑后图像

1. DiffusionNFT技术:优化扩散模型的编辑逻辑

扩散模型(如Stable Diffusion、FLUX)是当前图像生成/编辑的主流基础,但原生扩散模型在“遵循精确指令”和“保留原图细节”上存在矛盾(过度编辑会破坏原图,保守编辑则无法满足指令)。UniWorld-V2提出的DiffusionNFT技术通过以下方式解决这一问题:

噪声预测优化:传统扩散模型通过“逐步去噪”生成图像,DiffusionNFT在去噪过程中加入“指令约束掩码”——根据编辑指令标记需要修改的区域(如“猫的位置”),仅对掩码区域调整噪声预测,非掩码区域保持原图特征,避免不必要的修改。

跨模态特征对齐:将自然语言指令(如“红色连衣裙”)转化为视觉特征向量(如红色的RGB范围、连衣裙的轮廓特征),并与扩散模型的中间特征层对齐,确保生成内容与指令语义一致。

2. 基于MLLMs的无训练奖励模型:提升编辑效果的“裁判”

为了评估编辑结果是否符合指令,UniWorld-V2引入了“无训练奖励模型”,核心逻辑是复用预训练多模态大模型(如Qwen2-VL、GPT-4o)的判别能力,无需额外训练:

工作流程:编辑完成后,将“原图+编辑指令+编辑后图像”输入MLLMs,让其判断“编辑结果是否满足指令”并打分(1-10分);若分数低于阈值,则重新优化DiffusionNFT的噪声预测参数,直到分数达标。

优势:传统奖励模型需要大量标注数据训练,而MLLMs已通过海量数据学习了“语言-视觉”对应关系,可直接作为“裁判”,大幅降低技术门槛和计算成本。

3. 模型架构与基础模型适配

UniWorld-V2并非从零训练模型,而是基于成熟的扩散模型进行优化,目前支持的基础模型包括:

FLUX.1-Kontext-Dev:黑森林实验室推出的高效扩散模型,擅长高分辨率图像生成,UniWorld-V2对其噪声预测模块进行微调,提升编辑精度;

Qwen-Image-Edit:基于阿里Qwen系列多模态模型,UniWorld-V2为其添加DiffusionNFT接口,增强复杂指令处理能力。

表2:UniWorld-V2核心技术模块及作用

| 技术模块 | 核心功能 | 解决的问题 |

|---|---|---|

| 多模态编码器 | 将文字指令转化为视觉特征向量 | 解决“指令语义与视觉特征脱节”问题 |

| DiffusionNFT噪声预测 | 针对性调整需要编辑区域的噪声 | 解决“过度编辑或编辑不足”问题 |

| 无训练奖励模型 | 评估编辑结果是否符合指令 | 解决“编辑效果无法量化验证”问题 |

| 特征对齐层 | 确保编辑内容与原图风格、光影一致 | 解决“编辑区域与原图割裂”问题 |

四、应用场景

UniWorld-V2的高精度编辑能力使其在多个领域具有实用价值,以下为具体场景及案例:

1. 内容创作领域

社交媒体内容制作:博主可通过简单指令快速修改照片(如“给这张旅行照的天空添加晚霞,同时让人物戴一顶草帽”),无需专业修图技能;

短视频素材编辑:短视频团队可批量处理素材(如“将所有视频封面中的产品LOGO统一换成新样式”),提升制作效率。

2. 设计与广告领域

UI/UX设计:设计师可快速迭代界面方案(如“将按钮颜色改为蓝色,字体换成微软雅黑,位置右移10像素”),减少手动调整时间;

广告图优化:企业可根据不同渠道需求修改广告图(如“将电商广告中的促销标签从左上角移到右下角,背景换成节日氛围”)。

3. 影像修复与存档

老照片修复:用户可修复家中老照片(如“去除照片上的折痕,将黑白照片上色,还原人物模糊的面部细节”);

历史影像处理:档案馆可批量修复历史资料(如“修补报纸扫描件中的破损文字,增强模糊的图表清晰度”)。

4. 教育与演示领域

教学素材制作:老师可快速修改课件插图(如“在细胞结构图中用红色标注细胞核,添加箭头指向细胞膜”);

演示文稿优化:职场人士可调整PPT配图(如“将图表中的数据柱颜色按数值从低到高渐变,添加网格线”)。

五、使用方法

UniWorld-V2提供了两种使用方式:直接调用预训练模型(适合非开发者)和基于源码二次开发(适合开发者),以下为详细步骤:

1. 环境准备

无论哪种方式,均需先配置运行环境:

硬件要求:建议使用NVIDIA GPU(显存≥16GB,如RTX 4090),CPU≥8核,内存≥32GB;

软件依赖:Python 3.10+,PyTorch 2.0+,Hugging Face Transformers、Diffusers库。

安装命令:

pip install torch transformers diffusers accelerate pillow

2. 直接调用预训练模型(快速上手)

UniWorld-V2的模型已发布于Hugging Face,可直接加载使用,示例代码如下:

from diffusers import AutoPipelineForImage2Image

from PIL import Image

# 加载模型(以FLUX.1-Kontext-Dev优化版为例)

pipeline = AutoPipelineForImage2Image.from_pretrained(

"chestnutlzj/UniWorld-FLUX.1-Kontext-Dev",

torch_dtype=torch.float16

).to("cuda")

# 加载原图

image = Image.open("input.jpg").convert("RGB")

# 定义编辑指令

prompt = "将画面中的小狗移到树底下,让它抬头看天空"

# 执行编辑

edited_image = pipeline(

prompt=prompt,

image=image,

strength=0.7, # 编辑强度(0-1,越高修改越明显)

guidance_scale=3.5

).images[0]

# 保存结果

edited_image.save("output.jpg")3. 基于源码二次开发(进阶使用)

若需修改模型逻辑或添加新功能,可从GitHub克隆源码:

git clone https://github.com/PKU-YuanGroup/Uniworld.git cd Uniworld/UniWorld-V2

核心开发目录说明:

flow_grpo/:DiffusionNFT核心逻辑代码;config/:模型参数配置文件;examples/:编辑示例(含输入图、指令、输出图);reproduction/:论文实验复现脚本。

例如,修改奖励模型的评分阈值(默认7分),可编辑config/reward.yaml中的threshold: 7为目标值。

六、常见问题解答(FAQ)

Q:UniWorld-V2支持多大分辨率的图像?

A:目前支持最大1024×1024分辨率,更高分辨率(如2048×2048)可通过分块处理实现,但可能影响编辑一致性。Q:运行模型需要付费吗?

A:UniWorld-V2的代码和模型权重开源免费,但FLUX.1-Kontext-Dev基础模型遵循非商业许可证(详见官方说明),商业使用需联系黑森林实验室获得授权。Q:编辑效果不理想怎么办?

A:可尝试调整strength参数(提高强度增强修改幅度),或优化指令描述(如“将红色车移到左侧”改为“将画面中红色的小轿车平移至左侧人行道边缘,车头朝东”)。Q:是否支持视频编辑?

A:目前仅支持单张图像编辑,视频编辑可通过逐帧处理实现,但需额外开发帧间一致性逻辑。Q:Windows系统可以运行吗?

A:支持,但需确保安装正确的CUDA驱动(建议CUDA 11.7+),Linux系统兼容性更佳。

七、相关链接

Hugging Face模型集合:

八、总结

UniWorld-V2是一款聚焦高精度图像编辑的开源工具,通过DiffusionNFT技术和基于MLLMs的无训练奖励模型,实现了对复杂指令的精准响应,在移动物体、修改细节、风格统一等任务上表现优于同类工具。其开源特性降低了技术门槛,支持开发者快速部署和二次开发,广泛适用于内容创作、设计、影像修复等场景,为AI图像编辑领域提供了实用且可扩展的解决方案。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/uniworld-v2.html