UNO-Bench:美团推出的开源全模态模型综合评估工具

一、UNO-Bench是什么?

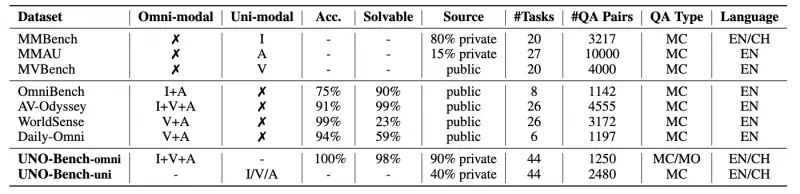

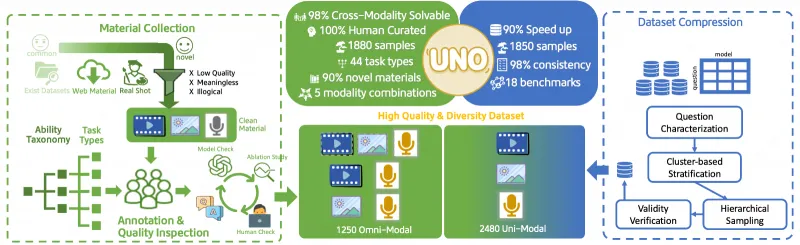

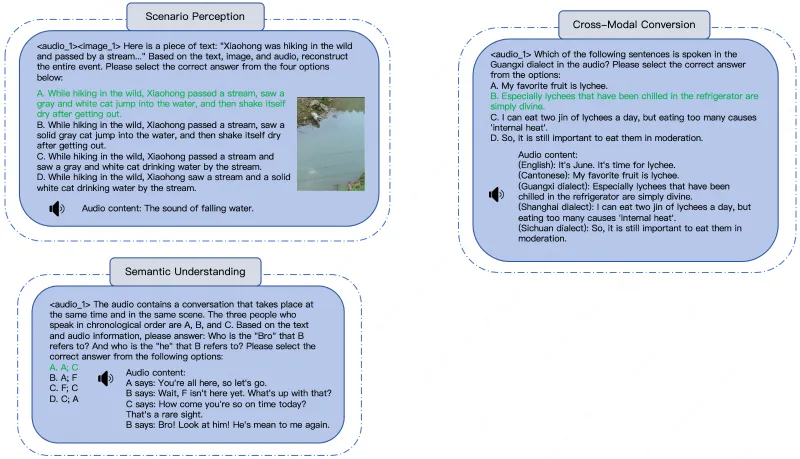

UNO-Bench是由美团LongCat团队开发的开源全模态模型评估基准,旨在系统衡量全模态模型的单模态(如音频、视觉)与全模态(跨模态)能力。该基准涵盖44种任务类型、5种模态组合,包含1250个人工构建的全模态样本和2480个增强的单模态样本,创新引入多步骤开放式问题评估复杂推理能力,并通过自动压缩技术实现高效测试。UNO-Bench不仅为模型研发提供了标准化评估工具,更揭示了单模态与全模态能力的组合定律,为全模态模型的优化方向提供了关键参考。

在人工智能领域,全模态模型(Omni Models)指能够同时处理文本、图像、音频、视频等多种模态信息,并实现跨模态理解与推理的模型(例如同时分析“一段视频+配套文字说明”并回答相关问题)。随着技术发展,全模态模型的应用场景日益广泛(如智能客服、自动驾驶、多模态内容生成等),但如何科学评估其能力却成为行业痛点:传统评估基准要么仅针对单一模态(如仅测图像识别),要么跨模态任务设计零散,难以统一衡量模型的综合性能。

UNO-Bench正是为解决这一问题而生的开源评估基准。其核心目标是:通过标准化的任务设计、高质量的数据集和创新的评估方法,帮助研究者和开发者全面了解全模态模型在单模态任务(如纯文本理解、纯音频识别)和全模态任务(如“图像+文本”跨模态推理)中的表现,并揭示两者之间的内在关联(即“组合定律”)。

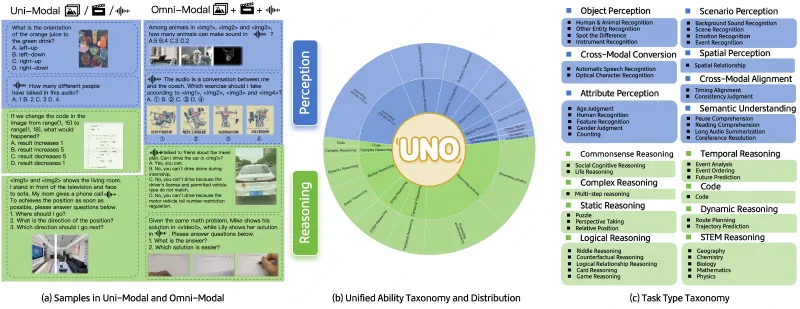

具体来说,UNO-Bench的核心构成包括:

任务体系:覆盖44种细分任务类型(如文本分类、图像分割、音频情感识别、“视频+文本”多步推理等),涵盖5种模态组合(单模态:文本、图像、音频、视频;全模态:跨两种及以上模态)。

数据集:包含1250个人工构建的全模态样本(确保跨模态可解性达98%)和2480个增强的单模态样本,数据来源兼顾真实场景(尤其贴合中文语境)与高质量公共资源。

评估工具:配套自动评分模型(支持6种题型,准确率达95%)、快速测试脚本(通过数据压缩技术提速90%),降低评估门槛。

二、功能特色

UNO-Bench的核心优势在于“统一、全面、高效、创新”,具体功能特色如下:

1. 统一的能力评估体系,打破模态壁垒

传统评估基准往往针对单一模态(如GLUE仅测文本、COCO仅测图像)或特定跨模态场景(如CLIP仅测“图像-文本匹配”),导致研究者难以对比模型在不同模态任务中的综合表现。UNO-Bench首次建立了覆盖“单模态→跨模态→全模态”的完整评估链条,通过统一的指标(如准确率、F1值、推理步数达标率)衡量模型在44种任务中的表现,让“全模态能力”有了可量化的对比标准。

例如:同一款模型可在UNO-Bench中同时测试“纯文本情感分析”“纯图像目标检测”“音频+文本语义匹配”“视频+图像+文本多步推理”等任务,最终输出综合能力得分,直观反映模型的短板(如单模态音频能力弱,或跨模态推理能力不足)。

2. 高质量数据集,兼顾真实性与可控性

数据集是评估基准的核心,UNO-Bench在数据构建上采用“人工标注+自动增强”结合的方式,确保质量与多样性:

真实场景导向:图像、视频多来自众包用户上传的日常生活场景(如家庭聚餐、街头交通);音频为20余人的真实对话录音(涵盖不同年龄、性别、方言口音);文本包含新闻、社交评论、产品描述等真实语料,尤其强化中文语境(如中文谐音梗、方言词汇的跨模态理解)。

人工严格质检:全模态样本由领域专家(如计算机视觉研究员、自然语言处理工程师)和大学生标注团队共同完成,标注后通过“模态消融实验”(如遮挡图像中的关键信息,验证模型是否依赖正确模态解题)确保跨模态关联性——最终98%的全模态样本可通过至少一种模态组合解出,避免“伪跨模态”问题(如仅通过文本即可答题,无需看图像)。

样本增强技术:单模态样本在公共数据集(如ImageNet、LibriSpeech)基础上进行自动增强(如文本同义词替换、图像轻微旋转、音频降噪处理),扩充至2480个,覆盖更多边缘场景(如模糊图像识别、嘈杂环境下的语音识别)。

3. 创新评估方式,聚焦复杂推理能力

传统多模态评估多采用选择题(如“以下哪个文本与图像匹配?”),难以衡量模型的复杂推理能力。UNO-Bench创新引入“多步骤开放式问题(Multi-Step Open-Ended, MO)”,要求模型通过多轮推理输出答案(而非选择选项),更贴近真实应用场景。

例如:

任务:给定一段“餐厅就餐”的视频(含画面和背景音)+ 文本“描述视频中顾客的情绪变化,并说明原因”。

要求:模型需先识别视频中的画面(如顾客皱眉、摆手)和音频(如抱怨“菜太咸”),再结合文本问题推理情绪变化(从“满意”到“不满”),最后输出完整逻辑链。

为支持这类开放式问题的高效评估,UNO-Bench配套了通用评分模型:通过微调大语言模型(如GPT-4、Qwen-7B),实现对6种题型(描述题、推理题、对比题等)的自动评分,经测试与人工评分的一致性达95%,大幅降低评估成本。

4. 高效测试工具,兼顾速度与准确性

全模态评估常因数据量大(如视频文件)导致测试耗时。UNO-Bench通过“聚类引导的分层抽样”技术,对18个公共基准的样本进行压缩:先通过聚类算法将相似样本分组,再从每组中抽取代表性样本,最终实现90%的规模压缩(如原10万样本缩减至1万),但保持98%的模型排名一致性(即压缩后模型的性能排序与原始数据一致)。

同时,项目提供轻量化测试脚本,支持单卡GPU运行(最低配置:NVIDIA GTX 1080Ti),全量任务测试耗时从传统的24小时缩短至2.5小时,适合中小团队快速验证模型效果。

表1:UNO-Bench与传统评估基准的核心差异

| 特性 | 传统评估基准(如COCO、GLUE) | UNO-Bench |

|---|---|---|

| 模态覆盖 | 单一模态或固定跨模态组合 | 单模态(4种)+全模态(跨多种) |

| 任务类型 | 1-5种细分任务 | 44种细分任务 |

| 评估题型 | 以选择题、分类题为主 | 多步骤开放式问题+传统题型 |

| 数据规模与效率 | 数据量大,测试耗时 | 压缩90%,耗时缩短至1/10 |

| 中文语境支持 | 较弱 | 强化中文场景与语料 |

| 单/全模态关联分析 | 无 | 支持组合定律量化分析 |

三、技术细节

UNO-Bench的技术核心体现在数据集构建、评估框架设计和组合定律验证三个方面,以下为具体解析:

1. 数据集构建流程

UNO-Bench的数据集构建遵循“来源筛选→标注质检→压缩增强”三步走流程,确保数据质量与效率:

来源筛选:

图像:50%来自美团众包用户上传的生活照(无版权风险),30%来自公开数据集(如Flickr30K),20%为人工拍摄的特定场景(如办公桌面、超市货架)。

音频:80%为真实对话录音(20名志愿者,涵盖普通话、粤语、四川话),20%来自LibriSpeech等公开语音库(经处理去除个人信息)。

视频:60%为众包用户拍摄的短视频(10-30秒,如街头事件、家庭活动),40%来自公开视频库(如UCF101)。

文本:70%为中文真实语料(新闻、评论、说明书),30%为英文翻译文本(确保多语言支持)。

标注与质检:

标注团队:由10名领域专家(负责任务设计)和30名大学生(负责样本标注)组成,标注内容包括“模态标签”(如图像中的物体、音频中的情感)和“任务答案”(如推理题的逻辑链)。

质检流程:

自动化检查:通过脚本验证“答案与模态的关联性”(如图像题答案是否在图像中可验证)。

人工复核:专家随机抽取20%样本,检查标注准确性,错误率需低于5%。

模态消融测试:对全模态样本,遮挡其中一种模态(如隐藏文本),验证模型是否仍能通过其他模态解题(确保跨模态必要性)。

数据压缩与增强:

文本:同义词替换、句式转换(如主动句变被动句)。

图像:随机裁剪、亮度调整、添加轻微噪声。

音频:语速调整(±10%)、背景 noise 叠加(如咖啡馆环境音)。

压缩技术:采用“聚类引导的分层抽样”,以图像为例:先通过ResNet提取图像特征,再用K-Means聚类(K=100),最后从每类中随机抽取10%样本,确保覆盖所有场景类型。

增强方法:单模态样本通过以下方式扩充:

2. 评估框架设计

UNO-Bench的评估框架可拆解为“任务类型划分”“模态组合定义”“评分指标设计”三部分:

任务类型划分:44种任务类型基于“能力维度”分类,涵盖5大方向(表2列出部分示例):

感知能力(如目标检测、语音识别);

理解能力(如文本语义匹配、图像场景分类);

推理能力(如多步逻辑推理、因果关系判断);

生成能力(如根据图像生成描述、根据音频生成文本摘要);

交互能力(如根据多模态输入生成对话回复)。

模态组合定义:明确5种模态组合的评估范围:

单模态:文本(T)、图像(I)、音频(A)、视频(V);

全模态:跨两种及以上模态(如T+I、A+V、T+I+A等)。

评分指标:根据任务类型选择适配指标:

分类/识别任务:准确率(Accuracy)、F1值;

生成任务:BLEU(文本生成)、CIDEr(图像描述);

推理任务:逻辑链完整度(Step Score,按推理步骤打分,满分10分);

综合能力:加权得分(各任务按重要性分配权重,总分100分)。

表2:UNO-Bench部分任务类型与模态组合示例

| 能力维度 | 任务类型示例 | 涉及模态组合 | 评分指标 |

|---|---|---|---|

| 感知能力 | 图像目标检测 | I | 准确率 |

| 理解能力 | 音频情感识别(喜/怒/中性) | A | F1值 |

| 推理能力 | “视频+文本”多步因果推理 | V+T | 逻辑链完整度 |

| 生成能力 | 根据“图像+音频”生成故事 | I+A | BLEU+人工评分 |

| 交互能力 | 多模态对话(文本+图像输入) | T+I | 回复相关性 |

3. 组合定律验证

UNO-Bench的核心发现是“单模态与全模态能力的组合定律”,其技术验证过程如下:

数据基础:在10款主流全模态模型(如Gemini-2.5-Pro、GPT-4V、Qwen-VL等)上运行UNO-Bench全量任务,记录各模型的单模态(音频、视觉)能力得分(P_Audio、P_Visual)和全模态能力得分(P_Omni)。

规律拟合:通过统计分析发现,P_Omni与P_Audio、P_Visual的乘积呈幂律关系,公式为:

$$ P_{\text{Omni}} = C \cdot (P_{\text{Audio}} \times P_{\text{Visual}})^{\alpha} + b $$

其中,C、α、b为常数(不同模型梯队的常数不同),α值反映协同效应强度(α>1为强协同,α<1为瓶颈效应)。结论:弱模型(如开源小模型)往往表现为“瓶颈效应”(α<1,全模态能力受限于最弱的单模态);强模型(如Gemini-2.5-Pro)表现为“协同促进”(α>1,单模态能力相互增强)。

四、应用场景

UNO-Bench作为全模态模型的评估工具,可广泛应用于模型研发、学术研究、产业落地等场景:

1. 全模态模型研发与优化

模型开发者可通过UNO-Bench定位模型短板:例如,若模型在“音频+文本”任务中得分低,但纯音频任务得分高,可能是跨模态融合模块存在缺陷;若单模态视觉任务得分低,则需优先优化视觉编码器。

以美团内部应用为例,其基于UNO-Bench测试自研全模态模型时,发现模型在“方言音频+中文文本”跨模态推理中得分仅62分(满分100),远低于行业平均的75分,进而针对性优化了方言语音识别模块和跨模态注意力机制,最终得分提升至81分。

2. 学术研究与理论验证

学术界可基于UNO-Bench探索全模态模型的能力边界:例如,验证“大模型参数规模与全模态能力的关系”“跨模态注意力机制的有效性”等理论假设。

例如,某高校团队通过UNO-Bench测试发现,当模型参数超过1000亿时,全模态能力的提升速度显著放缓(从每100亿参数提升5分降至2分),进而提出“模态融合效率瓶颈”理论,为模型架构创新提供了方向。

3. 企业级模型选型与落地

企业在引入全模态模型时,可通过UNO-Bench对比不同模型的适配性:例如,智能客服场景需重点关注“音频+文本”交互能力,自动驾驶场景需优先测试“视频+图像”实时推理能力。

某电商平台通过UNO-Bench测试3款候选模型,发现Model X在“商品图像+用户评论文本”的情感匹配任务中得分最高(89分),最终选择该模型优化“商品推荐-用户反馈”闭环,使推荐准确率提升12%。

4. 教育与培训

高校和培训机构可将UNO-Bench作为全模态模型教学的实践工具:通过可视化的评估结果,帮助学生理解“单模态能力如何影响全模态表现”,或通过修改样本数据(如添加噪声),观察模型鲁棒性变化。

五、使用方法

UNO-Bench提供了完整的开源工具链,支持本地部署和在线评估,以下为基础使用步骤:

1. 环境准备

硬件要求:最低配置为CPU i7-8700K、GPU NVIDIA GTX 1080Ti(11GB显存)、内存32GB;推荐配置为GPU NVIDIA A100(40GB显存),支持全量任务并行计算。

软件依赖:Python 3.8+、PyTorch 2.0+、Hugging Face Transformers、Datasets、OpenCV(图像处理)、Librosa(音频处理)。

安装依赖命令:

pip install torch transformers datasets opencv-python librosa pandas numpy

2. 获取数据集

UNO-Bench数据集已开源至Hugging Face,可直接下载:

from datasets import load_dataset

# 加载全量数据集(约10GB)

dataset = load_dataset("meituan-longcat/UNO-Bench")

# 加载轻量版(压缩后,约1GB)

dataset_light = load_dataset("meituan-longcat/UNO-Bench", "light")数据集包含train(训练集,用于模型微调)、test(测试集,用于评估)两个子集,每个样本包含“模态数据”(如image、audio、text字段)和“任务信息”(如task_type、answer字段)。

3. 运行评估脚本

项目提供统一评估脚本evaluate.py,支持指定模型和任务类型:

# 评估指定模型在全量任务上的表现 python evaluate.py \ --model_path "your_model_path" \ # 模型本地路径或Hugging Face模型名 --task_type "all" \ # 任务类型:all/vision/audio/omni等 --output_dir "results/" # 结果保存路径

脚本会自动加载数据集、运行模型推理、调用评分工具,并生成HTML格式的评估报告(包含各任务得分、综合排名、可视化图表)。

4. 自定义评估

若需评估自研模型,只需实现BaseModel接口(定义predict方法,输入模态数据,输出预测结果):

from base_model import BaseModel class YourModel(BaseModel): def predict(self, sample): # sample包含text、image、audio等字段 # 实现模型推理逻辑,返回预测结果 return prediction # 传入自定义模型运行评估 python evaluate.py --model_cls "YourModel" --model_path "your_model_path"

六、常见问题解答(FAQ)

UNO-Bench的数据集支持多语言吗?

主要支持中文和英文,其中中文样本占比60%(含方言相关任务),英文占比40%。未来计划添加日文、韩文样本,可关注GitHub更新。全量数据集10GB,下载缓慢怎么办?

推荐使用轻量版(1GB),包含核心任务样本,评估结果与全量版一致性达95%;或通过迅雷等工具加速下载,Hugging Face支持断点续传。自动评分模型的准确率如何保证?

自动评分模型基于10万+人工标注样本训练,在6种题型上与人工评分的平均一致性达95%;对高难度推理题,可开启“人工复核模式”(在评估脚本中添加--human_review True)。UNO-Bench的数据集和工具是否可商用?

遵循MIT许可证,允许商用,但需保留原作者信息(详见LICENSE文件);数据集不含侵权内容,可放心用于商业模型的测试与优化。

七、相关链接

数据集(Hugging Face):https://huggingface.co/datasets/meituan-longcat/UNO-Bench

技术报告(arXiv):https://arxiv.org/abs/2510.18915

八、总结

UNO-Bench作为首个统一的全模态模型评估基准,通过覆盖44种任务类型、5种模态组合的高质量数据集,结合创新的多步骤开放式问题评估与高效测试工具,为全模态模型的研发、优化与选型提供了标准化解决方案。其核心价值不仅在于提供“评估工具”,更在于揭示了单模态与全模态能力的组合定律,为行业理解全模态模型的发展规律提供了关键参考。无论是学术界探索理论边界,还是企业级落地应用,UNO-Bench都能通过直观、量化的评估结果,推动全模态技术向更高效、更可靠的方向发展。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/uno-bench.html