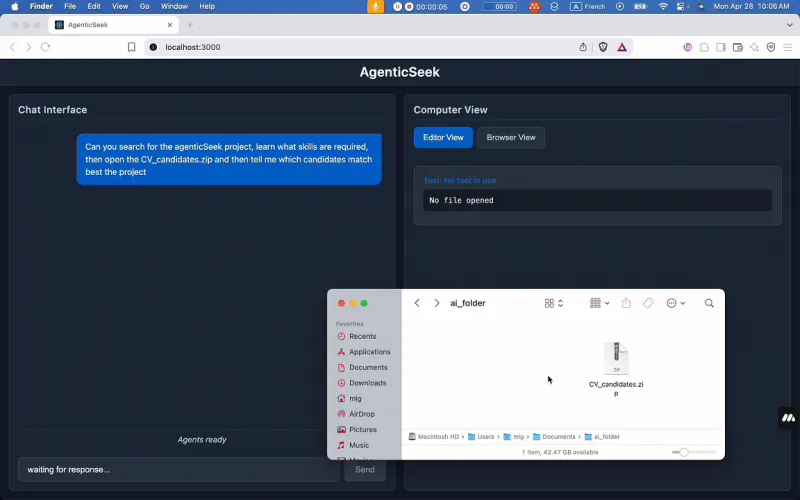

AgenticSeek:100%本地运行的Manus AI替代方案,隐私保护与多代理协同的智能助手

一、AgenticSeek是什么?

AgenticSeek是一款100%本地运行的开源AI智能体工具,定位为Manus AI的替代方案,专注于隐私保护与本地自主能力。它支持智能网页浏览、多语言编程辅助、复杂任务规划等功能,通过多代理协同机制实现高效任务处理,所有数据均在用户设备本地运行,无需依赖云端服务。适用于注重隐私的个人用户、开发者及企业,可满足自主编程、信息整理、项目规划等多样化需求。

该项目最初源于个人副业开发,因功能贴合用户对“本地隐私AI”的需求,登上GitHub Trending后快速获得开源社区关注,目前处于活跃开发阶段,依赖社区贡献持续迭代。其设计理念是让AI智能体像“本地专家团队”一样,自主完成复杂任务,同时确保用户对数据的绝对控制权。

二、功能特色

AgenticSeek的功能围绕“本地运行”“自主能力”“多代理协作”三大核心展开,具体特色如下:

1. 完全本地运行,隐私绝对可控

所有操作均在用户设备(电脑/服务器)本地执行,数据存储、模型计算、任务处理全程不联网、不上云。无论是个人隐私信息(如病历、财务数据)、企业敏感内容(如项目文档、客户资料),还是临时处理的文件,均不会被上传至第三方服务器,从底层保障数据安全。

2. 智能网页自主浏览

内置网页代理模块,支持全自动网页操作:

自主搜索:根据用户需求(如“查找2025年人工智能行业报告”),自动访问搜索引擎(如配置的SearxNG本地服务),筛选并提取关键信息;

信息提取:自动识别网页中的文本、表格、图片(非涉密场景),按用户要求整理为结构化内容(如Markdown、Excel);

表单交互:支持自动填写简单网页表单(如登录常用平台、提交预约信息),减少重复操作。

3. 多语言自主编程助手

覆盖主流编程语言,提供全流程开发支持:

代码生成:根据需求描述(如“写一个Python脚本批量处理CSV文件”),自动生成可运行代码;

调试优化:检测代码错误(如语法问题、逻辑漏洞),自动修复并给出优化建议;

跨语言转换:支持Python与C、Go、Java等语言的代码互转(如将Python数据处理脚本转为Go版本以提升性能);

本地运行:直接调用本地环境运行代码,输出结果并生成执行日志。

4. 智能代理选择与协同

采用“代理池”机制,根据任务类型自动匹配最合适的AI代理:

代理类型:包括“网页代理”(专注信息获取)、“编程代理”(专注代码开发)、“文档代理”(专注文件解析)、“规划代理”(专注任务拆解)等;

协同工作:复杂任务(如“开发一个带网页界面的数据分析工具”)会被“规划代理”拆解为“需求分析→前端代码生成→后端逻辑开发→数据接口调试”等步骤,再分配给对应代理协作完成,全程无需人工干预。

5. 复杂任务规划与执行

支持将大型任务拆解为可执行的子步骤,并按逻辑顺序推进:

任务拆解:例如“规划一场7天的日本旅行”会被拆解为“确定目的地→查询签证要求→预订机票酒店→制定每日行程→整理注意事项”;

动态调整:若某一步骤受阻(如“酒店满房”),系统会自动重新规划(如更换同区域酒店、调整行程顺序);

结果汇总:任务完成后,自动生成结构化报告(如旅行计划文档、项目进度表)。

6. 多语言支持与语音交互(开发中)

多语言适配:文档与交互界面支持中文(简/繁)、英文、法语、日语、西班牙语、葡萄牙语等,满足跨地区用户需求;

语音交互:正在开发语音输入输出功能,未来可通过自然对话下达指令(如“帮我查一下明天的天气,并用邮件发给同事”),提升交互便捷性。

三、技术细节

1. 架构设计

AgenticSeek采用模块化架构,核心模块包括:

用户交互层:提供命令行界面(CLI)与Web界面(基于Flask开发),支持文本输入与任务提交;

代理调度中心:核心模块,负责解析用户需求、匹配代理类型、分配子任务,并监控任务进度;

代理执行层:包含各类型代理(网页、编程、文档等),每个代理内置专项处理逻辑(如网页代理的爬虫与解析工具、编程代理的代码生成器);

本地资源管理器:管理本地文件、模型、运行环境(如Python虚拟环境、Docker容器),确保数据与工具的本地化调用;

LLM接口层:适配主流开源大模型(如Llama 3、Mistral、Qwen等),支持模型本地部署与调用。

2. 技术栈依赖

| 类别 | 核心技术/工具 | 作用 |

|---|---|---|

| 开发语言 | Python 3.10.x | 核心逻辑开发,兼容多数AI框架 |

| 容器化 | Docker Engine、Docker Compose | 部署配套服务(如SearxNG本地搜索引擎) |

| 网页处理 | BeautifulSoup、Selenium | 网页解析与自动化操作 |

| 代码处理 | AST(抽象语法树)、Pylint | 代码生成、调试与优化 |

| LLM集成 | llama.cpp、transformers | 本地大模型加载与调用 |

| 配置管理 | python-dotenv | 环境变量与参数配置 |

3. 本地运行实现机制

数据流向:用户输入→本地交互层→代理调度中心→本地代理执行→结果返回本地存储,全程无外部网络传输;

模型部署:大模型需用户手动下载至本地(支持通过Hugging Face等平台获取),存储路径配置在.env文件中,由LLM接口层直接调用;

依赖隔离:通过Docker容器隔离SearxNG等服务,避免与本地环境冲突;通过Python虚拟环境管理项目依赖,确保版本兼容性。

4. 模型支持与硬件要求

AgenticSeek支持不同参数规模的开源大模型,硬件要求随模型大小递增,具体如下:

| 模型参数规模 | 最低VRAM要求 | 推荐显卡型号 | 适用场景 |

|---|---|---|---|

| 7B | 8GB | RTX 3050/GTX 1660 | 简单文本处理、基础问答 |

| 14B | 12GB | RTX 3060/RTX 4060 | 代码生成、网页信息提取 |

| 32B | 24GB | RTX 3090/RTX 4090 | 复杂任务规划、多代理协作 |

| 70B+ | 48GB+ | RTX A6000/多卡协同 | 企业级复杂场景(如项目开发) |

注:若设备显存不足,可启用CPU模式(性能会显著下降,仅推荐测试使用)。

四、应用场景

AgenticSeek的本地隐私特性与多代理能力,使其适用于多种场景:

1. 个人隐私敏感场景

医疗数据处理:整理个人病历、分析体检报告(数据本地存储,避免泄露);

财务信息管理:自动汇总银行流水、生成支出报表(无需上传至云端财务工具);

私密文档处理:解析加密文件、提取关键信息(如合同条款、个人日记)。

2. 开发者日常工作

代码开发辅助:自动生成API文档、批量修复代码规范问题(如PEP8格式);

跨语言学习:将Python项目转为Go代码,并生成逐行注释,辅助理解新语言;

本地工具开发:快速开发小工具(如日志分析脚本、文件格式转换器),全程本地调试。

3. 复杂任务规划

旅行规划:根据预算、时间、兴趣自动生成行程,包含签证要求、交通接驳、景点预约等细节;

项目管理:拆解“产品上线”任务为“需求调研→原型设计→开发排期→测试计划”,并分配时间节点;

学术研究:自动搜索文献、提取核心观点、整理参考文献列表(支持本地LaTeX格式生成)。

4. 教育与学习

编程学习:针对“排序算法”等知识点,自动生成示例代码、调试步骤及常见错误解析;

语言学习:根据用户水平生成双语对话练习、语法纠错,并调用本地词典工具辅助记忆;

资料整理:将课程视频脚本、课件文档合并,自动生成思维导图与复习重点。

5. 企业内部工具

敏感数据处理:分析客户信息、项目报价单(符合数据合规要求,不泄露商业机密);

内部流程自动化:自动填写报销表单、生成会议纪要,并同步至本地共享文件夹;

多团队协作:市场、技术、运营团队的任务通过本地代理协同推进,数据不流出企业内网。

五、使用方法

1. 环境准备

(1)软件依赖

Git:用于克隆仓库(下载地址:https://git-scm.com/downloads);

Python 3.10.x:推荐3.10.12版本(避免依赖兼容问题,下载地址:https://www.python.org/downloads/);

Docker Engine与Docker Compose:用于运行SearxNG等配套服务(安装指南:https://docs.docker.com/get-docker/)。

(2)硬件检查

根据计划使用的模型参数,确认设备显存满足要求(参考“技术细节-模型支持与硬件要求”),并确保磁盘空间充足(至少预留50GB,用于存储模型与项目文件)。

2. 安装步骤

| 步骤 | 操作说明 | 命令/操作 |

|---|---|---|

| 1 | 克隆仓库并进入目录 | git clone https://github.com/Fosowl/agenticSeek.git && cd agenticSeek |

| 2 | 配置环境变量 |

复制示例配置文件:mv .env.example .env编辑.env:设置WORK_DIR(工作目录)、LLM_PORT(模型服务端口)等参数 |

| 3 | 安装Python依赖 | pip install -r requirements.txt |

| 4 | 启动Docker配套服务(如SearxNG本地搜索引擎) | docker-compose up -d |

| 5 | 下载并配置LLM模型 |

1. 从Hugging Face等平台下载模型(如Llama 3 8B) 2. 在.env中设置模型路径: MODEL_PATH=/path/to/your/model |

| 6 | 启动AgenticSeek | python main.py |

3. 基础操作

首次启动:运行后会显示命令行界面,输入“help”可查看支持的指令(如“task [任务描述]”提交任务、“agents”查看可用代理);

提交任务:例如输入“task 帮我写一个Python脚本,批量将CSV文件转为Excel”,系统会自动调用“编程代理”处理;

查看结果:任务完成后,结果会保存至WORK_DIR指定的目录(默认./output),并在界面显示路径;

切换语言:输入“lang zh-CN”切换为简体中文,“lang en”切换为英文(支持多语言列表见项目文档)。

六、常见问题解答(FAQ)

1. 设备显存不足,无法运行大模型怎么办?

答:可尝试以下方案:

选择更小参数的模型(如7B模型),牺牲部分性能换取兼容性;

启用CPU模式(在.env中设置

USE_CPU=True),但处理速度会显著下降(仅推荐测试);若设备支持,可通过“模型量化”(如4-bit量化)减少显存占用(需使用llama.cpp等工具预处理模型)。

2. 启动时Docker报错“port is already allocated”(端口被占用)怎么办?

答:这是因为SearxNG默认端口(8080)被其他程序占用,解决方案:

关闭占用8080端口的程序(可通过

netstat -tuln查看端口占用情况);修改docker-compose.yml中SearxNG的端口映射(如将

8080:8080改为8081:8080),并同步更新.env中的SEARXNG_URL为http://localhost:8081。

3. 支持哪些开源大模型?是否需要付费?

答:支持所有兼容llama.cpp或transformers格式的开源模型(如Llama 3、Mistral、Qwen、Phi-3等),无需付费,用户需自行从合法渠道(如Hugging Face、模型作者官网)下载。不支持闭源模型(如GPT-4、Claude)。

4. 如何切换不同的代理处理任务?

答:系统默认自动匹配代理,若需手动指定,可在提交任务时添加代理类型,例如:

“task [代理类型] 任务描述”,如“task code 写一个Java冒泡排序算法”(强制使用编程代理);

支持的代理类型:web(网页)、code(编程)、doc(文档)、plan(规划)。

5. 语音交互功能何时可用?如何体验?

答:语音交互目前处于开发中,尚未合并至主分支。若想测试,可切换至开发分支:git checkout dev-voice,并按照分支下的README安装额外依赖(如语音识别库Whisper、TTS工具),但功能可能不稳定。

七、相关链接

八、总结

AgenticSeek作为100%本地运行的开源AI智能体平台,以隐私保护为核心优势,通过多代理协同机制实现智能网页浏览、自主编程、复杂任务规划等功能,所有数据处理均在用户设备本地完成,适用于注重隐私的个人、开发者及企业。其模块化架构与开源特性支持灵活扩展,虽处于活跃开发阶段,但已能满足多种场景的基础需求,是本地AI工具领域的重要探索。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/agenticseek.html