AutoPR:开源学术推广自动化框架,智能生成多平台论文推广内容

一、AutoPR是什么

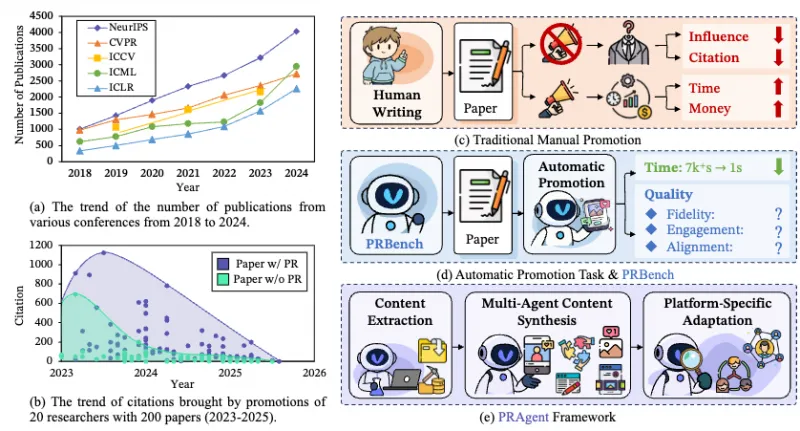

AutoPR是一款面向科研学者的开源学术推广自动化框架,基于大语言模型构建,核心包含PRAgent智能体框架与PRBench基准数据集两大模块。该工具可自动将学术论文转化为适配不同社交媒体平台的推广内容,同时提供标准化的评估基准,解决学者在成果传播过程中效率低、受众覆盖面窄的问题,助力科研成果快速触达公众与行业社群。

简单来说,AutoPR就像是学者的“专属学术推广助手”:输入一篇论文的PDF文件或相关信息,它就能自动分析论文的核心创新点、研究价值与应用场景,然后根据不同社交媒体平台的传播特性(如Twitter的简洁性、LinkedIn的专业性、知乎的深度性),生成风格适配、内容精准的推广文案。同时,AutoPR还提供了一套完整的评估基准,让开发者可以对不同生成模型的效果进行量化对比,推动学术推广自动化技术的迭代升级。

二、功能特色

AutoPR的核心优势在于“模块化设计、多平台适配、标准化评估”三大特性,具体功能特色可分为以下5个维度,详细内容如下表所示:

| 功能模块 | 核心特色 | 具体作用 | 适用场景 |

|---|---|---|---|

| PRAgent智能体框架 | 模块化架构、多平台适配、内容个性化 | 1. 解析论文结构(摘要、引言、实验结果等);2. 提取核心创新点与研究价值;3. 针对不同社交平台生成差异化推广文案;4. 支持自定义文案风格(严谨/活泼/科普向) | 学者快速生成论文推广内容、科研团队批量传播研究成果 |

| PRBench基准数据集 | 双子集设计、标准化评估指标、数据可追溯 | 1. 包含Core(核心子集,小而精)与Full(完整子集,大而全)两个版本;2. 提供统一的评估指标(如内容忠实度、可读性、传播潜力);3. 支持不同生成模型的效果对比 | 学术推广模型的研发与优化、相关算法的性能测试 |

| 多模态输入支持 | 兼容PDF、文本、论文链接等多种格式 | 支持直接输入论文PDF文件、论文标题+摘要文本,或arXiv论文链接,无需复杂的格式转换 | 不同数据源的论文推广需求 |

| 灵活的配置选项 | 支持自定义LLM接口、文案长度与风格 | 可对接OpenAI、智谱AI等主流大语言模型;允许用户设置文案字数上限、关键词强调程度;支持切换“学术严谨型”“大众科普型”等风格模式 | 个性化推广需求、不同算力条件下的模型部署 |

| 开源可扩展 | 代码开源、模块化易二次开发 | 所有代码托管于GitHub,遵循开源协议;模块化架构允许开发者新增平台适配模块、优化文本生成算法 | 开发者二次开发、科研机构定制化部署 |

除了上述核心功能,AutoPR还具备两个显著的特色优势:

内容忠实度高:PRAgent智能体在生成文案时,会严格基于论文原文内容,避免过度夸大或歪曲研究成果,确保推广内容的学术严谨性。

零门槛使用:无需深厚的编程基础,通过简单的命令行指令即可完成文案生成;同时提供详细的文档与示例,新手也能快速上手。

三、技术细节

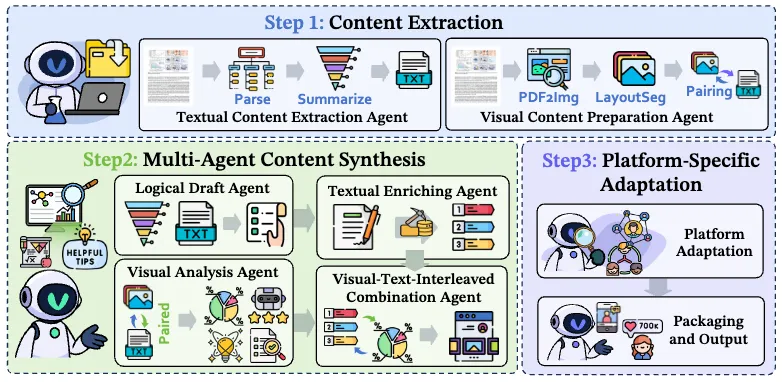

AutoPR的技术架构由“论文解析层、内容生成层、评估层”三个核心层级组成,各层级协同工作,实现从论文输入到推广文案输出的全流程自动化。

(一)整体技术架构

论文解析层 这是AutoPR的基础层,核心作用是将非结构化的论文内容转化为结构化的信息。该层级集成了DocLayout-YOLO模型——一款专门用于文档结构解析的深度学习模型,其核心功能包括:

值得注意的是,DocLayout-YOLO模型需要用户手动下载并配置路径,这是因为该模型体积较大,未包含在AutoPR的默认依赖中,以减小项目的安装包大小。

论文结构识别:自动识别论文的标题、摘要、关键词、引言、实验方法、实验结果、结论等核心模块;

关键信息提取:基于自然语言处理(NLP)技术,提取论文的研究问题、核心创新点、实验数据、应用价值等关键信息;

格式标准化:将不同格式的论文(如PDF、文本)转化为统一的结构化数据,为后续的内容生成提供输入。

内容生成层 这是AutoPR的核心层,由PRAgent智能体框架驱动,其核心技术是大语言模型(LLM)的提示工程(Prompt Engineering)。PRAgent的工作流程分为3个步骤:

PRAgent的模块化设计允许开发者新增自定义的平台模板,例如针对知乎、小红书等中文平台的风格模板,只需按照统一的格式编写模板文件,即可实现新平台的适配。

第一步:需求建模:根据用户选择的目标平台(如Twitter、LinkedIn),加载对应的平台风格模板。例如,Twitter模板强调“简洁、有吸引力、带话题标签”,而LinkedIn模板则更注重“专业性、逻辑清晰、突出研究价值”。

第二步:信息融合:将论文解析层提取的结构化信息,与平台风格模板进行融合,生成针对LLM的提示词。提示词的设计遵循“指令+上下文+约束条件”的原则,例如:“请基于以下论文摘要,生成一篇适用于Twitter的推广文案,字数不超过280字,突出核心创新点,结尾添加#学术推广 #人工智能 两个话题标签”。

第三步:文案生成与优化:将提示词发送至配置好的LLM接口,获取初步生成的文案;然后通过内置的优化算法,对文案进行润色(如调整语序、修正语法错误、增强感染力),最终输出符合要求的推广内容。

评估层 这是AutoPR的特色层,基于PRBench基准数据集构建,旨在为学术推广文案的生成效果提供标准化的量化评估。PRBench的技术特点如下:

双子集设计:Core子集包含100篇涵盖不同学科的论文及对应的人工标注推广文案,适用于快速测试;Full子集包含1000篇论文数据,适用于大规模模型训练与评估。

多维度评估指标:提供3类核心评估指标,分别是内容忠实度(文案与论文原文的一致性)、可读性(公众理解的难易程度)、传播潜力(文案的吸引力与分享意愿)。这些指标通过人工标注与自动计算相结合的方式得出。

评估流程自动化:用户只需运行指定的脚本,即可自动将生成的文案与PRBench中的人工标注文案进行对比,输出量化的评估分数,帮助用户判断生成效果的优劣。

(二)技术依赖与核心组件

AutoPR的运行依赖以下核心技术组件,各组件的作用与版本要求如下:

编程语言:Python 3.11(推荐版本,兼容Python 3.9-3.11);

大语言模型接口:支持OpenAI API、Hugging Face Transformers(本地模型部署);

文档解析组件:DocLayout-YOLO(文档结构解析)、PyPDF2(PDF文件读取);

数据处理组件:Pandas(结构化数据处理)、Numpy(数值计算);

评估组件:Scikit-learn(指标计算)、NLTK(文本可读性分析)。

四、应用场景

AutoPR的应用场景覆盖学术研究、科研管理、技术开发三大领域,具体可分为以下6个细分场景:

(一)学者个人学术成果推广

这是AutoPR最核心的应用场景。对于独立研究者或博士生来说,无需花费数小时撰写社交文案,只需输入论文PDF文件,选择目标平台,就能在几分钟内生成高质量的推广内容。例如:

在Twitter上发布简洁的论文亮点+链接,吸引同行关注;

在LinkedIn上发布深度科普文案,展示研究成果的行业价值,吸引企业合作;

在知乎、小红书等中文平台发布科普文章,提升公众对研究领域的认知。

(二)科研团队批量成果传播

高校实验室或科研团队往往会同时产出多篇论文,AutoPR可以帮助团队实现**“批量推广”**:通过编写简单的脚本,批量输入多篇论文的信息,生成适配不同平台的推广文案,然后统一发布,大幅提升团队成果的传播效率。

(三)学术期刊/会议的成果宣传

学术期刊和会议可以利用AutoPR,为发表的论文生成推广文案,发布在官方社交媒体账号上,提升期刊/会议的影响力。例如,某人工智能会议可以用AutoPR为录用的顶会论文生成Twitter文案,附带会议官网链接,吸引更多学者投稿。

(四)学术推广自动化模型的研发

对于AI领域的开发者来说,PRBench基准数据集是宝贵的研究资源。开发者可以基于PRBench训练新的学术推广生成模型,然后利用AutoPR的评估工具,对比新模型与现有模型的效果,加速技术迭代。

(五)科研机构的科普内容创作

科研机构(如中科院、高校科普中心)需要大量的科普内容来提升公众科学素养。AutoPR可以将机构内的研究成果转化为通俗易懂的科普文案,用于公众号、短视频脚本等内容创作,降低科普内容的制作成本。

(六)企业研发部门的技术传播

企业研发部门在发布新技术、新专利时,需要向客户、合作伙伴展示技术价值。AutoPR可以将技术白皮书、专利文档转化为专业的推广文案,发布在企业官网或行业媒体上,提升技术的商业影响力。

五、使用方法

AutoPR的使用流程分为**“环境搭建、配置设置、核心功能使用”**三个步骤,全程无需复杂的编程操作,新手也能快速上手。

(一)环境搭建

创建并激活Conda环境 推荐使用Conda管理Python环境,避免与其他项目的依赖冲突。打开终端,执行以下命令:

# 创建名为autopr的环境,指定Python版本为3.11 conda create -n autopr python=3.11 # 激活环境 conda activate autopr

若未安装Conda,可参考Anaconda官方文档进行安装。

克隆仓库并安装依赖 首先从GitHub克隆AutoPR仓库,然后安装项目所需的依赖包:

# 克隆仓库 git clone https://github.com/LightChen233/AutoPR.git # 进入项目目录 cd AutoPR # 安装依赖 pip install -r requirements.txt

依赖安装完成后,即可进行下一步配置。

(二)配置设置

AutoPR的核心配置是大语言模型接口与文档解析模型路径,具体步骤如下:

配置LLM接口 复制项目中的

.env.example文件,并重命名为.env:cp .env.example .env

用文本编辑器打开

.env文件,根据使用的LLM类型,填写对应的配置信息。以OpenAI API为例:# OpenAI API基础地址 OPENAI_API_BASE="https://api.openai.com/v1" # OpenAI API密钥 OPENAI_API_KEY="sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx" # 默认使用的模型(如gpt-3.5-turbo) DEFAULT_MODEL="gpt-3.5-turbo"

若使用本地部署的模型(如Llama 2),则需要修改配置文件中的模型路径与接口类型,具体可参考项目的官方文档。

配置DocLayout-YOLO模型路径 从Hugging Face下载DocLayout-YOLO模型文件,保存到本地的指定目录(如

./models)。然后在运行评估脚本时,通过--model-path参数指定模型路径。

(三)核心功能使用

AutoPR的核心功能包括“PRAgent文案生成”和“PRBench模型评估”,以下是具体的使用教程:

PRAgent文案生成 目前AutoPR的文案生成功能主要通过Python脚本调用,基本用法如下:

from pragent import PRAgent # 初始化PRAgent,指定LLM配置 agent = PRAgent(model_name="gpt-3.5-turbo", api_key="your_api_key") # 输入论文信息(以摘要为例) paper_abstract = """本文提出了一种新的深度学习模型,用于图像分割任务。该模型通过引入注意力机制,显著提升了分割精度,在Cityscapes数据集上的mIoU指标达到了85.2%,优于现有主流模型。""" # 生成适配Twitter的推广文案 twitter_post = agent.generate_post( content=paper_abstract, platform="twitter", max_length=280, hashtags=["#ComputerVision", "#ImageSegmentation"] ) # 打印生成的文案 print(twitter_post)

执行上述脚本后,即可得到一篇适配Twitter的推广文案。

PRBench模型评估 PRBench的评估流程分为**“数据集下载”和“模型评估”**两个步骤,通过命令行脚本完成:

步骤1:下载PRBench数据集 运行以下命令下载核心子集(Core)的数据集,保存到

./eval目录:python download_and_reconstruct_prbench.py \ --repo-id yzweak/PRBench \ --subset core \ --output-dir eval

若需下载完整子集(Full),只需将

--subset core改为--subset full。步骤2:运行评估脚本 下载DocLayout-YOLO模型后,运行以下命令进行模型评估:

python evaluate.py \ --dataset-dir ./eval \ --model-path ./models/doclayout_yolo_docstructbench_imgsz1024.pt \ --output-result ./eval_result.json

评估完成后,结果会保存到

eval_result.json文件中,包含不同指标的得分。

六、常见问题解答

Q:安装依赖时出现“版本冲突”错误怎么办?

A:这是因为本地Python环境中已安装的部分包与AutoPR的依赖版本不兼容。解决方案是:严格按照教程使用Conda创建新环境,避免使用系统全局Python环境;若仍出现冲突,可手动指定冲突包的版本,例如pip install pandas==2.0.0。

Q:配置.env文件后,运行脚本提示“API密钥无效”怎么办?

A:首先检查API密钥是否填写正确,注意不要包含空格或引号;其次确认LLM服务是否正常(如OpenAI API是否处于可用状态);最后检查网络连接,确保能正常访问LLM的API地址。

Q:输入论文PDF后,无法提取关键信息怎么办?

A:这可能是因为PDF文件存在加密或格式损坏的情况。解决方案是:将PDF文件转换为文本格式后再输入;或者检查DocLayout-YOLO模型路径是否配置正确,确保模型文件未损坏。

Q:生成的文案质量不高,与论文内容不符怎么办?

A:可以通过以下方式优化:① 更换更强大的LLM模型(如从gpt-3.5-turbo升级为gpt-4);② 调整提示词的参数,增加对核心创新点的强调;③ 在输入时提供更详细的论文信息(如实验结果、结论),而不仅仅是摘要。

Q:运行PRBench评估脚本时,提示“找不到数据集文件”怎么办?

A:检查--dataset-dir参数是否指向正确的数据集目录;确认数据集下载脚本是否执行成功,./eval目录下是否有train.json和test.json文件;若下载失败,可手动从PRBench的Hugging Face仓库下载数据集。

Q:如何新增自定义的社交平台模板?

A:在./pragent/templates目录下创建新的模板文件(如zhihu.json),按照现有模板的格式编写平台风格指令、字数限制、标签要求等内容,然后在代码中引入该模板即可。

Q:AutoPR是否支持中文论文的推广文案生成?

A:是的,只需选择支持中文的LLM模型(如GPT-4、智谱清言),并编写中文平台的模板,即可实现中文论文的文案生成。目前项目的默认模板以英文平台为主,中文模板需要用户自行添加。

七、相关链接

DocLayout-YOLO模型:https://huggingface.co/juliozhao/DocLayout-YOLO-DocStructBench

八、总结

AutoPR作为一款开源的学术推广自动化框架,通过PRAgent智能体框架与PRBench基准数据集的有机结合,为学者和开发者提供了“论文解析—内容生成—效果评估”的全流程解决方案,既解决了学者手动撰写推广文案的效率痛点,又为学术推广自动化技术的研发提供了标准化的评估工具。其模块化的设计、多平台的适配能力与开源可扩展的特性,使其不仅适用于学者个人的成果传播,还能满足科研团队、期刊会议、企业研发部门等多类用户的需求。相比于传统的学术推广方式,AutoPR在降低时间成本、提升内容传播效果方面具有显著优势,是连接学术研究与公众传播的重要桥梁,为科研成果的影响力提升提供了全新的技术路径。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/autopr.html