BabyVision:UniPat-AI开源的多模态大模型视觉推理评估基准

一、BabyVision是什么

BabyVision是一款面向多模态大模型(MLLM)和图像生成模型的纯视觉推理能力开源评估基准,由UniPat-AI团队联合红杉中国xbench共同开发,隶属于xbench双轨评估体系中AGI Tracking系列的多模态评估集。该项目的核心使命是量化当前顶尖人工智能模型在基础视觉推理能力上的短板——具体来说,就是检测这些在语言推理领域达到博士级水平的AI,在3岁儿童可轻松完成的纯视觉任务中表现如何,并通过标准化的评测体系,清晰呈现AI与人类在视觉原子能力上的系统性差距。

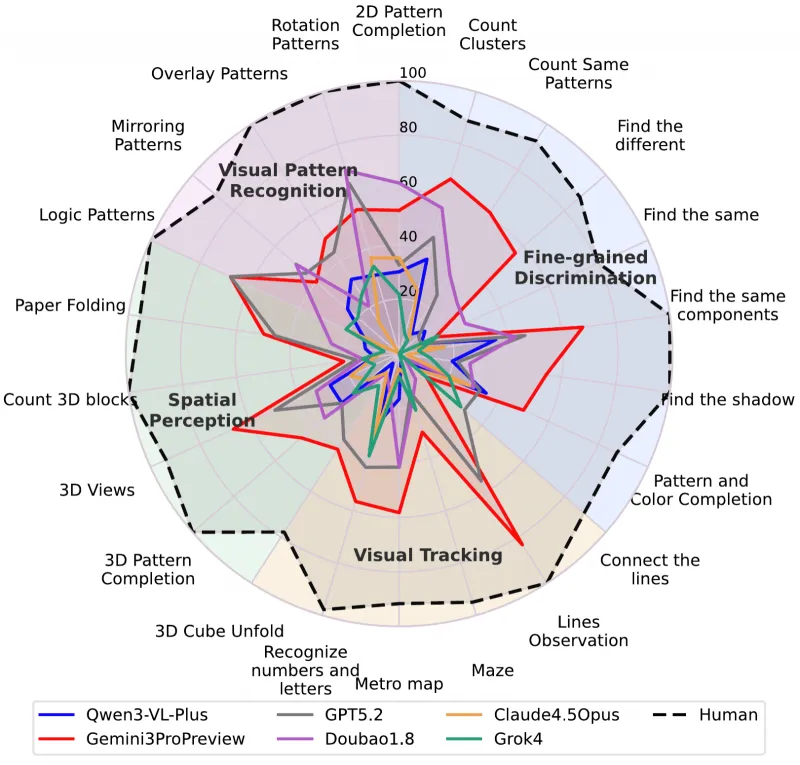

在设计理念上,BabyVision彻底打破了传统视觉评测对语言的依赖:所有题目答案均需通过视觉信息本身推导得出,避免模型借助语言推理能力“绕开”视觉理解的核心问题。研究团队通过对比实验发现,当前绝大多数顶尖多模态模型在BabyVision的测试中,得分甚至低于3岁儿童的平均水平,即便是表现最优的闭源模型,正确率也不足50%,而人类完成相同测试的准确率可达94.1%。这一结果直接揭示了一个关键问题:当前AI的视觉能力尚未掌握构成智能地基的基础视觉原子能力,而BabyVision正是为精准定位、量化这一问题而生的工具。

简单来说,BabyVision就像是给AI出的一套“幼儿园视觉考卷”,考卷里的题目不需要复杂的语言理解,只需要“看懂”图像中的细节、路径、空间关系和规律,而这套考卷的最终目的,是帮助AI研究者找到模型视觉能力的薄弱环节,为后续的技术优化提供明确方向。

二、功能特色

BabyVision作为一款聚焦基础视觉推理能力的评估基准,区别于传统多模态评测工具的核心特色体现在评测定位、任务设计、数据质量、评测维度、技术创新五大方面,具体如下:

1. 精准的评测定位:聚焦“非语言化”纯视觉能力

这是BabyVision最核心的特色。传统多模态模型评测往往会混入语言理解任务,导致模型可通过语言推理“掩盖”视觉理解的不足。而BabyVision严格遵循“最小化语言依赖”原则,所有388道题目均经过精心设计,问题描述简洁直白,答案完全由视觉信息决定,彻底杜绝模型“靠语言做题”的可能性。例如在视觉追踪类的连线题中,题目仅要求“将物品与对应的垃圾桶用线连接”,答案的关键是追踪线条的路径,而非理解复杂的文字说明,真正做到“测视觉,而非测语言”。

2. 科学的任务拆解:覆盖四大核心视觉能力维度

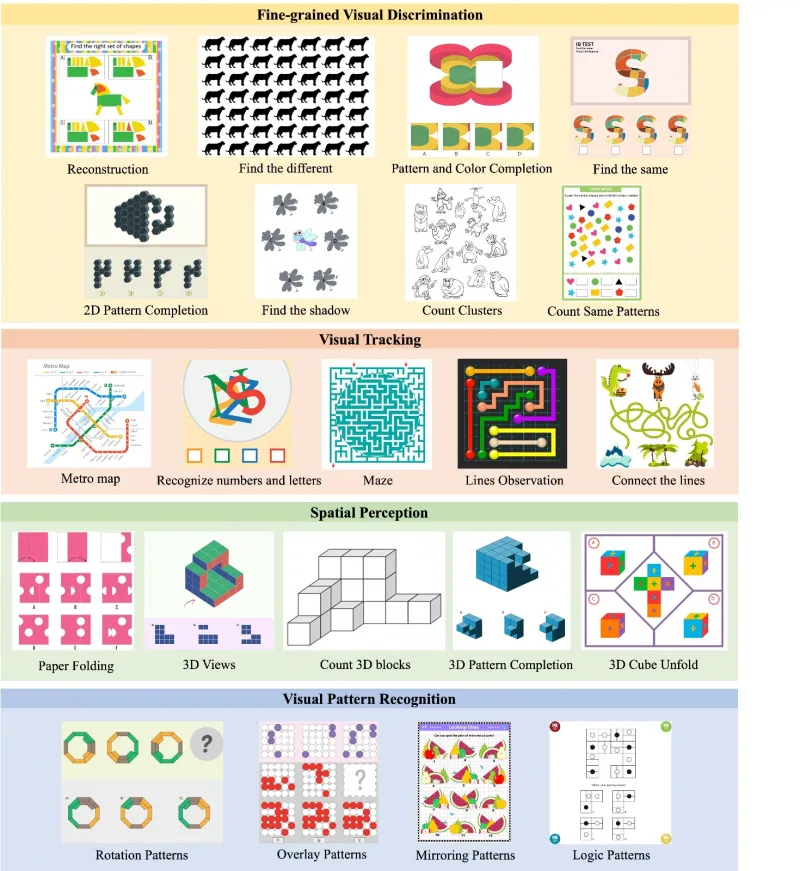

BabyVision并非简单堆砌视觉题目,而是基于儿童认知教材和视觉发育测验,将人类基础视觉能力提炼为四大核心类别,并进一步拆解为22个子任务,每个子任务对应一种具体的视觉原子能力。这种拆解方式既符合人类视觉能力的发展规律,也能让研究者精准定位模型在某一类具体视觉能力上的缺陷,而非只得到一个模糊的“视觉能力差”的结论。四大核心能力及对应子任务特点如下表所示:

| 核心能力类别 | 子任务数量 | 核心能力描述 | 典型任务示例 |

|---|---|---|---|

| 精细粒度辨别 | 8 | 识别图像中细微的视觉差异,区分相似元素、阴影、图案细节等 | 找不同、匹配阴影、图案补全 |

| 视觉追踪 | 5 | 跟随图像中的路径、线条、运动轨迹,处理交叉线、迷宫等连通性问题 | 解迷宫、线条追踪、地铁线路匹配 |

| 空间感知 | 5 | 理解三维结构、视角投影、遮挡关系,完成空间变换相关推理 | 3D方块计数、折纸展开图识别、视角匹配 |

| 视觉模式识别 | 4 | 从少量视觉示例中抽象逻辑规律,完成规律迁移和补全 | 旋转图案匹配、镜像规律推导、逻辑补全 |

3. 严苛的数据质量:打造高可信度的评测数据集

BabyVision的388道高质量题目并非简单收集而来,而是经过“素材筛选→人工标注→双盲质检”三大环节的严苛筛选,确保每一道题的客观性、正确性和可推理性:

素材筛选:先确定22个子任务的种子示例,再通过合规的图像搜索获取4000余张候选图片,过滤掉含大量文字、需文化常识理解的素材,仅保留非商业/学术可用的纯视觉素材;

人工标注:专业人员为图片设计问题和标准答案,同时附上详细的“解题过程”,证明答案可通过视觉推理得出;

双盲质检:两位独立专家交叉审核每道题,只有双方均认可答案无误、推理严谨的题目才会被收录,异议题目需修改或直接弃用。

这种严苛的流程让BabyVision数据集具备极高的可信度,避免了因题目设计不合理导致的评测结果偏差。

4. 双赛道评测:支持多模态与生成模型双重评估

BabyVision并非只针对多模态语言模型,而是设计了MLLM评估和生成任务评估两大核心赛道,覆盖不同类型AI模型的视觉推理能力检测:

MLLM评估赛道:针对多模态语言模型,要求模型通过语言输出答案,项目提供自动推理脚本和评分工具,快速计算模型在四大能力维度上的正确率;

生成任务评估赛道(BabyVision-Gen):针对图像生成模型,创新性地要求模型通过“画图、连线、描轨迹”的方式作答(如用红线描出线条路径),并开发了自动评测工具,与人工评测的一致性达96%,探索了“视觉推理落地到视觉操作”的新方向。

5. 全流程开源:提供可复现的评测体系与结果

作为开源项目,BabyVision公开了完整的数据集、评测代码、执行脚本、评分工具以及当前主流模型的评测结果排行榜。研究者无需从零搭建评测框架,只需按照项目文档操作,即可快速复现已有评测结果,或对新模型进行评估。同时,项目还公开了详细的技术论文和博客解读,让使用者能够深入理解评测设计的底层逻辑。

三、技术细节

BabyVision的技术架构围绕“数据集构建”和“两大评测模块”展开,核心技术细节涵盖数据集设计、评测流程、评分机制、生成式评测创新等方面,整体技术架构简洁清晰,便于使用者理解和二次开发。

1. 数据集核心技术细节

BabyVision的数据集是整个评测体系的基础,其核心技术亮点体现在任务设计逻辑和数据质量控制两方面,具体技术参数和设计细节如下:

数据集规模:共388道纯视觉题目,覆盖22个子任务,每道题均配有专属的纯视觉图像,无冗余文字信息;

语言依赖控制:问题描述均控制在10字以内,如“找不同的图案”“数3D方块数量”,避免语言理解成为评测的干扰项;

答案标注规范:所有答案均为“客观可验证”类型,如数字、方向、选项字母等,同时附带“解题过程标注”,明确视觉推理的步骤,为自动评分提供依据;

数据版权合规:所有图像素材均来自非商业或学术可用的公开资源,严格遵守版权规范,避免法律风险。

2. 核心评测模块技术架构

BabyVision的代码仓库主要分为babyvision_eval/(MLLM评估)和babyvision_gen_eval/(生成任务评估)两大模块,整体基于Python开发,依赖常见的深度学习和数据处理库(如PyTorch、Pandas、OpenCV等),具体技术细节如下:

(1)MLLM评估模块(./babyvision_eval/)

该模块是BabyVision的核心评测模块,针对多模态语言模型设计,核心技术流程为“模型推理→答案收集→自动评分→结果统计”:

推理脚本(

evaluate_model.py):核心功能是加载预训练的多模态模型,读取BabyVision数据集的图像和问题,调用模型的视觉-语言接口生成答案,并将答案保存为标准化的JSON格式文件,支持主流多模态模型(如Gemini、GPT-4V、Qwen-VL等)的快速适配;评分工具(

compute_score.py):采用“LLM-as-judge”的自动评分机制,将模型答案与标准答案输入到一个高性能的大语言模型中,由其判断两者的语义一致性,该机制与人类人工判断的吻合度达100%。评分工具会分别计算模型在四大核心能力类别、22个子任务上的正确率,最终生成综合评分报告;执行脚本(

run_inference.sh):为简化操作,项目提供了Shell脚本,使用者只需修改脚本中的模型路径、数据集路径等参数,即可一键执行推理流程,无需手动编写复杂的调用代码。

(2)生成任务评估模块(./babyvision_gen_eval/)

该模块是BabyVision的创新评测模块,针对图像生成模型设计,核心技术流程为“生成推理→视觉结果解析→自动评估→结果汇总”:

数据集适配:从原388道题目中筛选出280道适合“生成式作答”的题目,重新标注了“视觉作答要求”,如“用红线描出从A到B的路径”“在缺失的位置补全图案”;

推理脚本(

inference.sh):支持主流图像生成模型(如Sora-2、Veo-3、Qwen-Image等)的推理调用,要求模型根据题目要求生成包含解题过程的图像(如描线、补图),并将生成结果保存为指定格式;自动评测工具:基于计算机视觉技术开发,可自动识别生成图像中的关键视觉元素(如红线的路径、补全的图案形状),并与标准答案进行对比,计算匹配度。该工具与人工评测的一致性达96%,大幅降低了生成式评测的人力成本;

全流程脚本(

run_all_eval.sh):整合了推理、评测、结果汇总的全流程,执行后可直接生成模型在生成任务上的详细评分报告,包括各能力维度的表现和典型错误案例。

3. 模型评测核心发现的技术解读

BabyVision通过评测发现,当前顶尖模型在视觉推理任务上的失败并非“单点缺陷”,而是“系统性能力缺失”,研究团队将其总结为四大技术挑战,这也是BabyVision在技术分析上的核心贡献:

非语言细节丢失:模型将视觉信息压缩为语言token时,会抹平像素级的细微差异(如拼图的边界、局部凸起),导致无法区分相似选项;

连续轨迹追踪失效:模型将线条路径拆解为“左/右/上/下”的离散步骤,遇到交叉点时易出现“换轨”错误,无法像人类一样连续追踪路径;

3D空间表征能力不足:模型缺乏稳定的三维内部表征,在3D方块计数、视角投影等任务中,易漏掉隐藏块或搞错投影关系;

视觉规律归纳偏差:模型倾向于学习视觉元素的表面属性(颜色、形状),而非抽象的结构规则,导致规律迁移时出现“幻觉规则”。

这些技术解读为多模态模型的优化提供了明确方向,例如可通过增强模型的视觉连续表征能力、引入3D空间建模模块等方式,弥补基础视觉能力的短板。

四、应用场景

BabyVision作为一款标准化的视觉推理评估基准,其应用场景覆盖AI模型研发、学术研究、行业评测、教育科研四大领域,具体落地场景如下:

1. 多模态大模型研发优化

这是BabyVision最核心的应用场景。对于大模型研发团队(无论是闭源模型还是开源模型),BabyVision可作为模型视觉能力的“体检工具”:

研发人员可通过BabyVision快速检测新模型在四大核心视觉能力上的表现,精准定位薄弱环节(如3D空间感知能力差、视觉追踪易出错);

在模型迭代优化过程中,可将BabyVision的评测结果作为核心指标,判断优化方案(如增加视觉预训练数据、改进视觉编码器)是否有效;

针对BabyVision发现的“非语言细节丢失”“轨迹追踪失效”等技术挑战,研发团队可针对性地设计改进算法,提升模型的基础视觉原子能力。

2. 计算机视觉领域学术研究

BabyVision为计算机视觉和多模态学习领域的学术研究提供了标准化的评测基准和研究方向:

研究者可基于BabyVision数据集开展新的算法研究,例如针对“视觉追踪失效”问题设计新的轨迹表征算法,或针对“3D空间感知不足”开发新的空间建模模块;

学术论文中可将BabyVision的评测结果作为模型性能的重要参考指标,增强研究成果的说服力和可比性;

研究者可基于BabyVision的双盲质检数据集,开展视觉推理任务的标注方法、自动评分机制等方向的研究。

3. 人工智能行业评测与基准对比

对于AI行业评测机构(如xbench、各类AI竞赛主办方),BabyVision可作为多模态模型视觉能力评测的核心基准:

评测机构可将BabyVision纳入多模态模型的综合评测体系,补充传统语言-centric评测的不足,打造更全面的模型能力排行榜;

AI竞赛主办方可基于BabyVision设计专项竞赛,例如“视觉追踪能力优化大赛”“3D空间感知挑战赛”,推动行业技术进步;

企业在选型多模态模型时,可参考模型在BabyVision上的评测结果,判断模型的基础视觉能力是否满足业务需求(如智能视觉质检、机器人视觉导航等)。

4. 儿童认知与人工智能交叉研究

BabyVision的设计灵感来源于儿童视觉发育测验,因此也可应用于儿童认知科学与人工智能的交叉研究:

认知科学家可通过对比AI模型和不同年龄段儿童在BabyVision上的表现,研究人类视觉能力的发展规律,以及AI与人类认知的差异;

教育科研人员可基于BabyVision的任务设计,开发适合儿童视觉能力培养的教学工具,或研究AI在儿童教育中的应用边界。

5. 生成式AI视觉推理能力评测

BabyVision-Gen模块为图像生成模型的视觉推理能力评测提供了全新的应用场景:

生成模型研发团队可通过该模块检测模型“用视觉方式解决视觉问题”的能力,探索生成式AI在视觉推理领域的应用潜力;

研究者可基于BabyVision-Gen的评测结果,研究生成模型的视觉理解与视觉操作能力的关联,推动生成式AI向更智能的方向发展。

五、使用方法

BabyVision的使用流程遵循“环境准备→数据解压→模型评测→结果分析”的步骤,整体操作简洁,支持Linux/macOS系统,Windows系统可通过WSL适配。以下为详细的使用方法,涵盖核心的MLLM评估模块和生成任务评估模块。

1. 前期准备

(1)环境要求

操作系统:Linux(推荐Ubuntu 20.04+)、macOS 12+;

Python版本:3.8~3.11;

硬件要求:MLLM评估需配备GPU(显存≥16GB,推荐A100/V100),生成任务评估需更高显存(≥24GB);

网络要求:部分模型的推理需要联网调用官方API(如Gemini、GPT-4V),本地模型推理无需联网。

(2)克隆仓库与安装依赖

首先将BabyVision仓库克隆到本地,并安装所需的Python依赖:

# 克隆仓库 git clone https://github.com/UniPat-AI/BabyVision.git cd BabyVision # 安装依赖 pip install -r requirements.txt

requirements.txt中包含了PyTorch、Pandas、OpenCV、Transformers等核心依赖,安装过程中若出现版本冲突,可根据提示调整对应库的版本。

(3)解压数据集

BabyVision的评测数据集以压缩包形式存储在data/目录下,需先解压才能使用:

# 解压MLLM评估数据集(核心数据集) unzip data/babyvision_data.zip -d data/ # 若需进行生成任务评估,解压生成任务数据集 unzip data/babyvision_gen_data.zip -d data/

解压后,data/babyvision_data/目录下会生成包含388道题目的图像文件和标注文件,data/babyvision_gen_data/目录下为280道生成式作答题目。

2. MLLM评估模块使用(核心)

MLLM评估模块用于评测多模态语言模型的视觉推理能力,核心步骤为“配置模型参数→执行推理→计算评分→查看结果”。

(1)配置模型参数

打开babyvision_eval/evaluate_model.py文件,修改其中的模型配置参数,主要包括:

model_name:模型名称(如gemini-3-pro-preview、qwen3-vl-plus);model_path:本地模型的路径(若使用开源模型);api_key:闭源模型的API密钥(如Gemini、GPT-4V,本地模型无需配置);data_path:数据集路径(默认../data/babyvision_data/,无需修改);output_path:模型答案的保存路径(默认./results/)。

若使用项目提供的Shell脚本执行,可修改babyvision_eval/run_inference.sh中的参数,无需手动修改Python文件。

(2)执行模型推理

通过Shell脚本一键执行推理流程,生成模型的答案文件:

# 进入MLLM评估目录 cd babyvision_eval # 执行推理脚本 bash run_inference.sh

推理过程中,脚本会自动加载数据集,调用模型生成答案,并将答案保存为results/[model_name]_answers.json文件。推理时间取决于模型规模和硬件性能,一般来说,开源模型在单张A100 GPU上的推理时间约为12小时,闭源模型的API调用时间约为3060分钟。

(3)计算评测分数

推理完成后,使用compute_score.py工具计算模型的综合评分和各维度正确率:

# 计算评分 python compute_score.py \ --answer_path ./results/[model_name]_answers.json \ --gt_path ../data/babyvision_data/gt_answers.json \ --output_path ./scores/

其中,--gt_path为标准答案文件路径,--output_path为评分结果的保存路径。执行完成后,scores/目录下会生成[model_name]_score_report.json文件,包含模型在四大核心能力、22个子任务上的正确率,以及综合评分。

(4)查看评测结果

评分报告为JSON格式,可通过Python脚本或文本编辑器查看,核心结果包括:

overall_accuracy:综合正确率;fine_grained_discrimination_accuracy:精细粒度辨别能力正确率;visual_tracking_accuracy:视觉追踪能力正确率;spatial_perception_accuracy:空间感知能力正确率;visual_pattern_recognition_accuracy:视觉模式识别能力正确率;subtask_accuracies:各子任务的详细正确率。

3. 生成任务评估模块使用

生成任务评估模块用于评测图像生成模型的视觉推理能力,核心步骤与MLLM评估类似,具体操作如下:

# 回到BabyVision根目录 cd .. # 进入生成任务评估目录 cd babyvision_gen_eval # 执行推理脚本(配置参数在inference.sh中修改) bash inference.sh # 执行全流程评估(推理+评分+结果汇总) bash run_all_eval.sh

执行完成后,results/目录下会生成模型的生成图像和评分报告,评分报告包含生成式作答的匹配度、各能力维度的表现等信息。

4. 查看官方评测结果

项目已将当前主流模型的评测结果保存为data/mllm_results.zip,解压后可直接查看:

unzip data/mllm_results.zip -d data/

解压后的data/mllm_results/目录下包含Gemini3-Pro-Preview、GPT-5.2、Qwen3-VL-Plus等模型的评分报告,可作为对比参考。

六、常见问题解答(FAQ)

1. Q:BabyVision支持哪些多模态模型的评测?

A:BabyVision原生支持主流的闭源和开源多模态模型,其中闭源模型包括Gemini3-Pro-Preview、GPT-5.2、Doubao-Seed-1.8、Claude-4.5-Opus等,开源模型包括Qwen3-VL-Plus、Grok-4、LLaVA-1.6等。对于未原生支持的模型,使用者可通过修改evaluate_model.py中的模型调用接口,快速适配自定义模型,项目文档提供了详细的适配指南。

2. Q:运行推理时出现“显存不足”的错误怎么办?

A:针对显存不足的问题,可采取以下解决方案:

降低模型的推理批次大小(修改

evaluate_model.py中的batch_size参数,默认值为4,可改为1或2);使用模型的量化版本(如4-bit/8-bit量化),减少显存占用;

更换显存更大的GPU(如将16GB GPU更换为24GB或40GB GPU);

对于超大规模模型,可采用分布式推理的方式,将模型部署在多张GPU上。

3. Q:自动评分的结果是否可信?

A:BabyVision采用的“LLM-as-judge”自动评分机制,经过严格的验证,与人类人工判断的语义一致性达100%。同时,所有标准答案均附带详细的解题过程,评分工具会基于解题过程判断模型答案的正确性,而非简单的字符串匹配,因此评分结果具有高度的可信度。若对某道题的评分结果有异议,可手动查看模型答案和标准答案,进行人工复核。

4. Q:BabyVision的数据集是否可用于商业用途?

A:BabyVision的数据集是基于非商业和学术可用的素材构建的,严格遵守版权规范,因此仅可用于学术研究、模型评测等非商业用途。若需将数据集用于商业项目,需联系UniPat-AI团队获取商业授权,或自行重新收集和标注符合商业版权要求的素材。

5. Q:如何参与BabyVision的项目贡献?

A:BabyVision是开源项目,欢迎开发者和研究者贡献代码、优化功能、补充数据集。具体的贡献方式包括:

在GitHub仓库上提交Issue,反馈bug或提出功能建议;

提交Pull Request,修复bug、优化代码、增加新模型的适配支持;

为数据集补充新的题目,需遵循项目的标注规范和双盲质检流程;

参与项目的技术讨论,为模型优化和评测方法改进提供建议。

6. Q:BabyVision-Gen的生成式作答如何评估?

A:BabyVision-Gen开发了基于计算机视觉的自动评测工具,核心评估逻辑为:

识别生成图像中的关键视觉元素(如描线的颜色、路径,补全图案的形状、位置);

将识别结果与标准答案中的视觉要求进行对比,计算像素级的匹配度;

根据匹配度给出0~1的评分,匹配度≥90%为正确,否则为错误。

该工具与人工评测的一致性达96%,大幅降低了生成式评测的人力成本,同时项目也支持人工复核生成结果,确保评测的准确性。

7. Q:为什么模型在BabyVision上的表现远低于人类?

A:模型在BabyVision上表现不佳的核心原因是“视觉信息的语言化压缩导致细节丢失”,即模型无法像人类一样直接处理视觉信息,而是需要将视觉信息转换为语言token进行推理,这个转换过程会抹平大量的非语言细节,导致在精细辨别、轨迹追踪等任务中出错。此外,模型缺乏稳定的3D空间表征能力和视觉规律抽象能力,也是其表现不佳的重要原因,这也是当前多模态模型优化的核心方向。

七、相关链接

项目GitHub仓库:https://github.com/UniPat-AI/BabyVision

数据集Hugging Face地址:https://huggingface.co/UnipatAI/collections

八、总结

BabyVision是由UniPat-AI联合红杉中国xbench开发的一款聚焦纯视觉推理能力的开源评估基准,核心针对多模态大模型和图像生成模型,通过388道经严苛筛选的纯视觉题目,将基础视觉能力拆解为精细粒度辨别、视觉追踪、空间感知、视觉模式识别四大核心类别共22个子任务,严格控制语言依赖,精准量化了当前顶尖AI与人类在3岁儿童级视觉原子能力上的系统性差距。该项目设计了MLLM评估和生成任务评估两大核心模块,提供了从模型推理、自动评分到结果分析的全流程工具,同时公开了高质量数据集、详细的技术文档、主流模型的评测结果排行榜以及生成式作答的创新评测方向,其数据集经过素材筛选、人工标注、双盲质检三大环节的严苛把控,具备极高的可信度和可复现性。BabyVision不仅为多模态模型的研发优化提供了精准的“体检工具”,也为计算机视觉领域的学术研究、AI行业评测、儿童认知与人工智能的交叉研究提供了标准化的基准和方向,是当前多模态学习领域中聚焦基础视觉能力评估的重要开源项目,为推动AI模型视觉能力的提升奠定了坚实的评测基础。

版权及免责申明:本文由@97ai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/babyvision.html