DeepAgent:人大&小红书联合开源的端到端通用推理智能代理框架

一、DeepAgent是什么

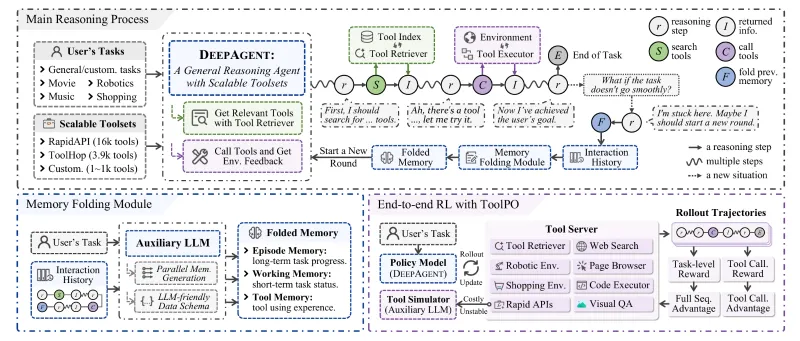

DeepAgent是一款面向通用场景的智能推理代理(General Reasoning Agent)开源项目,由中国人民大学(RUC)和小红书公司联合研发并开源。不同于传统依赖预定义流程(如ReAct的“推理-动作-观察”循环)的智能代理,DeepAgent以“单一思维流”为核心设计理念,能够自主分析任务目标、动态发现所需工具、执行操作并根据反馈调整策略,实现端到端的智能推理闭环。

简单来说,DeepAgent的本质是为大语言模型(LLM)赋予“自主解决复杂任务”的能力:面对需要多步推理、多工具协作的问题(如在线购物决策、复杂信息检索、具身环境交互),它无需人工预设工具调用顺序或流程模板,而是通过自身的记忆体系和推理逻辑,像人类一样“思考”该用什么工具、怎么用、何时调整策略,最终完成任务。该项目开源了完整的代码实现、配置文件、数据集及评估工具,开发者可直接基于框架进行二次开发或部署适配自身场景的智能代理。

二、功能特色

DeepAgent的核心优势集中在“自主推理”“高效记忆”“可扩展工具适配”三大维度,具体功能特色如下表所示:

| 功能特色 | 核心描述 | 解决的核心问题 |

|---|---|---|

| 统一智能推理流 | 摒弃预定义工作流程,采用单一思维流驱动,代理自主完成“任务分析-工具发现-动作执行-结果校验”全流程 | 传统智能代理依赖人工预设流程,无法适配未见过的复杂任务,灵活性差 |

| 自主记忆折叠机制 | 面对长交互历史、复杂子任务链时,自动将冗余信息整合为结构化记忆,精简推理上下文 | 长对话/长任务场景下,上下文过载导致LLM推理效率降低、遗忘关键信息 |

| 脑启发式记忆架构 |

包含三类记忆模块: 1. 情景记忆:记录关键事件、决策和子任务完成情况; 2. 工作记忆:存储当前子目标、近期计划等实时信息; 3. 工具记忆:整合工具调用经验,实现“从经验学习” | 智能代理缺乏长期记忆能力,无法复用过往工具使用经验,重复犯错 |

| 端到端强化学习训练(ToolPO) | 内置LLM驱动的工具模拟器(模拟真实API),并实现工具调用优势归因(为正确调用令牌分配细粒度信用) | 传统训练方式难以量化工具调用的贡献,训练效率低、真实环境测试不稳定 |

| 多基准测试适配 | 原生支持ToolBench、API-Bank、ALFWorld、WebShop等主流智能代理基准测试 | 开发者无需单独适配不同测试集,可快速验证代理性能 |

| 可扩展工具集 | 提供标准化工具接入接口,支持数十到上万种工具的动态发现与调用 | 工具适配成本高,无法快速接入新场景下的自定义工具 |

除此之外,DeepAgent还具备“轻量化部署”“细粒度评估”等特色:框架对硬件资源要求适配性强,支持中小规模LLM的部署测试;内置的评估模块可针对“工具调用准确率”“任务完成率”“推理步数”等维度进行量化分析,帮助开发者定位代理短板。

三、技术细节

3.1 核心架构

DeepAgent的整体架构分为“推理层”“记忆层”“工具层”“训练层”四大模块,各模块协同实现自主推理能力:

(1)推理层:单一思维流驱动

推理层是DeepAgent的核心,其核心逻辑是将所有任务拆解为“连续的推理步骤”,而非预设的流程模板。例如,面对“帮我找到小红书上近3个月点赞量超10万的咖啡探店笔记,并整理笔记中推荐的店铺地址”这一任务,推理层的执行逻辑为:

分析任务核心:需要“小红书笔记检索”“点赞量筛选”“地址提取”三个子目标;

发现适配工具:小红书开放API(笔记检索)、数据筛选工具(点赞量过滤)、文本提取工具(地址解析);

执行工具调用:先调用小红书API获取相关笔记,再用筛选工具过滤点赞量,最后用提取工具解析地址;

结果校验与调整:若地址提取不完整,重新调用工具补充解析,直至完成任务。

整个过程无预设流程,完全由LLM基于任务描述和记忆信息自主决策。

(2)记忆层:脑启发式设计

记忆层是DeepAgent区别于其他智能代理的核心模块,分为三类记忆,各司其职:

情景记忆:相当于“日记”,记录代理在任务执行过程中的关键决策(如“选择小红书API而非通用搜索引擎”)、子任务完成状态(如“已筛选出5篇符合点赞量的笔记”)、关键事件(如“某篇笔记无地址信息,已标记跳过”)。情景记忆为长期记忆,可跨任务复用;

工作记忆:相当于“临时草稿纸”,存储当前正在处理的子目标、近期工具调用结果、待验证的假设等实时信息。工作记忆会随任务推进动态更新,优先保障当前推理的效率;

工具记忆:相当于“工具使用手册”,记录各类工具的调用方式、参数要求、过往使用效果(如“调用小红书API时,参数‘time_range’设为90天可精准筛选近3个月笔记”)。工具记忆会通过强化学习持续更新,让代理“越用越熟练”。

自主记忆折叠机制:当交互历史过长(如超过10轮工具调用),工作记忆会触发“折叠”——将冗余的中间步骤整合为结构化摘要(如“已完成笔记检索和点赞量筛选,共得到5篇有效笔记,其中3篇含地址信息”),既保留关键信息,又精简上下文长度,避免LLM因上下文过载导致推理失效。

(3)工具层:标准化与动态发现

工具层提供了统一的工具接入规范,包含“工具注册”“工具发现”“工具执行”三个核心组件:

工具注册:开发者只需按照规范定义工具的名称、入参、出参、调用方式(REST API/本地函数),即可将自定义工具接入框架;

工具发现:代理通过LLM分析任务描述,从已注册的工具池中自主匹配“可能适用”的工具,无需人工指定;

工具执行:封装了工具调用的异常处理、重试机制,保障工具调用的稳定性(如API调用超时自动重试、参数错误提示代理调整)。

(4)训练层:ToolPO端到端强化学习

传统智能代理训练存在“真实环境API调用不稳定”“工具调用贡献难以量化”的问题,DeepAgent的ToolPO(Tool Preference Optimization)训练方案针对性解决了这些问题:

LLM驱动的工具模拟器:无需调用真实API,而是用LLM模拟工具的返回结果(如模拟小红书API返回指定条件的笔记数据),保障训练过程的稳定性和高效性;

工具调用优势归因:传统强化学习仅对“最终任务完成与否”进行奖励,而ToolPO会为“每一步正确的工具调用令牌”分配细粒度信用(如“选择正确的小红书API参数”会获得部分奖励),让代理更精准地学习“哪些工具调用行为是有效的”;

离线训练+在线微调:先在模拟器中完成离线训练,再用少量真实数据在线微调,兼顾训练效率和真实场景适配性。

3.2 技术亮点

无预设流程依赖:核心逻辑不绑定ReAct、CoT等固定范式,完全由LLM自主推理驱动,适配性更强;

记忆与推理协同:记忆层的三类记忆并非孤立存储,而是与推理层实时交互——推理层可随时调取记忆信息,记忆层可根据推理结果更新内容,形成“思考-记忆-再思考”的闭环;

低适配成本:工具层的标准化接口降低了新工具的接入成本,即使是上万种工具的大规模工具池,代理也能快速完成动态发现。

四、应用场景

DeepAgent的“自主推理+动态工具调用”特性使其适配多类复杂场景,核心应用场景如下:

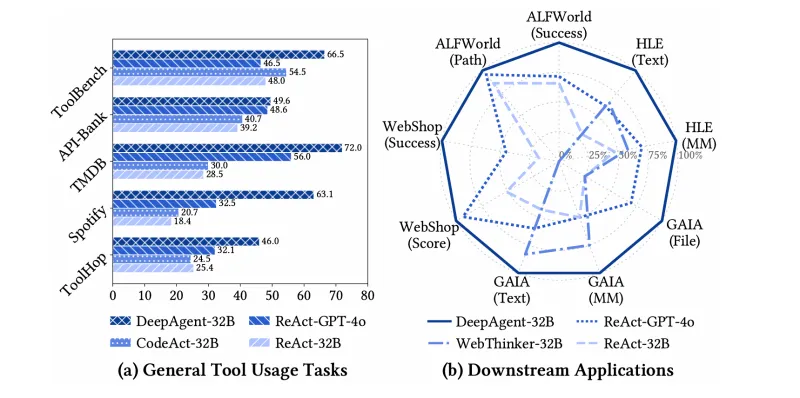

4.1 通用工具使用场景

适用于需要调用多类API/工具完成任务的场景,例如:

API密集型任务:基于API-Bank(包含数百类通用API)完成“天气查询+机票预订+酒店推荐”的一站式出行规划;

大规模工具池场景:基于ToolBench(包含超1万种工具)完成“股票数据查询+财报分析+投资建议生成”的金融分析任务;

第三方平台交互:调用Spotify API(音乐平台)、TMDB API(影视数据库)完成“用户偏好分析+个性化推荐”。

4.2 具身AI环境交互

在文本驱动的虚拟环境中完成具身交互任务,例如:

ALFWorld场景:代理在虚拟家居环境中,根据指令完成“打开冰箱拿牛奶”“整理书架”等连续动作,需要自主推理动作顺序、调用环境交互工具;

虚拟办公场景:在模拟办公环境中完成“整理邮件+生成会议纪要+发送提醒”的多步任务。

4.3 在线交互与决策

适用于需要与在线平台交互、完成复杂决策的场景,例如:

WebShop场景:在模拟在线购物平台中,根据用户需求(如“购买性价比高的无线耳机”)完成“商品检索+价格对比+评论分析+下单决策”;

电商内容运营:调用小红书开放平台工具,完成“笔记数据监控+爆款内容分析+创作灵感生成”的运营任务(契合小红书研发背景的场景适配优势)。

4.4 复杂信息检索

需要多轮搜索、多源信息整合的场景,例如:

GAIA场景:完成“查找某学术论文的引用数据+作者最新研究成果+相关领域综述”的深度信息检索,需要自主调用搜索引擎、学术数据库工具;

HLE(Humanity's Last Exam)场景:解决极具挑战性的推理问题(如跨学科知识问答、逻辑推理题),需要调用计算器、知识图谱、文献检索等多类工具。

4.5 企业级智能助手

企业可基于DeepAgent开发定制化智能助手,例如:

客服智能代理:自主调用客户档案工具、订单查询工具、售后政策工具,完成复杂客诉的解答与处理;

研发助手:调用代码仓库工具、文档工具、测试工具,辅助开发者完成“需求分析+代码编写+单元测试”。

五、使用方法

DeepAgent的使用流程分为“环境准备”“代码部署”“任务运行”“结果评估”四步,以下为通俗易懂的操作指南:

5.1 环境准备

(1)硬件要求

基础测试:CPU(8核及以上)+ 内存16GB及以上,支持中小规模LLM(如Qwen-7B);

高效训练:GPU(NVIDIA A10/A100,显存16GB及以上),支持大规模LLM和强化学习训练。

(2)软件依赖

DeepAgent基于Python开发,核心依赖如下:

# 核心依赖版本 python >= 3.9 torch >= 2.0.0 transformers >= 4.30.0 requests >= 2.31.0 # 工具调用依赖 pandas >= 2.0.0 # 数据处理依赖 numpy >= 1.24.0 # 数值计算依赖

可通过项目根目录的requirements.txt一键安装依赖:

pip install -r requirements.txt

5.2 代码部署

(1)克隆仓库

git clone https://github.com/xxx/DeepAgent.git # 替换为官方仓库地址 cd DeepAgent

(2)配置文件修改

项目的config/目录下包含不同场景的配置文件(如alfworld_config.yaml、apibank_config.yaml),需根据使用场景修改核心参数:

model_name:指定使用的LLM(如Qwen3、QwQ等);tool_pool_path:指定工具池路径(内置数据集或自定义工具池);memory_config:设置记忆折叠的阈值(如交互轮数超过10轮触发折叠);train_config:强化学习训练参数(如学习率、训练轮数)。

5.3 任务运行

(1)基础运行(以ToolBench为例)

运行核心脚本run_deep_agent.py,指定配置文件即可启动代理:

python src/run_deep_agent.py --config config/toolbench_config.yaml

(2)工具搜索服务启动(可选)

若需启用动态工具发现功能,需先启动工具搜索服务:

python src/run_tool_search_server.py --port 8080

(3)自定义工具接入

如需接入自定义工具,只需在src/tools/目录下创建工具类,实现ToolBase抽象类的call方法:

from src.tools.base import ToolBase

class MyCustomTool(ToolBase):

def __init__(self):

self.name = "自定义工具"

self.description = "用于完成XXX任务的自定义工具"

self.parameters = ["param1", "param2"] # 工具入参

def call(self, params):

# 实现工具调用逻辑

param1 = params.get("param1")

param2 = params.get("param2")

result = f"处理结果:{param1}_{param2}"

return result之后在配置文件中添加工具路径,代理即可自动发现并调用。

5.4 结果评估

运行src/evaluate/evaluate.py脚本可对任务执行结果进行量化评估:

python src/evaluate/evaluate.py --result_path outputs/toolbench_result.json --metric all

评估结果会输出“任务完成率”“工具调用准确率”“推理步数”等核心指标,并存入evaluate/results/目录。

六、常见问题解答

Q1:DeepAgent与ReAct、CoT等传统智能代理范式的核心区别是什么?

A:ReAct、CoT等范式依赖“预定义流程模板”(如ReAct固定的“推理-动作-观察”循环),代理需按照模板执行步骤;而DeepAgent无预设流程,完全由LLM基于单一思维流自主决策“何时推理、何时调用工具、调用什么工具”,灵活性和适配性更强。简单来说,传统范式是“按剧本演戏”,DeepAgent是“即兴发挥”。

Q2:DeepAgent支持哪些大语言模型?

A:DeepAgent对LLM无强绑定,理论上支持所有支持函数调用/工具调用的开源LLM,官方测试验证的模型包括QwQ、Qwen3(通义千问)、Llama 3、ChatGLM 4等。只需在配置文件中修改model_name和model_path,即可切换不同模型。

Q3:记忆折叠机制是否会丢失关键信息?

A:不会。记忆折叠的核心是“冗余信息整合”而非“删除”,代理会基于情景记忆保留所有关键决策和子任务状态,仅将重复、无意义的中间步骤整合为结构化摘要。例如,将“调用小红书API→返回100篇笔记→筛选点赞量≥10万→得到5篇笔记”整合为“已筛选出5篇小红书咖啡探店笔记(点赞量≥10万)”,既精简上下文,又保留核心信息。

Q4:ToolPO训练需要大量真实数据吗?

A:不需要。ToolPO的核心优势是“LLM工具模拟器”,可通过模拟真实API返回结果完成离线训练,仅需少量真实数据(约10%)进行在线微调即可适配真实场景,大幅降低数据采集成本。

Q5:DeepAgent的部署门槛高吗?是否需要专业的AI开发经验?

A:基础部署门槛较低:项目提供了完整的配置文件和示例脚本,具备Python基础和简单的LLM使用经验即可完成基础运行;若需定制化开发(如接入自定义工具、调整强化学习参数),则需要一定的AI开发和工具链使用经验。官方文档提供了详细的示例和注释,可辅助开发者快速上手。

Q6:DeepAgent支持多模态工具吗?(如图像识别、语音合成)

A:当前版本的核心能力集中在文本类工具调用和推理,但框架具备可扩展的工具接入接口,开发者可通过封装多模态工具的API(如调用百度OCR接口、科大讯飞语音合成接口),实现多模态工具的接入和调用。

七、相关链接

八、总结

DeepAgent是由中国人民大学与小红书联合打造的开源通用推理代理框架,其核心价值在于突破了传统智能代理依赖预定义流程的局限,通过单一思维流驱动的自主推理、脑启发式记忆架构、自主记忆折叠机制及ToolPO端到端强化学习训练方案,实现了复杂任务下的动态工具发现与高效执行,原生适配ToolBench、ALFWorld等多类主流基准测试场景,同时提供了标准化的工具接入接口和完整的评估体系。该项目既为科研人员提供了通用推理代理的研究基线,也为企业开发者提供了可快速部署、定制化的智能代理开发框架,是大语言模型驱动的智能代理领域的一款实用性、扩展性兼具的开源工具。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/deepagent.html