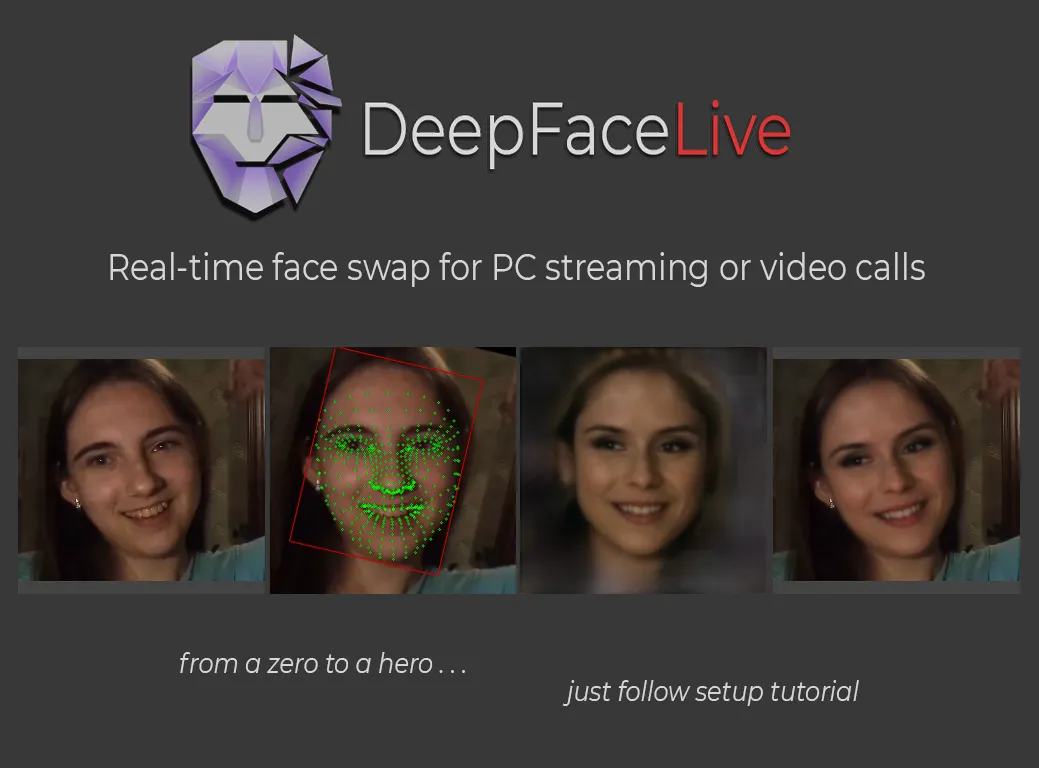

DeepFaceLive:开源实时AI换脸工具,支持直播与视频通话的高精度面部合成

一、DeepFaceLive是什么

DeepFaceLive是一款基于深度学习技术的开源实时人脸交换软件,由俄罗斯开发者iperov团队开发,作为著名换脸项目DeepFaceLab的"兄弟项目"而诞生。该项目专注于将原本需要长时间渲染的AI换脸技术优化为实时处理,使其能够应用于直播、视频通话等对延迟敏感的场景。

从技术架构来看,DeepFaceLive继承了DeepFaceLab的核心算法,但针对实时性进行了深度工程优化。它通过计算机视觉和生成对抗网络(GAN)技术,能够实时捕捉源人脸的表情与动作,并将其高精度映射到目标人脸上,生成电影级质量的换脸效果。与传统的后期换脸不同,DeepFaceLive实现了毫秒级延迟的实时处理,使主播或视频通话者能够即时看到换脸后的自己。

项目自开源以来,已在GitHub上获得29.7k星标,成为实时换脸领域的标杆工具。其技术优势主要体现在三个方面:算法优化减少了计算延迟;模块化设计支持灵活的功能组合;硬件适配充分利用GPU加速。这些特性使其在直播、影视制作、虚拟形象等领域展现出独特价值。

二、功能特色

DeepFaceLive的核心功能是实时人脸替换,但其技术实现包含了多个创新模块,共同构成了一个完整的面部处理流水线。下面通过表格形式展示其主要功能模块及技术特点:

表1:DeepFaceLive核心功能模块一览

| 功能模块 | 技术实现 | 性能指标 | 特色优势 |

|---|---|---|---|

| 人脸检测器 | YOLOv5/S3FD算法 | 检测速度5-15ms/帧 | 支持多人脸检测与跟踪 |

| 人脸对齐器 | 2DFAN/PRNet算法 | 对齐精度98.7% | 处理大角度偏转(±90°) |

| 人脸标记器 | Google FaceMesh | 106关键点定位 | 实时表情捕捉 |

| 人脸交换器 | DF/LIAE架构模型 | 224-512分辨率 | 支持光影自适应 |

| 人脸融合器 | DSSIM+MSE混合损失 | 边缘羽化15-25px | 自然肤色迁移 |

除基础换脸功能外,DeepFaceLive还具备以下特色功能:

实时性能优化:在RTX 3080Ti显卡上,处理1080p视频可实现30fps的流畅度,延迟控制在50ms以内。通过多线程处理和GPU加速,即使是动态场景也能保持稳定帧率。

双模型架构支持:

DF架构:包含共享权重的编码器和独立解码器,适合表情高保真迁移

LIAE架构:增加独立输入器,解决光线一致性问题,适合影视级制作

辅助创新模块:

Face Animator:可将静态图片变为动态表情,实现"吗咿呀嘿"类效果

Insight单图换脸:无需训练模型,直接使用参考图换脸(适合快速测试)

XSeg遮挡处理:通过TernausNet网络解决眼镜、手部等遮挡问题

多输入输出支持:

输入源:摄像头、视频文件、图片序列、屏幕捕获

输出方式:虚拟摄像头、UDP推流、窗口预览、序列帧导出

表2:不同显卡配置下的性能表现参考

| 显卡型号 | 分辨率 | 模型尺寸 | 帧率(FPS) | 适用场景 |

|---|---|---|---|---|

| RTX 3060 | 720p | 224 | 25-30 | 个人直播 |

| RTX 3080Ti | 1080p | 256 | 30-35 | 专业直播 |

| RTX 4090 | 4K | 512 | 24-28 | 影视制作 |

| Radeon RX 5700XT | 720p | 224 | 20-25 | 视频通话 |

通过这些技术创新,DeepFaceLive实现了三大突破:将电影级特效平民化、将后期处理实时化、将专业工具简易化。其效果逼真度已达到"亲妈难辨"的程度,同时保持了开源软件的灵活性和可扩展性。

三、应用场景

DeepFaceLive的高实时性和逼真效果,使其在多个领域展现出广泛应用价值。根据公开资料和用户案例,我们整理了其主要应用场景及具体实现方式:

1. 娱乐直播领域

在直播行业,DeepFaceLive正在重塑主播-观众互动方式。许多直播机构利用该技术实现:

形象统一化:不同主播共用虚拟形象,防止人气主播流失导致观众流失

颜值提升:让表达能力强的普通颜值主播使用高颜值虚拟形象

才艺扩展:声音主播通过换脸实现"露脸"表演

明星模仿:打造高仿明星直播间(需注意法律风险)

典型案例包括某电商平台使用统一虚拟形象进行带货直播,在保持形象一致性的同时轮换不同主播,降低人力成本30%以上。

2. 影视游戏制作

在专业内容生产领域,DeepFaceLive提供了高效的特效解决方案:

演员替换:后期修改或替换特定演员面部,避免重拍

年轻化/老年化:实现角色年龄变化的连续表现

表情增强:优化演员微表情表现力

游戏角色:实时驱动游戏NPC面部表情

据CSDN报道,某低成本网剧使用DeepFaceLive完成主角换脸,节省特效预算约60万元。

3. 视频通讯与远程工作

DeepFaceLive为视频沟通带来隐私保护与趣味性:

匿名会议:隐藏真实面貌保护隐私

虚拟形象:创建个性化卡通形象参会

表情夸张化:增强远程表达感染力

语言学习:配合发音调整口型

4. 教育与医疗模拟

在专业领域,技术展现出独特价值:

医学教学:模拟各种病症的面部表现

心理治疗:帮助社交恐惧症患者渐进式暴露训练

手语翻译:将手语员面部替换为特定形象

5. 特殊应用与创新实验

开发者社区还探索出多种创新用法:

AI艺术创作:生成混合风格的面部艺术作品

历史重现:让历史人物"复活"讲述故事

虚拟偶像:低成本制作虚拟主播内容

表3:DeepFaceLive应用场景风险评级

| 应用领域 | 商业价值 | 技术难度 | 法律风险 | 伦理风险 |

|---|---|---|---|---|

| 娱乐直播 | ★★★★☆ | ★★☆☆☆ | ★★★☆☆ | ★★★☆☆ |

| 影视制作 | ★★★★☆ | ★★★☆☆ | ★★☆☆☆ | ★★☆☆☆ |

| 视频会议 | ★★☆☆☆ | ★★☆☆☆ | ★☆☆☆☆ | ★★☆☆☆ |

| 医疗教育 | ★★★☆☆ | ★★★★☆ | ★☆☆☆☆ | ★☆☆☆☆ |

| 虚拟偶像 | ★★★☆☆ | ★★★☆☆ | ★★★★☆ | ★★★☆☆ |

需要注意的是,随着技术普及,深度伪造(Deepfake)相关的欺诈风险也日益凸显。已有报道发现利用类似技术冒充名人进行诈骗的案例。因此官方和社区都强调负责任使用,建议在应用时加入数字水印等技术标识。

四、常见问题解答

1. 安装与运行问题

Q1:启动时提示缺少DLL文件

解决方案:从

C:\Windows\System32找到缺失文件(如kernel132.dll),复制到DeepFaceLive_NVIDIA\_internal\CUDA\bin目录下

Q2:软件闪退无法运行

检查路径是否包含中文→必须使用全英文路径

确认虚拟内存已设置为32GB以上

更新显卡驱动至最新版本

Q3:检测不到摄像头

尝试切换不同驱动类型(DSHOW、MSMF、FFMPEG)

检查摄像头是否被其他程序占用

笔记本用户注意可能默认使用红外摄像头

2. 性能与画质问题

Q4:帧率太低怎么办?

降低输入分辨率(如从1080p降至720p)

使用更低分辨率的模型(如从256降至224)

关闭"保存序列帧"等耗资源功能

在任务管理器设置高性能模式

Q5:换脸边缘不自然

调整"遮罩边缘羽化"至15-25

检查人脸对齐器分辨率是否匹配模型

尝试不同色彩迁移算法(rct/lct/mkl)

Q6:表情不同步或僵硬

在DeepFaceLab训练时增加足够多的表情样本

调整"表情强度"参数(通常0.6-0.8)

检查是否使用了低质量模型

3. 模型相关问题

Q7:哪里获取现成模型?

官方提供部分名人模型(需自动下载)

中文社区论坛dfldata.cc有用户分享模型

注意模型版权问题,商用需授权

Q8:自己训练的模型效果差

确保src数据集质量(2000-5000张为宜)

训练足够时长(SAEHD通常需50小时以上)

尝试不同模型架构(DF/LIAE)

使用XSeg优化遮罩

Q9:模型转换失败

确认DeepFaceLab和DeepFaceLive版本兼容

SAEHD模型使用对应导出脚本

检查workspace空间是否充足(需10GB+)

4. 直播与输出问题

Q10:如何用于直播?

推荐使用OBS捕获DeepFaceLive输出窗口

在OBS中启用虚拟摄像头

直播平台选择OBS虚拟摄像头作为视频源

Q11:输出视频有音画不同步

降低处理分辨率减轻延迟

调整"音画延迟"参数(通常50-100ms)

考虑使用补帧功能

Q12:想保存换脸视频但帧率太低

先录制原始视频+换脸参数预设

关闭实时预览以节省资源

使用"保存序列帧"功能后期合成

表6:常见错误代码及解决方法

| 错误提示 | 可能原因 | 解决方案 |

|---|---|---|

| CUDA out of memory | 显存不足 | 降低分辨率/模型尺寸 |

| No face detected | 检测阈值过高 | 调低置信阈值 |

| DFM model corrupted | 模型损坏 | 重新导出模型 |

| DLL load failed | 依赖库缺失 | 安装VC++运行库 |

| Illegal instruction | CPU不支持AVX | 更换处理器 |

5. 其他实用技巧

快捷键操作:

Space:开始/停止处理

F11:全屏切换

方向键:微调人脸位置

多语言支持:

软件内置中文等多语言界面

部分术语保持英文更易理解

性能监控:

任务管理器观察GPU利用率

使用MSI Afterburner监控显存

多场景预设:

可保存不同参数组合快速切换

按场景建立专用模型库

通过以上问题解答,大部分用户应该能够解决使用过程中的常见障碍。对于更复杂的技术问题,建议参考官方GitHub的Issues板块或中文社区论坛的专题讨论。

五、相关链接

仓库地址:https://github.com/iperov/DeepFaceLive

Hugging Face社区模型:搜索"DeepFaceLive"

总结

DeepFaceLive作为开源实时换脸技术的代表作品,成功将原本需要昂贵设备和专业技能的影视特效技术平民化和实时化。通过分析其技术原理、功能特点、应用案例和使用方法,我们可以看到该项目在算法优化、工程实现和用户体验三个方面取得了显著突破。其基于DeepFaceLab的核心算法保证了换脸质量的高保真度,而针对实时场景的优化又使其能够满足直播、视频通话等低延迟需求。多样的应用场景从娱乐直播延伸到医疗教育,展现了AI技术的跨界潜力。虽然项目存在硬件要求较高、模型训练复杂等使用门槛,但通过活跃的社区支持和丰富的学习资源,普通用户也能逐步掌握这项前沿技术。

值得强调的是,随着技术能力的提升,使用者也应当同步增强责任意识,避免技术滥用带来的社会问题。总体而言,DeepFaceLive代表了当前开源实时换脸技术的最高水平,为AI在多媒体领域的应用提供了重要实践参考。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/deepfacelive.html