TurboDiffusion:清华大学开源的视频扩散模型加速框架,百倍生成提速且保质量

一、TurboDiffusion是什么?

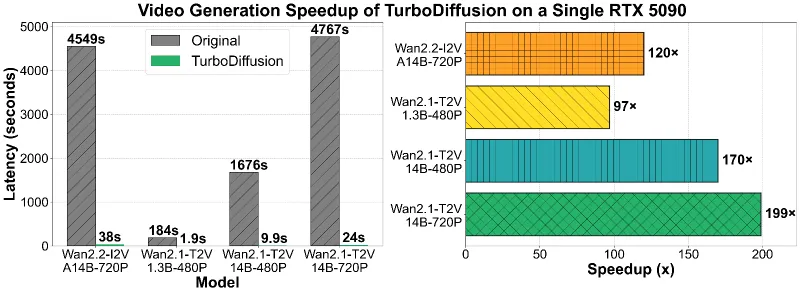

TurboDiffusion是由清华大学、生数科技和加州大学伯克利分校联合推出的开源视频扩散模型加速框架,专为解决传统视频扩散模型“生成速度慢、 latency 高”的核心痛点而设计。该框架的核心价值在于“极致加速+质量无损”:在单块RTX 5090 GPU上,可将主流视频扩散模型的端到端生成时间压缩100-200倍,例如将Wan2.1-T2V-14B-720P模型的生成时间从4767秒缩短至24秒,加速倍数达199×,且生成视频的清晰度、连贯性与原始模型基本一致。

TurboDiffusion并非独立的视频生成模型,而是对现有视频扩散模型(如Wan系列)的“加速赋能工具”,通过优化注意力计算和时间步采样流程,让普通GPU也能快速完成高质量视频生成,降低了视频AI生成的硬件门槛和时间成本。目前项目仍在持续迭代,checkpoints(模型权重)和配套论文尚未最终定稿,后续将更新优化以进一步提升性能。

二、功能特色

1. 极致加速:100-200×提速,突破生成效率瓶颈

TurboDiffusion的核心优势是“百倍级加速”,针对不同规格的视频模型均实现了显著的 latency 降低。以下是其在单RTX 5090上的关键测试数据,直观展现加速效果:

| 支持模型 | 原始端到端生成时间 | TurboDiffusion生成时间 | 加速倍数 | 输出分辨率 |

|---|---|---|---|---|

| Wan2.2-I2V-A14B-720P | 4549秒 | 38秒 | 120× | 720p |

| Wan2.1-T2V-1.3B-480P | 184秒 | 1.9秒 | 97× | 480p |

| Wan2.1-T2V-14B-480P | 1676秒 | 9.9秒 | 170× | 480p |

| Wan2.1-T2V-14B-720P | 4767秒 | 24秒 | 199× | 720p |

注:以上时间均为“纯扩散生成 latency”,不含文本编码和VAE解码时间,实际应用中整体流程耗时仍远低于原始模型。

2. 多场景覆盖:支持T2V/I2V,分辨率灵活适配

框架兼容4款核心模型,涵盖文本转视频(T2V)和图像转视频(I2V)两大核心场景,分辨率支持480p和720p,且每个模型均标注“最佳分辨率”,确保不同需求下的质量最优:

T2V模型:支持从文本描述直接生成视频,适用于无原始素材的创意生成;

I2V模型:支持以单张图像为基础扩展为动态视频,适用于静态素材的动态化改造;

分辨率适配:所有模型均可灵活切换480p/720p输出,满足短视频、广告片等不同场景的清晰度需求。

3. 质量无损:加速不牺牲视频效果

TurboDiffusion通过“注意力优化+时间步蒸馏”的协同设计,在极致加速的同时,保持了与原始模型一致的视频质量——画面清晰度、动态连贯性、内容与提示词的匹配度均无明显下降,解决了“加速必降质”的行业痛点。

4. 硬件适配灵活:兼容不同规格GPU

框架针对不同显存规模的GPU做了针对性优化,无需高端硬件也能流畅运行:

显存≥40GB的GPU(如H100):适配非量化模型,支持更高质量生成;

显存中等的GPU(如RTX 5090/4090):适配量化模型,通过高效量化技术避免显存不足(OOM),同时保持性能;

单卡即可运行:无需多卡集群,降低部署门槛。

5. 易用性强:安装简单,支持交互式推理

安装便捷:提供pip直接安装和源码编译两种方式,无需复杂依赖配置;

推理灵活:支持命令行脚本推理和交互式终端推理(多轮生成无需重复加载模型);

参数友好:核心参数(如采样步数、分辨率、注意力类型)均可灵活配置,兼顾新手和进阶用户。

6. 生态兼容:支持ComfyUI集成

借助社区贡献,TurboDiffusion已实现ComfyUI集成(插件:Comfyui_turbodiffusion),可无缝融入主流AI创作工作流,降低创作者的使用成本。

三、技术细节

TurboDiffusion的百倍加速能力,源于三大核心技术的协同作用——SageAttention、SLA(稀疏线性注意力)和rCM(时间步蒸馏),三者分别从“注意力计算”和“时间步采样”两个关键环节优化,实现双重加速。

1. SageAttention:精准量化的注意力加速

核心作用:优化注意力机制的计算效率,降低显存占用;

技术原理:基于8位量化的精准注意力机制,在不损失精度的前提下,减少注意力计算的显存消耗和计算量,支持“即插即用”,无需大幅修改原始模型结构;

依赖支持:需安装SpargeAttn库实现快速前向传播,确保加速效果。

2. SLA(Sparse-Linear Attention):稀疏化线性注意力

核心作用:通过“稀疏采样”减少注意力计算量;

技术原理:引入Top-k采样策略,仅对注意力权重中占比前k%的关键信息进行计算(默认k=0.1,推荐k=0.15以平衡质量与速度),过滤冗余信息,大幅降低计算复杂度;

优势:相比传统稀疏注意力,SLA支持微调优化,进一步提升稀疏计算的准确性。

3. rCM(Score-Regularized Continuous-Time Consistency):时间步蒸馏

核心作用:压缩原始模型的采样步骤,从根本上减少生成耗时;

技术原理:通过蒸馏技术,将原始模型数百步的采样过程压缩至1-4步,同时保证生成质量——核心是“连续时间一致性正则化”,让少步采样也能还原原始模型的生成分布;

关键价值:采样步数从“百级”降至“个级”,是实现百倍加速的核心技术之一。

技术协同逻辑

SageAttention和SLA负责“优化单次注意力计算”,减少每一步采样的耗时;rCM负责“减少总采样步数”,从整体上压缩生成流程——两者结合,最终实现“每步更快+步数更少”的双重加速,达成100-200×的端到端提速。

四、应用场景

基于“快速生成+质量无损+多场景支持”的核心优势,TurboDiffusion可广泛应用于以下场景:

1. 文本转视频(T2V)场景

创意内容生成:设计师、创作者快速将文字创意转化为视频原型,支持广告脚本、短视频脚本的快速迭代;

广告与营销:生成产品宣传短视频、社交媒体广告,满足“快速产出、多版本测试”的营销需求;

影视前期预览:导演、制片方基于剧本描述生成场景预览视频,辅助拍摄规划;

教育内容制作:将知识点描述转化为动态视频,提升教学内容的趣味性。

2. 图像转视频(I2V)场景

静态素材动态化:将图片、插画转化为短视频(如海报动态扩展、摄影作品添加运动效果);

影视特效预览:基于概念图生成特效片段预览,降低特效制作的前期成本;

游戏素材生成:将游戏场景图、角色图扩展为动态素材,用于游戏宣传或场景加载动画;

社交媒体创作:博主将静态照片转化为创意短视频,提升内容吸引力。

3. 其他场景

AI创作工具集成:开发者将TurboDiffusion集成到自研创作平台,提供“快速视频生成”功能;

科研与教学:用于视频扩散模型加速技术的研究与学习,作为开源基准框架。

五、使用方法

TurboDiffusion的使用流程分为“环境准备→安装→数据准备→推理”四步,操作简洁,新手也可快速上手。

1. 环境准备

需提前配置基础运行环境,关键依赖版本如下(避免版本不兼容导致问题):

Python ≥ 3.9(推荐3.12);

PyTorch ≥ 2.7.0(推荐2.8.0,更高版本可能导致显存不足);

其他依赖:自动安装(无需手动配置)。

2. 安装方式

提供两种安装方式,按需选择:

方式一:pip直接安装(推荐新手)

# 1. 创建并激活虚拟环境 conda create -n turbodiffusion python=3.12 conda activate turbodiffusion # 2. 安装TurboDiffusion pip install turbodiffusion --no-build-isolation # 3. (可选)启用SageSLA(核心加速功能),需安装SpargeAttn pip install git+https://github.com/thu-ml/SpargeAttn.git --no-build-isolation

方式二:源码编译安装(进阶用户)

# 1. 克隆仓库 git clone https://github.com/thu-ml/TurboDiffusion.git cd TurboDiffusion # 2. 初始化子模块 git submodule update --init --recursive # 3. 安装依赖并编译 pip install -e . --no-build-isolation # 4. (可选)安装SpargeAttn启用SageSLA pip install git+https://github.com/thu-ml/SpargeAttn.git --no-build-isolation

3. 数据准备

需下载三类核心文件:VAE(解码器)、umT5文本编码器、模型checkpoints(权重文件)。

步骤1:下载VAE和文本编码器

# 1. 创建checkpoints文件夹 mkdir checkpoints && cd checkpoints # 2. 下载Wan2.1 VAE(适配所有模型) wget https://huggingface.co/Wan-AI/Wan2.1-T2V-1.3B/resolve/main/Wan2.1_VAE.pth # 3. 下载umT5文本编码器 wget https://huggingface.co/Wan-AI/Wan2.1-T2V-1.3B/resolve/main/models_t5_umt5-xxl-enc-bf16.pth

步骤2:下载模型checkpoints

根据GPU类型选择“量化模型”或“非量化模型”:

量化模型(RTX 5090/4090等):

# T2V-1.3B-480P wget https://huggingface.co/TurboDiffusion/TurboWan2.1-T2V-1.3B-480P/resolve/main/TurboWan2.1-T2V-1.3B-480P-quant.pth # I2V-A14B-720P(含高低噪声模型) wget https://huggingface.co/TurboDiffusion/TurboWan2.2-I2V-A14B-720P/resolve/main/TurboWan2.2-I2V-A14B-high-720P-quant.pth wget https://huggingface.co/TurboDiffusion/TurboWan2.2-I2V-A14B-720P/resolve/main/TurboWan2.2-I2V-A14B-low-720P-quant.pth

非量化模型(H100等):

# T2V-1.3B-480P wget https://huggingface.co/TurboDiffusion/TurboWan2.1-T2V-1.3B-480P/resolve/main/TurboWan2.1-T2V-1.3B-480P.pth # I2V-A14B-720P wget https://huggingface.co/TurboDiffusion/TurboWan2.2-I2V-A14B-720P/resolve/main/TurboWan2.2-I2V-A14B-high-720P.pth wget https://huggingface.co/TurboDiffusion/TurboWan2.2-I2V-A14B-720P/resolve/main/TurboWan2.2-I2V-A14B-low-720P.pth

4. 推理运行

支持T2V和I2V两种推理模式,核心参数可灵活配置,以下是常用示例:

示例1:文本转视频(T2V)推理

# 1. 设置环境变量 export PYTHONPATH=turbodiffusion # 2. 运行推理脚本(Wan2.1-1.3B-480P,量化模型) python turbodiffusion/inference/wan2.1_t2v_infer.py \ --model Wan2.1-1.3B \ --dit_path checkpoints/TurboWan2.1-T2V-1.3B-480P-quant.pth \ --resolution 480p \ --prompt "一位时尚女性走在东京街头,霓虹闪烁,街道湿润反光,行人往来" \ --num_samples 1 \ --num_steps 4 \ --quant_linear \ --attention_type sagesla \ --sla_topk 0.1

示例2:图像转视频(I2V)推理

# 1. 设置环境变量 export PYTHONPATH=turbodiffusion # 2. 运行推理脚本(Wan2.2-A14B-720P,量化模型) python turbodiffusion/inference/wan2.2_i2v_infer.py \ --model Wan2.2-A14B \ --low_noise_model_path checkpoints/TurboWan2.2-I2V-A14B-low-720P-quant.pth \ --high_noise_model_path checkpoints/TurboWan2.2-I2V-A14B-high-720P-quant.pth \ --resolution 720p \ --adaptive_resolution \ --image_path assets/i2v_inputs/i2v_input_0.jpg \ --prompt "猫咪站在冲浪板上,突然落水,镜头跟随下沉后快速上浮" \ --num_samples 1 \ --num_steps 4 \ --quant_linear \ --attention_type sagesla \ --sla_topk 0.1 \ --ode

常用核心参数说明

| 参数名 | 作用 | 可选值/默认值 |

|---|---|---|

| --model | 指定使用的模型版本 | Wan2.1-1.3B/Wan2.1-14B/Wan2.2-A14B |

| --dit_path | 模型checkpoint路径 | 自定义路径 |

| --resolution | 输出分辨率 | 480p/720p(默认480p) |

| --prompt | 生成提示词 | 自定义文本 |

| --num_steps | 采样步数(越少越快) | 1-4(默认4) |

| --quant_linear | 启用线性层量化(量化模型必选) | 无需值,添加参数即可 |

| --attention_type | 注意力模块类型 | original/sla/sagesla(默认sagesla) |

| --sla_topk | SLA/ SageSLA的Top-k比例 | 0.1(推荐0.15) |

| --save_path | 输出视频路径 | output/generated_video.mp4 |

示例3:交互式推理(多轮生成无需重载模型)

# 进入交互式推理目录 cd turbodiffusion/serve/ # 运行交互式脚本(按提示输入参数即可) python serve.py

六、常见问题解答(FAQ)

1. 为什么推荐使用PyTorch 2.8.0?更高版本会有什么问题?

答:更高版本的PyTorch可能与框架的量化模块或依赖库不兼容,容易导致显存不足(OOM)或推理报错,建议优先使用PyTorch 2.8.0以确保稳定性。

2. 量化模型和非量化模型该如何选择?

答:核心看GPU显存:

显存≥40GB(如H100):选非量化模型,生成质量略高;

显存<40GB(如RTX 5090/4090):选量化模型,通过高效量化避免OOM,同时保持加速效果。

3. 生成的视频质量不满意怎么办?

答:可尝试以下调整:

提高采样步数(如从4步调整为3步,注意步数越少越快但质量可能略降,需平衡);

调整SLA的Top-k比例(从0.1提升至0.15,增加注意力计算的关键信息占比);

增大sigma_max参数(如从80调整为1600,降低多样性但提升质量);

检查提示词的清晰度,补充细节描述(如场景、动作、风格)。

4. 模型checkpoints和论文什么时候会更新?

答:项目说明中提到“checkpoints和论文尚未最终定稿”,后续会持续更新以提升质量,建议关注GitHub仓库的更新通知。

5. 安装过程中提示“依赖冲突”或“SpargeAttn安装失败”怎么办?

答:

依赖冲突:建议创建全新的conda虚拟环境(如示例中的turbodiffusion环境),避免与其他项目的依赖冲突;

SpargeAttn安装失败:确保网络通畅,若仍失败可参考其官方仓库的安装指南,或暂时不启用SageSLA(将--attention_type改为sla或original)。

6. 能否在Windows系统上使用TurboDiffusion?

答:框架的安装和推理脚本基于Linux/macOS环境开发,Windows系统可能需要适配WSL(Windows子系统)或修改部分脚本路径,建议优先使用Linux系统以确保兼容性。

七、相关链接

Huggingface模型库:https://huggingface.co/TurboDiffusion

核心依赖库(SpargeAttn):https://github.com/thu-ml/SpargeAttn

rCM源码(训练依赖):https://github.com/NVlabs/rcm

八、总结

TurboDiffusion是清华大学、生数科技和加州大学伯克利分校联合推出的开源视频扩散模型加速框架,以“100-200×端到端加速”为核心亮点,在单RTX 5090 GPU上即可实现高质量视频的快速生成,同时支持文本转视频(T2V)和图像转视频(I2V)两大场景,覆盖480p/720p分辨率,兼容不同规格GPU,安装简单、使用灵活且生态兼容ComfyUI。其核心技术通过SageAttention、SLA的注意力优化与rCM的时间步蒸馏协同,实现“加速不牺牲质量”的突破,解决了传统视频扩散模型生成慢的行业痛点,适用于创意内容生成、广告制作、影视预览等多个场景,为开发者和创作者提供了高效、低成本的视频生成解决方案,是开源社区中视频加速领域的重要突破。

版权及免责申明:本文由@97ai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/turbodiffusion.html