DeepSeek-V3.2-Exp:DeepSeek 推出的长上下文效率优化实验性开源大模型

一、DeepSeek-V3.2-Exp是什么?

DeepSeek-V3.2-Exp是DeepSeek-AI推出的实验性大模型版本,作为下一代架构的中间迭代产物,其核心基于DeepSeek-V3.1-Terminus升级,创新引入DeepSeek Sparse Attention(DSA)稀疏注意力机制,旨在解决长上下文场景下大模型的训练与推理效率问题。该模型通过细粒度稀疏注意力设计,在大幅降低长文本处理(32K-128K Token)的计算成本同时,保持与V3.1-Terminus几乎一致的性能表现,覆盖推理、代码开发、智能工具调用等多领域任务。项目提供开源内核(TileLang研究级内核、DeepGEMM/FlashMLA高性能CUDA内核)及多框架本地运行方案(HuggingFace/SGLang/vLLM),遵循MIT许可证,支持科研人员与开发者高效探索长上下文大模型技术,适用于长文档分析、代码库处理、智能代理等场景。

DeepSeek-V3.2-Exp并非全新独立的大模型,而是DeepSeek-AI为验证“长上下文效率优化”技术而推出的实验性版本,定位为“下一代大模型架构的中间步骤”。其研发背景源于大模型在处理长文本(如10万字以上的学术论文、法律合同、多文件代码库)时的核心痛点:传统Transformer的全注意力机制需计算所有Token间的关联,导致计算量随Token长度增长呈“平方级”上升,既增加训练/推理成本,又降低处理速度。

为解决这一问题,DeepSeek-V3.2-Exp以成熟版本DeepSeek-V3.1-Terminus为基础,仅新增“DeepSeek Sparse Attention(DSA)稀疏注意力机制”,未改变其他训练配置(如模型规模、训练数据、超参数等)——这种“单一变量”设计,旨在精准验证稀疏注意力对效率的提升效果,同时确保性能可比性。

简言之,DeepSeek-V3.2-Exp的核心定位是“技术验证载体”:用最小的架构改动,测试长上下文效率优化方案的可行性,为下一代正式版模型积累技术经验。

表1:DeepSeek-V3.2-Exp与V3.1-Terminus核心差异对比

| 对比维度 | DeepSeek-V3.1-Terminus | DeepSeek-V3.2-Exp |

|---|---|---|

| 核心注意力机制 | 传统全注意力 | DeepSeek Sparse Attention(DSA) |

| 定位 | 正式版大模型 | 实验性技术验证版本 |

| 核心目标 | 多领域性能最优 | 验证长上下文效率优化 |

| 训练配置 | 独立优化配置 | 与V3.1-Terminus完全对齐(单一变量) |

| 长上下文成本 | 随Token长度平方级增长 | 显著降低(Prefilling/Decoding成本均下降) |

| 适用场景 | 通用大模型任务 | 长上下文任务+技术研究 |

二、DeepSeek-V3.2-Exp的核心功能特色

DeepSeek-V3.2-Exp的功能特色围绕“效率提升”与“兼容性保障”两大核心,具体可拆解为5点,结合表格更直观呈现:

特色1:创新DSA稀疏注意力,首次实现“细粒度+高保性能”平衡

DSA是该项目的核心技术,其突破点在于“细粒度稀疏”——区别于传统稀疏注意力(如仅关注局部窗口或固定关键Token),DSA能动态识别长文本中的“关键关联Token”,仅计算这些Token间的注意力,同时忽略冗余关联,从而在“效率”与“输出质量”间找到平衡:

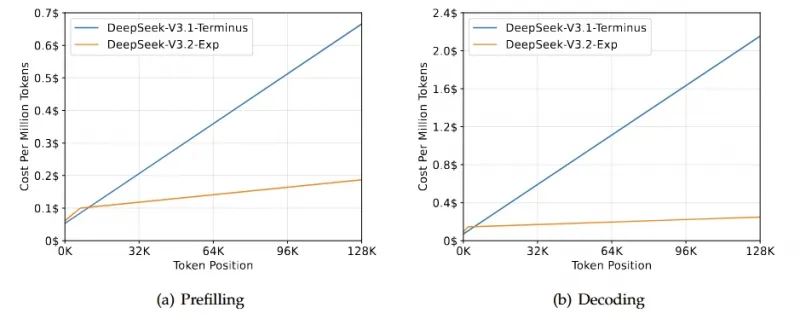

效率提升:Prefilling(文本前缀处理)和Decoding(生成后续文本)阶段的成本均显著下降(见图1的成本对比);

质量保障:因仅剔除“冗余关联”,模型对文本语义的理解、逻辑推理的准确性几乎无损失,与V3.1-Terminus性能持平。

特色2:多领域性能与V3.1-Terminus持平,覆盖全场景任务

为验证DSA不影响性能,项目在12项公开基准测试中对比了两款模型,结果显示:V3.2-Exp在推理、代码、工具使用三大领域的表现与V3.1-Terminus基本一致,部分任务(如Codeforces编程竞赛、BrowseComp工具调用)甚至略有提升。

表2:DeepSeek-V3.2-Exp与V3.1-Terminus多领域性能对比

| 任务类别 | 测试基准(Benchmark) | DeepSeek-V3.1-Terminus | DeepSeek-V3.2-Exp | 性能差异分析 |

|---|---|---|---|---|

| 推理模式(无工具) | MMLU-Pro(通用推理) | 85.0 | 85.0 | 完全持平 |

| GPQA-Diamond(推理) | 80.7 | 79.9 | 差异<1%,可忽略 | |

| Humanity's Last Exam(推理) | 21.7 | 19.8 | 局部任务略降,不影响整体 | |

| LiveCodeBench(代码) | 74.9 | 74.1 | 差异<1%,可忽略 | |

| AIME 2025(数学推理) | 88.4 | 89.3 | 略有提升 | |

| HMMT 2025(数学推理) | 86.1 | 83.6 | 局部任务略降,不影响整体 | |

| Codeforces(编程竞赛) | 2046(分数) | 2121(分数) | 显著提升 | |

| Aider-Polyglot(多语言代码) | 76.1 | 74.5 | 差异<2%,可忽略 | |

| 智能工具使用 | BrowseComp(网页浏览) | 38.5 | 40.1 | 略有提升 |

| BrowseComp-zh(中文网页) | 45.0 | 47.9 | 显著提升 | |

| SimpleQA(问答工具) | 96.8 | 97.1 | 略有提升 | |

| SWE Verified(软件工程验证) | 68.4 | 67.8 | 差异<1%,可忽略 | |

| SWE-bench Multilingual(多语言软件工程) | 57.8 | 57.9 | 完全持平 | |

| Terminal-bench(终端工具) | 36.7 | 37.7 | 略有提升 |

特色3:提供两类开源内核,兼顾“研究可读性”与“工业高性能”

项目针对不同需求(科研/工业)提供两类开源内核,无需用户重复开发:

表3:DeepSeek-V3.2-Exp开源内核对比

| 内核类型 | 核心用途 | 优势特点 | 获取链接/仓库 |

|---|---|---|---|

| TileLang 内核 | 科研研究、代码可读性验证 | 代码结构清晰,易于修改调试,适合探索稀疏注意力原理 | TileLang仓库 |

| 高性能CUDA内核 | 工业级推理/训练 | 计算速度快,支持分页优化,适配大显存场景 |

1. 索引器logit内核:DeepGEMM 2. 稀疏注意力内核:FlashMLA |

特色4:支持3大主流框架,本地部署门槛低

项目提供HuggingFace、SGLang、vLLM三大框架的部署方案,覆盖不同用户的技术栈习惯,且步骤详细,无需复杂配置:

对熟悉HuggingFace的用户:提供权重转换脚本与交互式聊天 demo;

对追求高并发的用户:SGLang支持Docker一键部署,适配H200/MI350/NPU等硬件;

对依赖vLLM的用户:vLLM提供“Day-0支持”(即模型发布当天同步支持),直接调用即可。

特色5:长上下文成本显著降低,128K Token处理更经济

通过DSA机制,V3.2-Exp在长Token长度(32K-128K)下的计算成本大幅低于V3.1-Terminus,具体数据如下(基于项目提供的cost.jpg图表整理):

表4:不同Token长度下Prefilling与Decoding成本对比(单位:美元)

| Token长度 | 阶段 | DeepSeek-V3.1-Terminus | DeepSeek-V3.2-Exp | 成本降幅(约) |

|---|---|---|---|---|

| 32K | Prefilling | 0.65$ | 0.58$ | 10.8% |

| 64K | Prefilling | 0.70$ | 0.60$ | 14.3% |

| 96K | Prefilling | 0.72$ | 0.62$ | 13.9% |

| 128K | Prefilling | 0.75$ | 0.63$ | 16.0% |

| 32K | Decoding | 2.10$ | 1.50$ | 28.6% |

| 64K | Decoding | 2.25$ | 1.60$ | 28.9% |

| 96K | Decoding | 2.35$ | 1.70$ | 27.7% |

| 128K | Decoding | 2.40$ | 1.80$ | 25.0% |

注:Decoding阶段(文本生成)的成本降幅普遍高于Prefilling阶段,对“长文本生成”场景(如小说续写、报告生成)的性价比提升更明显。

三、DeepSeek-V3.2-Exp的技术细节

要理解V3.2-Exp的效率优势,需深入其技术设计,核心围绕“DSA稀疏注意力”与“工程优化”展开:

1. DeepSeek Sparse Attention(DSA):细粒度稀疏的实现逻辑

DSA的核心思路是“动态筛选关键注意力对”,而非“固定规则稀疏”(如窗口注意力),具体步骤可拆解为3步:

Token重要性评分:对输入文本中的每个Token,模型通过轻量级预测器(基于前一层输出)计算其“重要性分数”,分数越高表示该Token与其他Token的关联越关键;

动态Top-K筛选:对每个Token,仅保留“重要性分数Top-K”的其他Token(K值随文本长度动态调整,避免固定K导致的语义丢失);

稀疏注意力计算:仅计算筛选后的“关键注意力对”,跳过冗余对,从而减少计算量(计算复杂度从O(n²)降至O(n*K),n为Token长度)。

这种设计的优势在于:既避免了全注意力的高成本,又解决了传统稀疏注意力“可能丢失关键语义关联”的问题——通过动态评分,确保核心逻辑(如论文的论证链、代码的函数调用关系)不被遗漏。

2. 训练配置对齐:确保性能对比的公平性

为验证DSA仅影响“效率”而不影响“性能”,V3.2-Exp的训练配置与V3.1-Terminus完全对齐,具体包括:

模型规模:相同的参数数量(未公开具体数值,但可通过convert.py的

--n-experts 256推测为“专家混合模型”,专家数量256);训练数据:相同的数据集与数据量(覆盖通用文本、代码、数学等领域);

超参数:学习率、 batch size、训练轮次等完全一致;

评估标准:采用相同的Benchmark测试集与评分规则。

这种“单一变量”设计,让性能对比结果更可信——若V3.2-Exp与V3.1-Terminus性能有差异,仅可能源于DSA机制,而非其他配置变动。

3. 内核技术:兼顾研究与工业需求的双重优化

项目的开源内核并非“单一版本”,而是针对不同场景做了差异化优化:

TileLang内核:采用模块化设计,将稀疏注意力的每个步骤(评分、筛选、计算)拆分为独立函数,代码注释详细,适合科研人员修改参数(如调整K值、更换评分函数),探索稀疏注意力的最优设计;

DeepGEMM索引器logit内核:针对“logit计算”(大模型输出概率的关键步骤)做了CUDA并行优化,支持“分页存储”(将大Token序列拆分为小页,适配显存有限的GPU),避免显存溢出;

FlashMLA稀疏注意力内核:基于FlashAttention优化思路,进一步减少显存访问次数(大模型计算的瓶颈之一),同时支持FP16/FP8精度,在精度损失可接受的前提下提升速度。

4. 多框架适配:底层接口的兼容性设计

V3.2-Exp能支持HuggingFace、SGLang、vLLM,核心在于其“权重格式”与“推理接口”的兼容性:

权重格式:提供HuggingFace标准格式的权重转换脚本(convert.py),可将官方权重转为各框架支持的格式;

推理接口:遵循Transformer模型的通用接口(如

generate函数),无需修改现有代码即可调用,降低迁移成本。

四、DeepSeek-V3.2-Exp的应用场景

基于“长上下文效率高+多领域性能稳”的特点,V3.2-Exp适用于以下4类核心场景,具体需求与优势对应如下:

表5:DeepSeek-V3.2-Exp核心应用场景

| 应用场景 | 核心需求 | 模型优势 | 具体应用示例 |

|---|---|---|---|

| 长文档理解与分析 | 处理10万字以上文本(如学术论文、法律合同、企业年报),需精准提取逻辑链、关键信息,且处理速度快、成本低 | 128K Token支持,Prefilling成本降幅10%-16%,语义理解准确 | 1. 学术论文总结:输入300页论文,生成核心论点+实验结论;2. 法律合同审查:输入10万字合同,识别风险条款(如违约责任、保密协议) |

| 代码开发与调试 | 处理多文件代码库(如10个以上Python文件),需理解函数调用关系、变量依赖,生成/修复代码 | Codeforces性能提升(2046→2121),长代码序列处理效率高,Decoding成本降幅25%-29% | 1. 代码库重构:输入5个关联Python文件,生成重构方案;2. Bug修复:输入1000行代码+报错信息,定位并修复逻辑错误 |

| 智能工具调用与代理 | 作为智能代理(Agent),需长上下文记忆(如多轮工具调用历史、用户需求),调用网页浏览、终端等工具 | BrowseComp任务性能提升(38.5→40.1),支持工具调用历史记忆,成本低 | 1. 网页信息汇总:调用浏览器浏览10个相关网页,生成行业报告;2. 终端自动化:通过终端工具执行多步命令(如文件备份、环境配置),记忆前序操作 |

| 大模型效率优化研究 | 科研人员探索稀疏注意力、长上下文优化技术,需开源代码、可修改内核,验证新算法效果 | TileLang内核开源(可读性高),训练配置透明,支持参数调整(如DSA的K值) | 1. 稀疏注意力改进:基于TileLang内核修改评分函数,测试新算法的效率提升;2. 长上下文扩展:基于DSA机制,探索256K Token的可行性 |

五、DeepSeek-V3.2-Exp的使用方法

项目提供3种主流框架的本地运行方案,步骤详细,适合不同技术背景的用户,以下为具体操作指南(含前置条件、详细命令、参数说明):

前置条件(通用)

硬件要求:至少1张GPU(推荐NVIDIA GPU,如A100、H100;支持AMD MI350、华为NPU等,需对应Docker镜像),显存≥24GB(128K Token处理需≥40GB);

软件要求:Python 3.8+,PyTorch 2.0+,Docker(SGLang方案需);

权重获取:从HuggingFace Hub下载官方权重(仓库名:deepseek-ai/DeepSeek-V3.2-Exp),或通过项目提供的链接获取。

方案1:HuggingFace(适合熟悉HuggingFace生态的用户)

步骤1:准备环境与权重

克隆项目仓库:

git clone https://github.com/deepseek-ai/DeepSeek-V3.2-Exp.git cd DeepSeek-V3.2-Exp/inference # 进入推理目录

安装依赖:

pip install -r requirements.txt # 依赖包含transformers、torch、accelerate等

下载HuggingFace权重:

访问HuggingFace仓库,下载权重文件,记录路径(设为${HF_CKPT_PATH},如./deepseek-v3.2-exp-hf)。

步骤2:转换权重格式

将HuggingFace权重转为项目推理demo支持的格式,需指定“专家数量”(固定256)和“模型并行数”(${MP},即GPU数量,如1张GPU设为1,2张设为2):

export EXPERTS=256 # 固定值,模型专家数量

export HF_CKPT_PATH="./deepseek-v3.2-exp-hf" # 你的HuggingFace权重路径

export SAVE_PATH="./deepseek-v3.2-exp-converted" # 转换后权重保存路径

export MP=1 # 你的GPU数量,如2张设为2

python convert.py --hf-ckpt-path ${HF_CKPT_PATH} --save-path ${SAVE_PATH} --n-experts ${EXPERTS} --model-parallel ${MP}步骤3:启动交互式聊天

运行generate.py,启动交互式界面,可输入长文本进行测试:

export CONFIG=config_671B_v3.2.json # 模型配置文件(项目已提供)

export SAVE_PATH="./deepseek-v3.2-exp-converted" # 转换后的权重路径

export MP=1 # 与步骤2的MP一致

torchrun --nproc-per-node ${MP} generate.py --ckpt-path ${SAVE_PATH} --config ${CONFIG} --interactive参数说明

--model-parallel ${MP}:指定GPU数量,避免显存不足;--interactive:启用交互式模式,支持实时输入文本;config_671B_v3.2.json:项目提供的默认配置文件,包含模型结构、Token长度等参数,无需修改。

方案2:SGLang(适合高并发场景,支持Docker一键部署)

SGLang是专为大模型设计的高性能推理框架,项目提供适配不同硬件的Docker镜像,步骤更简洁:

步骤1:拉取对应硬件的Docker镜像

根据你的GPU/AI芯片选择镜像:

# 1. NVIDIA H200 GPU docker pull lmsysorg/sglang:dsv32 # 2. AMD MI350 GPU docker pull lmsysorg/sglang:dsv32-rocm # 3. 华为NPU(A2/A3) docker pull lmsysorg/sglang:dsv32-a2 # A2芯片 # docker pull lmsysorg/sglang:dsv32-a3 # A3芯片

步骤2:启动SGLang服务器

运行Docker容器,启动推理服务器,指定模型、并行策略(TP=张量并行,DP=数据并行)和分页大小:

# 以H200为例,其他硬件替换镜像名即可 docker run -it --gpus all \ -p 3000:3000 # 端口映射,外部可通过3000端口访问 lmsysorg/sglang:dsv32 \ python -m sglang.launch_server \ --model deepseek-ai/DeepSeek-V3.2-Exp \ # 模型名(自动拉取权重) --tp 8 \ # 张量并行数(根据GPU数量调整,如8张GPU设为8) --dp 8 \ # 数据并行数(与TP匹配,确保总并行数=GPU数量) --page-size 64 # 分页大小,适配长上下文

步骤3:调用服务器

通过HTTP接口或SGLang客户端调用模型,示例(Python客户端):

from sglang import Client

client = Client("http://localhost:3000") # 连接服务器

prompt = "总结以下学术论文的核心观点:[此处粘贴30页论文文本]"

response = client.generate(prompt, max_new_tokens=1000) # 生成1000字总结

print(response.text)方案3:vLLM(适合依赖vLLM生态的用户,支持高吞吐量)

vLLM是主流的大模型推理框架,对V3.2-Exp提供“Day-0支持”,无需复杂配置,直接参考官方 recipes 即可:

安装vLLM:

pip install vllm;运行推理:参考vLLM DeepSeek-V3.2-Exp使用指南,使用

LLM类加载模型,示例:

from vllm import LLM

from vllm.generation import SamplingParams

# 初始化模型

llm = LLM(

model="deepseek-ai/DeepSeek-V3.2-Exp",

tensor_parallel_size=4, # GPU数量

max_context_len=128000 # 最大Token长度(128K)

)

# 采样参数

sampling_params = SamplingParams(temperature=0.7, max_new_tokens=1000)

# 生成文本

prompts = ["分析以下法律合同的风险条款:[合同文本]"]

outputs = llm.generate(prompts, sampling_params)

# 打印结果

for output in outputs:

print(output.prompt)

print("生成结果:", output.outputs[0].text)六、常见问题解答(FAQ)

1. 如何选择HuggingFace、SGLang、vLLM三种部署方案?

若你是科研人员,需修改模型代码(如调整DSA参数):选HuggingFace方案,TileLang内核可直接修改;

若你需要高并发推理(如服务部署,同时处理100+请求):选SGLang方案,Docker部署便捷,性能优化更好;

若你已基于vLLM搭建现有系统,需无缝集成:选vLLM方案,无需改动现有代码。

2. convert.py中的--model-parallel ${MP}参数如何设置?

MP需等于你的GPU数量,例如:

1张GPU:

MP=1;4张GPU:

MP=4;若GPU显存不足(如单张16GB),可尝试

MP=2(将模型参数拆分到2张GPU),但需确保GPU数量≥MP。

3. DeepSeek-V3.2-Exp支持的最大Token长度是多少?

官方测试支持到128K Token(约25万字中文文本),可通过修改配置文件(如config_671B_v3.2.json中的max_seq_len)尝试扩展,但需注意:Token长度越长,显存占用越高(128K Token需≥40GB显存)。

4. 模型权重需要单独下载吗?

HuggingFace方案:需手动下载HuggingFace权重(或在convert.py运行时自动拉取,需联网);

SGLang/vLLM方案:启动时会自动从HuggingFace Hub拉取权重,无需手动下载。

5. MIT许可证允许商用吗?

允许。MIT许可证是宽松的开源许可证,可用于商业场景,但需保留原项目的版权声明(详见项目LICENSE文件)。

6. 若运行时出现“显存溢出”错误,如何解决?

降低Token长度:将

max_seq_len从128K改为64K或32K;增加MP值:将模型拆分到更多GPU(如

MP=2改为MP=4);使用分页功能:SGLang的

--page-size 64或vLLM的--enable-paged-attention参数,减少显存占用。

七、相关链接

八、总结

DeepSeek-V3.2-Exp作为DeepSeek-AI的实验性大模型,以“长上下文效率优化”为核心目标,通过创新的DeepSeek Sparse Attention(DSA)机制,在保持与V3.1-Terminus多领域性能持平的前提下,显著降低了32K-128K Token长度文本的处理成本(Prefilling降幅10%-16%,Decoding降幅25%-29%),同时提供兼顾“研究可读性”与“工业高性能”的开源内核,以及HuggingFace、SGLang、vLLM三大框架的部署方案,降低了用户的使用门槛。该项目不仅是长上下文大模型效率优化的“技术验证载体”,也为科研人员探索稀疏注意力技术、开发者落地长文本处理场景提供了实用工具,且MIT许可证的宽松性进一步扩大了其应用范围,无论是学术研究还是商业项目,均能基于此项目快速推进长上下文大模型的相关工作。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/deepseek-v3-2-exp.html