DreamOmni2:开源多模态指令驱动的图像编辑与生成模型,支持跨模态参考与精准控制

一、DreamOmni2是什么?

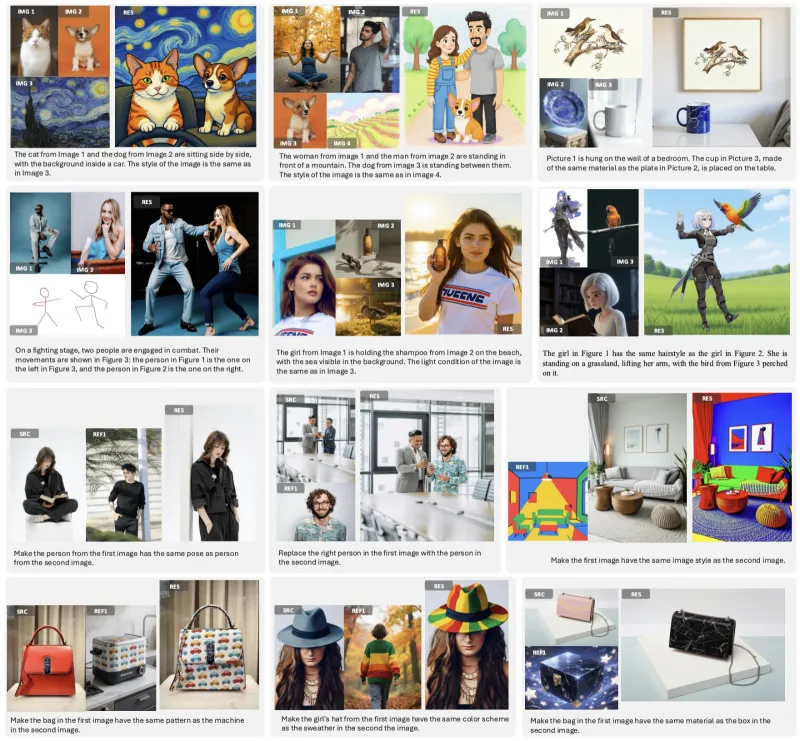

DreamOmni2是一款开源多模态指令驱动图像编辑与生成模型,支持基于文本和图像参考的跨模态内容创作。其核心优势在于统一架构下兼顾生成与编辑任务,能精准保持对象身份、姿态等关键属性,同时支持抽象风格迁移与跨图元素融合,性能接近商业模型。无论是专业设计师的创意创作,还是普通用户的日常图像处理,均可通过简单指令实现高效、高质量的图像生成与编辑,为多模态内容创作提供了强大且易用的开源解决方案。

简单来说,传统图像生成工具可能仅支持“用文本描述生成一张图”,而编辑工具可能仅能“基于原图修改指定区域”;但DreamOmni2可以做到:比如输入“让图1中的人物穿着图2的衣服,站在图3的场景里”,并同时提供图1、图2、图3作为参考,模型能精准理解跨模态指令,生成符合要求的图像。

该项目开源了模型代码、权重及测试基准,旨在为研究人员和开发者提供可扩展的多模态图像创作工具,推动跨模态生成技术的普及与创新。

二、功能特色

DreamOmni2的核心竞争力在于“多模态指令理解”与“精准控制能力”,其功能特色可概括为三大方向,且在关键性能上超越多数开源工具,接近商业模型水平。

1. 多模态指令生成:跨图融合与属性保持

生成任务指基于文本指令和参考图像,创作全新图像。与传统文本生成模型(如仅靠文字描述生成)相比,DreamOmni2的核心优势是“参考图像属性复用”,具体表现为:

身份一致性:能精准保留参考图像中人物、物体的核心特征(如人脸、宠物外形、特定物品的细节)。例如,用用户提供的“自家猫咪照片”作为参考,指令“生成这只猫在月球上玩耍的场景”,模型生成的图像中猫咪的毛色、花纹等特征与原图高度一致。

姿态与动作控制:支持基于参考图像的姿态迁移。例如,参考图中人物“抬手”的动作,指令“让这个人抬手接住飘落的雪花”,模型能保持“抬手”姿态并融合新场景。

抽象属性迁移:可提取参考图像的抽象风格(如油画、水墨)、材质(如金属、毛绒)或氛围(如黄昏、科幻),并应用于生成图像。例如,参考图为“梵高风格的星空”,指令“生成梵高风格的城市夜景”,模型能复现梵高的笔触与色彩基调。

2. 多模态指令编辑:精准修改与背景保持

编辑任务指基于文本指令和参考图像,对已有图像进行局部修改(而非生成全新图像)。与传统编辑工具(如仅支持“替换颜色”“裁剪”等简单操作)相比,其核心优势是“跨模态参考编辑”与“非编辑区域一致性”:

跨图元素融合:可将参考图像中的元素“移植”到待编辑图像中,并保持自然融合。例如,待编辑图是“空房间”,参考图是“红色沙发”,指令“在房间左侧放入这张沙发”,模型会生成沙发与房间光影、透视匹配的效果。

非编辑区域严格保持:仅修改指令指定的区域,原图其他部分(如背景、无关物体)几乎无变化。例如,待编辑图是“人物站在公园长椅旁”,指令“将人物的衬衫换成参考图中的条纹款”,模型仅修改衬衫,人物姿态、公园背景、长椅等均保持不变。

复杂指令理解:支持多条件组合编辑。例如,指令“让图1中的小狗坐在图2的椅子上,同时让小狗的毛色变成图3中猫咪的白色”,模型能同时处理“位置”“毛色”两个修改需求,并保持小狗的核心特征。

3. 统一模型架构:生成与编辑任务无缝切换

传统工具往往需要为“生成”和“编辑”开发两套独立模型,而DreamOmni2采用统一框架,通过任务类型自动适配逻辑,实现“一套模型、两种功能”:

生成任务时,模型侧重“参考图像属性的保留”与“新场景的美观融合”,允许一定程度的创意发挥(如背景细节优化);

编辑任务时,模型侧重“非编辑区域的严格一致性”,仅对指令指定内容进行修改,确保原图信息不丢失。

这种设计不仅降低了用户的学习成本(无需切换工具),还减少了模型部署的资源消耗(单模型支持多任务)。

功能对比表:DreamOmni2与传统工具的核心差异

| 功能维度 | 传统文本生成工具 | 传统图像编辑工具 | DreamOmni2 |

|---|---|---|---|

| 输入模态 | 仅文本 | 仅图像+简单文字指令 | 文本+1张或多张参考图像 |

| 身份/物体特征保留 | 差(易失真) | 无此功能 | 优(核心特征高度一致) |

| 跨图元素融合 | 无此功能 | 需手动调整(效果差) | 自动融合(光影/透视匹配) |

| 非编辑区域保持 | 无此功能 | 部分支持(易失真) | 严格保持(几乎无变化) |

| 抽象属性(风格/材质)控制 | 依赖文本描述(精度低) | 需手动调整(难度高) | 基于参考图提取(精度高) |

三、技术细节

DreamOmni2的强大功能源于其精心设计的技术架构,核心包括“多模态指令理解模块”“跨模态特征融合机制”和“任务自适应优化策略”三部分,整体基于扩散模型(Diffusion Model)构建。

1. 基础模型架构

底层框架:以稳定扩散模型(Stable Diffusion)为基础,保留其图像生成的高质量基础能力;

模态编码器:加入视觉-语言模型(VLM,如CLIP的改进版)作为“多模态指令理解核心”,负责将文本指令与参考图像转换为统一的语义特征向量;

任务控制器:通过轻量级适配器(Adapter)区分“生成”与“编辑”任务——生成任务时增强“创意融合”权重,编辑任务时增强“原图保留”权重。

2. 跨模态特征融合机制

为解决“文本指令与参考图像信息冲突”或“多参考图特征优先级”问题,模型设计了三级融合策略:

语义对齐:通过VLM将文本与参考图像的语义特征映射到同一空间,确保“指令描述”与“参考图内容”在语义上一致(如文本“红色”与参考图中红色物体的特征对齐);

权重分配:根据指令关键词(如“主要参考图1”“风格参考图2”)动态调整不同参考图像的特征权重;

细节修正:引入“对比损失函数”,对生成/编辑结果与参考图的关键特征(如人脸关键点、物体轮廓)进行比对,修正偏差。

3. 训练策略

数据来源:使用大规模多模态数据集(包括公开的图像-文本对、人工标注的编辑任务样本),涵盖人物、物体、场景等多类场景;

微调方式:采用LoRA(Low-Rank Adaptation)微调技术,仅对模型的关键层进行调整,在降低训练成本的同时,保留基础模型的生成能力;

评估指标:引入自定义基准测试集DreamOmni2Bench,从“身份一致性”“姿态准确率”“风格迁移度”“编辑区域精准度”四个维度量化模型性能。

技术模块作用表

| 技术模块 | 核心作用 | 优势 |

|---|---|---|

| 视觉-语言模型(VLM) | 统一文本与图像的语义特征 | 解决跨模态理解歧义问题 |

| 任务控制器(Adapter) | 区分生成/编辑任务的优化方向 | 单模型支持多任务,降低部署成本 |

| 对比损失函数 | 约束生成结果与参考图的关键特征一致性 | 提升身份、姿态等属性的保留精度 |

| LoRA微调 | 高效优化模型对多模态指令的响应能力 | 训练成本低,兼容基础模型的生成质量 |

四、应用场景

DreamOmni2的多模态控制能力使其适用于从专业创作到日常娱乐的多样化场景,以下为典型应用方向:

1. 内容创作领域

设计师高效出图:平面设计师可通过“参考图+文本”快速生成多个方案。例如,参考客户提供的“品牌LOGO”和“喜欢的海报风格图”,指令“生成包含该LOGO的海报,布局参考风格图,背景改为蓝色”,无需手动调整细节即可得到初稿;

自媒体素材制作:博主可快速生成符合主题的配图。例如,参考“自己的照片”和“旅行场景图”,指令“生成我在这个场景里喝咖啡的图片”,用于旅行攻略文章。

2. 电商与营销

商品图快速修改:电商运营可基于商品原图生成多场景展示图。例如,参考“连衣裙原图”和“沙滩场景图”,指令“让这件连衣裙穿在模特身上,背景为沙滩”,无需实际拍摄即可得到场景化商品图;

广告创意生成:营销团队可融合多元素生成广告素材。例如,参考“产品图”“目标人群照片”和“节日氛围图”,指令“生成目标人群使用产品的节日场景,风格参考氛围图”。

3. 影视与游戏辅助

场景概念设计:影视美术可快速迭代场景方案。例如,参考“古代建筑图”和“科幻元素图”,指令“生成融合古代建筑轮廓与科幻材质的城堡,光线为黄昏”;

角色服装修改:游戏开发者可快速测试角色服装效果。例如,参考“游戏角色图”和“新服装设计图”,指令“将角色的服装替换为设计图样式,保持角色姿态与场景不变”。

4. 教育与培训

教学素材定制:教师可生成符合知识点的示意图。例如,参考“地球仪图”和“太阳系图”,指令“生成地球仪在太阳系中的位置示意图,标注行星名称”;

情景模拟图制作:安全教育可生成危险场景模拟图。例如,参考“教室图”和“火灾场景图”,指令“生成教室发生火灾的模拟图,突出逃生通道”。

5. 个人创意与娱乐

日常修图:普通用户可轻松实现复杂修图需求。例如,参考“朋友聚会原图”和“夕阳风景图”,指令“将聚会照片的背景替换为夕阳,人物不变”;

创意合成:爱好者可制作趣味图像。例如,参考“宠物猫图”和“宇航员图”,指令“生成猫咪穿着宇航服在太空的图片”。

五、使用方法

DreamOmni2提供了命令行推理和Web交互两种使用方式,用户可根据需求选择。以下为详细步骤(需具备基础的Python环境操作能力):

1. 环境准备

(1)克隆仓库并安装依赖

首先确保本地安装了Git和Python(3.8及以上版本),执行以下命令:

# 克隆仓库 git clone https://github.com/dvlab-research/DreamOmni2 cd ./DreamOmni2 # 安装依赖(建议使用虚拟环境) pip install -r requirements.txt

requirements.txt中包含PyTorch、Diffusers、Transformers等必要库,安装过程可能需要10-20分钟(取决于网络速度)。

(2)下载模型权重

模型权重托管在Hugging Face Model Hub,需使用huggingface-cli工具下载(若未安装,可先执行pip install huggingface-hub):

# 下载模型权重至本地models文件夹 huggingface-cli download --resume-download --local-dir-use-symlinks False xiabs/DreamOmni2 --local-dir ./models

模型总大小约10GB,建议在网络稳定的环境下下载,支持断点续传。

2. 命令行推理

(1)生成任务(基于参考图和文本创作新图)

示例:用两张参考图生成指定场景的新图

python3 inference_gen.py \ --input_img_path "example_input/gen_tests/person.jpg" "example_input/gen_tests/scene.jpg" \ # 参考图路径(可多个) --input_instruction "让第一张图的人坐在第二张图的长椅上,背景保持场景原图风格,人物姿态为侧身微笑" \ # 文本指令 --output_path "output/gen_result.png" \ # 输出路径 --height 1024 \ # 输出图像高度 --width 1024 # 输出图像宽度

参数说明:

--input_img_path:参考图像路径,多个路径用空格分隔;--input_instruction:文本指令,需明确描述生成需求;--height/--width:支持512x512、768x768、1024x1024等尺寸, larger尺寸生成时间更长。

(2)编辑任务(基于参考图和文本修改原图)

示例:将参考图中的元素融合到待编辑图中

python3 inference_edit.py \ --input_img_path "example_input/edit_tests/original_room.jpg" "example_input/edit_tests/new_furniture.jpg" \ # 第一个为待编辑图,后续为参考图 --input_instruction "将第二张图中的沙发替换到第一张图的左侧,保持房间其他家具和光线不变" \ # 文本指令 --output_path "output/edit_result.png"

注意:编辑任务中,--input_img_path的第一个路径必须是“待编辑图像”,后续为参考图像。

3. Web演示(可视化交互)

若希望通过图形界面操作,可启动Web演示服务(需显卡支持CUDA,显存建议8GB以上):

(1)编辑功能Web界面

# 指定显卡(0号卡),启动编辑功能Web服务 CUDA_VISIBLE_DEVICES=0 python web_edit.py \ --vlm_path ./models/vlm \ # 视觉-语言模型路径(下载的权重中包含) --edit_lora_path ./models/edit_lora \ # 编辑任务LoRA权重路径 --server_name "0.0.0.0" \ # 允许局域网访问 --server_port 7860 # 端口号(可修改)

启动后,在浏览器访问http://localhost:7860即可打开界面,支持上传待编辑图和参考图,输入文本指令后点击“生成”即可。

(2)生成功能Web界面

# 指定显卡(1号卡),启动生成功能Web服务 CUDA_VISIBLE_DEVICES=1 python web_generate.py \ --vlm_path ./models/vlm \ --gen_lora_path ./models/gen_lora \ # 生成任务LoRA权重路径 --server_name "0.0.0.0" \ --server_port 7861

访问http://localhost:7861即可使用生成功能,操作流程与编辑界面类似。

六、常见问题解答(FAQ)

Q:运行DreamOmni2需要什么配置?

A:推荐配置:NVIDIA显卡(显存≥8GB,支持CUDA 11.7+),CPU≥4核,内存≥16GB;最低配置:显存6GB(可生成512x512尺寸图像,但速度较慢);不支持纯CPU运行(生成速度极慢,几乎不可用)。

Q:支持哪些图像格式?

A:输入图像支持JPG、PNG、WEBP格式;输出图像默认保存为PNG格式(无损压缩)。

Q:生成/编辑一张图需要多久?

A:取决于图像尺寸和显卡性能:1024x1024尺寸在RTX 3090(24GB显存)上约需10-15秒;在RTX 3060(12GB显存)上约需20-30秒。

Q:与Midjourney、DALL-E等商业工具相比,DreamOmni2有何优势?

A:优势在于开源免费、可本地部署(保护数据隐私)、支持多参考图精确控制;劣势是在极端复杂场景(如超写实人像)的生成质量略逊于商业模型。

Q:指令描述有什么技巧?

A:建议明确“对象”“动作/属性”“参考来源”,例如:“让[图1的人物]穿着[图2的外套],站在[图3的街道]上,风格参考[图4的复古滤镜]”;避免模糊描述(如“好看一点”“修改一下”)。

Q:生成结果不符合预期怎么办?

A:可尝试:① 优化指令描述,增加细节;② 更换参考图像(确保参考图清晰);③ 多次生成(扩散模型存在随机性,多试几次可能得到更好结果)。

Q:是否支持视频生成或3D模型编辑?

A:目前不支持,DreamOmni2仅专注于2D图像的生成与编辑。

七、相关链接

八、总结

DreamOmni2作为开源多模态指令驱动的图像编辑与生成工具,通过统一架构实现了生成与编辑任务的无缝切换,其核心优势在于对跨模态指令的精准理解、对参考图像属性的高效复用,以及对非编辑区域的严格保持。无论是专业创作者提升效率,还是普通用户实现创意,均能通过简单的文本指令与参考图像,快速得到高质量结果。项目开源免费的特性降低了多模态图像创作的技术门槛,为研究与应用提供了灵活的工具基础,是当前跨模态图像生成领域极具实用价值的开源方案。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/dreamomni2.html