Fara-7B:微软开源的轻量计算机操作 AI 代理,视觉交互 + 高效 Web 任务自动化

一、Fara-7B是什么?

Fara-7B是微软研发的首款专为计算机使用设计的代理型轻量语言模型(SLM),定位为“超紧凑计算机操作代理(Ultra-compact Computer Use Agent, CUA)”。与传统生成文本响应的聊天模型不同,Fara-7B的核心价值在于通过计算机接口(鼠标、键盘)替代人类执行多步骤Web任务,实现真正意义上的“计算机操作自动化”。

作为仅含70亿参数的轻量模型,Fara-7B打破了“大参数=高性能”的固有认知——在保持超紧凑体积的同时,其性能不仅达到同尺寸模型的顶尖水平,甚至能与更大规模、更耗资源的代理系统一较高下。其设计初衷是降低计算机操作AI的使用门槛,让开发者和普通用户都能便捷地实现Web任务自动化,同时兼顾隐私性和执行效率。

简单来说,Fara-7B就像一个“虚拟助手”:它能“看见”网页内容,像人一样点击按钮、输入文字、滚动页面,自主完成从信息检索到预订操作的全流程任务,而无需用户手动干预。

二、功能特色

Fara-7B的核心优势源于其独特的设计理念和技术实现,主要功能特色可概括为以下6点:

1. 视觉化交互,无需依赖辅助解析工具

传统Web自动化工具或AI模型往往需要解析网页结构(如HTML标签、无障碍树)或依赖专用接口,而Fara-7B采用纯视觉感知模式——直接“看懂”网页视觉呈现效果,通过预测精确坐标执行点击、滚动、输入等操作。这种方式完全模拟人类使用计算机的习惯,无需额外的网页解析模型或结构化数据支持,适配所有类型的网站(包括无明确接口的动态网页)。

2. 人类级操作模态,交互更自然

Fara-7B使用与人类完全一致的操作模态:仅通过鼠标和键盘完成所有任务。无论是填写表单时的文字输入、预订时的日期选择,还是比价时的页面切换,其操作逻辑与人类用户无差异,避免了传统自动化工具“机械感”带来的兼容性问题(如被网站反爬虫机制拦截)。

3. 轻量可本地部署,低延迟+高隐私

70亿参数的紧凑设计让Fara-7B具备设备端部署能力——无需依赖高性能服务器或大量GPU资源,普通配置的设备即可运行。这带来两大核心优势:

低延迟:任务执行无需跨网络调用云端模型,响应速度更快;

高隐私:用户数据(如操作记录、表单信息)完全留存本地,不经过第三方服务器,避免数据泄露风险。

4. 任务执行高效,步骤大幅精简

同类计算机操作模型完成单任务平均需要约41步操作,而Fara-7B通过优化的决策逻辑和操作路径规划,平均仅需16步即可完成任务,效率提升超过60%。这种高效性不仅减少了任务执行时间,还降低了网络波动、页面加载失败等外部因素导致的任务中断概率。

5. 全场景Web任务覆盖,实用性强

Fara-7B可自动化日常生活和工作中绝大多数Web相关任务,核心包括:

信息搜索与结果总结(如查询Wikipedia页面数量、整理学术论文摘要);

表单填写与账户管理(如注册网站账号、修改个人信息、提交申请);

旅行与票务预订(如查询并预订机票/酒店、购买电影票、预约餐厅);

购物与比价(如查找商品、跨电商平台比价、加入购物车);

求职与房产查找(如筛选职位招聘信息、联系招聘方、查找房源并对比户型价格)。

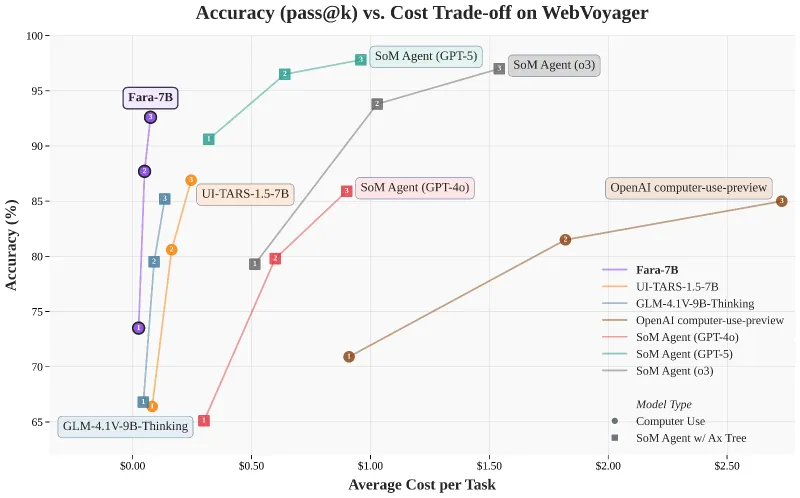

6. 领先的基准测试表现,性能可靠

Fara-7B在多个权威Web代理基准测试中表现突出,尤其在同参数规模模型中处于领先地位。以下为其与同类模型的核心性能对比:

表1:Fara-7B与同类模型跨基准性能对比(成功率%)

| 模型类型 | 模型名称 | 参数规模 | WebVoyager | Online-M2W | DeepShop | WebTailBench |

|---|---|---|---|---|---|---|

| 大型语言模型代理 | SoM Agent (GPT-4o-0513) | - | 90.6 | 57.7 | 49.1 | 60.4 |

| 大型语言模型代理 | SoM Agent (o3-mini) | - | 79.3 | 55.4 | 49.7 | 52.7 |

| 大型语言模型代理 | OpenAI computer-use-preview | - | 70.9 | 42.9 | 24.7 | 25.7 |

| 轻量语言模型 | GLM-4.1V-9B-Thinking | 9B | 66.8 | 33.9 | 32.0 | 22.4 |

| 轻量语言模型 | UI-TARS-1.5-7B | 7B | 66.4 | 31.3 | 11.6 | 19.5 |

| 轻量语言模型 | Fara-7B | 7B | 73.5 | 34.1 | 26.2 | 38.4 |

注:数据为3次独立运行的平均成功率,“-”表示未披露参数规模。

从表中可见,Fara-7B(7B参数)在WebVoyager基准中以73.5%的成功率超过所有同尺寸模型,甚至优于OpenAI的computer-use-preview;在WebTailBench(微软新发布的真实场景基准)中,38.4%的成功率大幅领先其他轻量模型,展现出极强的实际应用能力。

此外,针对真实世界Web任务设计的WebTailBench基准中,Fara-7B在多个核心任务段的表现同样亮眼:

表2:Fara-7B在WebTailBench核心任务段的性能表现(成功率%)

| 任务类型 | 任务数量 | Fara-7B | UI-TARS-1.5-7B | GLM-4.1V-9B | OpenAI computer-use-preview |

|---|---|---|---|---|---|

| 购物(单网站) | 56 | 52.4 | 41.1 | 31.0 | 42.3 |

| 酒店预订 | 52 | 53.8 | 35.3 | 19.9 | 26.9 |

| 餐厅预订 | 52 | 47.4 | 22.4 | 32.1 | 35.9 |

| 多商品购物清单 | 51 | 49.0 | 20.9 | 7.8 | 34.0 |

| 跨平台比价 | 57 | 32.7 | 8.8 | 22.8 | 1.2 |

注:数据为3次独立运行的平均成功率,WebTailBench共包含609个任务,覆盖11类真实场景。

三、技术细节

Fara-7B的高性能和独特功能源于其严谨的技术设计,核心技术细节可从训练基础、数据 pipeline、评估框架三个维度展开:

1. 模型基础与训练方式

底层模型:基于Qwen2.5-VL-7B构建,Qwen2.5-VL系列以强大的视觉理解能力和轻量部署特性著称,为Fara-7B的视觉交互提供了坚实基础;

训练方法:采用监督微调(Supervised Fine-Tuning, SFT),通过高质量标注数据优化模型的操作决策逻辑;

核心优化:针对计算机操作场景,重点优化了“视觉感知→动作预测→反馈调整”的闭环流程,确保模型能精准理解网页内容并执行正确操作。

2. 数据生成 pipeline

Fara-7B的训练数据来自微软自研的Magentic-One多代理框架,该框架能生成高质量、多样化的合成训练数据:

数据规模:145K条任务轨迹,覆盖不同类型网站(电商、旅游、招聘、房产等)、不同任务难度(简单查询→复杂多步骤操作);

数据多样性:包含单网站任务、跨网站任务、时间敏感任务(如预订)等多种场景,确保模型的泛化能力;

数据优势:合成数据可精准控制任务流程和标注质量,避免真实数据中的噪声和隐私风险,同时能覆盖真实场景中难以获取的边缘案例。

3. 评估框架与技术保障

为解决Web任务自动化评估的复杂性(如网站内容动态变化、任务时效性),Fara-7B配套了完整的评估框架(webeval目录),核心技术保障包括:

基准测试工具:推出WebTailBench新基准,包含609个真实世界任务,分为8个单技能任务段和3个复杂多步骤/跨网站任务段,填补现有基准对真实场景覆盖不足的空白;

自动化测试环境:基于Playwright(跨浏览器自动化框架)构建,可精准模拟Chrome、Firefox等主流浏览器环境,确保评估结果的通用性;

接口兼容性:通过Abstract Web Agent Interface,支持任何来源的模型接入评估环境,方便开发者对比不同模型性能;

鲁棒性优化:

任务更新:移除WebVoyager基准中48个不可完成的任务,更新50个过期任务(如将2024年日期改为2026年),确保任务可执行性;

错误处理:浏览器连接中断、页面超时等环境错误时,轨迹最多重试5次,且每次重试均启动全新浏览器会话,避免状态残留;

步骤预算:每个任务轨迹最多允许100步操作,超出则判定为任务失败,确保评估效率。

四、应用场景

Fara-7B的核心价值在于“自动化Web任务”,其应用场景覆盖个人生活、工作办公、企业运营等多个维度,以下为典型场景的详细说明:

1. 个人日常Web任务自动化

信息高效检索与总结:自动搜索指定主题(如“2025年全球AI发展报告”),浏览多个来源的网页内容,提取核心信息并生成摘要,无需手动打开多个网站逐一阅读;

生活服务预订:自动查询符合条件的机票/酒店(如“北京→上海2025年12月10日经济舱,价格低于800元”),对比不同平台价格,完成预订流程;或根据口味、评分自动查找附近餐厅并预约座位;

购物比价与下单:根据需求(如“性价比高的无线耳机,预算1000元内”),自动浏览京东、天猫、拼多多等平台,对比商品参数、价格、评价,生成比价报告,甚至可自动加入购物车;

表单自动填写:申请账号、报名活动、提交资料时,自动填写预设的个人信息(姓名、联系方式等),避免重复输入,提高效率。

2. 工作办公效率提升

求职与招聘辅助:求职者可通过Fara-7B自动筛选招聘网站(如BOSS直聘、智联招聘)中的目标岗位(如“北京+AI算法+3年经验”),提取岗位核心要求,甚至自动发送简历;企业HR可自动收集多个招聘平台的简历,按预设条件筛选;

房产信息整理:租房/买房时,自动浏览链家、贝壳等平台,筛选符合预算、户型、地段要求的房源,整理房源参数、价格走势、联系方式,生成对比表格;

数据收集与整理:需要从多个网站收集公开数据(如行业报告、统计数据)时,Fara-7B可自动访问目标网站,提取数据并按格式整理(如Excel表格),避免手动复制粘贴的繁琐操作。

3. 企业级Web流程优化

客户服务自动化:针对电商、旅游等行业,自动处理客户的常见Web操作需求(如查询订单状态、修改预订信息、申请退款),减轻人工客服压力;

市场调研自动化:自动监控竞品网站的产品价格、促销活动、新品发布信息,实时收集并整理数据,为企业决策提供支持;

业务流程自动化:金融、政务等领域的表单提交、信息核验等流程,可通过Fara-7B自动完成,提高流程效率并降低人工操作错误率。

4. 开发者与研究场景

AI代理技术探索:开发者可基于Fara-7B的开源代码,研究计算机操作AI的视觉交互、决策逻辑等核心技术,快速搭建自定义代理系统;

基准测试与模型对比:借助配套的webeval评估框架,可便捷地测试不同模型在Web任务中的性能,为研究提供可靠数据支持;

二次开发与定制:根据特定场景需求(如垂直行业的Web自动化),基于Fara-7B进行二次训练或功能扩展,开发专属的计算机操作代理。

五、使用方法

Fara-7B提供两种灵活的部署方式(Azure Foundry托管、VLLM自托管),同时配套完整的测试和评估工具,以下为详细使用步骤:

1. 前期准备

(1)环境要求

操作系统:支持Windows、macOS、Linux;

Python版本:3.12(推荐,评估框架需该版本支持);

依赖工具:Git、pip/uv(Python包管理工具)、Playwright(浏览器自动化工具)。

(2)基础安装

首先克隆GitHub仓库并安装核心依赖:

# 克隆仓库 git clone https://github.com/microsoft/fara.git cd fara # 安装核心包(二选一) # 方式1:使用uv(推荐,速度更快) uv sync --all-extras # 方式2:使用pip pip install -e . # 安装Playwright浏览器(必需,用于模拟浏览器环境) playwright install

2. 部署方式选择

Fara-7B支持两种部署方式,可根据自身资源和需求选择:

(1)Azure Foundry托管(推荐,无需GPU)

该方式无需下载模型权重或配置GPU,直接使用Azure的托管服务,适合快速上手:

部署模型:在Azure Foundry平台部署Fara-7B模型,获取专属的

endpoint URL和API key;配置端点:在仓库的

endpoint_configs/目录下创建或修改配置文件(示例格式如下):

// endpoint_configs/fara-7b-azure.json

{

"model": "Fara-7B",

"base_url": "https://your-endpoint.inference.ml.azure.com/",

"api_key": "YOUR_API_KEY_HERE"

}运行代理:通过测试脚本执行任务,示例命令:

python test_fara_agent.py --task "how many pages does wikipedia have" --start_page "https://www.bing.com" --endpoint_config endpoint_configs/fara-7b-azure.json

参数说明:

--task:指定要执行的任务(支持自然语言描述);--start_page:任务起始网页URL;--endpoint_config:指定Azure部署的配置文件路径;可选参数:

--headful(显示浏览器界面,默认后台运行)、--save_screenshots(保存操作截图)、--max_rounds 100(设置最大操作步数)。

(2)VLLM自托管(需GPU,本地部署)

若需本地控制模型或无Azure账号,可通过VLLM自托管,需GPU支持(需足够VRAM):

下载模型权重:通过脚本从Hugging Face下载Fara-7B权重(需Hugging Face账号):

# 安装Hugging Face Hub工具(若未安装) pip install -U huggingface_hub # (可选)登录Hugging Face CLI huggingface-cli login # 下载模型到指定目录(默认:model_checkpoints/fara-7b/) python scripts/download_model.py --output-dir ./model_checkpoints --token YOUR_HF_TOKEN

YOUR_HF_TOKEN:在Hugging Face个人设置中获取的访问令牌。

启动VLLM服务:

# 进入VLLM部署目录 cd src/fara/vllm # 安装VLLM依赖 pip install -r requirements.txt # 启动服务(默认端口5000,支持多GPU部署) python az_vllm.py --model_url ../../model_checkpoints/fara-7b/ --device_id 0,1

参数说明:

--device_id 0,1表示使用第1、2块GPU(根据实际GPU数量调整)。

测试自托管服务:

python test_fara_agent.py --task "查找北京2025年12月的演唱会门票" --start_page "https://www.bing.com" --endpoint_config endpoint_configs/vllm_config.json

vllm_config.json:仓库中提供的VLLM默认配置文件,无需修改(若端口变更需同步更新)。

3. 评估框架使用(WebEval)

若需复现Fara-7B的基准测试结果或测试自定义模型,可使用配套的webeval框架:

(1)安装评估环境

# 创建并激活conda环境(推荐,避免依赖冲突) conda create --name fara_webeval python=3.12 conda activate fara_webeval # 安装Fara核心包 pip install -e . # 安装autogen子模块(评估依赖) git submodule update --init --recursive cd autogen/python/packages pip install -e autogen-core pip install -e autogen-ext # 安装webeval评估包 cd ../../../../webeval pip install -e . # 安装Playwright浏览器(若已安装可跳过) playwright install

(2)运行评估

方式1:基于VLLM自托管模型评估

# 进入评估脚本目录 cd webeval/scripts # 运行WebVoyager基准评估 python webvoyager.py --model_url ../../model_checkpoints/fara-7b/ --model_port 5000 --eval_oai_config ../endpoint_configs_gpt4o/dev/ --out_url /data/data/Fara/eval --device_id 0,1 --processes 1 --run_id 1 --max_rounds 100

方式2:基于Azure Foundry部署评估

cd webeval/scripts # 运行评估(需先配置endpoint_configs/中的Azure端点) python webvoyager.py --model_endpoint ../../endpoint_configs/ --eval_oai_config ../endpoint_configs_gpt4o/dev/ --out_url /data/data/Fara/eval --processes 1 --run_id 1_endpoint --max_rounds 100

参数说明:

--eval_oai_config:指定GPT-4o的配置文件(用于LLM-as-a-judge评估);--out_url:评估结果保存路径;--processes:并发进程数(建议不超过10,避免VLLM服务过载);--browserbase:(可选)启用BrowserBase管理浏览器会话(需导出API key和项目ID环境变量)。

(3)分析评估结果

评估结果会按“模型名→数据集→用户名→运行ID”的目录结构保存,包含轨迹日志、截图、LLM评分等。可通过Jupyter Notebook分析结果:

cd webeval/scripts/analyze_eval_results/ jupyter notebook analyze.ipynb

该脚本可自动计算任务成功率、识别失败原因、区分“任务中断”和“完成但错误”的轨迹,支持重新运行失败任务。

4. 预期输出示例

执行测试命令后,终端会输出任务结果和操作日志,示例如下:

[fara_agent] Wikipedia currently has approximately 64,394,387 pages.

<tool_call>

{"name": "computer_use", "arguments": {"action": "terminate", "status": "success"}}

</tool_call>

[fara_agent] Wikipedia currently has approximately 64,394,387 pages.

INFO:__main__:Closing browser...若任务成功,

status为success并输出最终结果;若任务失败(如超出最大步数、环境错误),会显示失败原因(如

<step_budget_exceeded>)。

六、常见问题解答(FAQ)

1. Fara-7B与传统聊天模型(如GPT-4、Qwen)的核心区别是什么?

传统聊天模型以“生成文本”为核心,无法直接操作计算机;Fara-7B以“执行计算机操作”为核心,通过视觉感知和鼠标/键盘交互完成Web任务,无需用户手动转化文本指令为操作。例如,同样是“查询机票”,聊天模型会返回搜索链接,而Fara-7B会直接打开浏览器、输入查询条件、对比价格并返回结果。

2. 运行Fara-7B需要什么硬件配置?

Azure Foundry托管:无需任何GPU或高性能硬件,普通电脑即可(仅需网络连接);

VLLM自托管:需GPU支持,建议单卡VRAM≥16GB(7B参数模型的基础需求),多卡部署可提升并发性能。

3. Fara-7B支持哪些浏览器?

基于Playwright框架,支持Chrome、Firefox、Safari等所有主流浏览器,默认使用Chrome,可在配置文件中修改。

4. 如何处理任务执行失败的情况?

任务失败可能源于以下原因,可按对应方式排查:

网站内容变更:Web任务具有时效性,可尝试更新

start_page或修改任务描述;操作步数不足:增加

--max_rounds参数(默认100步,复杂任务可设为200);GPU资源不足(自托管):减少并发进程数或更换更高VRAM的GPU;

网络问题:检查网络连接,启用

--browserbase优化浏览器会话稳定性。

5. Fara-7B的用户数据是否会上传到云端?

设备端部署(VLLM自托管):所有数据(操作记录、截图、任务信息)均留存本地,无云端上传;

Azure Foundry托管:数据仅在Azure平台内部传输,遵循Azure的隐私政策,微软不会主动收集或使用用户任务数据。

6. 能否自定义Fara-7B的任务类型?

支持。Fara-7B的任务描述采用自然语言格式,可直接输入自定义任务(如“从XX网站下载2025年Q3的财务报告并转换为Excel”),模型会自动解析并执行。若需固定任务流程,可修改test_fara_agent.py脚本或基于Fara-Agent Class开发自定义代理。

7. Fara-7B的开源协议是什么?

采用MIT开源许可证,允许自由使用、修改、分发,商业用途无需额外授权,但需保留原作者版权声明和许可证文件。

8. 为什么部分任务的成功率不如预期?

Web任务的成功率受多种因素影响:

网站反爬虫机制:部分网站会拦截自动化工具,可启用

--headful模式(显示浏览器界面)或添加随机操作间隔(需二次开发);任务复杂度:跨网站、多步骤任务(如“比价后预订+填写发票信息”)成功率低于单步骤任务;

模型局限性:7B参数模型的复杂推理能力有限,极端场景(如需要复杂逻辑判断的表单填写)可能存在不足。

七、相关链接

GitHub仓库:https://github.com/microsoft/fara

八、总结

Fara-7B作为微软开源的首款轻量计算机操作智能代理,以70亿参数实现了同类领先的Web任务自动化能力,其核心优势在于“视觉化交互+轻量部署+高效执行”——通过模拟人类鼠标/键盘操作打破了传统文本模型的局限,7B参数规模支持设备端部署,兼顾低延迟和高隐私性,平均16步的任务执行效率远超同类模型。该项目配套了完整的评估框架(含WebTailBench新基准)和两种灵活部署方式(Azure托管免GPU、VLLM自托管本地可控),覆盖信息搜索、预订、购物、表单处理等多类实用场景,既适合普通用户快速实现日常Web任务自动化,也为开发者提供了探索计算机操作AI的开源工具包。Fara-7B的发布不仅填补了轻量级计算机操作AI的技术空白,其开源特性和领先性能也有望推动Web自动化、智能代理等领域的应用普及和技术创新。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/fara-7b.html