FlashVSR:开源实时视频超分辨率框架,基于扩散模型实现高效高画质视频增强

一、FlashVSR是什么

FlashVSR是一款开源的基于扩散模型的实时视频超分辨率框架,主打高效性、可扩展性与高保真度,创新性提出三阶段蒸馏管道与局部约束稀疏注意力机制,解决传统扩散模型视频超分速度慢、分辨率受限的痛点。该框架支持4倍视频超分,可在A100 GPU上以17 FPS速度处理768×1408分辨率视频,兼容ComfyUI等主流工作流,适用于影视修复、监控画质提升、直播实时增强等多个场景,为开发者与研究人员提供高性能、易部署的视频超分解决方案。

视频超分辨率(Video Super-Resolution,VSR)技术是计算机视觉领域的重要分支,其核心目标是将低分辨率、模糊的视频帧转化为高分辨率、细节丰富的视频内容,广泛应用于影视修复、监控安防、直播点播等领域。传统的视频超分模型主要分为两类:一类是基于深度学习的非扩散模型(如EDVR、BasicVSR),这类模型速度较快但细节重建能力不足,容易出现边缘模糊、伪影等问题;另一类是基于扩散模型的超分方案,这类模型凭借强大的生成能力能够还原更真实的细节,但存在计算复杂度高、推理速度慢、难以处理高分辨率视频的短板,无法满足实时应用的需求。

FlashVSR正是为解决上述痛点而生的开源项目,它由OpenImagingLab团队研发,是首个基于扩散模型的单步流式视频超分辨率框架。该框架创新性地融合了蒸馏技术、稀疏注意力机制与轻量化解码器设计,在保留扩散模型高画质优势的同时,实现了推理速度的数量级提升,打破了扩散模型在实时视频超分场景中的应用限制。目前,FlashVSR已发布v1和v1.1两个版本,v1.1版本在v1的基础上进一步增强了模型的稳定性与细节保真度,成为开源社区中性能领先的实时视频超分工具。

二、功能特色

FlashVSR凭借其创新的技术架构,在功能上展现出四大核心特色,全面超越传统扩散模型视频超分方案,具体如下:

1. 实时高分辨率推理能力

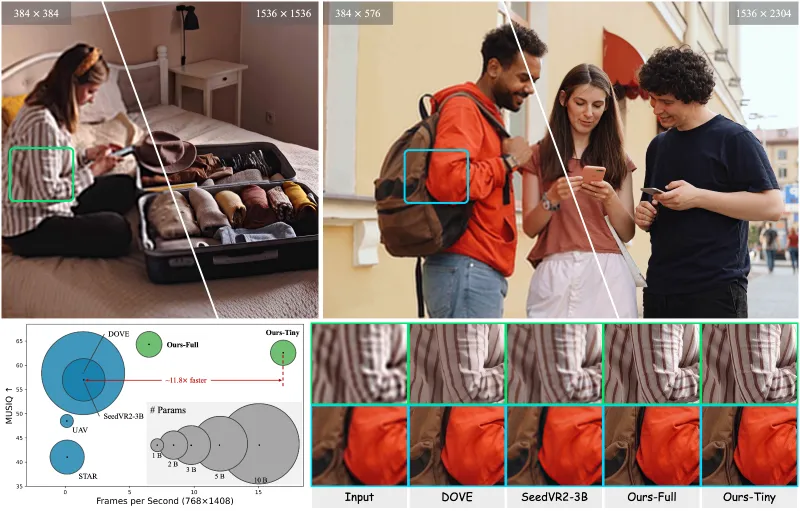

这是FlashVSR最核心的优势。传统扩散模型视频超分需要多步迭代采样,推理速度极慢,难以处理720P以上的视频;而FlashVSR通过单步采样设计与计算优化,能够在单张A100 GPU上以约17 FPS的速度处理768×1408分辨率的视频,相比先前的单步扩散VSR模型实现了高达12倍的速度提升。同时,该框架支持流式推理,可逐帧处理视频流,无需等待整段视频加载完成,完美适配直播、实时监控等低延迟需求的场景。

2. 高保真度细节重建

FlashVSR并未因追求速度而牺牲画质,其基于扩散模型的本质确保了强大的细节生成能力。在4倍超分(×4)设置下,该模型能够精准还原视频中的纹理、边缘、光影等细节,有效解决了传统非扩散模型超分后的模糊、伪影问题。官方测试结果显示,FlashVSR在多个公开视频超分数据集(如Vimeo-90K、REDS)上的主观画质评分与客观指标(如PSNR、SSIM)均达到领先水平,尤其在处理复杂动态场景(如运动物体、光影变化)时,能够保持帧间一致性,避免出现画面抖动、重影等问题。

3. 可扩展性强,支持超高分辨率视频

传统扩散模型受限于计算资源,难以处理4K及以上分辨率的视频;而FlashVSR引入的局部约束稀疏注意力(LCSA) 机制,通过减少冗余计算,弥合了训练与测试分辨率之间的差距,使模型能够可靠地扩展到超高分辨率视频处理。用户可以基于该框架轻松实现对1080P、2K、4K视频的超分增强,且无需大幅增加硬件成本。

4. 开源易用,生态兼容性好

FlashVSR是完全开源的项目,代码结构清晰,文档完善,支持开发者进行二次开发与定制化优化。同时,该框架与开源社区的主流工具深度集成:一方面,支持ComfyUI可视化工作流,用户无需编写代码即可通过拖拽节点的方式完成视频超分推理;另一方面,提供了云服务/API部署方案,第三方平台(如fal.ai、WaveSpeed AI、Segmind)已基于FlashVSR推出在线推理服务,用户可直接调用API实现视频增强。此外,框架支持分布式训练,能够利用多GPU集群加速模型训练过程,降低研究与应用的成本。

三、技术细节

FlashVSR的高性能源于其创新的技术架构,核心包含三阶段蒸馏管道、局部约束稀疏注意力机制、小型条件解码器三大关键技术,以下对其进行详细拆解:

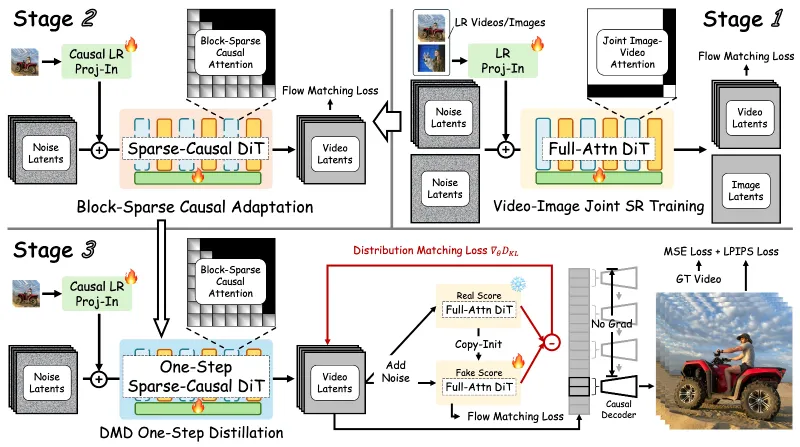

1. 核心技术架构总览

FlashVSR的整体架构分为训练与推理两个阶段,训练阶段采用三阶段蒸馏策略,将复杂的多步扩散模型知识蒸馏到轻量级单步模型中;推理阶段则基于蒸馏后的单步模型,结合局部约束稀疏注意力与小型解码器,实现高效推理。其架构流程如下:

预训练多步扩散模型:作为教师模型,具备强大的细节生成能力,但推理速度慢。

蒸馏得到单步扩散模型:通过知识蒸馏技术,将教师模型的能力迁移到单步学生模型中,实现一步采样即可完成超分。

引入局部约束稀疏注意力优化:在学生模型中替换传统的密集注意力,减少计算量。

小型条件解码器加速重建:设计轻量化解码器,在不损失画质的前提下提升推理速度。

2. 三阶段蒸馏管道

知识蒸馏是将复杂模型(教师模型)的知识迁移到简单模型(学生模型)的技术,FlashVSR创新性地提出三阶段蒸馏管道,专门针对流式视频超分场景进行优化,具体步骤如下:

阶段1:帧内蒸馏:聚焦单帧图像的超分能力,将教师模型在单帧上的细节生成知识迁移到学生模型,确保学生模型具备基础的超分重建能力。

阶段2:帧间蒸馏:针对视频的时序特性,蒸馏教师模型的帧间一致性建模能力,使学生模型能够处理视频的动态变化,避免帧间抖动、重影。

阶段3:流式蒸馏:模拟流式推理场景,让学生模型在逐帧输入的条件下进行训练,提升模型在实时视频流处理中的稳定性与适应性。

通过这三个阶段的蒸馏,FlashVSR的学生模型不仅继承了教师模型的高画质优势,还实现了单步推理的高效性,解决了传统扩散模型“多步采样慢”的核心痛点。

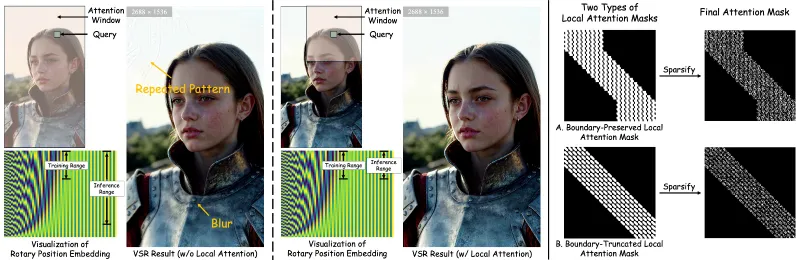

3. 局部约束稀疏注意力(LCSA)

注意力机制是深度学习模型捕捉长距离依赖的核心模块,但传统的密集注意力机制计算复杂度极高(与分辨率的平方成正比),处理高分辨率视频时会消耗大量显存与计算资源。

FlashVSR提出的局部约束稀疏注意力机制,通过两个核心策略降低计算量:

局部约束:将注意力的计算范围限制在每个像素的局部邻域内,而非全局范围,大幅减少注意力矩阵的大小。

稀疏采样:在局部邻域内稀疏地采样注意力关键点,而非对所有像素进行计算,进一步降低冗余运算。

该机制在保证模型捕捉关键细节依赖的同时,将注意力计算的复杂度从 $O(H^2W^2)$ 降低到 $O(HW)$(其中H、W为图像的高度和宽度),使模型能够高效处理高分辨率视频。需要注意的是,部分第三方实现的FlashVSR可能未集成LCSA模块,而是使用传统的密集注意力,这会导致模型在高分辨率下的质量与速度均出现下降。

4. 小型条件解码器

解码器是超分模型的核心组件,负责将模型提取的特征映射为高分辨率图像。FlashVSR设计了小型条件解码器,其核心特点如下:

轻量化设计:减少解码器的网络层数与参数量,降低计算复杂度。

条件输入机制:将低分辨率视频帧的特征与时序信息作为条件输入,引导解码器生成高保真的超分结果。

多尺度融合:融合不同尺度的特征信息,提升模型对细节的还原能力。

该解码器在不牺牲画质的前提下,显著提升了图像重建的速度,与LCSA机制配合,共同构成了FlashVSR高效推理的核心。

5. 数据集支撑:VSR-120K

为了训练出高性能的模型,FlashVSR团队构建了VSR-120K大规模视频超分数据集,该数据集包含12万段视频和18万张图像,涵盖了多种场景(如自然风光、城市街道、人物动作、室内环境等),能够充分覆盖现实世界中的视频类型。目前该数据集尚未完全公开,但团队表示将在后续版本中逐步开放,为社区研究提供支持。

四、应用场景

FlashVSR凭借其实时性、高画质、可扩展性的优势,能够广泛应用于多个领域,具体场景如下:

1. 影视与短视频修复

在影视行业中,大量老片、纪录片存在分辨率低、画面模糊的问题,传统修复方法成本高、效率低;在短视频领域,用户拍摄的视频可能因设备限制导致画质不佳。FlashVSR可快速将低分辨率视频超分为高清视频,还原细节与色彩,提升观看体验。例如,将标清(480P)老电影修复为1080P甚至4K分辨率,且保持帧间流畅性,无明显伪影。

2. 监控安防画质提升

监控摄像头受限于硬件成本、环境因素(如夜间、逆光),拍摄的视频往往分辨率低、噪点多,难以清晰识别人物、车牌等关键信息。FlashVSR支持实时流式处理,可对监控视频进行在线超分增强,提升画面清晰度,帮助安防人员快速定位目标,降低破案难度。同时,该框架可部署在边缘设备(如GPU服务器)上,满足监控系统的低延迟需求。

3. 直播与视频会议实时增强

直播主播、视频会议用户可能因网络带宽限制或设备性能不足,导致画面分辨率低、卡顿。FlashVSR可作为直播推流、视频会议软件的后端插件,对视频流进行实时超分处理,在不增加带宽消耗的前提下,提升画面质量。例如,将720P直播流超分为1080P,让观众获得更清晰的观看体验。

4. 自动驾驶与机器人视觉

自动驾驶车辆、服务机器人的视觉系统需要处理实时的环境视频,低分辨率、模糊的画面会影响目标检测、路径规划的准确性。FlashVSR可对视觉传感器采集的视频进行实时超分增强,帮助系统更清晰地识别行人、车辆、交通标识等目标,提升自动驾驶与机器人的安全性与可靠性。

5. 科研与二次开发

对于计算机视觉领域的研究人员而言,FlashVSR提供了一个高性能的扩散模型视频超分基线,可基于该框架进行进一步的技术创新,如探索新的注意力机制、蒸馏策略、轻量化方法等。同时,框架的开源特性允许开发者根据具体需求进行定制化修改,如适配特定场景的数据集、优化模型在边缘设备上的部署性能。

五、使用方法

FlashVSR的使用方法分为环境配置、模型推理、模型训练三个部分,同时支持ComfyUI可视化操作,以下为详细步骤:

1. 环境配置

FlashVSR基于Python与PyTorch开发,需配置以下环境依赖:

(1)硬件要求

GPU:推荐使用NVIDIA GPU(显存≥10GB,如A100、RTX 3090、RTX 4090),支持CUDA加速;

CPU:多核处理器(≥8核),用于数据预处理;

内存:≥16GB,确保数据加载与模型运行的流畅性。

(2)软件安装

克隆代码仓库

git clone https://github.com/OpenImagingLab/FlashVSR.git cd FlashVSR

创建并激活虚拟环境

conda create -n flashvsr python=3.10 conda activate flashvsr

安装依赖包

pip install -r requirements.txt # 安装对应版本的PyTorch(支持CUDA 11.7+) pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu117

2. 模型推理

FlashVSR支持单张图片、本地视频、视频流三种输入类型,官方推荐使用4倍超分(×4)设置以获得最佳效果,以下为常用推理命令:

(1)单张图片超分

python inference.py \ --input ./examples/low_res_img.png \ --output ./results/high_res_img.png \ --scale 4 \ --model_path ./weights/flashvsr_v1.1.pth

(2)本地视频超分

python inference_video.py \ --input ./examples/low_res_video.mp4 \ --output ./results/high_res_video.mp4 \ --scale 4 \ --model_path ./weights/flashvsr_v1.1.pth \ --fps 30

(3)ComfyUI可视化推理

克隆第三方ComfyUI插件仓库(如smthemex/ComfyUI_FlashVSR);

将插件复制到ComfyUI的

custom_nodes目录下;启动ComfyUI,拖拽

FlashVSR Loader、FlashVSR Inference等节点,连接输入输出后运行即可。

3. 模型训练

FlashVSR支持单机单卡、单机多卡、多机多卡三种训练模式,以下为单机多卡训练的基本步骤:

准备数据集:将训练数据整理为“低分辨率-高分辨率”配对格式,放入

./datasets目录;修改配置文件:在

./configs/flashvsr_v1.1.yaml中设置数据集路径、训练批次大小、学习率、GPU数量等参数;启动训练

torchrun --nproc_per_node=4 train.py --config ./configs/flashvsr_v1.1.yaml

监控训练过程:可通过TensorBoard查看训练损失、验证集指标等信息

tensorboard --logdir ./logs

4. 不同使用场景的参数优化建议

为了帮助用户在不同场景下获得最佳的速度与画质平衡,以下表格提供了针对性的参数优化建议:

| 使用场景 | 推荐GPU | 超分倍数 | 关键参数调整 | 预期效果 |

|---|---|---|---|---|

| 实时直播增强 | RTX 3090 | ×4 | batch_size=4,启用LCSA | 1080P视频推理速度≥15 FPS,画质清晰无延迟 |

| 离线影视修复 | A100 | ×4/×2 | batch_size=8,关闭LCSA(追求极致画质) | 4K视频修复,细节还原度高 |

| 监控视频实时处理 | RTX 4070 | ×4 | 启用流式推理,降低输入分辨率 | 720P监控视频实时超分,噪点减少 |

| 科研实验 | 多卡RTX 3090 | ×4 | 调整蒸馏温度、注意力稀疏度 | 快速验证新算法,平衡训练速度与精度 |

六、常见问题解答

1. 推理速度慢,达不到官方宣称的17 FPS怎么办?

检查硬件配置:确保使用支持CUDA的NVIDIA GPU,且显存≥10GB,避免使用CPU推理;

启用LCSA机制:确认配置文件中

use_lcsa: True,部分第三方实现未默认开启该功能;降低输入分辨率:若GPU性能不足,可将输入视频分辨率降低至720P以下,提升推理速度;

优化批量大小:适当调整

batch_size参数,避免因批次过大导致显存不足而触发降速。

2. 超分后的视频出现帧间抖动、重影怎么办?

检查帧间一致性参数:在配置文件中增大

frame_consistency_weight,增强模型对时序信息的建模能力;使用流式推理模式:对于视频流输入,启用

streaming: True参数,模拟训练时的流式场景;预处理输入视频:对输入视频进行去抖动处理,减少原始视频的帧间偏移。

3. 训练过程中出现显存溢出(OOM)错误怎么办?

降低批次大小:减小配置文件中的

batch_size参数,例如从8调整为4;启用梯度累积:设置

gradient_accumulation_steps=2,在不降低有效批次大小的前提下减少显存占用;使用混合精度训练:在配置文件中开启

fp16: True,支持自动混合精度训练,大幅降低显存消耗;降低注意力分辨率:调整

attention_scale参数,缩小注意力计算的分辨率。

4. ComfyUI插件无法加载模型怎么办?

检查模型路径:确保将下载的模型权重放入ComfyUI的

./models/FlashVSR目录;更新插件版本:部分旧版插件不支持v1.1模型,建议克隆最新的第三方插件仓库;

检查依赖版本:确保ComfyUI的Python环境中安装了

torch>=2.0、diffusers>=0.20等依赖。

5. 超分后的视频出现颜色失真怎么办?

调整色彩校正参数:在推理脚本中增加

color_correction: True,启用自动色彩校正;检查输入视频格式:避免使用色域异常的视频格式(如YUV420P),建议将输入转换为RGB格式;

使用最新模型权重:v1.1版本修复了v1版本的色彩失真问题,建议下载最新的

flashvsr_v1.1.pth权重。

6. 能否在边缘设备(如Jetson Nano)上部署FlashVSR?

可以,但需要进行轻量化优化:

模型量化:使用PyTorch的量化工具将模型转换为INT8格式,减少显存占用;

剪枝模型:去除模型中的冗余层,降低参数量;

使用TensorRT加速:将PyTorch模型转换为TensorRT引擎,提升边缘设备的推理速度。

七、相关链接

第三方ComfyUI插件:https://github.com/smthemex/ComfyUI_FlashVSR

八、总结

FlashVSR是一款由OpenImagingLab研发的开源实时视频超分辨率框架,它创新性地将知识蒸馏、局部约束稀疏注意力与轻量化解码器相结合,成功解决了传统扩散模型视频超分速度慢、分辨率受限的核心痛点,实现了“高画质”与“实时性”的完美平衡。该框架支持4倍视频超分,可在A100 GPU上以17 FPS速度处理768×1408分辨率视频,同时具备良好的可扩展性与生态兼容性,不仅能满足影视修复、监控安防、直播增强等实际应用场景的需求,还为科研人员提供了高性能的基线模型与二次开发平台。作为开源社区中的一款优秀工具,FlashVSR凭借其高效、易用、高保真的特性,正在推动扩散模型在视频超分领域的产业化应用,为各行各业的视频增强需求提供了可靠的解决方案。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/flashvsr.html