GLM-Image:智谱AI与华为联合开源的国产全栈算力支撑多模态图像生成模型

一、GLM-Image是什么

GLM-Image是由智谱AI与华为联合研发并开源的新一代工业级多模态图像生成模型,隶属于智谱GLM大模型生态,是国内首个全流程基于国产算力底座完成训练、优化与部署的SOTA(当前最优性能)级图像生成模型。该模型采用“90亿参数自回归生成器+70亿参数扩散解码器”的混合架构,核心优势在于中文/英文文本精准渲染、知识密集型场景图像生成、高分辨率图像原生适配,同时支持文本到图像(T2I)、图像到图像(I2I)两大核心任务。模型全流程依托华为昇腾Atlas 800T A2算力设备与昇思MindSpore框架构建,打破了高端多模态模型对海外芯片的依赖。

从技术定位来看,GLM-Image并非传统的纯扩散模型,而是一款融合自回归语义理解与扩散细节生成的混合架构模型,主打“认知型生成”能力——不仅能完成基础的图像视觉效果复刻,还能深度理解复杂文本指令中的逻辑关系、专业知识与排版要求,精准生成包含密集文字、结构化布局的图像内容,填补了传统图像生成模型在“文本渲染失真”“语义理解偏差”“知识密集型场景适配差”等方面的短板。

从产业价值来看,GLM-Image的推出具有里程碑意义:其训练、优化的全链路均基于华为昇腾Atlas 800T A2高性能计算设备与昇思MindSpore全场景AI框架,彻底打破了高端多模态图像生成模型对海外芯片与底层框架的路径依赖,验证了国产全栈算力底座支撑前沿AI模型研发的可行性与可靠性,为国产AI技术生态的自主化发展奠定了关键基础。

二、功能特色

GLM-Image凭借独特的混合架构设计与国产算力适配优化,在功能上形成了与传统图像生成模型的差异化竞争优势,核心特色可概括为六大核心能力,同时在成本、生态适配性上也具备显著亮点:

(一)强文本渲染能力,中/英文精准还原

文本渲染是AI图像生成领域的长期痛点,传统模型常出现文字笔画缺失、字形失真、排版混乱等问题,而GLM-Image通过在扩散解码器中集成Glyph Encoder文本模块(Glyph-byT5),实现了中、英文文本的高精度渲染,尤其在汉字生成任务中表现突出。在权威基准测试中,该模型的文本渲染准确率远超同类开源模型:

在CVTG-2K(复杂视觉文本生成)基准测试中,词准确率达到91.16%,高于Seedream 4.5的89.9%;

在LongText-Bench-ZH(中文长文本渲染)基准测试中,准确率高达97.88%,能精准处理多行文本、段落级语义与复杂排版要求;

在LongText-Bench EN(英文长文本渲染)基准测试中,准确率达95.57%,处于行业领先水平。

(二)知识密集型场景深度适配

针对包含专业知识、逻辑流程、结构化信息的图像生成需求(如科普原理示意图、技术文档插图、学术海报等),GLM-Image的自回归模块能深度解析文本指令中的专业术语、逻辑关系与层级结构,从全局上把控图像的构图逻辑与知识表达,生成的内容既符合视觉美学,又能精准传递专业信息,有效降低了知识密集型图像内容的创作门槛。

(三)高分辨率图像原生适配,无需二次训练

通过优化Tokenizer策略,GLM-Image实现了对1024×1024至2048×2048尺寸范围内任意比例图像的原生生成支持,且所有生成尺寸仅需满足“能被32整除”的条件即可,无需针对不同分辨率开展二次训练或微调。这一特性大幅提升了模型的应用灵活性,可直接适配正方形、横向、纵向、宽屏等多种构图需求,满足不同场景的视觉输出要求。

(四)双核心生成任务全覆盖

GLM-Image在单一模型中整合了文本到图像(T2I) 与图像到图像(I2I) 两大核心能力,无需切换模型即可完成多样化的图像生成需求:

T2I任务:从自然语言描述生成高细节图像,支持复杂多主体构图、知识密集型内容创作;

I2I任务:支持图像编辑、风格迁移、多主体一致性生成、人物/物体身份保留生成等子任务,能在保留原图核心特征的基础上,根据文本指令完成修改与优化。

(五)国产算力全流程支撑,自主可控性强

GLM-Image是国内首个全链路基于国产算力构建的SOTA级图像生成模型,从数据预处理、模型预训练,到后续微调与强化学习后训练,均依托华为昇腾Atlas 800T A2算力设备与昇思MindSpore框架完成。同时,智谱AI还针对性研发了专用训练套件,通过三大优化策略充分释放国产算力潜能,确保模型训练的效率与稳定性,实现了核心技术的自主可控。

(六)低成本商业化适配,普惠性强

在商业化应用层面,GLM-Image具备显著的成本优势:官方披露的API调用模式下,生成单张图像的成本仅为0.1元,远低于同类SOTA级图像生成模型,使得中小企业乃至个人开发者都能低成本获取前沿图像生成能力。此外,官方还计划推出高并发商业场景的速度优化版本,进一步提升图像生成速度,适配电商促销、节日营销等高峰期的批量创作需求。

三、技术细节

GLM-Image的核心竞争力源于其自主创新的混合架构设计与针对国产算力的深度优化,同时通过强化学习后训练进一步提升了模型的语义对齐与细节生成能力,以下从模型架构、算力优化、性能评测三个维度展开说明:

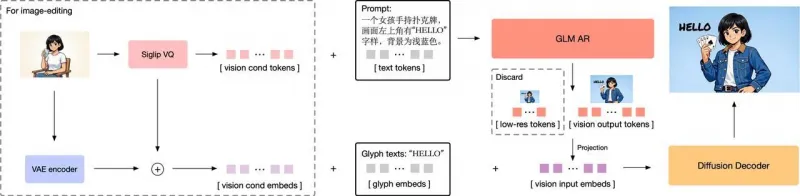

(一)混合架构设计:自回归生成器 + 扩散解码器

GLM-Image摒弃了传统纯扩散模型的设计思路,采用“两阶段生成”的混合架构,将90亿参数的自回归生成器与70亿参数的扩散解码器深度融合,分别负责“语义把控”与“细节生成”,实现了全局构图与局部细节的双重优化。具体架构细节如下表所示:

| 模块名称 | 参数规模 | 核心基础 | 核心功能 | 关键技术 |

|---|---|---|---|---|

| 自回归生成器 | 90亿 | GLM-4-9B-0414 | 低频语义把控:解析复杂文本指令,生成视觉令牌,把控图像全局构图、逻辑关系、美学风格 |

1. 扩展视觉词汇表,融入视觉特征token; 2. 先生成256个紧凑视觉令牌,再扩展为1K~4K令牌; 3. 采用MRoPE位置编码处理交错的图像文本序列 |

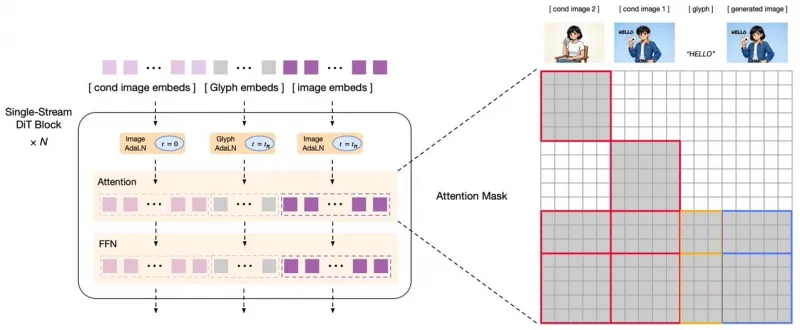

| 扩散解码器 | 70亿 | 单流DiT(扩散Transformer) | 高频细节生成:将视觉令牌解码为高分辨率图像,优化细节保真度与文本渲染准确性 |

1. 集成Glyph-byT5文本编码器,强化文本渲染; 2. 采用流匹配作为扩散调度策略; 3. 输出1024~2048像素高分辨率图像 |

1. 自回归生成器:图像的“大脑”,负责语义与构图

自回归生成器是GLM-Image的“语义核心”,基于智谱成熟的GLM-4-9B-0414大语言模型初始化,并非简单的视觉模型,而是具备深度语言理解能力的跨模态模块。其核心工作流程为:

文本指令解析:对接收到的自然语言指令(包括复杂的知识描述、排版要求、风格定义)进行深度解析,提取核心语义、逻辑关系与创作要求;

视觉令牌生成:先生成256个紧凑的视觉令牌,这些令牌并非直接对应图像像素,而是对图像全局特征、构图逻辑、主体关系的抽象表达;

令牌扩展:将256个基础令牌扩展为1K~4K个精细化视觉令牌,对应最终1024×1024至2048×2048分辨率的图像输出,为扩散解码器提供精准的生成指引。

这一设计从根源上解决了传统扩散模型“语义理解偏差”的问题,让模型能真正“读懂”用户的创作需求,而非简单匹配关键词。

2. 扩散解码器:图像的“手”,负责细节与文本

扩散解码器是GLM-Image的“细节核心”,基于单流DiT架构构建,专门负责将自回归生成器输出的视觉令牌转化为高分辨率、高保真的图像内容。其最大的技术亮点是集成了Glyph Encoder文本模块(Glyph-byT5),该模块针对文字的笔画、字形、排版进行了专门优化,能精准还原中、英文文本的视觉特征,有效避免了传统模型中文字“缺笔少画”“字形扭曲”“排版混乱”等问题。同时,扩散解码器采用“流匹配”作为扩散调度策略,在保证图像生成质量的前提下,提升了解码效率。

(二)强化学习后训练:解耦式反馈优化

为进一步提升模型的语义对齐能力与细节生成质量,GLM-Image采用了GRPO算法的解耦式反馈强化学习后训练策略,将自回归生成器与扩散解码器的优化目标分开,实现了“各司其职、精准优化”:

自回归生成器优化:聚焦美学效果与语义对齐,通过反馈信号调整模型参数,提升对文本指令的遵循度、图像的整体美学表现与逻辑关系表达;

扩散解码器优化:聚焦细节保真度与文本准确性,通过反馈信号优化图像的纹理、光影、色彩还原效果,同时进一步强化文本渲染的精准度。

这种解耦式的优化方式,避免了单一优化目标对模型不同能力的相互制约,让GLM-Image在“语义理解”与“细节生成”两个维度都实现了性能提升。

(三)国产算力适配优化:三大核心策略

为充分释放华为昇腾NPU的算力潜能,智谱AI针对性研发了专用模型训练套件,构建了三大核心优化策略,彻底解决了国产算力在大模型训练中的性能瓶颈:

动态图多级流水下发技术:将Host侧算子下发的关键阶段进行精细化的流水化重叠处理,消除了算子下发过程中的性能瓶颈,提升了训练流程的启动与执行效率;

多流并行策略:实现模型训练过程中“通信”与“计算”环节的相互掩蔽,突破了文本梯度同步、图像特征广播等关键操作中的通信壁垒,大幅提升分布式训练的整体性能;

高性能融合算子集成:整合了AdamW EMA、COC、RMS Norm等一系列昇腾适配型融合算子,在保障模型训练稳定性的同时,进一步提升了运算效率与模型收敛速度。

(四)性能评测:核心指标领先同类开源模型

GLM-Image在多项权威基准测试中表现优异,尤其在文本渲染、知识密集型场景生成等特色任务中,远超同类开源模型。以下为模型在核心基准测试中的关键性能数据:

| 测试基准 | 测试维度 | GLM-Image 成绩 | 同类模型平均成绩 | 优势表现 |

|---|---|---|---|---|

| CVTG-2K | 复杂视觉文本生成词准确率 | 91.16% | 87%左右 | 英文文本渲染准确率行业领先 |

| LongText-Bench-ZH | 中文长文本渲染准确率 | 97.88% | 85%左右 | 精准处理多行排版与段落语义 |

| LongText-Bench EN | 英文长文本渲染准确率 | 95.57% | 92%左右 | 长文本内容还原度高 |

| OneIG-Bench | 通用图像生成(中/英文) | 0.528(EN)/0.511(ZH) | 0.53左右 | 与通用模型持平,文本场景优势显著 |

| TIIF-Bench | 文本指令遵循度(短/长指令) | 81.01(短)/81.02(长) | 78左右 | 长文本指令遵循度表现优异 |

四、应用场景

GLM-Image的核心能力(强文本渲染、知识密集型场景适配、高分辨率原生生成)使其能精准匹配多元行业的实际创作需求,官方通过多轮场景测试验证了模型的稳定性与适配性,核心应用场景可分为五大类,覆盖To C与To B端的多样化需求:

(一)科普插画创作

针对科普内容创作中“专业知识可视化”的需求,GLM-Image能精准把握复杂逻辑流程、专业术语注释与原理说明的核心要求,通过清晰的视觉分层、规范的文字标注、准确的原理还原,生成符合科普传播需求的专业插画。例如:

生成包含“光合作用步骤”的生物学科普图,标注清晰的反应阶段、物质变化与场所;

生成“电路工作原理”的物理示意图,准确呈现元件连接关系与电流走向;

生成“地球板块运动”的地理科普图,还原板块边界类型与运动趋势。

这一场景下,GLM-Image能有效降低科普内容创作的门槛,让科普创作者无需具备专业的设计能力,即可快速生成高质量的可视化素材。

(二)多格图画制作

多格图画是电商、漫画、新媒体等领域的常见需求,核心痛点是“风格统一性、主体一致性、文字标注准确性”,而GLM-Image能完美解决这些问题:

电商多视角商品图:生成同一商品的正面、侧面、背面、细节特写图,保持商品的颜色、材质、造型一致,同时标注商品参数、卖点等文字信息;

漫画分镜画面:根据漫画脚本生成多格分镜,保持人物形象、画风、场景的统一性,同时精准还原台词气泡中的文字内容;

新媒体系列图文:生成同一主题的系列插画,保持视觉风格一致,适配公众号、小红书等平台的系列内容创作。

该场景下,GLM-Image适配商业化内容的批量创作需求,能有效提升内容生产效率,降低企业的设计成本。

(三)社交媒体图文封面设计

社交媒体内容的传播效果与封面视觉效果高度相关,GLM-Image能响应复杂排版设计、多元风格融合、创意表达的需求,生成构图新颖、视觉冲击力强、文字嵌入自然的封面图像。例如:

生成小红书美食笔记封面,融合“菜品实拍图+文字标题+emoji装饰+卖点标注”的排版;

生成公众号文章封面,结合“主题插画+大标题+副标题+作者信息”的结构化布局;

生成抖音短视频封面,适配竖屏分辨率,突出核心主题与文字卖点。

同时,模型支持1024×768、768×1024等竖屏分辨率的原生生成,无需后期裁剪,直接适配社交媒体的展示要求。

(四)商业海报制作

商业海报是企业营销的核心物料,要求“美学效果与营销价值兼顾”,GLM-Image能精准把握商业营销的核心诉求,生成构图兼具设计感与逻辑性、文字嵌入精准自然、营销卖点突出的商业海报,覆盖多种营销场景:

节日海报:生成春节、中秋、双十一等节日的营销海报,融入节日元素与促销文字(如“双十一限时折扣”“中秋团圆惠”);

产品宣传海报:生成新品上市、产品促销海报,突出产品外观、核心卖点与价格信息;

品牌活动海报:生成线下活动、线上直播的宣传海报,标注活动时间、地点、参与方式等关键信息。

该场景下,GLM-Image能大幅缩短企业营销物料的制作周期,从“数天设计”缩短为“分钟级生成”,且单张API调用成本仅0.1元,具备极高的性价比。

(五)写实摄影内容生成

除了图文融合场景,GLM-Image在纯写实图像生成任务中同样具备强劲实力,能精准还原人像、宠物、风景、静物等不同题材的写实质感,细节刻画细腻,色彩还原真实:

人像摄影:生成符合指定风格(日系、港风、复古)的人像写真,还原皮肤纹理、光影效果与服饰细节;

宠物摄影:生成宠物的特写照片,精准还原毛发质感、神态与动作;

风景摄影:生成山川、湖泊、城市夜景等风景照,还原自然光影与色彩层次;

静物摄影:生成美食、饰品、家居用品的静物照,适配电商商品展示需求。

这一场景下,GLM-Image可满足个人创作者的艺术创作需求,也能为商业摄影领域提供低成本的素材生成方案。

五、使用方法

GLM-Image的开源仓库提供了开箱即用的使用方式,核心基于Hugging Face的transformers与diffusers库构建专属Pipeline,支持本地部署与API调用两种模式,其中本地部署是开发者的主要使用方式,以下详细介绍本地部署的环境准备、快速上手与参数调优方法:

(一)环境准备

1. 硬件要求

GLM-Image的模型参数总量较大(自回归90亿+扩散70亿),对GPU显存有一定要求,官方推荐的硬件配置如下:

单GPU配置:最低要求80GB及以上显存,推荐使用NVIDIA H100(80GB)、A100(80GB);

多GPU配置:支持分布式推理,可降低单GPU显存要求,但会增加系统复杂性;

暂不支持CPU推理:模型未做CPU轻量化优化,纯CPU环境下无法完成推理。

2. 软件依赖

需安装Python 3.8及以上版本,并从Hugging Face源码安装最新版的transformers与diffusers库(需适配GLM-Image的专属Pipeline),核心依赖安装命令如下:

# 安装基础依赖 pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121 # 从源码安装transformers(适配GLM-Image) git clone https://github.com/huggingface/transformers.git cd transformers pip install -e . # 从源码安装diffusers(适配GLM-Image) git clone https://github.com/huggingface/diffusers.git cd diffusers pip install -e . # 安装其他辅助依赖 pip install accelerate sentencepiece protobuf

3. 模型下载

GLM-Image的模型权重已同步发布至两大主流开源平台,开发者可根据自身需求选择下载渠道:

Hugging Face:https://huggingface.co/zai-org/GLM-Image

可通过diffusers库的from_pretrained方法自动下载模型权重,也可手动下载后本地加载。

(二)快速上手:核心任务调用示例

GLM-Image的Pipeline已做高度封装,支持文本到图像(T2I) 与图像到图像(I2I) 两大核心任务,以下为最简调用示例,开发者可直接复制使用:

1. 文本到图像(T2I)生成

# 导入核心库与Pipeline

import torch

from diffusers.pipelines.glm_image import GLMImagePipeline

# 加载模型(自动从Hugging Face下载,或指定本地路径)

pipe = GLMImagePipeline.from_pretrained(

"zai-org/GLM-Image", # 模型名称/本地路径

torch_dtype=torch.bfloat16, # 数据类型,节省显存

device_map="cuda" # 设备映射,使用GPU

)

# 定义生成提示词(支持复杂文本描述与排版要求)

prompt = "一张现代美食杂志风格的树莓慕斯蛋糕食谱插画,整体布局清新明亮,分为四个区域:左上是蛋糕成品图,标注文字「树莓慕斯蛋糕 | 酸甜绵密」;右上是食材清单,文字为「食材:淡奶油200ml、树莓100g、吉利丁片10g、细砂糖30g」;左下是步骤1,标注「步骤1:树莓打成泥,加入细砂糖熬煮」;右下是步骤2,标注「步骤2:淡奶油打发,与树莓泥混合」。画面分辨率1024×1024,色彩以粉色与白色为主,细节细腻。"

# 执行生成

image = pipe(

prompt=prompt,

num_inference_steps=50, # 推理步数

guidance_scale=1.5, # 引导尺度

temperature=0.9, # 生成温度

top_p=0.75, # 采样Top-P

seed=42 # 随机种子,保证结果可复现

).images[0]

# 保存生成的图像

image.save("raspberry_mousse_cake.png")2. 图像到图像(I2I)生成

I2I任务需传入原始图像,模型将根据文本指令对图像进行编辑、风格迁移等操作,核心代码如下:

# 导入核心库、Pipeline与图像处理工具

import torch

from PIL import Image

from diffusers.pipelines.glm_image import GLMImagePipeline

# 加载模型

pipe = GLMImagePipeline.from_pretrained(

"zai-org/GLM-Image",

torch_dtype=torch.bfloat16,

device_map="cuda"

)

# 加载原始图像(需为PIL.Image格式)

init_image = Image.open("original_cake.png").convert("RGB")

# 调整图像尺寸(需能被32整除)

init_image = init_image.resize((1024, 1024))

# 定义编辑提示词

prompt = "将蛋糕的装饰改为草莓,保留整体布局与文字内容,文字中的「树莓」替换为「草莓」,色彩调整为红色与白色为主,风格保持美食杂志风。"

# 执行图像编辑

image = pipe(

prompt=prompt,

image=init_image, # 传入原始图像

num_inference_steps=50,

guidance_scale=1.2,

strength=0.7, # 编辑强度,0~1之间,值越大变化越明显

seed=42

).images[0]

# 保存编辑后的图像

image.save("strawberry_mousse_cake.png")(三)关键参数调优

GLM-Image的生成效果可通过调整推理参数进行优化,核心参数的作用与调优建议如下,开发者可根据需求灵活调整:

| 参数名称 | 取值范围 | 核心作用 | 调优建议 |

|---|---|---|---|

| num_inference_steps | 25~100 | 推理步数,步数越多质量越高,速度越慢 | 测试阶段设为2530,正式生成设为5075 |

| guidance_scale | 1.0~2.0 | 文本指令引导强度,值越大越遵循提示词 | 常规场景设为1.21.5,文本密集场景设为1.82.0 |

| temperature | 0.7~1.0 | 生成随机性,值越大创意性越强,一致性越差 | 追求精准还原设为0.70.8,追求创意生成设为0.91.0 |

| top_p | 0.6~0.9 | 采样Top-P,值越小生成结果越集中 | 配合temperature使用,常规设为0.75~0.85 |

| strength | 0.3~0.9(仅I2I) | 编辑强度,值越大原始图像的保留度越低 | 风格迁移设为0.70.9,细节修改设为0.30.5 |

| seed | 任意整数 | 随机种子,固定种子可复现生成结果 | 测试时固定种子,正式生成时使用随机种子 |

六、常见问题解答

问题1:安装transformers/diffusers后,运行代码提示“找不到GLMImagePipeline”?

解决方案:

确认是从Hugging Face源码安装的

transformers与diffusers,而非通过pip install安装的稳定版(稳定版暂未集成GLM-Image的Pipeline);进入

diffusers源码目录,执行git pull更新至最新版本,确保代码包含GLM-Image的Pipeline实现;检查Python环境是否正确,避免在虚拟环境外安装依赖导致的库版本冲突。

问题2:加载模型时提示“CUDA out of memory”(CUDA显存不足)?

解决方案:

降低分辨率:将生成分辨率从2048×2048降至1024×1024,显存占用将大幅减少;

使用混合精度:确保代码中设置了

torch_dtype=torch.bfloat16或torch_dtype=torch.float16,避免使用torch.float32(显存占用翻倍);启用分布式推理:若有多个GPU,可设置

device_map="auto",让模型自动分配到多个GPU上;关闭其他进程:关闭电脑中其他占用GPU显存的进程(如其他AI模型、游戏、视频剪辑软件)。

问题3:生成的图像分辨率不符合要求,或提示“分辨率必须能被32整除”?

解决方案:

GLM-Image要求生成的图像尺寸宽、高均能被32整除,有效分辨率如1024×1024、1024×768、768×1024等,无效分辨率如1000×1000、1920×1080(1080不能被32整除);

在代码中使用

resize方法调整图像尺寸时,确保宽高均为32的倍数,例如:init_image.resize((1152, 896))(1152÷32=36,896÷32=28);若需要生成1920×1080的图像,可先生成2048×1024的图像(均为32的倍数),再通过PIL库裁剪至目标分辨率。

问题4:I2I任务中,生成的图像与原始图像差异过大/过小?

解决方案:

调整

strength参数:差异过大则降低strength(如从0.9调至0.5),差异过小则提高strength(如从0.3调至0.7);优化提示词:明确标注“保留原始图像的XX特征”(如“保留人物的面部特征与服装款式”),让模型更精准地执行编辑指令;

降低

temperature参数:将温度从0.9调至0.7,减少生成的随机性,提升与原始图像的一致性。

问题5:生成的图像中文字出现笔画缺失、字形失真、排版混乱?

解决方案:

优化提示词:在提示词中明确文字的字体、大小、颜色、排版位置(如“文字使用微软雅黑字体,字号24,黑色,居中对齐”);

提高引导尺度:将

guidance_scale调至1.8~2.0,增强模型对文本指令的遵循度;减少生成随机性:将

temperature调至0.7~0.8,top_p调至0.7,让模型更专注于还原文字内容;选择合适分辨率:文字密集的场景建议使用1024×1024及以上分辨率,避免低分辨率导致的文字压缩失真。

问题6:知识密集型场景中,生成的图像出现专业知识错误或逻辑混乱?

解决方案:

细化提示词:在提示词中明确专业术语的定义、逻辑关系的层级(如“步骤1在前,步骤2在后,两者为因果关系”);

借助参考图像:若有相关的参考示意图,可通过I2I任务传入参考图像,让模型参考其逻辑结构与知识表达;

固定随机种子:使用固定的

seed参数,多次生成后选择知识表达最准确的结果,再进行微调。

问题7:生成的图像整体美学效果不佳(如色彩失调、构图混乱)?

解决方案:

优化提示词的美学描述:在提示词中加入风格、色彩、光影的具体描述(如“日系小清新风格,暖色调,柔和自然光,三分构图法”);

调整自回归模块的权重:若具备模型微调能力,可通过强化学习后训练调整自回归生成器的美学反馈权重;

使用图像后处理工具:生成图像后,通过Photoshop、醒图等工具进行色彩校正、构图裁剪等后处理,提升最终效果。

七、相关链接

GitHub开源仓库(核心使用入口):https://github.com/zai-org/GLM-Image

Hugging Face模型仓库(模型权重下载):https://huggingface.co/zai-org/GLM-Image

ModelScope模型仓库(国内模型下载渠道):https://modelscope.cn/models/ZhipuAI/GLM-Image

八、总结

GLM-Image是智谱AI与华为联合开源的工业级多模态图像生成模型,也是国内首个全流程基于国产昇腾算力构建的SOTA级图像生成模型,其核心价值体现在技术、产业与生态三个维度:技术层面,采用“90亿参数自回归生成器+70亿参数扩散解码器”的混合架构,实现了强文本渲染、知识密集型场景适配与高分辨率原生生成的核心能力,在中文文本渲染、复杂语义理解等方面远超同类开源模型;产业层面,模型单张API调用成本低至0.1元,且支持高并发场景的优化版本,大幅降低了前沿图像生成技术的商业化应用门槛,可广泛适配科普插画、商业海报、社交媒体图文等多元场景;生态层面,模型全链路依托国产算力与框架构建,打破了海外技术依赖,且已接入Hugging Face、ModelScope等主流开源平台,提供开箱即用的Pipeline调用方式,吸引全球开发者参与模型优化与应用拓展,为国产AI技术生态的自主化发展注入了核心动力。开源仓库zai-org/GLM-Image作为模型的官方落地入口,整合了技术文档、快速上手示例、模型下载链接等核心资源,是开发者接入与使用GLM-Image的核心渠道,助力技术成果从研发走向规模化落地。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/glm-image.html