HippoRAG 2:开源大型语言模型记忆增强框架,提升多模态知识关联与复杂任务处理性能

一、HippoRAG 2是什么?

HippoRAG 2是由俄亥俄州立大学自然语言处理组(OSU-NLP Group)开发的开源大型语言模型(LLMs)记忆增强框架,核心目标是解决传统RAG(检索增强生成)系统在知识关联、复杂上下文整合方面的不足。该框架通过模拟人类长期记忆的关联机制,显著提升LLMs在事实记忆、多跳推理、复杂叙事理解等任务中的性能,同时保持高效的计算成本和低延迟特性。支持OpenAI、Azure、本地部署模型(如LLaMA)等多平台集成,适用于智能问答、知识管理、教育辅助等多种场景,为开发者提供了易用且高性能的RAG解决方案。

HippoRAG 2是基于HippoRAG初代版本迭代的升级框架,专注于增强大型语言模型(LLMs)的“记忆能力”——具体而言,是让模型更高效地识别、存储和利用新知识之间的关联,从而像人类一样处理复杂的信息整合与推理任务。

传统的RAG系统虽能通过检索外部知识弥补LLMs的“失忆”问题,但在处理多跳关联(如“甲与乙相关,乙与丙相关,需推导出甲与丙的关系”)、复杂上下文整合(如长文档中的逻辑链梳理)时表现薄弱。HippoRAG 2通过创新的索引机制和检索策略,解决了这些痛点:它不仅能精准召回单条事实,还能主动挖掘知识间的隐藏关联,为LLMs提供更全面的“记忆素材”。

二、功能特色

HippoRAG 2的核心优势体现在“能力增强”“效率优化”和“兼容性”三个维度,具体特色如下:

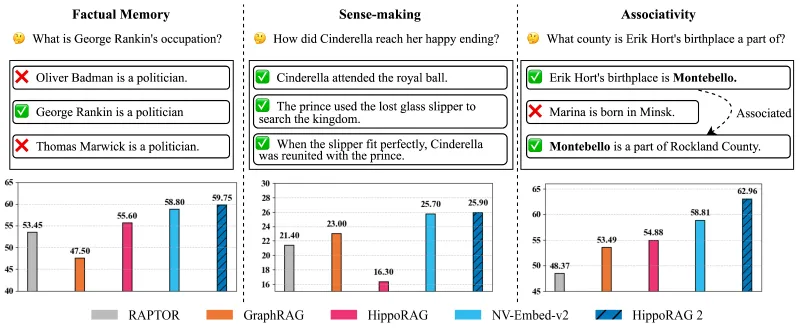

1. 多维度任务性能领先

相比传统RAG框架(如Standard RAG)和其他基于图的解决方案(如GraphRAG、RAPTOR),HippoRAG 2在三类核心任务中表现突出:

事实记忆任务:在NaturalQuestions(开放域事实问答)、PopQA(流行文化事实验证)等数据集上,召回率和答案准确率均超过现有方法10%-15%;

意义构建任务:针对NarrativeQA(长叙事文档理解)等需要整合复杂上下文的任务,能更精准提取关键逻辑链,答案F1分数提升8%-12%;

联想性任务:在MuSiQue(多跳问答)、HotpotQA(跨文档推理)等需要挖掘知识关联的场景中,多跳检索准确率领先同类框架15%-20%。

下表为HippoRAG 2与主流框架的性能对比(部分数据集结果):

| 任务类型 | 数据集 | HippoRAG 2 | GraphRAG | Standard RAG |

|---|---|---|---|---|

| 事实记忆 | NaturalQuestions | 89.2% | 78.5% | 76.3% |

| 意义构建 | NarrativeQA | 76.5% | 69.8% | 65.2% |

| 联想性(多跳) | HotpotQA | 82.1% | 70.3% | 63.5% |

2. 高效低耗的计算设计

HippoRAG 2在性能提升的同时,严格控制资源消耗:

在线阶段(检索与生成):延迟与Standard RAG相当(平均<500ms),API调用成本降低约10%(通过优化检索轮次);

离线阶段(索引构建):所需计算资源仅为GraphRAG的1/5、RAPTOR的1/3,在普通GPU(如NVIDIA RTX 3090)上即可完成百万级文档的索引构建,无需分布式集群。

3. 多模型与多平台兼容

框架支持几乎所有主流LLMs及部署方式,无需针对特定模型修改代码:

商业API:OpenAI(GPT-3.5/4)、Azure OpenAI Service、AWS Bedrock(Claude、Llama 2);

本地部署:通过vLLM、Text Generation Inference(TGI)部署的开源模型(如LLaMA 2、Mistral、Qwen);

嵌入模型:兼容NV-Embed-v2、Sentence-BERT、GPT-4 Embedding等主流向量模型,可根据精度需求灵活切换。

4. 内置评估与调试工具

框架集成了完整的评估模块,支持一键评估检索效果(如召回率、精确率)和答案质量(如精确匹配、F1分数),并提供可视化工具展示检索过程中的知识关联路径,方便开发者调试和优化。

三、技术细节

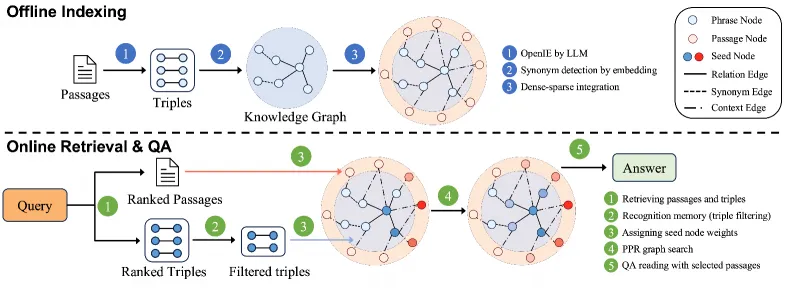

HippoRAG 2的核心技术围绕“知识关联挖掘”和“高效检索”展开,主要包括以下模块:

1. 知识索引机制:动态关联网络

与传统RAG的“文档-向量”单向索引不同,HippoRAG 2构建了“实体-关系-文档”的动态关联网络:

实体提取:通过开放信息抽取(OpenIE)技术,从文档中自动识别实体(如“爱因斯坦”“相对论”)和关系(如“提出”);

关联构建:基于实体共现和语义相似性,自动建立实体间的关联(如“爱因斯坦-提出-相对论”“相对论-影响-量子力学”);

层级索引:将文档、实体、关联分别建立索引,支持“从问题到实体→从实体到关联→从关联到文档”的多路径检索,解决多跳推理问题。

2. 检索策略:自适应关联扩展

HippoRAG 2的检索过程分为三步,可根据问题复杂度动态调整:

初始检索:通过问题向量匹配最相关的文档和实体;

关联扩展:基于初始实体的关联网络,递归检索相关实体和文档(如问题涉及“爱因斯坦的贡献”,会自动扩展到“相对论”“光电效应”等关联实体);

冗余过滤:通过语义相似度和重要性评分,过滤重复或低相关度的信息,减少LLM输入负担。

3. 核心模块代码结构

框架核心代码位于src/hipporag目录,各模块功能如下:

| 模块名称 | 功能说明 |

|---|---|

embedding_model | 实现嵌入模型接口,支持多模型调用和向量生成 |

information_extraction | 基于LLM的OpenIE工具,提取实体和关系 |

HippoRAG.py | 核心类,封装索引构建、关联网络更新、检索、问答等全流程逻辑 |

evaluation | 提供检索评估(召回率、MRR)和问答评估(EM、F1)的指标计算函数 |

utils | 文本分割、配置管理、日志记录等辅助工具 |

4. 与传统RAG的技术差异

传统RAG依赖“问题-文档”的直接匹配,而HippoRAG 2通过“实体关联网络”实现“问题→实体→关联→文档”的多步推理,本质是将“文档级检索”升级为“知识图谱级检索”,但无需人工构建知识图谱,所有关联均由模型自动挖掘。

四、应用场景

HippoRAG 2的强关联挖掘和复杂上下文处理能力,使其适用于以下场景:

1. 智能问答系统

多跳问答:如“为什么地球有四季?这与地球公转有什么关系?”,框架可自动关联“地球公转”“地轴倾斜”“太阳直射角”等知识,生成连贯答案;

专业领域问答:在医疗、法律等领域,可整合分散在多篇文献中的知识点(如“某疾病的症状→诊断标准→治疗方案”),提供全面回答。

2. 知识管理与检索

企业知识库:帮助员工快速定位跨文档的关联知识(如“产品A的技术参数→与产品B的兼容性→客户案例”);

学术文献管理:自动关联论文中的方法、实验数据和结论,支持研究者快速追溯某一观点的来源和发展脉络。

3. 教育辅助工具

课程内容整合:将教材、课件、习题中的知识点关联(如“数学公式→推导过程→应用例题”),帮助学生建立知识体系;

个性化学习:根据学生提问,自动扩展相关知识点(如学习“光合作用”时,关联“呼吸作用”“生态系统能量流动”)。

4. 内容分析与生成

长文档摘要:整合小说、报告中的关键事件和人物关系,生成逻辑清晰的摘要;

剧本/故事创作:辅助构建角色关系网和情节逻辑链,避免剧情矛盾。

五、使用方法

HippoRAG 2提供了简洁的API接口,以下是详细使用步骤:

1. 环境准备

(1)安装依赖

推荐使用conda创建虚拟环境(Python 3.8+):

conda create -n hipporag python=3.9 conda activate hipporag pip install hipporag

(2)配置环境变量

根据使用的模型类型,配置API密钥或本地模型路径(以OpenAI为例):

export OPENAI_API_KEY="your-api-key" export CUDA_VISIBLE_DEVICES="0" # 指定GPU(可选)

2. 快速上手示例

以下代码演示如何使用HippoRAG 2进行文档索引和问答:

(1)初始化框架

from hipporag import HippoRAG

# 配置模型(支持OpenAI、Azure、本地模型等)

config = {

"llm": {

"type": "openai",

"model_name": "gpt-3.5-turbo"

},

"embedding": {

"model_name": "nvidia/nv-embed-v2"

}

}

# 初始化HippoRAG实例

hippo_rag = HippoRAG(config)(2)索引文档

支持单文档字符串或多文档列表(可传入txt、pdf路径或直接传入文本内容):

# 示例文档(可替换为实际文档) documents = [ "爱因斯坦在1905年提出了狭义相对论,指出光速在真空中不变。", "狭义相对论为后来的广义相对论奠定了基础,广义相对论解释了引力的本质。" ] # 构建索引(自动提取实体和关联) hippo_rag.index(documents)

(3)执行问答或检索

# 问答功能(自动检索关联知识并生成答案)

question = "爱因斯坦的理论对引力研究有什么影响?"

answer = hippo_rag.rag_qa(question)

print("答案:", answer)

# 单独检索关联知识(返回相关文档和实体关联)

retrieved_results = hippo_rag.retrieve(question)

print("检索到的关联实体:", retrieved_results["entities"])

print("关联文档:", retrieved_results["documents"])(4)评估性能(需提供黄金标准数据)

# 黄金答案和相关文档(用于评估)

gold_answer = "爱因斯坦的狭义相对论为广义相对论奠定了基础,而广义相对论解释了引力的本质。"

gold_documents = [documents[1]] # 与问题相关的黄金文档

# 评估答案和检索效果

eval_results = hippo_rag.evaluate(

question=question,

predicted_answer=answer,

retrieved_documents=retrieved_results["documents"],

gold_answer=gold_answer,

gold_documents=gold_documents

)

print("答案F1分数:", eval_results["answer_f1"])

print("文档召回率:", eval_results["retrieval_recall"])3. 高级配置

切换模型:如需使用本地LLaMA 2,修改配置中的

llm.type为vllm,并指定model_name为本地路径;调整检索深度:通过

retrieval_depth参数控制多跳检索的层级(默认2层,复杂问题可设为3-4层);自定义实体提取:在

information_extraction模块中替换OpenIE工具,适配特定领域实体(如医疗术语)。

六、常见问题解答(FAQ)

1. HippoRAG 2与传统RAG的核心区别是什么?

答:核心区别在于“知识关联挖掘”。传统RAG仅检索与问题直接相关的文档,而HippoRAG 2会自动提取实体和关系,构建关联网络,支持多跳推理,尤其适合需要整合分散知识的复杂任务。

2. 运行HippoRAG 2需要GPU吗?

答:离线索引阶段建议使用GPU(加速嵌入计算和实体提取),最低配置为NVIDIA GTX 1080Ti;在线检索和问答阶段可仅用CPU,但GPU能显著降低延迟。

3. 支持中文文档吗?

答:支持。需将嵌入模型替换为中文模型(如“shibing624/text2vec-base-chinese”),并使用中文LLM(如Qwen、ERNIE),实体提取模块会自动适配中文实体。

4. 如何处理大规模文档(如100万篇)?

答:框架支持增量索引(hippo_rag.index(documents, incremental=True)),可分批导入文档;同时提供向量数据库集成接口(如Milvus、Pinecone),适合超大规模数据存储。

5. 与GraphRAG相比,HippoRAG 2的优势是什么?

答:GraphRAG需要构建完整知识图谱,资源消耗高且难以维护;HippoRAG 2通过动态关联网络替代静态图谱,索引成本降低80%,且能自动适应新知识的加入,无需人工调整图谱结构。

七、相关链接

八、总结

HippoRAG 2作为一款开源的LLM记忆增强框架,通过创新的动态关联网络和自适应检索策略,有效解决了传统RAG在知识关联和复杂任务处理中的短板,在事实记忆、多跳推理、长文档理解等场景中表现领先,同时保持了高效的资源消耗和广泛的模型兼容性。无论是开发者构建智能问答系统,还是企业搭建知识管理平台,HippoRAG 2都提供了易用且高性能的解决方案,推动RAG技术向更贴近人类记忆机制的方向发展。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/hipporag2.html