Hunyuan3D-Omni:腾讯混元开源的多模态条件控制 3D 资产生成框架

Hunyuan3D-Omni是什么

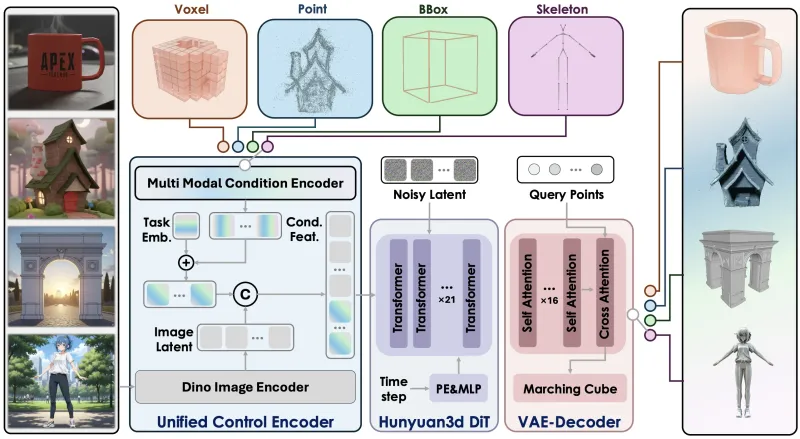

Hunyuan3D-Omni是腾讯混元团队推出的开源3D资产生成框架,该框架通过统一的控制编码器,能够接收多种不同类型的控制信号,实现对3D资产生成过程的精确引导。与传统的文本到3D或图像到3D生成方法相比,Hunyuan3D-Omni的最大优势在于其"可控性"。它不仅能根据文本或图像生成3D模型,还能通过额外的控制信号(如点云、体素、骨骼结构或边界框)来精确约束生成结果,使生成的3D资产更符合特定需求。

功能特色

Hunyuan3D-Omni的核心功能特色可以概括为以下几个方面:

1. 多模态条件控制

框架支持四种主要的控制方式,满足不同场景下的3D生成需求:

| 控制类型 | 输入形式 | 主要应用场景 | 控制精度 |

|---|---|---|---|

| 边界框控制 | 3D边界框坐标 | 物体位置和尺寸约束 | 中 |

| 姿态控制 | 骨骼关节数据 | 人体/动物姿态生成 | 高 |

| 点云控制 | 稀疏或稠密点云 | 形状和结构引导 | 高 |

| 体素控制 | 体素网格数据 | 内部结构和细节控制 | 高 |

2. 统一控制编码器

Hunyuan3D-Omni设计了一个统一的控制编码器,能够将不同类型的控制信号转换为统一的特征表示,然后融入3D生成过程。这种设计不仅简化了模型结构,还提高了不同控制方式之间的兼容性。

3. 高效推理

框架针对推理效率进行了优化,支持FlashVDM等加速技术,能够在保证生成质量的同时显著缩短推理时间。在配备10GB VRAM的GPU上,即可完成高质量3D模型的生成。

4. 高质量生成结果

Hunyuan3D-Omni在多个3D生成任务上表现出色,能够生成细节丰富、几何结构合理的3D模型。无论是人物、动物还是物体,都能保持良好的视觉质量和结构完整性。

5. 灵活的接口设计

项目提供了简洁易用的API接口,开发者可以轻松地将Hunyuan3D-Omni集成到自己的应用中。同时,丰富的命令行参数也使得用户可以根据需求灵活调整生成参数。

技术细节

1. 整体架构

Hunyuan3D-Omni的架构主要包括以下几个核心组件:

控制编码器:负责处理各种输入控制信号,将其转换为潜在空间的特征表示。

文本/图像编码器:处理文本描述或参考图像,提取内容特征。

生成网络:基于扩散模型架构,接收内容特征和控制特征,逐步生成3D资产。

解码器:将生成网络输出的潜在表示转换为实际的3D网格或点云。

2. 控制机制

框架的核心创新在于其控制机制,主要包括:

特征融合:控制特征与内容特征通过交叉注意力机制进行融合,确保控制信号能够影响生成过程的各个阶段。

条件指导:在扩散过程中,控制信号作为条件指导生成步骤,引导采样过程朝着满足控制约束的方向进行。

多尺度控制:控制信号在不同尺度上对生成过程产生影响,既保证整体结构符合约束,又不限制局部细节的生成。

3. 模型参数与性能

模型规模:3.3B参数

显存需求:约10GB VRAM

推理时间:根据控制类型和生成质量不同,通常在几分钟到十几分钟之间

输出格式:支持多种3D格式,包括点云、体素和网格

4. 技术亮点

统一控制接口:不同类型的控制信号通过相同的接口进入模型,简化了模型设计

自适应控制强度:可以调整控制信号对生成过程的影响程度,平衡自由度和可控性

鲁棒的控制信号处理:能够处理不完整或有噪声的控制信号,提高了实际应用中的可靠性

应用场景

Hunyuan3D-Omni的多模态控制能力使其在多个领域具有广泛的应用前景:

1. 游戏开发

角色创建:通过姿态控制快速生成特定动作的游戏角色

场景构建:利用边界框控制在游戏场景中精确定位和放置物体

资产定制:根据参考点云或体素数据生成符合特定风格的游戏资产

2. 影视动画

角色动画:基于骨骼控制生成复杂的角色动画序列

场景设计:利用点云或体素数据重建真实场景

特效制作:结合多种控制方式生成复杂的视觉特效

3. 工业设计

产品原型:根据2D图像和边界框控制生成3D产品模型

逆向工程:利用点云数据重建现有物体的3D模型

定制化设计:基于客户提供的参考数据生成定制化产品

4. 虚拟现实与增强现实

虚拟人物:创建具有特定姿态和特征的虚拟人物

环境构建:利用点云数据快速构建VR/AR环境

交互设计:基于骨骼控制实现自然的人机交互

5. 科研与教育

3D重建:辅助文物数字化和重建工作

解剖教学:生成精确的人体或动物解剖模型

地理信息:基于点云数据生成地形模型

使用方法

1. 环境准备

Hunyuan3D-Omni需要以下环境:

Python 3.10

PyTorch 2.5.1或更高版本

CUDA 12.4或兼容版本

至少10GB VRAM的NVIDIA GPU

2. 安装步骤

# 克隆代码仓库 git clone https://github.com/Tencent-Hunyuan/Hunyuan3D-Omni.git cd Hunyuan3D-Omni # 创建并激活虚拟环境 conda create -n hunyuan3d python=3.10 conda activate hunyuan3d # 安装PyTorch pip install torch==2.5.1 torchvision==0.20.1 torchaudio==2.5.1 --index-url https://download.pytorch.org/whl/cu124 # 安装其他依赖 pip install -r requirements.txt

3. 模型下载

模型权重可以从Hugging Face下载:

# 安装huggingface-cli pip install huggingface_hub # 登录Hugging Face(需要账号) huggingface-cli login # 下载模型权重 git lfs install git clone https://huggingface.co/tencent/Hunyuan3D-Omni

4. 基本使用

Hunyuan3D-Omni提供了inference.py脚本作为主要的推理入口。以下是几个常见的使用示例:

点云控制生成

python inference.py --control_type point \ --control_path ./data/point_clouds/car.ply \ --prompt "a red sports car" \ --output_dir ./output/car

姿态控制生成

python inference.py --control_type pose \ --control_path ./data/poses/standing.json \ --prompt "a muscular man standing" \ --output_dir ./output/man \ --use_ema

边界框控制生成

python inference.py --control_type bbox \ --control_path ./data/bboxes/table.npy \ --prompt "a wooden table" \ --output_dir ./output/table \ --flashvdm

体素控制生成

python inference.py --control_type voxel \ --control_path ./data/voxels/chair.npz \ --prompt "a modern office chair" \ --output_dir ./output/chair \ --use_ema --flashvdm

5. 参数说明

inference.py支持多种参数配置,以下是主要参数的说明:

| 参数 | 类型 | 说明 |

|---|---|---|

--control_type | 字符串 | 控制类型,可选:point, voxel, bbox, pose |

--control_path | 字符串 | 控制信号文件路径 |

--prompt | 字符串 | 文本描述 |

--image_path | 字符串 | 参考图像路径(可选) |

--output_dir | 字符串 | 输出目录 |

--use_ema | 开关 | 使用EMA模型,提高生成质量 |

--flashvdm | 开关 | 启用FlashVDM加速 |

--num_steps | 整数 | 扩散步骤数,默认50 |

--guidance_scale | 浮点数 | 引导强度,默认7.5 |

--control_strength | 浮点数 | 控制信号强度,0-1之间,默认0.8 |

--seed | 整数 | 随机种子,用于结果复现 |

常见问题解答

1. 模型需要多大的显存?

Hunyuan3D-Omni需要至少10GB VRAM才能正常运行。对于更高分辨率或更复杂的生成任务,建议使用16GB或以上VRAM的GPU。

2. 生成一个3D模型需要多长时间?

生成时间取决于多个因素,包括GPU性能、控制类型、生成质量设置等。在配备RTX 3090(24GB)的机器上,使用默认设置生成一个模型通常需要5-10分钟。

3. 可以在CPU上运行吗?

虽然理论上可以在CPU上运行,但由于模型规模较大,CPU推理会非常缓慢,可能需要数小时甚至数天才能完成一个模型的生成。因此,强烈建议使用GPU进行推理。

4. 控制信号的质量对生成结果有多大影响?

控制信号的质量对最终结果有显著影响。高质量、准确的控制信号能够引导模型生成更符合预期的结果。对于低质量或有噪声的控制信号,模型具有一定的鲁棒性,但生成结果可能会有偏差。

5. 如何调整控制信号的影响强度?

可以通过--control_strength参数调整控制信号对生成过程的影响强度。该值越接近1,控制信号的约束越强;越接近0,模型的创作自由度越高。

6. 支持哪些输出格式?

Hunyuan3D-Omni支持多种3D格式输出,包括PLY、OBJ、GLB等。可以通过--output_format参数指定输出格式。

7. 如何提高生成模型的质量?

可以通过以下几种方式提高生成质量:

使用

--use_ema参数启用EMA模型增加

--num_steps参数的值调整

--guidance_scale参数提供更高质量的控制信号或参考图像

8. 模型是否支持中文提示词?

是的,Hunyuan3D-Omni的文本编码器支持多语言,包括中文。使用中文提示词可以获得更符合中文语境的生成结果。

相关链接

Hugging Face模型页:https://huggingface.co/tencent/Hunyuan3D-Omni

腾讯混元官方网站:https://hunyuan.tencent.com

总结

Hunyuan3D-Omni是一个功能强大、灵活多样的3D资产生成框架,通过多模态条件控制机制,实现了对3D生成过程的精确引导。该框架支持点云、体素、骨骼和边界框等多种控制信号,能够满足游戏开发、影视动画、工业设计、虚拟现实等多个领域的需求。其统一的控制编码器设计和高效的推理优化,使得在普通GPU上也能生成高质量的3D模型。项目完全开源,提供了详细的文档和示例,便于开发者快速上手和二次开发。无论是研究人员还是行业从业者,都能从Hunyuan3D-Omni中受益,将AI驱动的3D生成技术应用到实际生产中。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/hunyuan3d-omni.html