HY-Motion 1.0:腾讯混元开源的文本到 3D 动作生成模型

一、HY-Motion 1.0是什么

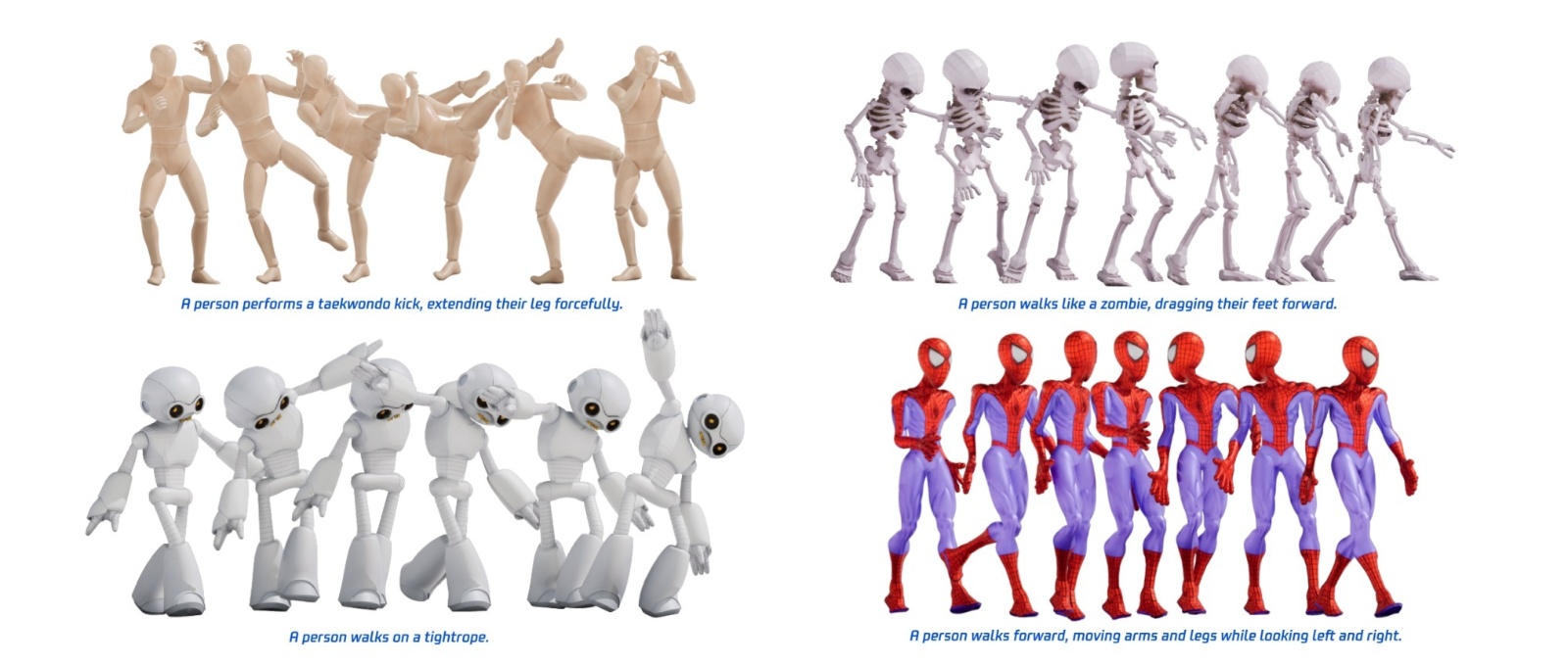

HY-Motion 1.0是腾讯混元团队开源的大规模文本到3D人体动作生成模型系列,核心定位是为数字内容创作领域提供高效、高精度的AI驱动动画生成解决方案。作为业界首个将Diffusion Transformer(DiT)架构基于流匹配(Flow Matching)目标扩展至十亿参数级别的动作生成模型,它系统性解决了长期困扰文本到3D动作领域的三大核心痛点:指令理解能力弱、动作质量不稳定(如抖动、滑步)、规模化训练难以落地。

传统3D动画制作依赖专业动画师手工关键帧调试或昂贵的动作捕捉(MoCap)设备,不仅制作周期长、成本高,还对技术门槛要求极高。而现有开源文本到动作模型普遍存在参数量小(多为千万级以下)、动作覆盖范围窄、语义对齐精度低等问题,难以满足工业级应用需求。HY-Motion 1.0的出现打破了这一局面,它通过自然语言描述作为输入,无需复杂操作即可直接输出符合物理规律、细节丰富的3D骨骼动画,实现了从“文本指令”到“可用动画资产”的端到端生成。

该模型系列包含两个版本:标准版HY-Motion 1.0(1.0B参数)与轻量版HY-Motion 1.0-Lite(0.46B参数),前者在动作质量与指令理解精度上达到最优,后者则在保持核心能力的同时优化了部署效率与硬件需求,让个人开发者与小型工作室也能轻松使用。模型输出统一采用SMPL-H标准骨骼格式,保留22个核心关节点的运动信息,确保生成动作具备良好的通用性与兼容性,可直接集成到各类3D创作流程中。

从技术定位来看,HY-Motion 1.0不仅是一个单一模型,更是一套完整的文本到动作生成解决方案——它包含了数据处理管线、多模态融合架构、训练优化策略、部署工具链等全流程组件,开源后为行业提供了首个可落地的十亿参数级动作生成基准,推动3D内容创作从“手工制作”向“AI生成”的范式转移。

二、功能特色

HY-Motion 1.0凭借创新的技术架构与系统化的训练策略,展现出四大核心功能特色,覆盖从性能表现、动作多样性到易用性的全维度需求:

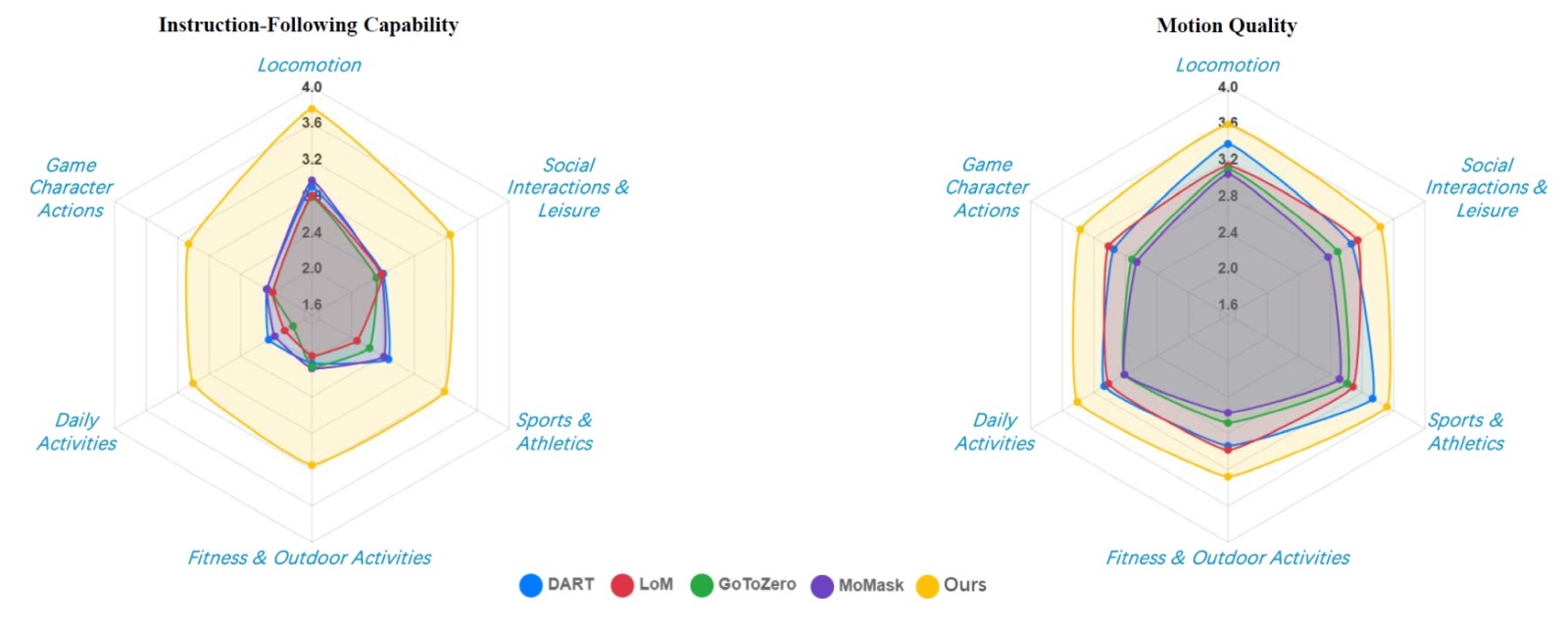

1. 十亿参数级性能,指令跟随能力行业领先

作为首个实现十亿参数规模稳定训练的文本到动作模型,HY-Motion 1.0充分验证了“缩放定律”在动作生成领域的有效性——模型参数量的提升直接带来了指令理解能力的显著飞跃。在权威的SSAE(结构化语义对齐评估)测试中,该模型取得78.6%的高分,远超MoMask(58.0%)、GoToZero(52.7%)等主流开源基准,能够精准解析复杂语义指令。

无论是简单的基础动作(如“缓慢行走”“原地跳跃”),还是多步骤组合动作(如“弯腰捡起地上的物品后站立”),甚至是高难度的影视级动作(如《黑客帝国》经典“子弹时间后仰”),模型都能准确捕捉核心姿态并保持运动连贯性。特别在细粒度指令理解上,模型能够区分“左手挥拳”与“右手挥拳”、“慢跑”与“快跑”等差异,语义对齐精度达到商业级应用标准。

2. 动作质量优异,物理合理性与流畅度兼具

通过三阶段训练与强化学习优化,HY-Motion 1.0生成的动作在流畅度、自然度与物理合理性上实现了质的突破。与传统模型常见的关节抖动、身体悬浮、脚部滑步等问题不同,该模型生成的动作严格遵循人体运动学规律,关节过渡平滑,重心转移自然,视觉观感接近专业动捕数据。

在5分制动作质量评分中,模型平均得分3.43分,其中“动作流畅度”与“物理合理性”两项指标得分均超过3.5分,显著优于同类开源模型。这一优势源于高质量微调阶段对400小时精选数据的学习,以及强化学习阶段针对物理约束的专项优化——通过Flow-GRPO算法引入滑步漂移惩罚项,有效抑制了运动伪影的产生。

3. 动作覆盖广泛,满足多场景创作需求

HY-Motion 1.0构建了业界覆盖最广的动作数据集体系,涵盖6大类、200余种细粒度动作类别,能够满足游戏、影视、VR/AR等不同领域的创作需求。具体动作分类如下表所示:

| 动作大类 | 核心涵盖内容 | 典型示例 |

|---|---|---|

| 基础位移类 | 人体基本移动动作,涵盖不同速度与姿态 | 行走、慢跑、快跑、跳跃、蹲走、侧移 |

| 体育竞技类 | 各类运动项目的标准动作与技巧动作 | 篮球投篮、网球挥拍、足球射门、羽毛球扣杀、游泳划水 |

| 健身户外类 | 健身锻炼与户外活动相关动作 | 瑜伽伸展、哑铃弯举、攀岩、骑行、登山 |

| 社交休闲类 | 人际互动与日常休闲动作 | 挥手致意、拥抱、握手、鼓掌、跷二郎腿、阅读 |

| 日常生活类 | 居家与日常场景的实用动作 | 开门、倒水、穿衣、做饭、扫地、拾取物品 |

| 游戏角色类 | 游戏场景专属的特色动作 | 持剑格挡、魔法释放、僵尸蹒跚、忍者跳跃、攻击连击 |

该数据集通过1200万个野外视频片段、专业动捕数据与游戏级动画资产整合而成,经严格清洗与人工校验后,确保了动作的多样性与纯净度。模型支持单原子动作(如“挥手”)、多步组合动作(如“先坐下再站起来”)与多肢体并发动作(如“一边走路一边打电话”)的生成,满足从简单到复杂的全场景动作需求。

4. 兼容性强,部署与使用门槛低

HY-Motion 1.0在兼容性与易用性上进行了全面优化,确保不同技术背景的用户都能快速上手。模型支持Windows、macOS、Linux全系统部署,提供CLI命令行工具与Gradio可视化Web界面两种使用方式,同时适配ComfyUI插件实现可视化操作。

在输出格式上,模型原生支持SMPL-H骨骼格式,可直接导入Blender、Unity、Unreal Engine等主流3D创作平台,无需额外格式转换工具;通过配套插件,还可导出为FBX格式,进一步扩展兼容范围。针对不同硬件条件,模型提供灵活的显存优化方案,标准版最低仅需26GB显存,轻量版可降至24GB,通过调整参数(如--num_seeds=1)还能进一步降低显存占用。

此外,模型开源了完整的推理代码、预训练权重与示例脚本,用户无需从零搭建开发环境,按照文档指引即可快速完成部署与测试。同时提供的“时长预测+Prompt重写”模块,能够自动处理模糊指令,即使是非专业用户输入的不规范描述,也能生成符合预期的动作。

三、技术细节

HY-Motion 1.0的优异表现源于其创新的技术架构、系统化的训练策略与精细化的数据工程,以下从核心技术模块进行详细解析:

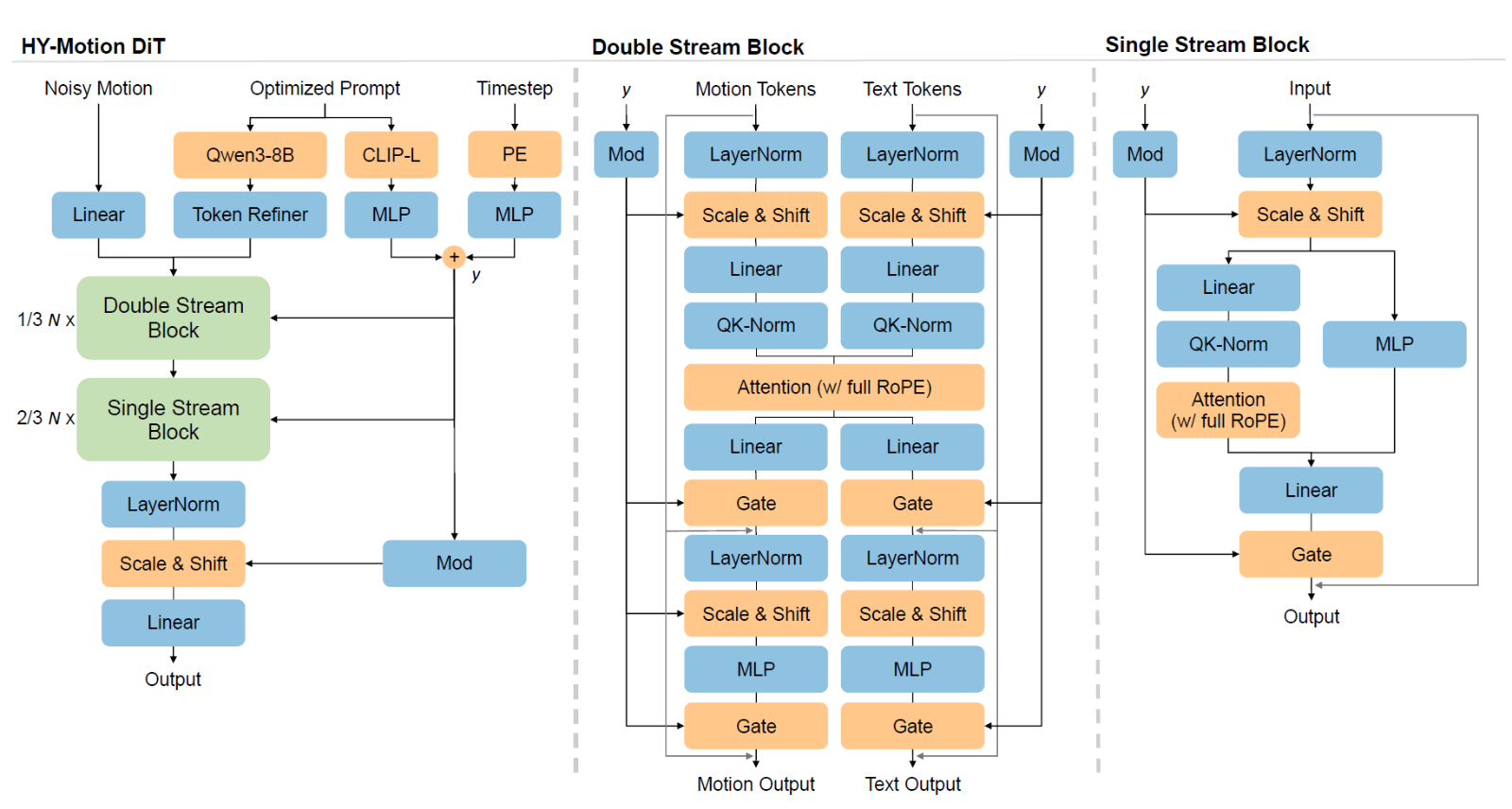

1. 核心架构:DiT+流匹配的多模态融合设计

模型采用Diffusion Transformer(DiT)作为基础架构,结合流匹配(Flow Matching)目标函数,构建了高效的文本到动作生成框架。与传统扩散模型相比,流匹配机制简化了采样过程,提升了生成效率,同时保持了高质量的生成效果,这一组合此前已在HunyuanVideo等项目中得到验证,此次首次成功应用于动作生成领域并扩展至十亿参数规模。

在多模态融合层面,模型创新设计了“双流→单流”的混合Transformer架构,实现文本与动作特征的深度交互:

双流模块阶段:动作潜在变量(Latent)与文本Token分别通过独立的Transformer编码器处理,保持各自模态的特征独立性;

交互融合阶段:通过联合注意力机制(Joint Attention)实现动作特征对文本语义的查询,建立两者的关联映射;

单流模块阶段:将处理后的动作Token与文本Token拼接为统一序列,通过并行空间和通道注意力模块完成深度融合。

为解决扩散过程中噪声对文本语义的破坏问题,模型引入非对称注意力掩码机制——动作Token可关注所有文本Token,而文本Token不可见动作Token,确保语义信息的稳定性。在时间维度上,采用滑动窗口注意力(Window Attention),仅让当前帧关注前后121帧的范围,既捕捉了运动的局部连续性,又将计算复杂度控制在线性水平,保障了长序列动作生成的效率。

位置编码方面,模型采用全旋转位置编码(RoPE),为动作序列与文本描述建立连续的相对坐标系统,强化了时空对应关系,让模型能够更好地理解动作的时间节奏与文本的语义逻辑关联。

2. 文本理解增强:LLM驱动的指令处理模块

为提升对自然语言指令的理解能力,HY-Motion 1.0引入了大语言模型(LLM)作为文本处理核心,构建了“指令解析→Prompt重写→时长预测”的全流程处理 pipeline:

文本编码器:采用Qwen3-8B作为基础模型,配合双向Token细化器(Bidirectional Token Refiner),将因果LLM的特征转化为双向表示,解决了自回归模型上下文受限的问题,提升了长文本指令的理解能力;

Prompt重写模块:由Qwen3-30B-A3B微调而来,能够将用户输入的非结构化自然语言(如“做一个很酷的动作”)转化为模型易于理解的结构化描述(如“站立姿态下,身体快速侧转90度,同时右手挥出一拳,左手自然护胸”),并通过人工校验的标注数据优化,消除机器幻觉带来的语义偏差;

时长预测模块:基于LLM的常识推理能力,自动预测动作的合理持续时间,例如将“短暂挥手”解析为1.5秒,“慢跑一段距离”解析为5秒,解决了用户未指定时长时的动作生成合理性问题。

该模块通过有监督微调(SFT)与强化学习(GRPO)两阶段优化,确保了指令改写的准确性与时长预测的合理性,使模型对模糊指令、不规范描述的鲁棒性显著提升。

3. 三阶段训练范式:从规模到质量的渐进式优化

HY-Motion 1.0采用“大规模预训练→高质量微调→强化学习对齐”的三阶段训练范式,实现了泛化能力与生成质量的平衡提升,具体流程如下:

(1)大规模预训练阶段

训练数据:超过3000小时的多样化动作数据,来源包括野外视频提取数据、专业动捕数据、游戏动画资产等,涵盖广泛的动作类型与场景,虽然包含少量噪声,但为模型提供了丰富的运动先验知识;

训练目标:学习人体运动的基本规律、动作与文本的映射关系,建立通用的运动认知,让模型初步掌握“如何动”的核心逻辑;

关键成果:模型能够理解简单指令并生成大致符合要求的动作,建立了鲁棒的语义-动作映射基础,为后续微调奠定基础。

(2)高质量微调阶段

训练数据:400小时经过严格筛选的高质量动作子集,通过自动清洗(剔除重复、异常姿态、关节速度离群值)与人工校验,确保数据的纯净度与动作的规范性;

训练策略:学习率降至预训练阶段的十分之一,采用更精细的优化目标,重点优化动作的流畅度、细节表现力与物理合理性;

关键成果:模型生成的动作从“大致正确”升级为“精确平滑”,高频抖动、滑步等伪影大幅减少,对细粒度指令的敏感度显著提升,同时未牺牲动作多样性。

(3)强化学习对齐阶段

优化算法:采用DPO(直接偏好优化)+ Flow-GRPO组合算法,前者基于9000多对人类标注的偏好数据,让模型内化人类对动作质量的评判标准;后者针对物理约束与语义约束进行显式优化;

奖励函数:融合语义检索模型(TMR)评分(评估语义对齐度)与物理惩罚项(如滑步漂移、关节角度异常),确保生成动作既符合用户指令,又满足物理规律;

关键成果:解决了生成模型“统计上合理但物理上不可行”的核心问题,动作的视觉真实感与用户偏好对齐度显著提升,达到商业级应用标准。

4. 数据工程:从采集到标注的全流程精细化处理

高质量的数据是模型性能的基础,HY-Motion 1.0构建了一套涵盖数据获取、处理、过滤、标注的完整数据管线,确保训练数据的质量与多样性:

(1)数据采集与提取

数据来源包括三大类:1200万个野外视频片段、专业动作捕捉(MoCap)数据、游戏级3D动画资产。对于视频数据,通过GVHMR算法提取SMPL-X参数,转化为3D骨骼动作;对于3D动画数据,直接提取骨骼运动信息,最终汇总形成大规模原始数据集。

(2)数据标准化处理

骨架统一:所有动作数据重定向至SMPL-H标准骨架,去除手部骨骼细微差异,保留22个核心关节点的运动信息,确保数据的一致性;

格式归一化:将所有动作重采样至30帧/秒,对动作起始位置与朝向进行统一对齐,消除空间位置偏差对训练的影响;

噪声过滤:通过自动化算法剔除重复动作、异常姿态、关节速度离群值及存在严重滑步的片段,初步提升数据纯净度。

(3)标注体系构建

初步标注:将动作数据(或渲染生成的合成视频)输入Gemini-2.5-Pro等视觉语言模型(VLM),生成初步的动作描述与关键词;

人工校验:对VLM生成的标注进行人工审核,修正错误描述、补充缺失细节,消除机器幻觉带来的标注偏差;

标准化与扩展:利用大语言模型对标注文本进行结构化处理,生成多样化改写,构建包含动作类别、持续时间、详细描述的层级化分类体系,最终形成覆盖6大类200余种动作的标注数据集。

四、应用场景

HY-Motion 1.0凭借其高质量的动作生成能力、广泛的兼容性与低使用门槛,在多个数字内容创作领域展现出巨大的应用价值,以下是核心应用场景详解:

1. 游戏开发领域

游戏开发是HY-Motion 1.0最核心的应用场景之一,能够为不同类型游戏提供高效的动画资产生成解决方案,显著降低开发成本与周期:

NPC动画批量生成:对于MMO、开放世界等需要大量NPC的游戏,模型可快速生成巡逻、交谈、拾取物品、闲逛等日常行为动画,无需动画师逐一键帧制作,大幅提升NPC群体的生动性与开发效率;

主角动作原型设计:在游戏预研阶段,开发者可通过文本指令快速生成攻击、跳跃、技能释放等核心动作原型,快速验证玩法设计可行性,缩短迭代周期;虽然主角最终动画仍需美术微调,但模型生成的内容可作为高质量基础素材,减少70%以上的基础制作工作量;

个性化动作定制:支持生成游戏专属的特色动作,如仙侠游戏的法术释放、武侠游戏的轻功跳跃、恐怖游戏的僵尸蹒跚等,丰富游戏角色的动作库,提升玩家体验。

模型生成的动作可直接导入Unity、Unreal Engine等游戏引擎,无需格式转换,完美适配游戏开发工作流,特别适合中小团队与独立开发者降低制作门槛。

2. 影视与广告制作领域

在影视、广告等视频内容创作中,HY-Motion 1.0可作为高效的预演与辅助制作工具,提升创作灵活性:

分镜预演动画生成:导演可通过文本指令快速生成分镜对应的人物动作动画,直观呈现镜头效果与叙事逻辑,便于团队沟通与方案调整,减少实拍阶段的反复试拍成本;

广告人物走位设计:对于需要展现特定动作的广告(如体育用品广告的运动场景、日用品广告的使用场景),模型可快速生成符合要求的动作动画,作为后期合成或实拍参考,提升广告制作效率;

低成本动画内容制作:对于短视频、科普视频等轻量化内容,可直接使用模型生成的动画素材,无需专业动画团队,降低内容创作门槛,同时支持快速迭代不同版本的动作设计。

3. VR/AR与元宇宙领域

VR/AR与元宇宙应用对实时、自然的人体动作交互需求强烈,HY-Motion 1.0能够提供高质量的动作生成支持:

VR/AR交互动作生成:为VR游戏、AR导航等应用生成实时响应的人体动作,如虚拟角色跟随用户指令做出挥手、指引、动作示范等,提升交互的自然度与沉浸感;

元宇宙 avatar 动作库构建:为元宇宙平台的用户虚拟形象(avatar)提供丰富的动作选择,用户可通过文本描述定制专属动作(如跳舞、打招呼、特殊姿态),增强虚拟社交的趣味性与个性化表达;

虚拟场景互动设计:为元宇宙中的虚拟空间生成环境互动动作,如打开虚拟门、操作虚拟设备、与虚拟物品交互等,提升场景的交互丰富度。

4. 数字人与虚拟主播领域

数字人技术的核心需求之一是自然流畅的动作表现,HY-Motion 1.0为数字人开发提供了高效解决方案:

虚拟主播实时动作生成:结合实时语音转文字技术,可将虚拟主播的台词转化为对应的肢体动作(如说话时的手势、情绪对应的姿态变化),提升直播的真实感与表现力,减少手动操控成本;

数字人交互动作库建设:为客服数字人、教育数字人等不同场景的数字人构建专用动作库,如客服数字人的问候、指引动作,教育数字人的演示、书写动作等,丰富数字人的交互能力;

动态数字人内容创作:快速生成数字人在不同场景下的动作动画,如产品介绍数字人的演示动作、虚拟偶像的舞蹈动作等,降低数字人内容制作的技术门槛与周期。

5. 教育与培训领域

在教育与职业培训场景中,HY-Motion 1.0可用于生成直观的动作示范内容,提升教学效果:

体育教学动画:生成标准的体育动作示范(如篮球投篮姿势、瑜伽动作分解),帮助学生直观理解动作要领,辅助线下教学;

职业技能培训:为工业操作、医疗护理等职业培训生成规范的操作动作动画,如手术器械使用姿势、设备操作步骤对应的肢体动作,帮助学员快速掌握关键动作要领;

科普动画制作:生成人体运动、生物力学相关的科普动画,如骨骼关节运动原理、肌肉发力过程等,将抽象知识具象化,提升学习兴趣与理解效率。

五、使用方法

HY-Motion 1.0提供了多种使用方式,支持从新手友好的可视化界面到开发者适用的命令行工具,同时兼容全平台部署,以下是详细使用指南:

1. 环境准备

(1)硬件要求

模型对GPU显存有一定要求,不同版本的最低配置与推荐配置如下表所示:

| 模型版本 | 最低显存要求 | 推荐显存配置 | 适用场景 |

|---|---|---|---|

| HY-Motion 1.0(1.0B) | 26GB | 32GB及以上 | 追求最优动作质量、工业级应用 |

| HY-Motion 1.0-Lite(0.46B) | 24GB | 24GB及以上 | 平衡性能与部署成本、个人开发 |

注:通过调整参数可进一步降低显存占用,具体优化方案见“常见问题解答”部分。

(2)软件环境

操作系统:Windows 10/11、macOS 12+、Linux(Ubuntu 20.04+);

依赖库:Python 3.8-3.10、PyTorch 2.0+、CUDA 11.7+(GPU加速必需)、Gradio 3.0+(可视化界面)、NumPy、SciPy、Pillow等;

其他工具:Git(代码克隆)、Blender/Unity/Unreal Engine(动画导入与编辑,可选)。

(3)环境安装步骤

克隆GitHub仓库:打开终端,执行命令

git clone https://github.com/Tencent-Hunyuan/HY-Motion-1.0.git,下载项目代码;进入项目目录:执行

cd HY-Motion-1.0;安装依赖库:执行

pip install -r requirements.txt,自动安装所有必需依赖;下载模型权重:从Hugging Face仓库下载对应版本的模型权重(标准版:https://huggingface.co/tencent/HY-Motion-1.0/tree/main/HY-Motion-1.0;轻量版:https://huggingface.co/tencent/HY-Motion-1.0/tree/main/HY-Motion-1.0-Lite),将权重文件放置在项目的`ckpts/`目录下。

2. 三种核心使用方式

(1)Gradio可视化界面(推荐新手)

这是最易用的使用方式,无需编写代码,通过网页界面即可完成操作:

启动界面:在项目目录下执行命令

python gradio_app.py;配置参数:在浏览器打开生成的本地链接(通常为http://127.0.0.1:7860),在界面中设置:

模型版本:选择HY-Motion 1.0或HY-Motion 1.0-Lite;

文本提示词:输入动作描述(如“缓慢行走,同时挥手致意”);

动作时长:手动设置或选择“自动预测”;

其他参数:采样步数(默认20步,步数越高质量越好但速度越慢)、种子(控制动作随机性);

生成动作:点击“Generate”按钮,等待生成完成(通常10-30秒,取决于硬件配置);

预览与导出:在界面中预览动作动画,支持下载为SMPL-H格式文件或FBX格式文件,用于后续导入3D工具。

(2)CLI命令行工具(推荐开发者)

适合集成到自动化脚本或批量生成场景,使用步骤如下:

准备配置文件:在

examples/目录下参考示例配置文件,编写JSON格式的配置文件,包含prompt(文本提示)、duration(时长)、model_path(模型路径)等参数;执行生成命令:在终端执行

python local_infer.py --config_path examples/config.json;查看结果:生成的动作文件会保存到指定输出目录(默认

output/),支持SMPL-H、FBX等格式。

(3)ComfyUI插件(可视化工作流)

适合需要与其他AI工具联动的复杂创作场景:

安装插件:将项目

comfyui_plugin/目录下的文件复制到ComfyUI的custom_nodes/目录;启动ComfyUI:打开ComfyUI,在节点列表中找到“HY-Motion 1.0”相关节点;

构建工作流:拖拽节点搭建生成流程,连接文本输入、模型加载、动作生成、格式导出等节点;

执行生成:点击“Queue Prompt”按钮,生成动作并导出文件。

3. 动作导入与编辑

生成的SMPL-H格式文件可直接导入主流3D工具进行后续编辑:

Blender:安装SMPL-H导入插件,直接导入文件,可对动作进行关键帧调整、姿态修改、绑定到自定义模型;

Unity:通过Unity的Animation导入功能,将FBX格式文件导入,适配角色模型骨骼,调整动画参数后即可用于游戏开发;

Unreal Engine:导入FBX文件后,利用引擎的动画工具进行优化,支持与物理系统、动画蓝图联动。

六、常见问题解答

1. 显存不足怎么办?

降低采样种子数量:执行命令时添加

--num_seeds=1(默认可能为多个种子),可减少显存占用;缩短动作时长:将动作时长控制在5秒以内,减少生成的帧数量;

简化文本提示:将文本提示词控制在30个单词以内,降低文本编码的显存消耗;

禁用提示工程:设置环境变量

disable_PROMPT_ENGINEERING=True,执行命令disable_PROMPT_ENGINEERING=True python3 gradio_app.py;选择轻量版模型:切换到HY-Motion 1.0-Lite,在牺牲少量质量的前提下降低显存需求。

2. 生成的动作存在轻微抖动或滑步,如何优化?

增加采样步数:将采样步数从默认20步提升至30-50步,提升动作平滑度;

优化提示词:增加细节描述,如“缓慢行走,脚部完全接触地面,无滑动”;

后处理优化:在Blender/Unity中使用动画平滑工具,对关节运动曲线进行插值处理;

调整模型参数:在CLI命令中添加

--flow_matching_steps=50,增强流匹配的优化效果。

3. 模型无法理解复杂的组合指令,该如何处理?

拆分指令:将复杂指令拆分为多个简单指令,分多次生成后拼接动作,如“先弯腰捡东西”和“再站起来”分别生成,再在3D工具中合并;

增加细节描述:明确动作的先后顺序、肢体分工,如“左手拿起杯子,举到嘴边,喝一口后放下”;

使用结构化提示词:按照“动作主体+动作步骤+姿态要求”的格式编写提示词,如“站立状态下,右脚向前迈出一步,身体前倾,右手伸出指向前方”。

4. 生成的动作与预期不符,如何调整?

更换种子:调整

--seed参数(如设置为不同的整数),生成不同版本的动作;补充否定提示:在提示词中添加不希望出现的动作,如“跑步,不要跳跃,不要摆臂过大”;

调整动作时长:适当延长或缩短动作时长,如将“挥手”从1秒调整为2秒,让动作更完整;

检查提示词歧义:避免模糊描述,如将“快速移动”明确为“快速跑步”或“快速侧移”。

5. 模型支持生成涉及物体交互的动作吗?

目前模型对涉及工具或外部物体的精准人-物交互动作支持有限,这是由于训练数据主要关注人体自身运动,缺乏对物体几何和约束的建模。若需此类动作,可采用以下方案:

分阶段生成:先生成人体动作,再在3D工具中手动添加物体交互逻辑;

提示词强化:详细描述物体位置与交互方式,如“右手握住杯子手柄,将杯子举至胸前”;

后期绑定:在Blender/Unity中为生成的人体动作绑定物体,调整骨骼与物体的碰撞关系。

6. 不同操作系统的部署有差异吗?

HY-Motion 1.0在Windows、macOS、Linux上的核心功能完全一致,仅在依赖库安装与GPU加速配置上有细微差异:

Windows:需确保安装对应版本的CUDA与Visual Studio Build Tools,避免编译错误;

macOS:M系列芯片用户需使用PyTorch的MPS加速版本,执行

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cpu后,模型会自动利用MPS加速;Linux:推荐使用Ubuntu 20.04+,通过apt-get安装依赖库,GPU加速配置更简便。

7. 模型可以进行二次开发或微调吗?

是的,项目开源了完整的模型代码、训练框架与数据处理管线,支持二次开发与微调:

二次开发:可基于

hymotion/network/目录下的代码修改模型架构,或扩展pipeline/目录下的生成流程;微调训练:参考

scripts/train_finetune.py脚本,使用自定义数据集进行微调,需确保数据格式符合SMPL-H标准,并按照项目提供的标注规范进行文本标注;模型导出:支持将微调后的模型导出为ONNX格式,便于部署到边缘设备。

七、相关链接

Hugging Face模型库:https://huggingface.co/tencent/HY-Motion-1.0

八、总结

HY-Motion 1.0是腾讯混元团队开源的一款里程碑式文本到3D动作生成模型,作为首个实现十亿参数规模稳定训练的DiT+流匹配架构模型,它通过三阶段训练范式与精细化数据工程,在指令跟随能力(SSAE指标78.6%)与动作质量上全面超越现有开源基准,系统性解决了该领域长期存在的指令理解弱、动作伪影多、部署门槛高的核心问题。模型覆盖6大类200余种动作,支持全平台部署与主流3D工具兼容,提供标准版与轻量版满足不同场景需求,能够为游戏开发、影视制作、VR/AR、数字人等领域提供高效、低成本的动画生成解决方案,显著降低3D内容创作门槛。其开源不仅为行业提供了首个商业级文本到动作生成基准,更推动了AIGC 3D技术的实用化落地,为数字内容创作行业的效率革命注入了强大动力,同时通过开放的代码与模型,赋能开发者与创作者进行二次创新,构建更丰富的应用生态。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/hy-motion-1-0.html