Kaleido:智谱AI开源的多主体参考视频生成模型

一、Kaleido是什么

Kaleido是由智谱AI、合肥工业大学、清华大学等机构联合研发的开源多主体参考视频生成模型,该模型解决了传统视频生成模型难以同时处理多个主体、生成内容与参考信息脱节的问题,支持512P分辨率视频生成,提供完整的训练、推理代码及预训练权重,适配Python 3.10-3.12环境,可通过简单的指令完成多主体参考视频的生成,为视频创作、数字内容生产等领域提供了高效、可定制的解决方案。

传统的视频生成模型往往存在两大核心痛点:一是难以精准还原参考内容中的多个主体特征,易出现主体丢失、特征混淆的问题;二是生成视频的分辨率和流畅度难以兼顾,且对参考信息的复用性差。Kaleido针对这些问题进行了针对性优化,其核心目标是让用户能够基于给定的参考图像/视频片段,生成包含多个指定主体、动作连贯、视觉效果统一的高分辨率视频,且整个过程支持开源定制,降低了多主体视频生成的技术门槛。

作为开源项目,Kaleido不仅提供了完整的模型训练、推理代码,还发布了预训练的Kaleido-14B-S2V模型权重,用户可通过Hugging Face获取权重文件,并基于自身需求进行二次训练或直接推理,覆盖科研、商业创作等多类使用场景。

二、功能特色

Kaleido的核心优势围绕“多主体、高还原、易使用、可定制”四大维度展开,具体功能特色如下表所示:

| 功能特色 | 具体描述 | 优势价值 |

|---|---|---|

| 多主体精准还原 | 支持基于单张/多张参考图像、短视频片段,生成包含2个及以上主体的视频,且每个主体的外观、特征(如服饰、面部、动作特征)与参考内容高度一致,无主体混淆、特征丢失问题 | 解决传统模型“单主体生成尚可,多主体易失真”的痛点,满足多角色视频创作需求 |

| 512P高分辨率输出 | 预训练模型支持512P分辨率视频生成,画面细节丰富,相较于同类型轻量级模型(如部分360P分辨率模型),视觉效果提升显著 | 兼顾生成效率与视觉质量,可直接用于短视频、数字内容等商业化场景 |

| 兼容多类参考输入 | 支持图像(JPG/PNG等)、短视频片段(MP4)作为参考素材,无需对参考内容进行特殊格式转换,输入适配性强 | 降低用户素材准备成本,适配多样化的创作源头 |

| 完整的开源链路 | 提供训练(train_video_concat.py)、推理(sample_video.py)、数据处理(data_video.py)全流程代码,且核心模块(量化器、梯度惩罚函数等)开源可定制 | 便于科研人员复现论文结果、企业开发者二次开发 |

| 提示词优化适配 | 支持结合GLM-4.5、GPT-5等大模型优化提示词,进一步提升视频生成的精准度和贴合度 | 降低普通用户的提示词编写门槛,提升生成效果的可控性 |

| 轻量化环境适配 | 适配Python 3.10-3.12版本,依赖库通过requirements.txt一键安装,无需复杂的环境配置 | 减少环境搭建耗时,降低非专业用户的使用门槛 |

除上述核心特色外,Kaleido还具备以下附加优势:

模型整合了Wan VAE(视频编码解码模块)和T5(文本语义理解模块),能够更好地理解文本提示词与参考素材的关联,让生成视频既符合文本指令,又匹配参考主体特征;

提供checkpoint合并工具(merge_kaleido.py),可便捷处理Hugging Face下载的权重文件,无需手动拆分/合并,提升权重使用效率;

训练过程支持梯度惩罚函数、FSQ量化器等优化组件,能够提升模型训练的稳定性和最终生成效果。

三、技术细节

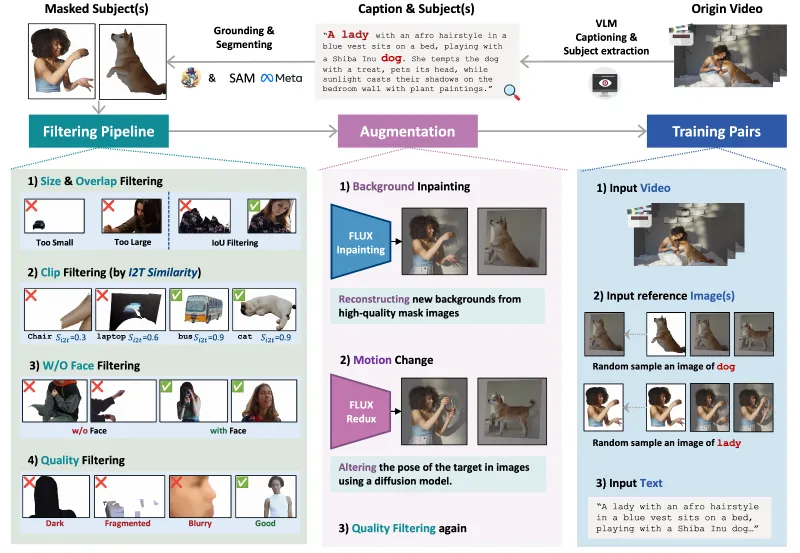

Kaleido的技术架构围绕“参考特征提取-文本语义理解-视频扩散生成-后处理优化”四大核心环节构建,以下从核心模块、代码结构、模型权重三个维度拆解技术细节:

3.1 核心技术模块

Kaleido的底层架构融合了多项成熟的AI技术,核心模块包括:

Wan VAE模块:负责视频的编码与解码,是实现512P高分辨率视频生成的核心组件。该模块能够将参考素材的视觉特征压缩编码,再在生成阶段还原为高分辨率视频帧,兼顾压缩效率与特征保留;

T5文本语义模块:用于解析用户输入的文本提示词,将自然语言指令转化为模型可理解的语义特征,实现“文本+参考素材”双驱动的视频生成;

FSQ量化器:全称“Finite Scalar Quantization”,用于对模型的中间特征进行量化处理,减少计算量的同时保证特征精度,提升训练和推理效率;

梯度惩罚函数:在训练过程中约束模型梯度的范围,避免梯度爆炸或消失,提升训练稳定性,确保模型收敛到更优的参数空间;

扩散模型核心:Kaleido的视频生成核心基于扩散模型实现,通过逐步去噪的方式生成连贯的视频帧,解决了传统生成模型视频帧不连贯、动作失真的问题。

3.2 代码结构

Kaleido的代码仓库结构清晰,按功能模块划分目录,便于用户快速定位核心代码,具体结构如下:

| 目录/文件 | 核心功能 | 关键文件示例 |

|---|---|---|

| 根目录 | 训练、推理、权重合并的主脚本 | train_video_concat.py(训练)、sample_video.py(推理)、merge_kaleido.py(权重合并) |

| configs/ | 配置文件目录 | sample.yaml(推理配置)、train.yaml(训练配置)、video_model.yaml(视频模型配置) |

| sat/ | 模型架构相关模块 | 包含FSQ量化器、梯度惩罚函数等核心工具类 |

| sgm/ | 扩散模型组件 | 扩散过程的核心逻辑、视频帧生成相关代码 |

| data_video.py | 数据处理脚本 | 参考素材的加载、预处理、格式转换等 |

| requirements.txt | 依赖清单 | 列出所有必要的Python库及版本 |

3.3 模型权重

Kaleido提供的预训练权重为Kaleido-14B-S2V,发布于Hugging Face(Crilias/Kaleido-14B-S2V),需注意以下技术细节:

权重文件需通过

merge_kaleido.py进行合并后才能使用,该脚本会将下载的分片权重整合为模型可识别的完整文件;14B参数量的模型在保证生成效果的同时,兼顾了推理效率,普通GPU(如NVIDIA A10、3090)均可支持推理;

权重适配512P分辨率生成,若需调整分辨率,需修改configs/下的视频模型配置文件,并重新微调训练。

四、应用场景

Kaleido的多主体参考视频生成能力使其可覆盖多个领域,具体应用场景如下:

4.1 数字内容创作

短视频创作者、自媒体博主可基于参考人物/物品素材,生成包含多个角色的剧情类视频,无需实际拍摄即可完成多主体互动的内容制作。例如:基于多张动漫角色参考图,生成角色互动的短视频;基于产品参考图,生成多产品展示的带货视频。

4.2 科研与学术研究

计算机视觉、生成式AI领域的研究者可基于Kaleido的开源代码和预训练权重,复现论文结果,或针对“多主体特征保留”“视频分辨率提升”等方向进行改进研究,降低科研实验的起步成本。

4.3 商业广告制作

广告公司可利用Kaleido生成包含多个产品、模特的广告视频,只需提供产品/模特的参考素材和文本指令,即可快速生成多版广告初稿,提升广告制作效率,降低拍摄成本。

4.4 虚拟人/数字分身应用

在虚拟人领域,可基于用户的数字分身参考图像,生成多个虚拟人互动的视频内容,用于虚拟直播、数字展厅等场景,无需复杂的动捕设备即可实现多虚拟人联动。

4.5 教育与培训内容制作

教育机构可基于教材中的人物、场景参考图,生成包含多个角色的教学动画视频,例如:历史场景还原(多个历史人物互动)、科学实验演示(多个实验器材/人物配合),提升教学内容的直观性。

五、使用方法

Kaleido的使用流程分为“环境搭建-权重下载与合并-推理生成”三步,部分场景可增加“二次训练”环节,具体操作如下:

5.1 环境准备

5.1.1 系统与Python版本要求

操作系统:支持Linux(推荐Ubuntu 20.04+)、Windows 10/11、macOS 12+;

Python版本:必须为3.10、3.11、3.12(其他版本可能出现依赖库兼容问题);

硬件要求:推理建议使用显存≥12GB的NVIDIA GPU(如3090、A10),训练建议使用显存≥24GB的GPU(如A100、4090);若无GPU,可使用CPU推理,但速度极慢,不推荐。

5.1.2 依赖安装

克隆Kaleido仓库到本地:

git clone https://github.com/Criliasmiller/Kaleido.git cd Kaleido

安装依赖库:

pip install -r requirements.txt

注:若安装过程中出现依赖冲突,可先升级pip,再重新安装:

pip install --upgrade pip pip install -r requirements.txt --force-reinstall

5.2 模型权重下载与合并

从Hugging Face下载

Kaleido-14B-S2V权重文件: 访问链接:https://huggingface.co/Crilias/Kaleido-14B-S2V,下载所有分片权重文件(通常为多个.bin文件),保存到本地`checkpoints/`目录(需手动创建该目录);运行权重合并脚本:

python merge_kaleido.py --checkpoint_dir ./checkpoints --output_dir ./merged_ckpt

运行完成后,merged_ckpt/目录下会生成完整的模型权重文件。

5.3 推理生成视频

5.3.1 基础推理指令

修改configs/sample.yaml配置文件,主要调整以下参数:

reference_path:参考素材路径(图像/视频文件路径);prompt:文本提示词(如“两个穿着红色裙子的女孩在公园跳舞,动作连贯,背景为绿色草地”);output_path:生成视频的保存路径;resolution:生成分辨率(默认512,无需修改);ckpt_path:合并后的权重文件路径(即./merged_ckpt/kaleido_14b_s2v.ckpt)。

配置完成后,运行推理脚本:

python sample_video.py --config configs/sample.yaml

5.3.2 提示词优化建议

官方强调提示词优化对生成效果影响显著,建议:

使用GLM-4.5、GPT-5等大模型辅助编写提示词,例如向大模型输入“帮我优化生成多主体视频的提示词,要求包含两个女孩,一个穿白衬衫,一个穿蓝裙子,在海边散步,视频时长10秒,分辨率512P”;

提示词需明确主体特征(服饰、动作、数量)、场景、视频时长等信息,避免模糊表述。

5.4 二次训练(可选)

若需基于自有数据集训练模型,可参考以下步骤:

整理数据集:将参考素材、文本提示词、目标视频按指定格式整理(参考

data_video.py中的数据加载逻辑);修改训练配置:调整

configs/train.yaml中的data_path(数据集路径)、epochs(训练轮数)、learning_rate(学习率)等参数;运行训练脚本:

python train_video_concat.py --config configs/train.yaml

六、常见问题解答

Q1:运行推理脚本时提示“找不到权重文件”怎么办?

答:首先检查sample.yaml中的ckpt_path是否指向合并后的权重文件(路径需精确到.ckpt文件);其次确认权重合并脚本是否运行成功,merged_ckpt/目录下是否有完整的权重文件;若仍报错,可重新下载权重文件并再次合并,避免文件下载不完整。

Q2:生成的视频出现主体特征失真、混淆的问题如何解决?

答:主要原因有两点:一是提示词描述不清晰,需补充主体的特征细节(如“女孩A穿白色运动鞋,女孩B穿黑色帆布鞋”);二是参考素材质量不足,建议使用高清、主体特征明显的参考图像/视频;此外,可尝试增加提示词的长度,让模型更精准理解主体差异。

Q3:Python版本符合要求,但安装依赖时仍报错?

答:不同操作系统的依赖库兼容情况不同,可尝试以下方案:

Linux/macOS:安装前执行

apt-get install libgl1-mesa-glx(Linux)或brew install libomp(macOS),解决底层依赖缺失问题;Windows:使用Anaconda创建虚拟环境后再安装依赖,命令如下:

conda create -n kaleido python=3.11 conda activate kaleido pip install -r requirements.txt

Q4:生成视频的帧率过低、画面卡顿怎么办?

答:可在sample.yaml中调整fps参数(默认15,可改为24/30),但需注意:帧率越高,生成时间越长,且对GPU显存要求更高;此外,若参考素材为低帧率视频,建议先将参考素材转换为高帧率后再输入模型。

Q5:能否基于Kaleido生成更长的视频(如超过30秒)?

答:预训练模型默认支持生成10-20秒的视频,若需生成更长视频,可分两段生成后拼接,或基于自有长视频数据集对模型进行微调,调整train.yaml中的max_frames参数(最大帧数量)。

Q6:权重文件过大,下载速度慢怎么办?

答:可使用Hugging Face的镜像源下载,或通过git lfs方式克隆权重仓库:

git lfs install git clone https://hf-mirror.com/Crilias/Kaleido-14B-S2V ./checkpoints

七、相关链接

| 链接类型 | 链接地址 | 说明 |

|---|---|---|

| 论文链接 | https://arxiv.org/abs/2510.18573 | Kaleido的核心论文,包含模型设计思路、实验结果 |

| Hugging Face模型 | https://huggingface.co/Crilias/Kaleido-14B-S2V | 预训练权重下载地址 |

| 项目主页 | https://criliasmiller.github.io/Kaleido_Project/ | 包含模型演示、核心特性介绍 |

| 代码仓库 | https://github.com/Criliasmiller/Kaleido | 核心训练、推理代码托管地址 |

八、总结

Kaleido作为一款开源的多主体参考视频生成模型,由高校与企业联合研发,依托成熟的扩散模型、Wan VAE、T5等技术模块,解决了传统视频生成模型多主体还原失真、分辨率低、使用门槛高的问题,其提供的完整训练/推理代码、预训练权重及简洁的使用流程,既满足了科研人员的研究需求,也为商业内容创作、教育、广告等领域提供了高效的视频生成解决方案;该项目的开源特性降低了多主体视频生成的技术门槛,且适配主流的Python环境和硬件配置,是当前多主体参考视频生成领域兼具实用性和可定制性的优秀开源工具。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/kaleido.html