Kotaemon:开源 RAG 交互工具,兼顾用户友好与开发灵活的文档对话解决方案

一、Kotaemon是什么?

Kotaemon是一款开源的检索增强生成(RAG)UI工具,旨在为终端用户提供简洁的文档对话交互界面,同时为开发者提供可定制的RAG管道框架。它支持多模型集成(包括OpenAI、本地LLM等)、混合检索策略、多模态文档解析,并通过Gradio构建可扩展的UI组件。无论是个人学习中的文献问答,还是企业知识库的智能查询,Kotaemon都能通过灵活的配置和直观的操作满足需求。

Kotaemon会先从上传的文档中精准定位相关内容,再让LLM基于这些内容生成回答,既保证了效率,又避免了“幻觉”。

与其他RAG工具相比,Kotaemon的核心优势在于“双向友好”:

对终端用户:提供无需编程的可视化界面,支持上传文档、提问、查看引用来源,操作像使用聊天工具一样简单;

对开发者:提供模块化的RAG管道框架,支持自定义组件(如检索策略、模型接口),并基于Gradio实现UI快速迭代。

二、功能特色

Kotaemon的功能设计围绕“精准检索、灵活交互、易扩展”三大核心目标,具体特色如下:

1. 多模型兼容,兼顾云端与本地

Kotaemon支持几乎所有主流LLM和嵌入模型,无论是云端API还是本地部署的模型,都能无缝集成:

云端模型:OpenAI(GPT-3.5/4)、Azure OpenAI、Cohere、Anthropic(Claude)等,通过API密钥即可快速接入;

本地模型:通过

ollama(支持Llama 3、Mistral等)或llama-cpp-python(支持量化模型)调用本地部署的LLM,无需联网即可使用,保障数据隐私;嵌入模型:兼容OpenAI Embeddings、HuggingFace开源嵌入模型(如BAAI/bge-large-en),可根据精度需求选择。

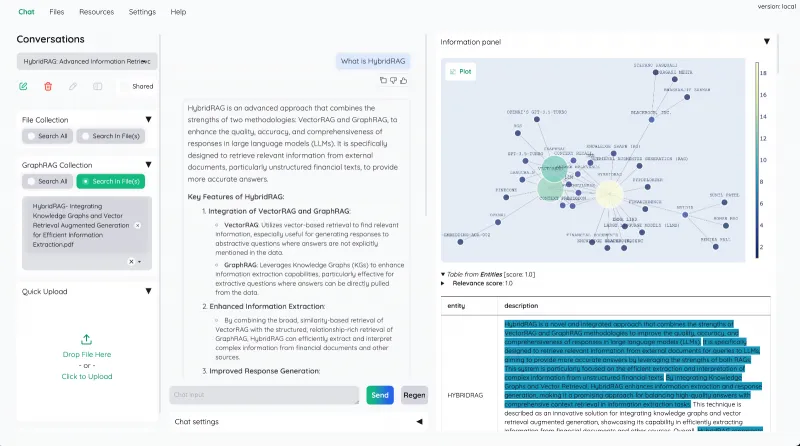

2. 混合RAG管道,提升检索精准度

传统RAG多依赖单一向量检索(通过文本语义相似度匹配),但可能遗漏关键词明确但语义差异大的内容。Kotaemon采用混合检索策略,大幅提升检索质量:

全文检索+向量检索:先通过全文检索(关键词匹配)快速过滤文档,再用向量检索(语义匹配)精准定位相关片段,兼顾效率与精度;

重排序机制:对初筛结果使用交叉编码器(如BAAI/reranker-large)二次排序,优先展示与问题最相关的内容;

检索警告:当检索结果相关性低于阈值时,界面会自动提示“信息可能不足”,避免用户被低质量回答误导。

3. 多模态QA支持,覆盖复杂文档类型

日常工作中的文档往往包含文字、表格、图表等多种元素(如PDF报告、Word文档),Kotaemon能深度解析这些内容:

支持格式:PDF、Word(.doc/.docx)、Excel、PowerPoint、纯文本(.txt)、Markdown等;

特殊元素处理:通过

Unstructured库解析表格结构(保留行列关系)、提取图表标题及说明文字,确保回答时不遗漏关键信息(例如:“文档中2023年销售额数据在哪个表格?”可直接定位并引用)。

4. 高级引用与预览,溯源有据可查

回答的可信度很大程度依赖于“是否有明确来源”。Kotaemon在引用功能上做了细致设计:

精准定位:回答中的每个结论都会标注来源文档的页码、段落,并支持点击跳转至PDF查看器中的对应位置,高亮显示相关内容;

多来源整合:当回答基于多个文档片段时,会按相关性排序列出所有来源,方便用户交叉验证;

引用格式自定义:开发者可通过配置文件调整引用显示样式(如编号、颜色、链接格式)。

5. 复杂推理支持,应对深层需求

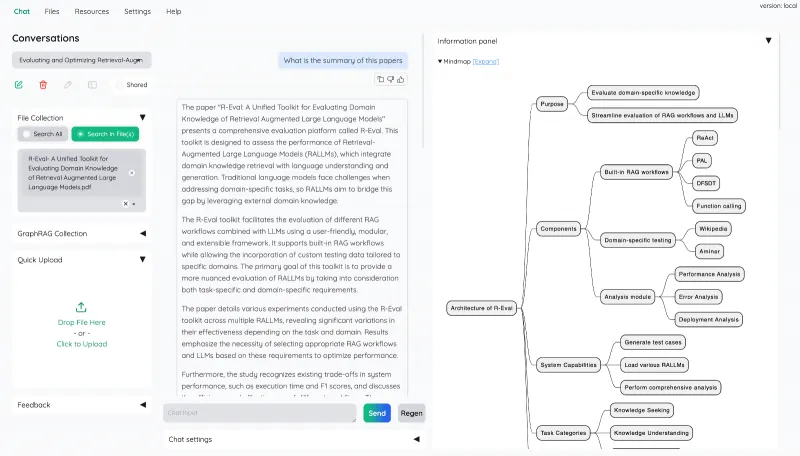

对于需要多步骤分析的问题(如“对比文档中三个方案的优劣势”“根据数据预测趋势”),Kotaemon提供多种推理策略:

问题分解:自动将复杂问题拆分为子问题(如“步骤1:提取方案A的优势;步骤2:提取方案B的优势;步骤3:对比差异”),逐步推导答案;

代理模式:支持ReAct(“思考-行动-观察”循环)、ReWOO(工具调用与结果整合分离)等代理框架,可调用计算器、表格分析工具等辅助推理;

自定义推理逻辑:开发者可通过修改提示词模板或编写插件,适配特定场景(如法律文档的条款对比、技术手册的故障排查)。

6. 可视化配置界面,零代码调整参数

无需编程,用户即可在UI中调整RAG关键参数,实时优化效果:

检索参数:修改检索数量(返回多少条相关片段)、相似度阈值(过滤低相关内容)、重排序模型等;

生成参数:调整LLM的温度(temperature,控制回答随机性)、最大 tokens(限制回答长度)、系统提示词(定义AI角色,如“用简洁的语言回答”);

保存配置:支持将常用参数组合保存为“配置模板”,一键切换(如“学术严谨模式”“快速回答模式”)。

7. 高可扩展性,支持二次开发

Kotaemon的模块化设计让开发者能轻松定制功能:

组件接口化:所有核心组件(LLM、向量存储、检索器等)都定义了标准接口,替换或新增组件只需实现接口即可(如将默认向量存储从Chroma换成Milvus);

UI自定义:基于Gradio框架,可直接修改前端代码调整界面布局、添加新按钮(如“导出回答为PDF”);

索引管道扩展:支持GraphRAG(将文档解析为知识图谱进行检索)等高级索引策略,通过插件机制集成。

表1:Kotaemon与主流RAG工具核心功能对比

| 功能 | Kotaemon | 其他开源RAG工具(如LangChain UI) | 商用RAG工具(如ChatPDF) |

|---|---|---|---|

| 多模型支持 | 云端+本地模型 | 以云端模型为主 | 固定模型,不可更换 |

| 检索策略 | 混合检索+重排序 | 多为单一向量检索 | 闭源策略,不可调 |

| 多模态文档处理 | 支持表格、图表解析 | 仅支持纯文本 | 部分支持,但解析精度有限 |

| 引用与溯源 | 页码高亮+多来源整合 | 简单片段引用 | 基础引用,无高亮 |

| 可扩展性 | 接口化组件+UI自定义 | 代码级扩展,无可视化配置 | 无扩展能力 |

三、技术细节

Kotaemon的技术架构围绕“模块化、可插拔”设计,核心分为接口层、组件层、应用层三层,确保各模块既能独立运行,又能灵活组合。

1. 基础接口设计

为实现组件的“即插即用”,Kotaemon定义了一系列核心接口,所有组件需遵循接口规范开发:

Document接口:统一文档数据格式,包含内容、元数据(文件名、页码等)、嵌入向量等字段;LLM接口:规定生成模型的调用方法(如generate(prompt))、参数(温度、最大tokens等);Embeddings接口:定义文本转向量的方法(embed_texts(texts)),兼容不同嵌入模型;VectorStore接口:规范向量存储的增删改查操作(add_documents()、similarity_search());Retriever接口:统一检索器的输出格式,要求返回带相关性分数的文档片段。

2. 核心组件实现

基于上述接口,Kotaemon封装了丰富的开箱即用组件:

| 组件类型 | 核心实现 | 功能说明 |

|---|---|---|

| LLM组件 | OpenAILLM、OllamaLLM | 封装OpenAI API、ollama本地调用,支持流式输出 |

| 嵌入组件 | OpenAIEmbeddings、HuggingFaceEmbeddings | 调用云端或本地嵌入模型生成向量 |

| 向量存储 | InMemoryVectorstore、ChromaVectorstore | 内存存储(轻量测试)、Chroma(持久化存储) |

| 检索器 | HybridRetriever、RerankingRetriever | 混合检索(全文+向量)、重排序检索 |

| 文档加载器 | PDFLoader、DocxLoader | 解析PDF(支持OCR)、Word文档,提取文本与元数据 |

| 工具组件 | CalculatorTool、TableAnalyzerTool | 提供计算、表格分析等辅助推理功能 |

3. 文件与索引管理

Kotaemon通过“文件-索引”关联机制管理用户上传的文档:

文件存储:上传的原始文件保存在本地目录(可配置路径),同时在SQLite数据库中记录文件元数据(ID、名称、上传时间、状态);

索引生成:文件上传后自动触发索引流程(解析文本→生成嵌入向量→存入向量存储),支持批量索引和增量索引(新增文件时仅处理新内容);

索引关联:数据库中通过“文件ID-索引ID”映射,实现“删除文件时自动清理对应索引”,避免冗余数据。

4. 前端与交互逻辑

前端基于Gradio构建,采用“单页应用+组件复用”模式:

核心页面:包含文件上传区、聊天交互区、配置面板、引用预览区四个模块,支持响应式布局(适配电脑、平板);

交互流程:用户提问→后端触发RAG管道(检索→生成)→前端实时显示生成过程(流式输出)→展示回答及引用→支持继续追问;

状态管理:通过Gradio的

State对象保存会话历史、当前配置,确保刷新页面后会话不丢失。

四、应用场景

Kotaemon的灵活性使其能适配多种场景,无论是个人用户还是企业团队,都能找到合适的用法:

1. 个人学习与研究

文献精读:上传多篇学术论文,提问“这三篇论文在研究方法上有何差异?”,Kotaemon会提取各论文的方法部分并对比,同时标注来源页码,省去逐篇查找的时间;

笔记整理:将课程PPT、教材章节上传,通过“总结文档核心观点”“列出3个关键问题及答案”等指令,快速生成复习资料;

跨语言阅读:上传外文文档,提问“用中文解释第5章的核心结论”,结合翻译与检索,避免理解偏差。

2. 企业知识库查询

内部文档检索:企业可将员工手册、产品手册、流程规范上传至Kotaemon,新员工通过提问“报销流程需要哪些材料?”“产品A的保修政策是什么?”快速获取信息,减少人力培训成本;

客户支持辅助:客服团队上传常见问题手册(FAQ)、故障排查指南,面对客户问题时,Kotaemon可实时检索相关解决方案,确保回答准确且一致;

数据隐私保障:通过部署本地LLM(如Llama 3 70B)和私有向量存储,所有文档和对话数据均在企业内网处理,符合数据安全规范。

3. 教育与培训

教材互动:教师将教材章节上传,学生可提问“用例子说明牛顿第二定律”“这道例题的解题步骤是什么?”,Kotaemon结合教材内容生成针对性解答,辅助自主学习;

培训考核:培训机构上传培训资料后,可通过Kotaemon生成“基于文档的测试题”,并自动核对学员答案是否符合资料表述,简化考核流程。

4. 内容创作辅助

资料整合:写报告时,上传多个参考文档,提问“整理文档中关于行业趋势的所有数据,按年份排序”,快速获取结构化信息;

引用规范:生成回答时自动附带文档来源,可直接用于论文或报告的参考文献部分,减少格式校对工作。

五、使用方法

Kotaemon支持两种安装方式:Docker(推荐,快速部署)和本地源码安装(适合开发),以下是详细步骤:

1. 系统要求

操作系统:Windows 10+、macOS 12+、Linux(Ubuntu 20.04+);

依赖:Python ≥ 3.10(本地安装)、Docker ≥ 20.10(Docker安装);

可选工具:

Unstructured(处理.doc/.docx等格式需安装,pip install "unstructured[all-docs]")。

2. Docker安装(推荐终端用户)

Docker安装无需配置依赖,适合快速启动:

步骤1:拉取镜像

Kotaemon提供两种镜像:lite(轻量版,支持PDF、纯文本)和full(完整版,支持所有文件类型,体积较大)。# 拉取轻量版 docker pull ghcr.io/cinnamon/kotaemon:lite # 或拉取完整版 docker pull ghcr.io/cinnamon/kotaemon:full

步骤2:启动容器

运行以下命令启动服务(默认端口7860,可通过-p 新端口:7860修改):docker run -p 7860:7860 -v ./kotaemon_data:/app/data ghcr.io/cinnamon/kotaemon:full

其中

-v ./kotaemon_data:/app/data用于将容器内的文档数据映射到本地kotaemon_data文件夹,避免容器删除后数据丢失。步骤3:使用工具

打开浏览器,访问http://localhost:7860,即可看到Kotaemon界面:点击“上传文件”按钮添加文档(支持批量上传);

等待文件索引完成(界面会显示进度);

在输入框中提问(如“文档中提到的核心技术是什么?”),点击“发送”即可获取回答。

3. 本地源码安装(适合开发者)

步骤1:克隆仓库

git clone https://github.com/Cinnamon/kotaemon.git cd kotaemon

步骤2:创建虚拟环境并安装依赖

# 创建虚拟环境 python -m venv venv # 激活环境(Windows:venv\Scripts\activate;macOS/Linux:source venv/bin/activate) # 安装依赖 pip install -e ".[dev,full]" # full版本支持所有文件类型 # 如需轻量版(仅PDF、纯文本),安装:pip install -e ".[dev]"

步骤3:启动服务

python -m kotaemon.app

服务启动后,访问

http://localhost:7860即可使用。

4. 基础配置(以切换LLM为例)

默认情况下,Kotaemon使用OpenAI的GPT-3.5-turbo,如需切换为本地模型(如通过ollama部署的Llama 3):

在界面点击“设置”→“LLM配置”;

选择“LLM类型”为“ollama”;

输入模型名称(如“llama3”)和ollama服务地址(默认

http://localhost:11434);点击“保存配置”,后续回答将使用该模型。

六、常见问题解答(FAQ)

1. Kotaemon支持哪些文件格式?

基础版(lite)支持PDF、纯文本(.txt)、Markdown;完整版(full)额外支持Word(.doc/.docx)、Excel(.xlsx)、PowerPoint(.pptx)、图片中的文字(需OCR支持)。若上传文件提示“不支持的格式”,请确认安装了完整版依赖(unstructured[all-docs])。

2. 如何解决“检索结果相关性低”的警告?

可能原因及解决方法:

文档内容与问题无关:上传更相关的文档;

检索参数设置不合理:在“设置→检索配置”中,降低“相似度阈值”(如从0.7调至0.5),或增加“检索数量”(如从5条增至10条);

嵌入模型不匹配:尝试更换嵌入模型(如从“OpenAI Embeddings”换成“BAAI/bge-large-en”)。

3. 本地模型运行速度慢怎么办?

选择更小的模型(如Llama 3 8B替代70B);

启用模型量化(如4-bit/8-bit量化,通过ollama部署时添加

--quant 4q参数);升级硬件(本地模型依赖GPU加速,推荐NVIDIA显卡,显存≥8GB)。

4. 能否将Kotaemon部署到服务器供多人使用?

可以。通过Docker部署时,修改启动命令为:

docker run -p 7860:7860 -v ./kotaemon_data:/app/data --restart always ghcr.io/cinnamon/kotaemon:full

其中--restart always确保服务器重启后自动启动服务,其他人通过“服务器IP:7860”访问。若需用户认证,可结合Nginx添加密码保护。

5. 如何自定义UI界面?

开发者可修改kotaemon/app.py中的Gradio代码:

新增组件:在

create_interface()函数中添加Gradio组件(如gr.DownloadButton用于导出回答);调整布局:修改

gr.Blocks()中的组件排列顺序;样式修改:通过

css参数自定义颜色、字体(如css=".chat-message { background: #f0f0f0; }")。

6. 数据存储在哪里?是否安全?

文档文件:保存在本地目录(Docker部署为

./kotaemon_data/files,本地安装为./data/files);索引数据:向量存储在

./kotaemon_data/vectorstore(Chroma格式),元数据保存在./kotaemon_data/db.sqlite;安全性:所有数据均存储在本地,无外部上传,如需更高安全级,可加密文件目录或部署在私有服务器。

七、相关链接

八、总结

Kotaemon是一款兼顾终端用户体验与开发者需求的开源RAG工具,通过混合检索、多模型兼容、多模态处理等功能,解决了文档问答中的“效率低”“不准确”“难扩展”问题。它既适合普通用户快速实现文档智能交互,也为开发者提供了灵活的框架进行二次开发,在学习、工作、教育等场景中都能发挥实用价值,是开源社区中RAG技术落地的优秀实践。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/kotaemon.html