Linly-Dubbing:开源多语言AI视频配音和翻译工具

一、Linly-Dubbing是什么?

Linly-Dubbing是一款开源的多语言AI视频配音和翻译工具,旨在通过先进的AI技术实现高质量的视频内容本地化。该项目受到YouDub-webui的启发,并进行了进一步的扩展和优化,集成了Linly-Talker的数字人唇同步技术,为用户提供多样化和高质量的视频配音选项。它能自动下载视频、翻译字幕、分离人声、克隆音色配音并合成视频,为用户提供了一种高效且自然的视频处理解决方案。

作为一个遵守Apache2.0开源协议的项目,Linly-Dubbing通过整合多种前沿AI技术,在多语言配音的自然性和准确性方面达到了新的高度。它支持将视频内容自动翻译成多种语言并生成字幕,还能克隆视频中说话者的声音并自动配音,以及进行口型匹配,使视频内容能够跨越语言障碍,触达全球观众。

表:Linly-Dubbing核心功能概览

| 功能类别 | 具体描述 | 技术支撑 |

|---|---|---|

| 语音识别 | 精确的语音到文本转换和说话者识别 | WhisperX、FunASR |

| 翻译引擎 | 高质量多语言翻译 | OpenAI API、Qwen大模型 |

| 语音合成 | 自然流畅的AI配音,支持声音克隆 | Edge TTS、XTTS、CosyVoice |

| 视频处理 | 人声分离、口型同步、字幕生成 | UVR5、Linly-Talker技术、ffmpeg |

| 多语言支持 | 中文及多种其他语言的配音和字幕 | 集成多种语言模型和语音库 |

二、功能特色

Linly-Dubbing集成了多种先进的AI技术,为用户提供了一系列强大的视频处理功能,使其在同类工具中脱颖而出。以下将详细介绍其主要功能特色:

1. 多语言支持

Linly-Dubbing支持中文及多种其他语言的配音和字幕翻译,能够满足内容创作者的国际化需求。无论是将中文视频翻译成英文、法语、西班牙语等主流语言,还是将外语视频本地化为中文,Linly-Dubbing都能提供高质量的翻译和配音服务。这一功能特别适合希望将内容推向全球市场的创作者和教育机构。

项目采用了模块化设计,可以灵活添加新的语言支持。目前已经内置了对数十种语言的支持,并且持续更新扩展语言库。用户可以根据目标受众选择最合适的语言组合,实现真正的全球化内容传播。

2. AI智能语音识别

Linly-Dubbing采用了先进的AI技术进行语音识别,提供精确的语音到文本转换和说话者识别功能。其核心语音识别引擎结合了WhisperX和FunASR两大技术:

WhisperX:作为OpenAI Whisper的扩展版本,专门为视频字幕生成和语音对齐优化,不仅准确转录口语内容,还能将文本与视频帧精确对齐,生成带时间戳的字幕文件。它对英语支持尤为出色,识别准确率高。

FunASR:一个全面的语音识别工具包,提供自动语音识别(ASR)、语音活动检测(VAD)、标点恢复等功能。FunASR特别针对中文语音进行了优化,在中文场景下表现优异,支持多人对话识别和说话人分离。

这两个引擎可以根据视频语言特点灵活选择或组合使用,确保获得最佳的语音识别效果。例如,对英文为主的视频可优先使用WhisperX,而中文内容则可选择FunASR以获得更高准确率。

3. 大型语言模型翻译

Linly-Dubbing的翻译功能结合了领先的大型语言模型(如GPT),能够快速且准确地进行翻译,确保专业性和自然性。与传统的机器翻译不同,基于LLM的翻译能够更好地理解上下文,保持语言的流畅性和文化适应性。

项目支持多种翻译引擎选择,包括:

OpenAI API:使用GPT-4或GPT-3.5-turbo等模型进行高质量翻译,需要用户提供自己的API密钥。

Qwen大模型:一种本地化的大型语言模型,特别适合中文相关内容翻译。

微软Bing Translate:作为备用选项,在国内网络环境下稳定可用。

Google翻译:需要科学上网,但在某些语言对上表现优秀。

用户可以根据自身需求、网络环境和预算选择最适合的翻译引擎。所有翻译引擎都经过优化配置,以确保翻译结果既准确又自然,符合目标语言的文化习惯。

4. AI声音克隆

Linly-Dubbing利用尖端的声音克隆技术,生成与原视频配音高度相似的语音,保持情感和语调的连贯性。这一功能通过CosyVoice和XTTS等先进语音合成技术实现,能够捕捉原声音的独特特征,如音调、节奏和情感表达。

声音克隆过程包括三个关键步骤:

声学特征提取:分析原始语音的音高、音色、节奏等特征。

语音模型适配:根据提取的特征调整语音合成模型参数。

目标语言合成:使用适配后的模型生成目标语言的语音,保持原声音特点。

这种高度定制化的语音合成方式,使得翻译后的视频不仅语言不同,连"声音"也能保持一致性,大大提升了观众的沉浸感和接受度。例如,一位知名讲师的中文讲座可以被翻译成英文,同时保留其独特的语音风格,让国际学生感觉就像在听原讲师亲自用英语授课一样。

5. 数字人对口型技术

Linly-Dubbing通过对口型技术,使配音与视频画面高度契合,提升真实性和互动性。这项功能借鉴了Linly-Talker的数字人唇同步技术,结合计算机视觉和语音识别,将虚拟角色的唇部运动与配音精确匹配。

口型同步技术的工作流程包括:

语音分析:识别语音中的音素(语音最小单位)及其时间位置。

唇形映射:将音素序列映射到对应的口型参数。

面部渲染:调整视频中人物的唇部形状,使其与配音匹配。

自然度优化:添加细微的面部表情和动作,增强真实感。

这项技术特别适用于动画人物、虚拟主播、教育视频中的旁白等多种场景。虽然目前的版本在对口型的精确度上还有提升空间,但已经能够显著提高翻译视频的专业度和观赏体验。

6. 灵活上传与翻译

用户可以上传视频,自主选择翻译语言和标准,确保个性化和灵活性。Linly-Dubbing支持多种视频输入方式:

本地视频文件上传

通过yt-dlp从YouTube、B站等平台下载视频

提供视频URL直接处理

在翻译标准方面,用户可以根据内容类型选择不同的翻译风格,如:

字面翻译:适合技术文档、学术内容

意译:适合娱乐内容、社交媒体视频

本地化翻译:考虑文化差异的深度适配

此外,用户还可以调整配音的声音特征(如性别、年龄、语调)和字幕样式,真正实现个性化的视频本地化。

7. 视频处理增强功能

除了核心的翻译配音功能外,Linly-Dubbing还提供了一系列视频处理增强功能,使用户能够进一步优化视频内容:

添加字幕:支持多种字幕格式和样式自定义

插入背景音乐:丰富视频的听觉体验

调节音量:平衡原声、配音和背景音乐的音量

调整播放速度:加快或放慢视频节奏

人声分离:使用UVR5技术分离人声和背景音乐

这些增强功能使得Linly-Dubbing不仅是一个翻译工具,更是一个全面的视频后期处理解决方案。用户可以根据创作需求,自由组合这些功能,制作出专业水准的多语言视频内容。

8. 定期更新与模型优化

Linly-Dubbing团队持续引入最新模型,保持配音和翻译的领先地位。项目采用了模块化架构,核心组件如语音识别、翻译引擎、语音合成等都可以独立更新,确保始终使用最先进的AI技术。

项目维护者积极跟踪AI领域的最新进展,定期集成以下更新:

更准确高效的语音识别模型

更自然流畅的语音合成引擎

支持更多语言和方言

改进的口型同步算法

性能优化和bug修复

这种持续的更新机制确保了Linly-Dubbing能够跟上AI技术的快速发展步伐,为用户提供始终如一的优质体验。

表:Linly-Dubbing核心技术栈

| 技术类别 | 具体技术/模型 | 功能描述 |

|---|---|---|

| 语音识别 | WhisperX、FunASR | 高精度语音转文字,支持多说话人识别 |

| 语音合成 | Edge TTS、XTTS、CosyVoice | 自然语音生成,支持声音克隆 |

| 翻译引擎 | OpenAI API、Qwen | 高质量多语言翻译 |

| 视频处理 | ffmpeg、UVR5 | 视频编解码、人声分离 |

| 口型同步 | Linly-Talker技术 | 使配音与视频人物口型匹配 |

| 大语言模型 | GPT、ERNIE Bot | 提供上下文感知的智能翻译 |

三、应用场景

1. 国际教育

教育机构可以利用Linly-Dubbing将教学视频翻译成多种语言,帮助学生更好地理解课程内容。在全球化的教育环境中,语言差异常常成为知识传播的障碍。Linly-Dubbing能够将优质的教育资源快速本地化,惠及更广泛的学生群体。

具体应用包括:

大学将名师讲座翻译成多种语言,供国际学生使用

在线教育平台提供多语言版本的课程,扩大受众范围

培训机构为不同地区的学员准备本地化教材

教育非营利组织将教育资源翻译成小语种,服务边缘化社区

Linly-Dubbing的声音克隆功能特别适合教育场景,可以保持原讲师的声音特征,让学生感受到一致的授课风格。同时,其准确的字幕生成功能也有助于听力障碍学生更好地理解内容。

2. 全球娱乐内容本地化

影视制作公司和内容创作者可以使用该工具将电影、动画或短视频翻译成目标语言,扩大作品的国际影响力。娱乐内容是全球化程度最高的领域之一,但语言障碍仍然是制约作品传播的重要因素。

Linly-Dubbing在这一场景下的应用包括:

独立制片人将短片作品翻译参加国际电影节

动画工作室为作品制作多语言配音版本

网络剧制作方快速推出不同语言版本,满足全球粉丝需求

自媒体创作者扩大内容受众,增加国际粉丝群体

与专业配音相比,Linly-Dubbing虽然音质尚有差距,但其低成本、高效率的特点非常适合预算有限或需要快速本地化的项目。特别是其口型同步技术,能够显著提升配音版作品的观赏体验。

3. 企业培训与推广

企业可以通过Linly-Dubbing提供多语言演讲和宣传材料,提高国际市场沟通效率。在全球化经营中,企业需要与不同国家和地区的员工、客户、合作伙伴沟通,多语言视频材料成为必不可少的工具。

具体应用场景:

跨国公司为全球员工统一培训材料的本地化

产品发布会视频的多语言版本制作

企业宣传片的国际化适配

技术产品的使用说明和教程翻译

上市公司财报视频的多语言版本

企业用户特别看重Linly-Dubbing的专业术语翻译准确性和语音合成的专业感。项目支持自定义术语库和翻译风格,能够满足企业品牌一致性的要求。

4. 社交媒体与内容创作

内容创作者可以快速制作多语言视频,扩大受众范围并增强互动性。在社交媒体时代,内容的多语言能力直接影响传播范围和影响力。Linly-Dubbing为个人创作者提供了原本只有大型制作公司才能拥有的本地化能力。

典型使用场景:

YouTuber为视频添加多语言字幕和配音

TikTok创作者制作多语言版本的内容

播客节目提供多语言转录和配音

知识分享者将内容本地化到不同市场

跨境电商制作多语言产品介绍视频

对于个人创作者而言,Linly-Dubbing的易用性和低成本尤为宝贵。它大大降低了内容国际化的门槛,使个人创作者也能触达全球受众。

5. 无障碍访问

Linly-Dubbing的视频处理功能可以帮助视听障碍人士更好地获取视频内容。通过生成高质量的字幕和语音描述,使视频内容对特殊需求群体更加友好。

无障碍应用包括:

为听力障碍者生成准确的字幕

为视力障碍者生成详细的音频描述

调整视频播放速度,方便不同学习能力的人群

提供清晰度高、对比度强的字幕选项

这一应用场景体现了技术的社会价值,使信息获取更加平等和包容。Linly-Dubbing的开发者也在持续优化其无障碍功能,如改进字幕的时序准确性和朗读的自然度。

表:Linly-Dubbing在不同场景中的应用方式

| 应用场景 | 主要用户群体 | 使用的核心功能 | 价值体现 |

|---|---|---|---|

| 国际教育 | 教育机构、教师、学生 | 语音识别、翻译、声音克隆 | 打破语言障碍,共享教育资源 |

| 娱乐本地化 | 影视公司、动画工作室、自媒体 | 口型同步、多语言配音 | 降低本地化成本,加快发行速度 |

| 企业传播 | 跨国公司、市场营销部门 | 术语准确翻译、专业语音合成 | 统一全球品牌形象,提高沟通效率 |

| 社交媒体 | YouTuber、TikTok创作者、博主 | 快速字幕生成、简易配音 | 扩大受众范围,增加内容影响力 |

| 无障碍访问 | 残障组织、公共服务机构 | 字幕生成、语音描述 | 促进信息平等,实现社会包容 |

四、使用方法

1. 安装与配置

1.1 环境要求

Linly-Dubbing主要基于Python开发,需要在具备适当硬件配置的系统上运行。以下是推荐的系统环境:

硬件要求:

NVIDIA显卡(建议RTX 3060或更高,显存8GB以上)

16GB以上系统内存

足够的存储空间(至少20GB用于模型和临时文件)

软件要求:

操作系统:Ubuntu 22.04 LTS(推荐)或Windows 10/11 64位

Python 3.10

CUDA 11.8或12.1(与显卡驱动匹配)

PyTorch 2.3.1

ffmpeg

对于Windows用户,如果不想手动配置环境,可以使用预编译的一键包版本(下载链接: https://pan.quark.cn/s/6808403e21d6 )。一键包版本已经包含了所有必要的依赖和模型,解压后即可使用。

1.2 安装步骤

对于希望从源代码安装的用户,以下是详细的安装步骤:

克隆项目仓库:

git clone https://github.com/Kedreamix/Linly-Dubbing.git --depth 1 cd Linly-Dubbing git submodule update --init --recursive

创建Python虚拟环境:

conda create -n linly_dubbing python=3.10 -y conda activate linly_dubbing

安装PyTorch(根据CUDA版本选择):

CUDA 11.8:

pip install torch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 --index-url https://download.pytorch.org/whl/cu118

CUDA 12.1:

pip install torch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 --index-url https://download.pytorch.org/whl/cu121

安装其他依赖:

conda install ffmpeg pynini -c conda-forge pip install -r requirements.txt pip install -r requirements_module.txt

下载预训练模型:

bash scripts/download_models.sh # Linux python scripts/modelscope_download.py # Windows

配置环境变量: 将项目根目录下的

env.example文件重命名为.env,并填写必要的API密钥:OPENAI_API_KEY=sk-xxx # 你的OpenAI API密钥 MODEL_NAME=gpt-4 # 或gpt-3.5-turbo HF_TOKEN=xxx # Hugging Face API令牌

1.3 常见安装问题解决

在安装过程中可能会遇到一些常见问题,以下是解决方案:

libcudnn_ops_infer.so.8错误:

export LD_LIBRARY_PATH=$(python3 -c 'import os; import torch; print(os.path.dirname(os.path.dirname(torch.__file__))+"/lib")'):$LD_LIBRARY_PATH

国内用户加速安装:

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

模型下载缓慢: 可以手动从Hugging Face或ModelScope下载模型,放到指定目录。

2. 基本使用流程

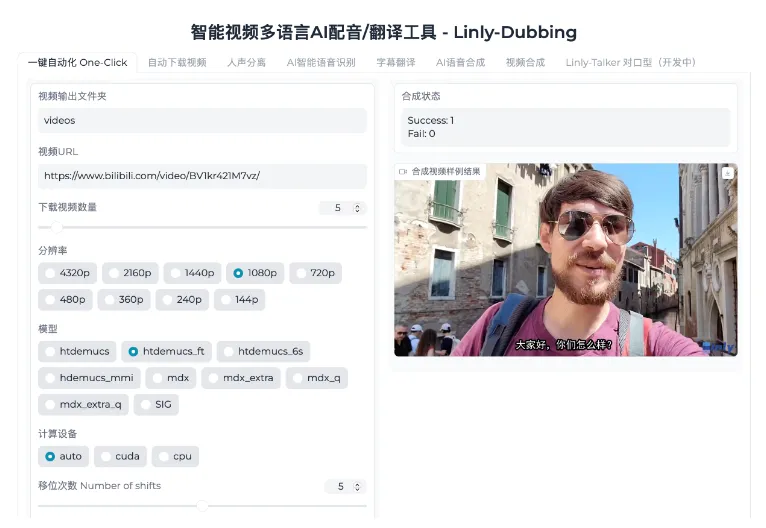

安装完成后,可以通过以下步骤使用Linly-Dubbing进行视频翻译和配音:

启动Web界面:

python webui.py

启动后,在浏览器中访问

http://127.0.0.1:6006。输入视频来源:

上传本地视频文件

或输入视频URL(支持YouTube、B站等)

选择翻译语言: 设置源语言和目标语言,如中文→英文。

配置处理参数:

ASR模型选择(Whisper或FunASR)

翻译引擎(OpenAI、Qwen或Bing)

语音合成方法(Edge TTS、XTTS或CosyVoice)

分辨率设置

其他高级选项

提交处理: 点击"Submit"按钮开始处理,等待完成。

获取结果: 处理完成后,翻译配音的视频会保存在

./video目录下。

3. 参数配置详解

Linly-Dubbing提供了丰富的参数配置选项,以满足不同用户的需求。以下是主要参数的详细说明:

视频URL:

使用yt-dlp支持国内外主流视频平台

国外平台可能需要科学上网

计算设备:

默认使用GPU(cuda)

无显卡时可选择CPU,但速度很慢

ASR模型选择:

openai-whisper:英文识别效果好

阿里FunASR:中文优化,支持多人对话

Whisper模型大小:

large:识别效果好,需要大显存

small/base/tiny:显存需求小,适合低配设备

说话人分离:

多人视频需设置说话人数

单人视频选择"none"

翻译方式:

LLM(OpenAI/Qwen):质量高但可能需要API

Bing Translate:国内稳定可用

Google翻译:需要科学上网

AI语音生成:

Edge TTS:速度快,质量一般

XTTS:平衡质量与速度

CosyVoice:质量最高,支持声音克隆

分辨率:

根据原视频质量和需求设置

高分辨率需要更多显存和处理时间

4. 云端使用方案

对于没有合适本地设备的用户,Linly-Dubbing也支持在云端运行。以下是基于算力云平台的部署示例:

创建云实例:

选择配备至少2张RTX 3060 GPU的主机

使用Ubuntu 22.04镜像

安装依赖:

sudo apt update sudo apt install -y git python3-pip ffmpeg

按照前述步骤安装Linly-Dubbing

启动Web服务:

python webui.py --share # 生成公开访问链接

此外,项目还提供了Google Colab脚本,可以在线体验基本功能。Colab版本虽然功能有限,但无需任何本地配置,适合快速体验和简单任务。

五、常见问题解答

在使用Linly-Dubbing过程中,用户可能会遇到各种技术和使用问题。本节将针对最常见的问题提供解答和解决方案。

1. 安装与配置问题

Q1:安装过程中出现CUDA或cuDNN相关错误怎么办?

A1:这通常是由于CUDA环境配置不正确导致的。请确保:

安装了与显卡驱动兼容的CUDA版本

安装了对应版本的cuDNN

环境变量PATH和LD_LIBRARY_PATH包含CUDA相关路径

PyTorch版本与CUDA版本匹配

Q2:模型下载非常慢或失败怎么办?

A2:国内用户可能会遇到模型下载问题,可以尝试:

使用modelscope源:

export USE_MODELSCOPE=True手动下载模型并放到指定目录

使用代理或VPN加速下载

Q3:运行时显存不足怎么办?

A3:可以尝试以下优化:

使用更小的Whisper模型(如small而非large)

降低视频处理分辨率

关闭不必要的功能如说话人分离

增加系统交换空间作为临时解决方案

2. 功能使用问题

Q4:翻译质量不理想怎么办?

A4:翻译质量受多种因素影响,可以尝试:

更换翻译引擎(如从Bing切换到OpenAI)

检查源语音识别是否准确

提供术语表或上下文提示

对专业内容,先进行机器翻译后人工校对

Q5:配音口型同步效果不佳怎么办?

A5:口型同步是较复杂的功能,当前版本可能存在局限。可以尝试:

确保原视频人物面部清晰可见

选择正脸角度较多的视频

调整口型同步强度参数

对要求高的项目,考虑后期手动调整

Q6:如何处理多人对话的视频?

A6:对于多人对话场景:

在ASR模型中选择FunASR,它对多人对话支持更好

正确设置说话人数

如需要区分说话人,启用说话人分离功能

可以为不同说话人分配不同的配音音色

3. 性能与优化问题

Q7:处理速度很慢怎么办?

A7:处理速度取决于硬件配置和参数设置,优化建议:

使用性能更好的GPU

降低视频分辨率

选择更小的模型(如Whisper small)

关闭实时预览功能

批量处理时合理安排任务顺序

Q8:如何减少API调用成本?

A8:如果使用OpenAI等付费API,可以:

缓存翻译结果避免重复请求

对长视频先分段再翻译

使用本地模型如Qwen替代

设置API使用限额

考虑使用微软Bing等免费选项

Q9:生成的视频文件太大怎么办?

A9:视频体积优化方法:

输出时选择更高的压缩率

降低输出视频分辨率

减少视频帧率(如从30fps降到24fps)

使用外部工具如HandBrake二次压缩

表:Linly-Dubbing常见问题速查指南

| 问题类型 | 常见症状 | 解决方案 | 参考文档 |

|---|---|---|---|

| 安装失败 | CUDA错误、依赖缺失 | 检查环境匹配,使用conda管理 | |

| 运行缓慢 | 处理时间长,GPU满载 | 降低模型大小,优化参数 | |

| 翻译质量差 | 语句不通,术语错误 | 更换翻译引擎,提供上下文 | |

| 口型不同步 | 唇形与语音不匹配 | 调整参数,选择合适视频 | |

| 显存不足 | 内存错误,进程终止 | 减小模型,降低分辨率 | |

| API限制 | 请求失败,费用高 | 使用本地模型,设置限额 |

六、相关链接

七、总结

Linly-Dubbing作为一款开源的多语言AI视频配音和翻译工具,通过整合WhisperX、FunASR、Edge TTS、XTTS、CosyVoice以及OpenAI API和Qwen大模型等先进技术,为用户提供了从视频下载、语音识别、字幕翻译、声音克隆到口型同步的一站式解决方案。该项目不仅支持多种语言的互译,还能保持原视频的声音特征和情感表达,通过数字人唇同步技术增强配音的真实感,在教育、娱乐、企业传播和社交媒体等多个领域展现出广泛的应用价值。虽然在对口型精确度和语音自然度方面仍有提升空间,但其开箱即用的特性、模块化设计和持续更新的技术栈,使其成为视频内容本地化和国际化的高效工具,大大降低了多语言视频制作的技术门槛和成本。无论是技术开发者还是普通用户,都能通过详细的文档和社区支持,快速掌握Linly-Dubbing的使用方法,实现视频内容的全球化传播和跨文化交流。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/linly-dubbing.html