LLaSO:开源语音 - 语言建模框架,端到端整合数据、评估与建模能力

一、LLaSO是什么

LLaSO是一个面向大规模语音-语言建模研究的开源框架,该框架以端到端的方式整合了数据资源、评估基准和建模工具,旨在为语音-语言交叉领域的研究提供标准化、可复现的基础平台。与传统单一模态或简单跨模态模型不同,LLaSO专注于解决语音与语言深度融合的技术挑战,支持"语音-文本"双向理解与生成任务。其核心目标是打破模态壁垒,实现对语音信号中语言内容、语义情感和副语言信息的全面建模,同时保持开源生态的开放性和研究的可复现性。

作为一个综合性研究框架,LLaSO不仅提供预训练模型和数据集,更建立了完整的技术栈,涵盖从数据处理、模型训练到性能评估的全流程工具链,使研究者能够在统一标准下进行算法比较和创新开发。

二、功能特色

LLaSO的核心优势体现在其全面性、标准化和易用性三个维度,具体功能特色如下:

1. 多模态数据生态系统

LLaSO构建了目前规模领先的语音-语言对齐数据集体系,包含三个核心数据集:

| 数据集名称 | 样本规模 | 核心功能 | 数据特点 |

|---|---|---|---|

| LLaSO-Align | 1200万样本 | 语音-文本基础对齐 | 基于ASR技术构建,覆盖16种语言,包含多样说话人、口音和场景 |

| LLaSO-Instruct | 1350万样本 | 多任务指令微调 | 涵盖20个任务类型,支持3种模态配置(文本+音频、音频+文本、纯音频) |

| LLaSO-Eval | 15,044样本 | 模型性能评估 | 分层设计,包含基础能力、指令遵循、跨模态泛化等评估维度 |

这种数据体系实现了从基础对齐到任务微调再到系统评估的完整闭环,为模型训练提供了高质量、多样化的数据源。

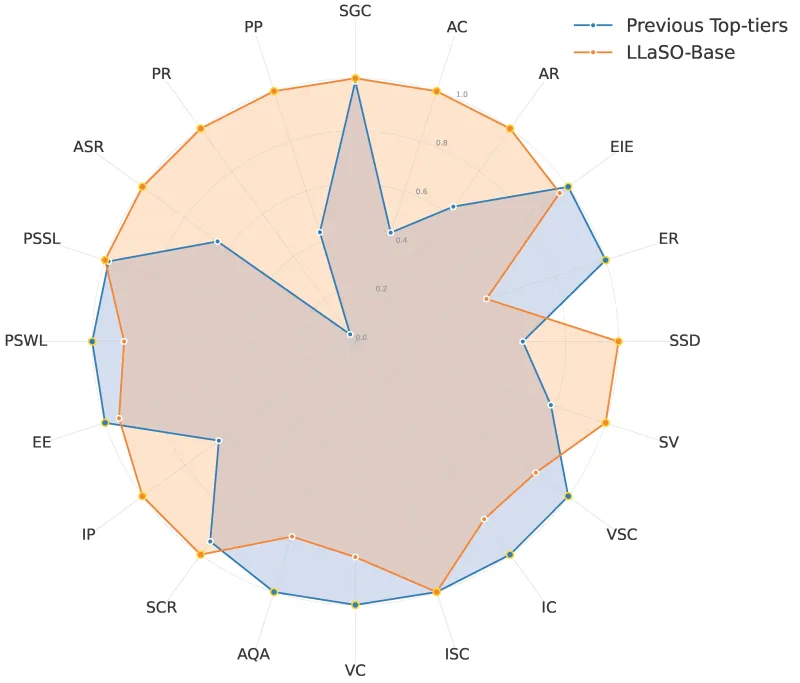

2. 标准化评估框架

LLaSO-Eval采用分层评估设计,突破了传统评估方法的局限性:

基础能力层:评估语音识别准确率、文本理解准确率等基础指标

任务表现层:针对20个具体任务(如情感识别、语音摘要、指令跟随等)进行专项评估

泛化能力层:测试模型在未见过的任务类型、语言或声学环境中的表现

稳健性层:评估模型对噪声、口音变异、指令模糊性的耐受能力

评估框架还创新性地引入"弃权率"指标,衡量模型在无法准确回答时主动放弃的能力,更贴近实际应用场景的需求。

3. 高效可扩展的模型架构

LLaSO-Base参考模型(3.8B参数)采用两阶段训练策略:

预训练阶段:通过LLaSO-Align数据进行语音-文本对齐训练,建立跨模态语义关联

微调阶段:使用LLaSO-Instruct数据进行多任务指令微调,增强任务适应性

模型架构基于LLaVA风格进行改进,采用分离的语音编码器与语言模型,通过交叉注意力机制实现模态融合,既保持了各模态的建模专业性,又实现了高效的信息交互。

4. 完全开源与可复现性

LLaSO践行开源研究理念,所有组件均完全开放:

完整的数据集可直接下载使用

模型训练代码、配置文件和日志完全公开

评估指标和基准测试结果透明可查

提供详细的复现指南,确保研究结果可验证

这种开放性有效解决了语音-语言研究领域中数据封闭、实验不可复现的痛点问题。

5. 多场景适应性

框架支持多种模态交互模式,包括:

语音到文本(如语音转写、语音翻译)

文本到语音(如文本引导的语音生成、情感语音合成)

语音到语音(如语音风格转换、语音摘要)

跨模态理解(如基于语音的情感分析、语义检索)

通过统一的框架支持多样化交互模式,大大降低了跨模态应用开发的门槛。

三、技术细节

1. 数据构建技术

LLaSO-Align数据构建流程

LLaSO-Align作为基础对齐数据集,采用了多源数据融合与精准对齐技术:

数据源:整合了公开语音语料(如LibriSpeech、CommonVoice)和专有标注数据,覆盖16种语言

对齐方法:使用Whisper-large-v3作为基础ASR模型生成文本候选,再通过双向解码和动态时间规整(DTW)实现语音片段与文本单元的精确对齐

质量控制:采用三级过滤机制(ASR置信度过滤、语言模型一致性检查、人工抽样验证),确保对齐错误率低于5%

数据集包含丰富的元数据,如说话人ID、性别、年龄范围、口音标签、录制环境等,为模型训练提供了全面的语境信息。

LLaSO-Instruct任务设计

LLaSO-Instruct的1350万样本分布在20个任务类型中,主要包括:

| 任务类别 | 具体任务 | 样本量 | 模态配置 |

|---|---|---|---|

| 语音理解 | 语音转写、语音翻译、情感识别 | 350万 | 音频→文本 |

| 语音生成 | 文本转语音、语音风格迁移 | 280万 | 文本→音频 |

| 跨模态推理 | 语音问答、语音摘要、指令跟随 | 420万 | 混合模态 |

| 副语言分析 | 说话人识别、情绪强度估计 | 300万 | 音频→文本 |

每个任务的指令都经过精心设计,包含明确的输入输出描述和示例,使模型能够理解任务意图并生成符合要求的结果。

2. 模型架构详解

LLaSO-Base模型采用模块化设计,主要包含以下组件:

语音编码器

基于改进的ResNet架构,包含12个卷积块

采用分组卷积和深度可分离卷积减少参数数量

引入注意力池化层,增强对长时语音特征的捕捉能力

输出维度为768,与语言模型输入维度匹配

语言模型

基于Llama-3.2-3B-Instruct架构进行适配

包含32个Transformer层,隐藏层维度为3072

采用RoPE位置编码,支持最长4096 tokens的上下文

针对语音-文本交互优化了注意力掩码机制

跨模态融合模块

位于语音编码器和语言模型之间的交叉注意力层

采用双向注意力机制,实现语音特征与文本特征的双向交互

引入模态门控机制,动态调整两种模态信息的融合比例

支持可变长度的语音输入(最长30秒)和文本输入

3. 训练策略

LLaSO模型训练采用两阶段策略,兼顾基础能力与任务适应性:

第一阶段:对齐预训练

目标:建立语音与文本的基础语义关联

训练数据:LLaSO-Align的1200万样本

训练任务:

语音-文本对比学习(最大化匹配对的相似度)

语音条件下的文本补全

文本条件下的语音特征重建

优化器:AdamW,学习率5e-5,权重衰减0.01

训练周期:10个epoch,采用混合精度训练

第二阶段:指令微调

目标:增强模型对具体任务的理解和执行能力

训练数据:LLaSO-Instruct的1350万样本

训练方式:

采用指令跟随格式(输入指令+模态数据→输出结果)

按任务类型动态采样,确保各任务训练均衡

使用LoRA(Low-Rank Adaptation)技术进行参数高效微调

优化器:AdamW,学习率2e-5,权重衰减0.001

训练周期:3个epoch,采用梯度累积提升训练稳定性

4. 评估方法

LLaSO-Eval采用多维评估体系,确保对模型能力的全面衡量:

自动评估指标

语音转写:词错误率(WER)、字符错误率(CER)

翻译质量:BLEU、CHRF、TER

生成质量:BLEU、ROUGE-L、CIDEr

分类任务:准确率、F1分数、混淆矩阵

人工评估维度

内容准确性:生成结果与输入信息的一致性

指令遵循度:对任务要求的满足程度

自然度:生成语音/文本的流畅自然程度

鲁棒性:在噪声/干扰条件下的表现稳定性

特殊评估设计

跨语言泛化测试:在训练未见过的语言上的表现

噪声鲁棒性测试:在不同信噪比(-10dB到20dB)下的性能变化

歧义指令处理:对模糊或矛盾指令的理解能力

弃权能力评估:模型识别超出自身能力范围任务的准确率

四、应用场景

LLaSO框架凭借其强大的跨模态处理能力,可应用于多个实际场景:

1. 智能语音助手

传统语音助手往往局限于简单指令识别和响应,而基于LLaSO的语音助手能够:

理解复杂语音指令(包含条件、逻辑关系)

识别说话人的情感状态并调整回应方式

处理跨模态请求(如"描述这段语音中的情绪并写成报告")

在无法明确理解时主动询问澄清,而非盲目响应

应用实例:智能客服系统可通过LLaSO实现对客户语音咨询的深层理解,不仅识别文字内容,还能捕捉情绪变化,提供更人性化的服务。

2. 语音内容分析与处理

在媒体制作、内容审核等领域,LLaSO可提供全方位的语音内容处理能力:

自动生成会议录音的结构化摘要(包含决策点、行动项)

分析广播/播客内容的情感倾向和观点分布

对多语言语音内容进行实时转写和翻译

识别语音中的副语言信息(如欺骗检测、压力分析)

应用实例:新闻媒体可利用LLaSO快速处理采访录音,自动提取关键信息并生成多语言版本的新闻稿件。

3. 无障碍沟通辅助

LLaSO在无障碍领域有重要应用价值:

为听障人士提供实时语音转写和场景理解服务

为语言障碍人士提供文本到自然语音的转换,支持情感表达

实现不同语言使用者之间的实时语音翻译沟通

帮助认知障碍者理解复杂语音指令,简化为步骤化指引

应用实例:在医疗场景中,LLaSO可帮助医生与听力障碍患者进行有效沟通,准确捕捉患者描述的症状和感受。

4. 教育与培训

在教育领域,LLaSO的跨模态能力可支持创新教学模式:

语言学习:提供发音评估、语调分析和实时纠错

演讲训练:分析语音表达的清晰度、情感传递和说服力

内容理解:帮助学生处理讲座录音,生成结构化笔记和重点提示

个性化教学:根据学生的语音反馈调整教学内容和节奏

应用实例:语言学习App可利用LLaSO评估学习者的发音准确性,并提供针对性改进建议,包括语调、重音等细节指导。

5. 安全与监控

LLaSO的语音分析能力可应用于安全领域:

公共场合异常声音检测(如呼救、争吵、玻璃破碎)

电话欺诈识别(基于语音特征和内容分析)

作业人员状态监测(如通过语音特征检测疲劳、压力)

多语言安全指令识别与响应

应用实例:在智慧安防系统中,LLaSO可实时分析监控区域的语音信息,快速识别潜在安全隐患并触发相应警报。

五、使用方法

1. 环境配置

系统要求

操作系统:Linux (Ubuntu 20.04+ 推荐)

内存:至少32GB(模型训练需128GB以上)

GPU:支持CUDA 11.7+的NVIDIA显卡(推理至少8GB显存,训练需24GB以上)

存储:至少100GB可用空间(数据集完整下载需5TB以上)

安装步骤

# 克隆仓库 git clone https://github.com/EIT-NLP/LLaSO.git cd LLaSO # 创建并激活虚拟环境 conda create -n llaso python=3.10 -y conda activate llaso # 安装基础依赖 pip install --upgrade pip pip install -e . pip install librosa==0.10.2.post1 # 安装训练所需额外依赖 pip install -e ".[train]" # 安装FlashAttention加速库(可选但推荐) MAX_JOBS=8 pip install -v flash-attn --no-build-isolation # 安装评估工具 pip install -e ".[eval]"

2. 数据获取与准备

数据集下载

LLaSO数据集可通过Hugging Face Hub获取:

# 安装Hugging Face Hub工具 pip install huggingface-hub # 登录(需要Hugging Face账号并接受数据集使用协议) huggingface-cli login # 下载LLaSO-Align(示例,完整下载需指定所有分块) mkdir -p data/align cd data/align git clone https://huggingface.co/datasets/EIT-NLP/LLaSO-Align # 下载LLaSO-Instruct mkdir -p ../instruct cd ../instruct git clone https://huggingface.co/datasets/EIT-NLP/LLaSO-Instruct # 下载LLaSO-Eval mkdir -p ../eval cd ../eval git clone https://huggingface.co/datasets/EIT-NLP/LLaSO-Eval

数据预处理

下载完成后,运行预处理脚本生成训练所需格式:

# 预处理对齐数据 python scripts/preprocess_align.py \ --input_dir data/align/LLaSO-Align \ --output_dir data/processed/align \ --num_workers 16 # 预处理指令数据 python scripts/preprocess_instruct.py \ --input_dir data/instruct/LLaSO-Instruct \ --output_dir data/processed/instruct \ --num_workers 16

3. 模型使用

加载预训练模型

LLaSO提供预训练模型 checkpoint,可直接用于推理:

from llaso import LLaSOModel, LLaSOProcessor

# 加载模型和处理器

processor = LLaSOProcessor.from_pretrained("EIT-NLP/LLaSO-Base")

model = LLaSOModel.from_pretrained("EIT-NLP/LLaSO-Base")

# 准备输入(语音文件路径)

audio_path = "example.wav"

# 语音转文本示例

inputs = processor(audio=audio_path, return_tensors="pt")

outputs = model.generate(**inputs, max_new_tokens=100)

transcription = processor.decode(outputs[0], skip_special_tokens=True)

print("Transcription:", transcription)

# 语音问答示例

question = "这段语音表达了什么情绪?"

inputs = processor(audio=audio_path, text=question, return_tensors="pt")

outputs = model.generate(** inputs, max_new_tokens=50)

answer = processor.decode(outputs[0], skip_special_tokens=True)

print("Answer:", answer)模型训练

使用提供的训练脚本进行模型训练:

# 第一阶段:对齐预训练 python train.py \ --config configs/align_pretrain.yaml \ --data_dir data/processed/align \ --output_dir checkpoints/align_pretrain \ --batch_size 32 \ --num_epochs 10 \ --logging_steps 100 \ --save_steps 1000 # 第二阶段:指令微调 python train.py \ --config configs/instruct_finetune.yaml \ --data_dir data/processed/instruct \ --output_dir checkpoints/instruct_finetune \ --pretrained_model checkpoints/align_pretrain \ --batch_size 16 \ --num_epochs 3 \ --logging_steps 50 \ --save_steps 500

4. 模型评估

使用LLaSO-Eval进行模型评估:

# 运行完整评估套件 python evaluate.py \ --model_path checkpoints/instruct_finetune \ --eval_data_dir data/eval/LLaSO-Eval \ --output_dir results/ \ --task all \ --batch_size 8 # 运行特定任务评估(如语音情感识别) python evaluate.py \ --model_path checkpoints/instruct_finetune \ --eval_data_dir data/eval/LLaSO-Eval \ --output_dir results/sentiment/ \ --task sentiment_recognition \ --batch_size 16

评估完成后,会在输出目录生成详细的评估报告(JSON和HTML格式),包含各任务的性能指标和对比分析。

六、常见问题解答

1. 硬件资源相关

Q: 运行LLaSO模型需要什么样的GPU配置?

A: 推理任务最低要求8GB显存的NVIDIA GPU(如RTX 3090),推荐使用16GB以上显存的GPU以获得更好性能。训练任务则需要至少24GB显存(如RTX 4090),完整训练3.8B参数模型建议使用8张A100(80GB)GPU。

Q: 没有高性能GPU可以使用LLaSO吗?

A: 可以。LLaSO支持CPU推理,但速度会显著降低。此外,可通过Hugging Face Inference API使用云端资源,或使用模型量化技术(如4-bit量化)降低显存需求,代价是可能损失少量性能。

2. 数据相关

Q: LLaSO数据集包含哪些语言?是否支持中文?

A: LLaSO-Align包含16种语言,包括英语、中文(普通话)、西班牙语、法语、德语等主要语言。LLaSO-Instruct和LLaSO-Eval对中文有专门优化,包含约10%的中文样本,支持中文语音-文本交互任务。

Q: 如何获取完整的LLaSO数据集?

A: 所有数据集均托管在Hugging Face Hub上,需注册Hugging Face账号并接受各数据集的使用协议。由于数据集规模较大(总大小约5TB),建议使用aria2等工具进行多线程下载,并确保有足够的存储空间。

Q: 可以使用自定义数据训练LLaSO模型吗?

A: 可以。LLaSO提供数据预处理工具,支持将自定义的语音-文本数据转换为训练所需格式。只需按照文档中"数据格式规范"准备数据,并修改配置文件指向自定义数据路径即可。

3. 模型使用相关

Q: LLaSO模型支持多长的语音输入?

A: 默认配置下,LLaSO支持最长30秒的语音输入。通过修改模型配置文件中的"max_audio_length"参数,可以调整支持的语音长度,但过长的输入可能导致性能下降和显存占用增加。

Q: 如何将LLaSO集成到现有应用中?

A: LLaSO提供Python API,可直接集成到Python应用中。对于其他语言应用,可通过REST API封装(项目提供FastAPI示例)进行集成。此外,也可将模型导出为ONNX格式,提高部署效率。

Q: 模型在低资源语言上的表现如何?

A: LLaSO在高资源语言(如英语、中文)上表现最佳。对于低资源语言,性能会有所下降,但通过在自定义低资源数据上进行微调,可以显著提升模型在特定语言上的表现。

4. 训练相关

Q: 完整训练LLaSO-Base模型需要多长时间?

A: 取决于硬件配置。使用8张A100(80GB)GPU,第一阶段对齐预训练约需7-10天,第二阶段指令微调节约需3-5天。使用较少GPU或显存较小的设备,训练时间会相应增加。

Q: 训练过程中出现显存不足怎么办?

A: 可采取以下措施:降低批次大小(batch_size)、启用梯度累积、使用更小的模型配置、启用混合精度训练(已默认开启)、使用梯度检查点技术(会增加训练时间)。配置文件中提供了"gradient_checkpointing"选项可直接开启。

Q: 如何在自定义任务上微调LLaSO模型?

A: 只需按照LLaSO-Instruct的数据格式准备自定义任务数据(包含指令、输入和输出),然后使用微调脚本,指定预训练模型路径和自定义数据路径即可。建议使用LoRA技术进行参数高效微调,以减少计算资源需求。

5. 性能相关

Q: LLaSO模型与专门的语音识别模型(如Whisper)相比表现如何?

A: 在纯语音识别任务上,专门优化的Whisper模型可能在词错误率上略占优势。但LLaSO的优势在于跨模态理解能力,能够处理更复杂的语音-文本交互任务,而不仅仅是转写。

Q: 如何提高LLaSO模型在特定任务上的性能?

A: 建议在特定任务的高质量数据上进行额外微调;调整生成参数(如temperature、top_p)以适应任务需求;使用提示工程(prompt engineering)优化输入指令;对于语音生成任务,可调整语音合成相关参数。

七、相关官方链接

GitHub仓库:https://github.com/EIT-NLP/LLaSO

模型与数据集(Hugging Face):

LLaSO-Base模型:https://huggingface.co/YirongSun/LLaSO-Base-3.8B-Instruct

LLaSO-Align数据集:https://huggingface.co/datasets/YirongSun/LLaSO-Align

LLaSO-Instruct数据集:https://huggingface.co/datasets/YirongSun/LLaSO-Instruct

LLaSO-Eval数据集:https://huggingface.co/datasets/YirongSun/LLaSO-Eval

八、总结

LLaSO作为一个全面的开源语音-语言建模框架,通过整合1200万对齐样本、1350万指令微调样本和15,044评估样本,构建了从数据到模型再到评估的完整生态系统,为语音-语言交叉领域的研究提供了标准化平台。其创新的两阶段训练策略和分层评估体系,不仅实现了语音与文本的深度融合,也为模型性能的全面衡量提供了科学方法。无论是学术研究还是工业应用,LLaSO都以其开源性、可复现性和多场景适应性,为开发者和研究者提供了强大的工具支持,推动着语音-语言智能交互技术的发展与应用。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/llaso.html