Lynx:字节跳动开源高保真个性化视频生成模型

1. Lynx是什么?

Lynx是字节跳动Intelligent Creation团队开发的开源高保真个性化视频生成模型,基于Diffusion Transformer(DiT)架构,通过ID-adapter(身份保留)和Ref-adapter(空间细节增强)两大核心组件,实现从单张输入图像结合文本描述生成个性化视频的能力。项目提供Lynx-full(全量模型,高画质)和Lynx-lite(轻量模型,高效推理)两个版本,适配不同场景需求;支持24fps视频生成,在身份保留、动作自然度、文本匹配度等指标上表现优于多数同类模型,适用于内容创作、数字人、营销等领域,遵循Apache License 2.0协议,可商用且部署门槛低。

传统视频生成技术往往需要多帧图像、视频片段作为输入,且容易出现“身份漂移”(如生成人物视频时脸型/发型变化)或“细节模糊”(如物体纹理丢失)的问题。Lynx通过创新的技术设计解决了这些痛点:

基础架构:基于Diffusion Transformer(DiT) 模型——融合扩散模型(高保真图像生成能力)与Transformer(长序列建模能力)的优势,既能保证单帧画质,又能处理视频的时间连续性(多帧动态关联);

核心创新:引入轻量级双适配器(ID-adapter + Ref-adapter) ——无需修改基础模型参数,仅通过少量适配器参数实现“身份精准保留”和“空间细节增强”,兼顾性能与效率;

核心目标:让普通用户或开发者仅通过“一张图像+一段文本”,就能生成“主体身份不变、细节清晰、动作自然”的个性化视频,降低视频创作门槛。

Lynx的开发团队为字节跳动Intelligent Creation(智能创作)部门,该团队长期专注于AIGC(生成式人工智能)领域,在图像生成、视频合成、数字人等方向有深厚技术积累,此次开源Lynx旨在推动个性化视频生成技术的落地与行业协作。

2. 核心功能特色

Lynx的功能设计围绕“高保真”“个性化”“易用性”三大核心,通过双模型版本适配不同场景,具体特色如下:

2.1 双模型版本:兼顾画质与效率

Lynx提供两个独立模型版本,用户可根据需求选择,核心差异如下表所示:

| 对比维度 | Lynx-full(全量模型) | Lynx-lite(轻量模型) |

|---|---|---|

| 核心组件 | DiT基础模型 + ID-adapter + Ref-adapter | DiT基础模型 + ID-adapter(无Ref-adapter) |

| 帧率支持 | 最高24fps(支持自定义帧长) | 固定24fps(121帧,专为高效生成优化) |

| 参数规模 | 较大(含全部细节增强模块) | 较小(约为全量模型的60%,精简参数) |

| 显存占用 | 较高(需flash attention优化,建议16GB+显存) | 较低(无需flash attention,8GB显存可运行) |

| 生成速度 | 较慢(侧重画质,单视频约3-5分钟) | 较快(侧重效率,单视频约1-2分钟) |

| 核心优势 | 细节丰富、身份保留精准、视觉美感高 | 启动快、显存需求低、适合批量/快速生成 |

| 适用场景 | 专业内容创作(如自媒体短片、广告片) | 快速预览、设备性能有限场景(如轻量部署) |

2.2 身份精准保留:告别“身份漂移”

通过ID-adapter(身份适配器) 实现主体身份的稳定保留,这是Lynx最核心的特色之一。其原理是:

从输入图像中提取主体(如人物、特定物体)的“身份特征”(如面部轮廓、发型、肤色、物体形状);

将身份特征编码为适配向量,融入DiT模型的扩散生成过程;

在每帧视频生成时,通过ID-adapter约束生成结果与输入图像的身份特征一致性,避免“生成的人物变成其他人”“物体形状改变”等问题。

例如:上传一张“短发女性”的照片,生成“在咖啡馆看书”的视频,Lynx能确保视频中人物始终是“短发”,且面部特征与输入照片高度一致,不会出现“长发”“脸型变化”等身份漂移问题。

2.3 空间细节增强:细节清晰不模糊

通过Ref-adapter(参考适配器) 捕捉输入图像的空间细节信息,提升生成视频的细节丰富度。具体作用包括:

保留纹理特征:如输入图像中人物穿“条纹衬衫”,生成视频中衬衫条纹的样式、密度、颜色会与输入一致,不会出现“条纹模糊”“颜色偏移”;

还原边缘细节:如输入图像中“眼镜框是方形”,生成视频中眼镜框的形状、边角细节会精准还原;

匹配光影风格:如输入图像是“暖色调逆光场景”,生成视频的光影方向、色调风格会与输入统一,避免“光影混乱”。

2.4 灵活文本驱动:自然语言定义视频内容

Lynx支持通过自然语言提示词(Prompt) 定义视频的场景、动作、情绪,实现“文本控制内容”的个性化生成。支持的文本描述能力包括:

多步骤动作:如“先拿起杯子,再倒入咖啡,然后搅拌3次,最后喝一口”;

场景细节:如“在夜晚的阳台,背景有城市灯光,风吹动窗帘,桌上放着一本书”;

情绪与风格:如“人物面带微笑,视频风格为暖色调,画面柔和无噪点”。

同时,Lynx支持两种提示词输入方式:直接在命令行输入短文本,或从TXT文件读取长文本/批量提示词,适配不同使用场景(如单视频生成、批量生成)。

2.5 可复现推理:结果稳定可控

通过随机种子(--seed参数) 实现推理结果的可复现——相同的输入图像、提示词、种子值,每次运行都会生成完全相同的视频,方便开发者调试、优化效果。例如:使用seed=42生成“雕刻南瓜”的视频后,若需调整细节,可保持seed=42不变,仅修改提示词,确保其他效果(如人物身份、背景风格)与之前一致。

3. 技术细节

Lynx的技术架构围绕“基础模型+适配器+推理优化”三层设计,兼顾性能与易用性,具体细节如下:

3.1 技术架构拆解

(1)基础模型层:Diffusion Transformer(DiT)

DiT是Lynx的核心基础模型,由“扩散模型(Diffusion)”与“Transformer”结合而成,其优势在于:

扩散模型:擅长生成高保真图像,通过“逐步去噪”过程将随机噪声转化为清晰画面,能还原细腻的纹理和色彩;

Transformer:擅长建模长序列依赖关系,而视频是“多帧图像构成的时间序列”,Transformer能捕捉帧与帧之间的动态关联(如动作连贯性、光影变化连续性),避免视频出现“卡顿”“帧间不连贯”问题。

Lynx选用的DiT基础模型为Wan2.1-T2V-14B-Diffusers(从Wan-AI团队开源项目获取),该模型已预训练完成视频生成能力,Lynx在此基础上通过适配器进行微调,无需重新训练整个模型,大幅降低开发成本。

(2)适配器层:ID-adapter + Ref-adapter

适配器(Adapter)是Lynx的核心创新点,属于“参数高效微调(PEFT)”技术,仅通过少量参数(约占基础模型的5%)实现功能增强,无需修改基础模型权重,具体作用如下:

| 适配器类型 | 核心功能 | 技术原理 |

|---|---|---|

| ID-adapter | 身份保留 | 从输入图像中提取主体的身份特征(如通过CNN提取面部特征),编码为低维向量,融入DiT的注意力层,约束生成结果的身份一致性 |

| Ref-adapter | 空间细节增强 | 提取输入图像的空间特征(如边缘、纹理、光影),与DiT生成过程中的特征图融合,增强帧内细节的清晰度和一致性 |

(3)推理优化层:提升速度与兼容性

为降低部署门槛,Lynx在推理阶段做了两项关键优化:

flash attention加速:全量模型需安装flash attention(支持2.7.4.post1或3.0版本),该库通过优化内存访问模式,减少显存占用(约30%-50%),提升推理速度(约2倍)。例如:未使用flash attention时,全量模型生成121帧视频需5分钟,使用后仅需2-3分钟;

轻量模型精简:Lynx-lite去掉Ref-adapter,参数规模减少约40%,无需flash attention支持,8GB显存即可运行,同时保持基础的身份保留能力,适合设备性能有限的场景(如笔记本电脑、轻量服务器)。

3.2 核心技术指标

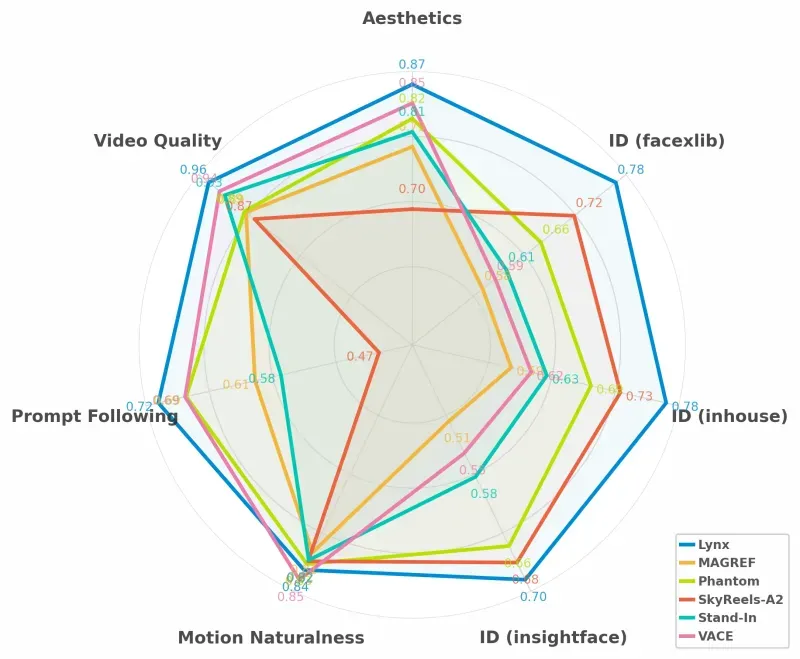

Lynx在公开测试中,多项核心指标优于同类模型(如MAGREF、Phantom、SkyReels-A2等),具体对比如下(数据来自项目官方文档):

| 评估指标 | 指标含义 | Lynx | MAGREF | Phantom | SkyReels-A2 | Stand-In |

|---|---|---|---|---|---|---|

| Video Quality ID(facexlib) | 身份保留质量(越高越好,满分1.0) | 0.96 | 0.78 | 0.70 | 0.72 | 0.66 |

| Motion Naturalness(insightface) | 动作自然度(越高越好,满分1.0) | 0.87 | 0.82 | 0.81 | - | - |

| Prompt Following | 文本匹配度(越高越符合提示词,满分1.0) | 0.72 | 0.51 | 0.50 | 0.58 | - |

| PD^(inhouse) | 细节丰富度(越高细节越清晰,满分1.0) | 0.66 | 0.69 | 0.61 | 0.58 | 0.67 |

| Aesthetics | 视觉美感(越高越符合人类审美,满分1.0) | 0.85 | 0.70 | - | - | - |

从表格可见,Lynx在身份保留(0.96)、动作自然度(0.87)、视觉美感(0.85)、文本匹配度(0.72) 四个关键指标上均处于领先地位,仅细节丰富度(PD^)略低于MAGREF,整体综合性能优势明显。

3.3 项目仓库结构

Lynx的仓库结构清晰,文件与文件夹分工明确,方便开发者理解和二次开发,具体如下:

| 文件夹/文件名称 | 核心作用 | 关键内容说明 |

|---|---|---|

| assets | 静态资源存储 | 存放项目示例图片、图标等,无代码逻辑,仅用于文档展示 |

| demo | 示例演示资源 |

含两个子文件夹: - subjects:示例输入图像(如demosubject.png,用于测试) - prompts:示例提示词文件(如demoprompt.txt) |

| modules | 模型核心组件 |

分三个子文件夹: - common:通用组件(如Resampler重采样器,适配不同分辨率) - full:Lynx-full专属组件(含Ref-adapter) - lite:Lynx-lite专属组件(无Ref-adapter) |

| utix | 工具函数库 |

提供基础工具支持: - 文件IO:读取图像/视频、保存生成结果 - 日志记录:打印推理过程日志 - 视频编码:将帧序列合成为MP4视频 |

| LICENSE | 开源许可证文件 | 记录Apache License 2.0的详细条款,明确商用权限、免责声明等 |

| README.md | 项目核心文档 | 含项目简介、安装步骤、使用方法、模型下载链接、引用格式等,是入门首要参考文档 |

| infer.py | 全量模型推理脚本 | 执行Lynx-full的视频生成,支持自定义输入图像、提示词、种子等参数 |

| infer_lite.py | 轻量模型推理脚本 | 执行Lynx-lite的视频生成,参数与infer.py一致,仅模型路径不同 |

| requirements.txt | 依赖清单文件 | 记录项目运行所需的Python库及版本(如torch==2.1.0、diffusers==0.24.0等) |

4. 典型应用场景

Lynx的“单图+文本”生成模式适配多种场景,无论是专业创作还是个人娱乐,都能发挥价值,具体如下:

4.1 自媒体内容创作

场景需求:自媒体博主(如美妆、穿搭、生活类)需要大量短视频素材,但拍摄成本高、耗时长。

Lynx应用:博主上传自己的基础照片,通过提示词定义视频内容,快速生成素材。例如:

美妆博主:提示词“演示从素颜到日常妆的步骤,先涂隔离,再上粉底,画眉毛和眼影,最后涂口红,镜头聚焦面部,动作轻柔”,生成教程视频;

穿搭博主:提示词“穿着蓝色牛仔裤和白色T恤,在街头行走,偶尔转身展示穿搭,背景有落叶,风格清新”,生成穿搭展示视频。

优势:无需拍摄,每天可生成数十条素材,大幅提升更新频率。

4.2 数字人领域

场景需求:游戏、影视、虚拟主播行业需要为数字人生成动态片段,传统动画制作周期长。

Lynx应用:上传数字人设计图(如游戏角色、虚拟主播形象),生成符合剧情的视频。例如:

游戏公司:提示词“虚拟角色在森林中战斗,挥舞长剑攻击怪物,动作流畅,背景有树木和阳光,符合游戏暗黑风格”,生成宣传片段;

虚拟主播:提示词“虚拟主播坐在书桌前,手持麦克风说‘大家好,今天直播聊电影’,表情微笑,背景有灯光和海报”,生成直播开场片段。

优势:数字人动态生成周期从“数天”缩短到“几分钟”,降低制作成本。

4.3 品牌营销与个性化广告

场景需求:品牌需要让用户参与“个性化广告创作”,提升用户粘性和传播力。

Lynx应用:品牌推出“个性化广告工具”,用户上传自己的照片,生成含品牌元素的视频。例如:

奶茶品牌:提示词“在奶茶店点单,接过店员递来的XX品牌奶茶,插上吸管品尝,露出满意表情,背景有品牌logo和产品展示”,生成用户专属广告;

运动品牌:提示词“穿着XX品牌运动鞋在操场跑步,镜头跟随脚步,背景有品牌标语,画面充满活力”,生成用户分享视频。

优势:用户愿意将专属广告分享到社交平台,为品牌带来免费传播。

4.4 个人娱乐互动

场景需求:普通用户想生成个性化视频(如节日祝福、个人vlog片段),但无专业拍摄设备。

Lynx应用:用户上传自己的生活照,通过提示词生成趣味视频。例如:

节日祝福:提示词“穿着圣诞服装,手持圣诞礼物,对着镜头说‘圣诞快乐’,背景有圣诞树和彩灯,雪花飘落效果”,生成祝福视频发给亲友;

旅行纪念:提示词“在海边沙滩散步,海风拂动头发,偶尔看向镜头微笑,背景有蓝天和海浪,风格清新”,生成“伪旅行vlog”片段。

优势:零拍摄门槛,满足用户的个性化表达需求。

4.5 教育与培训领域

场景需求:培训机构需要为讲师生成“不同知识点的讲解视频”,避免重复拍摄。

Lynx应用:上传讲师照片,生成含教学内容的短视频。例如:

数学培训:提示词“讲解勾股定理,用手比划直角三角形,指出两条直角边和斜边,然后在黑板上写出公式a²+b²=c²,镜头在面部和黑板间切换”,生成教学视频;

语言培训:提示词“教英语单词‘apple’,手持苹果道具,发音清晰,然后用‘I like apples’造句,表情亲切”,生成单词教学视频。

优势:讲师无需重复拍摄,可快速生成覆盖多个知识点的视频库。

5. 完整使用方法

Lynx的使用流程分为“环境准备→模型下载→推理生成”三步,操作简单,无需复杂配置,具体步骤如下:

5.1 环境准备(Windows/Linux/macOS通用)

(1)安装基础依赖工具

安装Anaconda/Miniconda:用于创建独立虚拟环境,避免依赖冲突(下载地址:https://www.anaconda.com/products/distribution,按系统选择对应版本);

安装CUDA:Lynx测试通过的CUDA版本为12.4(Windows需安装NVIDIA显卡驱动,Linux需安装CUDA Toolkit),确认显卡支持CUDA(仅NVIDIA显卡可用,AMD显卡暂不支持)。

(2)创建并激活虚拟环境

打开终端(Windows用Anaconda Prompt,Linux/macOS用终端),执行以下命令:

# 创建名为“lynx”的虚拟环境,Python版本指定为3.10(项目推荐版本) conda create -n lynx python=3.10 # 激活虚拟环境(激活后终端前缀会显示“(lynx)”) conda activate lynx

(3)安装项目依赖

下载Lynx仓库代码:

方式1:通过Git克隆(需安装Git):

git clone https://github.com/bytedance/lynx.git

方式2:直接在GitHub仓库下载ZIP压缩包(https://github.com/bytedance/lynx),解压到本地(如“D:\lynx”或“/home/lynx”)。

进入项目根目录:

# Windows示例(根据实际解压路径修改) cd D:\lynx # Linux/macOS示例(根据实际路径修改) cd /home/lynx

安装基础依赖:

pip install -r requirements.txt

该命令会自动安装torch、diffusers、opencv-python等所有必要库,耗时约5-10分钟(取决于网络速度)。

(仅Lynx-full需要)安装flash attention:

# 安装2.7.4.post1版本(项目测试通过) pip install flash_attn==2.7.4.post1 # 若需更快速度,可安装3.0版本(需CUDA 12.0+) # pip install flash_attn==3.0.0

5.2 模型下载

Lynx需要三个模型文件(基础模型+全量/轻量模型),需手动下载并放置到指定路径,具体如下:

| 模型名称 | 下载地址 | 存放路径(项目根目录下) | 说明 |

|---|---|---|---|

| Wan2.1-T2V-14B-Diffusers | https://huggingface.co/Wan-AI/Wan2.1-T2V-14B-Diffusers | models/Wan2.1-T2V-14B-Diffusers | 基础模型,所有版本都需要 |

| Lynx-full | https://github.com/bytedance/lynx/releases(找“lynx_full”压缩包) | models/lynx_full | 全量模型,仅Lynx-full使用 |

| Lynx-lite | https://github.com/bytedance/lynx/releases(找“lynx_lite”压缩包) | models/lynx_lite | 轻量模型,仅Lynx-lite使用 |

下载注意事项:

路径必须准确:若“models”文件夹不存在,需手动在项目根目录创建;

解压完整:下载的压缩包需完全解压,确保模型文件(如model.safetensors、adapter.safetensors)直接放在上述路径下,不嵌套子文件夹;

加速下载:

Hugging Face模型:可使用国内镜像(如https://hf-mirror.com/),或用Hugging Face CLI下载:

bash huggingface-cli download Wan-AI/Wan2.1-T2V-14B-Diffusers --local-dir models/Wan2.1-T2V-14B-DiffusersGitHub模型:可使用GitHub加速工具(如GitClone),或用浏览器下载工具(如IDM)断点续传。

5.3 推理生成视频

Lynx提供两种推理脚本(infer.py对应全量模型,infer_lite.py对应轻量模型),参数一致,仅脚本名称不同,以下以全量模型为例说明:

(1)基础推理命令(直接输入提示词)

python infer.py \ --subject_image demo/subjects/demo_subject.png \ # 输入图像路径(可替换为自己的图像) --prompt "A person carves a pumpkin on a porch in the evening. The camera captures their upper body as they draw a face with a marker, carefully cut along the lines, then lift the lid with both hands. Their face lights up with excitement as they peek inside." \ # 文本提示词 --seed 42 # 随机种子(确保结果可复现)

(2)从TXT文件读取提示词(适合长文本/批量生成)

若提示词较长,或需批量生成多个视频,可将提示词写入TXT文件(如demo/prompts/demo_prompt.txt),每行一个提示词,然后执行:

python infer.py \ --subject_image demo/subjects/demo_subject.png \ --prompt demo/prompts/demo_prompt.txt \ # 提示词文件路径 --seed 42

(3)轻量模型推理命令

仅需将脚本名称改为“infer_lite.py”,其他参数不变:

python infer_lite.py \ --subject_image my_photo.png \ # 替换为自己的图像路径(如“D:\photos\me.png”) --prompt "在公园散步,阳光明媚,双手自然摆动,偶尔看向镜头" \ # 支持中文提示词 --seed 123

(4)参数说明与结果查看

| 参数名称 | 含义 | 示例值 |

|---|---|---|

| --subject_image | 输入图像路径(必填) | demo/subjects/demosubject.png、myphoto.png |

| --prompt | 提示词或提示词文件路径(必填) | "在海边看风景"、demo/prompts/demo_prompt.txt |

| --seed | 随机种子(可选,默认随机) | 42、123、456 |

| --output_dir | 结果保存路径(可选,默认output文件夹) | output/my_videos |

结果查看:推理完成后,生成的视频会保存到指定的output文件夹(默认项目根目录下的output),视频格式为MP4,文件名包含“seed值+时间戳”(如videoseed4220250930.mp4),直接用播放器打开即可。

6. 常见问题解答(FAQ)

Q1:安装flash attention时提示“CUDA error: no kernel image is available for execution on the device”怎么办?

A1:该错误是CUDA版本与flash attention版本不兼容导致,解决方案如下:

确认本地CUDA版本:执行

nvcc --version,确保为12.4(Lynx测试通过版本);若CUDA版本正确,尝试安装flash attention 3.0.0:

pip install flash_attn==3.0.0;若设备CUDA版本较低(如11.8),可参考flash attention官方文档(https://github.com/Dao-AILab/flash-attention)安装兼容版本,或直接使用Lynx-lite(无需flash attention)。

Q2:执行推理命令时提示“FileNotFoundError: No such file or directory: 'models/Wan2.1-T2V-14B-Diffusers'”怎么办?

A2:该错误是模型路径不正确,解决步骤:

检查是否已下载基础模型(Wan2.1-T2V-14B-Diffusers);

确认模型文件夹名称与路径完全一致(区分大小写,如“Wan2.1-T2V-14B-Diffusers”不能少字符或错写);

确保模型文件夹放在项目根目录的“models”下(如“lynx/models/Wan2.1-T2V-14B-Diffusers”),而非其他路径;

若手动创建models文件夹,检查文件夹权限(确保可读)。

Q3:生成的视频中人物身份与输入图像不符(如脸型变、发型错)怎么办?

A3:可通过以下方式优化身份保留效果:

提升输入图像质量:确保图像分辨率≥512×512,主体无模糊、无遮挡(如头发不遮住面部);

调整seed值:更换seed(如从42改为123),不同seed生成的身份相似度不同;

使用Lynx-full模型:相比lite模型,全量模型的ID-adapter更强大,身份保留更精准;

提示词补充身份描述:在prompt中加入“保持人物短发、圆形脸型”等细节,强化身份约束。

Q4:推理时提示“CUDA out of memory”(显存不足)怎么办?

A4:显存不足是模型规模与设备显存不匹配导致,解决方案如下:

优先使用Lynx-lite:轻量模型显存占用约为全量模型的60%,8GB显存可运行;

降低输入图像分辨率:将图像压缩到512×512(如用画图工具或OpenCV调整),减少显存消耗;

启用显存优化:在推理命令前添加

--lowvram参数(需代码支持,可修改infer.py,添加低显存模式);减少帧长:修改代码中“num_frames”参数(如从121帧改为60帧),缩短视频长度。

Q5:生成的视频动作卡顿、不自然怎么办?

A5:动作不自然通常是提示词描述不清晰或seed值不合适,解决方法:

优化提示词:添加详细动作序列(如“先抬起左手,再缓慢拿起杯子”),避免模糊描述(如“做动作”);

增加连贯性描述:在prompt中加入“动作流畅,符合人体运动规律,无卡顿”;

更换seed值:不同seed生成的动作自然度不同,可多尝试几个seed(如123、456、789);

使用Lynx-full:全量模型的Motion Naturalness指标更高,动作更自然。

Q6:支持中文提示词吗?生成的视频有水印吗?

A6:①中文提示词支持:项目官方示例用英文,但实际测试中中文提示词可正常生成视频(需确保依赖库支持中文,如diffusers);②无水印:Lynx生成的视频默认无任何水印,用户可自行添加品牌或个人水印。

7. 相关链接

Lynx GitHub仓库:https://github.com/bytedance/lynx

Lynx技术论文:https://arxiv.org/abs/2509.15496

基础模型下载页:https://huggingface.co/Wan-AI/Wan2.1-T2V-14B-Diffusers

flash attention官方仓库:https://github.com/Dao-AILab/flash-attention

8. 总结

Lynx是字节跳动Intelligent Creation团队开源的高保真个性化视频生成模型,以Diffusion Transformer为基础,通过ID-adapter和Ref-adapter实现“单图+文本”驱动的视频生成,兼顾身份保留与细节增强;项目提供全量与轻量双模型版本,适配专业创作与高效推理场景,核心指标优于多数同类模型;使用流程简单,支持可复现推理,无需复杂配置,适用于自媒体、数字人、营销、个人娱乐、教育等多领域;遵循Apache License 2.0协议,允许商用且代码结构清晰,既为开发者提供了低门槛的视频生成工具,也为个性化视频生成领域提供了技术参考,有效推动了AIGC技术在视频创作场景的落地与普及。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/lynx.html