MiMo-Audio:小米公司开源的多功能AI音频处理模型

一、MiMo-Audio是什么

MiMo-Audio是小米公司开发并开源的音频语言模型项目,旨在通过大规模预训练和创新的模型架构,实现音频领域的少样本学习能力。该项目依托超过1亿小时的多语言、多场景音频数据进行训练,构建了一套完整的音频理解与生成体系,能够在无需针对特定任务进行大量微调的情况下,快速适应多种音频相关任务。

作为一个开源项目,MiMo-Audio不仅提供了预训练模型,还包含了完整的工具链、示例代码和评估套件,方便开发者快速上手和二次开发。其设计理念是打破传统音频处理模型对特定任务的依赖,通过统一的框架支持多种音频应用场景,降低音频AI技术的使用门槛。

二、功能特色

MiMo-Audio凭借其创新的模型设计和大规模训练数据,具备以下核心功能特色:

1. 强大的少样本学习能力

模型能够通过少量示例或简单指令快速适应新的音频任务,无需针对每个任务进行大规模微调。这种能力极大地降低了模型应用于新场景的成本和时间,使开发者能够快速验证想法并部署解决方案。

2. 丰富的多任务支持

MiMo-Audio支持多种音频相关任务,涵盖了从语音理解到音频生成的多个维度:

| 任务类别 | 具体任务 |

|---|---|

| 语音智能 | 语音识别、语音合成、语音转写、语音唤醒 |

| 音频理解 | 音频分类、声音事件检测、音乐流派识别、情感识别 |

| 语音转换 | 音色转换、跨语言语音转换、语音风格迁移 |

| 语音编辑 | 语音内容编辑、降噪处理、音频修复 |

| 内容生成 | 脱口秀生成、朗诵生成、直播语音生成、辩论内容生成 |

3. 高质量的生成能力

模型在音频生成任务中表现出色,能够生成自然、流畅且富有表现力的语音内容。无论是新闻播报、故事讲述还是日常对话,生成的音频都具有高度的逼真度和可理解性。

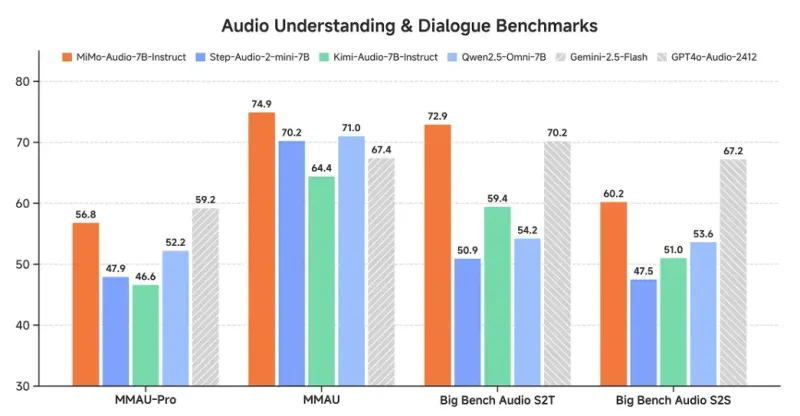

4. 指令调优版本的优势

MiMo-Audio-7B-Instruct作为指令调优版本,引入了思维机制,在多项评估中达到开源领域的SOTA(State-of-the-Art)水平:

在音频理解任务中,能够准确解析音频中的语义信息和情感倾向

在口语对话场景中,支持自然流畅的多轮交互

在指令TTS(文本到语音)评估中,生成质量接近专业录制水平

5. 高效的处理能力

模型采用优化的架构设计,能够在普通硬件上实现高效推理,平衡了性能和资源消耗。同时支持批量处理,提高了大规模音频处理的效率。

三、技术细节

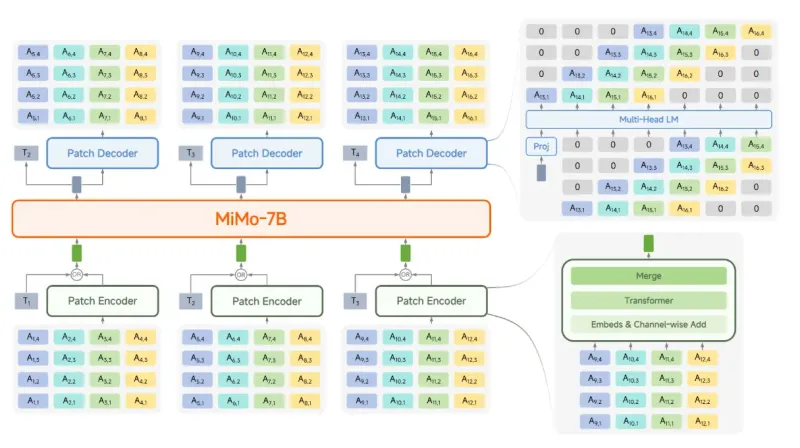

1. 整体架构

MiMo-Audio的整体架构由三个核心组件构成:MiMo-Audio-Tokenizer(音频令牌化器)、补丁编码器(Patch Encoder)、大型语言模型(LLM)和补丁解码器(Patch Decoder)。

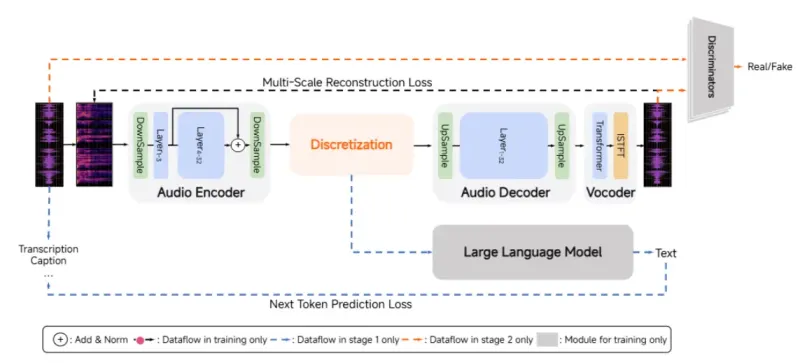

2. MiMo-Audio-Tokenizer

MiMo-Audio-Tokenizer是音频处理的基础组件,负责将原始音频转换为离散的令牌序列,以及将令牌序列重建为音频:

模型规模:12亿参数的Transformer模型

采样频率:工作在25Hz的频率上

量化方案:采用8层残差向量量化(RVQ)堆栈

令牌生成:每秒生成200个令牌

训练优化:同时优化语义和重建目标,在1000万小时多样化语料上进行训练

功能特点:既能保留音频的语义信息,又能保证重建音频的质量

3. 补丁编码器与解码器

补丁编码器:将RVQ令牌下采样至6.25Hz,减少输入到LLM的数据量,提高处理效率

补丁解码器:通过延迟生成方案,自回归生成完整的25Hz RVQ令牌序列,保证输出音频的连续性和质量

4. LLM(大型语言模型)部分

基础模型:MiMo-Audio-7B-Base包含70亿参数

指令调优:MiMo-Audio-7B-Instruct在基础模型上通过指令数据进行微调,增强了对自然语言指令的理解能力

上下文处理:能够处理长上下文的音频和文本信息,支持复杂指令的执行

5. 训练数据

数据规模:超过1亿小时的音频数据

数据多样性:涵盖多语言(包括中文、英文等多种语言)、多场景(对话、演讲、音乐、环境音等)、多风格(正式、随意、情感化等)的音频内容

数据处理:采用严格的数据清洗和预处理流程,确保训练数据的质量

四、应用场景

MiMo-Audio的多功能性使其能够应用于多个领域和场景:

1. 智能语音助手

利用模型的语音识别、语义理解和语音合成能力,开发更智能、更自然的语音助手。支持多轮对话、复杂指令执行,适用于智能家居、智能车载系统等场景。

例如,在智能车载系统中,用户可以通过自然语言指令控制导航、音乐播放,查询天气等信息,系统能够理解上下文并提供连贯的回应。

2. 内容创作与编辑

音频内容生成:自动生成新闻播报、有声书、广告配音等内容,支持多种风格和音色

语音编辑:对录制的语音进行编辑,如修改特定词语、调整语速和语调、去除背景噪音等

多语言转换:将一种语言的语音转换为另一种语言,同时保留原有的音色和情感

3. 音频监控与分析

在安防、工业监控等领域,利用模型的音频理解能力检测特定声音事件,如玻璃破碎声、警报声、设备异常声音等,及时发出预警。

在会议场景中,可以实时对会议内容进行转写和分析,提取关键信息和决策点,生成会议纪要。

4. 无障碍辅助

为听障人士提供实时语音转文字服务

为视障人士提供环境声音识别和描述服务

帮助语言障碍者进行更有效的沟通,如将文字转换为自然语音

5. 娱乐与媒体

游戏开发:为游戏角色提供多样化的语音生成,支持实时语音交互

动画制作:快速生成动画角色的配音,减少制作成本

音乐创作:辅助音乐创作,如生成伴奏、转换音乐风格等

6. 教育培训

语言学习:提供标准发音示例、语音评测、多语言翻译等功能

教学辅助:自动生成教学音频内容,如课文朗读、知识点讲解等

无障碍教育:为特殊需求学生提供定制化的音频学习材料

五、使用方法

1. 环境准备

硬件要求

最低配置:CPU具有8核以上,内存16GB以上,GPU具有4GB以上显存

推荐配置:CPU 16核以上,内存32GB以上,GPU(如NVIDIA RTX 3090/4090或同等性能)具有10GB以上显存

软件要求

操作系统:Linux(推荐Ubuntu 20.04及以上版本)、Windows 10/11、macOS 12及以上版本

Python:3.8-3.10版本

依赖库:PyTorch、Transformers、Datasets、Gradio等(具体版本见requirements.txt)

2. 安装步骤

方法一:直接安装

# 克隆仓库 git clone https://github.com/XiaomiMiMo/MiMo-Audio.git cd MiMo-Audio # 安装依赖 pip install -e .

方法二:使用虚拟环境(推荐)

# 克隆仓库 git clone https://github.com/XiaomiMiMo/MiMo-Audio.git cd MiMo-Audio # 创建并激活虚拟环境 python -m venv mimo-env source mimo-env/bin/activate # Linux/macOS # 或 mimo-env\Scripts\activate # Windows # 安装依赖 pip install -e .

3. 模型下载

模型可以通过Hugging Face Hub获取,支持自动下载和本地加载两种方式:

自动下载

在代码中指定模型名称,会自动从Hugging Face Hub下载模型:

from mimo_audio import MiMoAudioPipeline

pipeline = MiMoAudioPipeline.from_pretrained("XiaomiMiMo/MiMo-Audio-7B-Instruct")手动下载

可以先手动下载模型到本地,再从本地加载:

# 安装git-lfs git lfs install # 克隆模型仓库 git clone https://huggingface.co/XiaomiMiMo/MiMo-Audio-7B-Instruct

from mimo_audio import MiMoAudioPipeline

pipeline = MiMoAudioPipeline.from_pretrained("./MiMo-Audio-7B-Instruct")4. 基本使用示例

语音合成

from mimo_audio import MiMoAudioPipeline

import soundfile as sf

# 加载模型

pipeline = MiMoAudioPipeline.from_pretrained("XiaomiMiMo/MiMo-Audio-7B-Instruct")

# 文本输入

text = "欢迎使用小米MiMo-Audio模型,这是一个强大的音频处理工具。"

# 生成语音

audio = pipeline.tts(text, voice="female", speed=1.0)

# 保存音频

sf.write("output.wav", audio["audio"], samplerate=audio["sampling_rate"])语音转文字

from mimo_audio import MiMoAudioPipeline

import soundfile as sf

# 加载模型

pipeline = MiMoAudioPipeline.from_pretrained("XiaomiMiMo/MiMo-Audio-7B-Instruct")

# 加载音频文件

audio, sr = sf.read("input.wav")

# 语音转文字

result = pipeline.asr(audio, sampling_rate=sr)

print("转写结果:", result["text"])音频分类

from mimo_audio import MiMoAudioPipeline

import soundfile as sf

# 加载模型

pipeline = MiMoAudioPipeline.from_pretrained("XiaomiMiMo/MiMo-Audio-7B-Instruct")

# 加载音频文件

audio, sr = sf.read("environment.wav")

# 音频分类

result = pipeline.classify(audio, sampling_rate=sr, categories=["音乐", "对话", "环境音", "警报声"])

print("分类结果:", result["labels"])

print("置信度:", result["scores"])5. 交互式演示

项目提供了Gradio交互式界面,方便用户直观体验模型功能:

python run_mimo_audio.py

运行后,会在本地启动一个Web服务器,通过浏览器访问显示的地址(通常是http://localhost:7860)即可使用交互式界面,支持语音合成、语音识别、音频转换等多种功能的可视化操作。

六、常见问题解答

1. 模型运行需要什么级别的硬件配置?

答:模型可以在CPU和GPU上运行,但为了获得较好的性能,推荐使用GPU。最低配置要求CPU 8核、内存16GB、GPU 4GB显存;推荐配置CPU 16核、内存32GB、GPU 10GB以上显存(如NVIDIA RTX 3090/4090)。对于7B参数的模型,完全加载需要约13GB的显存。

2. 如何处理模型运行速度慢的问题?

答:可以尝试以下方法提高运行速度:

使用GPU加速,确保正确安装了CUDA和cuDNN

降低输入音频的采样率或长度

调整模型的推理参数,如使用更小的batch size

对于不需要太高精度的场景,可以使用模型的量化版本(如有提供)

3. 模型支持哪些语言?

答:MiMo-Audio在训练过程中使用了多语言数据,主要支持中文和英文,对其他常见语言也有一定的处理能力。具体语言支持程度可以通过实际测试验证。

4. 如何将模型集成到自己的应用中?

答:项目提供了Python API,可以方便地集成到各种Python应用中。对于非Python应用,可以通过REST API的方式封装模型服务,或使用跨语言调用的方式集成。详细的集成示例可以参考项目文档中的"Integration Guide"部分。

5. 模型的音频生成质量与哪些因素有关?

答:音频生成质量受多种因素影响,包括输入文本的清晰度、指令的明确性、选择的语音风格和音色、采样率设置等。为了获得更好的生成效果,建议提供清晰、简洁的输入文本,明确指定所需的语音风格,并适当调整生成参数。

6. 项目是否提供模型微调的方法?

答:是的,项目提供了模型微调的工具和示例代码。用户可以根据自己的数据集对模型进行微调,以适应特定场景的需求。微调教程和示例可以在项目的"Fine-tuning Guide"中找到。

7. 如何评估模型在特定任务上的性能?

答:项目提供了配套的评估工具MiMo-Audio-Eval(https://github.com/XiaomiMiMo/MiMo-Audio-Eval),可以用于评估模型在多种音频任务上的性能。用户也可以根据自己的需求,设计特定的评估指标和测试集。

8. 模型的许可证是什么?可以用于商业用途吗?

答:MiMo-Audio基于Apache License 2.0开源协议发布。根据该协议,用户可以自由使用、修改和分发模型,包括用于商业用途,但需要遵守协议中的相关条款,如保留版权声明和免责声明等。详细条款参见项目根目录下的LICENSE文件。

七、相关链接

| 链接类型 | 地址 |

|---|---|

| 项目GitHub仓库 | https://github.com/XiaomiMiMo/MiMo-Audio |

| 模型Hugging Face主页 | https://huggingface.co/XiaomiMiMo |

| MiMo-Audio-Tokenizer | https://huggingface.co/XiaomiMiMo/MiMo-Audio-Tokenizer |

| MiMo-Audio-7B-Base | https://huggingface.co/XiaomiMiMo/MiMo-Audio-7B-Base |

| MiMo-Audio-7B-Instruct | https://huggingface.co/XiaomiMiMo/MiMo-Audio-7B-Instruct |

| 评估工具 | https://github.com/XiaomiMiMo/MiMo-Audio-Eval |

八、总结

MiMo-Audio是小米公司推出的一款功能强大的开源音频语言模型,通过大规模预训练和创新的架构设计,实现了音频领域的少样本学习能力,支持语音识别、语音合成、音频理解、语音转换等多种任务。该项目提供了完整的工具链和示例代码,方便开发者快速上手和二次开发,其应用场景广泛,涵盖智能语音助手、内容创作、音频监控、无障碍辅助、娱乐媒体和教育培训等多个领域。无论是研究人员还是企业开发者,都可以利用MiMo-Audio推动音频AI技术的应用和创新,降低音频处理解决方案的开发成本和门槛。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/mimo-audio.html