ML-Master:上海交大开源的下一代自主机器学习 AI 专家智能体

一、 ML-Master是什么

ML-Master是由上海交通大学人工智能学院SAI实验室主导,联合EigenAI提供基础设施支持研发的开源AI-for-AI(即用AI解决AI任务)自主智能体,核心定位是成为“机器学习领域的AI专家”,能够像人类机器学习工程师一样,自主完成从问题建模、实验设计、代码编写、模型调参到结果提交的全流程任务。该项目聚焦机器学习工程(MLE)场景,解决传统AI-for-AI方案中探索与推理割裂、经验无法复用、复杂任务适应性差等核心痛点,目前已迭代至2.0版本,核心代码完全开源在GitHub平台。

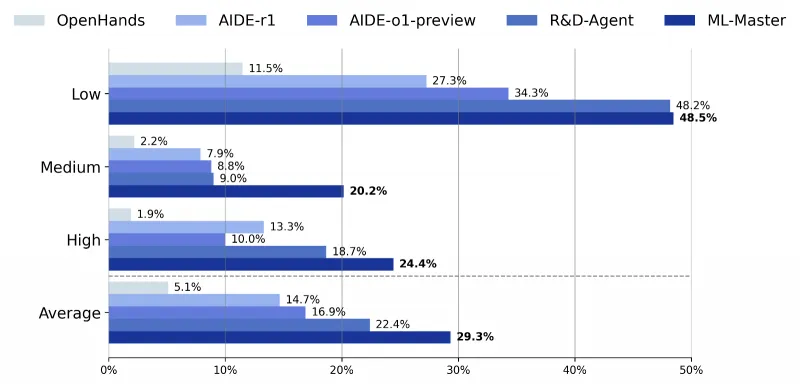

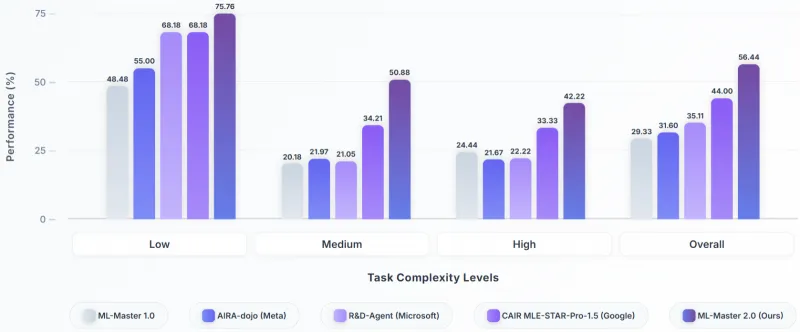

从发展历程来看,ML-Master 1.0版本实现了探索与推理的初步整合,而2025年推出的2.0版本则新增GPT-5支持、轻量化Docker部署,优化代码可读性与可维护性,性能实现跨越式提升,整体性能较1.0版本提升92.7%。在权威评测中,ML-Master凭借29.3%的平均奖牌率登顶OpenAI MLE-Bench基准榜单,大幅领先微软R&D-Agent(22.4%)和OpenAI AIDE系统(16.9%),同时达成Kaggle比赛“Grandmaster(特级大师)”级别,在20余万Kaggle参赛者中位列第259位,是目前全球领先的开源自主机器学习智能体之一。

二、 功能特色

ML-Master凭借创新的技术范式和扎实的性能表现,具备五大核心功能特色,且在权威基准中实现全维度领先,核心性能数据可通过下表直观呈现:

表1 ML-Master核心性能对比表(2.0版本 vs 1.0版本 vs 同类竞品)

| 评测维度 | ML-Master 2.0 | ML-Master 1.0 | 微软R&D-Agent | OpenAI AIDE |

|---|---|---|---|---|

| 平均奖牌率(MLE-Bench) | 29.3% | 15.2% | 22.4% | 16.9% |

| 中等难度任务奖牌率 | 20.2% | 8.0% | 9.0% | 7.5% |

| 高难度任务奖牌率 | 24.4% | 14.1% | 18.7% | 15.1% |

| 任务有效提交率 | 93.3% | 78.5% | 85.1% | 81.2% |

| 完成全量任务耗时 | 12小时 | 24小时 | 20小时 | 22小时 |

权威榜单登顶,全维度性能领先:ML-Master 2.0在OpenAI MLE-Bench基准中斩获榜首,该基准包含75个来自Kaggle的真实机器学习任务,覆盖代码编写、模型调参等完整流程,是全球最权威的机器学习工程能力评测标准。项目不仅奖牌率领先,还实现93.3%的任务有效提交率,44.9%的任务性能超越半数人类参赛者,且完成全量任务仅需12小时,计算效率为基线方法的2倍,兼顾性能与效率。

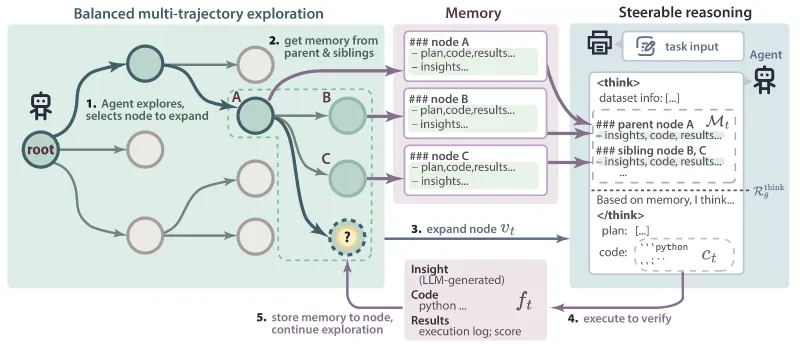

探索推理深度融合,突破传统技术瓶颈:区别于传统AI-for-AI方案中探索与推理各自为战的问题,ML-Master创新采用“探索-推理深度融合”范式,平衡多轨迹探索与可控推理两大核心能力,既避免无目的低效试错,也防止脱离实际的空想推理,让智能体像人类专家一样“广泛探索+深度思考”。

自适应记忆+层次化认知缓存,实现经验复用:核心搭载自适应记忆机制,可智能捕捉探索过程中的有效信息、代码片段和性能指标,避免信息过载;2.0版本新增层次化认知缓存,将认知分为即时经验、阶段性知识、跨任务智慧三个层级,实现长期经验沉淀与复用,让智能体在多轮任务中持续进化,性能较初始状态提升超120%。

多LLM兼容+轻量化部署,适配性极强:支持多类大语言模型后端,包括GPT-5、通义千问、DeepSeek等闭源与开源模型,用户可按需切换;同时提供Docker镜像一键部署,无需复杂环境配置,本地部署仅需满足基础Python环境,降低使用门槛,兼顾科研与工程场景需求。

高泛化适配,覆盖全难度机器学习任务:在低、中、高不同复杂度任务中均表现稳定,低难度任务奖牌率达48.5%,中等难度任务奖牌率较竞品提升2.2倍,高难度任务实现30%性能超越,可适配图像分类、分割、文本处理、数值预测等多类型机器学习任务,泛化能力突出。

三、 技术细节

ML-Master的核心优势源于其严谨的技术架构设计,整体采用“五大核心模块+三大核心技术”的架构体系,各模块分工明确、协同联动,技术实现兼顾创新性与实用性

表2 ML-Master核心模块及核心功能

| 核心模块 | 所属目录 | 核心功能 |

|---|---|---|

| 平衡多轨迹探索模块 | agent/search | 基于MCTS构建决策树,并行探索多解决方案,动态分配计算资源,避免无效探索 |

| 可控推理模块 | agent/interpreter | 基于记忆信息做情境化决策,形成闭环学习,让推理有据可依,持续优化策略 |

| 自适应记忆模块 | utils/memory | 捕捉关键信息、筛选冗余内容,实现探索与推理的信息互通,支撑协同进化 |

| 多LLM后端模块 | backend | 适配GPT-5、通义千问、DeepSeek等模型,提供统一调用接口,灵活切换 |

| 任务调度与评分模块 | main_mcts.py/grading_server.py | 任务流程管控、结果评分校验,保障任务全流程闭环执行 |

(一) 核心架构设计

ML-Master的整体架构围绕“探索-推理-记忆”三大核心逻辑构建,形成完整闭环,确保智能体自主完成机器学习任务:

平衡多轨迹探索模块:这是智能体的“实践探索引擎”,核心基于蒙特卡洛树搜索(MCTS)技术,将机器学习任务拆解为决策树,每个节点代表一个解决方案状态。模块支持多分支并行探索,突破传统串行探索的效率瓶颈,同时会动态评估各分支潜力,将计算资源优先分配给高价值方向,大幅提升探索效率,减少无效试错。

可控推理模块:这是智能体的“深度思考引擎”,核心作用是基于探索结果和记忆信息做精准决策。不同于传统推理的“拍脑袋”输出,该模块会结合历史执行反馈和成功经验,做情境化推理,比如根据上一轮模型的精度不足,针对性优化调参策略,同时形成“推理-执行-反馈-优化”的闭环,持续提升决策质量。

自适应记忆模块:这是智能体的“核心大脑中枢”,也是探索与推理的协同桥梁。模块会自动收集探索过程中的执行结果、有效代码、性能指标,同时筛选冗余信息,避免信息过载;还会整合不同分支的关键经验,将其嵌入推理模块的决策过程,实现“探索驱动推理、推理反哺探索”的协同进化,让两大模块相互强化。

多LLM后端模块:提供统一的LLM调用接口,适配不同类型大语言模型,用户只需在配置文件中修改模型参数,即可切换GPT-5、通义千问、DeepSeek等模型,兼顾闭源模型的高性能和开源模型的低成本,适配不同用户的资源条件。

任务调度与评分模块:负责任务全流程管控,从任务初始化、探索推理分配到结果提交、评分校验,一站式完成;评分模块可对接MLE-Bench标准,实时校验提交结果格式与性能,确保输出符合任务要求。

(二) 核心技术支撑

蒙特卡洛树搜索(MCTS)优化:针对机器学习任务特点优化MCTS算法,优化节点评估权重,重点关注模型精度、训练效率、代码可行性三大指标,让探索方向更贴合机器学习工程实际需求,提升探索的有效性。

层次化认知缓存机制:2.0版本核心升级技术,将智能体的认知分为三个层级,即时经验用于当前任务的实时决策,阶段性知识用于同一任务的反复复用,跨任务智慧用于迁移到新任务中,解决传统智能体“上下文爆炸”和“经验遗忘”的问题,实现长期自主进化。

探索-推理闭环协同技术:通过自适应记忆模块搭建两大模块的信息通道,探索结果实时同步给推理模块,推理模块输出的优化策略即时指导后续探索,形成无人工干预的自主闭环,让智能体在反复迭代中持续提升任务性能。

(三) 代码结构说明

ML-Master仓库代码结构清晰,核心文件分工明确,方便用户查阅和二次开发:

核心运行文件:main_mcts.py(项目主程序,启动探索推理全流程)、grading_server.py(评分服务器)、run.sh(快速启动脚本);

核心模块目录:agent(智能体核心逻辑)、backend(LLM后端适配)、dataset(75个真实任务数据集)、utils(工具函数);

配置文件:config_mcts.yaml(核心配置,可修改模型、探索参数、任务类型等);

开发分支:main分支为稳定版本,feature-dev分支为优化版本,可读性和可维护性更强,适合二次开发。

四、 应用场景

ML-Master聚焦机器学习全流程自主化,凭借高泛化性和强性能,可适配多领域实际场景,核心应用场景分为三大类,覆盖工程落地与前沿科研:

计算机视觉领域:这是ML-Master适配最成熟的场景,可自主完成图像分类、语义分割等任务,具体包括植物标本分类、酒店ID识别(反人口贩卖场景)、肾脏组织医疗影像分割等。比如在肾脏组织分割任务中,智能体可自主设计分割模型、优化标注数据利用率,性能超越半数人类参赛者,可辅助医疗影像辅助诊断,降低人工成本。

通用机器学习预测任务:适配各类结构化数据预测场景,包括用户行为预测、销量预测、风险评估等。比如基于电商用户行为数据,自主完成特征工程、模型选择、调参优化,输出精准的用户购买转化预测结果,无需人工参与建模流程,提升企业数据分析效率。

前沿科研辅助场景:依托2.0版本的层次化认知缓存和长期自主进化能力,ML-Master已落地前沿科研场景,包括具身智能机器人训练、理论物理模拟等。在具身智能训练中,可自主优化机器人感知与决策模型;在理论物理模拟中,可自主调整模拟参数、分析模拟结果,辅助科研人员提升研究效率。

五、 使用方法

ML-Master提供两种部署方式,优先推荐Docker镜像部署,无需复杂环境配置;本地部署需满足基础Python环境,整体操作简单易懂,分三步即可快速上手:

(一) 环境准备

方式一:Docker镜像部署(推荐) 这是最便捷的部署方式,无需手动安装依赖,适配Windows、Mac、Linux系统,核心命令如下:

# 拉取最新ML-Master镜像

docker pull sjtu-sai-agents/ml-master:latest

# 启动交互式容器

docker run -it --name ml-master-container sjtu-sai-agents/ml-master:latest /bin/bash

方式二:本地部署 需满足Python 3.11+环境,核心步骤如下:

# 克隆GitHub仓库

git clone https://github.com/sjtu-sai-agents/ML-Master.git

# 进入仓库目录

cd ML-Master

# 安装依赖包

pip install -r requirements.txt

(二) 快速启动

本地部署和Docker部署均可通过脚本快速启动,无需手动配置复杂参数,核心操作如下:

# 执行快速启动脚本,默认运行MLE-Bench基准任务

bash run.sh

# 若需指定任务,可修改main_mcts.py中的任务ID参数,或通过命令行传入

python main_mcts.py --task_id herbarium-2021-fgvc8(植物标本分类任务)

(三) 自定义任务配置

若需适配自身机器学习任务,可通过修改配置文件实现,核心操作如下:

打开utils/config_mcts.yaml配置文件;

修改LLM后端参数:选择使用的模型(如gpt-5、qwen、deepseek),填写对应API密钥;

修改探索参数:调整MCTS探索分支数、迭代次数,适配任务复杂度;

上传自定义任务数据:将任务数据放入dataset目录,按照MLE-Bench格式编写任务说明,即可让智能体自主完成任务。

六、 常见问题解答

Q:Docker拉取镜像失败,提示连接超时怎么办?

A:可更换国内Docker镜像源(如阿里云、网易云),配置完成后重新执行拉取命令;若仍失败,可直接克隆仓库进行本地部署,本地部署仅需满足Python 3.11+环境,依赖包均可通过pip安装。

Q:运行任务时提示LLM调用报错,无法生成代码怎么办?

A:首先检查config_mcts.yaml中模型API密钥是否填写正确,网络是否能正常访问对应模型服务;若使用开源模型(如通义千问),需确保本地已部署对应模型服务,或填写正确的开源模型调用地址。

Q:智能体执行任务后性能不达标,如何优化?

A:可通过两种方式优化:一是调整config_mcts.yaml中的探索参数,增加探索分支数和迭代次数,提升探索全面性;二是在任务说明中补充更多细节(如数据特点、性能要求),让智能体的推理更贴合任务需求。

Q:ML-Master支持哪些大语言模型,是否支持国产开源模型?

A:目前支持GPT-3.5、GPT-4、GPT-5等闭源模型,同时支持通义千问、DeepSeek、Llama 3等开源模型,国产开源模型需在backend目录下确认对应适配文件,若无对应文件可基于现有backend模板快速适配。

Q:想基于ML-Master二次开发,优先选择哪个分支?

A:优先选择feature-dev分支,该分支是2025年10月更新的优化版本,优化了代码可读性和可维护性,补充了详细注释,更适合二次开发;main分支为稳定版本,适合直接使用,不建议修改核心代码。

七、 相关链接

项目GitHub仓库(核心开源地址):https://github.com/sjtu-sai-agents/ML-Master/

权威评测基准MLE-Bench(任务来源):https://github.com/openai/mle-bench

八、 总结

ML-Master作为一款开源AI-for-AI自主智能体,核心以探索与推理深度融合为核心范式,搭配自适应记忆与层次化认知缓存机制,实现机器学习任务全流程自主完成,在OpenAI MLE-Bench权威基准中以29.3%平均奖牌率登顶榜首,达成Kaggle特级大师水平,2.0版本性能较1.0提升92.7%,且计算效率翻倍,同时支持多LLM兼容和Docker轻量化部署,降低使用门槛,其核心架构兼顾创新性与实用性,代码结构清晰便于二次开发,既能适配计算机视觉、通用预测等工程落地场景,也能辅助具身智能、理论物理模拟等前沿科研,为AI自主优化AI领域提供了高效、可靠的开源解决方案,是当前开源生态中极具实用性和参考价值的机器学习智能体项目。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/ml-master.html